社交媒体应如何应对错误信息?

已发表: 2022-03-09作为一个社会,我们与社交媒体有着复杂的关系。 当我们听到网络欺凌、错误信息和仇恨言论时,我们正确地谴责它给社会投下的丑陋阴影。 但是,当俄罗斯禁止 Facebook 以试图控制围绕乌克兰的叙事时,感觉好像一项基本人权正在被剥夺。

我们的困惑是由于价值观的冲突:言论自由与不受伤害的自由。 这是我们这个时代最重要的辩论之一。 但这也是一场过于简单化、两极分化和部落化的辩论。

这场辩论的两个方面是什么?

一方面是不想要规则的言论自由绝对主义者。 它们推动了新社交媒体平台的兴起,例如 Gab 和唐纳德特朗普的“Truth Social”,这些平台对您发布的内容没有限制。 他们很快陷入白人民族主义、反犹太主义和 QAnon 阴谋论。

另一方正在寻求对社交媒体进行更大的国家监管。 这导致了诸如Google Fact Check、Good Information Inc 和 Trusted News Summit 等新举措的出现,这些举措旨在验证什么是真实的。 这一方往往低估了授予国家监管互联网权力的风险。 这可能出错的例子是寻求控制信息自由流动的政治政权对社交媒体的镇压。

以 Meta(我使用“Facebook”来区分特定的社交媒体平台)为例,我将审视争论的双方——并提出一个旨在解决价值观冲突的解决方案。

脸书受到抨击

全球近四分之一的人口使用 Facebook,使其成为全球最受欢迎的社交媒体平台。

但他们宣称的使命“建立社区,让世界更紧密地联系在一起”的可信度最近受到了抨击。

举报人指责 Facebook 故意选择利润而不是社会; 他们争辩说,在宣传错误信息时,Facebook 正在削弱民主进程的完整性。 此外,有人认为,社交媒体的错误信息削弱了社会有效应对疫情的能力。

马克扎克伯格回应如下:

“我们允许错误信息在我们的平台上恶化,或者我们以某种方式从这些内容中受益的想法是错误的。”

Facebook 的辩护是,他们拥有比任何其他技术平台更多的事实核查合作伙伴。 他们的努力无疑令人印象深刻,每月删除超过 500 万条仇恨内容。

Facebook 还将向您指出他们的社区标准,其中列出了他们可能会采取行动的 4 种类型的内容:

- 暴力和犯罪行为

- 安全问题(例如欺凌、虐待儿童、剥削)

- 令人反感的内容,例如色情和仇恨言论

- 不真实的内容(例如错误信息)

其中,第 1 点至第 3 点几乎没有争议。人们普遍认为 Facebook 应该采取行动防止暴力、欺凌和仇恨言论造成的伤害。

这是第4点,错误信息,这是有争议的。

错误信息的兴起

有时感觉就像我们准备好同时相信一切而什么都不相信。

而这种感觉并不新鲜。

1835年,《纽约太阳报》声称月球上有外星文明。 它卖得很好,以至于它使《纽约太阳报》成为领先的出版物。

然而,作为一种心理控制形式的有针对性的错误信息只会随着数字通信的兴起而增加。

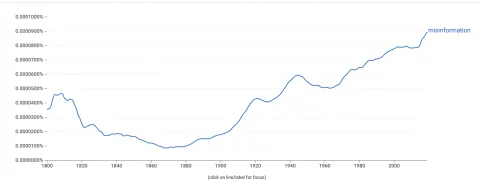

谷歌 Ngram 查看器测量了单词在书中出现的频率,显示我们对“错误信息”这个词的使用急剧增加。  要理解这一点,我们应该了解错误信息是如何传播的。

要理解这一点,我们应该了解错误信息是如何传播的。

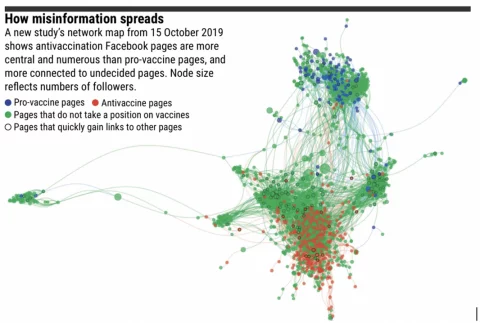

Facebook 的算法针对参与度进行了优化——这通常会推广引起强烈情感反应的内容。 对算法来说重要的是参与度,而不是共享信息的真实性。

有趣的是,当回音室很少时,错误信息不会传播太远。 内容将传播到不同意它的用户,随后对其进行事实检查并将其揭示为错误信息。

然而,在线群体越来越被意识形态信仰所隔离。 在这些泡沫中,错误信息可以在网络中传播很远而不会受到挑战。

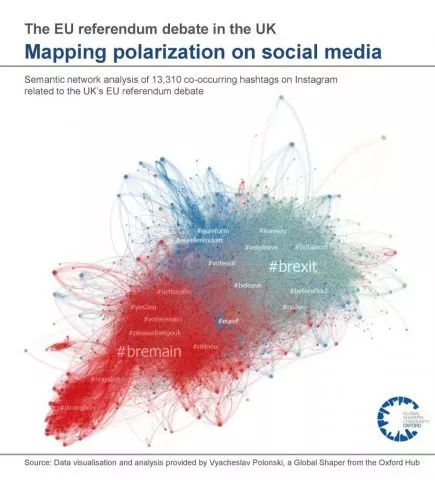

下面是来自英国欧盟公投辩论的回声室的视觉表示:

确认偏差是我们倾向于寻找并相信与我们现有观点一致的信息。 心理学家知道,一旦下定决心,就很难改变。 因此,错误信息旨在利用算法、回声室和确认偏见来扩大和加强现有观点。 这可能导致极端主义。

当它溢出到现实世界中时,这尤其成问题。

错误信息对现实世界的影响示例:

- 源于 QAnon 阴谋论的 2021 年国会大厦袭击

- 加纳、尼日利亚、汤戈、突尼斯和荷兰等国的选举中断

- 与各种错误信息来源有关的 Covid-19 疫苗缺乏吸收

- 右翼极端主义论坛助长了夏洛茨维尔的死亡事件

- “披萨门”枪击案,也源于 QAnon

此外,人们发现错误信息会破坏我们对机构的信任并传播虚假科学,这会影响公共卫生并破坏民主进程。

那么,应该采取什么措施呢?

反对审查的论点

为了打击错误信息的危害,倡导者正在主张加强国家干预以规范社交媒体并消除错误信息。

例如,联合国秘书长安东尼奥·古特雷斯呼吁制定全球规则来规范社交媒体内容。

“我不认为我们可以生活在一个将过多权力赋予少数公司的世界。 我们需要一个新的监管框架,其中包含允许按照法律进行的规则。”

~ 联合国秘书长安东尼奥·古特雷斯

很难不同意这种说法背后的情绪。 如果没有适当的检查,科技公司的力量可能会超出我们的控制范围。

但是,在我们授予机构权力以允许他们决定我们使用哪些信息之前,我们应该考虑潜在的不利因素。

首先,审查社交媒体帖子可能违反了《人权法》的条款,该条款规定:

“每个人都有表达自由的权利。 这项权利应包括持有意见的自由,以及在不受公共当局干预的情况下接收和影响信息和想法的自由。”

~ 《人权法》第 10 条

有趣的是,英国政府目前正在寻求改革《人权法》,以“权利法案”取而代之。

一项提议的改变是,如果个人“维护更广泛的公共利益”(第 56 页,人权改革),个人的人权可能会受到侵犯。 这种变化可能会允许国家对错误信息进行更大的审查。

反对审查错误信息的第二个论点是,它很容易被寻求集中权力的政治政权滥用。 决定什么是——什么不是——错误信息的权力可能导致对抗议、集体行动和政治激进主义的压制。

如果 Twitter 和 Facebook 受到当局的监管,阿拉伯之春会发生吗?

虽然社交媒体在阿拉伯之春中的作用可能被记者夸大了,但仔细的学术分析发现,社交媒体确实导致了政府压迫性国家的积极集体行动的增加。

此外,我们可以查看禁止社交媒体平台的国家/地区的记录:

- 中国

- 俄罗斯

- 伊朗

- 北朝鲜

所有这些国家都在“世界自由指数”中被列为拥有世界上一些最差的公民自由。 我并不是说他们的公民自由很差,因为他们不允许使用社交媒体,而是观察到试图控制在线信息的国家在人权方面往往有不良记录。

即使国家审查不是解决办法,我们也确实有问题。

对传统新闻来源的信任正在迅速消失。 错误信息涌入这个真空,产生了足够强大的风,它已经吹走了我们对真实事物的控制。 这通过疫苗犹豫不决、极端主义加剧和民主进程受到破坏而损害了社会。

但是,下意识的反应,将决定什么是真实的权力交给国家,可能会造成比错误信息更大的伤害。

无论如何,这很可能是对人权的侵犯。

Facebook 解决方案面临的挑战

Facebook 的目标是通过自我监管来防止政府监管。

他们处理错误信息的策略包括:

- 应用机器学习来检测错误信息

- 事实更改标记内容的响应团队

- 与第三方事实核查机构合作验证内容

然而,Facebook 自己也承认这种高度自动化的方法存在局限性。 例如,自动化程序如何确定讽刺网站和故意错误信息之间的区别?

此外,存在大量点击诱饵,其唯一目的是将点击转化为广告收入。 这些通常使用看起来像带有诱人标题的官方新闻网站的模板网站,经常诱使观众点击。

这些网站不是错误信息,但也不是值得信赖的信息来源。

在讽刺和点击诱饵之间,有八卦专栏和舆论新闻。 这是不声称客观的“合法”媒体。 例如,美国右翼媒体评论员本·夏皮罗公开承认,他的新闻网站《每日电讯报》的存在不是为了报道新闻,而是为了“赢得一场文化战争”。 这些出版商典型的旋转和夸张是寻找错误信息的自动化程序的灰色地带。

马克扎克伯格最近表示,“Facebook 在解决错误信息方面做得比任何其他公司都多”。 他可能是对的。 但够了吗?

建议的解决方案

我们已经看到如何解决错误信息是价值观的冲突:言论自由与免受伤害的自由。 任何解决方案都必须寻求平衡两者。

我提供一个潜在的解决方案只是作为一个思想实验——毕竟,在别人的工作中找漏洞更容易,而自己提出建议要困难得多。 诚然,这不是我的专业领域,任何建议充其量都是不切实际的!

有了这个警告,我将提出三点:

- 不要试图审查个人社交媒体帖子中的错误信息

- 在算法上推广权威内容而不是参与度

- 限制回声室

1. 不审查个人帖子中的错误信息

这保护了个人的人权。 它还保护希望使用社交媒体动员反对压迫性政治政权的活动人士。

但这并不是不惜一切代价的言论自由。

Facebook 应继续删除鼓励暴力行为、欺凌、剥削和仇恨言论的内容。

2. 宣传权威内容胜过引人入胜的内容

Facebook 的“EdgeRank”算法决定了您的新闻提要中显示的内容以及显示顺序。

它旨在通过将您的个人兴趣与更广泛的社区与特定帖子的互动方式相结合来个性化您的提要。

Facebook 的算法以高参与度推广内容。 通常,这很有效,您会看到朋友和家人的帖子,以及病毒性模因和猫视频。 然而,同样的机制也促进了情绪化的内容,这往往是分裂的或不真实的。

然而,该算法可以适应以类似于 Google 的 PageRank 算法的方式工作。

谷歌推广权威——而不是引人入胜的——内容。 它通过分析其他网站以超链接或“反向链接”的形式引用一段内容的次数来做到这一点。 例如,我向您介绍 Google 的 PageRank 算法如何工作的详细分类是该页面可信度的指标。

当个人将网站上的文章发布到 Facebook 上时,Facebook 不一定需要对该网站进行事实核查。 相反,它可以以类似于谷歌的方式通过算法确定网站的权限。

如果新闻来源是权威的,例如 BBC,它将在新闻提要中优先于错误信息、垃圾邮件或点击诱饵。

至关重要的是,这个过程是去中心化的。

没有人认为 BBC 是权威的。 相反,这个结论是众包的结果。

数以百万计的个人网站都引用了 BBC,就像权威学者的作品合法时会收到引用一样。 因此,集中控制的风险被最小化。

这种提议的解决方案将减少错误信息的传播范围,而无需 Facebook 成为互联网的警察。

那么为什么 Facebook 还没有尝试过这样的事情呢?

嗯,这会减少他们的广告收入。 宣传权威内容而不是引人入胜的内容会使您的新闻提要有点……嗯,无聊。 这意味着在平台上花费的时间更少,点击次数更少,广告收入也更少。

还有一个小问题是 Google 拥有 PageRank 的知识产权。 Facebook 需要开发自己的算法,以提供类似的结果,但有足够不同的方法来避免知识产权侵权。

我确实说过这些只是受不切实际限制的思想实验!

3. 限制回声室

研究表明,在回声室较少的地方,错误信息不会传播太远。 此外,群体极化理论表明,回声室将整个群体移动到更极端的位置。

这表明也许错误信息不是问题——也许是回声室……

在隔离用户集群较少的网络中,错误信息传播的距离较短,对其所接触的人的影响也较小。 问题是“隔离用户集群”这个短语是“社区”的一种技术表达方式!

社区是 Facebook 的核心,但它也是推动两极分化的原因。

因此,移除回声室是不可行的,但可以采取措施限制它们的危害。

这些步骤可能包括:

- Facebook 可以为用户提供一项功能,以关闭我们新闻源中的个性化,这样我们就可以看到其他人正在消费什么,而无需算法。

- Facebook 可以标记高度两极分化或党派的内容,并提供选项以从相反的角度查看内容

- 验证徽章可以放置在符合新闻行为准则的内容上

此外,可以提供教育以帮助个人走出自己的回声室。 我们有责任寻求“否认”。

这对我们来说并不自然,但成为一个知情的公民意味着消费我们可能不一定同意的信息。

我们都将从不太确定中受益。

概括

社会联系构成了我们社会的结构。 但是,我们形成志同道合社区的倾向可能会被利用,从而导致错误信息和分裂。 审查制度的警笛声似乎是一个吸引人的解决方案,但它可能会引诱我们走向我们最好避免的岩石。

删除共识之外的声明似乎是可取的,但可能会使问题变得更糟。 审查制度甚至可能使人们对权威的信任度降低,将更恶意的观点推向地下,从而传播开来。

相反,我们应该寻求去中心化的解决方案。

在保护我们的基本人权——言论自由权的同时,最大限度地减少错误信息的危害的解决方案。