¿Cómo deben responder las redes sociales a la desinformación?

Publicado: 2022-03-09Como sociedad, tenemos una relación complicada con las redes sociales. Cuando escuchamos sobre el acoso en línea, la desinformación y el discurso de odio, condenamos con razón la fea sombra que arroja sobre la sociedad. Pero cuando Rusia prohíbe Facebook en un intento de controlar la narrativa sobre Ucrania, se siente como si se estuviera arrebatando un derecho humano fundamental.

Nuestra confusión se debe a un conflicto de valores: libertad de expresión vs libertad de daño. Y es uno de los debates más importantes de nuestro tiempo. Pero también es un debate que se ha vuelto demasiado simplificado, polarizado y tribal.

¿Cuáles son los dos lados de este debate?

Un lado es la libertad de expresión de los absolutistas que no quieren reglas. Han impulsado el surgimiento de nuevas plataformas de redes sociales, como "Truth Social" de Gab y Donald Trump, que no tienen límites en lo que publicas. Han descendido rápidamente al nacionalismo blanco, el antisemitismo y las teorías de conspiración de QAnon.

El otro lado busca una mayor regulación estatal de las redes sociales. Esto ha resultado en nuevas iniciativas como Google Fact Check, Good Information Inc y Trusted News Summit, que buscan verificar lo que es cierto. Este lado a menudo subestima los riesgos de otorgar poderes a un estado para vigilar Internet. Ejemplos de cómo esto puede salir mal son las medidas enérgicas contra las redes sociales por parte de regímenes políticos que buscan controlar el libre flujo de información.

Usando Meta (uso "Facebook" para distinguir la plataforma de redes sociales específica) como ejemplo, examinaré ambos lados del debate y propondré una solución destinada a resolver el conflicto de valores.

Facebook bajo fuego

Casi una cuarta parte de la población mundial está en Facebook, lo que la convierte en la plataforma de redes sociales más popular del mundo.

Pero la credibilidad de su misión declarada, "construir una comunidad y acercar al mundo" ha sido criticada recientemente.

Los denunciantes han acusado a Facebook de elegir a sabiendas las ganancias por encima de la sociedad; Argumentan que, al promover la desinformación, Facebook está menoscabando la integridad del proceso democrático. Además, se argumenta que la desinformación en las redes sociales ha debilitado la capacidad de la sociedad para responder de manera efectiva a la pandemia.

Mark Zuckerberg respondió con lo siguiente:

“La idea de que permitimos que la información errónea se infecte en nuestra plataforma, o que de alguna manera nos beneficiamos de este contenido, es incorrecta”.

La defensa de Facebook es que tienen más socios de verificación de hechos que cualquier otra plataforma tecnológica. Sus esfuerzos son ciertamente impresionantes, eliminando más de 5 millones de piezas de contenido odioso cada mes.

Facebook también te indicará los estándares de su comunidad, que enumeran 4 tipos de contenido sobre los que pueden tomar medidas:

- Comportamiento violento y criminal.

- Preocupaciones de seguridad (como intimidación, abuso infantil, explotación)

- Contenido objetable, como pornografía e incitación al odio.

- Contenido no auténtico (como información errónea)

De estos, hay poca controversia sobre los puntos 1 a 3. Existe un amplio acuerdo en que Facebook debe actuar para prevenir los daños causados por la violencia, el acoso y la incitación al odio.

Es el punto 4, la desinformación, el que es controvertido.

El auge de la desinformación

A veces parece que estamos preparados para creer simultáneamente en todo y en nada.

Y este sentimiento no es nuevo.

En 1835, el periódico New York Sun afirmó que había una civilización extraterrestre en la luna. Se vendió tan bien que estableció al New York Sun como una publicación líder.

Sin embargo, la información errónea dirigida como una forma de control psicológico solo ha aumentado con el auge de la comunicación digital.

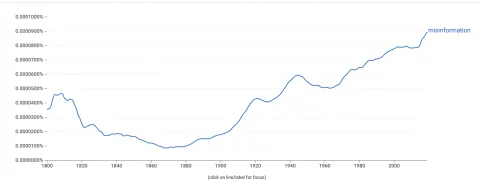

El visor Google Ngram, que mide la frecuencia con la que aparecen las palabras en los libros, muestra un fuerte aumento en el uso de la palabra "desinformación".  Para entender esto, debemos entender cómo se propaga la información errónea.

Para entender esto, debemos entender cómo se propaga la información errónea.

Los algoritmos de Facebook están optimizados para la participación; esto a menudo promueve contenido que provoca una fuerte respuesta emotiva. Lo que es importante para el algoritmo es el compromiso, no la veracidad de la información que se comparte.

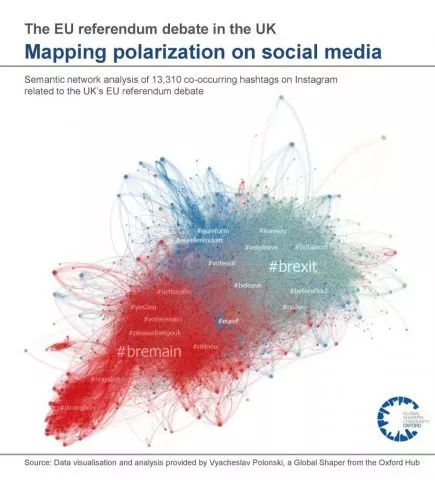

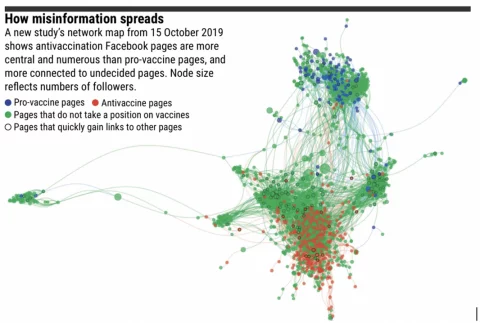

Curiosamente, la desinformación no viaja muy lejos cuando hay pocas cámaras de eco. El contenido viajará tan lejos como un usuario que no esté de acuerdo con él, quien posteriormente lo verificará y lo revelará como información errónea.

Sin embargo, los grupos en línea están cada vez más segregados por creencias ideológicas. En estas burbujas, la información errónea puede viajar lejos a través de la red sin ser cuestionada.

A continuación se muestra una representación visual de las cámaras de eco del debate del referéndum sobre la UE en el Reino Unido:

El sesgo de confirmación es nuestra tendencia a buscar y creer información que se alinea con nuestros puntos de vista existentes. Los psicólogos saben que una vez que la mente de alguien está decidida, es difícil cambiarla. Entonces, en cambio, la desinformación tiene como objetivo explotar algoritmos, cámaras de eco y sesgos de confirmación para amplificar y fortalecer las opiniones existentes . Esto puede conducir al extremismo.

Esto es particularmente problemático cuando se extiende al mundo real.

Ejemplos del impacto de la desinformación en el mundo real:

- Los ataques al Capitolio de 2021, con raíces en la teoría de la conspiración de QAnon

- Elecciones interrumpidas en países como Ghana, Nigeria, Tongo, Túnez y Holanda

- La falta de aceptación de las vacunas contra el covid-19 está relacionada con una variedad de fuentes de información errónea

- Las muertes en Charlottesville, alimentadas por foros de extrema derecha

- Tiroteos de 'Pizzagate', también con raíces en QAnon

Además, se ha descubierto que la información errónea socava nuestra confianza en las instituciones y difunde ciencia falsa, lo que afecta la salud pública e interrumpe el proceso democrático.

Entonces, ¿qué acción se debe tomar?

El argumento contra la censura

Para combatir los daños de la desinformación, los defensores abogan por una mayor intervención estatal para regular las redes sociales y eliminar la información errónea.

Por ejemplo, el jefe de las Naciones Unidas, el secretario general Antonio Guterres, pidió reglas globales para regular el contenido de las redes sociales.

“No creo que podamos vivir en un mundo donde se da demasiado poder a un número reducido de empresas. Necesitamos un nuevo marco regulatorio con reglas que permitan que eso se haga de acuerdo con la ley”.

~ Jefe de las Naciones Unidas, Secretario General Antonio Guterres

Es difícil estar en desacuerdo con el sentimiento detrás de esta declaración. Sin los controles adecuados, el poder de las empresas de tecnología podría aumentar más allá de nuestro control.

Sin embargo, antes de otorgar poderes a los organismos que les permitan decidir qué información consumimos, debemos considerar las posibles desventajas.

En primer lugar, censurar las publicaciones en las redes sociales puede ser una violación del artículo de la Ley de derechos humanos, que establece:

“Toda persona tiene derecho a la libertad de expresión. Este derecho incluirá la libertad de opinar y de recibir e incidir en información e ideas sin interferencia de la autoridad pública.”

~ Artículo 10 de la Ley de Derechos Humanos

Curiosamente, el gobierno del Reino Unido actualmente está buscando reformar la Ley de derechos humanos, reemplazándolos con una "Declaración de derechos".

Un cambio propuesto es que se podrían violar los derechos humanos de una persona si “salvaguarda el interés público más amplio” (página 56, Reforma de los derechos humanos). Este cambio puede permitir una mayor censura de la información errónea por parte del estado.

Un segundo argumento contra la censura de la desinformación es que está abierta al abuso por parte de regímenes políticos que buscan centralizar el poder. El poder de decidir qué es y qué no es información errónea podría llevar a una represión de las protestas, la acción colectiva y el activismo político.

¿Podría haber ocurrido la Primavera Árabe si Twitter y Facebook hubieran sido vigilados por las autoridades?

Si bien es probable que los periodistas exageren el papel de las redes sociales en la Primavera Árabe, un análisis académico cuidadoso ha encontrado que las redes sociales han llevado a un aumento de la acción colectiva positiva en países con gobiernos opresores.

Además, podemos ver el historial de países que han prohibido las plataformas de redes sociales:

- Porcelana

- Rusia

- Irán

- Corea del Norte

Todos estos países figuran en el "Índice de libertad en el mundo" por tener algunas de las peores libertades civiles del mundo. No estoy argumentando que tienen pocas libertades civiles porque no permiten las redes sociales, sino que observo que los estados que intentan controlar la información en línea tienden a tener malos antecedentes en lo que respecta a los derechos humanos.

Incluso si la censura estatal no es la solución, tenemos un problema.

La confianza en las fuentes de noticias tradicionales se está evaporando rápidamente. En este vacío se precipita la información errónea, creando un viento lo suficientemente fuerte como para que nos haya quitado el control de lo que es verdad. Esto ha dañado a la sociedad a través de la vacilación de las vacunas, el aumento del extremismo y la interrupción de los procesos democráticos.

Pero una reacción instintiva, con entregar al estado el poder de decidir qué es verdad, podría causar un daño mayor que la desinformación.

Y de todos modos, es probable que sea una violación de los derechos humanos.

Desafíos a la solución de Facebook

El objetivo de Facebook es evitar la regulación por parte de los gobiernos a través de la autorregulación.

Su estrategia para abordar la desinformación incluye:

- Aplicar el aprendizaje automático para detectar información errónea

- Equipos de respuesta para cambiar contenido marcado

- Asociarse con organizaciones de verificación de hechos de terceros para verificar el contenido

Sin embargo, los propios Facebook admitirán las limitaciones de este enfoque en gran medida automatizado. Por ejemplo, ¿cómo determinaría un programa automatizado la diferencia entre sitios web satíricos e información errónea intencional?

Además, existen grandes cantidades de clickbait con el único propósito de convertir los clics en ingresos publicitarios. Estos a menudo usan sitios con plantillas que parecen sitios web de noticias oficiales con titulares atractivos, a menudo engañando a los espectadores para que hagan clic.

Estos sitios no son información errónea, pero tampoco son fuentes confiables de información.

Entre la sátira y el clickbait, hay columnas de chismes y periodismo de opinión. Se trata de medios “legítimos” que no pretenden objetividad. Por ejemplo, Ben Shapiro, un comentarista de los medios estadounidenses de derecha, admite abiertamente que su sitio web de noticias, The Daily Wire, existe no para informar las noticias sino para "ganar una guerra cultural". El giro y la exageración típicos de estos editores es un área gris para los programas automatizados que buscan información errónea.

Mark Zuckerberg ha dicho recientemente que “Facebook hace más para abordar la desinformación que cualquier otra empresa”. Puede que tenga razón. ¿Pero es suficiente?

Una solución propuesta

Hemos visto cómo la solución a la desinformación es un conflicto de valores: libertad de expresión vs libertad de daño. Cualquier solución debe buscar el equilibrio de los dos.

Ofrezco una solución potencial solo como un experimento mental; después de todo, es más fácil detectar fallas en el trabajo de otros y mucho más difícil sugerir algo uno mismo. Es cierto que esta no es mi área de especialización y cualquier sugerencia será poco práctica en el mejor de los casos.

Con esa advertencia dicha, propondría tres puntos:

- No busque censurar información errónea en las publicaciones de redes sociales de un individuo.

- Promover contenido autorizado sobre el compromiso algorítmicamente

- Limitar las cámaras de eco

1. No censurar la información errónea en las publicaciones de las personas.

Esto protege los derechos humanos de un individuo. También protege a los activistas que deseen utilizar las redes sociales para movilizarse contra los regímenes políticos opresivos.

Pero esto no es libertad de expresión a toda costa.

Facebook debe continuar eliminando contenido que fomente el comportamiento violento, el acoso, la explotación y el discurso de odio.

2. Promover contenido autorizado sobre contenido atractivo

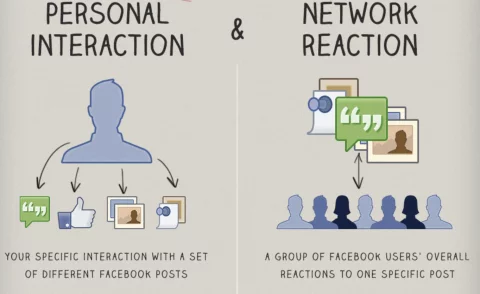

El algoritmo “EdgeRank” de Facebook determina qué contenido se muestra en su fuente de noticias y en qué orden.

Busca personalizar su feed a través de una combinación de sus intereses personales con la forma en que la comunidad en general ha interactuado con una publicación en particular.

El algoritmo de Facebook promueve contenido con alto compromiso. A menudo, esto funciona bien y ves publicaciones de amigos y familiares, junto con memes virales y videos de gatos. Sin embargo, el mismo mecanismo también promueve el contenido emotivo, que a menudo es divisivo o falso.

Sin embargo, el algoritmo podría adaptarse para funcionar de manera similar al algoritmo PageRank de Google.

Google promueve contenido autorizado, en lugar de atractivo. Lo hace analizando cuántas veces otros sitios web hacen referencia a un contenido en forma de hipervínculos o "vínculos de retroceso". Por ejemplo, si te refiero a este desglose detallado de cómo funciona el algoritmo PageRank de Google, es un indicador de la confiabilidad de esa página.

Cuando una persona publica un artículo de un sitio web en Facebook, Facebook no necesariamente necesita verificar el sitio web. En cambio, podría determinar algorítmicamente la autoridad del sitio web de manera similar a Google.

Si la fuente de noticias es autorizada, como la BBC, se le dará prioridad en las fuentes de noticias sobre la información errónea, el spam o el clickbait.

Críticamente, este proceso está descentralizado.

Nadie ha decidido que la BBC tiene autoridad. En cambio, esta conclusión es el resultado del crowdsourcing.

Millones de sitios web individuales han hecho referencia a la BBC, al igual que un académico autorizado recibe citas si su trabajo es legítimo. Por lo tanto, se minimizan los riesgos del control centralizado.

Esta solución propuesta disminuiría el alcance de la desinformación sin necesidad de que Facebook se convierta en la policía de Internet.

Entonces, ¿por qué Facebook no ha intentado algo como esto ya?

Bueno, disminuiría sus ingresos publicitarios. Promocionar contenido de autoridad sobre contenido atractivo haría que tu fuente de noticias fuera un poco... bueno, aburrida. Esto significa menos tiempo dedicado a la plataforma, menos clics y menos ingresos publicitarios.

También está el pequeño problema de que Google posee la propiedad intelectual de PageRank. Facebook necesitaría desarrollar su propio algoritmo que pudiera ofrecer resultados similares, pero que tuviera métodos suficientemente diferentes para evitar la infracción de propiedad intelectual.

¡Dije que estos eran solo experimentos mentales limitados por la impracticabilidad!

3. Limite las cámaras de eco

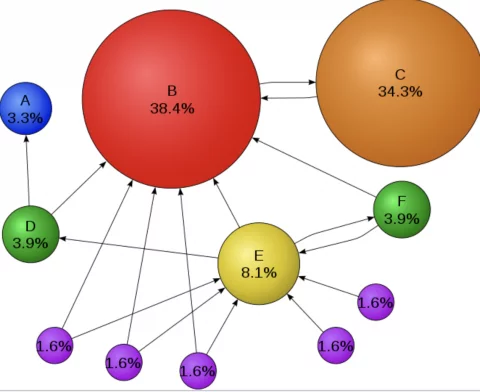

La investigación sugiere que la información errónea no viaja muy lejos donde hay menos cámaras de eco. Además, la teoría de la polarización de grupos sugiere que las cámaras de eco mueven grupos enteros a posiciones más extremas.

Esto sugiere que tal vez la desinformación no sea el problema, tal vez sean las cámaras de eco...

En una red con menos grupos de usuarios segregados, la desinformación viaja menos lejos y tiene un impacto menor en aquellos a los que llega. ¡El problema es que la frase "grupo de usuarios segregados" es una forma técnica de decir "la comunidad"!

La comunidad está en el corazón de Facebook, pero también es lo que está impulsando la polarización.

Por lo tanto, eliminar las cámaras de eco no es viable, pero se podrían tomar medidas para limitar su daño.

Estos pasos podrían incluir:

- Facebook podría proporcionar una función para que los usuarios desactiven la personalización en nuestras fuentes de noticias para que podamos ver lo que otros consumen, sin algoritmos.

- Facebook podría marcar contenido altamente polarizado o partidista y brindar opciones para verlo junto con contenido desde el punto de vista opuesto.

- Se podrían colocar insignias de verificación en contenido que cumpla con el código de conducta periodístico.

Además, se podría proporcionar educación para ayudar a las personas a salir de sus propias cámaras de eco. Tenemos la responsabilidad de buscar la "desconfirmación".

No es natural para nosotros, pero ser un ciudadano informado significa consumir información con la que no necesariamente estamos de acuerdo.

Todos nos beneficiaríamos de estar un poco menos seguros.

Resumen

Las conexiones sociales forman el tejido de nuestra sociedad. Pero nuestra misma tendencia a formar comunidades de ideas afines puede ser explotada, lo que lleva a la desinformación y la división. El canto de sirena de la censura puede parecer una solución atractiva, pero puede atraernos hacia una roca que es mejor evitar.

Quitar las afirmaciones fuera del consenso puede parecer deseable, pero es probable que empeore el problema. La censura puede incluso hacer que la gente confíe menos en la autoridad, empujando las opiniones más maliciosas a la clandestinidad donde podría propagarse.

En cambio, deberíamos buscar soluciones descentralizadas.

Soluciones que minimicen el daño de la desinformación mientras protegen nuestros derechos humanos fundamentales: el derecho a la libertad de expresión.