Come dovrebbero reagire i social media alla disinformazione?

Pubblicato: 2022-03-09Come società, abbiamo una relazione complicata con i social media. Quando sentiamo parlare di bullismo online, disinformazione e incitamento all'odio, giustamente condanniamo la brutta ombra che getta sulla società. Ma quando la Russia mette al bando Facebook nel tentativo di controllare la narrativa sull'Ucraina, sembra che un diritto umano fondamentale venga portato via.

La nostra confusione è dovuta a un conflitto di valori: libertà di espressione vs libertà dal male. Ed è uno dei dibattiti più importanti del nostro tempo. Ma è anche un dibattito diventato eccessivamente semplificato, polarizzato e tribale.

Quali sono le due facce di questo dibattito?

Un lato è la libertà di parola assolutisti che non vogliono regole. Hanno alimentato l'ascesa di nuove piattaforme di social media, come "Truth Social" di Gab e Donald Trump, che non hanno limiti su ciò che pubblichi. Sono rapidamente scesi nel nazionalismo bianco, nell'antisemitismo e nelle teorie del complotto di QAnon.

L'altra parte è alla ricerca di una maggiore regolamentazione statale dei social media. Ciò ha portato a nuove iniziative come Google Fact Check, Good Information Inc e Trusted News Summit, che cercano di verificare ciò che è vero. Questa parte spesso sottovaluta i rischi di concedere a uno stato poteri di polizia su Internet. Esempi di come ciò possa andare storto sono le repressioni dei social media da parte dei regimi politici che cercano di controllare il libero flusso di informazioni.

Utilizzando Meta (uso “Facebook” per distinguere la specifica piattaforma di social media) come esempio, esaminerò entrambi i lati del dibattito e proporrò una soluzione mirata a risolvere il conflitto di valori.

Facebook sotto tiro

Quasi un quarto della popolazione mondiale è su Facebook, il che lo rende la piattaforma di social media più popolare al mondo.

Ma la credibilità della loro missione dichiarata, quella di "costruire una comunità e avvicinare il mondo" è stata recentemente messa sotto accusa.

Gli informatori hanno accusato Facebook di scegliere consapevolmente il profitto rispetto alla società; Essi sostengono che, promuovendo la disinformazione, Facebook sta sminuendo l'integrità del processo democratico. Inoltre, si sostiene che la disinformazione sui social media abbia indebolito la capacità della società di rispondere efficacemente alla pandemia.

Mark Zuckerberg ha risposto con quanto segue:

"L'idea che consentiamo che la disinformazione si inasprisca sulla nostra piattaforma, o che in qualche modo traiamo vantaggio da questo contenuto, è sbagliata".

La difesa di Facebook è che hanno più partner di verifica dei fatti rispetto a qualsiasi altra piattaforma tecnologica. I loro sforzi sono certamente impressionanti, rimuovendo oltre 5 milioni di contenuti odiosi ogni mese.

Facebook ti indicherà anche gli standard della loro community, che elencano 4 tipi di contenuti su cui possono intervenire:

- Comportamento violento e criminale

- Problemi di sicurezza (come bullismo, abusi sui minori, sfruttamento)

- Contenuti discutibili, come pornografia e incitamento all'odio

- Contenuti non autentici (come disinformazione)

Di questi, c'è poca controversia sui punti da 1 a 3. C'è un ampio consenso sul fatto che Facebook dovrebbe agire per prevenire i danni causati dalla violenza, dal bullismo e dall'incitamento all'odio.

È il punto 4, disinformazione, che è controverso.

L'aumento della disinformazione

A volte sembra che siamo pronti a credere contemporaneamente a tutto e niente.

E questa sensazione non è nuova.

Nel 1835, il quotidiano New York Sun affermò che c'era una civiltà aliena sulla luna. Vendette così bene che affermò il New York Sun come pubblicazione leader.

Tuttavia, la disinformazione mirata come forma di controllo psicologico è aumentata solo con l'ascesa della comunicazione digitale.

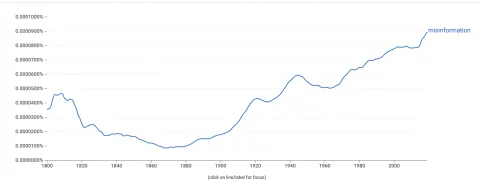

Il visualizzatore di Google Ngram, che misura la frequenza con cui le parole appaiono nei libri, mostra un forte aumento del nostro uso della parola "disinformazione".  Per capirlo, dovremmo capire come si diffonde la disinformazione.

Per capirlo, dovremmo capire come si diffonde la disinformazione.

Gli algoritmi di Facebook sono ottimizzati per il coinvolgimento: questo spesso promuove contenuti che suscitano una forte risposta emotiva. Ciò che è importante per l'algoritmo è il coinvolgimento, non la veridicità delle informazioni condivise.

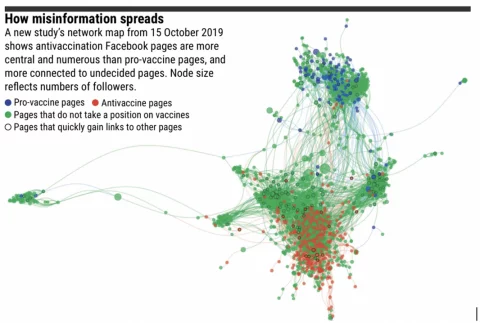

È interessante notare che la disinformazione non va lontano quando ci sono poche camere d'eco. Il contenuto arriverà fino a un utente che non è d'accordo con esso, che successivamente lo verifica e lo rivela come disinformazione.

Tuttavia, i gruppi online sono sempre più segregati da convinzioni ideologiche. In queste bolle, la disinformazione può viaggiare molto attraverso la rete senza essere contestata.

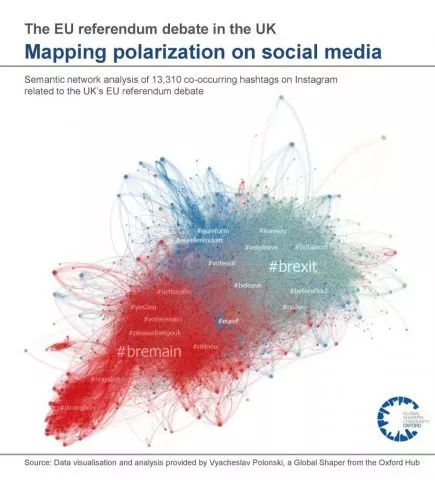

Di seguito è riportata una rappresentazione visiva delle camere d'eco dal dibattito referendario dell'UE nel Regno Unito:

Il bias di conferma è la nostra tendenza a cercare e credere alle informazioni che si allineano con le nostre opinioni esistenti. È noto agli psicologi che una volta che la mente di qualcuno è decisa, è difficile cambiarla. Quindi, invece, la disinformazione mira a sfruttare algoritmi, camere d'eco e bias di conferma per amplificare e rafforzare le opinioni esistenti . Questo può portare all'estremismo.

Questo è particolarmente problematico quando si riversa nel mondo reale.

Esempi dell'impatto nel mondo reale della disinformazione:

- Gli attacchi al Campidoglio del 2021, con radici nella teoria del complotto QAnon

- Elezioni interrotte in paesi tra cui Ghana, Nigeria, Tongo, Tunisia e Olanda

- Mancanza di assorbimento dei vaccini Covid-19 legata a una varietà di fonti di disinformazione

- Le morti a Charlottesville, alimentate da forum di estremisti di destra

- Sparatoria 'Pizzagate', anch'essa con radici a QAnon

Inoltre, è stato riscontrato che la disinformazione mina la nostra fiducia nelle istituzioni e diffonde una falsa scienza, che ha un impatto sulla salute pubblica e sconvolge il processo democratico.

Quindi, quale azione dovrebbe essere intrapresa?

L'argomento contro la censura

Al fine di combattere i danni della disinformazione, i sostenitori stanno sostenendo un maggiore intervento statale per regolamentare i social media e rimuovere la disinformazione.

Ad esempio, il capo delle Nazioni Unite, il segretario generale Antonio Guterres, ha chiesto regole globali per regolamentare i contenuti dei social media.

“Non credo che si possa vivere in un mondo in cui viene dato troppo potere a un numero ridotto di aziende. Abbiamo bisogno di un nuovo quadro normativo con regole che consentano che ciò avvenga in linea con la legge”.

~ Capo delle Nazioni Unite, Segretario Generale Antonio Guterres

È difficile non essere d'accordo con il sentimento dietro questa affermazione. Senza controlli appropriati, il potere delle aziende tecnologiche potrebbe aumentare al di là del nostro controllo.

Tuttavia, prima di concedere poteri agli organismi che consentiranno loro di decidere quali informazioni consumiamo, dovremmo considerare i potenziali svantaggi.

In primo luogo, la censura dei post sui social media può essere una violazione dell'articolo della legge sui diritti umani, che afferma:

“Ognuno ha diritto alla libertà di espressione. Questo diritto include la libertà di esprimere opinioni e di ricevere e influenzare informazioni e idee senza interferenze da parte dell'autorità pubblica.

~ Articolo 10 della legge sui diritti umani

È interessante notare che il governo del Regno Unito sta attualmente cercando di riformare la legge sui diritti umani, sostituendola con una "Carta dei diritti".

Un cambiamento proposto è che i diritti umani di un individuo potrebbero essere violati se "salvaguarda il più ampio interesse pubblico" (pagina 56, Riforma dei diritti umani). Questo cambiamento potrebbe consentire una maggiore censura della disinformazione da parte dello stato.

Un secondo argomento contro la censura della disinformazione è che è aperta agli abusi da parte dei regimi politici che cercano di centralizzare il potere. Il potere di decidere cosa è – e cosa non lo è – disinformazione potrebbe portare a una repressione della protesta, dell'azione collettiva e dell'attivismo politico.

La primavera araba sarebbe potuta accadere se Twitter e Facebook fossero stati sorvegliati dalle autorità?

Sebbene il ruolo dei social media nella Primavera Araba sia probabilmente sopravvalutato dai giornalisti, un'attenta analisi accademica ha scoperto che i social media hanno effettivamente portato a un aumento dell'azione collettiva positiva nei paesi con governi oppressivi.

Inoltre, possiamo esaminare il track record dei paesi che hanno vietato le piattaforme di social media:

- Cina

- Russia

- Iran

- Corea del nord

Tutti questi paesi sono elencati nell '"Indice della libertà nel mondo" come aventi alcune delle peggiori libertà civili al mondo. Non sto sostenendo che hanno scarse libertà civili perché non consentono i social media, piuttosto osservo che gli stati che cercano di controllare le informazioni online tendono ad avere pessimi record quando si tratta di diritti umani.

Anche se la censura statale non è la soluzione, abbiamo un problema.

La fiducia nelle fonti di notizie tradizionali sta rapidamente svanendo. In questo vuoto si precipita la disinformazione, creando un vento abbastanza forte da aver spazzato via la nostra presa su ciò che è vero. Ciò ha danneggiato la società attraverso l'esitazione sui vaccini, l'aumento dell'estremismo e l'interruzione dei processi democratici.

Ma una reazione istintiva, con la consegna allo stato del potere di decidere ciò che è vero, potrebbe creare danni maggiori della disinformazione.

E comunque, è probabile che si tratti di una violazione dei diritti umani.

Sfide alla soluzione di Facebook

L'obiettivo di Facebook è prevenire la regolamentazione da parte dei governi attraverso l'autoregolamentazione.

La loro strategia per combattere la disinformazione include:

- Applicazione dell'apprendimento automatico per rilevare la disinformazione

- Team di risposta per modificare i contenuti segnalati

- Collaborazione con organizzazioni di verifica dei fatti di terze parti per verificare il contenuto

Tuttavia, Facebook stesso ammetterà limitazioni a questo approccio ampiamente automatizzato. Ad esempio, in che modo un programma automatizzato determinerebbe la differenza tra siti Web satirici e disinformazione intenzionale?

Inoltre, esistono enormi quantità di clickbait al solo scopo di trasformare i clic in entrate pubblicitarie. Questi spesso utilizzano siti basati su modelli che sembrano siti Web di notizie ufficiali con titoli allettanti, spesso inducendo gli spettatori a fare clic.

Questi siti non sono disinformazione, ma non sono nemmeno fonti di informazioni affidabili.

Tra satira e clickbait, ci sono rubriche di gossip e giornalismo d'opinione. Si tratta di media “legittimi” che non fanno pretese di obiettività. Ad esempio, Ben Shapiro, un commentatore dei media americano di destra, ammette apertamente che il suo sito web di notizie, The Daily Wire, non esiste per riportare le notizie ma per "vincere una guerra culturale". La rotazione e l'esagerazione tipiche di questi editori sono un'area grigia per i programmi automatizzati in cerca di disinformazione.

Mark Zuckerberg ha recentemente affermato che "Facebook fa di più per affrontare la disinformazione di qualsiasi altra azienda". Potrebbe avere ragione. Ma basta?

Una proposta di soluzione

Abbiamo visto come la soluzione alla disinformazione sia un conflitto di valori: libertà di espressione vs libertà dal male. Qualsiasi soluzione deve cercare di bilanciare i due.

Offro una potenziale soluzione solo come esperimento mentale: dopotutto, è più facile trovare buchi nel lavoro degli altri e molto più difficile suggerire qualcosa da soli. Certo, questa non è la mia area di competenza e qualsiasi suggerimento sarà al massimo impraticabile!

Detto questo avvertimento, proporrei tre punti:

- Non cercare di censurare la disinformazione nei post sui social media di un individuo

- Promuovi contenuti autorevoli rispetto al coinvolgimento in modo algoritmico

- Limitare le camere d'eco

1. Non censurare la disinformazione nei post delle persone

Questo protegge i diritti umani di un individuo. Salvaguarda anche gli attivisti che desiderano utilizzare i social media per mobilitarsi contro regimi politici oppressivi.

Ma questa non è libertà di parola a tutti i costi.

Facebook dovrebbe continuare a rimuovere i contenuti che incoraggiano comportamenti violenti, bullismo, sfruttamento e incitamento all'odio.

2. Promuovere contenuti autorevoli rispetto a contenuti coinvolgenti

L'algoritmo "EdgeRank" di Facebook determina quale contenuto viene mostrato nel feed delle notizie e in quale ordine.

Cerca di personalizzare il tuo feed attraverso una combinazione dei tuoi interessi personali con il modo in cui la comunità più ampia ha interagito con un determinato post.

L'algoritmo di Facebook promuove contenuti ad alto coinvolgimento. Spesso funziona bene e vedi i post di amici e familiari, insieme a meme virali e video di gatti. Tuttavia, lo stesso meccanismo promuove anche il contenuto emotivo, che è spesso divisivo o falso.

L'algoritmo, tuttavia, potrebbe essere adattato per funzionare in modo simile all'algoritmo PageRank di Google.

Google promuove contenuti autorevoli, anziché coinvolgenti. Lo fa analizzando quante volte altri siti Web fanno riferimento a un contenuto sotto forma di collegamenti ipertestuali o "link a ritroso". Ad esempio, il fatto che ti riferisco a questa analisi dettagliata di come funziona l'algoritmo PageRank di Google è un indicatore dell'affidabilità di quella pagina.

Quando un individuo pubblica un articolo da un sito Web su Facebook, Facebook non deve necessariamente controllare il sito Web. Invece, potrebbe determinare algoritmicamente l'autorità del sito Web in modo simile a Google.

Se la fonte di notizie è autorevole, come la BBC, avrebbe la priorità nei feed di notizie rispetto a disinformazione, spam o clickbait.

Fondamentalmente, questo processo è decentralizzato.

Nessuno ha deciso che la BBC sia autorevole. Invece, questa conclusione è il risultato del crowdsourcing.

Milioni di singoli siti web hanno fatto riferimento alla BBC, proprio come un autorevole studioso riceve citazioni se il suo lavoro è legittimo. Pertanto, i rischi del controllo centralizzato sono ridotti al minimo.

Questa soluzione proposta ridurrebbe la portata della disinformazione senza la necessità che Facebook diventi la polizia di Internet.

Allora perché Facebook non ha già provato qualcosa del genere?

Ebbene, diminuirebbe i loro introiti pubblicitari. Promuovere contenuti autorevoli rispetto a contenuti coinvolgenti renderebbe il tuo feed di notizie un po'... beh, noioso. Ciò significa meno tempo trascorso sulla piattaforma, meno clic e meno entrate pubblicitarie.

C'è anche il piccolo problema che Google possiede la proprietà intellettuale di PageRank. Facebook dovrebbe sviluppare il proprio algoritmo che potrebbe fornire risultati simili, ma disporre di metodi sufficientemente diversi per evitare la violazione della PI.

Ho detto che questi erano solo esperimenti mentali limitati dall'impraticabilità!

3. Limitare le camere d'eco

La ricerca suggerisce che la disinformazione non viaggia lontano dove ci sono meno camere d'eco. Inoltre, la teoria della polarizzazione di gruppo suggerisce che le camere d'eco spostano interi gruppi in posizioni più estreme.

Questo suggerisce che forse la disinformazione non è il problema, forse sono le camere d'eco...

In una rete con meno gruppi di utenti segregati, la disinformazione viaggia meno lontano e ha un impatto ridotto su coloro che raggiunge. Il problema è che l'espressione “cluster di utenti segregati” è un modo tecnico per dire “la comunità”!

La community è al centro di Facebook, ma è anche ciò che sta guidando la polarizzazione.

Quindi, la rimozione delle camere d'eco non è praticabile, ma si potrebbero adottare misure per limitarne i danni.

Questi passaggi potrebbero includere:

- Facebook potrebbe fornire agli utenti una funzione per disattivare la personalizzazione nei nostri feed di notizie in modo da poter vedere cosa stanno consumando gli altri, senza algoritmi.

- Facebook potrebbe segnalare contenuti altamente polarizzati o di parte e fornire opzioni per visualizzarli insieme ai contenuti da un punto di vista opposto

- I badge di verifica possono essere apposti su contenuti conformi al codice di condotta giornalistico

Inoltre, l'istruzione potrebbe essere fornita per aiutare le persone a uscire dalle proprie camere d'eco. Abbiamo la responsabilità di cercare la "disconferma".

Non è naturale per noi, ma essere un cittadino informato significa consumare informazioni con cui potremmo non essere necessariamente d'accordo.

Tutti trarremmo vantaggio dall'essere un po' meno sicuri.

Sommario

Le connessioni sociali formano il tessuto della nostra società. Ma la nostra stessa tendenza a formare comunità che la pensano allo stesso modo può essere sfruttata, portando a disinformazione e divisione. La sirena della censura può sembrare una soluzione allettante, ma potrebbe attirarci verso una roccia che è meglio evitare.

Rimuovere le affermazioni al di fuori del consenso può sembrare auspicabile, ma è probabile che peggiori il problema. La censura può persino rendere le persone meno fiduciose nell'autorità, spingendo le opinioni più dannose sottoterra dove potrebbe diffondersi.

Invece, dovremmo cercare soluzioni decentralizzate.

Soluzioni che riducono al minimo i danni della disinformazione salvaguardando i nostri diritti umani fondamentali: il diritto alla libertà di espressione.