كيف يجب أن تستجيب وسائل التواصل الاجتماعي للمعلومات المضللة؟

نشرت: 2022-03-09كمجتمع ، لدينا علاقة معقدة مع وسائل التواصل الاجتماعي. عندما نسمع عن التنمر عبر الإنترنت والمعلومات المضللة وخطاب الكراهية ، فإننا ندين بحق الظل القبيح الذي يلقيه على المجتمع. لكن عندما تحظر روسيا Facebook في محاولة للسيطرة على السرد حول أوكرانيا ، يبدو الأمر كما لو أن حقًا أساسيًا من حقوق الإنسان يتم انتزاعه.

سبب ارتباكنا هو تضارب القيم: حرية التعبير مقابل التحرر من الأذى. وهي من أهم النقاشات في عصرنا. لكنه أيضًا نقاش أصبح مفرطًا في التبسيط والاستقطاب والقبلية.

ما وجهان هذا النقاش؟

جانب واحد هو حرية التعبير المطلقين الذين لا يريدون قواعد. لقد ساهموا في صعود منصات وسائل التواصل الاجتماعي الجديدة ، مثل "Truth Social" لغاب ودونالد ترامب ، والتي ليس لها حدود لما تنشره. وسرعان ما انحدروا إلى القومية البيضاء ومعاداة السامية ونظريات قنون المؤامرة.

يبحث الجانب الآخر عن مزيد من التنظيم الحكومي لوسائل التواصل الاجتماعي. وقد أدى ذلك إلى مبادرات جديدة مثل Google Fact Check و Good Information Inc و Trusted News Summit ، والتي تسعى للتحقق مما هو صحيح. غالبًا ما يستخف هذا الجانب بمخاطر منح الدولة سلطات لمراقبة الإنترنت. ومن الأمثلة على الكيفية التي يمكن أن يحدث بها هذا الخطأ حملات القمع التي تمارسها الأنظمة السياسية على وسائل التواصل الاجتماعي والتي تتطلع إلى التحكم في التدفق الحر للمعلومات.

باستخدام Meta (أستخدم "Facebook" لتمييز منصة وسائل التواصل الاجتماعي المحددة) كمثال ، سأفحص جانبي النقاش - وأقترح حلاً يهدف إلى حل تعارض القيم.

الفيسبوك تحت النار

ما يقرب من ربع سكان العالم على Facebook ، مما يجعله أكثر منصات التواصل الاجتماعي شعبية في العالم.

لكن مصداقية مهمتهم المعلنة ، المتمثلة في "بناء المجتمع والتقريب بين العالم" ، تعرضت مؤخرًا لانتقادات شديدة.

اتهم المبلغون عن المخالفات فيسبوك باختيار الربح على المجتمع عن قصد ؛ وهم يجادلون بأن فيسبوك في الترويج للمعلومات المضللة يقلل من نزاهة العملية الديمقراطية. علاوة على ذلك ، يُقال إن المعلومات المضللة على وسائل التواصل الاجتماعي قد أضعفت قدرة المجتمع على الاستجابة بفعالية للوباء.

أجاب مارك زوكربيرج بما يلي:

"فكرة أننا نسمح للمعلومات الخاطئة بأن تتفاقم على منصتنا ، أو أننا نستفيد بطريقة ما من هذا المحتوى ، فكرة خاطئة."

دفاع Facebook هو أن لديهم شركاء في التحقق من الحقائق أكثر من أي منصة تقنية أخرى. جهودهم مثيرة للإعجاب بالتأكيد ، حيث قاموا بإزالة أكثر من 5 ملايين قطعة من المحتوى البغيض كل شهر.

سيوجهك Facebook أيضًا نحو معايير مجتمعهم ، والتي تسرد 4 أنواع من المحتوى الذي قد يتخذون إجراءات بشأنه:

- السلوك العنيف والإجرامي

- مخاوف تتعلق بالسلامة (مثل التنمر وإساءة معاملة الأطفال والاستغلال)

- المحتوى المرفوض ، مثل المواد الإباحية والكلام الذي يحض على الكراهية

- محتوى غير أصلي (مثل المعلومات المضللة)

من بين هؤلاء ، هناك القليل من الجدل حول النقاط من 1 إلى 3. هناك اتفاق واسع على أن Facebook يجب أن يعمل على منع الضرر الناجم عن العنف والبلطجة وخطاب الكراهية.

النقطة 4 ، المعلومات الخاطئة ، مثيرة للجدل.

ظهور المعلومات الخاطئة

يبدو أحيانًا أننا مستعدون لتصديق كل شيء ولا شيء في نفس الوقت.

وهذا الشعور ليس جديدا.

في عام 1835 ، زعمت صحيفة New York Sun أن هناك حضارة غريبة على سطح القمر. بيعت بشكل جيد لدرجة أنها أسست New York Sun كمطبوعة رائدة.

ومع ذلك ، فإن المعلومات المضللة المستهدفة كشكل من أشكال التحكم النفسي قد زادت فقط مع ظهور الاتصالات الرقمية.

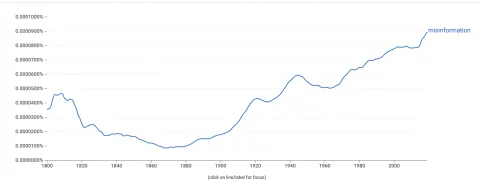

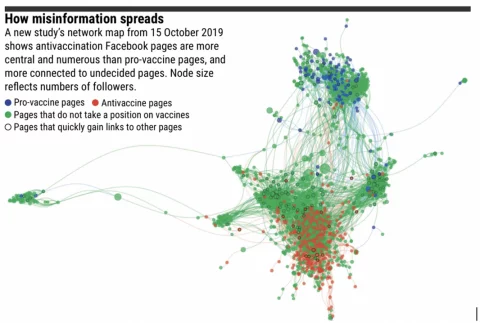

يُظهر عارض Google Ngram ، الذي يقيس تكرار ظهور الكلمات في الكتب ، زيادة حادة في استخدامنا لكلمة "معلومات مضللة".  لفهم هذا ، يجب أن نفهم كيف تنتشر المعلومات المضللة.

لفهم هذا ، يجب أن نفهم كيف تنتشر المعلومات المضللة.

تم تحسين خوارزميات Facebook للتفاعل - وهذا غالبًا ما يروج للمحتوى الذي يثير استجابة عاطفية قوية. ما يهم الخوارزمية هو المشاركة ، وليس صحة المعلومات التي يتم مشاركتها.

ومن المثير للاهتمام أن المعلومات المضللة لا تنتقل بعيدًا عندما يكون هناك عدد قليل من غرف الصدى. سينتقل المحتوى إلى أبعد من المستخدم الذي لا يوافق عليه ، والذي يتحقق لاحقًا من الحقائق ويكشف عنها على أنها معلومات مضللة.

ومع ذلك ، يتم فصل المجموعات عبر الإنترنت بشكل متزايد عن طريق المعتقدات الأيديولوجية. في ظل هذه الفقاعات ، يمكن للمعلومات الخاطئة أن تنتقل بعيدًا عبر الشبكة دون أن يتم تحديها.

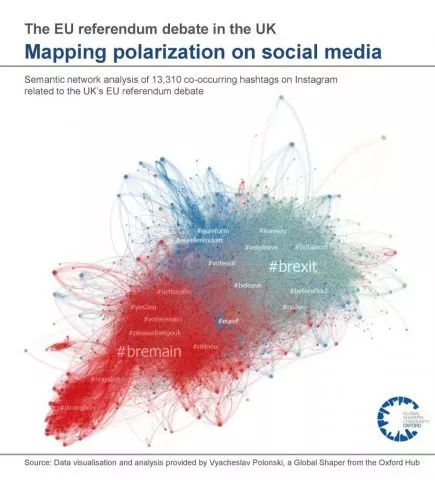

يوجد أدناه تمثيل مرئي لغرف الصدى من مناظرة استفتاء الاتحاد الأوروبي في المملكة المتحدة:

التحيز التأكيدي هو ميلنا للبحث عن المعلومات التي تتوافق مع آرائنا الحالية والإيمان بها. من المعروف من قبل علماء النفس أنه بمجرد أن يتخذ شخص ما قرارًا ، من الصعب تغييره. لذا بدلاً من ذلك ، تهدف المعلومات المضللة إلى استغلال الخوارزميات وغرف الصدى وتحيز التأكيد لتضخيم وتعزيز الآراء الحالية . هذا يمكن أن يؤدي إلى التطرف.

هذا يمثل مشكلة خاصة عندما ينتقل إلى العالم الحقيقي.

أمثلة على التأثير الواقعي للمعلومات المضللة:

- هجمات الكابيتول عام 2021 لها جذور في نظرية المؤامرة QAnon

- وتعطلت الانتخابات في دول من بينها غانا ونيجيريا وتونجو وتونس وهولندا

- يرتبط عدم تناول لقاحات Covid-19 بمجموعة متنوعة من مصادر المعلومات المضللة

- الوفيات في شارلوتسفيل ، تغذيها منتديات اليمين المتطرف

- عمليات إطلاق النار "Pizzagate" ، التي تعود جذورها أيضًا إلى قنون

علاوة على ذلك ، تم العثور على معلومات مضللة تقوض ثقتنا في المؤسسات وتنشر علمًا كاذبًا ، مما يؤثر على الصحة العامة ويعطل العملية الديمقراطية.

إذن ، ما هو الإجراء الذي ينبغي اتخاذه؟

الحجة ضد الرقابة

من أجل مكافحة أضرار المعلومات المضللة ، ينادي المدافعون عن المزيد من تدخل الدولة لتنظيم وسائل التواصل الاجتماعي وإزالة المعلومات المضللة.

على سبيل المثال ، دعا الأمين العام للأمم المتحدة ، أنطونيو غوتيريش ، إلى قواعد عالمية لتنظيم محتوى وسائل التواصل الاجتماعي.

"لا أعتقد أنه يمكننا العيش في عالم يتم فيه منح الكثير من القوة لعدد مخفض من الشركات. نحن بحاجة إلى إطار تنظيمي جديد بقواعد تسمح بذلك بما يتماشى مع القانون ".

~ أمين عام الأمم المتحدة ، أنطونيو غوتيريش

من الصعب الاختلاف مع المشاعر الكامنة وراء هذا البيان. بدون عمليات التحقق المناسبة ، يمكن أن تتضخم قوة شركات التكنولوجيا خارجة عن سيطرتنا.

ومع ذلك ، قبل منح الصلاحيات للهيئات التي ستسمح لها بتحديد المعلومات التي نستهلكها ، يجب أن نأخذ في الاعتبار الجوانب السلبية المحتملة.

أولاً ، قد يكون فرض الرقابة على منشورات وسائل التواصل الاجتماعي انتهاكًا لمادة قانون حقوق الإنسان ، والتي تنص على:

"لكل شخص الحق في حرية التعبير. يجب أن يشمل هذا الحق حرية اعتناق الآراء وتلقي المعلومات والأفكار والتأثير عليها دون تدخل من السلطة العامة ".

~ المادة 10 من قانون حقوق الإنسان

ومن المثير للاهتمام أن حكومة المملكة المتحدة تتطلع حاليًا إلى إصلاح قانون حقوق الإنسان ، واستبدالها بـ "وثيقة الحقوق".

يتمثل أحد التغييرات المقترحة في إمكانية انتهاك حقوق الإنسان للفرد إذا كان ذلك "يحمي المصلحة العامة الأوسع" (صفحة 56 ، إصلاح حقوق الإنسان). قد يسمح هذا التغيير بمزيد من الرقابة على المعلومات المضللة من قبل الدولة.

الحجة الثانية ضد الرقابة على المعلومات الخاطئة هي أنها مفتوحة للانتهاك من قبل الأنظمة السياسية التي تتطلع إلى مركزية السلطة. قد تؤدي سلطة تقرير ما هو التضليل - وما هو غير ذلك - إلى قمع الاحتجاج والعمل الجماعي والنشاط السياسي.

هل كان من الممكن أن يحدث الربيع العربي إذا تم مراقبة تويتر وفيسبوك من قبل السلطات؟

في حين أن دور وسائل التواصل الاجتماعي في الربيع العربي قد يكون مبالغًا فيه من قبل الصحفيين ، فقد وجد التحليل الأكاديمي الدقيق أن وسائل التواصل الاجتماعي أدت بالفعل إلى زيادة في العمل الجماعي الإيجابي في البلدان ذات الحكومات القمعية.

علاوة على ذلك ، يمكننا إلقاء نظرة على سجل الدول التي حظرت منصات التواصل الاجتماعي:

- الصين

- روسيا

- إيران

- كوريا الشمالية

تم إدراج كل هذه البلدان في "مؤشر الحرية في العالم" على أنها تضم بعضًا من أسوأ الحريات المدنية في العالم. أنا لا أزعم أن لديهم حريات مدنية ضعيفة لأنهم لا يسمحون بوسائل التواصل الاجتماعي ، بل لاحظ أن الدول التي تحاول التحكم في المعلومات عبر الإنترنت تميل إلى امتلاك سجلات سيئة عندما يتعلق الأمر بحقوق الإنسان.

حتى لو لم تكن رقابة الدولة هي الحل ، فلدينا مشكلة.

الثقة في مصادر الأخبار التقليدية تتبخر بسرعة. في هذا الفراغ تندفع المعلومات المضللة ، مما يخلق رياحًا قوية بما فيه الكفاية بحيث تزيل قبضتنا على ما هو حقيقي. وقد أضر ذلك بالمجتمع من خلال التردد في تلقي اللقاحات وزيادة التطرف وتعطيل العمليات الديمقراطية.

لكن رد الفعل المفاجئ ، مع تسليم السلطة إلى الدولة لتقرير ما هو حقيقي ، يمكن أن يسبب ضررًا أكبر من المعلومات المضللة.

وعلى أي حال ، فمن المحتمل أن يكون انتهاكًا لحقوق الإنسان.

التحديات التي تواجه حل Facebook

هدف Facebook هو منع التنظيم من قبل الحكومات من خلال التنظيم الذاتي.

تشمل استراتيجيتهم لمعالجة المعلومات الخاطئة ما يلي:

- تطبيق التعلم الآلي لاكتشاف المعلومات الخاطئة

- فرق الاستجابة لحقيقة تغيير المحتوى الذي تم الإبلاغ عنه

- الشراكة مع جهات خارجية للتحقق من صحة المحتوى

ومع ذلك ، فإن Facebook أنفسهم سوف يعترفون بحدود هذا النهج الآلي إلى حد كبير. على سبيل المثال ، كيف سيحدد برنامج آلي الفرق بين المواقع الساخرة والمعلومات المضللة المتعمدة؟

بالإضافة إلى ذلك ، توجد كميات هائلة من اصطياد النقرات لغرض وحيد هو تحويل النقرات إلى عائدات إعلانات. غالبًا ما تستخدم هذه المواقع النموذجية التي تشبه مواقع الأخبار الرسمية ذات العناوين الجذابة ، وغالبًا ما تخدع المشاهدين للنقر.

هذه المواقع ليست معلومات مضللة ، لكنها ليست مصادر موثوقة للمعلومات.

بين السخرية والصيد النقر ، هناك أعمدة ثرثرة وصحافة رأي. هذا إعلام "شرعي" لا يدعي الموضوعية. على سبيل المثال ، يعترف بن شابيرو ، معلق إعلامي أمريكي يميني ، علانية أن موقعه الإخباري ، The Daily Wire ، موجود ليس لنشر الأخبار ولكن "للفوز في حرب ثقافية". إن المغالاة والمبالغة النموذجية لهؤلاء الناشرين هي منطقة رمادية للبرامج الآلية التي تبحث عن معلومات مضللة.

صرح مارك زوكربيرج مؤخرًا أن "فيسبوك يفعل أكثر من أي شركة أخرى لمعالجة المعلومات المضللة". قد يكون على حق. لكن هل هذا كاف؟

حل مقترح

لقد رأينا كيف أن حل التضليل هو تضارب في القيم: حرية التعبير مقابل التحرر من الأذى. يجب أن يسعى أي حل لتحقيق التوازن بين الاثنين.

أنا أقدم حلاً محتملاً فقط كتجربة فكرية - بعد كل شيء ، من الأسهل اختيار ثغرات في عمل الآخرين وأصعب بكثير اقتراح شيء ما بنفسك. من المسلم به أن هذا ليس مجال خبرتي وأي اقتراحات ستكون غير عملية في أحسن الأحوال!

مع هذا التحذير المذكور ، أود أن أقترح ثلاث نقاط:

- لا تسعى إلى فرض رقابة على المعلومات الخاطئة في منشورات الفرد على وسائل التواصل الاجتماعي

- تعزيز المحتوى الموثوق به على المشاركة بطريقة حسابية

- الحد من غرف الصدى

1. عدم الرقابة على المعلومات الخاطئة في مشاركات الأفراد

هذا يحمي حقوق الإنسان للفرد. كما أنه يحمي النشطاء الذين يرغبون في استخدام وسائل التواصل الاجتماعي للتعبئة ضد الأنظمة السياسية القمعية.

لكن هذه ليست حرية التعبير بأي ثمن.

يجب أن يستمر Facebook في حذف المحتوى الذي يشجع على السلوك العنيف والتنمر والاستغلال وخطاب الكراهية.

2. الترويج للمحتوى الموثوق به على المحتوى الجذاب

تحدد خوارزمية "EdgeRank" في Facebook المحتوى الذي يتم عرضه في موجز الأخبار الخاص بك وبأي ترتيب.

يسعى إلى تخصيص خلاصتك من خلال مجموعة من اهتماماتك الشخصية مع كيفية تفاعل المجتمع الأوسع مع منشور معين.

تروج خوارزمية Facebook للمحتوى بمشاركة عالية. في كثير من الأحيان ، يعمل هذا بشكل جيد وسترى منشورات من الأصدقاء والعائلة ، جنبًا إلى جنب مع الميمات الفيروسية ومقاطع الفيديو الخاصة بالقطط. ومع ذلك ، فإن نفس الآلية تروج أيضًا للمحتوى الانفعالي ، والذي غالبًا ما يكون مثيرًا للانقسام أو غير صحيح.

ومع ذلك ، يمكن تكييف الخوارزمية للعمل بطريقة مماثلة لخوارزمية PageRank من Google.

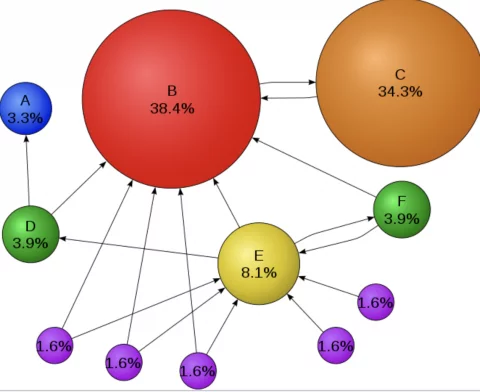

تروج Google للمحتوى الموثوق به - وليس المحتوى الجذاب -. يقوم بذلك عن طريق تحليل عدد المرات التي تشير فيها مواقع الويب الأخرى إلى جزء من المحتوى في شكل روابط تشعبية أو "روابط خلفية". على سبيل المثال ، أحيلك إلى هذا التحليل التفصيلي لكيفية عمل خوارزمية PageRank من Google وهو مؤشر على مصداقية تلك الصفحة.

عندما ينشر فرد مقالًا من موقع ويب على Facebook ، لا يحتاج Facebook بالضرورة إلى التحقق من صحة الموقع. بدلاً من ذلك ، يمكنه تحديد سلطة الموقع بطريقة حسابية بطريقة مماثلة لـ Google.

إذا كان مصدر الأخبار موثوقًا ، مثل BBC ، فسيتم منحه الأولوية في موجز الأخبار على المعلومات الخاطئة أو البريد العشوائي أو clickbait.

بشكل حاسم ، هذه العملية لا مركزية.

لم يقرر أي فرد أن هيئة الإذاعة البريطانية (بي بي سي) موثوقة. بدلاً من ذلك ، هذا الاستنتاج هو نتيجة التعهيد الجماعي.

أشارت الملايين من مواقع الويب الفردية إلى هيئة الإذاعة البريطانية (BBC) ، تمامًا مثل تلقي باحث موثوق استشهادات إذا كان عملهم مشروعًا. لذلك ، يتم تقليل مخاطر التحكم المركزي.

سيقلل هذا الحل المقترح من وصول المعلومات المضللة دون الحاجة إلى أن يصبح Facebook شرطة الإنترنت.

فلماذا لم يجرب Facebook شيئًا كهذا بالفعل؟

حسنًا ، سيقلل من عائدات إعلاناتهم. إن الترويج للمحتوى الموثوق على المحتوى الجذاب من شأنه أن يجعل تغذية أخبارك قليلاً ... مملة. وهذا يعني قضاء وقت أقل على النظام الأساسي ونقرات أقل وإيرادات إعلانية أقل.

هناك أيضًا مشكلة صغيرة هي أن Google تمتلك الملكية الفكرية لـ PageRank. سيحتاج Facebook إلى تطوير خوارزمية خاصة به يمكن أن تقدم نتائج مماثلة ، ولكن لديها طرق مختلفة بما فيه الكفاية لتجنب انتهاك IP.

لقد قلت أن هذه كانت مجرد تجارب فكرية مقيدة بعدم الواقعية!

3. الحد من غرف الصدى

تشير الأبحاث إلى أن المعلومات الخاطئة لا تنتقل بعيدًا حيث يوجد عدد أقل من غرف الصدى. علاوة على ذلك ، تقترح نظرية استقطاب المجموعة أن غرف الصدى تحرك مجموعات بأكملها إلى مواقع أكثر تطرفًا.

يشير هذا إلى أن المعلومات المضللة ربما ليست هي المشكلة - ربما غرف الصدى ...

في شبكة بها مجموعات أقل من المستخدمين المنفصلين ، تنتقل المعلومات المضللة مسافة أقل ويكون تأثيرها متضائلًا على من تصل إليهم. المشكلة هي أن عبارة "مجموعة المستخدمين المنفصلين" طريقة فنية لقول "المجتمع"!

يقع المجتمع في قلب Facebook ، ومع ذلك فهو أيضًا الدافع وراء الاستقطاب.

لذا ، فإن إزالة غرف الصدى ليست قابلة للتطبيق ، ولكن يمكن اتخاذ خطوات للحد من ضررها.

يمكن أن تشمل هذه الخطوات:

- يمكن أن يوفر Facebook ميزة للمستخدمين لإيقاف التخصيص في موجز الأخبار لدينا حتى نتمكن من رؤية ما يستهلكه الآخرون ، بدون خوارزميات.

- يمكن لـ Facebook وضع علامة على المحتوى شديد الاستقطاب أو الحزبي وتوفير خيارات لمشاهدته جنبًا إلى جنب مع المحتوى من وجهة نظر معارضة

- يمكن وضع شارات التحقق على المحتوى الذي يتوافق مع مدونة السلوك الصحفي

علاوة على ذلك ، يمكن توفير التعليم لمساعدة الأفراد على الخروج من غرف الصدى الخاصة بهم. تقع على عاتقنا مسؤولية السعي وراء "عدم التأكيد".

ليس من الطبيعي بالنسبة لنا ، ولكن أن نكون مواطنين مطلعين يعني استهلاك المعلومات التي قد لا نتفق معها بالضرورة.

سنستفيد جميعًا من كوننا أقل يقينًا.

ملخص

تشكل الروابط الاجتماعية نسيج مجتمعنا. لكن ميولنا إلى تشكيل مجتمعات ذات تفكير متشابه يمكن استغلالها ، مما يؤدي إلى تضليل المعلومات والانقسام. قد يبدو نداء الرقابة حلاً جذابًا ، لكنه قد يغرينا نحو صخرة من الأفضل تجنبها.

قد تبدو إزالة المطالبات خارج الإجماع أمرًا مرغوبًا فيه ، ولكن من المرجح أن تزيد المشكلة سوءًا. حتى أن الرقابة قد تجعل الناس أقل ثقة في السلطة ، مما يدفع بالمزيد من الآراء الخبيثة تحت الأرض حيث يمكن أن تنتشر.

بدلاً من ذلك ، يجب أن نسعى إلى حلول لامركزية.

حلول تقلل من ضرر المعلومات المضللة مع حماية حقوق الإنسان الأساسية - الحق في حرية التعبير.