Comment les réseaux sociaux doivent-ils répondre à la désinformation ?

Publié: 2022-03-09En tant que société, nous avons une relation compliquée avec les médias sociaux. Lorsque nous entendons parler d'intimidation en ligne, de désinformation et de discours de haine, nous condamnons à juste titre l'ombre laide qu'elle projette sur la société. Mais lorsque la Russie interdit Facebook dans le but de contrôler le récit autour de l'Ukraine, on a l'impression qu'un droit humain fondamental est supprimé.

Notre confusion est due à un conflit de valeurs : liberté d'expression contre protection contre le mal. Et c'est l'un des débats les plus importants de notre époque. Mais c'est aussi un débat devenu trop simplifié, polarisé et tribal.

Quels sont les deux côtés de ce débat ?

D'un côté, les absolutistes de la liberté d'expression qui ne veulent aucune règle. Ils ont alimenté la montée en puissance de nouvelles plateformes de médias sociaux, telles que "Truth Social" de Gab et Donald Trump, qui n'ont aucune limite sur ce que vous publiez. Ils sont rapidement tombés dans le nationalisme blanc, l'antisémitisme et les théories du complot QAnon.

L'autre partie souhaite une plus grande réglementation étatique des médias sociaux. Cela a donné lieu à de nouvelles initiatives telles que Google Fact Check, Good Information Inc et Trusted News Summit, qui cherchent à vérifier ce qui est vrai. Ce côté sous-estime souvent les risques d'accorder des pouvoirs à un État pour contrôler Internet. Des exemples de la façon dont cela peut mal tourner sont la répression des médias sociaux par des régimes politiques qui cherchent à contrôler la libre circulation de l'information.

En utilisant Meta (j'utilise "Facebook" pour distinguer la plate-forme de médias sociaux spécifique) comme exemple, j'examinerai les deux côtés du débat - et je proposerai une solution visant à résoudre le conflit de valeurs.

Facebook sous le feu

Près d'un quart de la population mondiale est sur Facebook, ce qui en fait la plateforme de médias sociaux la plus populaire au monde.

Mais la crédibilité de leur mission déclarée, « construire une communauté et rapprocher le monde », a récemment été critiquée.

Les dénonciateurs ont accusé Facebook de choisir sciemment le profit plutôt que la société ; Ils soutiennent qu'en faisant la promotion de la désinformation, Facebook porte atteinte à l'intégrité du processus démocratique. En outre, il est avancé que la désinformation sur les réseaux sociaux a affaibli la capacité de la société à réagir efficacement à la pandémie.

Mark Zuckerberg a répondu ce qui suit :

"L'idée que nous permettons à la désinformation de s'envenimer sur notre plate-forme, ou que nous bénéficions d'une manière ou d'une autre de ce contenu, est fausse."

La défense de Facebook est qu'ils ont plus de partenaires de vérification des faits que toute autre plate-forme technologique. Leurs efforts sont certainement impressionnants, supprimant plus de 5 millions de contenus haineux chaque mois.

Facebook vous indiquera également ses normes communautaires, qui répertorient 4 types de contenu sur lesquels ils peuvent agir :

- Comportement violent et criminel

- Problèmes de sécurité (tels que l'intimidation, la maltraitance des enfants, l'exploitation)

- Contenu répréhensible, comme la pornographie et les discours de haine

- Contenu non authentique (tel que la désinformation)

Parmi ceux-ci, il y a peu de controverse sur les points 1 à 3. Il existe un large consensus sur le fait que Facebook devrait agir pour prévenir les dommages causés par la violence, l'intimidation et les discours de haine.

C'est le point 4, la désinformation, qui est controversé.

La montée de la désinformation

On a parfois l'impression que nous sommes prêts à croire simultanément tout et rien.

Et ce sentiment n'est pas nouveau.

En 1835, le journal New York Sun a affirmé qu'il y avait une civilisation extraterrestre sur la lune. Il s'est si bien vendu qu'il a fait du New York Sun une publication de premier plan.

Cependant, la désinformation ciblée en tant que forme de contrôle psychologique n'a fait qu'augmenter avec l'essor de la communication numérique.

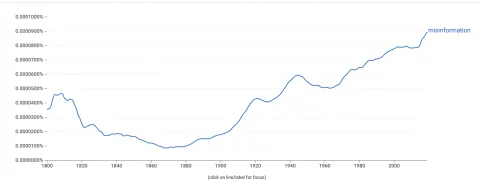

La visionneuse Google Ngram, qui mesure la fréquence à laquelle les mots apparaissent dans les livres, montre une forte augmentation de notre utilisation du mot « désinformation ».  Pour comprendre cela, nous devons comprendre comment la désinformation se propage.

Pour comprendre cela, nous devons comprendre comment la désinformation se propage.

Les algorithmes de Facebook sont optimisés pour l'engagement - cela favorise souvent le contenu qui suscite une forte réponse émotive. Ce qui est important pour l'algorithme, c'est l'engagement, pas la véracité des informations partagées.

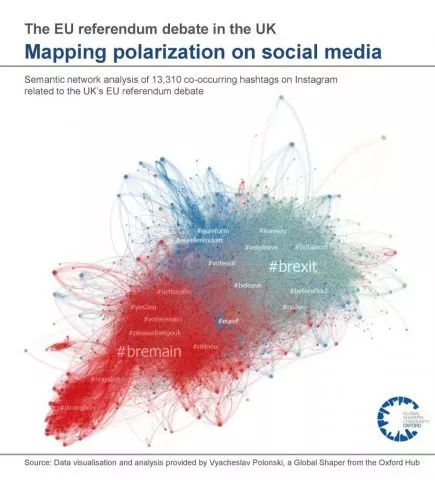

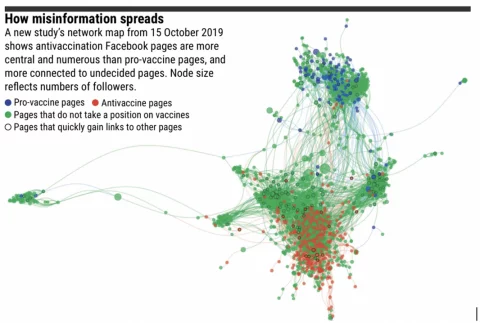

Fait intéressant, la désinformation ne va pas loin lorsqu'il y a peu de chambres d'écho. Le contenu voyagera jusqu'à un utilisateur qui n'est pas d'accord avec lui, qui le vérifie ensuite et le révèle comme une désinformation.

Cependant, les groupes en ligne sont de plus en plus séparés par des croyances idéologiques. Dans ces bulles, la désinformation peut voyager loin à travers le réseau sans être contestée.

Vous trouverez ci-dessous une représentation visuelle des chambres d'écho du débat sur le référendum de l'UE au Royaume-Uni :

Le biais de confirmation est notre tendance à rechercher et à croire des informations qui correspondent à nos points de vue existants. Les psychologues savent qu'une fois que la décision de quelqu'un est prise, il est difficile de la changer. Ainsi, la désinformation vise plutôt à exploiter les algorithmes, les chambres d'écho et le biais de confirmation pour amplifier et renforcer les opinions existantes . Cela peut conduire à l'extrémisme.

Ceci est particulièrement problématique lorsqu'il se répand dans le monde réel.

Exemples de l'impact réel de la désinformation :

- Les attaques du Capitole de 2021, avec des racines dans la théorie du complot QAnon

- Élections perturbées dans des pays comme le Ghana, le Nigeria, Tongo, la Tunisie et la Hollande

- Manque d'absorption des vaccins Covid-19 lié à une variété de sources de désinformation

- Les morts à Charlottesville, alimentées par des forums d'extrême droite

- Tournages «Pizzagate», également avec des racines dans QAnon

En outre, il a été constaté que la désinformation sape notre confiance dans les institutions et diffuse de fausses données scientifiques, ce qui a un impact sur la santé publique et perturbe le processus démocratique.

Alors, quelle action faut-il entreprendre ?

L'argument contre la censure

Afin de lutter contre les méfaits de la désinformation, les défenseurs plaident pour une plus grande intervention de l'État pour réglementer les médias sociaux et supprimer la désinformation.

Par exemple, le chef des Nations Unies, le secrétaire général Antonio Guterres, a appelé à des règles mondiales pour réglementer le contenu des médias sociaux.

« Je ne pense pas qu'on puisse vivre dans un monde où trop de pouvoir est donné à un nombre réduit d'entreprises. Nous avons besoin d'un nouveau cadre réglementaire avec des règles qui permettent de le faire conformément à la loi.

~ Chef des Nations Unies, Secrétaire général Antonio Guterres

Il est difficile d'être en désaccord avec le sentiment derrière cette déclaration. Sans contrôles appropriés, le pouvoir des entreprises technologiques pourrait exploser au-delà de notre contrôle.

Cependant, avant d'accorder des pouvoirs aux organismes qui leur permettront de décider quelles informations nous consommons, nous devrions considérer les inconvénients potentiels.

Premièrement, la censure des publications sur les réseaux sociaux peut constituer une violation de l'article de la loi sur les droits de l'homme, qui stipule :

"Tout le monde a le droit à la liberté d'expression. Ce droit comprend la liberté d'avoir des opinions et de recevoir et d'influer sur des informations et des idées sans ingérence de l'autorité publique. »

~ Article 10 de la loi sur les droits de l'homme

Fait intéressant, le gouvernement britannique cherche actuellement à réformer la loi sur les droits de l'homme, en la remplaçant par une «déclaration des droits».

L'un des changements proposés est que les droits de l'homme d'un individu pourraient être violés si cela « protège l'intérêt public général » (page 56, Réforme des droits de l'homme). Ce changement peut permettre une plus grande censure de la désinformation par l'État.

Un deuxième argument contre la censure de la désinformation est qu'elle est ouverte aux abus des régimes politiques cherchant à centraliser le pouvoir. Le pouvoir de décider ce qui est - et ce qui n'est pas - de la désinformation pourrait conduire à une répression de la protestation, de l'action collective et de l'activisme politique.

Le printemps arabe aurait-il pu avoir lieu si Twitter et Facebook avaient été contrôlés par les autorités ?

Alors que le rôle des médias sociaux dans le printemps arabe est probablement surestimé par les journalistes, une analyse académique approfondie a révélé que les médias sociaux ont en effet conduit à une augmentation de l'action collective positive dans les pays aux gouvernements oppressifs.

En outre, nous pouvons examiner les antécédents des pays qui ont interdit les plateformes de médias sociaux :

- Chine

- Russie

- L'Iran

- Corée du Nord

Tous ces pays sont répertoriés dans «l'indice de la liberté dans le monde» comme ayant certaines des pires libertés civiles au monde. Je ne prétends pas qu'ils ont de faibles libertés civiles parce qu'ils n'autorisent pas les médias sociaux, mais j'observe plutôt que les États qui tentent de contrôler les informations en ligne ont tendance à avoir de mauvais résultats en matière de droits de l'homme.

Même si la censure d'État n'est pas la solution, nous avons un problème.

La confiance dans les sources d'information traditionnelles s'évapore rapidement. Dans ce vide se précipite la désinformation, créant un vent suffisamment fort pour qu'il ait emporté notre emprise sur ce qui est vrai. Cela a nui à la société en raison de la réticence à la vaccination, de l'extrémisme accru et de la perturbation des processus démocratiques.

Mais une réaction instinctive, consistant à donner à l'État le pouvoir de décider de ce qui est vrai, pourrait causer plus de tort que la désinformation.

Et de toute façon, c'est probablement une violation des droits de l'homme.

Défis à la solution de Facebook

L'objectif de Facebook est d'empêcher la réglementation par les gouvernements grâce à l'autorégulation.

Leur stratégie pour lutter contre la désinformation comprend :

- Appliquer l'apprentissage automatique pour détecter la désinformation

- Équipes d'intervention en cas de changement de fait lié au contenu signalé

- Partenariat avec des organisations tierces de vérification des faits pour vérifier le contenu

Cependant, Facebook lui-même admettra des limites à cette approche largement automatisée. Par exemple, comment un programme automatisé déterminerait-il la différence entre les sites Web satiriques et la désinformation intentionnelle ?

De plus, de grandes quantités de clickbait existent dans le seul but de transformer les clics en revenus publicitaires. Ceux-ci utilisent souvent des sites modèles qui ressemblent à des sites Web d'actualités officiels avec des titres attrayants, incitant souvent les téléspectateurs à cliquer.

Ces sites ne sont pas de la désinformation, mais ils ne sont pas non plus des sources d'information fiables.

Entre la satire et le clickbait, il y a les chroniques à potins et le journalisme d'opinion. Ce sont des médias "légitimes" qui ne revendiquent aucune objectivité. Par exemple, Ben Shapiro, un commentateur de médias américain de droite, admet ouvertement que son site d'information, The Daily Wire, n'existe pas pour rapporter l'actualité mais pour « gagner une guerre culturelle ». Le spin et l'exagération typiques de ces éditeurs sont une zone grise pour les programmes automatisés à la recherche de désinformation.

Mark Zuckerberg a récemment déclaré que "Facebook fait plus pour lutter contre la désinformation que toute autre entreprise". Il a peut-être raison. Mais est-ce suffisant ?

Une proposition de solution

Nous avons vu comment la solution à la désinformation est un conflit de valeurs : liberté d'expression vs protection contre le mal. Toute solution doit chercher à équilibrer les deux.

J'offre une solution potentielle uniquement comme une expérience de pensée - après tout, il est plus facile de trouver des trous dans le travail des autres et beaucoup plus difficile de suggérer quelque chose soi-même. Certes, ce n'est pas mon domaine d'expertise et toute suggestion sera au mieux peu pratique !

Cette mise en garde étant faite, je proposerais trois points :

- Ne cherchez pas à censurer la désinformation dans les publications d'un individu sur les réseaux sociaux

- Promouvoir le contenu faisant autorité plutôt que l'engagement de manière algorithmique

- Limiter les chambres d'écho

1. Ne pas censurer la désinformation dans les messages individuels

Cela protège les droits de l'homme d'un individu. Il protège également les militants qui souhaitent utiliser les médias sociaux pour se mobiliser contre les régimes politiques oppressifs.

Mais ce n'est pas la liberté d'expression à tout prix.

Facebook devrait continuer à supprimer les contenus encourageant les comportements violents, l'intimidation, l'exploitation et les discours de haine.

2. Promouvoir un contenu faisant autorité plutôt qu'un contenu engageant

L'algorithme "EdgeRank" de Facebook détermine quel contenu est affiché dans votre fil d'actualités et dans quel ordre.

Il cherche à personnaliser votre flux en combinant vos intérêts personnels avec la façon dont la communauté au sens large a interagi avec un message particulier.

L'algorithme de Facebook promeut le contenu avec un engagement élevé. Souvent, cela fonctionne bien et vous voyez des messages d'amis et de famille, ainsi que des mèmes viraux et des vidéos de chats. Cependant, le même mécanisme favorise également le contenu émotif, qui est souvent source de division ou faux.

L'algorithme, cependant, pourrait être adapté pour fonctionner de la même manière que l'algorithme PageRank de Google.

Google promeut un contenu faisant autorité, par opposition à engageant. Pour ce faire, il analyse le nombre de fois où d'autres sites Web référencent un élément de contenu sous la forme d'hyperliens ou de "back-links". Par exemple, le fait que je vous renvoie à cette ventilation détaillée du fonctionnement de l'algorithme PageRank de Google est un indicateur de la fiabilité de cette page.

Lorsqu'un individu publie un article d'un site Web sur Facebook, Facebook n'a pas nécessairement besoin de vérifier les faits du site Web. Au lieu de cela, il pourrait déterminer de manière algorithmique l'autorité du site Web d'une manière similaire à Google.

Si la source d'information fait autorité, comme la BBC, elle serait prioritaire dans les flux d'actualités par rapport à la désinformation, au spam ou au clickbait.

Surtout, ce processus est décentralisé.

Personne n'a décidé que la BBC faisait autorité. Au lieu de cela, cette conclusion est le résultat du crowdsourcing.

Des millions de sites Web individuels ont fait référence à la BBC, tout comme un universitaire faisant autorité reçoit des citations si son travail est légitime. Par conséquent, les risques d'un contrôle centralisé sont minimisés.

Cette solution proposée diminuerait la portée de la désinformation sans qu'il soit nécessaire que Facebook devienne la police d'Internet.

Alors pourquoi Facebook n'a-t-il pas déjà essayé quelque chose comme ça ?

Eh bien, cela diminuerait leurs revenus publicitaires. Promouvoir un contenu faisant autorité plutôt qu'un contenu engageant rendrait votre fil d'actualité un peu… eh bien, ennuyeux. Cela signifie moins de temps passé sur la plateforme, moins de clics et moins de revenus publicitaires.

Il y a aussi le petit problème que Google détient la propriété intellectuelle du PageRank. Facebook devrait développer son propre algorithme qui pourrait produire des résultats similaires, mais disposer de méthodes suffisamment différentes pour éviter les atteintes à la propriété intellectuelle.

J'ai bien dit que ce n'étaient que des expériences de pensée limitées par l'impraticabilité !

3. Limiter les chambres d'écho

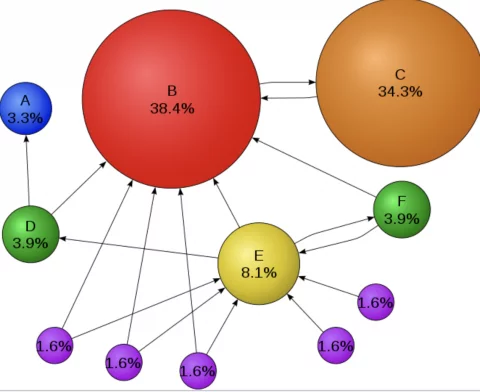

La recherche suggère que la désinformation ne va pas loin là où il y a moins de chambres d'écho. De plus, la théorie de la polarisation de groupe suggère que les chambres d'écho déplacent des groupes entiers dans des positions plus extrêmes.

Cela suggère que la désinformation n'est peut-être pas le problème - peut-être que ce sont les chambres d'écho…

Dans un réseau avec moins de groupes d'utilisateurs séparés, la désinformation voyage moins loin et a un impact moindre sur ceux qu'elle atteint. Le problème est que l'expression "groupe d'utilisateurs séparés" est une manière technique de dire "la communauté" !

La communauté est au cœur de Facebook, mais c'est aussi ce qui alimente la polarisation.

Ainsi, la suppression des chambres d'écho n'est pas viable, mais des mesures pourraient être prises pour limiter leurs dommages.

Ces étapes pourraient inclure :

- Facebook pourrait fournir une fonctionnalité permettant aux utilisateurs de désactiver la personnalisation dans nos fils d'actualités afin que nous puissions voir ce que les autres consomment, sans algorithme.

- Facebook pourrait signaler le contenu hautement polarisé ou partisan et fournir des options pour le voir à côté du contenu du point de vue opposé

- Des badges de vérification pourraient être apposés sur des contenus conformes au code de conduite du journalisme

De plus, une éducation pourrait être dispensée pour aider les individus à sortir de leurs propres chambres d'écho. Nous avons la responsabilité de rechercher la « non-confirmation ».

Ce n'est pas naturel pour nous, mais être un citoyen informé signifie consommer des informations avec lesquelles nous ne sommes pas nécessairement d'accord.

Nous gagnerions tous à être un peu moins sûrs.

Résumé

Les liens sociaux forment le tissu de notre société. Mais notre tendance même à former des communautés partageant les mêmes idées peut être exploitée, conduisant à la désinformation et à la division. L'appel des sirènes de la censure peut sembler une solution séduisante, mais il peut nous attirer vers un rocher que nous ferions mieux d'éviter.

La suppression des revendications en dehors du consensus peut sembler souhaitable, mais risque d'aggraver le problème. La censure peut même rendre les gens moins confiants envers l'autorité, poussant les opinions les plus malveillantes dans la clandestinité où elles pourraient se propager.

Au lieu de cela, nous devrions rechercher des solutions décentralisées.

Des solutions qui minimisent les méfaits de la désinformation tout en préservant nos droits humains fondamentaux - le droit à la liberté d'expression.