โซเชียลมีเดียควรตอบสนองต่อข้อมูลที่ผิดอย่างไร?

เผยแพร่แล้ว: 2022-03-09ในฐานะสังคม เรามีความสัมพันธ์ที่ซับซ้อนกับโซเชียลมีเดีย เมื่อเราได้ยินเกี่ยวกับการกลั่นแกล้งทางออนไลน์ ข้อมูลที่ผิด และคำพูดแสดงความเกลียดชัง เราขอประณามเงาน่าเกลียดที่มันทอดทิ้งในสังคมอย่างถูกต้อง แต่เมื่อรัสเซียแบน Facebook เพื่อพยายามควบคุมการเล่าเรื่องเกี่ยวกับยูเครน รู้สึกเหมือนกับว่าสิทธิมนุษยชนขั้นพื้นฐานกำลังถูกพรากไป

ความสับสนของเราเกิดจากการขัดกันของค่านิยม: เสรีภาพในการแสดงออกและเสรีภาพจากอันตราย และเป็นหนึ่งในการโต้วาทีที่สำคัญที่สุดในยุคของเรา แต่มันก็ยังเป็นการโต้วาทีที่มีความเรียบง่าย โพลาไรซ์ และชนเผ่ามากเกินไป

อะไรคือสองด้านของการอภิปรายนี้?

ด้านหนึ่งคือเสรีภาพในการพูดของผู้สมบูรณาญาสิทธิราชย์ที่ไม่ต้องการกฎเกณฑ์ พวกเขาเป็นแรงผลักดันให้เกิดแพลตฟอร์มโซเชียลมีเดียใหม่ๆ เช่น Gab และ “Truth Social” ของ Donald Trump ซึ่งไม่มีข้อจำกัดในสิ่งที่คุณโพสต์ พวกเขาสืบเชื้อสายมาจากลัทธิชาตินิยมผิวขาว การต่อต้านชาวยิว และทฤษฎีสมคบคิดของ QAnon อย่างรวดเร็ว

อีกด้านหนึ่งกำลังมองหากฎระเบียบของรัฐที่มากขึ้นของโซเชียลมีเดีย ส่งผลให้มีการริเริ่มใหม่ๆ เช่น Google Fact Check, Good Information Inc และ Trusted News Summit ซึ่งพยายามตรวจสอบความถูกต้อง ฝ่ายนี้มักประเมินความเสี่ยงต่ำเกินไปในการให้อำนาจรัฐในการเฝ้าระวังอินเทอร์เน็ต ตัวอย่างที่อาจผิดพลาดได้คือ การปราบปรามสื่อสังคมโดยระบอบการเมืองที่ต้องการควบคุมการไหลของข้อมูลอย่างเสรี

การใช้ Meta (ฉันใช้ “Facebook” เพื่อแยกแยะแพลตฟอร์มโซเชียลมีเดียเฉพาะ) เป็นตัวอย่าง ฉันจะตรวจสอบการอภิปรายทั้งสองด้าน – และฉันเสนอวิธีแก้ปัญหาที่มีเป้าหมายเพื่อแก้ไขข้อขัดแย้งด้านค่านิยม

Facebook ถูกไฟไหม้

เกือบหนึ่งในสี่ของประชากรโลกใช้ Facebook ทำให้เป็นแพลตฟอร์มโซเชียลมีเดียที่ได้รับความนิยมมากที่สุดในโลก

แต่ความน่าเชื่อถือของภารกิจที่ระบุไว้ในการ "สร้างชุมชนและทำให้โลกใกล้ชิดกันมากขึ้น" เพิ่งถูกไฟไหม้

ผู้แจ้งเบาะแสกล่าวหา Facebook ว่าจงใจเลือกผลกำไรเหนือสังคม เฮ้ เถียงว่าในการส่งเสริมข้อมูลที่ผิด Facebook กำลังลดความสมบูรณ์ของกระบวนการประชาธิปไตย นอกจากนี้ยังเป็นที่ถกเถียงกันอยู่ว่าข้อมูลที่ผิดบนโซเชียลมีเดียได้บั่นทอนความสามารถของสังคมในการตอบสนองต่อการระบาดใหญ่อย่างมีประสิทธิภาพ

มาร์ก ซักเคอร์เบิร์ก ตอบกลับดังนี้:

“แนวคิดที่เราอนุญาตให้ข้อมูลที่ผิด ๆ แพร่ระบาดบนแพลตฟอร์มของเรา หรือว่าเราได้รับประโยชน์จากเนื้อหานี้ในทางใดทางหนึ่งนั้นผิด”

การป้องกันของ Facebook คือพวกเขามีพันธมิตรตรวจสอบข้อเท็จจริงมากกว่าแพลตฟอร์มเทคโนโลยีอื่น ๆ ความพยายามของพวกเขาน่าประทับใจอย่างยิ่ง โดยได้ลบเนื้อหาแสดงความเกลียดชังออกไปมากกว่า 5 ล้านชิ้นทุกเดือน

Facebook ยังจะชี้ให้คุณเห็นถึงมาตรฐานชุมชนของพวกเขาด้วย ซึ่งแสดงเนื้อหา 4 ประเภทที่พวกเขาอาจดำเนินการ:

- พฤติกรรมรุนแรงและอาชญากรรม

- ข้อกังวลด้านความปลอดภัย (เช่น การกลั่นแกล้ง การล่วงละเมิดเด็ก การแสวงประโยชน์)

- เนื้อหาที่ไม่เหมาะสม เช่น ภาพอนาจารและคำพูดแสดงความเกลียดชัง

- เนื้อหาที่ไม่ถูกต้อง (เช่น ข้อมูลที่ผิด)

ในจำนวนนี้ มีการโต้เถียงกันเล็กน้อยในจุดที่ 1 ถึง 3 มีข้อตกลงในวงกว้างว่า Facebook ควรดำเนินการเพื่อป้องกันอันตรายจากความรุนแรง การกลั่นแกล้ง และคำพูดแสดงความเกลียดชัง

มันคือจุดที่ 4 ข้อมูลที่ผิดซึ่งเป็นข้อโต้แย้ง

การเพิ่มขึ้นของข้อมูลที่ผิด

บางครั้งรู้สึกเหมือนว่าเราพร้อมที่จะเชื่อทุกอย่างและไม่มีอะไรเลย

และความรู้สึกนี้ไม่ใช่เรื่องใหม่

ในปี ค.ศ. 1835 หนังสือพิมพ์นิวยอร์กซันอ้างว่ามีอารยธรรมมนุษย์ต่างดาวอยู่บนดวงจันทร์ ขายดีจนทำให้ New York Sun เป็นสื่อสิ่งพิมพ์ชั้นนำ

อย่างไรก็ตาม ข้อมูลที่ผิดแบบมุ่งเป้าในรูปแบบของการควบคุมทางจิตวิทยาได้เพิ่มขึ้นก็ต่อเมื่อการสื่อสารทางดิจิทัลเพิ่มขึ้นเท่านั้น

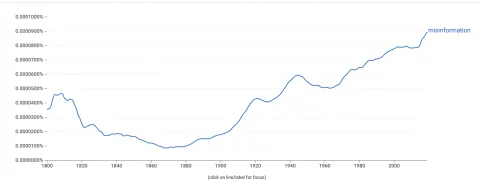

โปรแกรมดู Google Ngram ซึ่งวัดความถี่ของคำที่ปรากฏในหนังสือ แสดงให้เห็นว่าการใช้คำว่า "ข้อมูลที่ผิด" ของเราเพิ่มขึ้นอย่างมาก  เพื่อทำความเข้าใจสิ่งนี้ เราควรเข้าใจว่าข้อมูลที่ผิดแพร่กระจายไปอย่างไร

เพื่อทำความเข้าใจสิ่งนี้ เราควรเข้าใจว่าข้อมูลที่ผิดแพร่กระจายไปอย่างไร

อัลกอริธึมของ Facebook ได้รับการปรับให้เหมาะสมสำหรับการมีส่วนร่วม ซึ่งมักจะส่งเสริมเนื้อหาที่กระตุ้นการตอบสนองทางอารมณ์ที่รุนแรง สิ่งสำคัญสำหรับอัลกอริทึมคือการมีส่วนร่วม ไม่ใช่ความจริงของข้อมูลที่แชร์

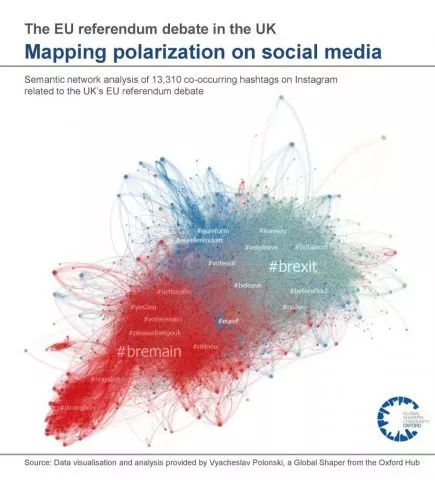

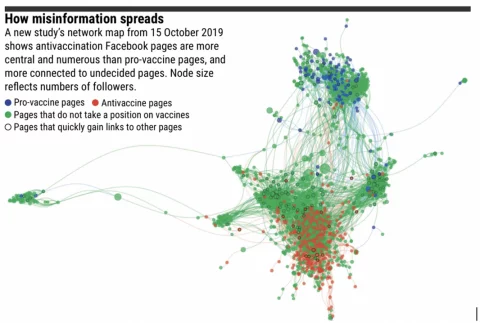

น่าสนใจ ข้อมูลที่ ผิดจะไม่เดินทางไกลเมื่อมีห้องสะท้อนเสียงไม่กี่แห่ง เนื้อหาจะไปไกลถึงผู้ใช้ที่ไม่เห็นด้วยกับเนื้อหา ซึ่งต่อมาตรวจสอบข้อเท็จจริงและเปิดเผยว่าเป็นข้อมูลที่ผิด

อย่างไรก็ตาม กลุ่มออนไลน์ถูกแบ่งแยกมากขึ้นตามความเชื่อในอุดมคติ ในฟองสบู่เหล่านี้ ข้อมูลที่ผิดสามารถเดินทางผ่านเครือข่ายได้ไกลโดยไม่ถูกท้าทาย

ด้านล่างนี้คือภาพจำลองของห้องสะท้อนเสียงจากการอภิปรายประชามติสหภาพยุโรปของสหราชอาณาจักร:

อคติในการยืนยัน คือแนวโน้มที่เราจะค้นหาและเชื่อข้อมูลที่สอดคล้องกับมุมมองที่มีอยู่ของเรา นักจิตวิทยารู้กันดีว่าเมื่อจิตใจของใครก่อตัวขึ้นแล้ว ยากจะเปลี่ยนแปลงได้ ดังนั้น ข้อมูลที่ไม่ถูกต้องจึงมีจุดมุ่งหมายเพื่อใช้ประโยชน์จากอัลกอริธึม ห้องเสียงสะท้อน และอคติในการยืนยันเพื่อ ขยายและเสริมความแข็งแกร่งให้กับมุมมองที่มีอยู่ สิ่งนี้สามารถนำไปสู่ความคลั่งไคล้

นี่เป็นปัญหาโดยเฉพาะอย่างยิ่งเมื่อมันรั่วไหลเข้าสู่โลกแห่งความเป็นจริง

ตัวอย่างผลกระทบของข้อมูลที่ผิดในโลกแห่งความเป็นจริง:

- การโจมตี Capitol ปี 2021 โดยมีรากฐานมาจากทฤษฎีสมคบคิดของ QAnon

- การเลือกตั้งที่หยุดชะงักในประเทศต่างๆ เช่น กานา ไนจีเรีย ตองโก ตูนิเซีย และฮอลแลนด์

- การขาดวัคซีนป้องกันโควิด-19 เชื่อมโยงกับแหล่งข้อมูลเท็จที่หลากหลาย

- การเสียชีวิตที่ชาร์ลอตส์วิลล์ หนุนโดยฟอรัมหัวรุนแรงฝ่ายขวา

- การยิง 'Pizzagate' พร้อมรากฐานใน QAnon

นอกจากนี้ ยังพบว่าข้อมูลที่ผิดได้บ่อนทำลายความไว้วางใจของเราในสถาบันต่างๆ และเผยแพร่วิทยาศาสตร์เท็จ ซึ่งส่งผลกระทบต่อสาธารณสุขและขัดขวางกระบวนการประชาธิปไตย

แล้วควรดำเนินการอย่างไร?

อาร์กิวเมนต์ต่อต้านการเซ็นเซอร์

เพื่อต่อสู้กับอันตรายของข้อมูลที่ผิด ผู้สนับสนุนกำลังโต้เถียงกันเพื่อให้รัฐเข้าแทรกแซงเพื่อควบคุมสื่อสังคมออนไลน์และเพื่อลบข้อมูลที่ผิด

ตัวอย่างเช่น เลขาธิการสหประชาชาติ อันโตนิโอ กูเตอร์เรส เรียกร้องให้มีกฎเกณฑ์ระดับโลกเพื่อควบคุมเนื้อหาโซเชียลมีเดีย

“ฉันไม่คิดว่าเราจะอยู่ในโลกที่บริษัทจำนวนมากได้รับอำนาจมากเกินไป เราต้องการกรอบการกำกับดูแลใหม่พร้อมกฎเกณฑ์ที่อนุญาตให้ดำเนินการได้ตามกฎหมาย”

~ เลขาธิการสหประชาชาติ อันโตนิโอ กูเตอร์เรส

เป็นการยากที่จะไม่เห็นด้วยกับความรู้สึกที่อยู่เบื้องหลังข้อความนี้ หากไม่มีการตรวจสอบที่เหมาะสม อำนาจของบริษัทเทคโนโลยีก็อาจพุ่งเกินการควบคุมของเรา

อย่างไรก็ตาม ก่อนที่เราจะให้อำนาจแก่หน่วยงานที่จะอนุญาตให้พวกเขาตัดสินใจว่าเราใช้ข้อมูลใด เราควรพิจารณาถึงข้อเสียที่อาจเกิดขึ้น

ประการแรก การเซ็นเซอร์โพสต์บนโซเชียลมีเดียอาจเป็นการละเมิดมาตราของพระราชบัญญัติสิทธิมนุษยชน ซึ่งระบุว่า:

"ทุกคนมีสิทธิที่จะมีเสรีภาพในการแสดงออก. สิทธินี้จะรวมถึงเสรีภาพในการแสดงความคิดเห็นและรับและส่งผลกระทบต่อข้อมูลและความคิดโดยไม่มีการแทรกแซงจากหน่วยงานสาธารณะ”

~ มาตรา 10 แห่งพระราชบัญญัติสิทธิมนุษยชน

ที่น่าสนใจคือ รัฐบาลสหราชอาณาจักรกำลังพยายามปฏิรูปกฎหมายว่าด้วยสิทธิมนุษยชน แทนที่ด้วย "ร่างกฎหมาย"

การเปลี่ยนแปลงที่เสนออย่างหนึ่งคือสิทธิมนุษยชนของบุคคลอาจถูกละเมิดได้หาก “ปกป้องผลประโยชน์สาธารณะในวงกว้าง” (หน้า 56 การปฏิรูปสิทธิมนุษยชน) การเปลี่ยนแปลงนี้อาจอนุญาตให้มีการเซ็นเซอร์ข้อมูลที่ผิดโดยรัฐมากขึ้น

ข้อโต้แย้งประการที่สองที่ต่อต้านการเซ็นเซอร์ข้อมูลเท็จก็คือ การเปิดกว้างสำหรับการละเมิดโดยระบอบการเมืองที่ต้องการรวมอำนาจไว้ที่ศูนย์กลาง อำนาจในการตัดสินใจว่าข้อมูลใดเป็นหรือไม่เป็นข้อมูลที่ไม่ถูกต้องอาจนำไปสู่การปราบปรามการประท้วง การดำเนินการโดยรวม และการเคลื่อนไหวทางการเมือง

Arab Spring อาจเกิดขึ้นได้หรือไม่หาก Twitter และ Facebook ถูกทางการเฝ้าระวัง?

แม้ว่านักข่าวจะมีบทบาทในโซเชียลมีเดียมากเกินไปในอาหรับสปริง การวิเคราะห์ทางวิชาการอย่างรอบคอบพบว่าสื่อสังคมออนไลน์ได้นำไปสู่การเพิ่มการดำเนินการในเชิงบวกในประเทศที่มีรัฐบาลที่กดขี่

นอกจากนี้เรายังสามารถดูประวัติของประเทศที่แบนแพลตฟอร์มโซเชียลมีเดีย:

- จีน

- รัสเซีย

- อิหร่าน

- เกาหลีเหนือ

ประเทศทั้งหมดเหล่านี้มีรายชื่ออยู่ใน "ดัชนีเสรีภาพในโลก" ว่ามีเสรีภาพพลเมืองที่เลวร้ายที่สุดในโลก ฉันไม่ได้เถียงว่าพวกเขามีเสรีภาพพลเมืองที่ไม่ดี เพราะ พวกเขาไม่อนุญาตให้มีโซเชียลมีเดีย แต่สังเกตว่ารัฐที่พยายามควบคุมข้อมูลออนไลน์มักจะมีประวัติที่ไม่ดีเกี่ยวกับสิทธิมนุษยชน

แม้ว่าการเซ็นเซอร์ของรัฐจะไม่ใช่วิธีแก้ปัญหา แต่เราก็ยังมีปัญหาอยู่

ความเชื่อถือในแหล่งข่าวแบบเดิมๆ ระเหยไปอย่างรวดเร็ว ข้อมูลเท็จทำให้เกิดกระแสลมแรงพอที่จะพัดพาสิ่งที่เราจับผิดออกไปได้ สิ่งนี้ได้ทำร้ายสังคมผ่านความลังเลใจในวัคซีน ความคลั่งไคล้ที่เพิ่มขึ้น และการขัดขวางกระบวนการประชาธิปไตย

แต่การตอบโต้แบบสะบัดเข่าด้วยการมอบอำนาจให้รัฐในการตัดสินว่าอะไรเป็นความจริง อาจสร้างความเสียหายมากกว่าการให้ข้อมูลเท็จ

และอย่างไรก็ตาม มีแนวโน้มว่าจะเป็นการละเมิดสิทธิมนุษยชน

ความท้าทายในการแก้ปัญหาของ Facebook

เป้าหมายของ Facebook คือการป้องกันการควบคุมโดยรัฐบาลผ่านการควบคุมตนเอง

กลยุทธ์ของพวกเขาเพื่อจัดการกับข้อมูลที่ผิดรวมถึง:

- การใช้แมชชีนเลิร์นนิงเพื่อตรวจจับข้อมูลที่ผิด

- ทีมตอบสนองต่อการเปลี่ยนแปลงเนื้อหาที่ถูกตั้งค่าสถานะ

- ร่วมมือกับองค์กรตรวจสอบข้อเท็จจริงบุคคลที่สามเพื่อตรวจสอบเนื้อหา

อย่างไรก็ตาม Facebook เองจะยอมรับข้อ จำกัด ของแนวทางอัตโนมัติส่วนใหญ่นี้ ตัวอย่างเช่น โปรแกรมอัตโนมัติจะกำหนดความแตกต่างระหว่างเว็บไซต์เสียดสีและข้อมูลเท็จโดยเจตนาได้อย่างไร

นอกจากนี้ยังมีคลิกเบตจำนวนมากเพื่อจุดประสงค์เดียวในการเปลี่ยนการคลิกเป็นรายได้จากการโฆษณา ไซต์เหล่านี้มักใช้ไซต์เทมเพลตที่ดูเหมือนเว็บไซต์ข่าวอย่างเป็นทางการที่มีหัวข้อข่าวที่น่าดึงดูด ซึ่งมักหลอกให้ผู้ดูคลิก

ไซต์เหล่านี้ไม่ใช่ข้อมูลที่ผิด แต่ก็ไม่ใช่แหล่งข้อมูลที่เชื่อถือได้เช่นกัน

ระหว่างเสียดสีกับคลิกเบต มีคอลัมน์ซุบซิบและวารสารศาสตร์เกี่ยวกับความคิดเห็น นี่คือสื่อที่ “ถูกกฎหมาย” ที่ไม่อ้างว่ามีความเป็นกลาง ตัวอย่างเช่น เบน ชาปิโร นักวิจารณ์สื่ออเมริกันฝ่ายขวา ยอมรับอย่างเปิดเผยว่าเว็บไซต์ข่าวของเขา The Daily Wire ไม่ได้มีไว้เพื่อรายงานข่าว แต่เพื่อ 'ชนะสงครามวัฒนธรรม' การหมุนและการพูดเกินจริงโดยทั่วไปของผู้เผยแพร่เหล่านี้เป็นพื้นที่สีเทาสำหรับโปรแกรมอัตโนมัติที่กำลังมองหาข้อมูลที่ผิด

Mark Zuckerberg ได้กล่าวเมื่อเร็ว ๆ นี้ว่า "Facebook จัดการกับข้อมูลที่ไม่ถูกต้องมากกว่าบริษัทอื่น" เขาอาจจะถูกต้อง แต่เพียงพอหรือไม่

ทางออกที่เสนอ

เราได้เห็นวิธีการแก้ไขข้อมูลที่ผิดเป็นความขัดแย้งของค่านิยม: เสรีภาพในการแสดงออกและเสรีภาพจากอันตราย วิธีแก้ปัญหาใด ๆ จะต้องพยายามทำให้ทั้งสองสมดุล

ฉันเสนอวิธีแก้ปัญหาที่เป็นไปได้เป็นการทดลองทางความคิดเท่านั้น ท้ายที่สุดแล้ว การเลือกช่องโหว่ในงานของผู้อื่นง่ายกว่า และแนะนำตัวเองได้ยากกว่ามาก เป็นที่ยอมรับว่านี่ไม่ใช่ความเชี่ยวชาญของฉัน และข้อเสนอแนะใด ๆ จะไม่สามารถทำได้อย่างดีที่สุด!

ด้วยคำเตือนดังกล่าว ข้าพเจ้าขอเสนอสามจุด:

- อย่าพยายามเซ็นเซอร์ข้อมูลที่ผิดในโพสต์โซเชียลมีเดียของแต่ละบุคคล

- ส่งเสริมเนื้อหาที่เชื่อถือได้มากกว่าการมีส่วนร่วมอัลกอริทึม

- ห้องจำกัดเสียงสะท้อน

1. ไม่เซ็นเซอร์ข้อความที่ผิดในโพสต์ของแต่ละคน

สิ่งนี้ปกป้องสิทธิมนุษยชนของแต่ละบุคคล นอกจากนี้ยังปกป้องนักเคลื่อนไหวที่ต้องการใช้โซเชียลมีเดียเพื่อต่อต้านระบอบการเมืองที่กดขี่

แต่นี่ไม่ใช่เสรีภาพในการพูดแต่อย่างใด

Facebook ควรดำเนินการลบเนื้อหาที่สนับสนุนพฤติกรรมรุนแรง การกลั่นแกล้ง การแสวงประโยชน์ และคำพูดแสดงความเกลียดชังต่อไป

2. ส่งเสริมเนื้อหาที่เชื่อถือได้มากกว่าเนื้อหาที่มีส่วนร่วม

อัลกอริธึม “EdgeRank” ของ Facebook เป็นตัวกำหนดเนื้อหาที่จะแสดงในฟีดข่าวของคุณและเรียงลำดับอย่างไร

มันพยายามปรับแต่งฟีดของคุณผ่านการผสมผสานความสนใจส่วนตัวของคุณกับวิธีที่ชุมชนในวงกว้างโต้ตอบกับโพสต์เฉพาะ

อัลกอริทึมของ Facebook ส่งเสริมเนื้อหาที่มีส่วนร่วมสูง บ่อยครั้งวิธีนี้ใช้ได้ผลดี และคุณเห็นโพสต์จากเพื่อนและครอบครัว พร้อมกับมีมไวรัลและวิดีโอเกี่ยวกับแมว อย่างไรก็ตาม กลไกเดียวกันนี้ยังส่งเสริมเนื้อหาเกี่ยวกับอารมณ์ ซึ่งมักสร้างความแตกแยกหรือไม่จริง

อย่างไรก็ตาม อัลกอริธึมนี้สามารถปรับให้ทำงานในลักษณะเดียวกันกับอัลกอริธึม PageRank ของ Google

Google ส่งเสริมเนื้อหาที่เชื่อถือได้ แทนที่จะมีส่วนร่วม โดยวิเคราะห์ว่าเว็บไซต์อื่นๆ อ้างอิงเนื้อหาในรูปแบบของไฮเปอร์ลิงก์หรือ "ลิงก์ย้อนกลับ" กี่ครั้ง ตัวอย่างเช่น ฉันกำลังอ้างอิงถึงรายละเอียดที่แจกแจงโดยละเอียดว่าอัลกอริธึม PageRank ของ Google ทำงานอย่างไร เป็นตัวบ่งชี้ถึงความน่าเชื่อถือของหน้านั้น

เมื่อบุคคลโพสต์บทความจากเว็บไซต์บน Facebook ทาง Facebook ไม่จำเป็นต้องตรวจสอบข้อเท็จจริงของเว็บไซต์ แต่อัลกอริธึมสามารถกำหนดอำนาจของเว็บไซต์ในลักษณะที่คล้ายคลึงกับ Google แทน

หากแหล่งข่าวเชื่อถือได้ เช่น BBC ก็จะถูกจัดลำดับความสำคัญในฟีดข่าวมากกว่าข้อมูลที่ผิด สแปม หรือคลิกเบต

วิกฤต กระบวนการนี้มีการกระจายอำนาจ

ไม่มีใครตัดสินใจว่า BBC มีอำนาจ ในทางกลับกัน ข้อสรุปนี้เป็นผลมาจากการระดมมวลชน

เว็บไซต์หลายล้านแห่งได้อ้างอิง BBC เช่นเดียวกับนักวิชาการที่เชื่อถือได้ได้รับการอ้างอิงหากงานของพวกเขาถูกต้องตามกฎหมาย ดังนั้นความเสี่ยงของการควบคุมจากส่วนกลางจึงลดลง

วิธีแก้ปัญหาที่เสนอนี้จะช่วยลดการเข้าถึงข้อมูลที่ไม่ถูกต้องโดยไม่จำเป็นต้องให้ Facebook เป็นตำรวจทางอินเทอร์เน็ต

เหตุใด Facebook จึงไม่ลองทำอะไรแบบนี้อยู่แล้ว

มันจะลดรายได้จากการโฆษณาของพวกเขา การโปรโมตเนื้อหาที่เชื่อถือได้มากกว่าเนื้อหาที่มีส่วนร่วมจะทำให้ฟีดข่าวของคุณ… น่าเบื่อ ซึ่งหมายความว่าใช้เวลาบนแพลตฟอร์มน้อยลง คลิกน้อยลง และรายได้จากการโฆษณาน้อยลง

นอกจากนี้ยังมีปัญหาเล็กน้อยที่ Google เป็นเจ้าของทรัพย์สินทางปัญญาของ PageRank Facebook จะต้องพัฒนาอัลกอริธึมของตัวเองที่สามารถให้ผลลัพธ์ที่คล้ายคลึงกัน แต่มีวิธีการที่แตกต่างกันเพียงพอเพื่อหลีกเลี่ยงการละเมิด IP

ฉันบอกว่านี่เป็นเพียงการทดลองทางความคิดที่ถูกจำกัดด้วยความเป็นไปไม่ได้!

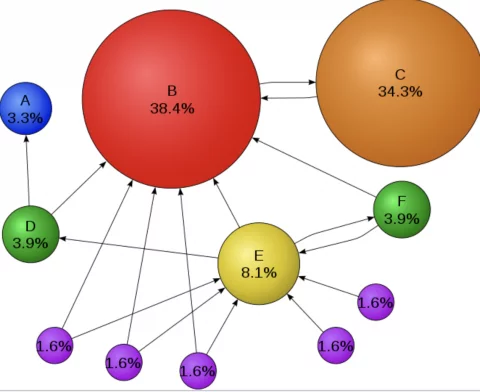

3. จำกัดห้องเสียงสะท้อน

การวิจัยชี้ให้เห็นว่าข้อมูลที่ผิดจะไม่เดินทางไกลในที่ที่มีห้องเสียงสะท้อนน้อยลง นอกจากนี้ ทฤษฎีโพลาไรเซชันของกลุ่มยังแนะนำว่าห้องสะท้อนเสียงจะย้ายทั้งกลุ่มไปยังตำแหน่งที่รุนแรงมากขึ้น

นี่แสดงให้เห็นว่าข้อมูลที่ผิดอาจไม่ใช่ปัญหา – อาจเป็นห้องเสียงสะท้อน…

ในเครือข่ายที่มีกลุ่มผู้ใช้ที่แยกจากกันน้อยลง ข้อมูลที่ผิดจะเดินทางไกลน้อยลงและมีผลกระทบต่อผู้ที่เข้าถึงน้อยลง ปัญหาคือวลี "cluster of segregated users" เป็นวิธีทางเทคนิคในการพูดว่า "the community"!

ชุมชนเป็นหัวใจสำคัญของ Facebook แต่ก็เป็นสิ่งที่ผลักดันให้เกิดโพลาไรเซชัน

ดังนั้นการลบห้องสะท้อนเสียงจึงไม่สามารถทำได้ แต่สามารถดำเนินการตามขั้นตอนเพื่อจำกัดอันตรายได้

ขั้นตอนเหล่านี้อาจรวมถึง:

- Facebook สามารถให้คุณสมบัติสำหรับผู้ใช้ในการปิดการปรับเปลี่ยนในแบบของคุณในฟีดข่าวของเรา เพื่อให้เราเห็นว่าผู้อื่นกำลังบริโภคอะไรอยู่ โดยปราศจากอัลกอริธึม

- Facebook สามารถตั้งค่าสถานะเนื้อหาที่มีการแบ่งขั้วสูงหรือเข้าข้าง และให้ตัวเลือกในการดูควบคู่ไปกับเนื้อหาจากมุมมองของฝ่ายตรงข้าม

- สามารถติดป้ายยืนยันในเนื้อหาที่สอดคล้องกับจรรยาบรรณสื่อสารมวลชน

นอกจากนี้ยังสามารถให้การศึกษาเพื่อช่วยให้บุคคลก้าวออกจากห้องสะท้อนเสียงของตนเอง เรามีหน้าที่ในการขอ "การยืนยัน"

ไม่ใช่เรื่องธรรมชาติสำหรับเรา แต่การเป็นพลเมืองที่ได้รับแจ้งหมายถึงการใช้ข้อมูลที่เราอาจไม่เห็นด้วยเสมอไป

เราทุกคนจะได้ประโยชน์จากการมั่นใจน้อยลงเล็กน้อย

สรุป

การเชื่อมต่อทางสังคมก่อตัวขึ้นในสังคมของเรา แต่แนวโน้มของเราที่จะสร้างชุมชนที่มีความคิดเหมือนๆ กันนั้นสามารถถูกเอารัดเอาเปรียบได้ ซึ่งนำไปสู่ข้อมูลที่ผิดและทำให้เกิดการแบ่งแยก การเซ็นเซอร์ไซเรนอาจดูเหมือนวิธีแก้ปัญหาที่น่าสนใจ แต่อาจหลอกล่อเราให้เข้าหาหินที่เราหลีกเลี่ยงได้ดีกว่า

การนำการอ้างสิทธิ์ออกนอกฉันทามติอาจดูเหมือนเป็นที่น่าพอใจ แต่มีแนวโน้มว่าจะทำให้ปัญหาแย่ลง การเซ็นเซอร์อาจทำให้ผู้คนไม่ไว้วางใจผู้มีอำนาจน้อยลง ผลักดันมุมมองที่มุ่งร้ายลงไปใต้ดินในที่ที่มันสามารถแพร่กระจายได้

เราควรแสวงหาโซลูชันแบบกระจายอำนาจแทน

แนวทางแก้ไขที่ลดอันตรายจากข้อมูลที่ผิดในขณะที่ปกป้องสิทธิมนุษยชนขั้นพื้นฐานของเรา – สิทธิในเสรีภาพในการแสดงออก