Wie sollten soziale Medien auf Fehlinformationen reagieren?

Veröffentlicht: 2022-03-09Als Gesellschaft haben wir eine komplizierte Beziehung zu sozialen Medien. Wenn wir von Online-Mobbing, Fehlinformationen und Hassreden hören, verurteilen wir zu Recht den hässlichen Schatten, den sie auf die Gesellschaft werfen. Aber wenn Russland Facebook verbietet, um das Narrativ um die Ukraine zu kontrollieren, fühlt es sich an, als würde ein grundlegendes Menschenrecht weggenommen.

Unsere Verwirrung ist auf einen Wertekonflikt zurückzuführen: Meinungsfreiheit vs. Freiheit von Schaden. Und es ist eine der wichtigsten Debatten unserer Zeit. Aber es ist auch eine Debatte, die allzu vereinfacht, polarisiert und tribal geworden ist.

Was sind die beiden Seiten dieser Debatte?

Die eine Seite sind die Meinungsfreiheits-Absolutisten, die keine Regeln wollen. Sie haben den Aufstieg neuer Social-Media-Plattformen wie Gab und Donald Trumps „Truth Social“ vorangetrieben, die keine Grenzen für das, was Sie posten, haben. Sie sind schnell in weißen Nationalismus, Antisemitismus und QAnon-Verschwörungstheorien verfallen.

Die andere Seite strebt eine stärkere staatliche Regulierung von Social Media an. Dies hat zu neuen Initiativen wie Google Fact Check, Good Information Inc und Trusted News Summit geführt, die versuchen zu überprüfen, was wahr ist. Diese Seite unterschätzt oft die Risiken, die mit der Gewährung staatlicher Befugnisse zur Überwachung des Internets verbunden sind. Beispiele dafür, wie dies schief gehen kann, sind das Durchgreifen von Social Media durch politische Regime, die versuchen, den freien Informationsfluss zu kontrollieren.

Am Beispiel von Meta (ich benutze „Facebook“, um die spezifische Social-Media-Plattform zu unterscheiden) werde ich beide Seiten der Debatte untersuchen – und ich schlage eine Lösung vor, die darauf abzielt, den Wertekonflikt zu lösen.

Facebook unter Beschuss

Fast ein Viertel der Weltbevölkerung nutzt Facebook und ist damit die beliebteste Social-Media-Plattform der Welt.

Aber die Glaubwürdigkeit ihrer erklärten Mission, „Gemeinschaft aufzubauen und die Welt näher zusammenzubringen“, ist kürzlich unter Beschuss geraten.

Whistleblower haben Facebook beschuldigt, wissentlich den Profit der Gesellschaft vorzuziehen; Sie argumentieren, dass Facebook durch die Förderung von Fehlinformationen die Integrität des demokratischen Prozesses schwäche. Darüber hinaus wird argumentiert, dass Fehlinformationen in den sozialen Medien die Fähigkeit der Gesellschaft geschwächt haben, effektiv auf die Pandemie zu reagieren.

Mark Zuckerberg antwortete mit folgendem:

„Die Vorstellung, dass wir Fehlinformationen auf unserer Plattform schwelen lassen oder irgendwie von diesen Inhalten profitieren, ist falsch.“

Facebook verteidigt sich damit, dass sie mehr Partner zur Überprüfung von Fakten haben als jede andere Technologieplattform. Ihre Bemühungen sind sicherlich beeindruckend und entfernen jeden Monat über 5 Millionen hasserfüllte Inhalte.

Facebook weist Sie auch auf seine Community-Standards hin, die 4 Arten von Inhalten auflisten, für die sie Maßnahmen ergreifen können:

- Gewalttätiges und kriminelles Verhalten

- Sicherheitsbedenken (wie Mobbing, Kindesmissbrauch, Ausbeutung)

- Anstößige Inhalte wie Pornos und Hassreden

- Unauthentische Inhalte (z. B. Fehlinformationen)

Von diesen gibt es wenig Kontroversen über die Punkte 1 bis 3. Es besteht weitgehend Einigkeit darüber, dass Facebook handeln sollte, um Schäden durch Gewalt, Mobbing und Hassreden zu verhindern.

Es ist Punkt 4, Fehlinformationen, der umstritten ist.

Der Aufstieg von Fehlinformationen

Es fühlt sich manchmal so an, als wären wir darauf vorbereitet, gleichzeitig alles und nichts zu glauben.

Und dieses Gefühl ist nicht neu.

1835 behauptete die Zeitung New York Sun, es gäbe eine außerirdische Zivilisation auf dem Mond. Es verkaufte sich so gut, dass es die New York Sun als führende Publikation etablierte.

Gezielte Fehlinformationen als Form der psychologischen Kontrolle haben jedoch erst mit dem Aufkommen der digitalen Kommunikation zugenommen.

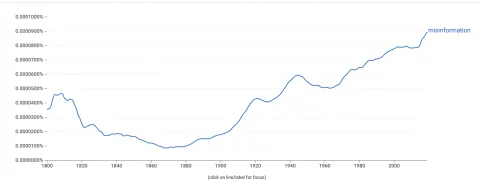

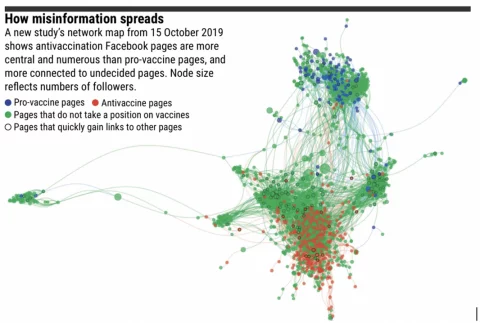

Der Google Ngram Viewer, der die Häufigkeit misst, mit der Wörter in Büchern vorkommen, zeigt einen steilen Anstieg in unserer Verwendung des Wortes „Fehlinformationen“.  Um dies zu verstehen, sollten wir verstehen, wie sich Fehlinformationen verbreiten.

Um dies zu verstehen, sollten wir verstehen, wie sich Fehlinformationen verbreiten.

Die Algorithmen von Facebook sind für Engagement optimiert – dies fördert oft Inhalte, die eine starke emotionale Reaktion hervorrufen. Was für den Algorithmus wichtig ist, ist das Engagement, nicht die Wahrhaftigkeit der geteilten Informationen.

Interessanterweise verbreiten sich Fehlinformationen nicht weit, wenn es nur wenige Echokammern gibt. Inhalte werden bis zu einem Benutzer weitergeleitet, der damit nicht einverstanden ist, der sie anschließend auf Fakten überprüft und sie als Fehlinformationen entlarvt.

Online-Gruppen werden jedoch zunehmend durch ideologische Überzeugungen getrennt. In diesen Blasen können Fehlinformationen weit durch das Netzwerk reisen, ohne dass sie in Frage gestellt werden.

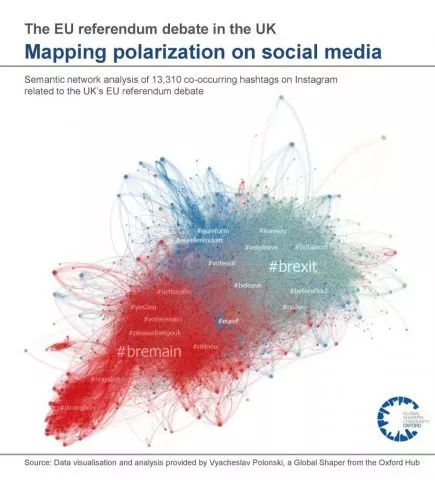

Unten finden Sie eine visuelle Darstellung der Echokammern der britischen EU-Referendumsdebatte:

Bestätigungsverzerrung ist unsere Tendenz, Informationen zu suchen und zu glauben, die mit unseren bestehenden Ansichten übereinstimmen. Psychologen wissen, dass es schwierig ist, die Meinung einer Person zu ändern, wenn sie einmal feststeht. Stattdessen zielen Fehlinformationen darauf ab, Algorithmen, Echokammern und Bestätigungsverzerrungen auszunutzen, um bestehende Ansichten zu verstärken und zu stärken . Dies kann zu Extremismus führen.

Dies ist besonders problematisch, wenn es in die reale Welt übergeht.

Beispiele für die realen Auswirkungen von Fehlinformationen:

- Die Angriffe auf das Kapitol von 2021 mit Wurzeln in der QAnon-Verschwörungstheorie

- Gestörte Wahlen in Ländern wie Ghana, Nigeria, Tongo, Tunesien und Holland

- Mangelnde Aufnahme von Covid-19-Impfstoffen im Zusammenhang mit einer Vielzahl von Fehlinformationsquellen

- Die Todesfälle in Charlottesville, angeheizt von rechtsextremen Foren

- 'Pizzagate'-Shootings, ebenfalls mit Wurzeln in QAnon

Darüber hinaus wurde festgestellt, dass Fehlinformationen unser Vertrauen in Institutionen untergraben und falsche Wissenschaft verbreiten, was sich auf die öffentliche Gesundheit auswirkt und den demokratischen Prozess stört.

Welche Maßnahmen sollten also ergriffen werden?

Das Argument gegen die Zensur

Um den Schaden von Fehlinformationen zu bekämpfen, plädieren Befürworter für ein stärkeres staatliches Eingreifen, um soziale Medien zu regulieren und Fehlinformationen zu entfernen.

So forderte beispielsweise der Chef der Vereinten Nationen, Generalsekretär Antonio Guterres, globale Regeln zur Regulierung von Social-Media-Inhalten.

„Ich glaube nicht, dass wir in einer Welt leben können, in der einer reduzierten Anzahl von Unternehmen zu viel Macht eingeräumt wird. Wir brauchen einen neuen Ordnungsrahmen mit Regeln, die dies gesetzeskonform ermöglichen.“

~ Chef der Vereinten Nationen, Generalsekretär Antonio Guterres

Es ist schwer, der Stimmung hinter dieser Aussage zu widersprechen. Ohne angemessene Kontrollen könnte sich die Macht von Technologieunternehmen unserer Kontrolle entziehen.

Bevor wir jedoch Stellen Befugnisse erteilen, die es ihnen ermöglichen, zu entscheiden, welche Informationen wir konsumieren, sollten wir die potenziellen Nachteile berücksichtigen.

Erstens kann die Zensur von Social-Media-Beiträgen eine Verletzung des Artikels des Menschenrechtsgesetzes darstellen, der besagt:

„Jeder hat das Recht auf freie Meinungsäußerung. Dieses Recht schließt die Freiheit ein, Meinungen zu vertreten und Informationen und Ideen ohne behördliche Eingriffe zu erhalten und zu beeinflussen.“

~ Artikel 10 des Menschenrechtsgesetzes

Interessanterweise versucht die britische Regierung derzeit, das Menschenrechtsgesetz zu reformieren und durch eine „Bill of Rights“ zu ersetzen.

Eine vorgeschlagene Änderung ist, dass die Menschenrechte einer Person verletzt werden könnten, wenn dies „das breitere öffentliche Interesse schützt“ (Seite 56, Menschenrechtsreform). Diese Änderung kann eine stärkere Zensur von Fehlinformationen durch den Staat ermöglichen.

Ein zweites Argument gegen die Zensur von Fehlinformationen ist, dass sie von politischen Regimen, die die Macht zentralisieren wollen, missbraucht werden können. Die Macht zu entscheiden, was Fehlinformation ist – und was nicht – könnte dazu führen, dass Protest, kollektives Handeln und politischer Aktivismus unterbunden werden.

Hätte es zum Arabischen Frühling kommen können, wenn Twitter und Facebook von den Behörden überwacht worden wären?

Während die Rolle der sozialen Medien im Arabischen Frühling wahrscheinlich von Journalisten übertrieben wird, haben sorgfältige wissenschaftliche Analysen ergeben, dass soziale Medien tatsächlich zu einer Zunahme positiver kollektiver Aktionen in Ländern mit repressiven Regierungen geführt haben.

Darüber hinaus können wir uns die Erfolgsbilanz von Ländern ansehen, die Social-Media-Plattformen verboten haben:

- China

- Russland

- Iran

- Nord Korea

Alle diese Länder sind im „Index of Freedom in the World“ als Länder mit den schlechtesten Bürgerrechten der Welt aufgeführt. Ich behaupte nicht, dass sie schlechte bürgerliche Freiheiten haben, weil sie soziale Medien nicht zulassen, sondern beobachte, dass Staaten, die versuchen, Informationen online zu kontrollieren, in Bezug auf die Menschenrechte tendenziell schlechte Bilanzen haben.

Auch wenn staatliche Zensur keine Lösung ist, haben wir ein Problem.

Das Vertrauen in traditionelle Nachrichtenquellen schwindet schnell. In dieses Vakuum rauschen Fehlinformationen und erzeugen einen Wind, der stark genug ist, dass er unseren Halt an der Wahrheit weggeblasen hat. Dies hat der Gesellschaft durch Impfzögerlichkeit, zunehmenden Extremismus und die Störung demokratischer Prozesse geschadet.

Aber eine reflexartige Reaktion, bei der dem Staat die Befugnis übertragen wird, zu entscheiden, was wahr ist, könnte größeren Schaden anrichten als Fehlinformationen.

Und außerdem ist es wahrscheinlich eine Verletzung der Menschenrechte.

Herausforderungen an die Lösung von Facebook

Ziel von Facebook ist es, staatliche Regulierung durch Selbstregulierung zu verhindern.

Ihre Strategie zur Bekämpfung von Fehlinformationen umfasst:

- Anwendung von maschinellem Lernen zur Erkennung von Fehlinformationen

- Response-Teams, um gekennzeichnete Inhalte zu ändern

- Partnerschaft mit externen Organisationen zur Überprüfung von Fakten, um Inhalte zu überprüfen

Facebook selbst wird jedoch Grenzen dieses weitgehend automatisierten Ansatzes einräumen. Wie würde beispielsweise ein automatisiertes Programm den Unterschied zwischen satirischen Websites und vorsätzlicher Fehlinformation feststellen?

Darüber hinaus gibt es riesige Mengen an Clickbait, die ausschließlich dazu dienen, Klicks in Werbeeinnahmen umzuwandeln. Diese verwenden oft vorgefertigte Websites, die wie offizielle Nachrichten-Websites mit verlockenden Schlagzeilen aussehen und die Zuschauer oft zum Klicken verleiten.

Diese Seiten sind keine Fehlinformationen, aber sie sind auch keine vertrauenswürdigen Informationsquellen.

Zwischen Satire und Clickbait gibt es Klatschkolumnen und Meinungsjournalismus. Dabei handelt es sich um „legitime“ Medien, die keinen Anspruch auf Objektivität erheben. Zum Beispiel gibt Ben Shapiro, ein rechtsgerichteter amerikanischer Medienkommentator, offen zu, dass seine Nachrichten-Website The Daily Wire nicht existiert, um die Nachrichten zu verbreiten, sondern um „einen Kulturkrieg zu gewinnen“. Der für diese Verlage typische Spin und die Übertreibung ist eine Grauzone für automatisierte Programme, die nach Fehlinformationen suchen.

Mark Zuckerberg hat kürzlich gesagt, dass „Facebook mehr tut, um Fehlinformationen zu bekämpfen, als jedes andere Unternehmen“. Er mag recht haben. Aber reicht es?

Ein Lösungsvorschlag

Wir haben gesehen, dass die Lösung für Fehlinformationen ein Wertekonflikt ist: Meinungsfreiheit vs. Jede Lösung muss danach streben, beides in Einklang zu bringen.

Ich biete eine mögliche Lösung nur als Gedankenexperiment an – schließlich ist es einfacher, Lücken in der Arbeit anderer zu finden und viel schwieriger, selbst etwas vorzuschlagen. Zugegeben, das ist nicht mein Fachgebiet und alle Vorschläge sind bestenfalls unpraktisch!

Mit diesem Vorbehalt würde ich drei Punkte vorschlagen:

- Versuchen Sie nicht, Fehlinformationen in den Social-Media-Beiträgen einer Person zu zensieren

- Bewerben Sie maßgebliche Inhalte algorithmisch über Engagement

- Echokammern begrenzen

1. Fehlinformationen in den Posts von Einzelpersonen nicht zensieren

Dies schützt die Menschenrechte einer Person. Es schützt auch Aktivisten, die soziale Medien nutzen möchten, um gegen repressive politische Regime zu mobilisieren.

Aber das ist nicht Meinungsfreiheit um jeden Preis.

Facebook sollte weiterhin Inhalte entfernen, die gewalttätiges Verhalten, Mobbing, Ausbeutung und Hassreden fördern.

2. Förderung maßgeblicher Inhalte gegenüber ansprechenden Inhalten

Der „EdgeRank“-Algorithmus von Facebook bestimmt, welche Inhalte in Ihrem Newsfeed in welcher Reihenfolge angezeigt werden.

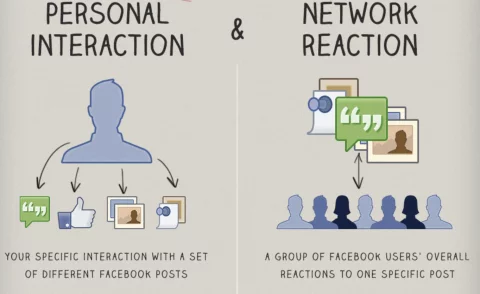

Es versucht, Ihren Feed durch eine Kombination aus Ihren persönlichen Interessen und der Interaktion der breiteren Community mit einem bestimmten Beitrag zu personalisieren.

Der Algorithmus von Facebook fördert Inhalte mit hohem Engagement. Oft funktioniert das gut und Sie sehen Posts von Freunden und Familie neben viralen Memes und Katzenvideos. Derselbe Mechanismus fördert jedoch auch emotionale Inhalte, die oft spaltend oder unwahr sind.

Der Algorithmus könnte jedoch so angepasst werden, dass er ähnlich wie der PageRank-Algorithmus von Google funktioniert.

Google fördert maßgebliche – im Gegensatz zu ansprechenden – Inhalten. Dazu wird analysiert, wie oft andere Websites auf einen Inhalt in Form von Hyperlinks oder „Backlinks“ verweisen. Wenn ich Sie beispielsweise auf diese detaillierte Aufschlüsselung der Funktionsweise des PageRank-Algorithmus von Google verweise, ist dies ein Indikator für die Vertrauenswürdigkeit dieser Seite.

Wenn eine Person einen Artikel von einer Website auf Facebook postet, muss Facebook die Website nicht unbedingt auf Fakten überprüfen. Stattdessen könnte es ähnlich wie Google algorithmisch die Autorität der Website bestimmen.

Wenn die Nachrichtenquelle maßgeblich ist, wie z. B. die BBC, wird sie in Nachrichtenfeeds gegenüber Fehlinformationen, Spam oder Clickbait priorisiert.

Entscheidend ist, dass dieser Prozess dezentralisiert ist.

Niemand hat entschieden, dass die BBC maßgeblich ist. Stattdessen ist diese Schlussfolgerung das Ergebnis von Crowdsourcing.

Millionen einzelner Websites haben auf die BBC verwiesen, ähnlich wie ein maßgeblicher Gelehrter Zitate erhält, wenn seine Arbeit legitim ist. Daher werden die Risiken einer zentralisierten Steuerung minimiert.

Diese vorgeschlagene Lösung würde die Reichweite von Fehlinformationen verringern, ohne dass Facebook zur Polizei des Internets werden müsste.

Warum hat Facebook so etwas nicht bereits versucht?

Nun, es würde ihre Werbeeinnahmen schmälern. Die Förderung von maßgeblichen Inhalten gegenüber ansprechenden Inhalten würde Ihren Newsfeed ein bisschen … na ja, langweilig machen. Das bedeutet weniger Verweildauer auf der Plattform, weniger Klicks und weniger Werbeeinnahmen.

Es gibt auch das kleine Problem, dass Google das geistige Eigentum von PageRank besitzt. Facebook müsste einen eigenen Algorithmus entwickeln, der ähnliche Ergebnisse liefern könnte, aber über ausreichend unterschiedliche Methoden verfügt, um IP-Verletzungen zu vermeiden.

Ich habe gesagt, dass dies nur Gedankenexperimente sind, die durch Unpraktikabilität begrenzt sind!

3. Echokammern begrenzen

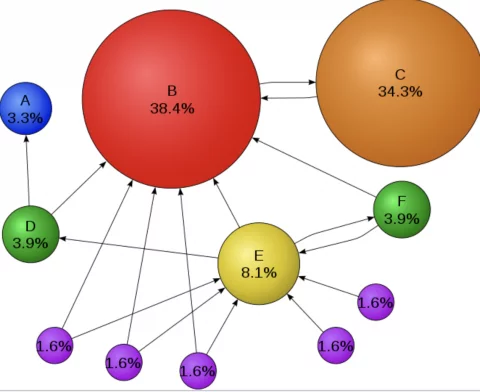

Untersuchungen legen nahe, dass Fehlinformationen dort nicht weit verbreitet werden, wo es weniger Echokammern gibt. Darüber hinaus legt die Gruppenpolarisationstheorie nahe, dass Echokammern ganze Gruppen in extremere Positionen bringen.

Das deutet darauf hin, dass vielleicht nicht die Fehlinformationen das Problem sind – vielleicht sind es Echokammern …

In einem Netzwerk mit weniger Clustern getrennter Benutzer reisen Fehlinformationen weniger weit und haben geringere Auswirkungen auf diejenigen, die sie erreichen. Das Problem ist, dass der Ausdruck „Cluster getrennter Benutzer“ eine technische Art ist, „die Gemeinschaft“ zu sagen!

Die Gemeinschaft ist das Herzstück von Facebook, aber sie treibt auch die Polarisierung voran.

Das Entfernen von Echokammern ist also nicht praktikabel, aber es könnten Schritte unternommen werden, um ihren Schaden zu begrenzen.

Diese Schritte könnten Folgendes umfassen:

- Facebook könnte eine Funktion bereitstellen, mit der Benutzer die Personalisierung in unseren Newsfeeds deaktivieren können, damit wir ohne Algorithmen sehen können, was andere konsumieren.

- Facebook könnte stark polarisierte oder parteiische Inhalte kennzeichnen und Optionen anbieten, um sie neben Inhalten aus der entgegengesetzten Sichtweise zu betrachten

- Verifizierungsplaketten könnten auf Inhalten platziert werden, die dem Verhaltenskodex für Journalismus entsprechen

Darüber hinaus könnte Bildung bereitgestellt werden, um Einzelpersonen dabei zu helfen, aus ihren eigenen Echokammern herauszutreten. Wir haben die Verantwortung, eine „Nichtbestätigung“ zu suchen.

Es ist für uns nicht selbstverständlich, aber ein informierter Bürger zu sein bedeutet, Informationen zu konsumieren, mit denen wir möglicherweise nicht unbedingt einverstanden sind.

Wir alle würden davon profitieren, etwas unsicherer zu sein.

Zusammenfassung

Soziale Verbindungen bilden das Gefüge unserer Gesellschaft. Aber unsere Tendenz, gleichgesinnte Gemeinschaften zu bilden, kann ausgenutzt werden, was zu Fehlinformationen und Spaltung führt. Der Sirenenruf der Zensur mag eine ansprechende Lösung sein, aber er könnte uns zu einem Felsen locken, den wir besser meiden sollten.

Das Entfernen von Behauptungen außerhalb des Konsenses mag wünschenswert erscheinen, verschlimmert das Problem jedoch wahrscheinlich. Zensur kann sogar dazu führen, dass Menschen weniger Vertrauen in Autoritäten haben und böswilligere Ansichten in den Untergrund drängen, wo sie sich ausbreiten könnten.

Stattdessen sollten wir nach dezentralen Lösungen suchen.

Lösungen, die den Schaden von Fehlinformationen minimieren und gleichzeitig unsere grundlegenden Menschenrechte schützen – das Recht auf freie Meinungsäußerung.