21 experimentos de SEO que mudarão a maneira como você pensa sobre SEO (para sempre)

Publicados: 2020-11-10 Acho que você vai concordar comigo quando eu disser:

Acho que você vai concordar comigo quando eu disser:

Existem MAIS equívocos em torno do SEO…

… do que quase qualquer outro aspecto do marketing digital.

E não é surpreendente quando você considera que existem mais de 200 fatores de classificação , mas quase todos estão envoltos em sigilo.

Como o Google não compartilha (e provavelmente nunca compartilhará) o funcionamento interno de seu algoritmo, como você sabe o que realmente funciona?

Como você decifra os mitos de SEO do assunto e o boato do fato?

Você se volta para a ciência, é isso!

BÔNUS: Baixe todos os experimentos de SEO contidos neste post como um guia prático em PDF que você pode imprimir ou salvar em seu computador.

Neste post, vou compartilhar com você 21 incríveis experimentos de SEO (atualizados para o ano de 2021) que desafiarão o que você pensava ser verdade sobre otimização de mecanismos de busca.

Eu até chegaria ao ponto de prever que esses estudos de SEO mudarão a maneira como você faz SEO para sempre.

Você está pronto? Porque tudo está prestes a mudar para você.

Ok, vamos pular:

1. A taxa de cliques afeta as classificações orgânicas (e como usar isso a seu favor)

Este primeiro experimento é um doozy.

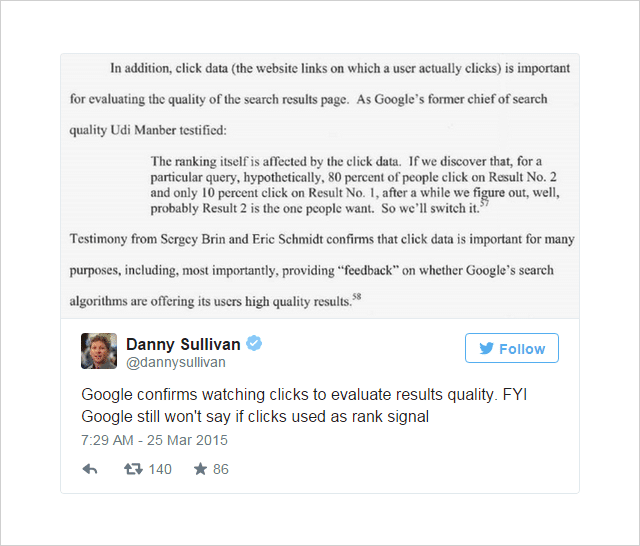

Há algum tempo, existe uma opinião no mundo do SEO de que a taxa de cliques (CTR) pode influenciar a classificação de pesquisa.

Alimentando a opinião estavam algumas pistas fortes (embora não conclusivas) de dentro do Google:

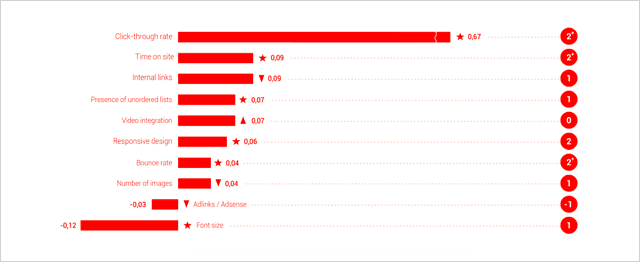

E, os estudos de fatores de classificação da Searchmetrics têm considerado cada vez mais a CTR como um dos fatores de classificação mais importantes.

(Baseado em correlação, não causa, mente)

O argumento como Jamie Richards aponta é que um site que recebe uma taxa de cliques mais alta do que os sites acima dele, pode se sinalizar como um resultado mais relevante e afetar o Google a movê-lo para cima nas SERPs.

A ideia discutida pelo WordStream aqui é semelhante ao Índice de qualidade atribuído aos anúncios do Adwords – um fator determinado em parte pela taxa de cliques relativa de um anúncio versus os outros anúncios ao seu redor.

Essa foi a ideia que Rand Fishkin de Moz se propôs a testar em experimentos consecutivos.

Número um: experimento de volume de consultas e cliques

O cenário de teste que Rand Fishkin usou foi bem simples.

- Faça com que várias pessoas pesquisem uma consulta específica no Google.

- Faça com que essas pessoas cliquem em um resultado específico.

- Registre as alterações na classificação para determinar se o aumento do volume de cliques nesse resultado influencia sua posição.

Para fazer a bola rolar, Rand enviou este Tweet para seus 264 mil seguidores no Twitter:

Quer ajudar com uma teoria/teste do Google? Você poderia pesquisar "IMEC Lab" no Google e clicar no link do meu blog? Eu tenho um palpite.

— Rand Fishkin (@randfish) 1º de maio de 2014

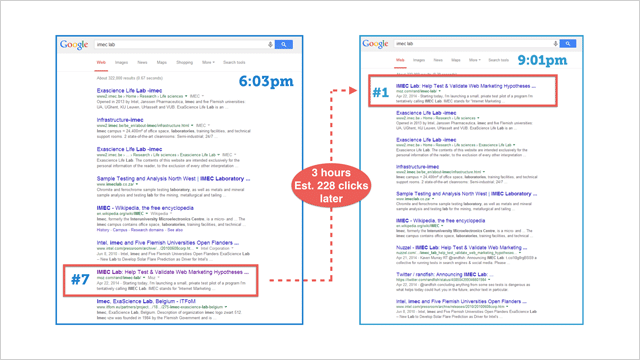

Com base nos dados do Google Analytics, Rand estima que 175-250 pessoas responderam ao seu apelo à ação e clicaram no resultado do IMEC.

Aqui está o que aconteceu:

A página subiu para a posição #1.

Isso indica claramente (pelo menos neste caso específico) que a taxa de cliques influencia significativamente as classificações .

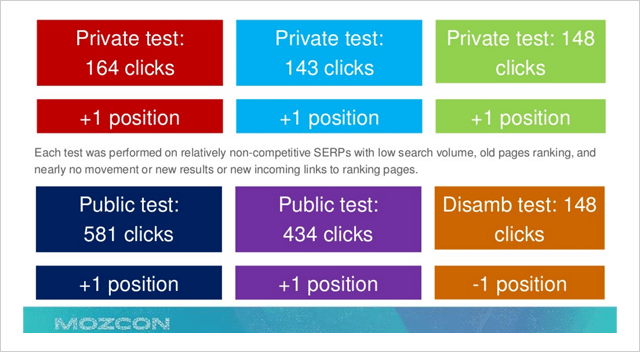

Na tentativa de validar esses dados, o que se seguiu foi uma série de testes repetidos que mostraram uma tendência geral de aumento quando o volume de cliques para um determinado resultado foi aumentado.

Infelizmente, desta vez, os dados foram muito menos dramáticos e conclusivos.

Por que isso poderia ser?

Rand estava preocupado que, em resposta ao seu post público mostrando como os cliques podem influenciar os resultados do Google de forma mais direta do que se suspeitava anteriormente, o Google pode ter endurecido seus critérios em torno desse fator específico.

Ainda assim, ele não foi dissuadido…

Número dois: experiência de consulta e volume de cliques

Inspirado por uma garrafa de Sullivans Cove Whiskey durante uma pausa em uma partida da Copa do Mundo, Rand Fishkin enviou outro tweet:

O que você deve fazer durante essa calmaria na partida da Copa do Mundo? Ajude-me a fazer um teste! Leva <30 segundos: http://t.co/PxXWNlVdTi

— Rand Fishkin (@randfish) 13 de julho de 2014

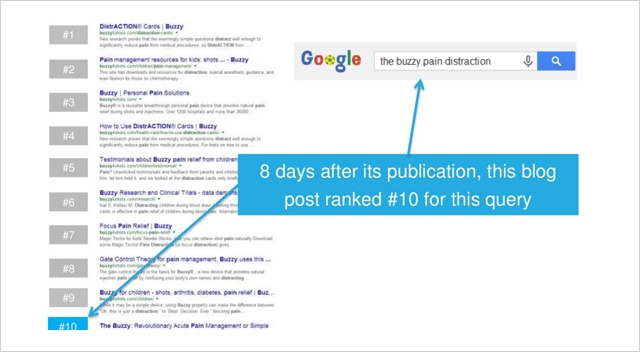

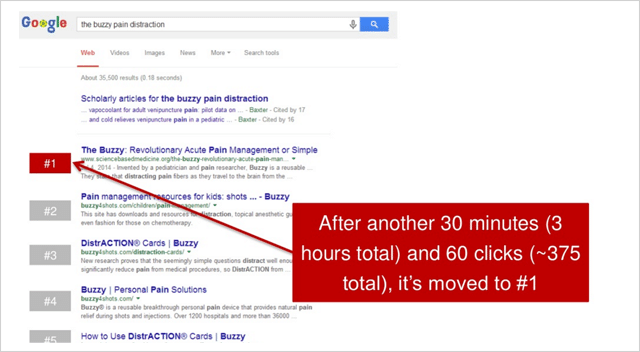

O tweet apontou seus seguidores para algumas instruções básicas que pediam aos participantes para pesquisar “a distração da dor zumbido” e clicar no resultado para sciencebasedmedicine.org.

Veja onde o website de destino apareceu antes do início do experimento:

Nas próximas 2,5 horas após o tweet inicial de Rand, um total de 375 participantes clicaram no resultado.

O efeito foi dramático.

sciencebasedmedicine.org subiu do número dez para o primeiro lugar no Google.

Eureca!

Este evento milagroso, por sua vez, desencadeou uma reação em cadeia...

Que terminou neste momento comemorativo para Rand:

Portanto, parece que o volume de cliques (ou taxa de cliques relativa) afeta a classificação de pesquisa. Embora existam algumas pessoas, como Bartosz Goralewicz, que argumentam contra isso, acredito que isso seja verdade.

Existem várias razões pelas quais o Google consideraria a taxa de cliques como um sinal de classificação, além dos principais sinais, como conteúdo e links.

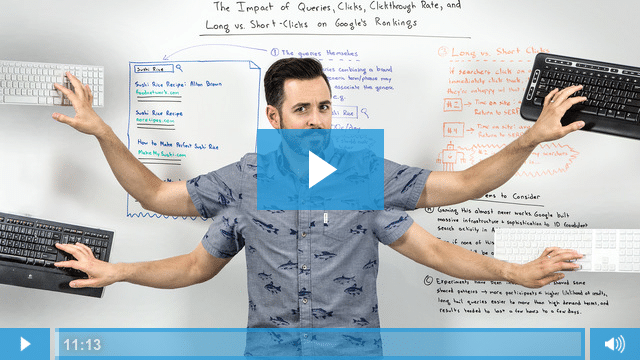

Este vídeo da Whiteboard Friday fornece uma excelente explicação do porquê:

Portanto, o caso é convincente, a taxa de cliques certamente afeta os rankings de busca do Google.

Um estudo posterior de Larry Kim parece sugerir que, se você superar a taxa de cliques esperada em 20%, subirá na classificação.

Ótimo, tudo bem.

Mas, como você usa essas informações a seu favor?

Aqui estão 4 etapas de ação que mostrarão exatamente isso:

(1) Otimize sua taxa de cliques – Para fazer isso, crie títulos de página e meta descrições atraentes para suas páginas que vendem as pessoas ao clicarem em seu resultado acima dele.

(2) Construa sua marca – Uma marca estabelecida e reconhecível atrairá mais cliques. Se os usuários conhecem sua marca (e esperamos gostar e confiar também), você terá mais destaque nas SERPs.

(3) Otimize para cliques longos – Não otimize apenas para obter cliques, concentre-se em manter os usuários em seu site por um longo tempo. Se você receber mais cliques, mas esses usuários simplesmente retornarem aos resultados, qualquer benefício obtido com uma CTR maior será cancelado.

(4) Use táticas genuínas – Os efeitos de um aumento repentino na CTR (assim como o experimento de Rand) durarão apenas um curto período de tempo. Quando as taxas de cliques normais retornarem, sua posição anterior no ranking também retornará. Use os itens 1 e 2 para resultados duradouros.

2. A indústria entendeu errado. Mobilegeddon era enorme

Mobilegeddon foi o nome não oficial dado à atualização otimizada para dispositivos móveis do Google antes de seu lançamento em 21 de abril de 2015.

Esperava-se que a atualização disparasse as classificações de pesquisa móvel para sites legíveis e utilizáveis em dispositivos móveis.

Previa-se que iria afundar sites não compatíveis com dispositivos móveis.

Algumas pessoas chegaram a dizer que seria um evento cataclísmico maior que o Google Penguin e o Panda.

Nos meses anteriores, os webmasters lutaram para colocar seus sites em ordem. À medida que o dia se aproximava, a confusão se transformou em pânico quando os proprietários de sites perceberam que seus sites falharam no teste de compatibilidade com dispositivos móveis do Google.

Então, o que aconteceu em 21 de abril de 2015? Milhões de sites caíram no abismo da pesquisa móvel?

De acordo com a maioria dos relatórios, não aconteceu muita coisa.

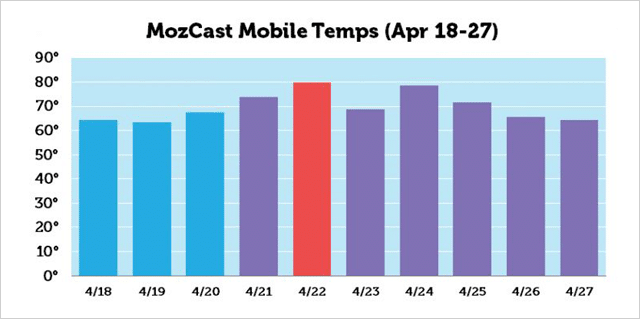

Claro, houve um pico de atividade por volta de 22 de abril, de acordo com o MozCast, mas as mudanças no ranking não foram tão grandes quanto a maioria dos SEOs pensava que seriam.

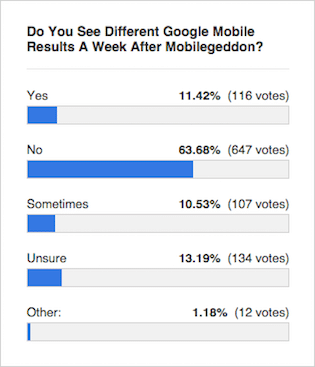

O consenso de especialistas como esta pesquisa do Search Engine Roundtable foi que os resultados praticamente não mudaram:

Mas, o que os resultados do teste mostraram?

Mas, o que os resultados do teste mostraram?

Entram Eric Enge e a equipe Stone Temple Consulting…

Estudo de classificação de Mobilegeddon

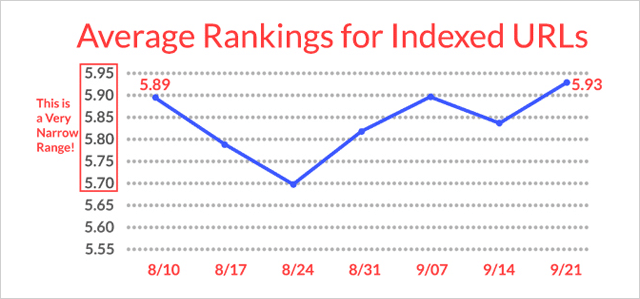

Na semana de 17 de abril de 2015 (pré-Mobilegeddon), o Stone Temple extraiu dados de classificação dos 10 principais resultados para 15.235 consultas de pesquisa. Eles extraíram dados das mesmas 15.235 consultas de pesquisa novamente na semana de 18 de maio de 2015 (depois de Mobilegeddon).

Eles registraram posições de classificação e também identificaram se os slugs de URL nos resultados foram designados como Mobile Friendly pelo Google ou não.

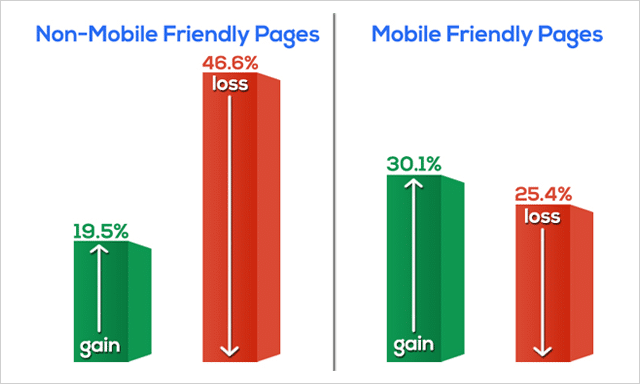

Isto é o que eles encontraram:

As páginas da Web não compatíveis com dispositivos móveis perderam classificações drasticamente.

Na verdade, quase 50% de todas as páginas da Web não compatíveis com dispositivos móveis caíram nos SERPs.

As páginas compatíveis com dispositivos móveis (no geral) ganharam em seu ranking.

Os dados que Eric e a equipe reuniram em seu teste Mobilegeddon claramente vão contra a opinião geral da imprensa especializada.

Por que a imprensa errou?

É provável que, como a atualização do algoritmo foi lançada lentamente ao longo do tempo, não ficou imediatamente óbvio que movimentos tão significativos estavam ocorrendo.

Além disso, houve uma atualização de qualidade lançada durante o mesmo período que pode ter atrapalhado os efeitos do Mobilegeddon nos rankings de busca.

Então, vamos encerrar rapidamente o Mobilegeddon com três pontos;

- Foi um grande negócio.

- Se você ainda não 'se tornou móvel', o que está esperando?

- Se você não tiver certeza se seu site é compatível com dispositivos móveis ou não, faça este teste.

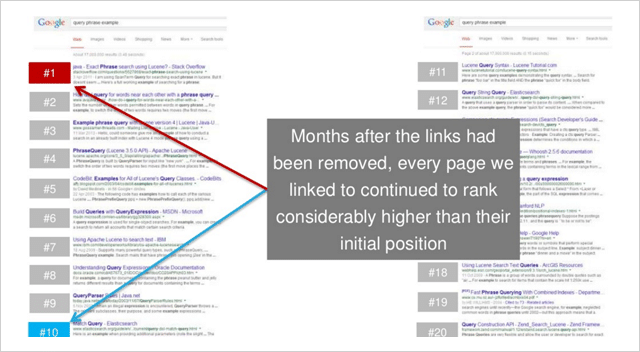

3. Link Echoes: Como os backlinks funcionam mesmo depois de removidos

Crédito onde o crédito é devido.

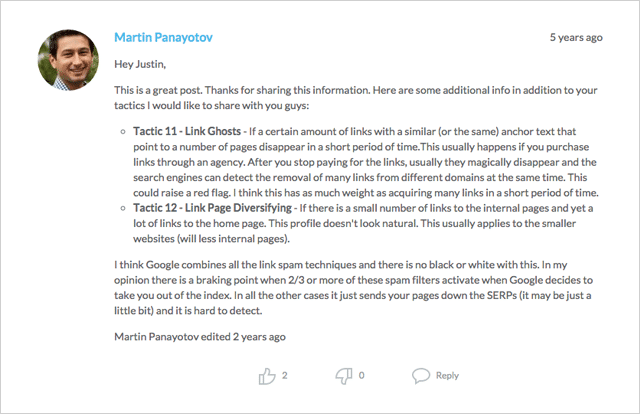

A ideia de 'link echoes' (ou 'link ghosts' como também foram chamados) foi identificada pela primeira vez por Martin Panayotov e também por Mike King do iPullRank nos comentários deste post.

A ideia é que o Google continue rastreando links e considere o valor deles (positivo ou negativo) mesmo depois que os links forem removidos.

Se este for o caso, um site que aumentou de classificação depois que um link foi adicionado continua a ser classificado depois que o link foi removido?

Bem vamos ver.

Esse experimento em particular foi realizado pela equipe da Moz e estava entre uma série que se propôs a testar o efeito de links de texto âncora (veja o experimento de SEO número 8) nos rankings de busca.

Mas, como tantas vezes acontece na ciência, os experimentos trouxeram algumas descobertas totalmente inesperadas.

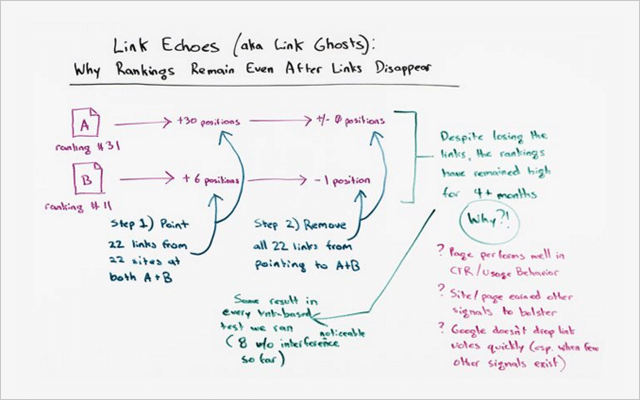

O efeito de eco do link

Havia 2 sites neste experimento; Site A e Site B.

Antes do teste, é assim que eles ranqueavam para a mesma (palavra-chave não muito competitiva):

- Site A - posição 31

- Site B - posição 11

Durante o teste, links foram adicionados a 22 páginas em vários sites apontando para o site A e o site B.

Ambos os sites, que receberam 22 links cada, subiram posteriormente no ranking:

- O site A passou da posição 31 para a posição 1 (aumento de +30 posições)

- O site B passou da posição 11 para a posição 5 (e aumento de +6 posições)

Em suma, ambos os sites aumentaram consideravelmente no ranking quando os links foram adicionados.

Mas o que aconteceu quando esses mesmos links foram removidos?

Responda. Muito pouco.

O site A ficou na posição número 1.

O site B caiu ligeiramente para a posição 6 (uma pequena queda de apenas 1 posição)

Este experimento valida a hipótese.

Parece que algum valor dos links (talvez muito) permanece, mesmo depois que os links são removidos.

Este experimento poderia ter sido um caso isolado?

Não de acordo com Rand Fishkin:

“Esse efeito desses testes de link, permanecendo em vigor muito tempo depois que o link foi removido, aconteceu em todos os testes de link que executamos, dos quais contei oito, onde me sinto altamente confiante de que não houve variáveis de confusão, me sentindo muito bem por termos seguiu um processo mais ou menos assim. Os links apontaram, o ranking subiu. Os links desapareceram, o ranking permaneceu alto.”

Mas, aqui está o que é tão notável…

Essas classificações mais altas não foram de curta duração.

Eles permaneceram por muitos meses depois que os links foram removidos.

Na época deste vídeo, os resultados permaneceram verdadeiros por 4,5 meses.

Além disso…

“Nem em um único teste, quando os links foram removidos, os rankings voltaram à sua posição original”, diz Rand Fiskin.

Existem várias lições que você pode aprender com isso, mas vou deixar essas duas:

(1) Links de qualidade valem seu peso em ouro . Como um investimento sólido, os backlinks continuarão a oferecer um bom retorno. O 'eco' de um voto uma vez lançado (como comprovado por este teste) fornecerá benefícios mesmo quando removido.

(2) O valor dos links permanece por algum tempo . Portanto, antes de ficar tentado a adquirir links ilegítimos, considere se você está pronto para manter essa pegada por meses (ou até anos) à frente.

Em suma, gaste seu tempo focando na construção de links orgânicos naturais.

Os links podem funcionar para você ou contra você. Então, certifique-se de que é o primeiro.

Curto em estratégias de construção de links?

Confira este post que tem dezenas de ideias para você começar.

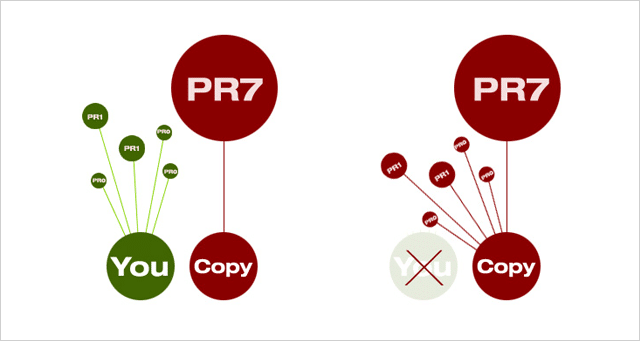

4. Você pode classificar com conteúdo duplicado. Funciona mesmo em palavras-chave competitivas

Divulgação completa, o que estou prestes a compartilhar com você pode funcionar apenas por um curto período de tempo. Mas, pelo tempo que funciona, cara, funciona como gangbusters.

Primeiro a teoria.

Quando houver dois documentos idênticos na web, o Google escolherá aquele com um PageRank mais alto e o usará nos resultados da pesquisa.

Ele também encaminhará quaisquer links de qualquer 'duplicado' percebido para o documento 'principal' selecionado.

Por que ele faz isso?

A menos que haja uma razão válida para duas ou mais versões do mesmo conteúdo, apenas uma precisa existir.

E, o que isso significa para você?

Isso significa que, se você estiver criando conteúdo exclusivo e autoritário (que atrai links e compartilhamentos de qualidade), você deve sair por cima. O Google manterá sua versão no índice e apontará todos os links direcionados às duplicatas para o seu site.

A má notícia (pelo menos para os mocinhos), nem sempre é o caso.

De tempos em tempos, um site maior e com mais autoridade ultrapassará os sites menores nas SERPs para seu próprio conteúdo.

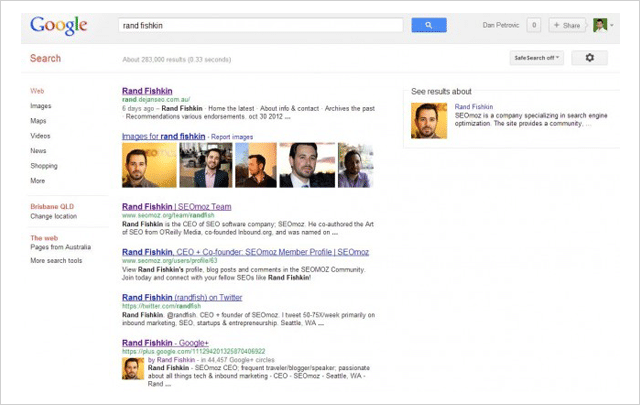

Foi isso que Dan Petrovic, da Dejan SEO, decidiu testar em seu agora famoso experimento de seqüestro de SERPs.

Usando quatro páginas da Web separadas, ele testou se o conteúdo poderia ser 'sequestrado' dos resultados da pesquisa copiando-o e colocando-o em uma página PageRank mais alta - que substituiria o original nas SERPs.

Aqui está o que aconteceu:

- Em todos os quatro testes, a página de cópia de PR mais alta superou a original .

- Em 3 de 4 casos, a página original foi removida dos SERPs .

Seus testes provam que uma página de PageRank mais alta vencerá uma página de PageRank mais baixa com o mesmo conteúdo, mesmo que a página de PR mais baixa seja a fonte original.

E, mesmo que a página original tenha sido criada pelo próprio ex-mago de Moz, Rand Fishkin.

( Imagem: Rand Fishkin foi superado por seu próprio nome no experimento de Dan Petrovic.)

Então surge a pergunta: o que você pode fazer para evitar que seu próprio conteúdo seja invadido?

Embora não haja garantia de que você possa impedir que seu próprio conteúdo suado seja copiado e depois batido, Dan oferece as seguintes medidas que podem ajudar a defendê-lo de ladrões de conteúdo:

(1) Adicione a tag rel=”canonical” ao seu conteúdo usando o texto http:// completo.

(2) Link para páginas internas em seu próprio site.

(3) Adicionar marcação de autoria do Google.

(4) Verifique regularmente se há conteúdo duplicado usando uma ferramenta como Copyscape.

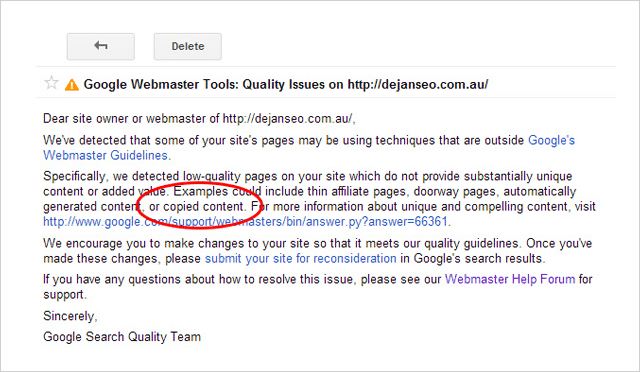

Cuidado com plagiadores

Só porque você pode vencer seus concorrentes roubando o conteúdo deles, isso não significa que você deva .

Não é apenas antiético e totalmente obscuro reivindicar o conteúdo de outra pessoa como seu, mas o plágio também pode causar problemas.

Pouco depois de executar o experimento, o Dejan SEO recebeu uma mensagem de aviso em sua conta do Google Search Console.

A mensagem citou o domínio dejanseo.com.au como tendo páginas de baixa qualidade, um exemplo disso é o 'conteúdo copiado'. Na mesma época, uma das páginas de teste copycat também parou de aparecer nas SERPs para alguns termos.

Isso forçou Dan a remover as páginas de teste para resolver o problema de qualidade de seu site.

Portanto, parece que, embora você possa vencer seus concorrentes com seu próprio conteúdo, definitivamente não é uma boa ideia fazê-lo.

5. O número um NÃO é o ponto 'Top' (e o que é agora)

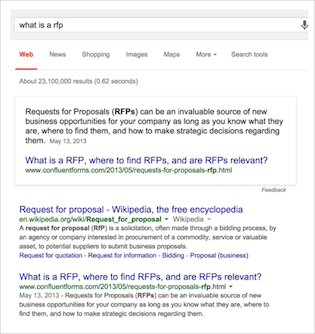

Nesse teste, Eric Enge e a equipe da Stone Temple Consulting (agora parte da Perficient) começaram a medir a mudança na exibição de Rich Answers nos resultados de pesquisa do Google.

Caso você não esteja familiarizado com a terminologia…

Rich Answers são as respostas 'na pesquisa' às suas consultas que você provavelmente tem visto mais nos últimos tempos. Eles visam responder à sua consulta sem que você precise clicar em um site.

Existem muitas variedades de Rich Answers, como esta:

Ou este carrossel que foi exibido para mim quando pesquisei “time zones of australia”

Existem literalmente dezenas de variações, muitas das quais são compartilhadas pelo Google aqui.

Estudo de respostas ricas da Stone Temple Consulting

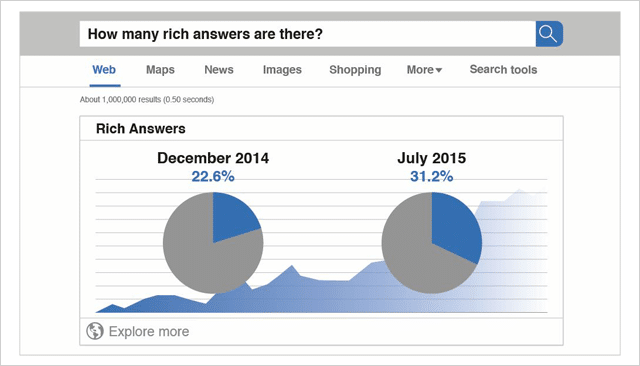

Os dados da linha de base para este estudo foram coletados em dezembro de 2014.

No total, foram analisadas 855.243 consultas.

Do total de consultas medidas na época, 22,6% exibiam Rich Answers.

Mais tarde, em julho de 2015, as mesmas 855.243 consultas foram analisadas novamente.

Naquela época (apenas 7 meses depois), a porcentagem total de consultas exibindo Rich Answers aumentou para 31,2%.

Como o estudo da Stone Temple Consulting mediu exatamente as mesmas 855.243 consultas, a comparação entre esses dois conjuntos de dados é estrita.

Os dados são claros.

Rich Answers estão em ascensão e os resultados que você vê hoje estão muito longe dos dez links azuis do passado.

( Fonte: Quicksprout)

A visualização em mudança nos resultados da pesquisa

Quando as páginas de resultados do mecanismo de pesquisa eram apenas uma lista de sites ordenados de acordo com sua relevância para uma consulta, ficou claro por que os proprietários de sites fariam tudo o que pudessem para ganhar o primeiro lugar.

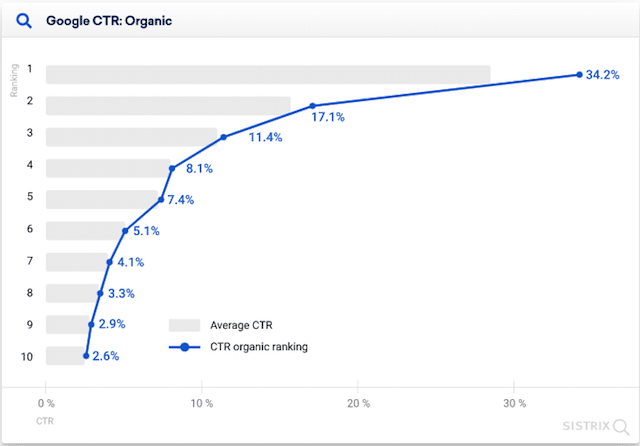

Quanto mais alto os rankings, mais cliques você tem.

De acordo com este estudo de Erez Barak da Optify, em 2011 o site mais bem classificado receberia até 37% do total de cliques.

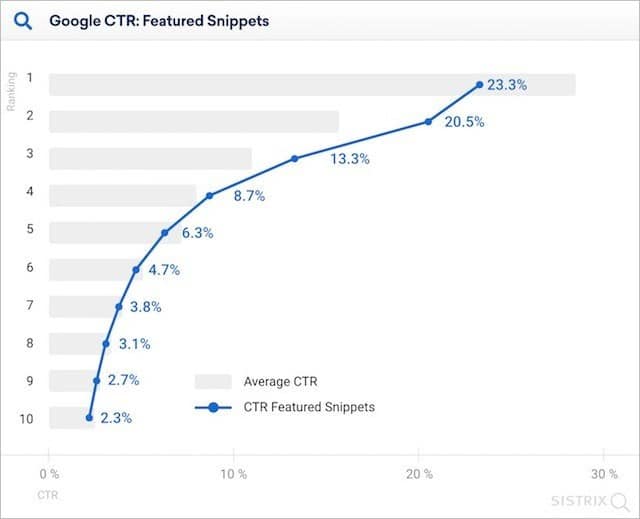

Mesmo em 2020, o Sistrix relatou em sua pesquisa que os sites mais bem classificados (onde não são exibidos snippets em destaque) geram mais que o dobro do número de cliques em comparação com os sites em segundo lugar.

Mas, com o crescimento da Rich Answers, tudo isso está mudando.

O resultado orgânico 'número um' está sendo empurrado cada vez mais para baixo na página. Os volumes de cliques para o 'primeiro lugar' estão caindo.

Mas até que ponto as Rich Answers estão afetando as taxas de cliques?

A resposta curta é muito.

Em seu estudo de 2020, o Sistrix determinou que, na presença de um trecho em destaque, o resultado número um na web do ranking obteve 23,3% dos cliques.

Isso é onze por cento menos do que quando não há snippet em destaque.

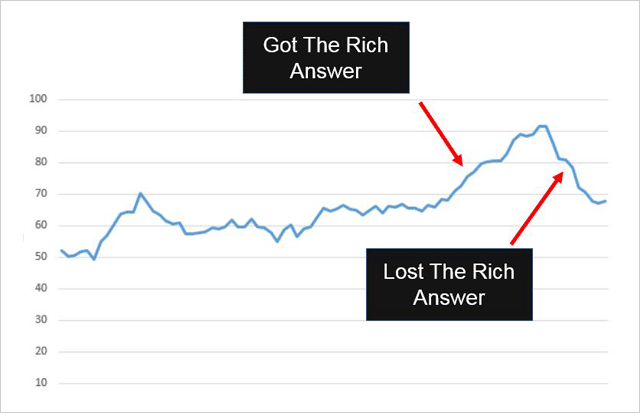

Fica claro como a inclusão (e remoção) de uma resposta de rich snippet nas SERPs pode afetar o tráfego geral de pesquisa para um site.

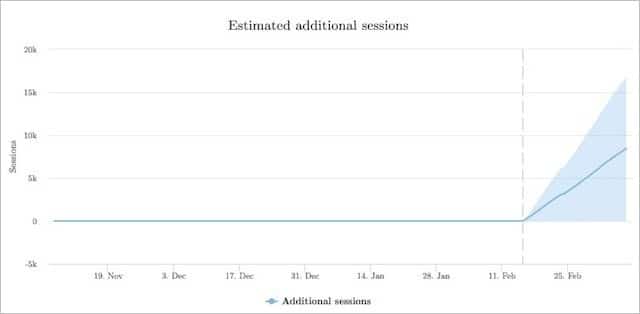

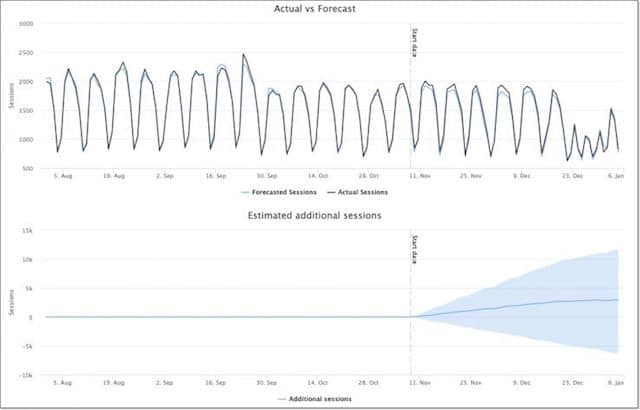

Aqui está um exemplo:

O Confluent Forms obteve um resultado de Rich Snippet listado em seu site e foi isso que aconteceu com o tráfego:

Ele subiu assim que a Rich Answer foi adicionada.

Ele caiu quando o Rich Answer foi removido.

E, lembre-se disso…

Rich Answers destinam-se a resolver consultas de dentro dos resultados da pesquisa. No entanto, eles ainda podem enviar tráfego adicional para seu site , assim como fizeram com o Confluent Forms.

Como usar as respostas ricas a seu favor

As respostas avançadas geralmente são fornecidas para consultas de pesquisa baseadas em perguntas.

E, de acordo com Eric Enge (que conseguiu uma Rich Answer listada para seu próprio site), responder a perguntas é a melhor maneira de fazer isso.

Se você quiser se beneficiar do Rich Answers (e quem não gostaria), sugiro que preste atenção ao conselho dele:

(1) Identifique uma pergunta simples – Certifique-se de que a pergunta está no tópico. Você pode verificar isso usando uma ferramenta de relevância, como nTopic.

(2) Forneça uma resposta direta – Certifique-se de que sua resposta seja simples, clara e útil para usuários e mecanismos de pesquisa.

(3) Ofereça informações de valor agregado – Além de sua resposta concisa à pergunta, inclua mais detalhes e valor. Certifique-se de não apenas citar novamente a Wikipedia, pois isso não o levará muito longe.

(4) Facilite a localização dos usuários e do Google – Isso pode significar compartilhá-lo com seus seguidores de mídia social ou vinculá-lo a partir de sites próprios ou de terceiros.

6. Usar HTTPS pode prejudicar sua classificação

Torne seu site seguro ou então.

Essa foi a mensagem que o Google apresentou nesta postagem do blog quando declarou HTTPS como um sinal de classificação.

E faria sentido certo?

Sites que usam HTTPS são mais seguros. O Google quer que os sites que as pessoas acessam a partir do mecanismo de pesquisa sejam seguros. Sites que usam HTTPS devem receber um aumento de classificação.

Mas aqui está a coisa. Eles não.

(Isso se o estudo da Stone Temple Consulting e da seoClarity servir de base.)

O estudo HTTPS rastreou classificações em 50.000 pesquisas de palavras-chave e 218.000 domínios. Eles monitoraram essas classificações ao longo do tempo e observaram quais URLs nos SERPs mudaram de HTTP para HTTPS.

Dos 218.000 domínios rastreados, apenas 630 (0,3%) deles mudaram para HTTPS.

Aqui está o que aconteceu com os sites HTTPS:

Na verdade, eles perderam o ranking .

Mais tarde, eles se recuperaram (lentamente) para praticamente onde começaram.

Dificilmente uma razão para pular no movimento HTTPS.

Parece que o HTTPS (apesar do Google querer torná-lo padrão em todos os lugares da web) não tem nenhum benefício significativo de classificação por enquanto e pode realmente prejudicar suas classificações no curto prazo.

Meu conselho : Fique usando HTTP, a menos que você realmente precise mudar.

7. Robots.txt NoIndex não funciona (sempre)

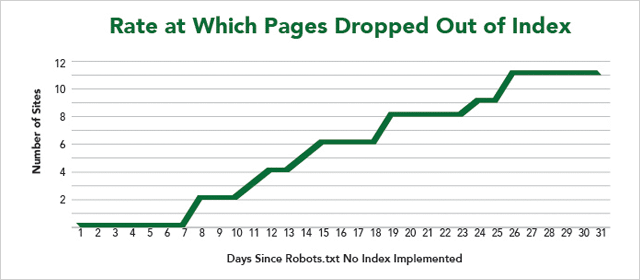

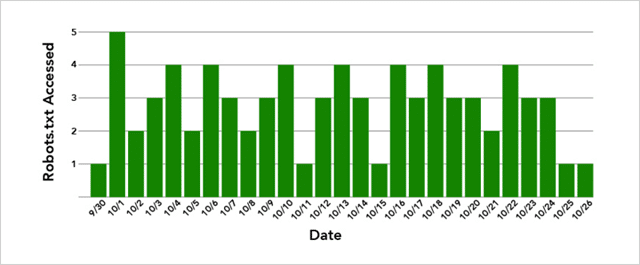

Em outro experimento do IMEC Lab, 12 sites ofereceram suas páginas para testar se o uso do Robots.txt NoIndex bloqueia com sucesso os mecanismos de pesquisa de rastrear E indexar uma página.

Primeiro as coisas técnicas.

Como parar os motores de busca indexando sua página da web

A abordagem comum adotada pelos Webmasters é adicionar uma diretiva NoIndex dentro do Robots Metatag em uma página. Quando os spiders do mecanismo de pesquisa rastreiam essa página, eles identificam a diretiva NoIndex no cabeçalho da página e removem a página do Index.

Em suma, eles rastreiam a página e impedem que ela apareça nos resultados da pesquisa.

O código fica assim:

Por outro lado, a diretiva NoIndex colocada dentro do arquivo Robots.txt de um site impedirá que a página seja indexada e que a página seja rastreada.

Ou pelo menos deveria…

Como você pode ver nos resultados, nem todas as páginas da web foram removidas do índice.

Más notícias se você quiser esconder o conteúdo do seu site de olhares indiscretos.

Além disso, o Google não removeu nenhuma das páginas imediatamente, apesar de os arquivos Robots.txt do site serem rastreados várias vezes por dia.

E, se você acha que é porque o Google também precisa tentar rastrear a própria página, isso também não é verdade.

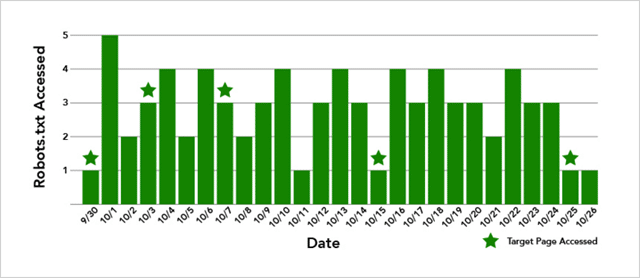

No caso do site que não teve sua página removida do Índice, a página de destino foi rastreada 5 vezes:

Então, o que está em jogo aqui?

Bem, os resultados são inconclusivos.

Mas, o que podemos ter certeza de dizer é que (apesar do Google mostrar suporte ao Robots.txt NoIndex) é lento para funcionar e às vezes não funciona.

Meu conselho: Use Robots.txt NoIndex com cautela.

8. Links de texto âncora de correspondência exata Links de correspondência não âncora de Trump

Se você leu uma ou duas coisas sobre SEO, terá aprendido que o texto âncora de correspondência exata é ruim .

Muitos links dizendo a mesma coisa não são naturais.

E poderia desembarcar você com uma penalidade.

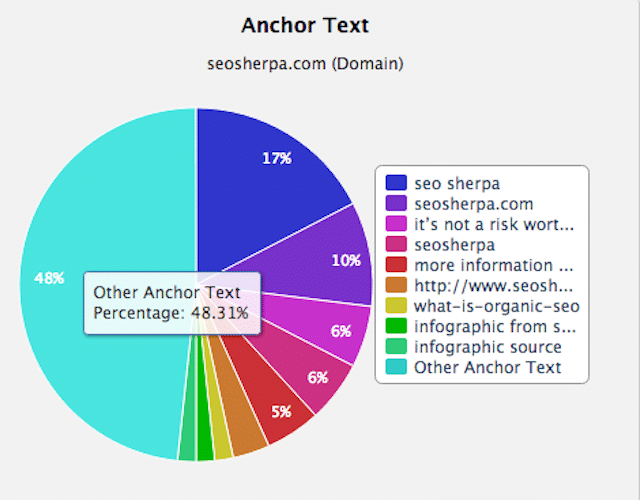

Desde que o Google Penguin foi lançado para acabar com a construção de links manipulativos, o conselho dos especialistas tem sido “manter as proporções de texto âncora baixas”.

Em termos simples, isso significa que você deseja uma combinação de links para o seu site para que nenhum texto âncora rico em palavras-chave represente mais do que uma pequena porcentagem do total.

Links brutos como este: http//seudominio.com, bem como links genéricos como “sua marca”, “clique aqui” e “visite este site” são bons.

Mais do que uma pequena porcentagem de links ricos em palavras-chave é ruim.

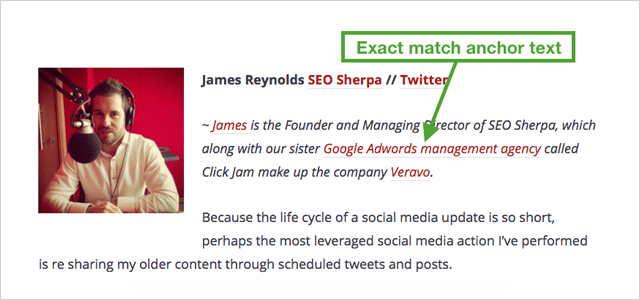

Um perfil de link variado e natural será parecido com o meu:

Como você pode ver, a maioria dos links são para a minha marca. O resto são principalmente outros textos âncora.

Com aquilo em mente.

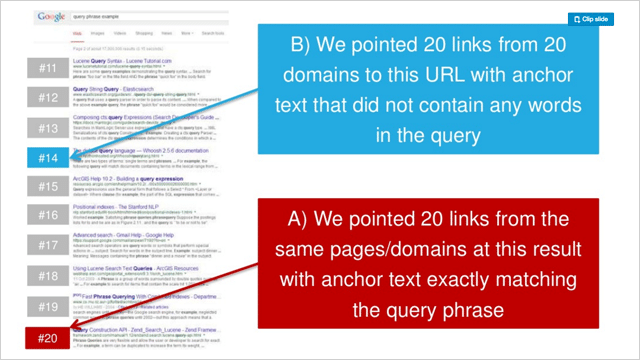

O que acontece quando você aponta 20 links para um site, todos com o mesmo texto âncora rico em palavras-chave?

Seus rankings disparam, é isso!

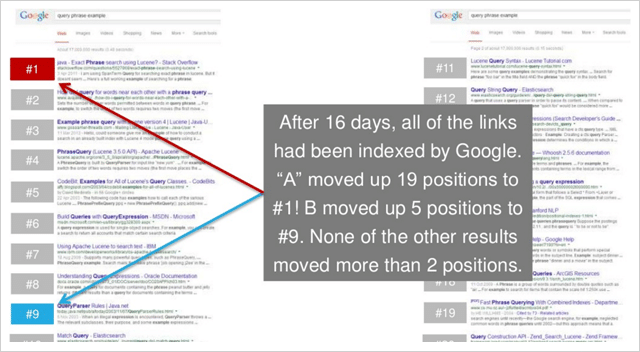

Em uma série de três experimentos, Rand Fishkin testou apontar 20 links âncora genéricos para uma página da web versus 20 links de texto âncora de correspondência exata.

Em cada caso, o texto âncora de correspondência exata aumentou significativamente a classificação das páginas de destino.

E, em 2 de 3 testes, os sites de texto âncora de correspondência exata capitularam os sites de texto âncora genérico nos resultados.

Aqui estão os rankings anteriores do teste 2 na série de Rand:

E aqui estão os rankings depois:

Isso é muito conclusivo.

O texto âncora de correspondência exata é consideravelmente mais poderoso do que os links de correspondência não âncora.

(E surpreendentemente poderoso no geral)

9. Link para outros sites para aumentar suas classificações

Links externos diluem a autoridade do seu site.

Esta tem sido a noção geralmente concebida no mundo do SEO há algum tempo.

E isso apesar do Google dizer que vincular a recursos relacionados é uma boa prática.

Então, por que os SEOs são tão contrários aos links externos?

A ideia é que os links de saída percam o PageRank. Quanto mais links de saída, mais PageRank você distribui.

E como perder o PageRank significa perder autoridade, o resultado da vinculação são classificações mais baixas. Certo

Bem, vamos descobrir.

Shai Aharony e a equipe da Reboot testaram essa noção em seu experimento de links de saída.

Para o experimento, Shai configurou dez sites, todos com formatos e estrutura de domínio semelhantes.

Cada site continha um artigo exclusivo de 300 palavras que foi otimizado para uma palavra inventada “filandocic”

Antes do teste, a palavra “phylandocic” não apresentava resultados no Google.

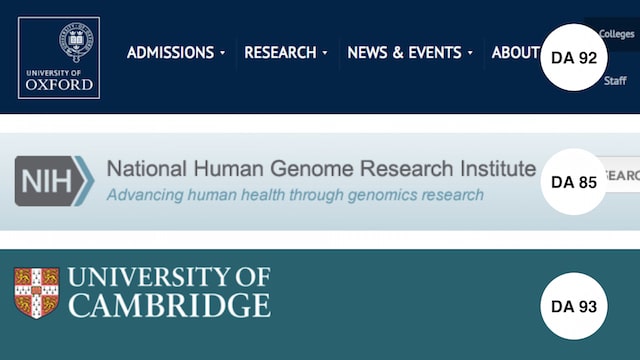

Para testar o efeito dos links externos, 3 links completos foram adicionados a 5 dos 10 domínios.

Os links apontavam para sites altamente confiáveis:

- Universidade de Oxford (DA 92)

- Instituto de Pesquisa do Genoma (DA 85)

- Universidade de Cambridge (DA 93)

Uma vez que todos os sites de teste foram indexados, os rankings foram registrados.

Aqui estão os resultados:

Eles são tão claros quanto a noite e o dia.

TODOS os sites com links externos superaram aqueles sem.

Isso significa que sua etapa de ação é simples.

Cada vez que você postar um artigo em seu site, certifique-se de que ele inclua alguns links para recursos relevantes e confiáveis.

Como o experimento de Reboot provou. Ele servirá aos seus leitores E aos seus rankings.

10. Incrível descoberta de que links nofollow realmente aumentam sua classificação

Outro experimento do IMEC Lab foi realizado para responder:

Os links não seguidos têm algum impacto direto nos rankings?

Como o objetivo de usar um link “não seguir” é impedir que a autoridade seja passada, você esperaria que links não seguidos não tivessem valor de SEO (direto).

Este experimento se mostra diferente.

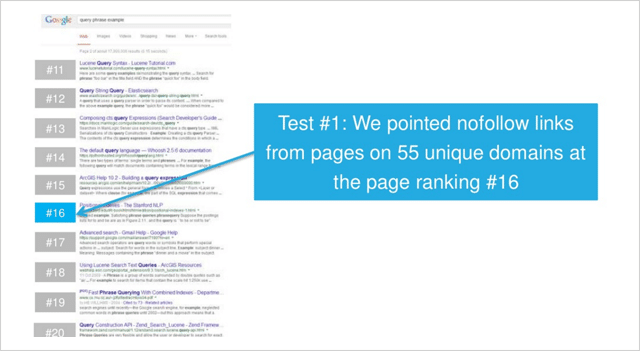

No primeiro de dois testes, os participantes do IMEC Lab apontaram links de páginas em 55 domínios únicos em uma página de classificação #16.

Depois que todos os links no-follow foram indexados, a página subiu um pouco para a consulta de baixo volume de pesquisa competitiva que estava sendo medida.

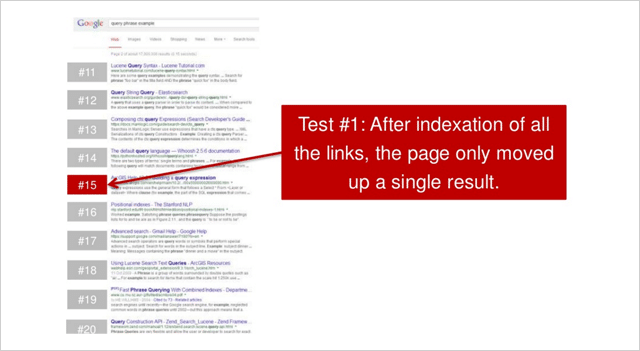

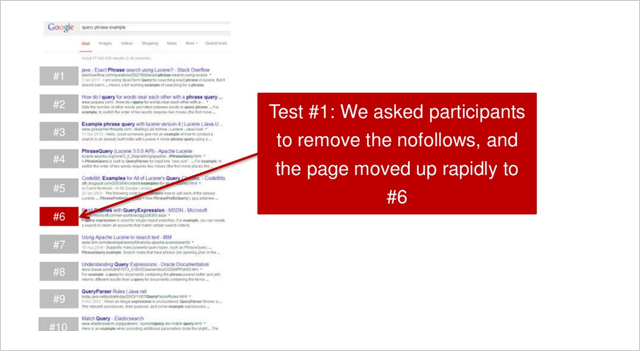

Os participantes foram então solicitados a remover os links no-follow que resultaram nisso:

A página subiu rapidamente para a posição número 6.

Um aumento acumulado de 10 posições, apenas de alguns links no-follow.

Nada mal.

Isso pode ser repetido?

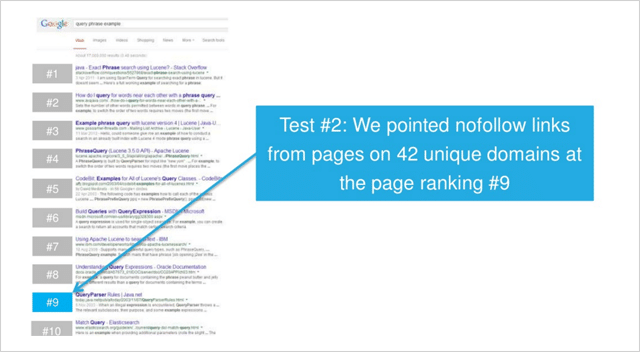

Em um segundo teste, desta vez para uma consulta de baixa concorrência, links no-follow foram adicionados a páginas em 42 domínios exclusivos.

( Nota – todos os links estavam em links de texto da página. Nenhum cabeçalho, rodapé, barra lateral, links de widgets (ou similares) foram usados em nenhum dos testes.)

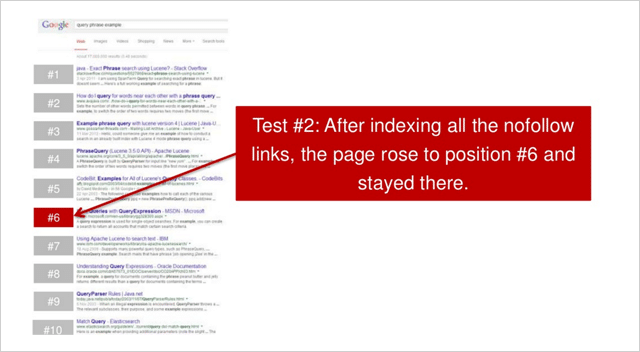

Depois que todos os links foram indexados, a página subiu para a posição número 6.

Um aumento de 3 posições.

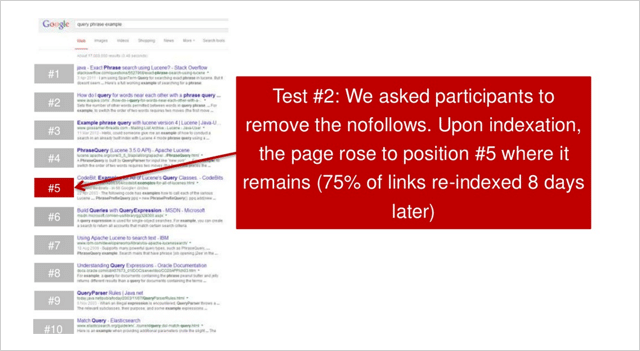

Em seguida, os participantes foram solicitados a remover todos os links no-follow. O site então subiu uma posição para o número 5.

Em ambos os testes; quando os links no-follow foram adquiridos, os sites melhoraram significativamente seus rankings

O primeiro site aumentou 10 posições.

O segundo site aumentou 4 posições.

Então, mais uma teoria de SEO desmascarada?

Rand Fishkin ressalta que o teste deve ser repetido várias vezes para ser conclusivo.

“Minha saída. O teste deve ser repetido pelo menos 2-3 vezes mais, mas os dados iniciais sugerem que parece haver uma relação entre os aumentos de classificação e o conteúdo, sem links seguidos”, diz Rand.

Bem, independentemente disso, como Nicole Kohler aponta, certamente há um caso para links no-follow.

Links geram links.

E (de acordo com este estudo) no-follow ou full follow. Ambos são valiosos para você.

11. Fato: Links de páginas da Web com milhares de links funcionam

Existe uma crença no SEO de que links de páginas da web com muitos links de saída não valem muito.

A teoria aqui é que, com muitos links de saída, o 'link juice', também conhecido como PageRank da página da web de links, é tão espalhado que o valor de um link para o seu site não pode ser muito.

Quanto mais links externos o site tiver, menos valor passará para o seu site.

Essa teoria é reforçada pela noção de que diretórios e outros sites de qualidade inferior que possuem muitos links externos não devem fornecer benefícios significativos de classificação aos sites aos quais eles vinculam. Por sua vez, links de páginas da web com poucos links externos são mais valiosos.

Isso é exatamente o que Dan Petrovic colocou à prova em seu PageRank Split Experiment.

O teste de divisão do PageRank

Em seu experimento, Dan configurou 2 domínios (A e B).

Ambos os domínios eram .com e ambos tinham características semelhantes e conteúdo semelhante, mas exclusivo.

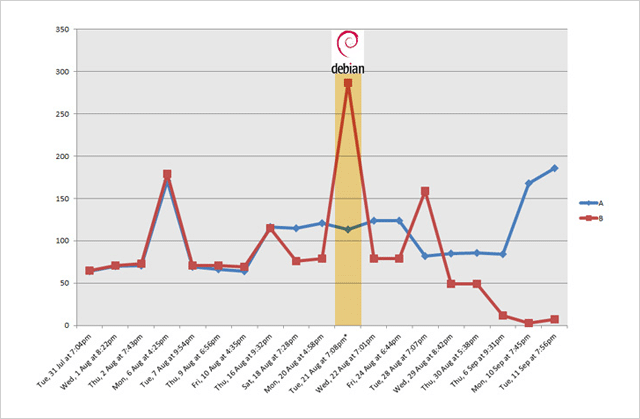

A única diferença real foi que durante o teste o Site B foi vinculado a um site que está vinculado a uma subpágina em http://www.debian.org (PR 7) que tem 4.225 links externos seguidos.

O objetivo do teste era simplesmente ver se algum grau de PageRank é passado quando existem tantos links externos e qual efeito (se houver) isso tem no ranking dos sites aos quais ele se vincula.

Se a crença da maioria dos SEOs é algo a se considerar, não deveria ter acontecido muita coisa.

Aqui está o que aconteceu…

Imediatamente após o site B ter sido vinculado ao PR 7 debian.org (através do site da ponte), o site B disparou no ranking , eventualmente alcançando a posição 2.

E, de acordo com a atualização mais recente de Dan (3 meses após o teste), o site B manteve sua posição, apenas mantido no topo por uma página PageRank 4 significativamente mais confiável.

O site A (que não havia sido vinculado) permaneceu em uma posição estável por um tempo, depois caiu no ranking.

Portanto, parece que os links de páginas que têm muitos links externos são de fato extremamente valiosos .

Que mito nossa lista de experimentos de SEO pode dissipar a seguir…

12. Links de imagem funcionam (realmente) bem

Como muitos dos experimentos de SEO nesta lista, este surgiu porque um cara teve um palpite.

A ideia de Dan Petrovic era que o texto em torno de um link desempenhasse um papel semântico no algoritmo de busca do Google.

Mas, Dan nunca foi capaz de determinar o grau de sua influência ou se tem algum impacto .

Então ele montou esse teste para descobrir…

Experiência de proximidade de texto âncora

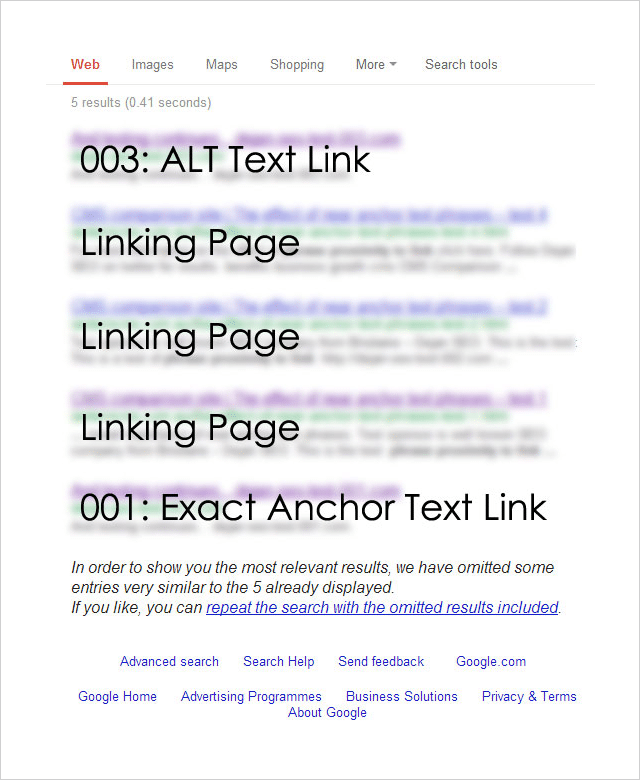

O experimento foi projetado para testar o impacto de vários tipos de links (e seu contexto) nas classificações de pesquisa.

Para realizar o teste, Dan registrou 4 nomes de domínio quase idênticos :

http://********001.com.au

http://********002.com.au

http://********003.com.au

http://********004.com.au

Each of the 4 domains was then linked to from a separate page on a well-established website. Each page targeted the same exact phrase but had a different link type pointing to it:

001: [exact phrase]

Used the exact target keyword phrase in the anchor text of the link.

002: Surrounding text followed by the [exact phrase]: http://********002.com.au

Exact target keyword phrase inside a relevant sentence immediately followed by a raw http:// link to the target page.

003: Image link with an ALT as [exact phrase]

An image linking to the target page that used the exact target keyword phrase as the ALT text for the image.

004: Some surrounding text with [exact phrase] near the link which says click here .

This variation used the junk anchor text link “click here” and the exact target keyword phrase near to the link.

So which link type had the greatest effect on rankings?

Here are the results:

Unsurprisingly, the exact match anchor text link worked well.

But most surprisingly, the ALT text-based image link worked best .

And, what about the other two link types?

The junk link (“click here”) and the raw link (“http//”) results did not show up at all.

The Anchor Text Lessons You Can Take Away From This

This is just one isolated experiment, but it's obvious that image links work really well.

Consider creating SEO-optimized image assets that you can utilize to generate backlinks.

The team at Ahrefs put together a useful post about image asset link building here.

But don't leave it at that, best results will come from a varied and natural backlink profile.

Check out this post from Brian Dean which provides 17 untapped backlink sources for you to try.

13. Press Release Links Work. Matt Cutts Take Note

Towards the end of 2014, Google's head of webspam publicly denounced press release links as holding no SEO value.

“Note: I wouldn't expect links from press release web sites to benefit your rankings” – Said Matt Cutts.

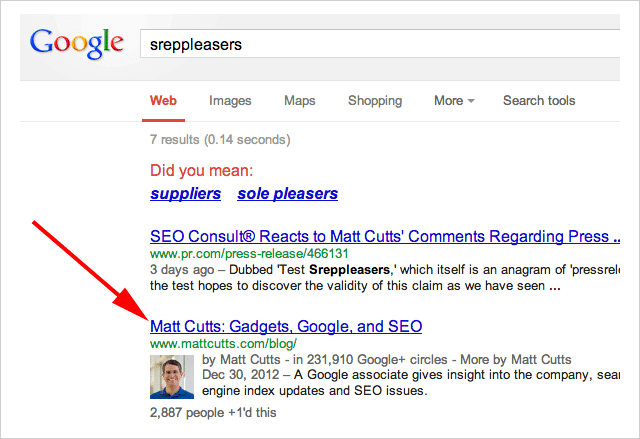

In an ironic (and brilliant) move, SEO Consult put Cutt's claim to the test this by issuing a press release which linked to, of all places….

Matt Cutts blog:

The anchor text used in the was the term “Sreppleasers”

The term is not present anywhere on Cutts's website.

Yet still, when you search “Sreppleasers” guess who's website comes up top?

There has been a lot of discussion about whether Press Release links work.

Is the jury still out on this?

I'll let you decide.

14. First Link Bias. Proven

First, let me say this…

This experiment is a few years old so things may now have changed. However, the results are so interesting it's very worthy of inclusion.

The theory for this experiment began with a post by Rand Fishkin which claimed that Google only counts one link to a URL from any given page.

Shortly after that post was published Rand's claims were debunked by David Eaves.

The opinion was rife in the SEO world as to whether either experiment was sound.

So, SEO Scientist set out to solve the argument once and for all.

The Test

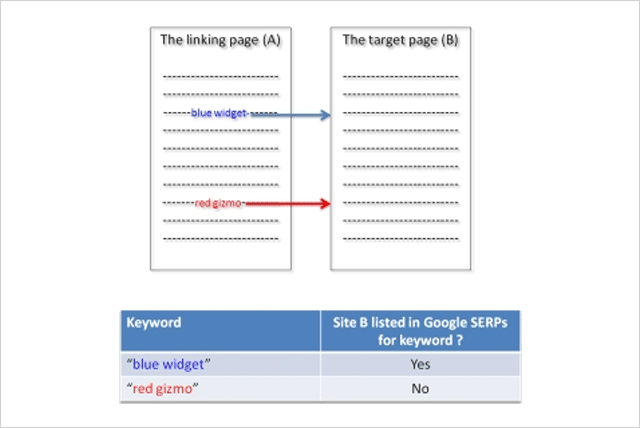

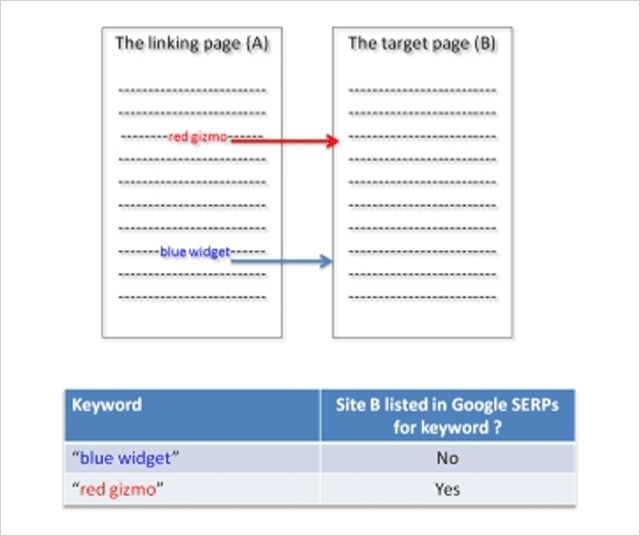

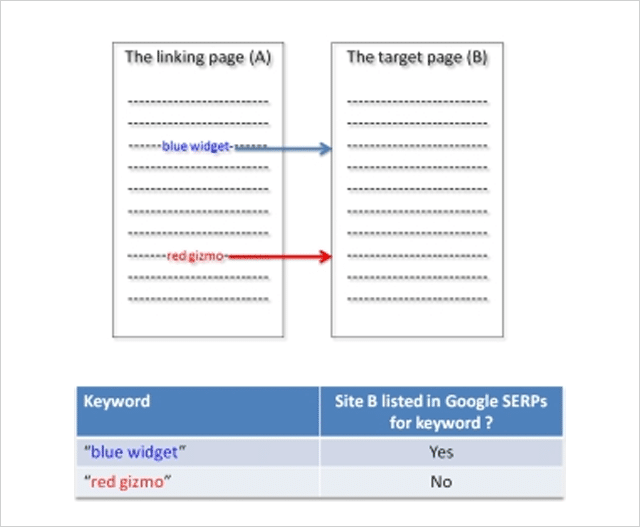

The hypothesis goes something like this…

If a website is linked to twice (or more) from the same page, only the first link will affect rankings.

In order to conduct the test SEO Scientist set up two websites (A and B).

Website A links to website B with two links using different anchor texts.

Test Variation 1

The websites were set up, then after the links got indexed by Google, the rankings of site B were checked for the two phrases.

Result : Site B ranked for the first phrase and not for the second phrase.

Here is what the results looked like:

Test Variation 2

Next, the position of links to site B was switched. Now the second phrase appears above the previously first phrase on site A and visa versa.

Once Google had indexed the change, rankings were again checked for website B.

Result : Site B disappeared from the SERPs for the new second phrase (previously first) and appears for the new first phrase (previously second).

Rankings switched when the order of the links switched!

Test Variation 3

To check this was not some anomaly, in the third test variation the sites were reverted back to their original state.

Once the sites were re-indexed by Google, the rankings of website B were checked again.

Result : Site B reappeared for the initially first phrase and disappeared again for the initially second phrase:

The test proved that Google only counts the first link.

But, it gets even more interesting.

In a follow-up experiment, SEO Scientist made the first link “no follow” and still the second link was not counted!

The lesson from this experiment is clear.

If you are “self-creating” links ensure that your first link is to your most important target page.

15. The Surprising Influence of Anchor Text on Page Titles

Optimizing your Title tags has always been considered an important SEO activity and rightly so.

Numerous SEO studies have identified the title tag as a genuine ranking factor.

Since it's also what normally gets shown in the search results when Google lists your website, spending time on crafting well-optimized title tags is a good use of your time.

But, what if you don't bother?

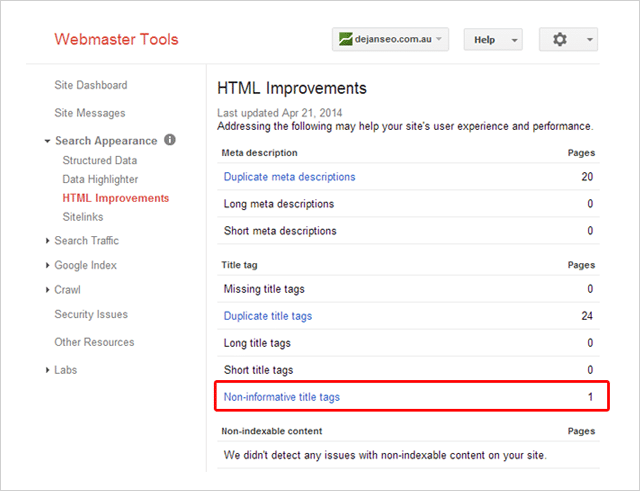

A few years ago Dejan SEO set out to test what factors Google considers when creating a document title when a title tag is not present.

They tested several factors including domain name, the header tag, and URLs – all of which did influence the document title shown in search results.

What about anchor text? Could that influence the title shown?

In this video Matt Cutts suggested it could:

But, wanting some real evidenc e Dan Petrovic put it to the test in this follow-up experiment.

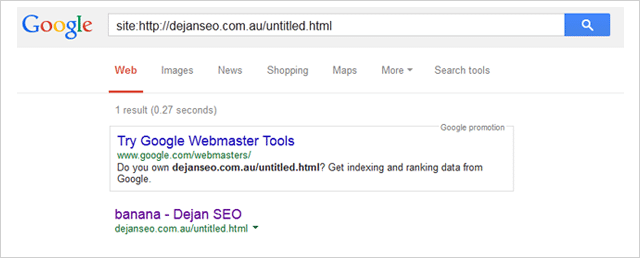

His experiment involved several participants linking to a page on his website using the anchor text “banana”.

The page being linked to had the non-informative title “Untitled Document”.

Here it is listed inside Dan's Search Console account:

Durante o teste, Dan monitorou três consultas de pesquisa:

- http://goo.gl/8uPrz0

- http://goo.gl/UzBOQh

- http://goo.gl/yW2iGi

E, aqui está o resultado:

O título do documento apareceu milagrosamente como “banana”.

O teste prova que o texto âncora pode influenciar o título do documento mostrado pelo Google nos resultados de pesquisa.

Isso significa que você não deve escrever tags de título únicas e atraentes para cada página do seu site?

Eu sugiro que não.

Como Brian Dean aponta, a tag de título da sua página pode não ser tão importante quanto costumava ser, mas ainda conta.

16. SEO negativo: como você pode (mas não deve) prejudicar os rankings de seus concorrentes

Não há questionamento, SEO negativo é possível.

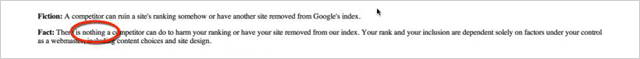

Em 2003, o Google mudou sua postura ao dizer que não há nada que um concorrente possa fazer para prejudicar sua classificação:

Para dizer que não há quase nada que eles possam fazer:

![]()

No que diz respeito ao Google, uma pequena mudança como essa é um grande negócio.

Então surge a pergunta…

Quão fácil é afetar a classificação de um site (negativamente)?

A Tasty Placement realizou um experimento para determinar exatamente isso.

Os experimentos negativos de SEO

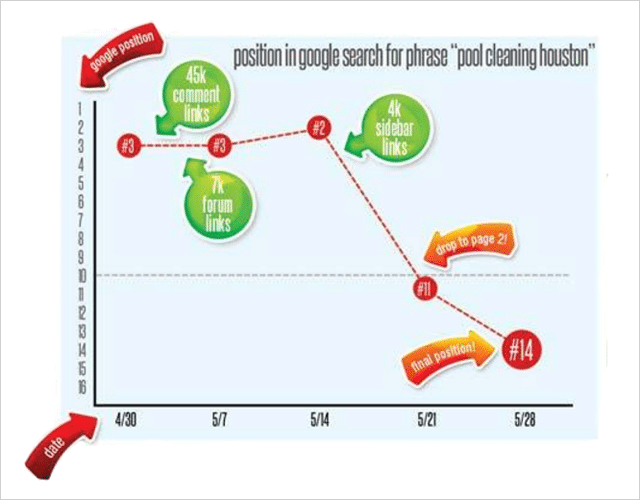

Em uma tentativa de prejudicar as classificações de pesquisa, a Tasty Placement comprou um grande número de links de spam que apontaram para o site de destino Pool-Cleaning-Houston.com.

O site estava relativamente estabelecido e, antes do experimento, tinha uma boa classificação para vários termos de palavras-chave, incluindo “limpeza de piscina houston” e outros termos semelhantes.

Um total de 52 posições de palavras-chave foram rastreadas durante o experimento.

O spam de links

Eles compraram uma variedade de links indesejados para o experimento a um custo muito baixo:

45.000 links de comentários. Texto âncora “Limpeza da piscina Houston”. Custo: $ 15

7000 links de perfil de fórum de duas camadas. Texto âncora “Limpeza da piscina Houston”. Custo: $ 5

Links de blogs da barra lateral em quatro blogs inúteis, gerando quase 4.000 links. Texto âncora “Limpeza da piscina Houston”. Custo: $ 20

Custo total?

Uma gritante 40 dólares.

Ao longo de 2 semanas, os links de lixo baratos foram apontados para Pool-Cleaning-Houston.com

Primeiro os links de comentários, depois os links do perfil do fórum e, finalmente, os links da barra lateral.

Aqui está o que aconteceu com o ranking de “limpeza de piscinas houston”

O lote de links de comentários não teve nenhum efeito.

7 dias depois, os links dos posts do fórum foram colocados, o que foi seguido por um surpreendente aumento no ranking do site da posição 3 para a posição 2. Não era o que se esperava.

Outros 7 dias depois que os links da barra lateral foram adicionados.

O resultado…

Kabum!

Uma queda quase instantânea no ranking.

Além da palavra-chave principal, outras 26 palavras-chave também caíram visivelmente .

Então parece que é muito fácil (e barato) destruir o ranking de um concorrente se você estiver tão inclinado, o que eu sei que você não está!

Embora o experimento do Tasty Placement deixe algumas questões sobre a verdadeira causa da queda de classificação (texto âncora repetitivo ou links de uma vizinhança ruim, talvez?) ele deixa claro que SEO negativo é real.

E, muito fácil de fazer.

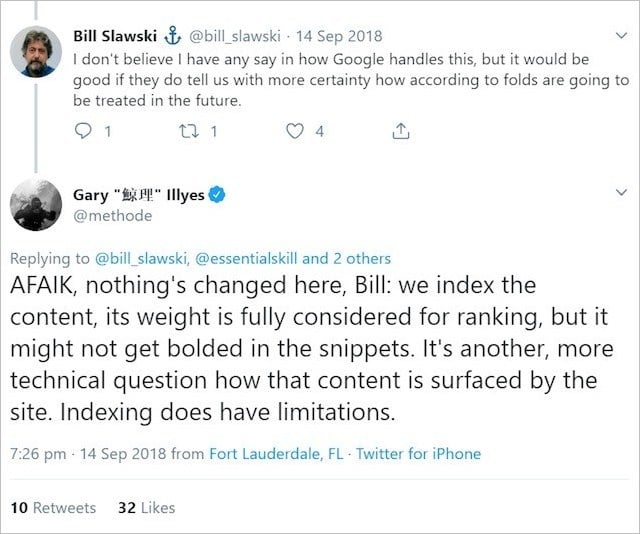

17. O Google escreve descrições melhores do que você?

Se você trabalha com SEO há algum tempo, provavelmente já escreveu centenas, se não milhares, de meta descrições.

Mas, você é legal com isso.

Essas incontáveis horas de escrita de meta descrição são um tempo bem gasto.

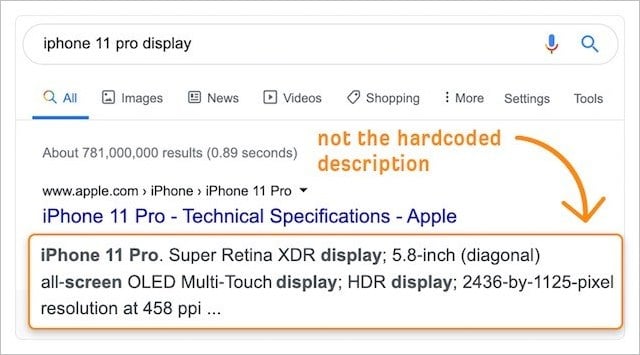

Com a crescente importância da taxa de cliques nos rankings (veja o experimento número 2), quaisquer melhorias feitas nos snippets SERP do seu site por meio de descrições personalizadas (codificadas) certamente aumentarão os resultados.

Afinal, conhecemos melhor o nosso negócio e o nosso público.

O que significa que nossas descrições precisam superar as versões geradas automaticamente pelo Google, certo?

Infelizmente não.

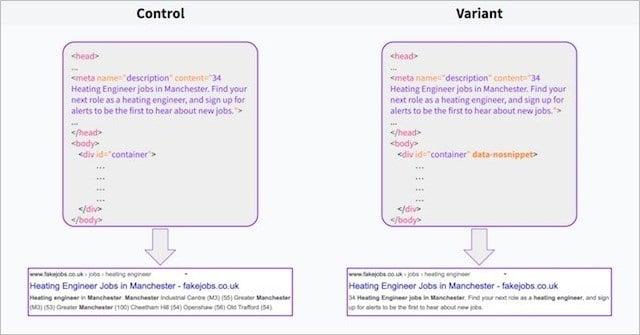

Em um experimento recente , a equipe do Search Pilot descobriu que (pelo menos no caso deles) as descrições geradas automaticamente pelo Google superaram as meta descrições personalizadas por um fator de 3% .

Usando o atributo data-no snippet no elemento body de metade de suas páginas, o Search Pilot foi capaz de testar as descrições geradas pelo Google (o controle) em relação às suas próprias descrições personalizadas (a variante).

Logo após o início do teste, a tendência de cliques diminuiu e, em duas semanas, o teste atingiu significância estatística para um resultado negativo!

Em suma, as descrições do Google tiveram um desempenho melhor.

O que você pode tirar disso?

O Google tem acesso a muitos dados do usuário.

Essa vantagem de dados ajuda o Google a saber o que os usuários estão procurando e a criar descrições que são mais relevantes para os usuários do que aquelas que nós mesmos escrevemos – mesmo que as próprias descrições do Google sejam raspadas e muitas vezes lidas como lixo.

Isso é reforçado por estudos que mostraram que o Google ignora a meta tag tag para 63% das consultas.

Podemos supor que o Google faz isso quando a meta descrição criada pelo proprietário do site não é totalmente relevante para a consulta do usuário – e o Google acha que pode fazer um trabalho melhor.

O estudo do Search Pilot indica que sim.

Isso significa que você deve acabar com a escrita de meta descrição e deixar tudo para o Google?

Não inteiramente.

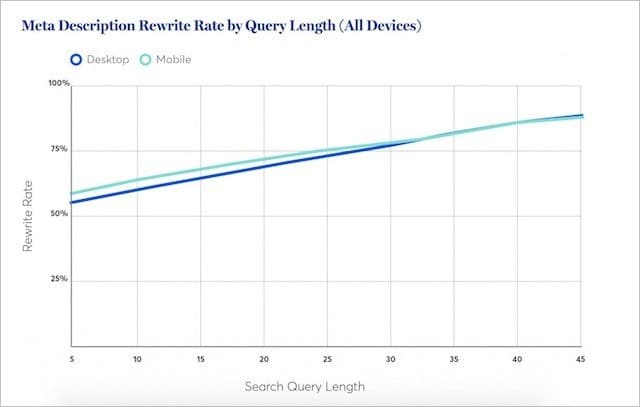

A pesquisa da Portent sugere que o Google reescreve menos as meta descrições para palavras-chave curtas (normalmente de alto volume).

Na verdade, para as consultas mais curtas, o Google comprará a meta descrição real pelo menos metade das vezes.

Isso indica que em cerca de 50% das buscas, sua meta descrição será a melhor.

Meu conselho:

Continue a escrever meta descrições personalizadas para o seu conteúdo mais importante.

Mas elimine as meta descrições onde o potencial de tráfego para o seu conteúdo é menor.

O Google fará um trabalho decente ao criar descrições relevantes – que são estatisticamente comprovadas para superar as suas.

18. Experiência de texto oculto

O Google disse repetidamente que, desde que você tenha o texto que deseja classificar em sua página da web;

Será “totalmente considerado para classificação”.

Em outras palavras, você pode exibir texto dentro de acordeões, guias e outros elementos expansíveis, e o Google considerará esse texto com peso igual ao texto totalmente visível no carregamento da página.

Essa linha oficial do Google forneceu um compromisso feliz para SEOs e desenvolvedores da Web que desejam encontrar um equilíbrio entre conteúdo rico em texto e apelo visual elegante.

Tem uma longa passagem de texto?

Basta colocá-lo dentro de um bloco de conteúdo expansível – e será perfeitamente bom para SEO.

Ou, pelo menos, foi isso que o Google nos levou a acreditar.

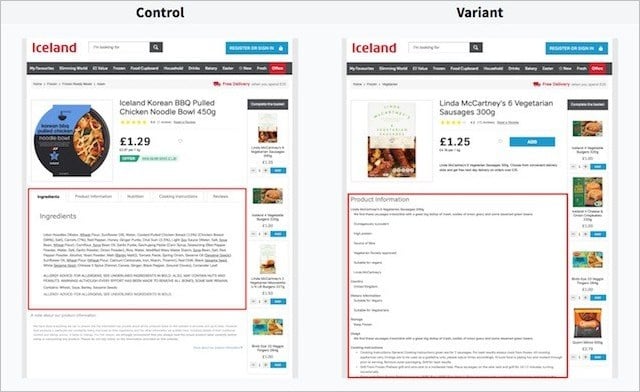

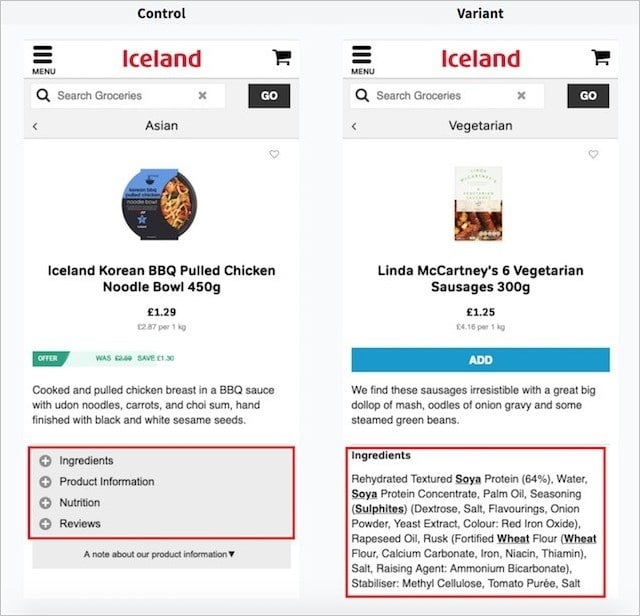

Digite Search Pilot e seu experimento de texto oculto.

Em seu experimento, o Search Pilot procurou testar o desempenho do texto nas guias (o controle) versus o texto totalmente visível no carregamento da página (a variante).

Aqui estão as versões da página na área de trabalho:

E aqui estão as versões da página no celular;

Eles testaram essas duas versões em muitas páginas de produtos do site de seus clientes e mediram a mudança no tráfego orgânico ao longo do tempo.

Veja como a variante (texto visível) se comportou em relação ao controle (o texto está oculto):

A versão com texto totalmente visível obteve 12% mais sessões orgânicas do que o texto oculto nas versões com abas.

Parece bem claro no teste do Search Pilot, ter seu conteúdo visível na página pode ser muito melhor para o seu tráfego orgânico.

O Search Pilot não foi o único a testar a hipótese de que mais peso é dado ao texto que é visível para o usuário em vez do texto que está fora da visão imediata do usuário.

Outro experimento da Reboot descobriu que o texto totalmente visível (e o texto contido em uma área de texto) superava significativamente o texto oculto atrás de JavaScript e CSS:

19. Testando a velocidade da página (os resultados podem surpreendê-lo)

Você provavelmente já ouviu falar que a velocidade da página é um importante fator de classificação.

Existem literalmente milhares de blogs que dizem que quanto mais rápida sua página, maior a probabilidade de classificação mais alta.

O que mais:

Não muito tempo atrás, o Google lançou uma “atualização de velocidade” que pretendia diminuir a classificação de sites carregando lentamente em dispositivos móveis.

Com todas as informações disponíveis sobre os tempos de carregamento da página sendo importantes para classificações mais altas, certamente o desempenho da velocidade da página é um sinal de classificação pesado!

Bem vamos ver.

É exatamente o que Brain Dean colocou à prova em seu experimento de velocidade de página :

Os resultados surpreenderam você?

20. Tags H1 e seu impacto nos rankings: o debate está encerrado

Todo guia de SEO oferece o mesmo conselho:

(Enrole o título da sua página ou poste em uma tag H1)

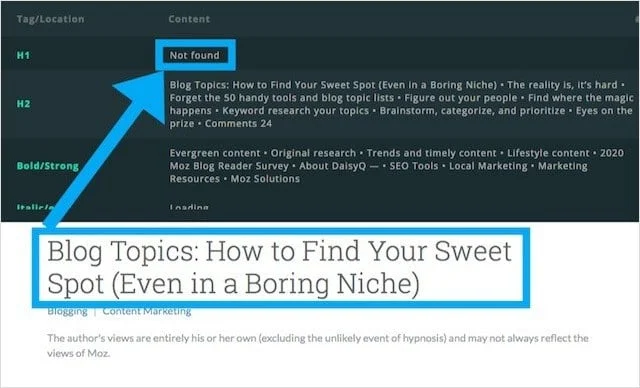

Mas nem todos os sites seguem essas chamadas melhores práticas, sendo o Moz.com uma delas.

Vamos encarar:

Moz é um dos sites mais confiáveis (e altamente trafegados) no tópico de SEO.

Ainda assim:

O blog da Moz não tem tag H1 e usa uma tag H2 como título principal.

Depois de perceber que o blog da Moz usava tags H2 para manchetes (em vez de H1s), Craig Bradford da Distilled entrou em contato com Cyrus Shepard na Moz.

Juntos, Craig e Cyrus decidiram realizar um experimento de tags de cabeçalho que, esperançosamente, determinaria de uma vez por todas se as tags H1 impactam os rankings orgânicos.

Para fazer isso, eles criaram um teste de divisão 50/50 das manchetes do blog da Moz usando o SearchPilot.

No experimento, metade das manchetes do Moz foi alterada para H1s e a outra metade mantida como H2s.

Cyrus e Crag então mediram a diferença no tráfego orgânico entre os dois grupos.

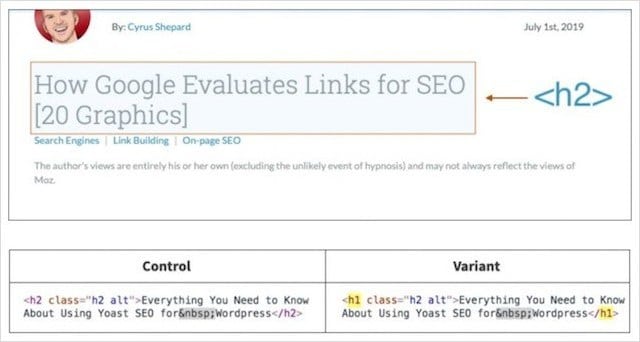

Resultados do experimento de tag de cabeçalho

Então, o que você acha que aconteceu quando os títulos principais foram alterados da tag de título incorreta (H2) para o título correto (H1)?

A resposta:

Não muito!

Após oito semanas de coleta de dados, eles determinaram que alterar os títulos dos posts do blog de H2s para H1s não fez diferença estatisticamente significativa.

O que podemos deduzir disso?

Apenas que o Google é igualmente capaz de determinar o contexto da página se seu título principal estiver envolvido em um H1 ou um H2.

Isso significa que você deve abandonar todos os guias de melhores práticas de SEO e acabar com os H1s?

Não!

Usar um H1 como seu cabeçalho principal fornece a estrutura de conteúdo adequada para ferramentas de leitura de tela, ajudando os leitores com deficiência visual a navegar melhor em seu conteúdo.

Eu explico este e outros quatro benefícios menos conhecidos em meu guia completo sobre tags de cabeçalho.

Por enquanto, vamos para o nosso experimento final de SEO.

21. Experimento de Hospedagem Compartilhada: Provando o Efeito “Bad Neighborhood”

Debates sobre o impacto da hospedagem de sites compartilhados e seu efeito nos rankings se espalharam na comunidade de SEO por eras.

Esses debates não se concentram apenas no aspecto de desempenho da hospedagem compartilhada (por exemplo, tempos de carregamento lentos que geralmente têm implicações negativas de SEO), mas em um conceito conhecido como “vizinhanças ruins”.

Bairros ruins, descrevem um ambiente de hospedagem com um IP comum e uma coleção de sites de baixa qualidade, não relacionados, penalizados e/ou potencialmente problemáticos (por exemplo, pornografia, jogos de azar, pílulas).

Da mesma forma, você pode ser impactado negativamente se linkar ou receber links de sites com spam;

Muitos acreditavam que encontrar seu site no mesmo servidor de sites de baixa qualidade ou não relacionados poderia ter efeitos semelhantes de esmagamento de classificação.

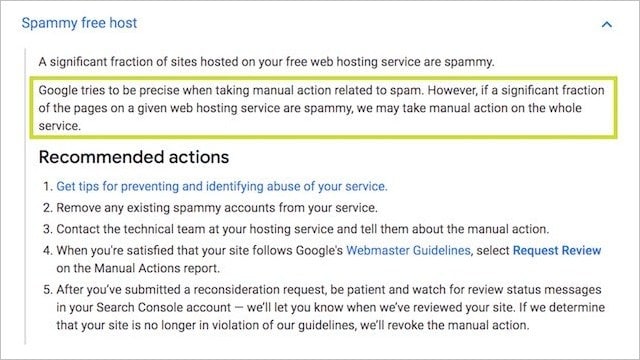

Esta ideia tem substância:

A própria documentação de ações manuais do Google afirma que todos os sites em um servidor podem ser “penalizados” devido à reputação de alguns:

Também é provável que os algoritmos do Google procurem padrões entre sites de baixa qualidade – e hospedagem compartilhada gratuita/barata é potencialmente um deles .

Vamos ser reais;

É mais provável que você encontre um site PBN descartável em uma conta de hospedagem compartilhada barata de US $ 10 por mês ou em um servidor dedicado premium de US $ 200 ou mais?

Você entendeu.

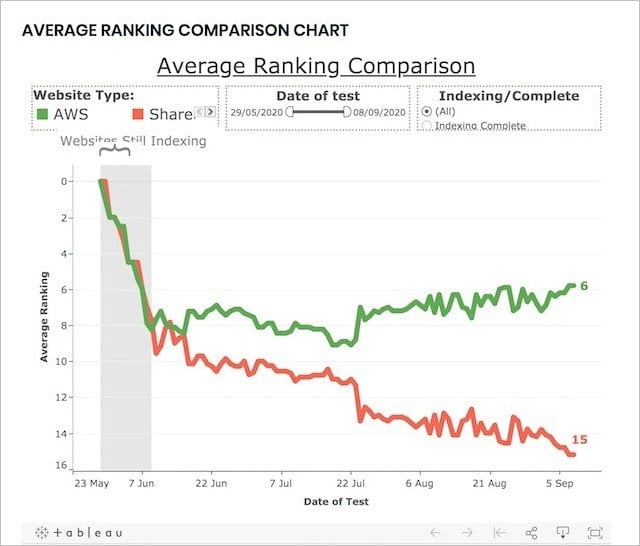

Para testar o desempenho da hospedagem compartilhada (muitos sites em um IP) versus hospedagem dedicada (IP único para um site), o Reboot realizou esse experimento de SEO.

Experiência de hospedagem compartilhada de longo prazo:

Para realizar o experimento, o Reboot Online criou 20 sites – todos em domínios .co.uk totalmente novos e contendo conteúdo exclusivo, mas otimizado de forma semelhante:

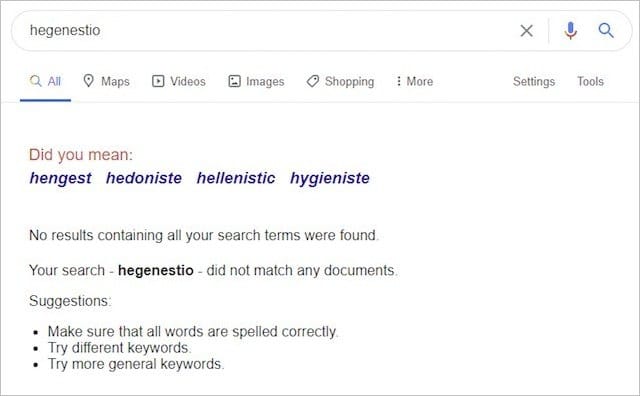

Todos os vinte sites segmentaram a mesma palavra-chave (“hegenestio”) que antes do experimento não tinha resultados no Google:

Eles então colocaram dez sites em servidores dedicados da AWS e dez em servidores compartilhados, alguns dos quais continham sites de bairros ruins como este:

E isto:

E, depois de indexar, os sites monitoraram seus rankings por um período de três meses.

Para garantir que o experimento não pudesse ser influenciado por outros fatores, o Reboot fez o seguinte:

- Garantiu que todos os domínios não tivessem conteúdo anterior indexado pelo Google.

- Construiu todos os sites com HTML estático, mas com CSS variável.

- Mediu regularmente o tempo de carregamento de cada site para garantir que não fosse um fator de influência.

- Usado StatusCake para verificar o uptime dos sites diariamente.

- Deu a cada site um meta título básico e semelhante e nenhuma meta descrição.

Essas etapas foram implementadas para demonstrar que a velocidade, confiabilidade, consistência, conteúdo, código e tempo de atividade dos sites não afetam os rankings.

Certo, então o que aconteceu?

Ao final do experimento, os resultados foram claros e conclusivos:

Sites em um endereço IP dedicado tiveram uma classificação MUITO melhor do que aqueles em um IP compartilhado.

Na verdade, no final do experimento, os dez principais resultados para a palavra-chave inventada continham 80%-90% de sites em IPs dedicados:

Os resultados desse experimento evidentemente sugerem que hospedar seu site em um ambiente de hospedagem compartilhada (contendo sites tóxicos e de baixa qualidade) pode ter um efeito negativo no seu desempenho orgânico.

Dado que todos os outros sinais de classificação foram removidos, em quanto, nesta fase, não sabemos.

O que podemos ter certeza é que, isoladamente, a hospedagem compartilhada é um fator negativo E se você leva a sério o seu negócio, um servidor decente (dedicado) é o caminho a percorrer .

Conclusão

Esses 21 experimentos de SEO renderam alguns resultados muito inesperados.

Alguns até transformaram o que pensávamos ser verdade sobre SEO inteiramente de cabeça para baixo.

Isso só prova que, com tão pouco conhecido sobre o funcionamento interno do algoritmo do Google, é essencial que testemos.

É somente através de testes que podemos ter certeza de que as estratégias de SEO que estamos implementando realmente produzirão resultados.

Terminamos este post com uma explicação de como o teste de SEO é feito para que você também possa executar experimentos de SEO e obter resultados de teste válidos (talvez até inovadores).

Um agradecimento especial a Eric Enge por esta contribuição:

“Investimos muita energia em cada teste que fazemos. Isso ocorre em grande parte porque fazer um trabalho sólido de teste exige que você faça uma remoção completa de variáveis de confusão e certifique-se de que o tamanho dos dados de sua amostra seja suficiente.

Algumas das principais coisas que tentamos fazer são:

1. Obtenha uma amostra de dados razoavelmente grande.

2. Esfregue os parâmetros de teste para remover os fatores que invalidarão o teste. Por exemplo, se estamos tentando testar se o Google usa um método específico para indexar uma página, precisamos fazer coisas como garantir que nada seja vinculado a essa página e que não haja ferramentas do Google referenciadas no HTML dessa página (por exemplo, Google Analytics, AdSense, Google Plus, Google Tag Manager, …).

3. Depois de obter os resultados, você deve deixar os dados contarem a história. Quando você iniciou o teste, provavelmente esperava um determinado resultado, mas precisa estar preparado para descobrir que estava errado.

Resumindo, é muito trabalho, mas para nós, os resultados justificam o esforço!”

Então aí está…

21 experimentos de SEO e seus resultados inesperados. O que mais você acha que deveria ser testado?

Qual resultado do experimento de SEO mais te surpreendeu?

Diga-me nos comentários abaixo.