21 experimentos de SEO que cambiarán tu forma de pensar sobre el SEO (para siempre)

Publicado: 2020-11-10 Creo que estarás de acuerdo conmigo cuando digo:

Creo que estarás de acuerdo conmigo cuando digo:

Hay MÁS conceptos erróneos en torno al SEO...

…que casi cualquier otro aspecto del marketing digital.

Y no es de extrañar si considera que hay más de 200 factores de clasificación , pero casi todos están envueltos en secreto.

Dado que Google no comparte (y es probable que nunca lo haga) el funcionamiento interno de su algoritmo, ¿cómo sabe lo que realmente funciona?

¿Cómo se descifran los mitos SEO del asunto y los rumores del hecho?

Te vuelves a la ciencia, eso es lo que!

BONIFICACIÓN: descargue cada experimento de SEO contenido en esta publicación como una práctica guía en PDF que puede imprimir o guardar en su computadora.

En esta publicación, compartiré contigo 21 increíbles experimentos de SEO (actualizados para el año 2021) que desafiarán lo que creías que era cierto sobre la optimización de motores de búsqueda.

Incluso iría tan lejos como para predecir que estos estudios de SEO cambiarán la forma en que haces SEO para siempre.

¿Estás listo? Porque todo está a punto de cambiar para ti.

Bien, entremos:

1. La tasa de clics afecta las clasificaciones orgánicas (y cómo usar eso para su beneficio)

Este primer experimento es un desastre.

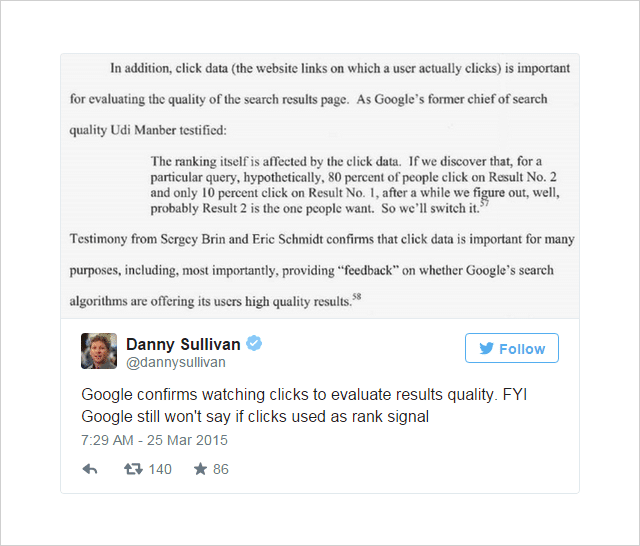

Durante algún tiempo, ha habido una opinión en el mundo de SEO de que la tasa de clics (CTR) puede influir en el ranking de búsqueda.

Alimentando la opinión hubo algunas pistas sólidas (aunque no concluyentes) desde dentro de Google:

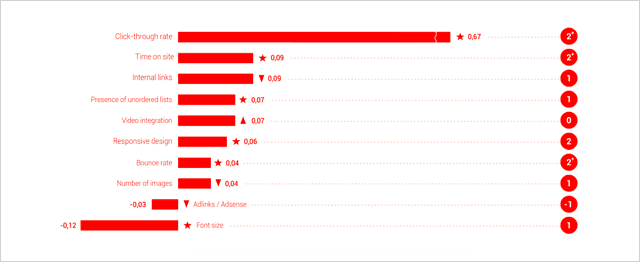

Y, los estudios de factores de clasificación de Searchmetrics han considerado cada vez más el CTR como uno de los factores de clasificación más importantes.

(Basado en la correlación, no en la causalidad, mente)

El argumento, como señala Jamie Richards, es que un sitio web que recibe una tasa de clics más alta que los sitios web que se encuentran por encima de él, puede señalarse a sí mismo como un resultado más relevante y afectar a Google para que lo mueva hacia arriba en los SERP.

La idea discutida por WordStream aquí es similar al Nivel de calidad asignado a los anuncios de Adwords, un factor determinado en parte por la tasa de clics relativa de un anuncio en comparación con los otros anuncios a su alrededor.

Esta fue la idea que Rand Fishkin de Moz se propuso probar en experimentos consecutivos.

Número uno: experimento de volumen de consultas y clics

El escenario de prueba que usó Rand Fishkin fue bastante simple.

- Haz que un grupo de personas busque una consulta específica en Google.

- Haga que esas personas hagan clic en un resultado en particular.

- Registre los cambios en la clasificación para determinar si el mayor volumen de clics en ese resultado influye en su posición.

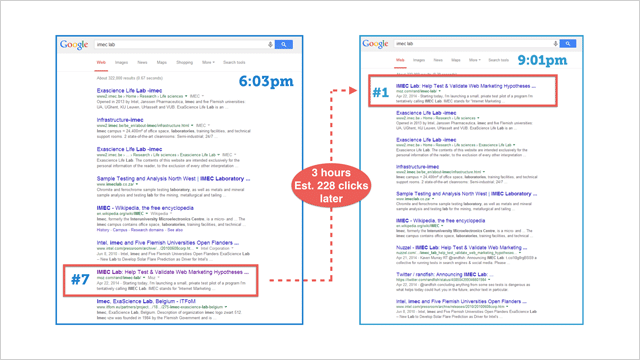

Para poner las cosas en marcha, Rand envió este Tweet a sus 264k seguidores de Twitter:

¿Quieres ayudar con una teoría/prueba de Google? ¿Podría buscar "IMEC Lab" en Google y hacer clic en el enlace de mi blog? Tengo una corazonada.

— Rand Fishkin (@randfish) 1 de mayo de 2014

Según los datos de Google Analytics, Rand estima que entre 175 y 250 personas respondieron a su llamado a la acción e hicieron clic en el resultado de IMEC.

Esto es lo que sucedió:

La página se disparó hasta la posición #1.

Esto indica claramente (al menos en este caso particular) que la tasa de clics influye significativamente en las clasificaciones .

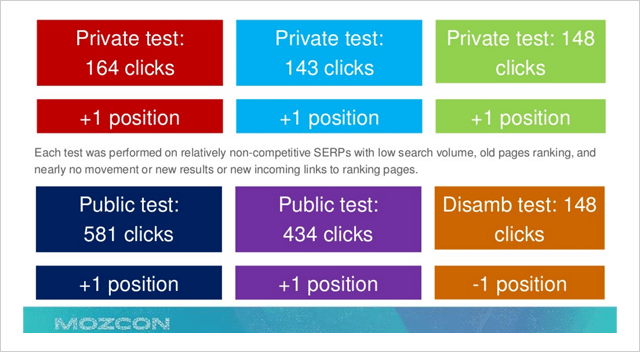

En un intento de validar estos datos, lo que siguió fue una serie de pruebas repetidas que mostraron una tendencia ascendente general cuando se incrementó el volumen de clics para un resultado en particular.

Desafortunadamente, esta vez, los datos fueron mucho menos dramáticos y concluyentes.

¿Por qué podría ser eso?

A Rand le preocupaba que, en respuesta a su publicación pública que mostraba cómo los clics pueden influir en los resultados de Google de manera más directa de lo que se sospechaba anteriormente, Google podría haber endurecido sus criterios en torno a este factor en particular.

Aún así, no se desanimó…

Número dos: experimento de volumen de consultas y clics

Inspirado por una botella de whisky Sullivans Cove durante un descanso en un partido de la Copa Mundial, Rand Fishkin envió otro tweet:

¿Qué debe hacer durante esa pausa en el partido de la Copa del Mundo? ¡Ayúdame a hacer una prueba! Toma <30 segundos: http://t.co/PxXWNlVdTi

— Rand Fishkin (@randfish) 13 de julio de 2014

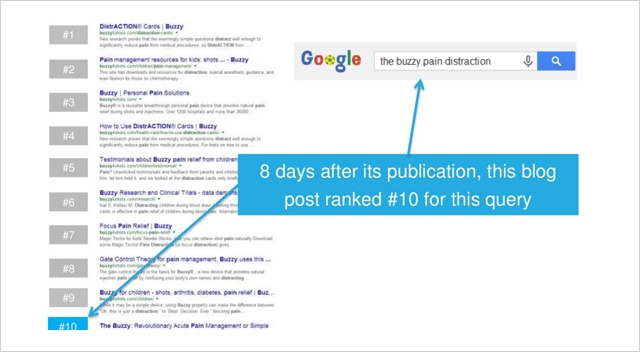

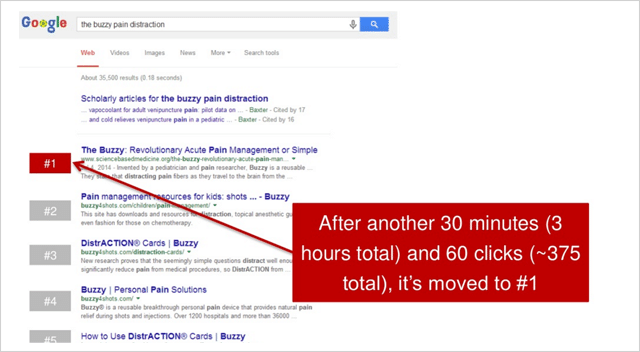

El tweet señaló a sus seguidores algunas instrucciones básicas que pedían a los participantes que buscaran "la distracción del dolor zumbante" y luego hicieran clic en el resultado para sciencebasedmedicine.org.

Aquí es donde apareció el sitio web de destino antes del inicio del experimento:

Durante el siguiente período de 2,5 horas después del tweet inicial de Rand, un total de 375 participantes hicieron clic en el resultado.

El efecto fue dramático.

sciencebasedmedicine.org saltó del número diez al número uno en Google.

¡Eureka!

Este evento milagroso, a su vez, provocó una reacción en cadena...

Que terminó en este momento de celebración para Rand:

Por lo tanto, parece que el volumen de clics (o la tasa de clics relativa) sí afecta la clasificación de búsqueda. Si bien hay algunas personas como Bartosz Goralewicz que argumentan en contra de esto, creo que esto es cierto.

Hay varias razones por las que Google consideraría la tasa de clics como una señal de clasificación además de las señales principales como el contenido y los enlaces.

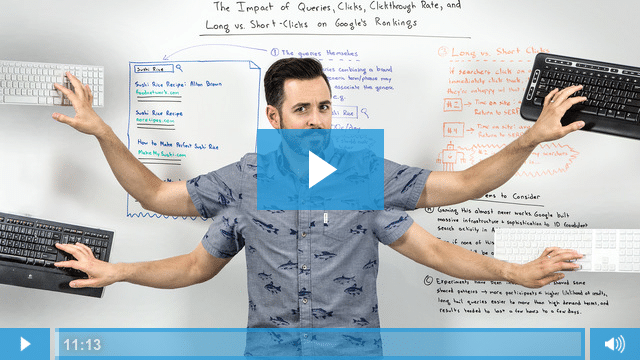

Este video de Whiteboard Friday proporciona una excelente explicación de por qué:

Así que el caso es convincente, la tasa de clics ciertamente afecta las clasificaciones de búsqueda de Google.

Un estudio posterior de Larry Kim parece sugerir que si superas la tasa de clics esperada en un 20 por ciento, subirás de rango.

Genial, eso está muy bien.

Pero, ¿cómo utilizas esa información a tu favor?

Aquí hay 4 pasos de acción que le mostrarán exactamente eso:

(1) Optimice su tasa de clics : para hacer esto, cree títulos de página y descripciones meta convincentes para sus páginas que vendan a las personas al hacer clic en su resultado sobre los que están arriba.

(2) Cree su marca : una marca establecida y reconocible atraerá más clics. Si los usuarios conocen tu marca (y, con suerte, también les gusta y confían en ella), tendrás más prominencia en las SERP.

(3) Optimizar para clics prolongados : no solo optimice para obtener clics, concéntrese en mantener a los usuarios en su sitio durante mucho tiempo. Si obtiene más clics, pero esos usuarios simplemente regresan a los resultados, cualquier beneficio que haya obtenido de un mayor CTR se cancelará.

(4) Use tácticas genuinas : los efectos de un aumento repentino en el CTR (al igual que el experimento de Rand) durarán poco tiempo. Cuando regresen las tasas de clics normales, también lo hará su posición anterior en el ranking. Utilice los elementos 1 y 2 para obtener resultados duraderos.

2. La industria se equivocó. Mobilegeddon era enorme

Mobilegeddon fue el nombre no oficial que se le dio a la actualización compatible con dispositivos móviles de Google antes de su lanzamiento el 21 de abril de 2015.

Se esperaba que la actualización disparara las clasificaciones de búsqueda móvil para sitios web que son legibles y utilizables en dispositivos móviles.

Se anticipó que hundiría los sitios web que no fueran aptos para dispositivos móviles.

Algunas personas incluso decían que sería un evento catastrófico más grande que Google Penguin y Panda.

Durante los meses anteriores, los webmasters se esforzaron por poner en orden sus sitios. A medida que se acercaba el día, la lucha se convirtió en pánico cuando los propietarios de los sitios se dieron cuenta de que sus sitios web fallaron en la prueba de Google para dispositivos móviles.

Entonces, ¿qué sucedió el 21 de abril de 2015? ¿Millones de sitios web cayeron en el abismo de la búsqueda móvil?

Según la mayoría de los informes, no sucedió gran cosa.

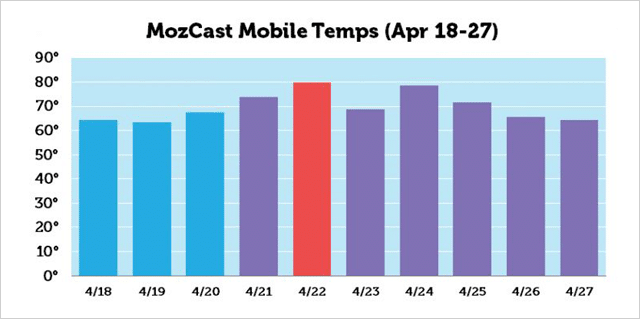

Claro, hubo un pico de actividad alrededor del 22 de abril según MozCast, pero los cambios en la clasificación no fueron tan grandes como la mayoría de los SEO pensaron que serían.

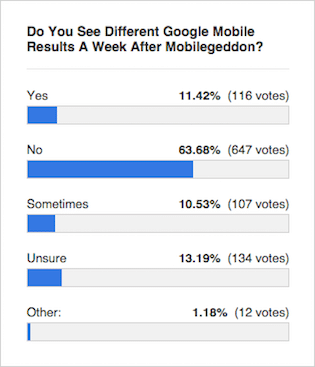

El consenso de expertos como esta encuesta de la Mesa Redonda de Motores de Búsqueda fue que los resultados prácticamente no cambiaron:

Pero, ¿qué mostraron los resultados de la prueba?

Pero, ¿qué mostraron los resultados de la prueba?

Entra Eric Enge y el equipo de Stone Temple Consulting...

Estudio de clasificación de Mobilegeddon

En la semana del 17 de abril de 2015 (antes de Mobilegeddon), Stone Temple extrajo datos de clasificación de los 10 resultados principales para 15 235 consultas de búsqueda. Obtuvieron datos sobre las mismas 15 235 consultas de búsqueda nuevamente en la semana del 18 de mayo de 2015 (después de Mobilegeddon).

Registraron las posiciones de clasificación y también identificaron si los slugs de URL en los resultados fueron designados como aptos para dispositivos móviles por Google o no.

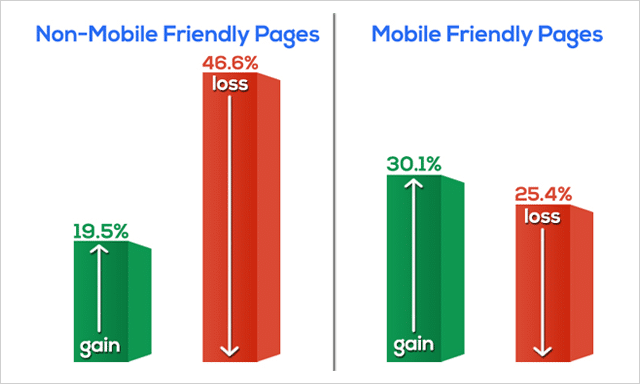

Esto es lo que encontraron:

Las páginas web no aptas para dispositivos móviles perdieron clasificaciones drásticamente.

De hecho, casi el 50% de todas las páginas web que no son compatibles con dispositivos móviles bajaron las SERP.

Las páginas optimizadas para dispositivos móviles (en general) ganaron en su ranking.

Los datos que Eric y el equipo recopilaron en su prueba de Mobilegeddon claramente van en contra de la opinión general de la prensa especializada.

¿Por qué la prensa se equivocó?

Es probable que debido a que la actualización del algoritmo se implementó lentamente con el tiempo, no fue inmediatamente obvio que se estaban produciendo movimientos tan significativos.

Además, se lanzó una actualización de calidad durante el mismo período que puede haber enturbiado los efectos de Mobilegeddon en las clasificaciones de búsqueda.

Entonces, terminemos rápidamente con Mobilegeddon con tres puntos;

- Fue un gran problema.

- Si aún no te has "pasado al móvil", ¿qué estás esperando?

- Si no está seguro de si su sitio web es compatible con dispositivos móviles o no, realice esta prueba.

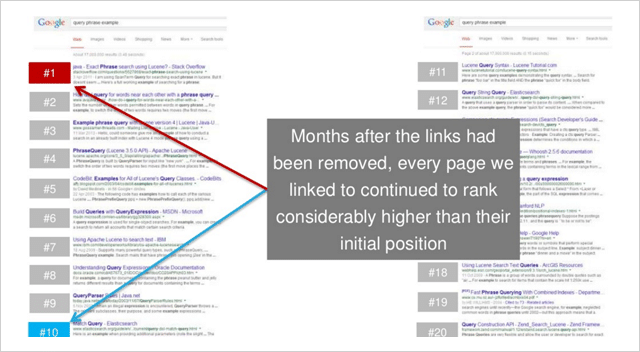

3. Ecos de enlaces: cómo funcionan los backlinks incluso después de que se eliminan

Crédito a quien crédito merece.

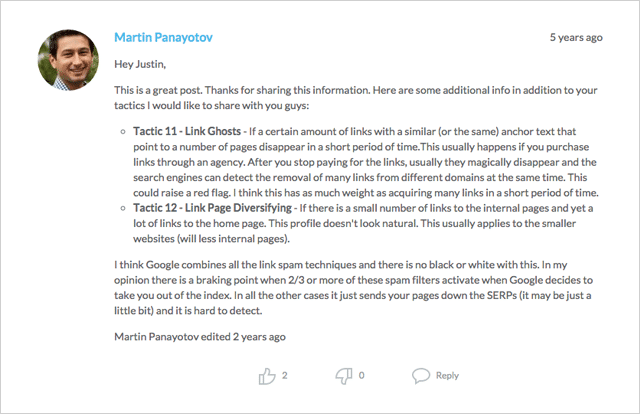

La idea de 'ecos de enlaces' (o 'fantasmas de enlaces', como también se les conoce) fue identificada por primera vez por Martin Panayotov y también por Mike King de iPullRank en los comentarios de esta publicación.

La idea es que Google continúe rastreando los enlaces y considere el valor de estos (positivos o negativos) incluso después de que se eliminen los enlaces.

Si este es el caso, ¿un sitio web que aumentó de rango después de que se agregó un enlace continúa clasificándose después de que se eliminó el enlace?

Bien, veamos.

Este experimento en particular fue realizado por el equipo de Moz y se encontraba entre una serie que se propuso probar el efecto de los enlaces de texto de anclaje enriquecidos (consulte el experimento de SEO número 8) en las clasificaciones de búsqueda.

Pero, como suele suceder en la ciencia, los experimentos produjeron algunos hallazgos completamente inesperados.

El efecto de eco de enlace

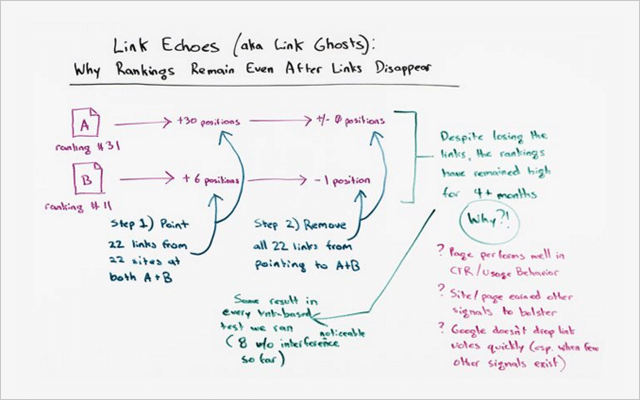

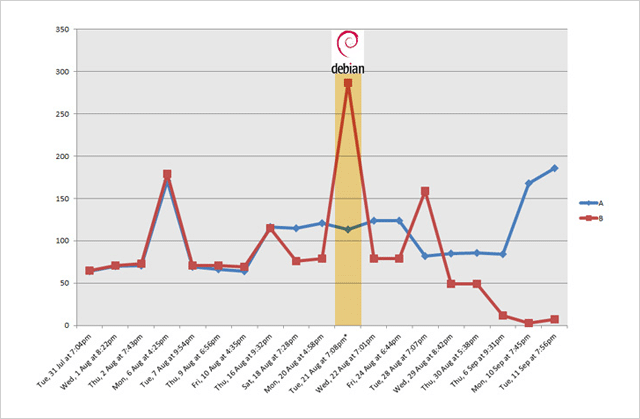

Hubo 2 sitios web en este experimento; Sitio web A y sitio web B.

Antes de la prueba, así es como se clasificaron para la misma (palabra clave no muy competitiva):

- Sitio web A – posición 31

- Sitio web B – posición 11

Durante la prueba, se agregaron enlaces a 22 páginas en varios sitios web que apuntaban tanto al sitio web A como al sitio web B.

Ambos sitios web, que recibieron 22 enlaces cada uno, posteriormente se dispararon en la clasificación:

- El sitio web A pasó de la posición 31 a la posición 1 (un aumento de +30 posiciones)

- El sitio web B pasó de la posición 11 a la posición 5 (y aumento de +6 posiciones)

En resumen, ambos sitios web aumentaron considerablemente su clasificación cuando se agregaron enlaces.

Pero, ¿qué sucedió cuando se eliminaron esos mismos enlaces?

Responder. Muy poco en absoluto.

El sitio web A permaneció en la posición número 1.

El sitio web B descendió ligeramente a la posición 6 (una pequeña caída de solo 1 posición)

Este experimento valida la hipótesis.

Parece que queda algo de valor de los enlaces (quizás mucho), incluso después de que se eliminan los enlaces.

¿Podría haber sido este experimento un caso aislado?

No según Rand Fishkin:

“Este efecto de estas pruebas de enlace, que permanecieron en su lugar mucho después de que se eliminó el enlace, ocurrió en cada prueba de enlace que realizamos, de las cuales conté ocho en las que me siento muy seguro de que no hubo variables de confusión, sintiéndome realmente bien que hemos siguió un proceso como este. Los enlaces señalaron, el ranking subió. Los enlaces desaparecieron, el ranking se mantuvo alto”.

Pero, esto es lo que es tan notable...

Estas clasificaciones más altas no fueron de corta duración.

Permanecieron durante muchos meses después de que se eliminaron los enlaces.

En el momento de este video, los resultados se habían mantenido durante 4,5 meses.

Es más…

“Ni en una sola prueba, cuando se eliminaron los enlaces, las clasificaciones volvieron a su posición original”, dice Rand Fiskin.

Hay varias lecciones que puedes aprender de esto, pero lo dejaré en estos dos:

(1) Los enlaces de calidad valen su peso en oro . Al igual que una inversión sólida, los vínculos de retroceso seguirán brindándole un buen rendimiento. El 'eco' de un voto una vez emitido (como lo demuestra esta prueba) proporcionará beneficios incluso cuando se elimine.

(2) El valor de los enlaces SÍ permanece durante algún tiempo . Por lo tanto, antes de caer en la tentación de adquirir enlaces ilegítimos, considere si está listo para dejar esa huella durante meses (o incluso años) en el futuro.

En resumen, dedique su tiempo a concentrarse en crear enlaces orgánicos naturales.

Los enlaces pueden funcionar a tu favor o en tu contra. Por lo tanto, asegúrese de que sea el primero.

¿Te faltan estrategias de construcción de enlaces?

Echa un vistazo a esta publicación que tiene docenas de ideas para comenzar.

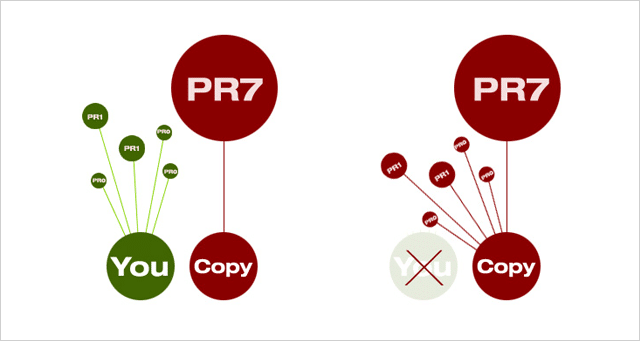

4. Puedes clasificar con contenido duplicado. Funciona incluso con palabras clave competitivas

Divulgación completa, lo que estoy a punto de compartir contigo puede que solo funcione por un corto tiempo. Pero, por el momento , funciona, chico, funciona como gangbusters.

Primero la teoría.

Cuando hay dos documentos idénticos en la web, Google elegirá el que tenga un PageRank más alto y lo utilizará en los resultados de búsqueda.

También reenviará cualquier enlace de cualquier 'duplicado' percibido hacia el documento 'principal' seleccionado.

¿Por qué hace esto?

A menos que exista una razón válida para dos o más versiones del mismo contenido, solo es necesario que exista una.

Y, ¿qué significa eso para ti?

Significa que si está creando contenido único y autorizado (que atrae enlaces y recursos compartidos de calidad), debe salir primero. Google mantendrá su versión en el índice y apuntará todos los enlaces dirigidos a los duplicados a su sitio.

La mala noticia (al menos para los buenos), no siempre es así.

De vez en cuando, un sitio más grande y con mayor autoridad superará a los sitios web más pequeños en las SERP por su propio contenido.

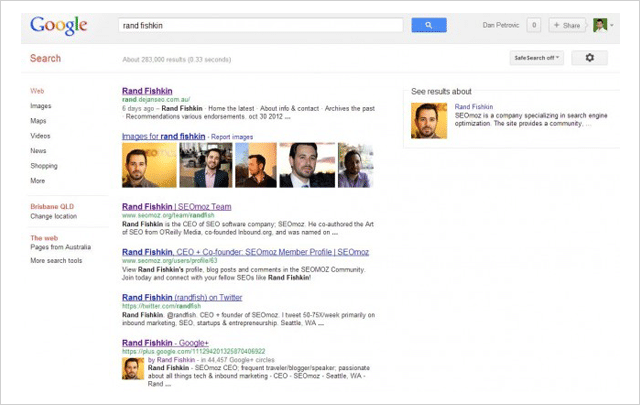

Esto es lo que Dan Petrovic de Dejan SEO decidió probar en su ahora famoso experimento de secuestro de SERP.

Usando cuatro páginas web separadas, probó si el contenido podía ser 'secuestrado' de los resultados de búsqueda copiándolo y colocándolo en una página de PageRank más alta, que luego reemplazaría al original en los SERP.

Esto es lo que sucedió:

- En las cuatro pruebas, la página imitadora de relaciones públicas más alta venció a la original .

- En 3 de cada 4 casos, la página original se eliminó de las SERP .

Sus pruebas demuestran que una página de PageRank más alta vencerá a una página de PageRank más baja con el mismo contenido, incluso si la página de PR más baja es la fuente original.

E, incluso si la página original fue creada por el mismo ex Mago de Moz, Rand Fishkin.

( Imagen: Rand Fishkin fue superado por su propio nombre en el experimento de Dan Petrovic).

Entonces surge la pregunta, ¿qué puedes hacer para evitar que tu propio contenido sea secuestrado?

Si bien no hay garantía de que puedas evitar que el contenido que tanto te ha costado conseguir sea copiado y luego golpeado, Dan ofrece las siguientes medidas que pueden ayudarte a defenderte de los ladrones de contenido:

(1) Agregue la etiqueta rel=”canonical” a su contenido usando el texto http:// completo.

(2) Enlace a páginas internas en su propio sitio web.

(3) Agregue el marcado de autoría de Google.

(4) Verifique si hay contenido duplicado regularmente usando una herramienta como Copyscape.

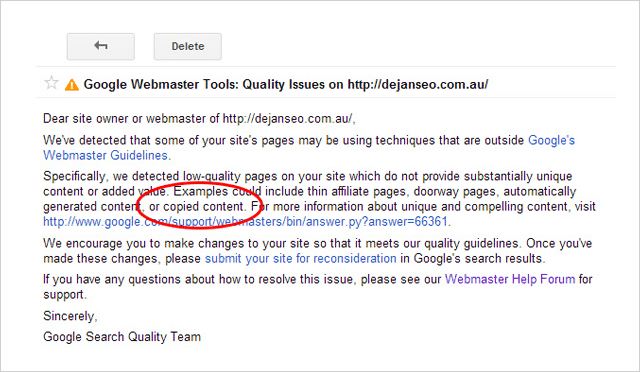

Cuidado con los plagiadores

El hecho de que pueda vencer a sus competidores robando su contenido no significa que deba hacerlo .

No solo es poco ético y francamente turbio reclamar el contenido de otra persona como propio, sino que el plagio también puede causarle problemas.

Poco después de ejecutar el experimento, Dejan SEO recibió un mensaje de advertencia dentro de su cuenta de Google Search Console.

El mensaje mencionaba que el dominio dejanseo.com.au tenía páginas de baja calidad, un ejemplo de lo cual es el "contenido copiado". Casi al mismo tiempo, una de las páginas de prueba de imitación también dejó de mostrarse en SERP para algunos términos.

Esto obligó a Dan a eliminar las páginas de prueba para resolver el problema de calidad de su sitio.

Así que parece que si bien puedes vencer a tus competidores con su propio contenido, definitivamente no es una buena idea hacerlo.

5. El número uno NO es el lugar 'superior' (y lo que es ahora)

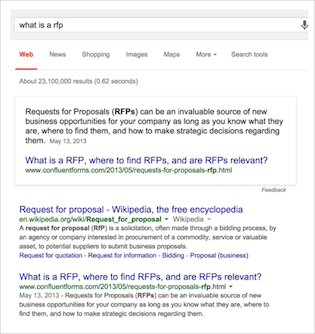

En esta prueba, Eric Enge y el equipo de Stone Temple Consulting (ahora parte de Perficient) se dispusieron a medir el cambio en la visualización de Rich Answers en los resultados de búsqueda de Google.

En caso de que no esté familiarizado con la terminología...

Las respuestas enriquecidas son las respuestas 'en la búsqueda' a sus consultas que probablemente ha visto más en los últimos tiempos. Su objetivo es responder a su consulta sin que tenga que hacer clic en un sitio web.

Hay muchas variedades de Rich Answers como esta:

O este carrusel que se me mostró cuando busqué "zonas horarias de Australia"

Hay literalmente docenas de variaciones, muchas de las cuales son compartidas por Google aquí.

Estudio de respuestas enriquecidas de Stone Temple Consulting

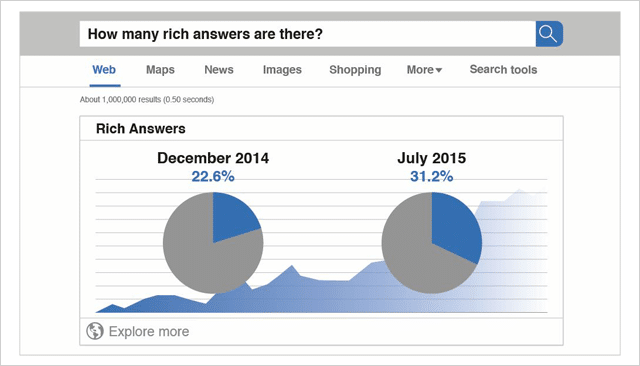

Los datos de referencia para este estudio se recopilaron en diciembre de 2014.

En total se analizaron 855.243 consultas.

Del total de consultas medidas en ese momento, el 22,6 % mostró respuestas enriquecidas.

Posteriormente en julio de 2015 se volvieron a analizar las mismas 855.243 consultas.

En ese momento (solo 7 meses después), el porcentaje total de consultas que mostraban Rich Answers había aumentado al 31,2 %.

Debido a que el estudio de Stone Temple Consulting midió exactamente las mismas 855,243 consultas, la comparación entre estos dos conjuntos de datos es una comparación estricta de manzana a manzana.

Los datos son claros.

Rich Answers está en aumento y los resultados que ve hoy están muy lejos de los diez enlaces azules del pasado.

( Fuente: Quicksprout)

La vista cambiante en los resultados de búsqueda

Cuando las páginas de resultados del motor de búsqueda eran solo una lista de sitios web ordenados según su relevancia para una consulta, estaba claro por qué los propietarios de sitios web harían todo lo posible para obtener el primer puesto.

Cuanto más arriba en los rangos, más clics obtuvo.

Según este estudio realizado por Erez Barak en Optify, en 2011 el sitio web mejor clasificado recibiría hasta el 37% del total de clics.

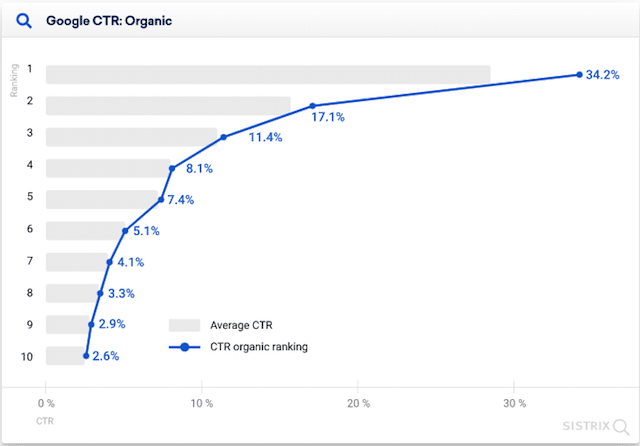

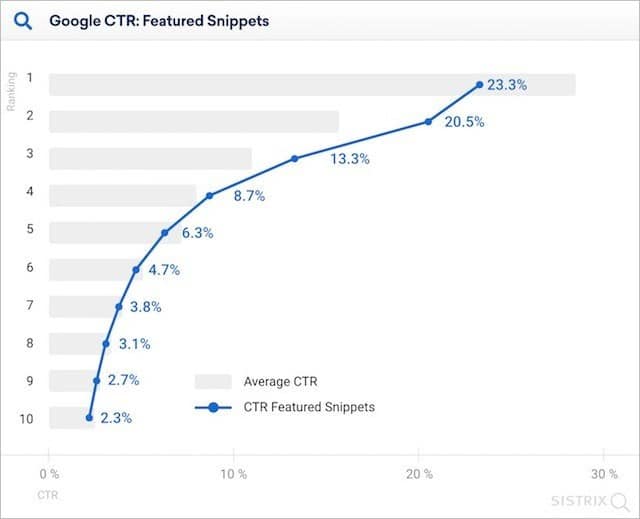

Incluso en 2020, Sistrix informó en su investigación que los sitios mejor clasificados (donde no se muestran fragmentos destacados) generan más del doble de clics en comparación con los sitios web en segundo lugar.

Pero, con el crecimiento de Rich Answers, todo eso está cambiando.

El resultado orgánico 'número uno' está siendo empujado más y más abajo en la página. Los volúmenes de clics para el 'primer puesto' están cayendo.

Pero, ¿cuánto afectan Rich Answers a las tasas de clics?

La respuesta corta es mucho.

En su estudio de 2020, Sistrix determinó que, en presencia de un fragmento destacado, el resultado web número uno en la clasificación obtuvo el 23,3 % de los clics.

Eso es un once por ciento menos que cuando no hay un fragmento destacado.

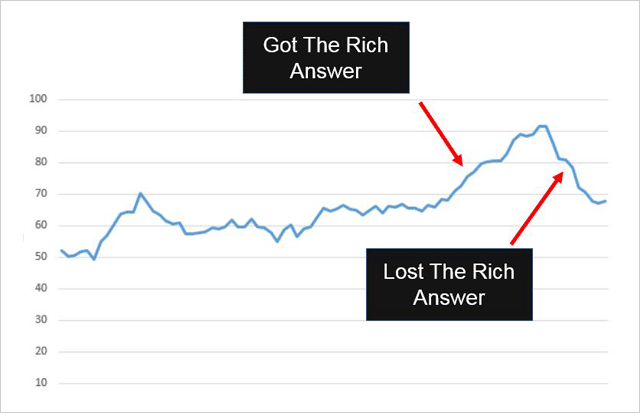

Es claro ver cómo la inclusión (y eliminación) de una respuesta de fragmento enriquecido en las SERP puede afectar el tráfico de búsqueda general de un sitio web.

Aquí hay un ejemplo:

Confluent Forms obtuvo un resultado de Rich Snippet en su sitio web y esto es lo que sucedió con su tráfico:

Subió una vez que se agregó Rich Answer.

Se cayó cuando se eliminó Rich Answer.

Y recuerda esto…

Las respuestas enriquecidas están destinadas a resolver consultas desde los resultados de búsqueda. Sin embargo, aún pueden enviar tráfico adicional a su sitio , tal como lo hicieron con Confluent Forms.

Cómo utilizar las respuestas enriquecidas a su favor

Las respuestas enriquecidas generalmente se proporcionan para consultas de búsqueda basadas en preguntas.

Y, según Eric Enge (quien obtuvo con éxito una respuesta enriquecida para su propio sitio web), responder preguntas es la mejor manera de hacerlo.

Si desea beneficiarse de Rich Answers (y quién no), le sugiero que preste atención a su consejo:

(1) Identifique una pregunta simple : asegúrese de que la pregunta sea sobre el tema. Puede verificar esto usando una herramienta de relevancia como nTopic.

(2) Proporcione una respuesta directa : asegúrese de que su respuesta sea simple, clara y útil tanto para los usuarios como para los motores de búsqueda.

(3) Ofrezca información de valor agregado : además de su respuesta concisa a la pregunta, incluya más detalles y valor. Asegúrate de no volver a citar Wikipedia ya que eso no te llevará muy lejos.

(4) Facilite la búsqueda por parte de los usuarios y de Google : esto podría significar compartirlo con sus seguidores de las redes sociales o vincularlo desde sitios web propios o de terceros.

6. El uso de HTTPS en realidad puede dañar su clasificación

Haga que su sitio web sea seguro o de lo contrario.

Ese fue el mensaje que Google presentó en esta publicación de blog cuando declaró HTTPS como una señal de clasificación.

Y tendría sentido ¿no?

Los sitios web que usan HTTPS son más seguros. Google quiere que los sitios a los que accede la gente desde el motor de búsqueda sean seguros. Los sitios que usan HTTPS deberían recibir un impulso de clasificación.

Pero aquí está la cosa. ellos no

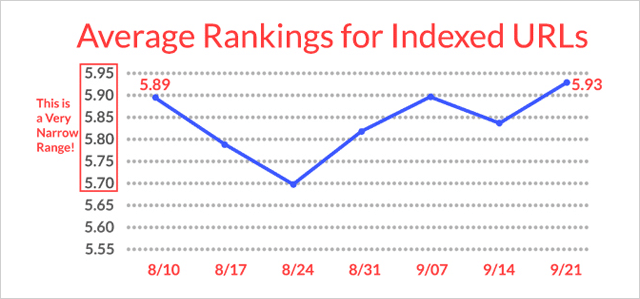

(Eso es si el estudio de Stone Temple Consulting y seoClarity sirve de referencia).

El estudio de HTTPS rastreó las clasificaciones en 50 000 búsquedas de palabras clave y 218 000 dominios. Supervisaron esas clasificaciones a lo largo del tiempo y observaron qué URL en las SERP cambiaron de HTTP a HTTPS.

De los 218 000 dominios rastreados, solo 630 (0,3 %) de ellos cambiaron a HTTPS.

Esto es lo que sucedió con los sitios web HTTPS:

De hecho, perdieron ranking .

Más tarde se recuperaron (lentamente) hasta prácticamente donde comenzaron.

Apenas una razón para subirse al carro de HTTPS.

Parece que HTTPS (a pesar de que Google quiere que sea estándar en todas partes de la web) no tiene un beneficio de clasificación significativo por ahora y, de hecho, puede dañar su clasificación a corto plazo.

Mi consejo : sigue usando HTTP a menos que realmente necesites cambiar.

7. Robots.txt NoIndex no funciona (siempre)

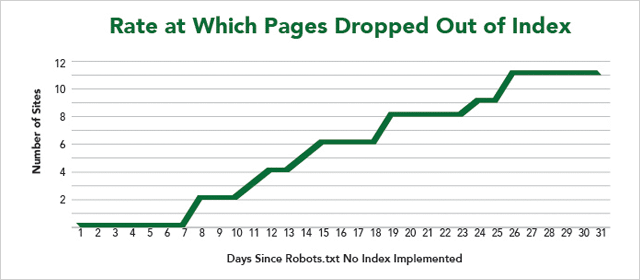

En otro experimento del Laboratorio IMEC, 12 sitios web ofrecieron sus páginas para probar si el uso de Robots.txt NoIndex bloquea con éxito a los motores de búsqueda para que no rastreen E indexen una página.

Primero lo técnico.

Cómo evitar que los motores de búsqueda indexen su página web

El enfoque común adoptado por los webmasters es agregar una directiva NoIndex dentro de la metaetiqueta Robots en una página. Cuando las arañas de los motores de búsqueda rastrean esa página, identifican la directiva NoIndex en el encabezado de la página y eliminan la página del índice.

En resumen, rastrean la página y luego evitan que se muestre en los resultados de búsqueda.

El código se ve así:

Por otro lado, la directiva NoIndex colocada dentro del archivo Robots.txt de un sitio web detendrá la indexación de la página y el rastreo de la página.

O al menos debería…

Como puede ver en los resultados, no todas las páginas web se eliminaron del índice.

Malas noticias si desea ocultar el contenido de su sitio de miradas indiscretas.

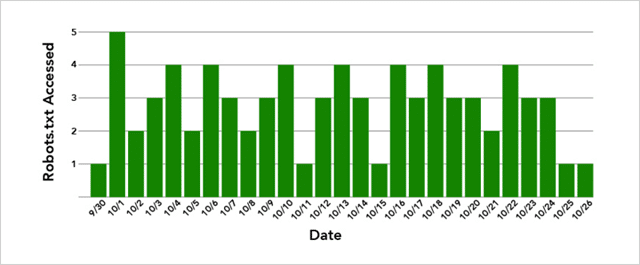

Además, Google no eliminó ninguna de las páginas inmediatamente a pesar de que los archivos Robots.txt del sitio web se rastreaban varias veces al día.

Y, si cree que es porque Google también necesita intentar rastrear la página, tampoco es cierto.

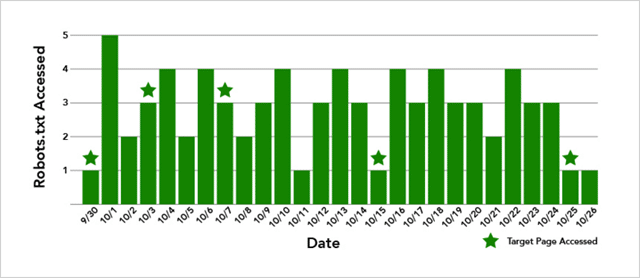

En el caso del sitio web cuya página no se eliminó del Índice, la página de destino se rastreó 5 veces:

Entonces, ¿qué está en juego aquí?

Bueno, los resultados no son concluyentes.

Pero, lo que podemos estar seguros de decir es que (a pesar de que Google muestra el soporte de Robots.txt NoIndex) funciona lentamente y, a veces, no funciona en absoluto.

Mi consejo: utilice Robots.txt NoIndex con precaución.

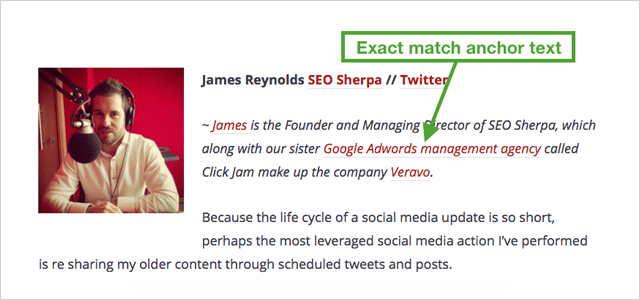

8. Enlaces de texto ancla de coincidencia exacta Enlaces de coincidencia no ancla de Trump

Si ha leído un par de cosas sobre SEO, habrá aprendido que el texto de anclaje de coincidencia exacta es malo .

Demasiados enlaces que dicen lo mismo no son naturales.

Y podría aterrizarte con una penalización.

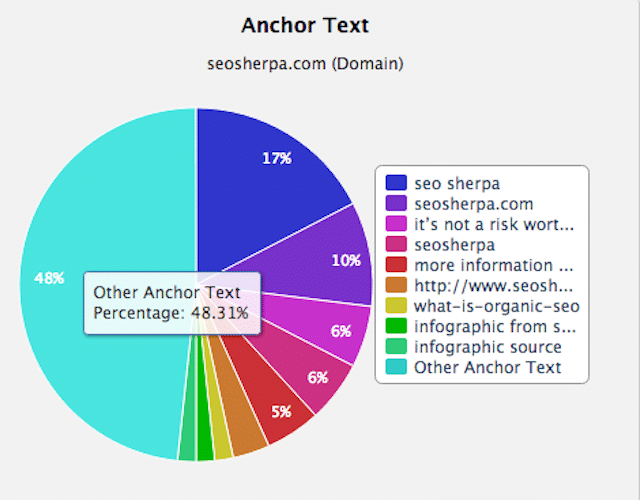

Desde que se lanzó Google Penguin para poner fin a la construcción de enlaces manipuladores, el consejo de los expertos ha sido "mantener bajas las proporciones de texto de anclaje".

En términos simples, eso significa que desea una combinación de enlaces a su sitio para que ningún texto de anclaje rico en palabras clave represente más que un pequeño porcentaje del total.

Los enlaces sin formato como este: http//yourdomain.com, así como los enlaces genéricos como "su marca", "haga clic aquí" y "visite este sitio web" son buenos.

Más de un pequeño porcentaje de enlaces ricos en palabras clave es malo.

Un perfil de enlace variado y natural se parecerá al mío:

Como puede ver, la mayoría de los enlaces son para mi marca. El resto son en su mayoría otros textos de anclaje.

Con eso en mente.

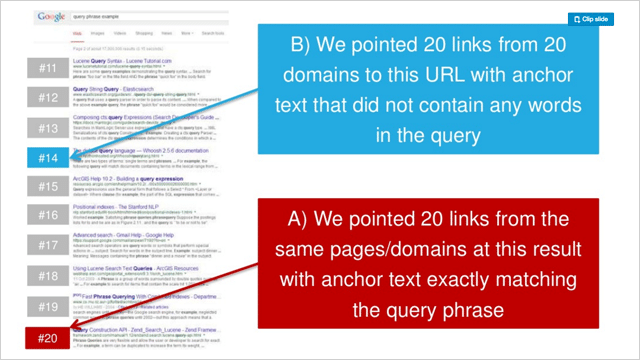

¿Qué sucede cuando apunta 20 enlaces a un sitio web, todos con el mismo texto de anclaje rico en palabras clave?

Tu ranking se dispara, ¡eso es lo que pasa!

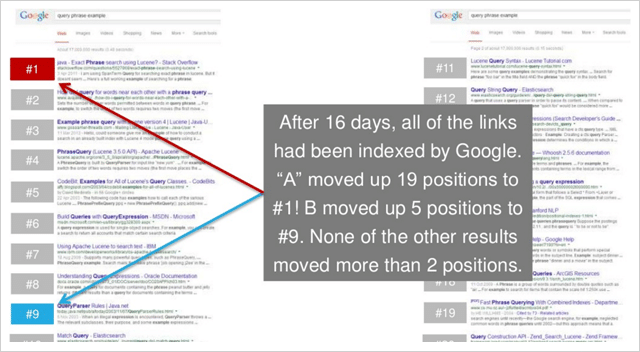

En una serie de tres experimentos, Rand Fishkin probó señalar 20 enlaces de anclaje genéricos a una página web frente a 20 enlaces de texto de anclaje de coincidencia exacta.

En cada caso, el texto de anclaje de coincidencia exacta aumentó significativamente la clasificación de las páginas de destino.

Y, en 2 de 3 pruebas, los sitios web de texto de anclaje de coincidencia exacta capitularon los sitios web de texto de anclaje genérico en los resultados.

Aquí están las clasificaciones anteriores de la prueba 2 en la serie de Rand:

Y aquí están las clasificaciones después:

Eso es condenadamente concluyente.

El texto de anclaje de coincidencia exacta es considerablemente más poderoso que los enlaces que no son de coincidencia de anclaje.

(Y sorprendentemente poderoso en general)

9. Enlace a otros sitios web para mejorar su clasificación

Los enlaces salientes diluyen la autoridad de su sitio.

Esta ha sido la noción generalmente concebida en el mundo del SEO durante algún tiempo.

Y esto a pesar de que Google dice que la vinculación a recursos relacionados es una buena práctica.

Entonces, ¿por qué los SEO están tan en contra de los enlaces salientes?

La idea es que los enlaces salientes te hagan perder PageRank. Cuantos más enlaces salientes, más PageRank das.

Y dado que perder PageRank significa perder autoridad, el resultado de la vinculación es una clasificación más baja. Derecha

Bueno, averigüémoslo.

Shai Aharony y el equipo de Reboot pusieron a prueba esta noción en su experimento de enlaces salientes.

Para el experimento, Shai configuró diez sitios web, todos con formatos de dominio y estructura similares.

Cada sitio web contenía un artículo único de 300 palabras que se optimizó para una palabra inventada "phylandocic"

Antes de la prueba, la palabra "phylandocic" mostró cero resultados en Google.

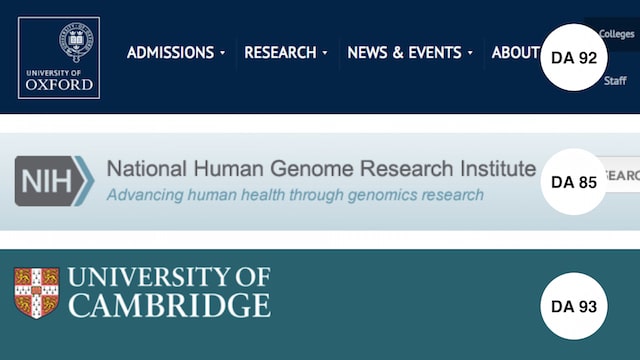

Para probar el efecto de los enlaces salientes, se agregaron 3 enlaces de seguimiento completos a 5 de los 10 dominios.

Los enlaces apuntaban a sitios web altamente confiables:

- Universidad de Oxford (DA 92)

- Instituto de Investigación del Genoma (DA 85)

- Universidad de Cambridge (DA 93)

Una vez indexados todos los sitios web de prueba, se registraron las clasificaciones.

Aquí están los resultados:

Son tan claros como la noche y el día.

CADA sitio web con enlaces salientes superó a los que no los tenían.

Esto significa que su paso de acción es simple.

Cada vez que publique un artículo en su sitio, asegúrese de que incluya algunos enlaces a recursos relevantes y confiables.

Como demostró el experimento de Reboot. Servirá a sus lectores Y a sus clasificaciones.

10. Sorprendente descubrimiento de que los enlaces Nofollow en realidad aumentan su clasificación

Se realizó otro experimento del IMEC Lab para responder:

¿Los enlaces no seguidos tienen algún impacto directo en las clasificaciones?

Dado que el propósito de usar un enlace de "no seguir" es evitar que se pase la autoridad, esperaría que los enlaces de no seguir no tengan ningún valor de SEO (directo).

Este experimento resulta diferente.

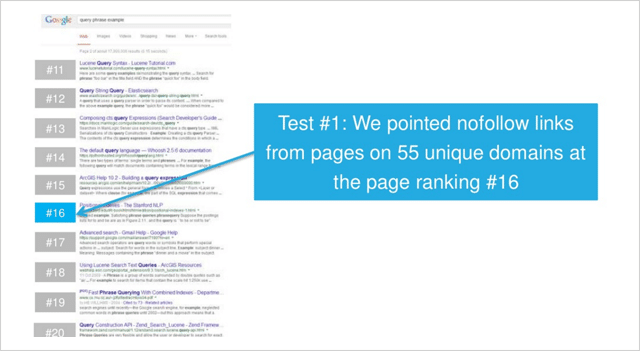

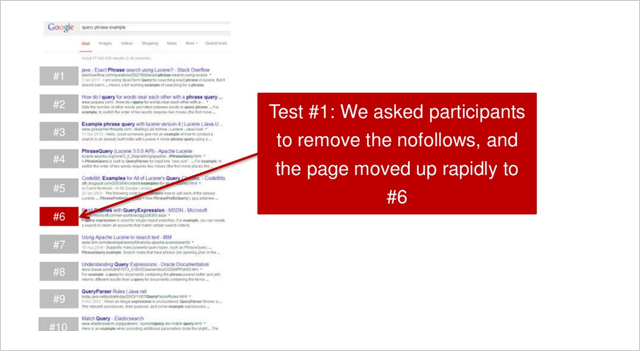

En la primera de las dos pruebas, los participantes de IMEC Lab señalaron enlaces de páginas en 55 dominios únicos en una página clasificada en el puesto 16.

Después de que se indexaron todos los enlaces sin seguimiento, la página se movió ligeramente hacia arriba para la consulta de bajo volumen de búsqueda competitivo que se estaba midiendo.

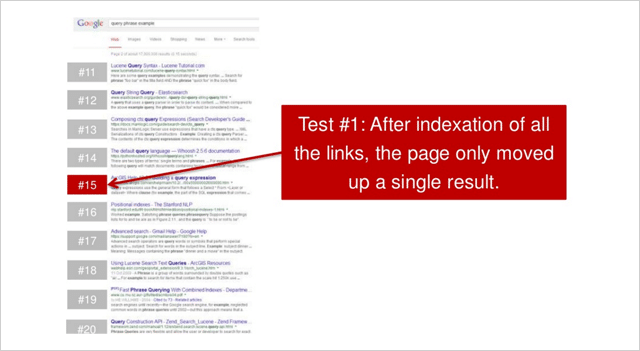

Luego se les pidió a los participantes que eliminaran los enlaces de no seguimiento que resultaron en esto:

La página subió rápidamente a la posición número 6.

Un aumento acumulativo de 10 posiciones, solo de algunos enlaces no-follow.

Nada mal.

¿Se podría repetir esto?

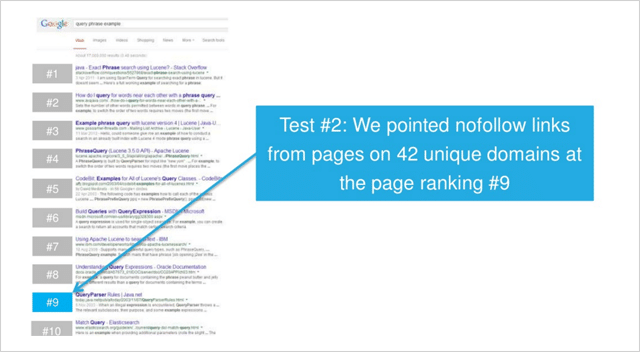

En una segunda prueba, esta vez para una consulta de baja competencia, se agregaron enlaces sin seguimiento a páginas en 42 dominios únicos.

( Nota : todos los enlaces estaban en los enlaces de texto de la página. No se usaron enlaces de encabezado, pie de página, barra lateral, widget (o similares) en ninguna de las pruebas).

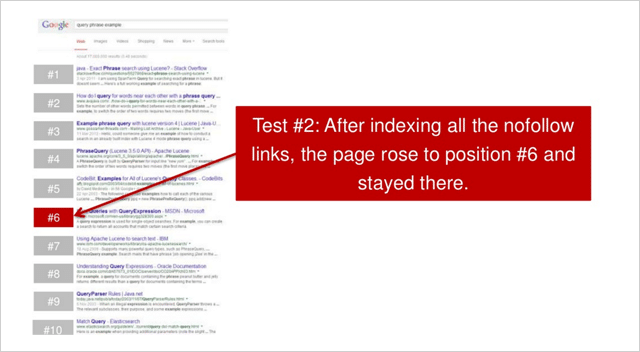

Después de que todos los enlaces se indexaron, la página subió a la posición número 6.

Un aumento de 3 posiciones.

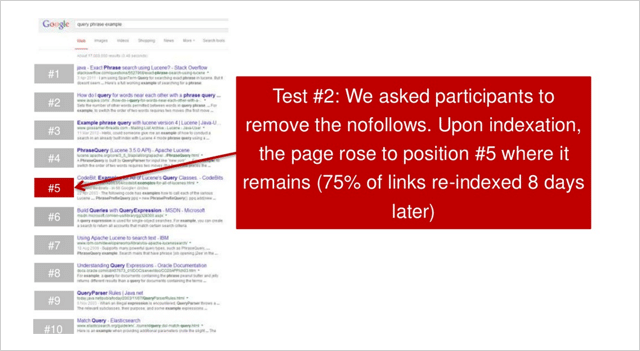

Luego se les pidió a los participantes que eliminaran todos los enlaces de no seguimiento. El sitio web luego subió una posición al número 5.

En ambas pruebas; cuando se adquirieron enlaces no-follow, los sitios web mejoraron significativamente su clasificación

El primer sitio web aumentó 10 posiciones.

El segundo sitio web aumentó 4 posiciones.

Entonces, ¿otra teoría de SEO desacreditada?

Rand Fishkin señala que la prueba debe repetirse varias veces más para que sea concluyente.

"Mi conclusion. La prueba debe repetirse al menos 2 o 3 veces más, pero los primeros datos sugieren que parece haber una relación entre los aumentos de clasificación y los enlaces dentro del contenido, sin seguimiento”, dice Rand.

Bueno, independientemente, como señala Nicole Kohler, ciertamente hay un caso para los enlaces sin seguimiento.

Los enlaces engendran enlaces.

Y (según este estudio) sin seguimiento o seguimiento completo. Ambos son valiosos para usted.

11. Realidad: los enlaces de páginas web con miles de enlaces funcionan

Existe la creencia en SEO de que los enlaces de páginas web con muchos enlaces salientes no valen mucho la pena.

La teoría aquí es que con muchos enlaces salientes, el 'jugo de enlace', también conocido como PageRank de la página web de enlace, se dispersa tan poco que el valor de un enlace a su sitio no puede ascender a mucho.

Cuantos más enlaces salientes tenga el sitio web, menos valor pasará a su sitio.

Esta teoría se ve reforzada por la noción de que los directorios y otros sitios de menor calidad que tienen muchos enlaces salientes no deberían proporcionar un beneficio de clasificación significativo a los sitios a los que se vinculan. A su vez, los enlaces de páginas web con pocos enlaces salientes son más valiosos.

Esto es exactamente lo que Dan Petrovic puso a prueba en su PageRank Split Experiment.

La prueba dividida de PageRank

En su experimento, Dan estableció 2 dominios (A y B).

Ambos dominios eran .com y ambos tenían características similares y contenido similar pero único.

La única diferencia real fue que durante la prueba se vinculó al sitio web B desde un sitio que está vinculado desde una subpágina en http://www.debian.org (PR 7) que tiene 4.225 enlaces externos seguidos.

El objetivo de la prueba era simplemente ver si se pasa algún grado de PageRank cuando existen tantos enlaces salientes, y qué efecto (si lo hay) tiene eso en la clasificación de los sitios web a los que enlaza.

Si la creencia de la mayoría de los SEO es válida, no debería haber sucedido mucho.

Esto es lo que sucedió...

Inmediatamente después de que se vinculara el sitio web B desde PR 7 debian.org (a través del sitio web del puente), el sitio web B se disparó en las clasificaciones , alcanzando finalmente la posición 2.

Y, según la actualización más reciente de Dan (3 meses después de la prueba), el sitio web B mantuvo su posición, solo superado por una página de PageRank 4 significativamente más autoritaria.

El sitio web A (al que no se había vinculado) permaneció en una posición estable durante un tiempo, luego cayó en la clasificación.

Así que parece que los enlaces de páginas que tienen muchos enlaces salientes son de hecho extremadamente valiosos .

¿Qué mito puede disipar nuestra lista de experimentos de SEO a continuación...

12. Los enlaces de imágenes funcionan (realmente) bien

Al igual que muchos de los experimentos de SEO en esta lista, este se produjo porque un tipo tuvo una corazonada.

La idea de Dan Petrovic fue que el texto que rodea un enlace juega un papel semántico en el algoritmo de búsqueda de Google.

Pero, Dan nunca pudo determinar el grado de su influencia o si tiene algún impacto .

Así que preparó esta prueba para averiguarlo...

Experimento de proximidad de texto ancla

El experimento fue diseñado para probar el impacto de varios tipos de enlaces (y su contexto) en las clasificaciones de búsqueda.

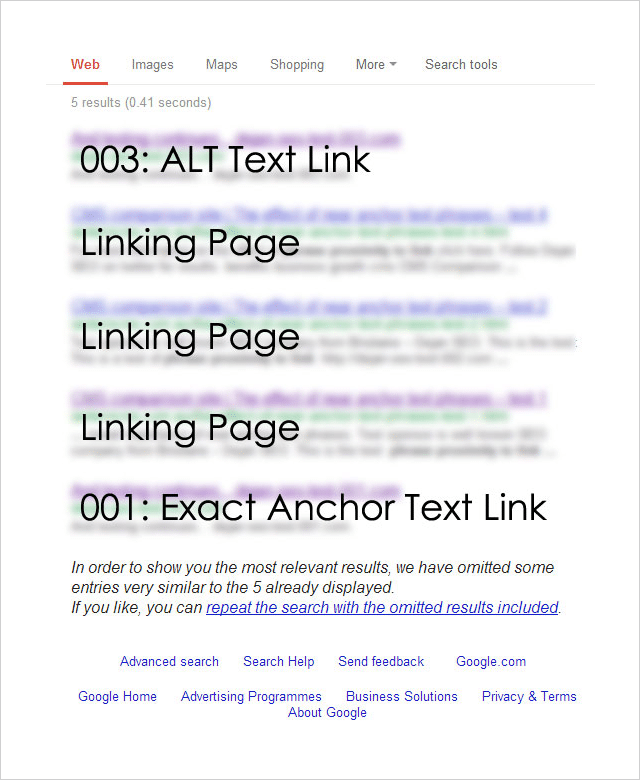

Para realizar la prueba, Dan registró 4 nombres de dominio casi idénticos :

http://********001.com.au

http://********002.com.au

http://********003.com.au

http://********004.com.au

Each of the 4 domains was then linked to from a separate page on a well-established website. Each page targeted the same exact phrase but had a different link type pointing to it:

001: [exact phrase]

Used the exact target keyword phrase in the anchor text of the link.

002: Surrounding text followed by the [exact phrase]: http://********002.com.au

Exact target keyword phrase inside a relevant sentence immediately followed by a raw http:// link to the target page.

003: Image link with an ALT as [exact phrase]

An image linking to the target page that used the exact target keyword phrase as the ALT text for the image.

004: Some surrounding text with [exact phrase] near the link which says click here .

This variation used the junk anchor text link “click here” and the exact target keyword phrase near to the link.

So which link type had the greatest effect on rankings?

Here are the results:

Unsurprisingly, the exact match anchor text link worked well.

But most surprisingly, the ALT text-based image link worked best .

And, what about the other two link types?

The junk link (“click here”) and the raw link (“http//”) results did not show up at all.

The Anchor Text Lessons You Can Take Away From This

This is just one isolated experiment, but it's obvious that image links work really well.

Consider creating SEO-optimized image assets that you can utilize to generate backlinks.

The team at Ahrefs put together a useful post about image asset link building here.

But don't leave it at that, best results will come from a varied and natural backlink profile.

Check out this post from Brian Dean which provides 17 untapped backlink sources for you to try.

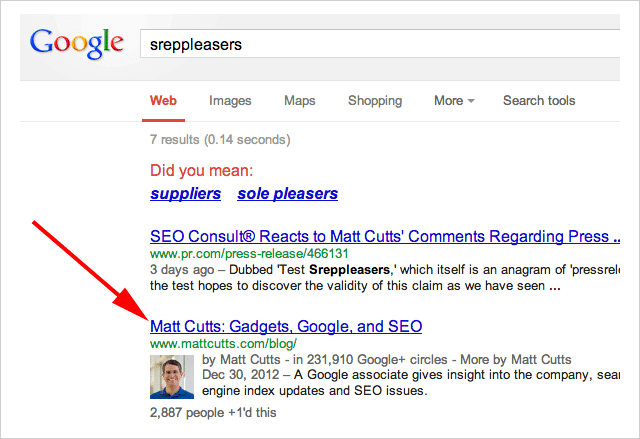

13. Press Release Links Work. Matt Cutts Take Note

Towards the end of 2014, Google's head of webspam publicly denounced press release links as holding no SEO value.

“Note: I wouldn't expect links from press release web sites to benefit your rankings” – Said Matt Cutts.

In an ironic (and brilliant) move, SEO Consult put Cutt's claim to the test this by issuing a press release which linked to, of all places….

Matt Cutts blog:

The anchor text used in the was the term “Sreppleasers”

The term is not present anywhere on Cutts's website.

Yet still, when you search “Sreppleasers” guess who's website comes up top?

There has been a lot of discussion about whether Press Release links work.

Is the jury still out on this?

I'll let you decide.

14. First Link Bias. Proven

First, let me say this…

This experiment is a few years old so things may now have changed. However, the results are so interesting it's very worthy of inclusion.

The theory for this experiment began with a post by Rand Fishkin which claimed that Google only counts one link to a URL from any given page.

Shortly after that post was published Rand's claims were debunked by David Eaves.

The opinion was rife in the SEO world as to whether either experiment was sound.

So, SEO Scientist set out to solve the argument once and for all.

The Test

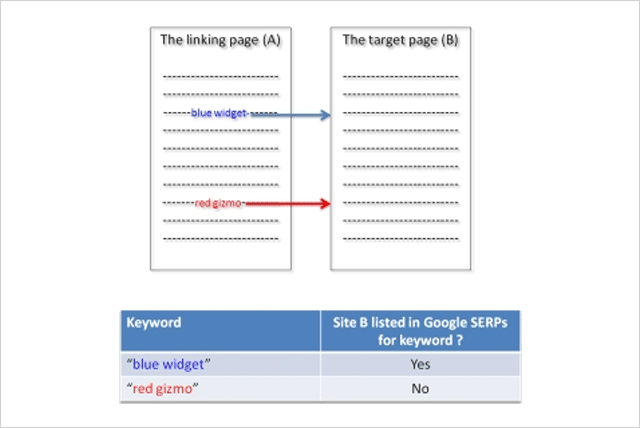

The hypothesis goes something like this…

If a website is linked to twice (or more) from the same page, only the first link will affect rankings.

In order to conduct the test SEO Scientist set up two websites (A and B).

Website A links to website B with two links using different anchor texts.

Test Variation 1

The websites were set up, then after the links got indexed by Google, the rankings of site B were checked for the two phrases.

Result : Site B ranked for the first phrase and not for the second phrase.

Here is what the results looked like:

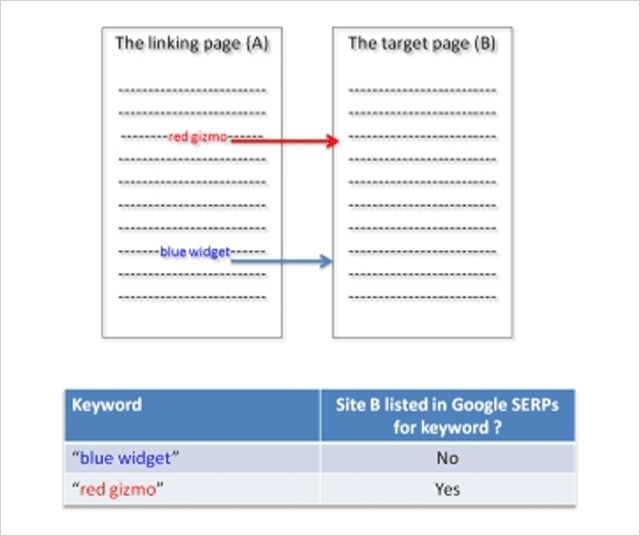

Test Variation 2

Next, the position of links to site B was switched. Now the second phrase appears above the previously first phrase on site A and visa versa.

Once Google had indexed the change, rankings were again checked for website B.

Result : Site B disappeared from the SERPs for the new second phrase (previously first) and appears for the new first phrase (previously second).

Rankings switched when the order of the links switched!

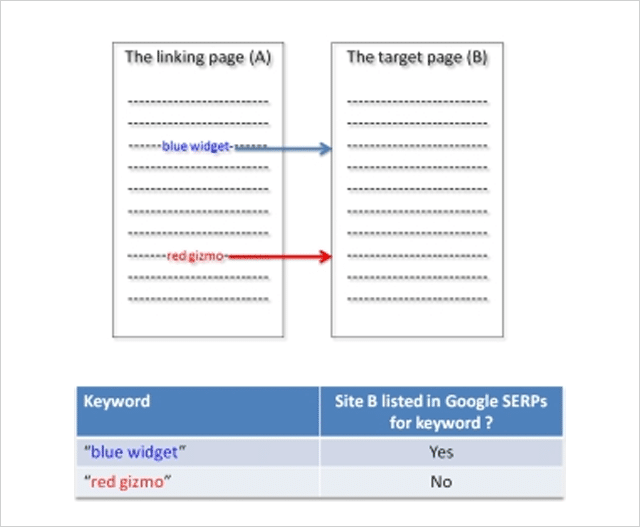

Test Variation 3

To check this was not some anomaly, in the third test variation the sites were reverted back to their original state.

Once the sites were re-indexed by Google, the rankings of website B were checked again.

Result : Site B reappeared for the initially first phrase and disappeared again for the initially second phrase:

The test proved that Google only counts the first link.

But, it gets even more interesting.

In a follow-up experiment, SEO Scientist made the first link “no follow” and still the second link was not counted!

The lesson from this experiment is clear.

If you are “self-creating” links ensure that your first link is to your most important target page.

15. The Surprising Influence of Anchor Text on Page Titles

Optimizing your Title tags has always been considered an important SEO activity and rightly so.

Numerous SEO studies have identified the title tag as a genuine ranking factor.

Since it's also what normally gets shown in the search results when Google lists your website, spending time on crafting well-optimized title tags is a good use of your time.

But, what if you don't bother?

A few years ago Dejan SEO set out to test what factors Google considers when creating a document title when a title tag is not present.

They tested several factors including domain name, the header tag, and URLs – all of which did influence the document title shown in search results.

What about anchor text? Could that influence the title shown?

In this video Matt Cutts suggested it could:

But, wanting some real evidenc e Dan Petrovic put it to the test in this follow-up experiment.

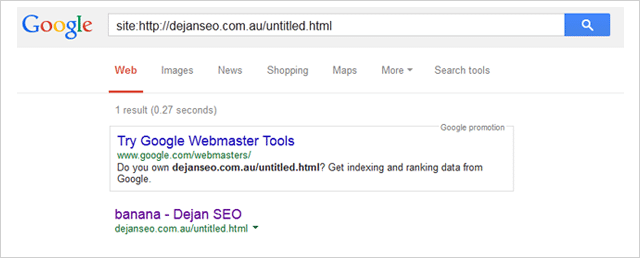

His experiment involved several participants linking to a page on his website using the anchor text “banana”.

The page being linked to had the non-informative title “Untitled Document”.

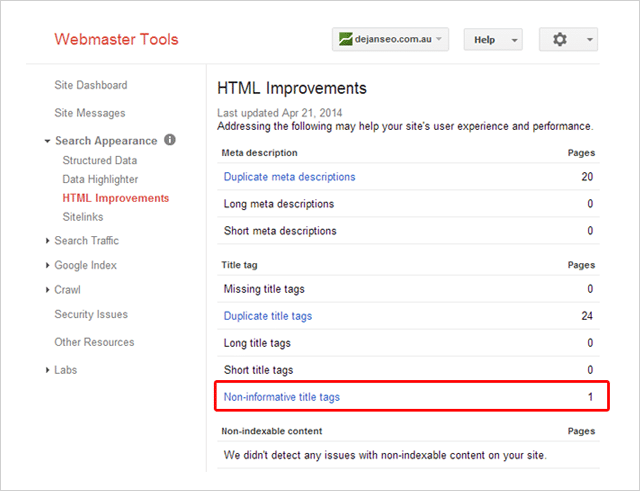

Here it is listed inside Dan's Search Console account:

Durante la prueba, Dan supervisó tres consultas de búsqueda:

- http://goo.gl/8uPrz0

- http://goo.gl/UzBOQh

- http://goo.gl/yW2iGi

Y aquí está el resultado:

El título del documento apareció milagrosamente como "banana".

La prueba demuestra que el texto de anclaje puede influir en el título del documento que muestra Google en los resultados de búsqueda.

¿Eso significa que no debe escribir etiquetas de título únicas y convincentes para cada página de su sitio?

sugiero que no

Como señala Brian Dean, la etiqueta de título de su página puede no ser tan importante como solía ser, pero aún cuenta.

16. SEO negativo: cómo puede (pero no debe) dañar las clasificaciones de sus competidores

No hay cuestionamiento, el SEO negativo es posible.

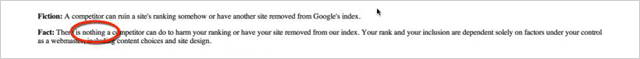

En 2003, Google cambió su postura de decir que no hay nada que un competidor pueda hacer para dañar su clasificación:

A decir que no hay casi nada que puedan hacer:

![]()

En lo que respecta a Google, un pequeño cambio como este es un gran problema.

Entonces surge la pregunta…

¿Qué tan fácil es afectar la clasificación de un sitio (negativamente)?

Tasty Placement realizó un experimento para determinar precisamente eso.

Los experimentos negativos de SEO

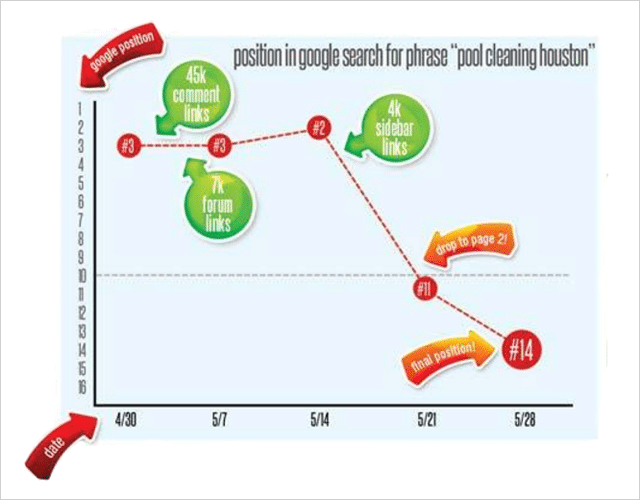

En un intento de dañar las clasificaciones de búsqueda, Tasty Placement compró una gran cantidad de enlaces de spam que apuntaban a su sitio web objetivo Pool-Cleaning-Houston.com.

El sitio estaba relativamente establecido y, antes del experimento, se clasificó bien para varios términos de palabras clave, incluidos "limpieza de piscinas houston" y otros términos similares.

Se realizó un seguimiento de un total de 52 posiciones de palabras clave durante el experimento.

El enlace no deseado

Compraron una variedad de enlaces basura para el experimento a un costo muy bajo:

45.000 enlaces de comentarios. Texto ancla "Limpieza de piscinas de Houston". Costo: $15

7000 enlaces de perfil de foro de dos niveles. Texto ancla "Limpieza de piscinas de Houston". Costo: $ 5

Enlaces de blog en la barra lateral en cuatro blogs de mala calidad, que arrojan casi 4000 enlaces. Texto ancla "Limpieza de piscinas de Houston". Costo: $20

¿Coste total?

La friolera de 40 dólares.

En el transcurso de 2 semanas, los enlaces basura baratos apuntaron a Pool-Cleaning-Houston.com

Primero los enlaces de comentarios, luego los enlaces de perfil del foro y finalmente los enlaces de la barra lateral.

Esto es lo que sucedió con las clasificaciones de "limpieza de piscinas en houston"

El lote de enlaces de comentarios no tuvo ningún efecto.

7 días después se colocaron los enlaces de las publicaciones del foro, lo que fue seguido por un aumento sorprendente en la clasificación del sitio de la posición 3 a la posición 2. No era lo que se esperaba en absoluto.

Otros 7 días después de eso, se agregaron los enlaces de la barra lateral.

El resultado…

¡Kabum!

Una caída en picado casi instantánea en la clasificación.

Aparte de la palabra clave principal, otras 26 palabras clave también bajaron notablemente .

Así que parece que es bastante fácil (y barato) destruir las clasificaciones de un competidor si así lo deseas, ¡lo cual sé que no es así!

Si bien el experimento de Tasty Placement deja algunas preguntas sobre la verdadera causa de la caída en el ranking (quizás, ¿texto de anclaje repetitivo o enlaces de un vecindario malo?), deja en claro que el SEO negativo es real.

Y, muy fácil de hacer.

17. ¿Google escribe mejores descripciones que tú?

Si ha estado en SEO durante algún tiempo, probablemente haya escrito cientos, si no miles, de meta descripciones.

Pero, estás bien con eso.

Esas incontables horas de escribir metadescripciones son tiempo bien invertido.

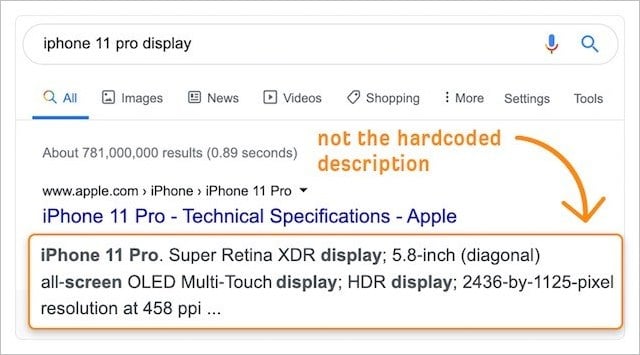

Con la creciente importancia de la tasa de clics en las clasificaciones (consulte el experimento número 2), cualquier mejora realizada en los fragmentos SERP de su sitio web a través de descripciones personalizadas (codificadas) seguramente mejorará los resultados.

Después de todo, conocemos mejor nuestro negocio y nuestra audiencia.

Lo que significa que nuestras descripciones tienen que superar las versiones generadas automáticamente de Google, ¿verdad?

Lamentablemente no.

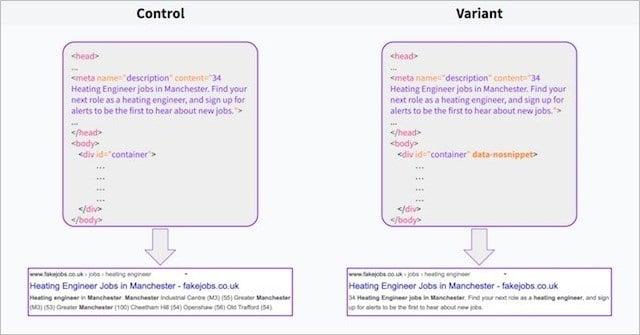

En un experimento reciente , el equipo de Search Pilot descubrió que (al menos en su caso) las descripciones generadas automáticamente por Google superaron a las metadescripciones personalizadas en un factor del 3 % .

Usando el atributo data-no snippet en el elemento del cuerpo de la mitad de sus páginas, Search Pilot pudo dividir las descripciones generadas por Google (el control) contra sus propias descripciones personalizadas (la variante).

Muy pronto después de que comenzara la prueba, los clics tendieron a la baja y, en dos semanas, ¡la prueba alcanzó la significación estadística para un resultado negativo!

En resumen, las descripciones de Google funcionaron mejor.

¿Qué puedes sacar de esto?

Google tiene acceso a una gran cantidad de datos de usuario.

Esta ventaja de datos ayuda a Google a saber qué buscan los usuarios y a crear descripciones que son más relevantes para los usuarios que las que podríamos escribir nosotros mismos, incluso si las propias descripciones de Google se raspan y, a menudo, se leen como basura.

Esto se ve reforzado por estudios que han demostrado que Google ignora la etiqueta de meta descripción en el 63 % de las consultas.

Podemos suponer que Google hace esto cuando la meta descripción creada por el propietario del sitio web no es del todo relevante para la consulta del usuario, y Google cree que puede hacer un mejor trabajo.

El estudio de Search Pilot indica que sí.

¿Significa eso que deberías acabar con la escritura de metadescripciones y dejarlo todo en manos de Google?

No completamente.

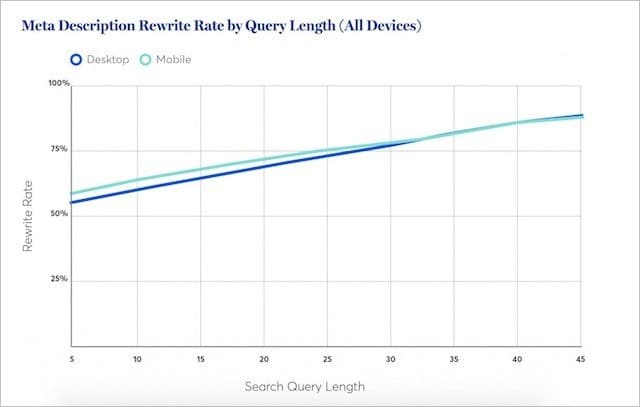

La investigación de Portent sugiere que Google reescribe menos meta descripciones para palabras clave cortas (normalmente de gran volumen).

De hecho, para las consultas más cortas, Google comprará la meta descripción real al menos la mitad del tiempo.

Esto indica que en alrededor del 50% de las búsquedas, tu meta descripción será la mejor.

Mi consejo:

Continúe escribiendo meta descripciones personalizadas para su contenido más importante.

Pero elimine las meta descripciones donde el potencial de tráfico para su contenido es menor.

Google hará un trabajo decente al crear descripciones relevantes, que están estadísticamente probadas para superar las suyas.

18. Experimento de texto oculto

Google ha dicho repetidamente que siempre que tenga el texto que desea clasificar en su página web;

Será "totalmente considerado para la clasificación".

En otras palabras, puede mostrar texto dentro de acordeones, pestañas y otros elementos expandibles, y Google considerará ese texto con el mismo peso que el texto que es completamente visible en la carga de la página.

Esta línea oficial de Google ha brindado un compromiso feliz para los SEO y los desarrolladores web que desean lograr el equilibrio entre el contenido rico en texto y el atractivo visual elegante.

¿Tienes un pasaje largo de texto?

Simplemente colóquelo dentro de un bloque de contenido expandible, y será perfectamente bueno para SEO.

O, al menos, eso es lo que Google nos hizo creer.

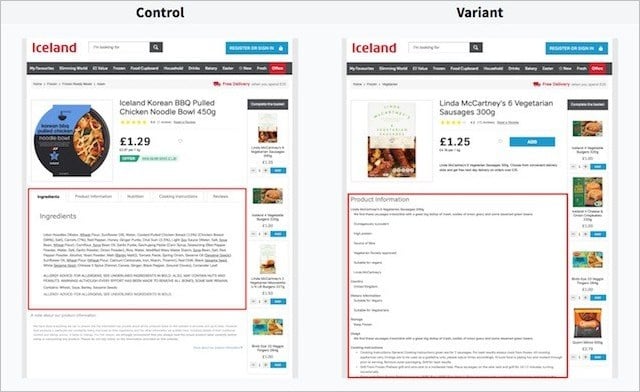

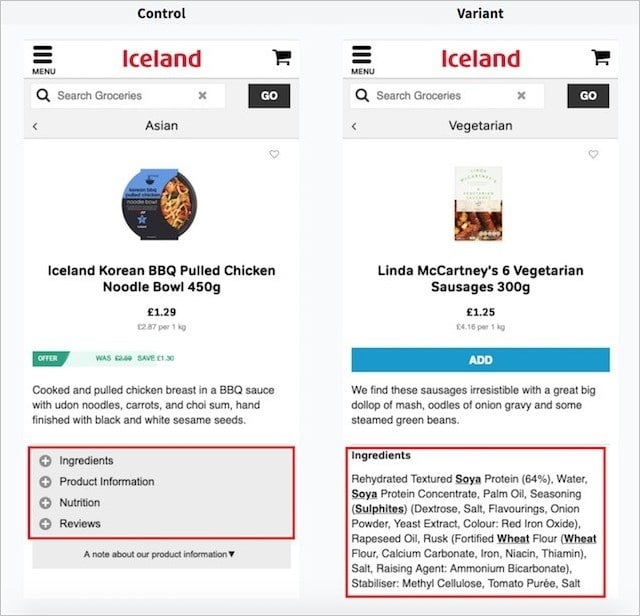

Ingrese a Search Pilot y su experimento de texto oculto.

En su experimento, Search Pilot buscó probar el rendimiento del texto dentro de las pestañas (el control), en comparación con el texto que es completamente visible al cargar la página (la variante).

Estas son las versiones de la página en el escritorio:

Y aquí están las versiones de la página en dispositivos móviles;

Hicieron pruebas divididas de estas dos versiones en muchas páginas de productos del sitio web de su cliente y midieron el cambio en el tráfico orgánico a lo largo del tiempo.

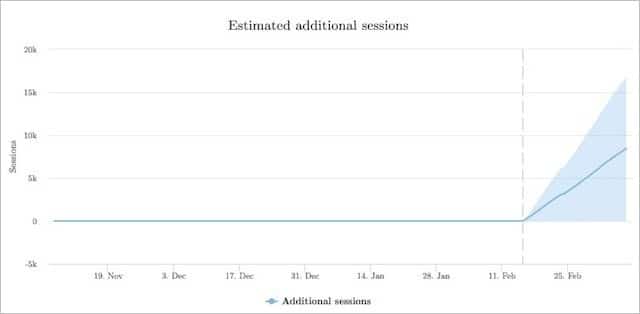

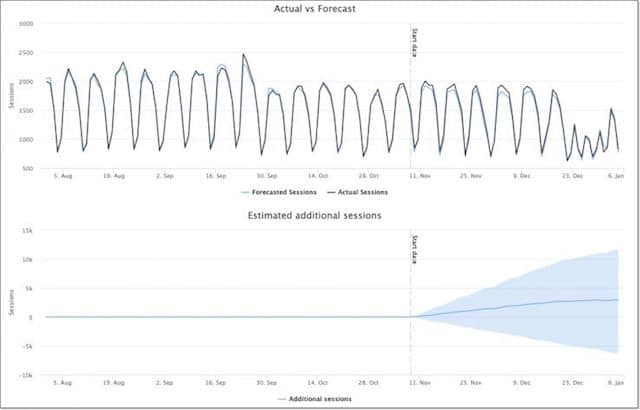

Así es como se comportó la variante (texto visible) contra el control (el texto está oculto):

La versión con texto totalmente visible obtuvo un 12 % más de sesiones orgánicas que las versiones con texto oculto en pestañas.

Parece bastante claro a partir de la prueba de Search Pilot, tener su contenido visible en la página puede ser mucho mejor para su tráfico orgánico.

Search Pilot no fue la única parte en probar la hipótesis de que se le da más peso al texto que es visible para el usuario en lugar del texto que está fuera de la vista inmediata del usuario.

Otro experimento de Reboot descubrió que el texto totalmente visible (y el contenido dentro de un área de texto) superó significativamente al texto oculto detrás de JavaScript y CSS:

19. Poniendo a prueba la velocidad de la página (los resultados pueden sorprenderte)

Probablemente haya escuchado que la velocidad de la página es un factor de clasificación importante.

Hay literalmente miles de blogs que le dicen que cuanto más rápida sea su página, más probable es que se clasifique más alto.

Y lo que es más:

No hace mucho tiempo, Google lanzó una "actualización de velocidad" que pretendía que los sitios web de rango inferior se cargaran lentamente en los dispositivos móviles.

Con toda la información disponible sobre los tiempos de carga de la página que son importantes para las clasificaciones más altas, ¡seguramente el rendimiento de la velocidad de la página es una señal de clasificación de peso pesado!

Bien, veamos.

Es exactamente lo que Brain Dean puso a prueba en su experimento de velocidad de página :

¿Te sorprendieron los resultados?

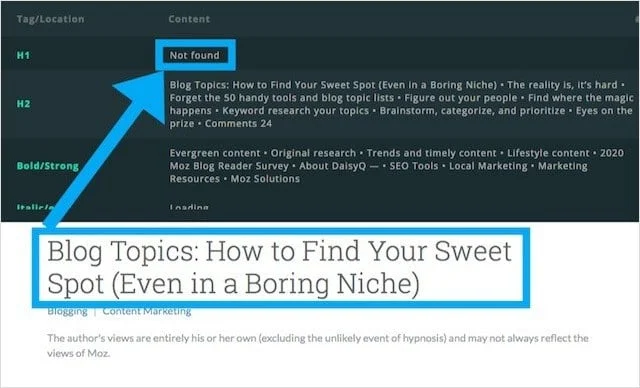

20. Etiquetas H1 y su impacto en las clasificaciones: el debate está cerrado

Todas las guías de SEO ofrecen el mismo consejo:

(Envuelva el título de su página o publicación en una etiqueta H1)

Pero, no todos los sitios web siguen estas llamadas mejores prácticas, siendo Moz.com uno de ellos.

Seamos sinceros:

Moz es uno de los sitios web más confiables (y con mucho tráfico) sobre el tema de SEO.

Aun así:

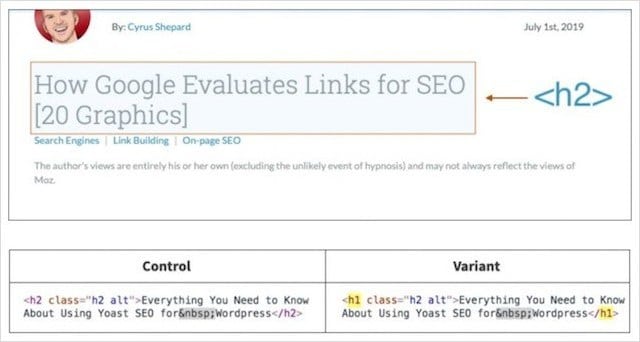

El blog de Moz no tiene una etiqueta H1 y, en su lugar, usa una etiqueta H2 para su título principal.

Después de notar que el blog de Moz usaba etiquetas H2 para los titulares (en lugar de H1), Craig Bradford de Distilled contactó a Cyrus Shepard en Moz.

Juntos, Craig y Cyrus decidieron realizar un experimento de etiquetas de encabezado que, con suerte, determinaría de una vez por todas si las etiquetas H1 afectan las clasificaciones orgánicas.

Para hacer eso, idearon una prueba dividida 50/50 de los titulares del blog de Moz usando SearchPilot.

En el experimento, la mitad de los titulares de Moz se cambiaron a H1 y la otra mitad se mantuvo como H2.

Cyrus y Crag luego midieron la diferencia en el tráfico orgánico entre los dos grupos.

Resultados del experimento de etiqueta de encabezado

Entonces, ¿qué cree que sucedió cuando los títulos principales se cambiaron de la etiqueta de encabezado incorrecta (H2) al encabezado correcto (H1)?

La respuesta:

¡No mucho en absoluto!

Después de ocho semanas de recopilación de datos, determinaron que cambiar los titulares de las publicaciones de blog de H2 a H1 no generaba una diferencia estadísticamente significativa.

¿Qué podemos deducir de esto?

Simplemente que Google es igualmente capaz de determinar el contexto de la página si su título principal está envuelto en un H1 o un H2.

¿Eso significa que debe abandonar todas las guías de mejores prácticas de SEO y eliminar los H1?

¡No!

El uso de un H1 como encabezado principal proporciona la estructura de contenido adecuada para las herramientas de lectura de pantalla, lo que ayuda a los lectores con discapacidades visuales a navegar mejor por su contenido.

Explico este y otros cuatro beneficios menos conocidos en mi guía completa sobre etiquetas de encabezado.

Por ahora, pasemos a nuestro último experimento de SEO.

21. Experimento de alojamiento compartido: prueba del efecto de "mal vecindario"

Los debates sobre el impacto del alojamiento de sitios web compartidos y su efecto en las clasificaciones se han desatado en la comunidad de SEO durante eones.

Estos debates no se centran simplemente en el aspecto de rendimiento del alojamiento compartido (p. ej., tiempos de carga lentos que generalmente se considera que tienen implicaciones negativas para el SEO), sino en un concepto denominado "vecindarios malos".

Malos vecindarios, describe un entorno de alojamiento con una IP común y una colección de sitios web de baja calidad, no relacionados, penalizados y/o potencialmente problemáticos (por ejemplo, pornografía, apuestas, píldoras).

De la misma manera, podría verse afectado negativamente si vincula o recibe enlaces de sitios web fraudulentos;

Muchos creían que encontrar su sitio web en el mismo servidor que sitios de baja calidad o no relacionados podría tener efectos aplastantes similares.

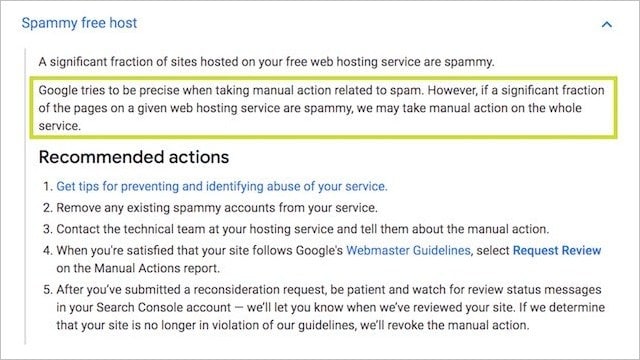

Esta idea tiene sustancia:

La propia documentación de acciones manuales de Google establece que todos los sitios web en un servidor podrían ser "penalizados" debido a la reputación de algunos:

También es probable que los algoritmos de Google busquen patrones entre los sitios de baja calidad, y el alojamiento compartido gratuito/económico es potencialmente uno de ellos .

Seamos realistas;

¿Es más probable que encuentre un sitio PBN desechable en una cuenta de alojamiento compartido barata de $ 10 dólares al mes o en un servidor dedicado premium de $ 200 o más?

Tú entiendes.

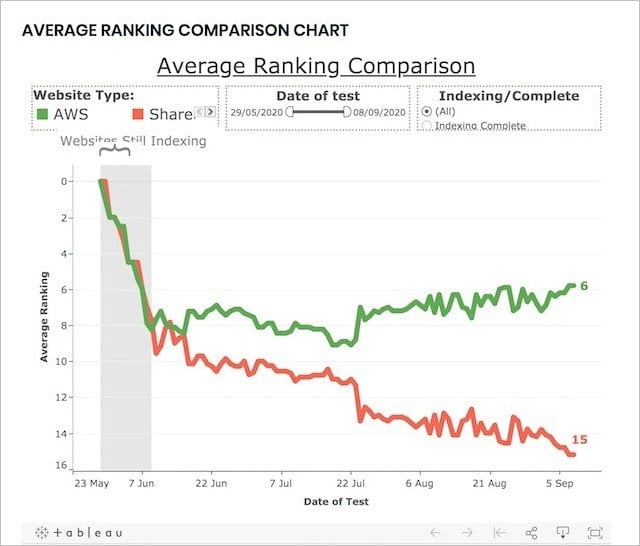

Para probar el rendimiento del alojamiento compartido (muchos sitios web en una IP) frente al alojamiento dedicado (IP única para un sitio web), Reboot realizó este experimento de SEO.

Experimento de alojamiento compartido a largo plazo:

Para realizar el experimento, Reboot Online creó 20 sitios web, todos en nuevos dominios .co.uk, y con contenido único pero optimizado de manera similar:

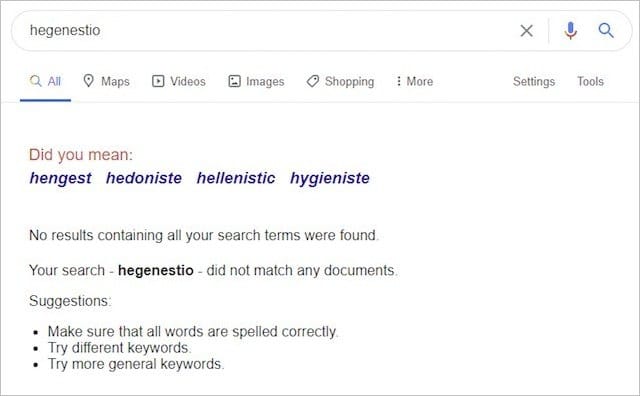

Los veinte sitios web apuntaron a la misma palabra clave ("hegenestio") que antes del experimento no tenía resultados en Google:

Luego colocaron diez sitios web en servidores de AWS dedicados y diez en servidores compartidos, algunos de los cuales contenían sitios maliciosos como este:

Y esto:

Y luego, después de indexar, los sitios web monitorearon sus clasificaciones durante un período de tres meses.

Para asegurarse de que el experimento no pudiera verse sesgado por otros factores, Reboot hizo lo siguiente:

- Se aseguró de que todos los dominios no tuvieran contenido anterior indexado por Google.

- Construí todos los sitios web con HTML estático pero CSS variable.

- Midió regularmente el tiempo de carga de cada sitio web para asegurarse de que no fuera un factor influyente.

- Usé StatusCake para verificar el tiempo de actividad de los sitios web diariamente.

- Le dio a cada sitio web un meta título básico y similar y ninguna meta descripción.

Estos pasos se implementaron para demostrar que la velocidad, la confiabilidad, la consistencia, el contenido, el código y el tiempo de actividad de los sitios web no afectaron las clasificaciones.

Bien, entonces, ¿qué pasó?

Al final del experimento, los resultados fueron claros y concluyentes:

Los sitios web en una dirección IP dedicada se clasificaron MUCHO mejor que aquellos en una IP compartida.

De hecho, al final del experimento, los diez primeros resultados para la palabra clave inventada contenían entre un 80 % y un 90 % de sitios web con direcciones IP dedicadas:

Los resultados de este experimento sugieren evidentemente que alojar su sitio web en un entorno de alojamiento compartido (que contiene sitios web tóxicos y de baja calidad) puede tener un efecto perjudicial en su rendimiento orgánico.

Dado que se eliminaron todas las demás señales de clasificación, por cuánto, en esta etapa no lo sabemos.

De lo que podemos estar seguros es que, de forma aislada, el alojamiento compartido es un factor negativo Y si se toma en serio su negocio, un servidor decente (dedicado) es el camino a seguir .

Conclusión

Estos 21 experimentos de SEO arrojaron algunos resultados inesperados.

Algunos incluso dieron la vuelta a lo que creíamos que era verdad sobre el SEO.

Simplemente demuestra que, con tan poco conocimiento sobre el funcionamiento interno del algoritmo de Google, es esencial que lo probemos.

Solo a través de las pruebas podemos estar seguros de que las estrategias de SEO que estamos implementando realmente darán resultados.

Terminamos esta publicación con una explicación de cómo se realizan las pruebas de SEO para que usted también pueda ejecutar experimentos de SEO y obtener resultados de prueba válidos (quizás incluso innovadores).

Un agradecimiento especial a Eric Enge por esta contribución:

“Invertimos una gran cantidad de energía en cada prueba que hacemos. Esto se debe en gran parte a que hacer un trabajo sólido de prueba requiere que elimine minuciosamente las variables de confusión y que se asegure de que el tamaño de los datos de su muestra sea suficiente.

Algunas de las cosas clave que tratamos de hacer son:

1. Obtenga una muestra de datos razonablemente grande.

2. Frote los parámetros de la prueba para eliminar los factores que invalidarán la prueba. Por ejemplo, si estamos tratando de probar si Google usa un método particular para indexar una página, entonces debemos hacer cosas como asegurarnos de que nada vincule a esa página y que no haya herramientas de Google a las que se haga referencia en el HTML de esa página. (por ejemplo, Google Analytics, AdSense, Google Plus, Google Tag Manager, …).

3. Una vez que tenga los resultados, debe dejar que los datos cuenten la historia. Cuando comenzó la prueba, probablemente esperaba un resultado determinado, pero debe estar preparado para descubrir que se equivocó.

En resumen, es mucho trabajo, pero para nosotros, ¡los resultados justifican el esfuerzo!”

Así que ahí lo tienes…

21 experimentos SEO y sus resultados inesperados. ¿Qué más crees que debería probarse?

¿Qué resultado del experimento de SEO te sorprendió más?

Cuéntamelo en los comentarios a continuación.