21 SEO-Experimente, die Ihre Denkweise über SEO verändern werden (für immer)

Veröffentlicht: 2020-11-10 Ich denke, Sie werden mir zustimmen, wenn ich sage:

Ich denke, Sie werden mir zustimmen, wenn ich sage:

Es gibt MEHR Missverständnisse rund um SEO…

… als fast jeder andere Aspekt des digitalen Marketings.

Und es ist kaum verwunderlich, wenn man bedenkt, dass es mehr als 200 Ranking-Faktoren gibt, aber fast alle in Geheimhaltung gehüllt sind.

Da Google das Innenleben seines Algorithmus nicht teilt (und dies wahrscheinlich auch nie tun wird), woher wissen Sie, was wirklich funktioniert?

Wie entschlüsseln Sie die SEO-Mythen von der Sache und das Hörensagen von der Tatsache?

Sie wenden sich der Wissenschaft zu, das ist was!

BONUS: Laden Sie jedes einzelne in diesem Beitrag enthaltene SEO-Experiment als praktische PDF-Anleitung herunter, die Sie ausdrucken oder auf Ihrem Computer speichern können.

In diesem Beitrag werde ich mit Ihnen 21 erstaunliche SEO-Experimente (aktualisiert für das Jahr 2021) teilen, die das in Frage stellen, was Sie über die Suchmaschinenoptimierung für wahr gehalten haben.

Ich würde sogar so weit gehen zu sagen, dass diese SEO-Studien die Art und Weise, wie Sie SEO betreiben, für immer verändern werden.

Sind Sie bereit? Denn für Sie ändert sich alles.

Okay, steigen wir ein:

1. Click-Through-Rate wirkt sich auf organische Rankings aus (und wie Sie das zu Ihrem Vorteil nutzen können)

Dieses erste Experiment ist ein Trottel.

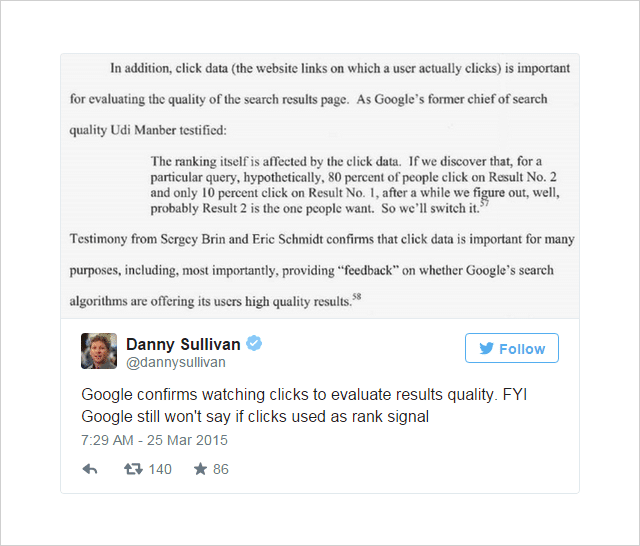

Seit einiger Zeit gibt es in der SEO-Welt die Meinung, dass die Click-Through-Rate (CTR) das Suchranking beeinflussen könnte.

Die Meinung wurde durch einige starke (wenn auch nicht schlüssige) Hinweise von Google befeuert:

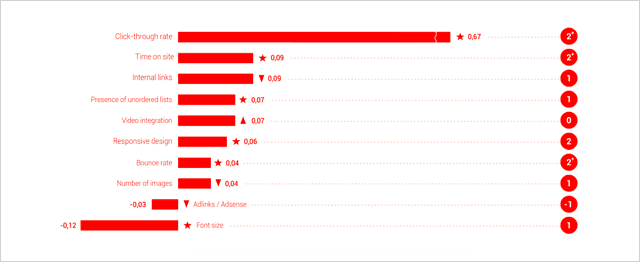

Und die Ranking-Faktoren-Studien von Searchmetrics haben CTR zunehmend als einen der wichtigsten Ranking-Faktoren erachtet.

(Basierend auf Korrelation, nicht Kausalität, Verstand)

Das Argument, wie Jamie Richards betont, ist, dass eine Website, die eine höhere Klickrate als Websites darüber erhält, sich selbst als relevanteres Ergebnis signalisieren und Google dazu bringen kann, sie in den SERPs nach oben zu verschieben.

Die hier von WordStream diskutierte Idee ähnelt dem Qualitätsfaktor, der Adwords-Anzeigen zugewiesen wird – ein Faktor, der teilweise durch die relative Klickrate einer Anzeige im Vergleich zu den anderen Anzeigen in der Umgebung bestimmt wird.

Dies war die Idee, die Rand Fishkin von Moz in aufeinanderfolgenden Experimenten testen wollte.

Nummer eins: Abfrage- und Klickvolumen-Experiment

Das von Rand Fishkin verwendete Testszenario war ziemlich einfach.

- Bringen Sie ein paar Leute dazu, bei Google nach einer bestimmten Suchanfrage zu suchen.

- Lassen Sie diese Personen auf ein bestimmtes Ergebnis klicken.

- Zeichnen Sie Änderungen im Ranking auf, um festzustellen, ob das erhöhte Klickvolumen auf dieses Ergebnis seine Position beeinflusst.

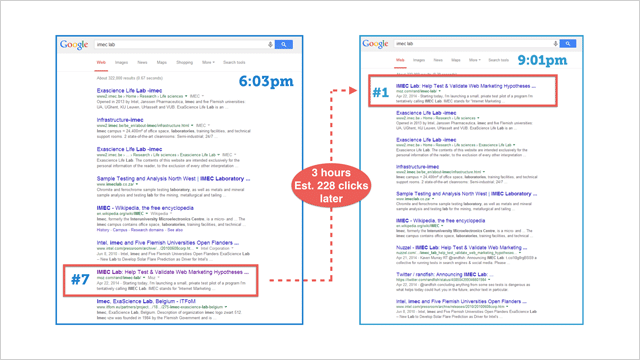

Um den Stein ins Rollen zu bringen, schickte Rand diesen Tweet an seine 264.000 Twitter-Follower:

Möchtest du mit einer Google-Theorie/einem Test helfen? Könnten Sie in Google nach „IMEC Lab“ suchen und auf den Link in meinem Blog klicken? Ich habe eine Ahnung.

– Rand Fishkin (@randfish) 1. Mai 2014

Basierend auf Google Analytics-Daten schätzt Rand, dass 175-250 Personen auf seinen Call-to-Action reagierten und auf das IMEC-Ergebnis klickten.

Folgendes ist passiert:

Die Seite schoss auf Platz 1 hoch.

Dies zeigt deutlich (zumindest in diesem speziellen Fall), dass die Klickrate das Ranking erheblich beeinflusst .

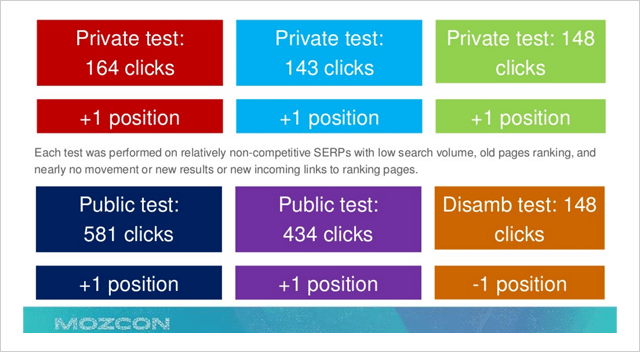

Um diese Daten zu validieren, folgte eine Reihe von Wiederholungstests, die einen allgemeinen Aufwärtstrend zeigten, wenn das Klickvolumen für ein bestimmtes Ergebnis erhöht wurde.

Leider waren die Daten diesmal weit weniger dramatisch und schlüssig.

Warum könnte das sein?

Rand befürchtete, dass Google als Reaktion auf seinen öffentlichen Beitrag, der zeigt, wie Klicks die Ergebnisse von Google direkter als bisher angenommen beeinflussen könnten, seine Kriterien um diesen bestimmten Faktor verschärft haben könnte.

Trotzdem ließ er sich nicht beirren …

Nummer zwei: Abfrage- und Klickvolumen-Experiment

Inspiriert von einer Flasche Sullivans Cove Whiskey während einer Pause in einem WM-Spiel, schickte Rand Fishkin einen weiteren Tweet:

Was sollten Sie während dieser Pause im WM-Spiel tun? Helfen Sie mir, einen Test durchzuführen! Dauert <30 Sekunden: http://t.co/PxXWNlVdTi

– Rand Fishkin (@randfish) 13. Juli 2014

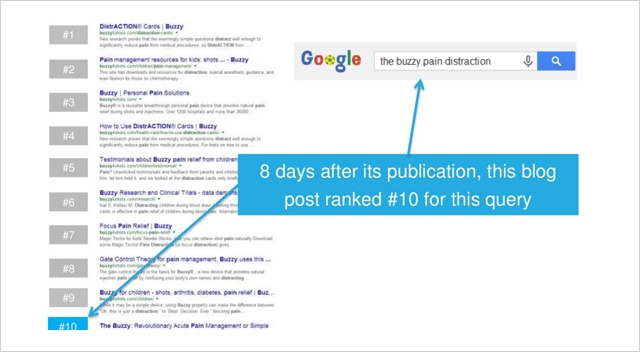

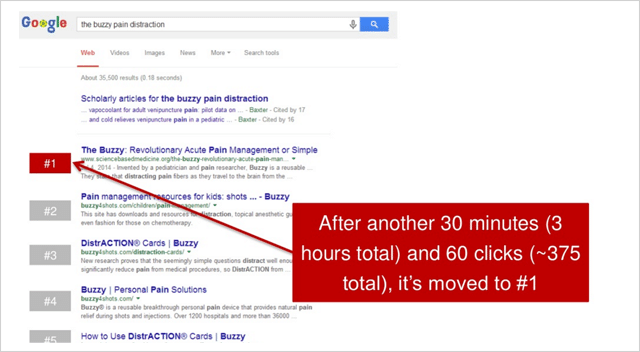

Der Tweet wies seine Follower auf einige grundlegende Anweisungen hin, in denen die Teilnehmer aufgefordert wurden, nach „die lebhafte Schmerzablenkung“ zu suchen und dann auf das Ergebnis für sciencebasedmedicine.org zu klicken.

Hier ist die Ziel-Website vor dem Start des Experiments erschienen:

In den nächsten 2,5 Stunden nach Rands erstem Tweet klickten insgesamt 375 Teilnehmer auf das Ergebnis.

Die Wirkung war dramatisch.

sciencebasedmedicine.org schoss von Platz zehn auf Platz eins bei Google nach oben.

Eureka!

Dieses wundersame Ereignis wiederum löste eine Kettenreaktion aus …

Was in diesem feierlichen Moment für Rand endete:

Es scheint also, dass das Klickvolumen (oder die relative Klickrate) das Suchranking beeinflusst. Während einige Leute wie Bartosz Goralewicz dagegen argumentieren, glaube ich, dass dies wahr ist.

Es gibt mehrere Gründe, warum Google die Klickrate als Ranking-Signal neben Mainstream-Signalen wie Inhalt und Links betrachtet.

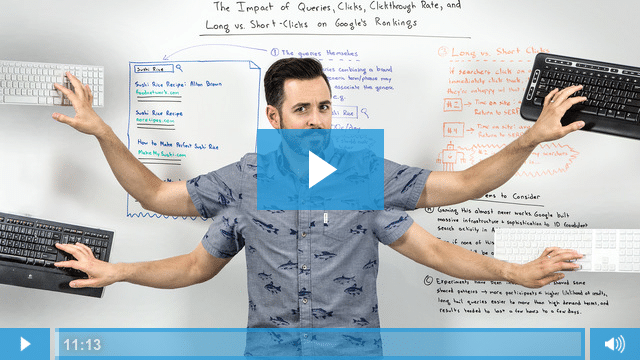

Dieses Whiteboard Friday-Video bietet eine hervorragende Erklärung dafür, warum:

Der Fall ist also überzeugend, die Klickrate wirkt sich sicherlich auf die Suchrankings von Google aus.

Eine spätere Studie von Larry Kim scheint darauf hinzudeuten, dass Sie im Rang aufsteigen, wenn Sie die erwartete Klickrate um 20 Prozent übertreffen.

Super, das ist alles schön und gut.

Aber wie nutzen Sie diese Informationen zu Ihrem Vorteil?

Hier sind 4 Handlungsschritte, die Ihnen genau das zeigen:

(1) Optimieren Sie Ihre Klickrate – Erstellen Sie dazu überzeugende Seitentitel und Meta-Beschreibungen für Ihre Seiten, die die Leute verkaufen, wenn sie auf Ihr Ergebnis über den darüber liegenden klicken.

(2) Bauen Sie Ihre Marke auf – Eine etablierte und erkennbare Marke wird mehr Klicks anziehen. Wenn Benutzer Ihre Marke kennen (und ihr hoffentlich auch gefallen und ihr vertrauen), werden Sie in den SERPs mehr Beachtung finden.

(3) Optimieren Sie für lange Klicks – Optimieren Sie nicht nur, um Klicks zu erhalten, sondern konzentrieren Sie sich darauf, Benutzer lange auf Ihrer Website zu halten. Wenn Sie mehr Klicks erhalten, diese Benutzer aber einfach zu den Ergebnissen zurückkehren, werden alle Vorteile, die Sie von einer höheren CTR erhalten haben, zunichte gemacht.

(4) Verwenden Sie echte Taktiken – Die Auswirkungen eines plötzlichen Anstiegs der CTR (genau wie bei Rands Experiment) werden nur kurze Zeit anhalten. Wenn die normalen Klickraten zurückkehren, wird dies auch Ihre vorherige Ranking-Position tun. Verwenden Sie die Punkte 1 und 2 für langanhaltende Ergebnisse.

2. Die Industrie hat es falsch verstanden. Mobilegeddon war riesig

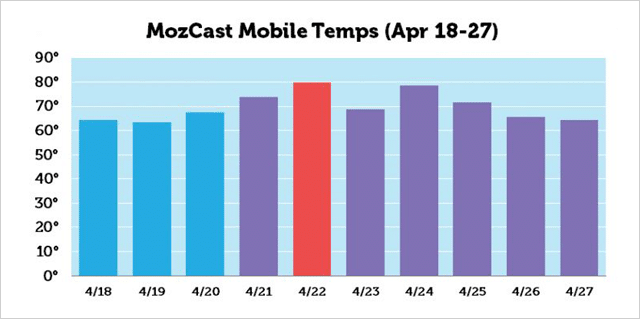

Mobilegeddon war der inoffizielle Name, der dem mobilfreundlichen Update von Google vor seiner Veröffentlichung am 21. April 2015 gegeben wurde.

Das Update sollte die Platzierungen in der mobilen Suche für Websites, die auf Mobilgeräten lesbar und nutzbar sind, in die Höhe schnellen lassen.

Es wurde erwartet, dass nicht für Mobilgeräte optimierte Websites versenkt werden.

Einige Leute sagten sogar, dass es ein katastrophales Ereignis sein würde, das größer wäre als Google Penguin und Panda.

Monate zuvor haben sich Webmaster bemüht, ihre Websites in Ordnung zu bringen. Als der Tag näher rückte, verwandelte sich das Gedränge in Panik, als Websitebesitzer feststellten, dass ihre Websites den Google-Test für Mobilgeräte nicht bestanden hatten.

Was ist also am 21. April 2015 passiert? Sind Millionen Websites in den Abgrund der mobilen Suche gestürzt?

Den meisten Berichten zufolge ist überhaupt nicht viel passiert.

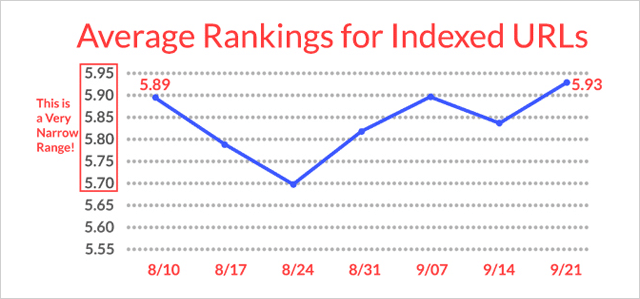

Sicher, laut MozCast gab es um den 22. April herum einen Höhepunkt der Aktivität, aber die Ranking-Änderungen waren bei weitem nicht so groß, wie die meisten SEOs dachten.

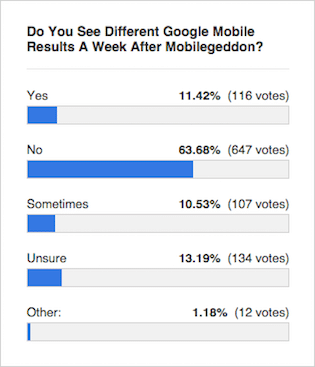

Der Konsens von Experten wie dieser Search Engine Roundtable-Umfrage war, dass die Ergebnisse ziemlich unverändert blieben:

Aber was haben die Testergebnisse gezeigt?

Aber was haben die Testergebnisse gezeigt?

Hier kommen Eric Enge und das Team von Stone Temple Consulting ins Spiel…

Mobilegeddon-Ranking-Studie

In der Woche vom 17. April 2015 (vor Mobilegeddon) zog Stone Temple Ranking-Daten zu den Top-10-Ergebnissen für 15.235 Suchanfragen. Sie zogen in der Woche vom 18. Mai 2015 (nach Mobilegeddon) erneut Daten zu denselben 15.235 Suchanfragen.

Sie zeichneten Ranking-Positionen auf und identifizierten auch, ob die URL-Slugs in den Ergebnissen von Google als mobilfreundlich gekennzeichnet wurden oder nicht.

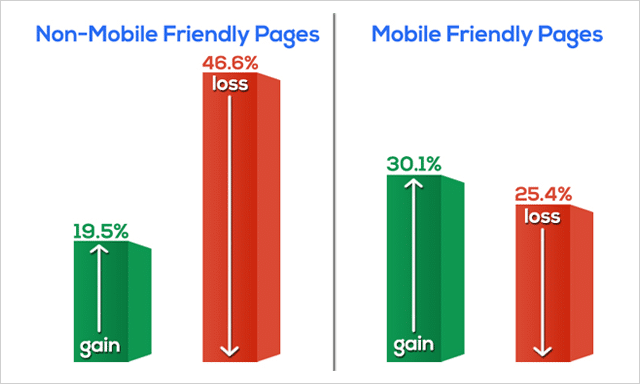

Das haben sie gefunden:

Die nicht für Mobilgeräte optimierten Webseiten verloren dramatisch an Rankings.

Tatsächlich sind fast 50 % aller nicht für Mobilgeräte optimierten Webseiten aus den SERPs verschwunden.

Die mobilfreundlichen Seiten (insgesamt) haben in ihrem Ranking zugelegt.

Die Daten, die Eric und das Team in ihrem Mobilegeddon-Test gesammelt haben, widersprechen eindeutig der allgemeinen Meinung der Fachpresse.

Warum hat die Presse das falsch verstanden?

Es ist wahrscheinlich, dass aufgrund der langsamen Einführung des Algorithmus-Updates im Laufe der Zeit nicht sofort offensichtlich war, dass solch signifikante Bewegungen stattfanden.

Außerdem wurde im selben Zeitraum ein Qualitätsupdate veröffentlicht, das möglicherweise die Auswirkungen von Mobilegeddon auf die Suchrankings getrübt hat.

Lassen Sie uns Mobilegeddon also schnell mit drei Punkten abschließen;

- Es war eine große Sache.

- Wenn Sie noch nicht „mobil geworden“ sind, worauf warten Sie noch?

- Wenn Sie sich nicht sicher sind, ob Ihre Website für Mobilgeräte geeignet ist oder nicht, machen Sie diesen Test.

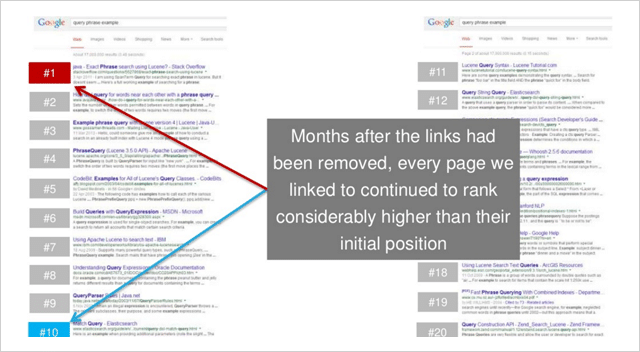

3. Link-Echos: Wie Backlinks funktionieren, auch nachdem sie entfernt wurden

Kredit wem Kredit gebührt.

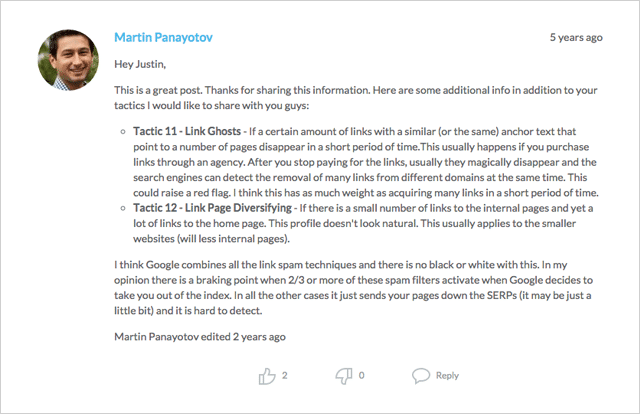

Die Idee der „Link-Echos“ (oder „Link-Geister“, wie sie auch genannt werden) wurde erstmals von Martin Panayotov und auch Mike King von iPullRank in den Kommentaren zu diesem Beitrag identifiziert.

Die Idee ist, dass Google weiterhin Links verfolgt und deren Wert (positiv oder negativ) berücksichtigt, auch nachdem die Links entfernt wurden.

Wenn dies der Fall ist, bleibt eine Website, die im Rang gestiegen ist, nachdem ein Link hinzugefügt wurde, weiterhin im Rang, nachdem der Link entfernt wurde?

Okay, lass uns nachsehen.

Dieses spezielle Experiment wurde vom Team von Moz durchgeführt und gehörte zu einer Reihe, die darauf abzielte, die Wirkung von Rich-Anchor-Text-Links (siehe SEO-Experiment Nr. 8) auf Suchrankings zu testen.

Doch wie so oft in der Wissenschaft brachten die Experimente völlig unerwartete Erkenntnisse.

Der Link-Echo-Effekt

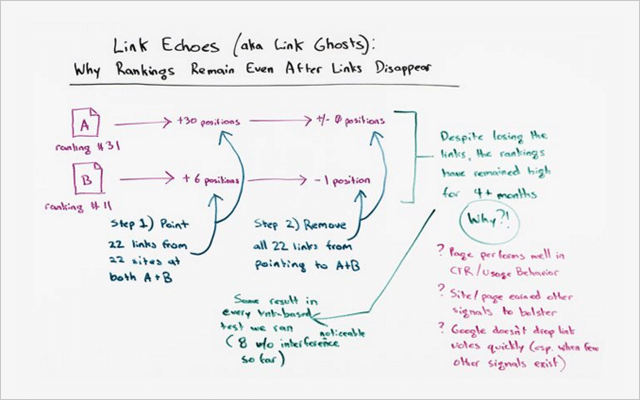

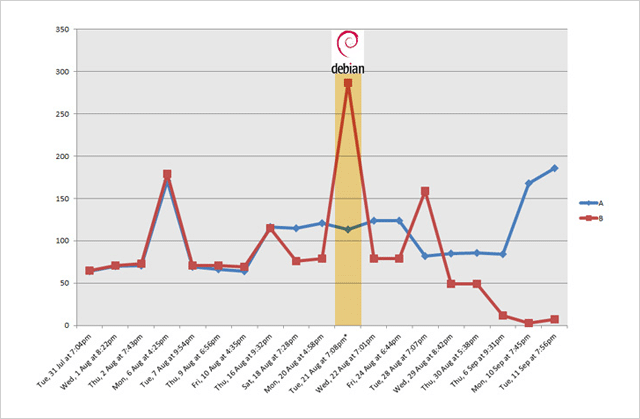

Es gab 2 Websites in diesem Experiment; Webseite A und Webseite B.

Vor dem Test haben sie für das gleiche (nicht sehr konkurrenzfähige) Keyword so gerankt:

- Website A – Position 31

- Website B – Position 11

Während des Tests wurden Links zu 22 Seiten auf verschiedenen Websites hinzugefügt, die sowohl auf Website A als auch auf Website B verweisen.

Beide Websites, die jeweils 22 Links erhielten, schossen in der Folge im Ranking nach oben:

- Website A rückte von Position 31 auf Position 1 vor (eine Steigerung um +30 Positionen)

- Website B wurde von Position 11 auf Position 5 verschoben (und Anstieg um +6 Positionen)

Kurz gesagt, beide Websites stiegen im Ranking erheblich, wenn Links hinzugefügt wurden.

Aber was geschah, als dieselben Links entfernt wurden?

Antworten. Überhaupt sehr wenig.

Website A blieb auf Platz 1.

Website B fiel leicht auf Position 6 zurück (ein kleiner Rückgang von nur 1 Position)

Dieses Experiment bestätigt die Hypothese.

Es scheint , dass ein gewisser Wert von Links (vielleicht viel) auch nach dem Entfernen der Links erhalten bleibt.

Könnte dieses Experiment ein Einzelfall gewesen sein?

Nicht laut Rand Fishkin:

„Dieser Effekt dieser Link-Tests, der noch lange nach dem Entfernen des Links bestehen blieb, trat bei jedem einzelnen von uns durchgeführten Link-Test auf, von denen ich acht zählte, bei denen ich sehr zuversichtlich bin, dass es keine verwirrenden Variablen gab, und fühle mich wirklich gut, dass wir folgte einem ähnlichen Prozess. Die Links zeigten, das Ranking stieg. Die Links verschwanden, das Ranking blieb hoch.“

Aber hier ist, was so bemerkenswert ist …

Diese höheren Platzierungen waren nicht von kurzer Dauer.

Sie blieben noch viele Monate, nachdem die Links entfernt wurden.

Zum Zeitpunkt dieses Videos waren die Ergebnisse 4,5 Monate lang gültig.

Außerdem…

„In keinem einzigen Test, als die Links entfernt wurden, fielen die Rankings auf ihre ursprüngliche Position zurück“, sagt Rand Fiskin.

Es gibt mehrere Lektionen, die Sie daraus lernen können, aber ich belasse es bei diesen beiden:

(1) Qualitätslinks sind Gold wert . Wie eine solide Investition werden Ihnen Backlinks weiterhin eine gute Rendite einbringen. Das „Echo“ einer einmal abgegebenen Stimme (wie durch diesen Test bewiesen) bringt auch dann Vorteile, wenn es entfernt wird.

(2) Der Wert von Links bleibt für einige Zeit erhalten . Bevor Sie also in Versuchung geraten, illegitime Links zu erwerben, überlegen Sie, ob Sie bereit sind, diese für Monate (oder sogar Jahre) im Voraus zu hinterlassen.

Kurz gesagt, verbringen Sie Ihre Zeit damit, sich auf den Aufbau natürlicher organischer Links zu konzentrieren.

Links können entweder für Sie oder gegen Sie arbeiten. Stellen Sie also sicher, dass es ersteres ist.

Fehlen Linkbuilding-Strategien?

Schauen Sie sich diesen Beitrag an, der Dutzende von Ideen enthält, um Ihnen den Einstieg zu erleichtern.

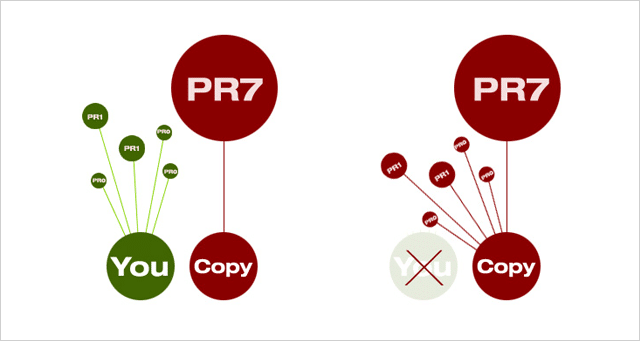

4. Sie können mit Duplicate Content ranken. Funktioniert sogar bei konkurrierenden Keywords

Vollständige Offenlegung, was ich Ihnen mitteilen werde, funktioniert möglicherweise nur für kurze Zeit. Aber für die Zeit, in der es funktioniert , Junge, funktioniert es wie Gangbuster.

Zuerst die Theorie.

Wenn es zwei identische Dokumente im Web gibt, wählt Google das mit dem höheren PageRank aus und verwendet es in den Suchergebnissen.

Es leitet auch alle Links von einem wahrgenommenen „Duplikat“ zum ausgewählten „Hauptdokument“ weiter.

Warum tut es das?

Sofern es keinen triftigen Grund für zwei oder mehr Versionen desselben Inhalts gibt, muss nur eine vorhanden sein.

Und was bedeutet das für Sie?

Das bedeutet, dass Sie, wenn Sie einzigartige und maßgebliche Inhalte erstellen (die qualitativ hochwertige Links und Shares anziehen), die Nase vorn haben sollten. Google wird Ihre Version im Index behalten und alle Links, die auf die Duplikate abzielen, auf Ihre Website verweisen.

Die schlechte Nachricht (zumindest für die Guten), dies ist nicht immer der Fall.

Von Zeit zu Zeit überholt eine größere, maßgeblichere Website kleinere Websites in den SERPs für ihren eigenen Inhalt.

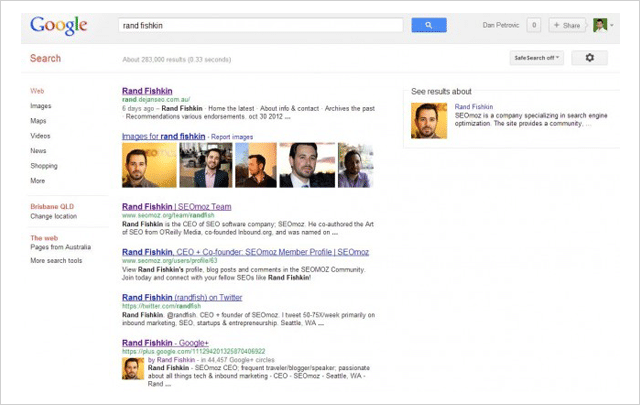

Das wollte Dan Petrovic von Dejan SEO in seinem mittlerweile berühmten SERPs-Hijack-Experiment testen.

Anhand von vier separaten Webseiten testete er, ob der Inhalt aus den Suchergebnissen „gekapert“ werden konnte, indem er kopiert und auf einer Seite mit höherem PageRank platziert wurde – die dann das Original in den SERPs ersetzen würde.

Folgendes ist passiert:

- In allen vier Tests schlug die Nachahmerseite mit höherem PR das Original.

- In 3 von 4 Fällen wurde die Originalseite aus den SERPs entfernt .

Seine Tests beweisen, dass eine höhere PageRank-Seite eine niedrigere PageRank-Seite mit demselben Inhalt schlägt, selbst wenn die niedrigere PR-Seite die ursprüngliche Quelle ist.

Und selbst wenn die Originalseite vom ehemaligen Zauberer von Moz selbst, Rand Fishkin, erstellt wurde.

( Bild: Rand Fishkin wurde in Dan Petrovics Experiment für seinen eigenen Namen übertroffen.)

Es stellt sich also die Frage, was Sie tun können, um zu verhindern, dass Ihre eigenen Inhalte gekapert werden?

Obwohl es keine Garantie gibt, dass Sie verhindern können, dass Ihre eigenen hart erarbeiteten Inhalte kopiert und dann geschlagen werden, bietet Dan die folgenden Maßnahmen an, die Ihnen helfen können, Sie vor Inhaltsdieben zu schützen:

(1) Fügen Sie Ihrem Inhalt das Tag rel="canonical" hinzu und verwenden Sie dabei den vollständigen http://-Text.

(2) Link zu internen Seiten auf Ihrer eigenen Website.

(3) Google-Urheberschafts-Markup hinzufügen.

(4) Suchen Sie regelmäßig mit einem Tool wie Copyscape nach doppelten Inhalten.

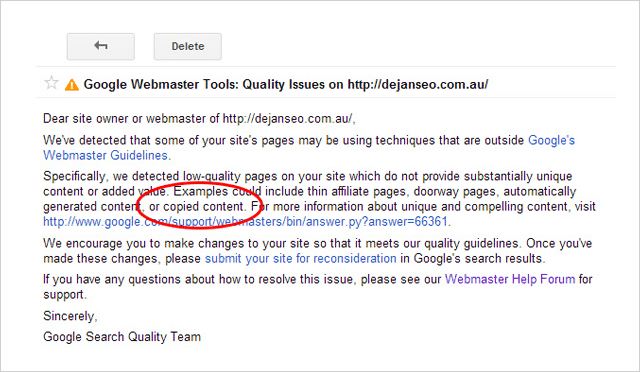

Plagiatoren aufgepasst

Nur weil Sie Ihre Konkurrenten schlagen können, indem Sie ihre Inhalte stehlen, bedeutet das nicht, dass Sie dies tun sollten .

Es ist nicht nur unethisch und geradezu zwielichtig, den Inhalt eines anderen für sich zu beanspruchen, sondern Plagiate können Sie auch in Schwierigkeiten bringen.

Kurz nach Durchführung des Experiments erhielt Dejan SEO eine Warnmeldung in ihrem Google Search Console-Konto.

In der Nachricht wurde die Domain dejanseo.com.au mit Seiten von geringer Qualität zitiert, ein Beispiel dafür sind „kopierte Inhalte“. Etwa zur gleichen Zeit wurde auch eine der Nachahmer-Testseiten für einige Begriffe nicht mehr in den SERPs angezeigt.

Dies zwang Dan, die Testseiten zu entfernen, um das Qualitätsproblem für seine Website zu lösen.

Es scheint also, dass Sie Ihre Konkurrenten zwar mit ihren eigenen Inhalten schlagen können, es aber definitiv keine gute Idee ist, dies zu tun.

5. Nummer Eins ist NICHT der „Top“-Spot (und was ist jetzt)

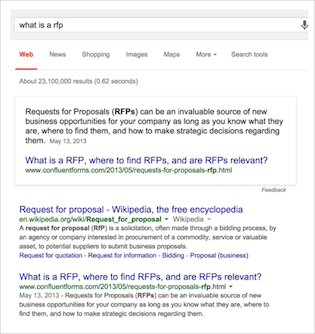

In diesem Test machten sich Eric Enge und das Team von Stone Temple Consulting (jetzt Teil von Perficient) daran, die Veränderung in der Anzeige von Rich Answers in den Suchergebnissen von Google zu messen.

Nur für den Fall, dass Sie mit der Terminologie nicht vertraut sind …

Rich Answers sind die „In Search“-Antworten auf Ihre Suchanfragen, von denen Sie in letzter Zeit wahrscheinlich öfter gesehen haben. Sie zielen darauf ab, Ihre Anfrage zu beantworten, ohne dass Sie sich zu einer Website durchklicken müssen.

Es gibt viele Arten von Rich Answers wie diese:

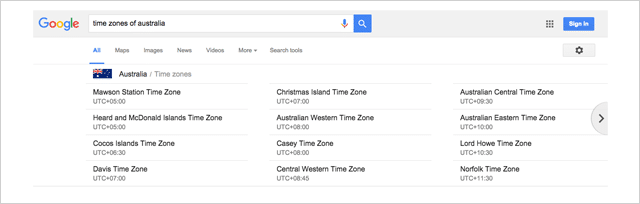

Oder dieses Karussell, das mir angezeigt wurde, als ich nach „Zeitzonen von Australien“ gesucht habe

Es gibt buchstäblich Dutzende von Variationen, von denen viele hier von Google geteilt werden.

Rich-Answers-Studie von Stone Temple Consulting

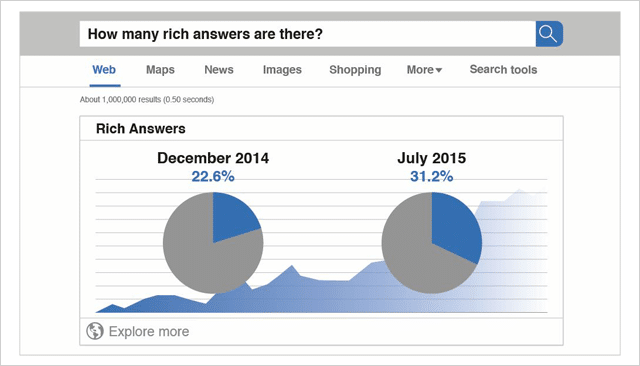

Die Ausgangsdaten für diese Studie wurden im Dezember 2014 erhoben.

Insgesamt wurden 855.243 Anfragen analysiert.

Von den damals gemessenen Suchanfragen zeigten 22,6 % Rich Answers an.

Später im Juli 2015 wurden dieselben 855.243 Anfragen erneut analysiert.

Zu diesem Zeitpunkt (nur 7 Monate später) war der Gesamtprozentsatz der Suchanfragen mit Rich Answers auf 31,2 % gestiegen.

Da die Studie von Stone Temple Consulting genau die gleichen 855.243 Suchanfragen gemessen hat, ist der Vergleich zwischen diesen beiden Datensätzen ein strenger Vergleich von Apfel zu Apfel.

Die Daten sind klar.

Rich Answers sind auf dem Vormarsch und die Ergebnisse, die Sie heute sehen, sind weit entfernt von den zehn blauen Links der Vergangenheit.

( Quelle: Quicksprout)

Die sich ändernde Ansicht in den Suchergebnissen

Als die Suchmaschinen-Ergebnisseiten nur eine Liste von Websites waren, die nach ihrer Relevanz für eine Suchanfrage geordnet waren, war klar, warum Website-Eigentümer alles tun würden, um den ersten Platz zu erreichen.

Je höher die Ränge, desto mehr Klicks erhalten Sie.

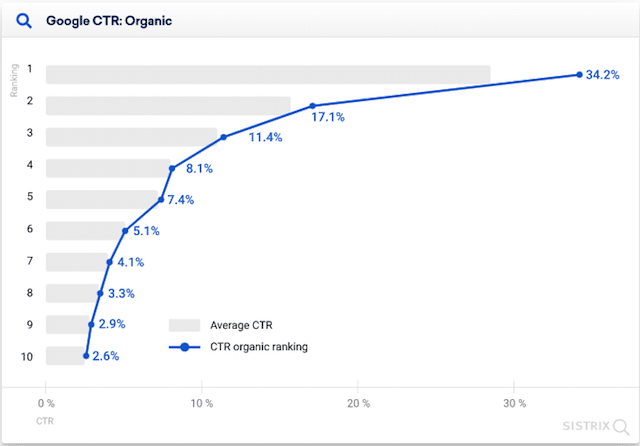

Laut dieser Studie von Erez Barak von Optify würde die bestplatzierte Website im Jahr 2011 bis zu 37 % aller Klicks erhalten.

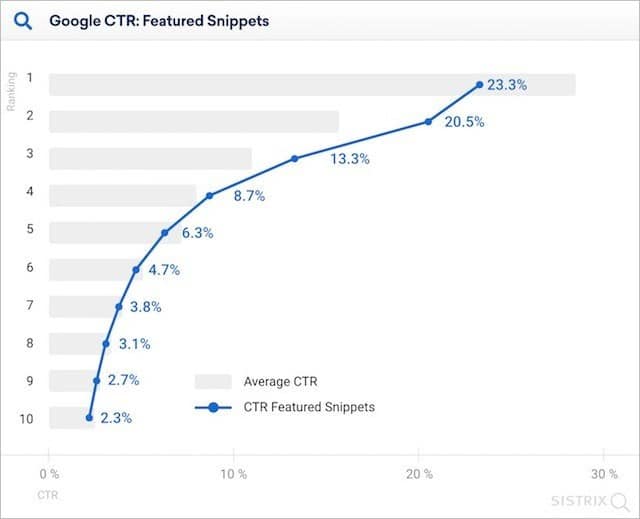

Noch im Jahr 2020 berichtete Sistrix in seiner Studie, dass Top-Ranking-Sites (auf denen keine Featured Snippets angezeigt werden) mehr als doppelt so viele Klicks generieren im Vergleich zu zweitplatzierten Websites.

Aber mit dem Wachstum von Rich Answers ändert sich das alles.

Das organische Ergebnis „Nummer eins“ wird auf der Seite immer weiter nach unten verschoben. Die Klickzahlen für den „Top-Spot“ sinken.

Aber wie stark wirken sich Rich Answers auf die Klickraten aus?

Die kurze Antwort ist viel.

In ihrer Studie aus dem Jahr 2020 stellte Sistrix fest, dass in Gegenwart eines Featured Snippets das Webergebnis Nummer eins 23,3 % der Klicks erhielt.

Das sind elf Prozent weniger als ohne Featured Snippet.

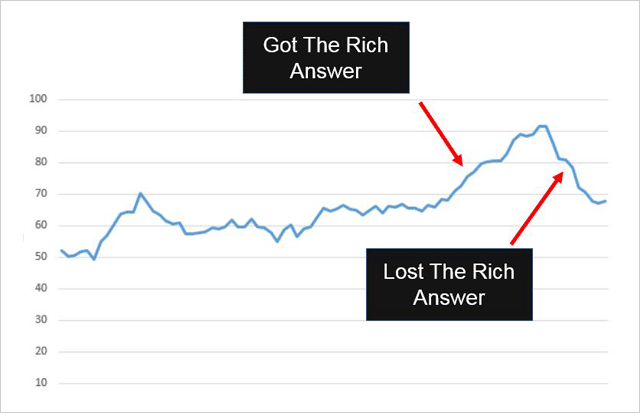

Es ist klar ersichtlich, wie sich die Aufnahme (und Entfernung) einer Rich-Snippet-Antwort in die SERPs auf den gesamten Suchverkehr zu einer Website auswirken kann.

Hier ist ein Beispiel:

Confluent Forms hat ein Rich-Snippet-Ergebnis auf ihrer Website aufgelistet bekommen und das ist, was mit ihrem Traffic passiert ist:

Es stieg, sobald die Rich-Antwort hinzugefügt wurde.

Es ging aus, als die Rich-Antwort entfernt wurde.

Und denken Sie daran…

Rich Answers sind dazu gedacht, Anfragen innerhalb der Suchergebnisse zu lösen. Sie können jedoch immer noch zusätzlichen Traffic auf Ihre Website senden , genau wie sie es bei Confluent Forms getan haben.

Wie Sie Rich-Antworten zu Ihrem Vorteil nutzen

Rich Answers werden im Allgemeinen für fragenbasierte Suchanfragen bereitgestellt.

Und laut Eric Enge (der erfolgreich eine Rich Answer-Liste für seine eigene Website erhalten hat) ist das Beantworten von Fragen der beste Weg, dies zu tun.

Wenn Sie von Rich Answers profitieren möchten (und wer würde das nicht tun), empfehle ich Ihnen, seinen Rat zu beherzigen:

(1) Identifizieren Sie eine einfache Frage – Stellen Sie sicher, dass die Frage zum Thema gehört. Sie können dies mit einem Relevanz-Tool wie nTopic überprüfen.

(2) Geben Sie eine direkte Antwort – Stellen Sie sicher, dass Ihre Antwort einfach, klar und sowohl für Benutzer als auch für Suchmaschinen nützlich ist.

(3) Bieten Sie Mehrwertinformationen an – Fügen Sie neben Ihrer prägnanten Antwort auf die Frage weitere Details und Mehrwerte hinzu. Achten Sie darauf, Wikipedia nicht einfach erneut zu zitieren, da Sie damit nicht sehr weit kommen.

(4) Machen Sie es Benutzern und Google leicht, sie zu finden – Dies könnte bedeuten, dass Sie sie mit Ihren Social-Media-Followern teilen oder von Ihren eigenen Websites oder Websites von Drittanbietern darauf verlinken.

6. Die Verwendung von HTTPS kann Ihrem Ranking tatsächlich schaden

Machen Sie Ihre Website sicher oder sonst.

Das war die Botschaft von Google in diesem Blogbeitrag, als sie HTTPS als Ranking-Signal anführten.

Und es würde Sinn machen, oder?

Websites, die HTTPS verwenden, sind sicherer. Google möchte, dass die Websites, auf die Benutzer über die Suchmaschine zugreifen, sicher sind. Websites, die HTTPS verwenden, sollten einen Ranking-Boost erhalten.

Aber hier ist das Ding. Sie tun es nicht.

(Soweit man der Studie von Stone Temple Consulting und seoClarity glauben kann.)

Die HTTPS-Studie verfolgte Rankings über 50.000 Keyword-Suchen und 218.000 Domains. Sie überwachten diese Rankings im Laufe der Zeit und beobachteten, welche URLs in den SERPs von HTTP zu HTTPS geändert wurden.

Von den 218.000 verfolgten Domains haben nur 630 (0,3 %) auf HTTPS umgestellt.

Folgendes ist mit den HTTPS-Websites passiert:

Sie haben tatsächlich Rang verloren .

Später erholten sie sich (langsam) ziemlich genau dort, wo sie begonnen hatten.

Kaum ein Grund, auf den HTTPS-Zug aufzuspringen.

Es scheint, dass HTTPS (obwohl Google es überall im Web zum Standard machen will) vorerst keinen signifikanten Ranking-Vorteil hat und Ihren Rankings kurzfristig sogar schaden kann.

Mein Rat : Verwenden Sie weiterhin HTTP, es sei denn, Sie müssen wirklich etwas ändern.

7. Robots.txt NoIndex funktioniert nicht (immer).

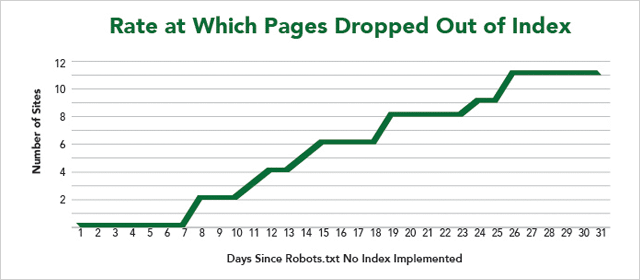

In einem weiteren Experiment aus dem IMEC Lab boten 12 Websites ihre Seiten an, um zu testen, ob die Verwendung von Robots.txt NoIndex Suchmaschinen erfolgreich daran hindert, eine Seite zu crawlen UND zu indizieren.

Zuerst die technischen Sachen.

So verhindern Sie, dass Suchmaschinen Ihre Webseite indizieren

Der übliche Ansatz von Webmastern besteht darin, eine NoIndex-Direktive innerhalb des Robots-Metatags auf einer Seite hinzuzufügen. Wenn die Suchmaschinen-Spider diese Seite crawlen, identifizieren sie die NoIndex-Direktive in der Kopfzeile der Seite und entfernen die Seite aus dem Index.

Kurz gesagt, sie crawlen die Seite und verhindern dann , dass sie in den Suchergebnissen angezeigt wird.

Der Code sieht so aus:

Andererseits stoppt die NoIndex-Direktive, die in der Robots.txt-Datei einer Website platziert wird, sowohl die Indexierung der Seite als auch das Crawlen der Seite.

Oder sollte es zumindest…

Wie Sie den Ergebnissen entnehmen können, wurden nicht alle Webseiten aus dem Index entfernt.

Schlechte Nachrichten, wenn Sie den Inhalt Ihrer Website vor neugierigen Blicken verbergen möchten.

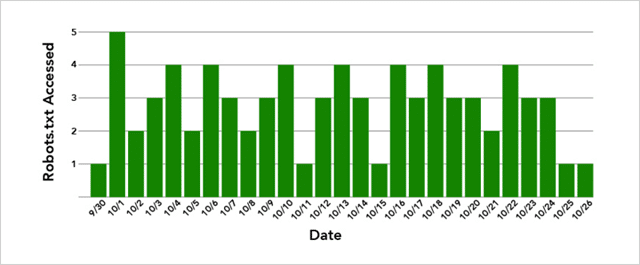

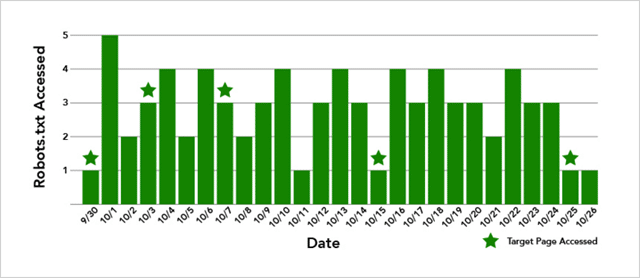

Darüber hinaus hat Google keine der Seiten sofort entfernt, obwohl die Robots.txt-Dateien der Website mehrmals täglich gecrawlt wurden.

Und wenn Sie denken, dass das daran liegt, dass Google auch versuchen muss, die Seite selbst zu crawlen, ist das auch nicht wahr.

Im Fall der Website, deren Seite nicht aus dem Index entfernt wurde, wurde die Zielseite 5 Mal gecrawlt:

Also, was ist hier im Spiel?

Nun, die Ergebnisse sind nicht schlüssig.

Was wir jedoch mit Sicherheit sagen können, ist, dass es (obwohl Google Robots.txt NoIndex unterstützt) langsam funktioniert und manchmal überhaupt nicht funktioniert.

Mein Rat: Verwenden Sie Robots.txt NoIndex mit Vorsicht.

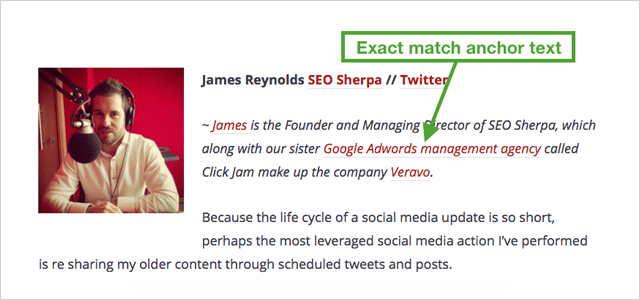

8. Genau passende Ankertext-Links Trumpf Nicht-Anker-Match-Links

Wenn Sie ein oder zwei Dinge über SEO gelesen haben, wissen Sie, dass genau passender Ankertext schlecht ist .

Zu viele Links, die dasselbe sagen, sind unnatürlich.

Und könnte Sie mit einer Strafe landen.

Seit Google Penguin veröffentlicht wurde, um dem manipulativen Linkaufbau Einhalt zu gebieten, lautet der Rat von Experten, „das Verhältnis von Ankertexten niedrig zu halten“.

Einfach ausgedrückt bedeutet dies, dass Sie eine Mischung aus Links zu Ihrer Website wünschen, sodass kein schlüsselwortreicher Ankertext mehr als einen kleinen Prozentsatz der Gesamtzahl ausmacht.

Rohe Links wie diese: http//IhreDomain.com sowie generische Links wie „Ihr Markenname“, „Klicken Sie hier“ und „Besuchen Sie diese Website“ sind alle gut.

Mehr als ein kleiner Prozentsatz der Keyword-reichen Links ist schlecht.

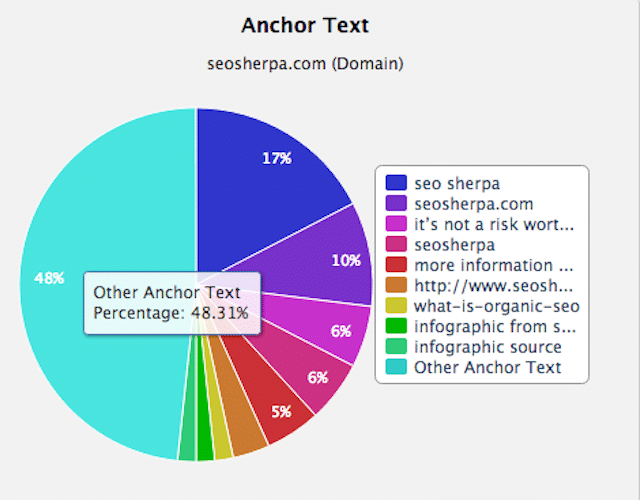

Ein abwechslungsreiches und natürliches Linkprofil wird in etwa so aussehen wie meines:

Wie Sie sehen, beziehen sich die meisten Links auf meinen Markennamen. Der Rest sind meist andere Ankertexte.

In diesem Sinne.

Was passiert, wenn Sie 20 Links auf eine Website verweisen, die alle denselben schlüsselwortreichen Ankertext enthalten?

Ihre Rankings schießen in die Höhe, das ist was!

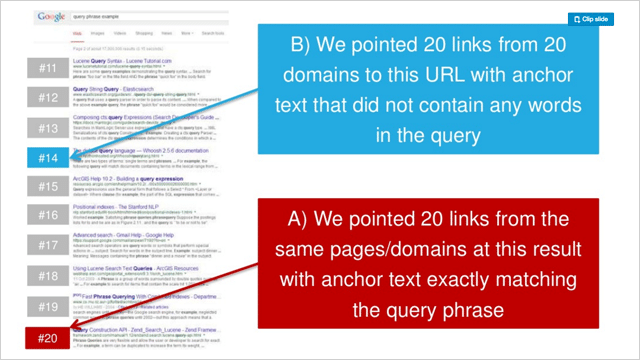

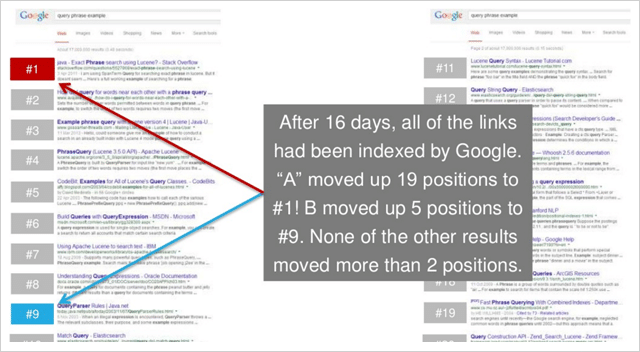

In einer Reihe von drei Experimenten testete Rand Fishkin das Verweisen von 20 generischen Ankerlinks auf eine Webseite im Vergleich zu 20 exakt passenden Ankertextlinks.

In jedem Fall steigerte der exakt passende Ankertext das Ranking der Zielseiten deutlich.

Und in 2 von 3 Tests kapitulierten die exakt passenden Ankertext-Websites in den Ergebnissen vor den generischen Ankertext-Websites.

Hier ist die Vorher-Rangliste von Test 2 in Rands Serie:

Und hier die Platzierungen danach:

Das ist verdammt schlüssig.

Genau passender Ankertext ist erheblich leistungsfähiger als Nicht-Anker-Match-Links.

(Und insgesamt überraschend stark)

9. Link zu anderen Websites, um Ihre Rankings zu verbessern

Ausgehende Links verwässern die Autorität Ihrer Website.

Dies ist seit einiger Zeit die allgemein verbreitete Vorstellung in der Welt der SEO.

Und das, obwohl Google sagt, dass das Verlinken verwandter Ressourcen eine gute Praxis ist.

Warum also sind SEOs so gegen ausgehende Links?

Die Idee dahinter ist, dass ausgehende Links Ihren PageRank verlieren. Je mehr ausgehende Links, desto mehr PageRank verschenken Sie.

Und da der Verlust von PageRank einen Verlust an Autorität bedeutet, führt die Verlinkung zu niedrigeren Rankings. Rechts

Finden wir es heraus.

Shai Aharony und das Team von Reboot haben diese Vorstellung in ihrem Experiment zu ausgehenden Links auf die Probe gestellt.

Für das Experiment richtete Shai zehn Websites ein, alle mit ähnlichen Domain-Formaten und -Strukturen.

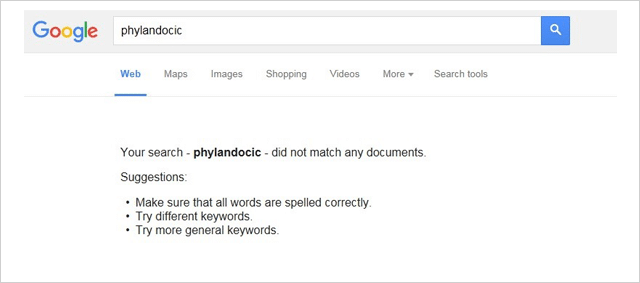

Jede Website enthielt einen einzigartigen Artikel mit 300 Wörtern, der für ein Kunstwort „Phylandocic“ optimiert wurde.

Vor dem Test zeigte das Wort „Phylandocic“ bei Google keine Ergebnisse.

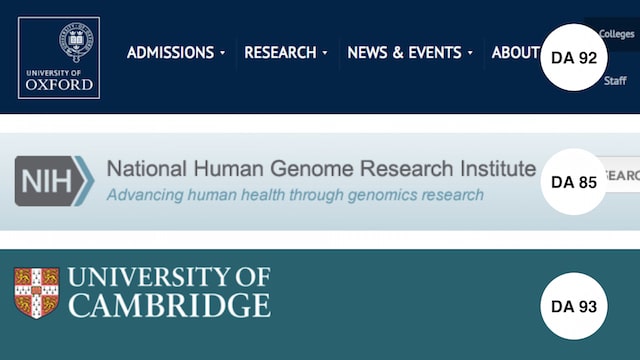

Um die Wirkung von ausgehenden Links zu testen, wurden 5 der 10 Domains um 3 vollständige Follow-Links erweitert.

Die Links verwiesen auf sehr vertrauenswürdige Websites:

- Universität Oxford (DA 92)

- Institut für Genomforschung (DA 85)

- Universität Cambridge (DA 93)

Nachdem alle Testseiten indexiert waren, wurden Rankings erfasst.

Hier sind die Ergebnisse:

Sie sind so klar wie Tag und Nacht.

JEDE einzelne Website mit ausgehenden Links übertraf die ohne.

Dies bedeutet, dass Ihr Aktionsschritt einfach ist.

Stellen Sie jedes Mal, wenn Sie einen Artikel auf Ihrer Website veröffentlichen, sicher, dass er eine Handvoll Links zu relevanten und vertrauenswürdigen Ressourcen enthält.

Wie das Experiment von Reboot bewies. Es wird Ihren Lesern UND Ihren Rankings dienen.

10. Erstaunliche Entdeckung, dass Nofollow-Links Ihr Ranking tatsächlich verbessern

Ein weiteres Experiment des IMEC-Labors wurde durchgeführt, um zu antworten:

Haben No-Follow-Links direkten Einfluss auf das Ranking?

Da der Zweck der Verwendung eines „No-Follow“-Links darin besteht, die Weitergabe von Autorität zu verhindern, würden Sie erwarten, dass No-Follow-Links keinen (direkten) SEO-Wert haben.

Dieses Experiment beweist etwas anderes.

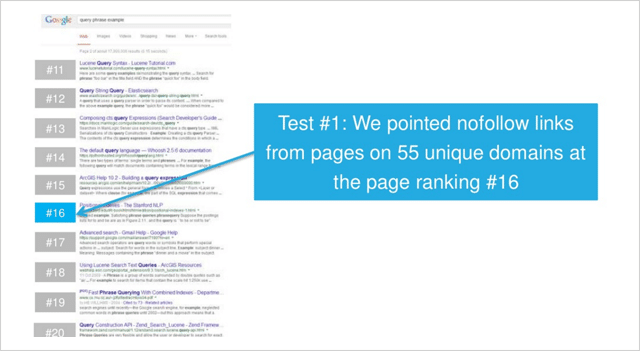

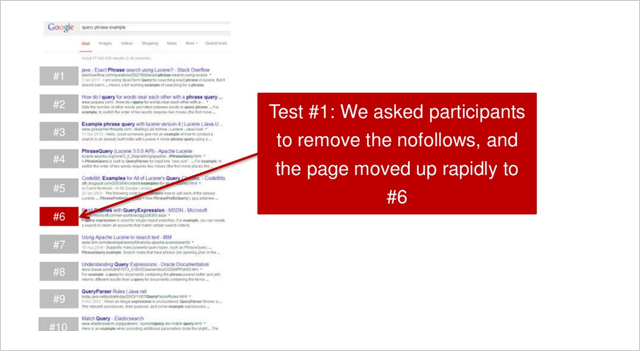

Im ersten von zwei Tests zeigten IMEC Lab-Teilnehmer Links von Seiten auf 55 einzigartigen Domains mit einem Seitenranking auf Platz 16.

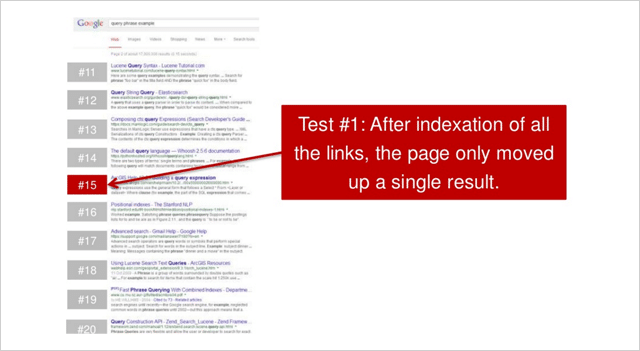

Nachdem alle No-Follow-Links indexiert wurden, bewegte sich die Seite für die gemessene wettbewerbsfähige Suchanfrage mit niedrigem Suchvolumen leicht nach oben.

Die Teilnehmer wurden dann gebeten, die No-Follow-Links zu entfernen, die dazu führten:

Die Seite bewegte sich schnell nach oben zur Position Nummer 6.

Ein kumulativer Anstieg um 10 Positionen, nur durch einige No-Follow-Links.

Nicht schlecht.

Könnte sich das wiederholen?

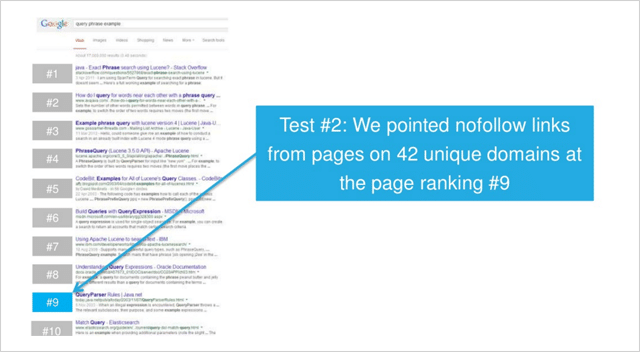

In einem zweiten Test, diesmal für eine Suchanfrage mit geringem Wettbewerb, wurden No-Follow-Links zu Seiten von 42 einzigartigen Domains hinzugefügt.

( Hinweis – alle Links waren Seitentext-Links. In keinem der Tests wurden Kopfzeilen-, Fußzeilen-, Seitenleisten-, Widget-Links (oder ähnliches) verwendet.)

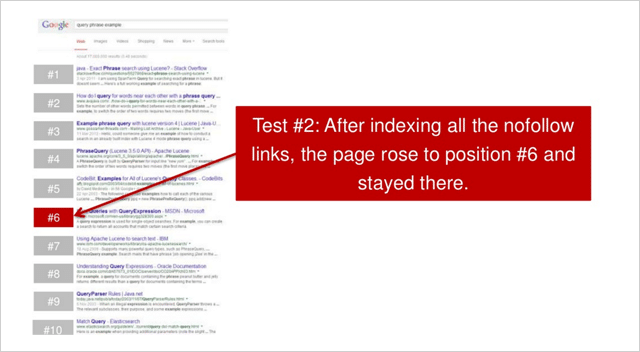

Nachdem alle Links indexiert wurden, kletterte die Seite auf Platz 6.

Eine Erhöhung um 3 Stellen.

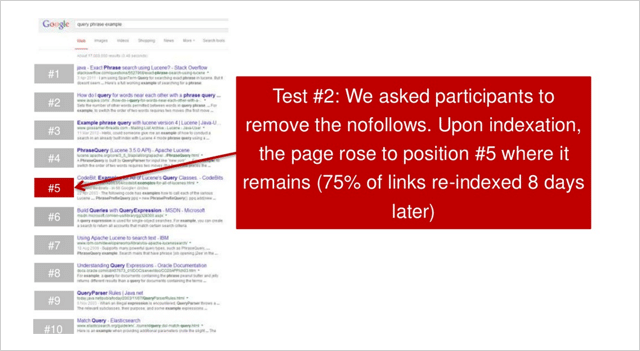

Dann wurden die Teilnehmer gebeten, alle No-Follow-Links zu entfernen. Die Website stieg dann um eine Position auf Platz 5 auf.

In beiden Tests; Wenn No-Follow-Links erworben wurden, verbesserten die Websites ihre Platzierungen erheblich

Die erste Website stieg um 10 Positionen.

Die zweite Website stieg um 4 Positionen.

Also noch eine weitere SEO-Theorie entlarvt?

Rand Fishkin weist darauf hin, dass der Test mehrmals wiederholt werden sollte, um endgültig zu sein.

„Mein Imbiss. Der Test sollte mindestens 2-3 Mal wiederholt werden, aber erste Daten deuten darauf hin, dass es einen Zusammenhang zwischen Ranking-Erhöhungen und In-Content, nicht verfolgten Links zu geben scheint“, sagt Rand.

Unabhängig davon, wie Nicole Kohler betont, gibt es sicherlich einen Grund für No-Follow-Links.

Links erzeugen Links.

Und (laut dieser Studie) No-Follow oder Full-Follow. Sie sind BEIDE von Wert für Sie.

11. Tatsache: Links von Webseiten mit Tausenden von Links funktionieren

In der Suchmaschinenoptimierung herrscht die Überzeugung vor, dass Links von Webseiten mit vielen ausgehenden Links nicht wirklich viel wert sind.

Die Theorie hier ist, dass bei vielen ausgehenden Links der „Link Juice“ AKA PageRank von der verlinkenden Webseite so dünn gestreut wird, dass der Wert eines Links zu Ihrer Seite nicht viel ausmachen kann.

Je mehr ausgehende Links die Website hat, desto weniger Wert wird an Ihre Website weitergegeben.

Diese Theorie wird durch die Vorstellung verstärkt, dass Verzeichnisse und andere Websites mit geringerer Qualität, die viele ausgehende Links haben, den Websites, auf die sie verlinken, keinen signifikanten Ranking-Vorteil bieten sollten. Links von Webseiten mit wenigen ausgehenden Links sind wiederum wertvoller.

Genau das hat Dan Petrovic in seinem PageRank Split Experiment auf die Probe gestellt.

Der PageRank-Split-Test

In seinem Experiment richtete Dan zwei Domänen (A und B) ein.

Beide Domains waren .com und beide hatten ähnliche Merkmale und ähnliche, aber einzigartige Inhalte.

Der einzige wirkliche Unterschied bestand darin, dass während des Tests auf Website B von einer Website aus verlinkt wurde, auf die von einer Unterseite auf http://www.debian.org (PR 7) verlinkt wurde, die 4.225 extern verfolgte Links hat.

Das Ziel des Tests war einfach zu sehen, ob ein gewisser Grad an PageRank bestanden wird, wenn so viele ausgehende Links vorhanden sind, und welche Auswirkung (wenn überhaupt) dies auf das Ranking der verlinkten Websites hat.

Geht man nach der Überzeugung der meisten SEOs, dürfte nicht viel passiert sein.

Hier ist, was passiert ist …

Unmittelbar nachdem Website B von der PR 7 debian.org (über die Bridge-Website) verlinkt wurde, schoss Website B in den Rankings nach oben und erreichte schließlich Position 2.

Und laut Dans letztem Update (3 Monate nach dem Test) behielt Website B ihre Position, nur durch eine bedeutend maßgeblichere PageRank 4-Seite vom Spitzenplatz abgehalten.

Website A (auf die nicht verlinkt wurde) blieb eine Zeitlang auf einer stabilen Position und fiel dann im Ranking zurück.

Es scheint also, dass Links von Seiten, die viele ausgehende Links haben, tatsächlich äußerst wertvoll sind.

Welchen Mythos kann unsere Liste von SEO-Experimenten als nächstes zerstreuen…

12. Bildlinks funktionieren (wirklich) gut

Wie viele der SEO-Experimente auf dieser Liste entstand dieses, weil ein Typ eine Ahnung hatte.

Dan Petrovics Idee war, dass der Text, der einen Link umgibt, eine semantische Rolle im Suchalgorithmus von Google spielt.

Aber Dan war nie in der Lage, den Grad seines Einflusses festzustellen oder ob er überhaupt eine Auswirkung hat .

Also hat er diesen Test ins Leben gerufen, um es herauszufinden …

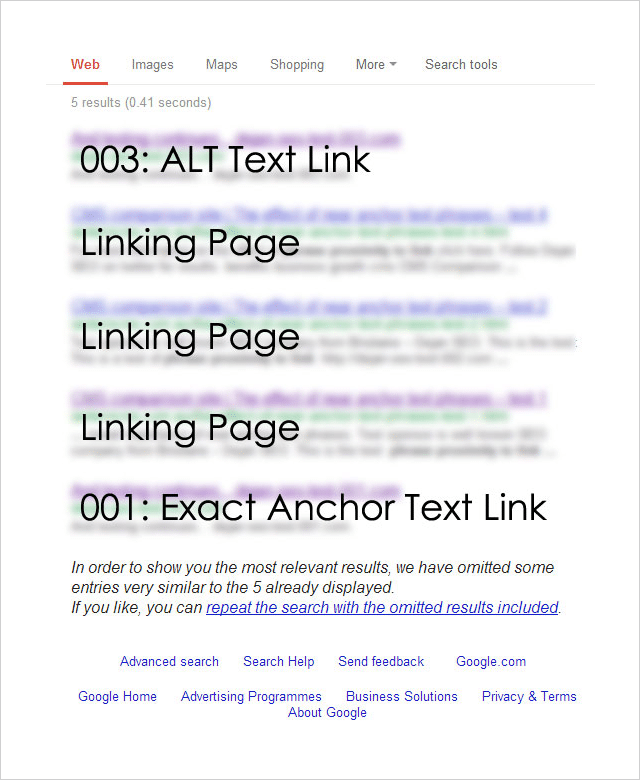

Ankertext-Näherungsexperiment

Das Experiment wurde entwickelt, um die Auswirkungen verschiedener Linktypen (und ihres Kontexts) auf das Suchranking zu testen.

Um den Test durchzuführen, registrierte Dan 4 fast identische Domainnamen:

http://********001.com.au

http://********002.com.au

http://********003.com.au

http://********004.com.au

Each of the 4 domains was then linked to from a separate page on a well-established website. Each page targeted the same exact phrase but had a different link type pointing to it:

001: [exact phrase]

Used the exact target keyword phrase in the anchor text of the link.

002: Surrounding text followed by the [exact phrase]: http://********002.com.au

Exact target keyword phrase inside a relevant sentence immediately followed by a raw http:// link to the target page.

003: Image link with an ALT as [exact phrase]

An image linking to the target page that used the exact target keyword phrase as the ALT text for the image.

004: Some surrounding text with [exact phrase] near the link which says click here .

This variation used the junk anchor text link “click here” and the exact target keyword phrase near to the link.

So which link type had the greatest effect on rankings?

Here are the results:

Unsurprisingly, the exact match anchor text link worked well.

But most surprisingly, the ALT text-based image link worked best .

And, what about the other two link types?

The junk link (“click here”) and the raw link (“http//”) results did not show up at all.

The Anchor Text Lessons You Can Take Away From This

This is just one isolated experiment, but it's obvious that image links work really well.

Consider creating SEO-optimized image assets that you can utilize to generate backlinks.

The team at Ahrefs put together a useful post about image asset link building here.

But don't leave it at that, best results will come from a varied and natural backlink profile.

Check out this post from Brian Dean which provides 17 untapped backlink sources for you to try.

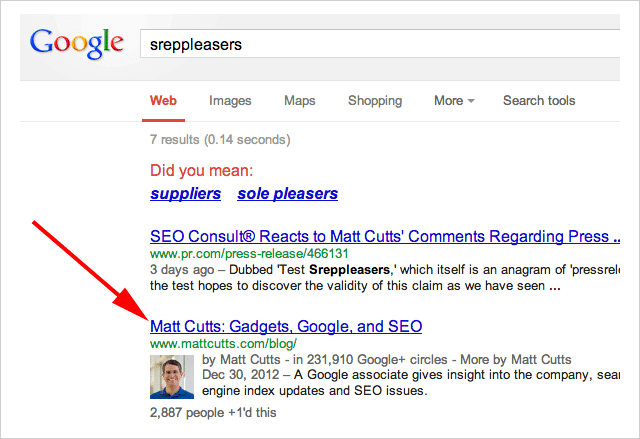

13. Press Release Links Work. Matt Cutts Take Note

Towards the end of 2014, Google's head of webspam publicly denounced press release links as holding no SEO value.

“Note: I wouldn't expect links from press release web sites to benefit your rankings” – Said Matt Cutts.

In an ironic (and brilliant) move, SEO Consult put Cutt's claim to the test this by issuing a press release which linked to, of all places….

Matt Cutts blog:

The anchor text used in the was the term “Sreppleasers”

The term is not present anywhere on Cutts's website.

Yet still, when you search “Sreppleasers” guess who's website comes up top?

There has been a lot of discussion about whether Press Release links work.

Is the jury still out on this?

I'll let you decide.

14. First Link Bias. Proven

First, let me say this…

This experiment is a few years old so things may now have changed. However, the results are so interesting it's very worthy of inclusion.

The theory for this experiment began with a post by Rand Fishkin which claimed that Google only counts one link to a URL from any given page.

Shortly after that post was published Rand's claims were debunked by David Eaves.

The opinion was rife in the SEO world as to whether either experiment was sound.

So, SEO Scientist set out to solve the argument once and for all.

The Test

The hypothesis goes something like this…

If a website is linked to twice (or more) from the same page, only the first link will affect rankings.

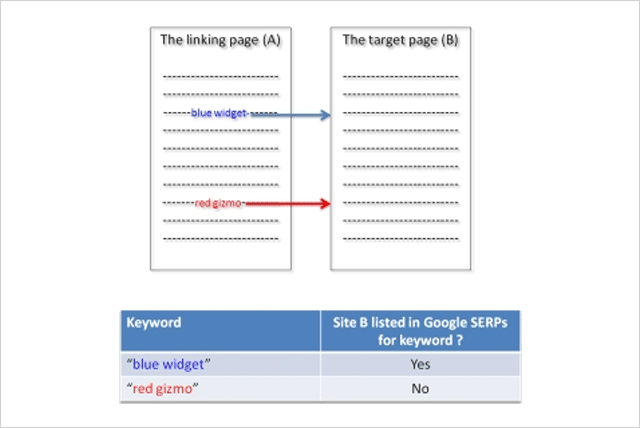

In order to conduct the test SEO Scientist set up two websites (A and B).

Website A links to website B with two links using different anchor texts.

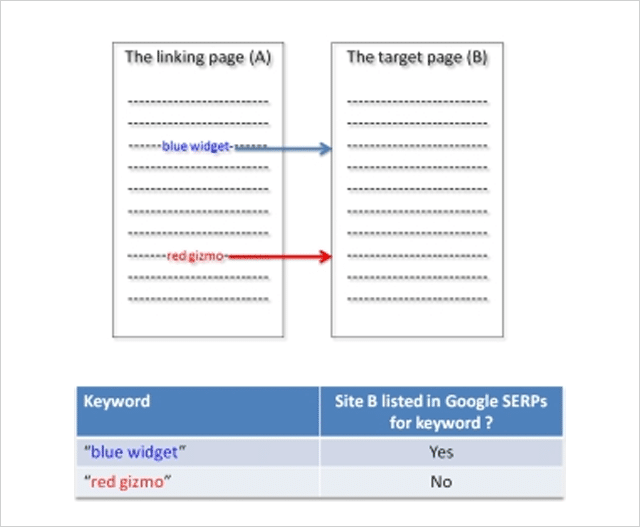

Test Variation 1

The websites were set up, then after the links got indexed by Google, the rankings of site B were checked for the two phrases.

Result : Site B ranked for the first phrase and not for the second phrase.

Here is what the results looked like:

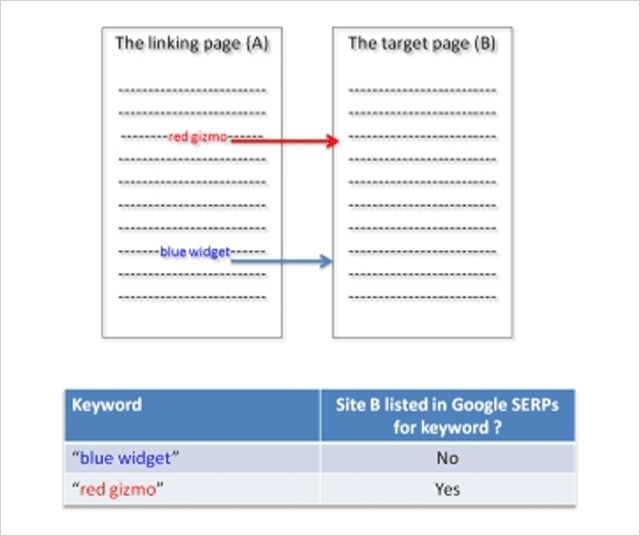

Test Variation 2

Next, the position of links to site B was switched. Now the second phrase appears above the previously first phrase on site A and visa versa.

Once Google had indexed the change, rankings were again checked for website B.

Result : Site B disappeared from the SERPs for the new second phrase (previously first) and appears for the new first phrase (previously second).

Rankings switched when the order of the links switched!

Test Variation 3

To check this was not some anomaly, in the third test variation the sites were reverted back to their original state.

Once the sites were re-indexed by Google, the rankings of website B were checked again.

Result : Site B reappeared for the initially first phrase and disappeared again for the initially second phrase:

The test proved that Google only counts the first link.

But, it gets even more interesting.

In a follow-up experiment, SEO Scientist made the first link “no follow” and still the second link was not counted!

The lesson from this experiment is clear.

If you are “self-creating” links ensure that your first link is to your most important target page.

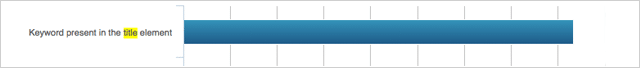

15. The Surprising Influence of Anchor Text on Page Titles

Optimizing your Title tags has always been considered an important SEO activity and rightly so.

Numerous SEO studies have identified the title tag as a genuine ranking factor.

Since it's also what normally gets shown in the search results when Google lists your website, spending time on crafting well-optimized title tags is a good use of your time.

But, what if you don't bother?

A few years ago Dejan SEO set out to test what factors Google considers when creating a document title when a title tag is not present.

They tested several factors including domain name, the header tag, and URLs – all of which did influence the document title shown in search results.

What about anchor text? Could that influence the title shown?

In this video Matt Cutts suggested it could:

But, wanting some real evidenc e Dan Petrovic put it to the test in this follow-up experiment.

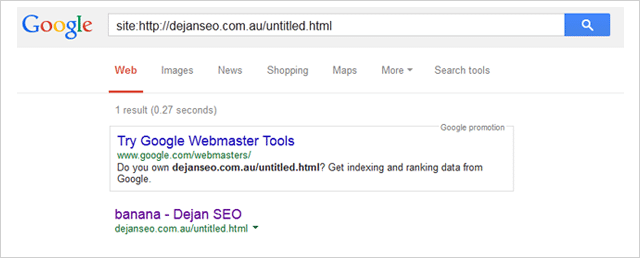

His experiment involved several participants linking to a page on his website using the anchor text “banana”.

The page being linked to had the non-informative title “Untitled Document”.

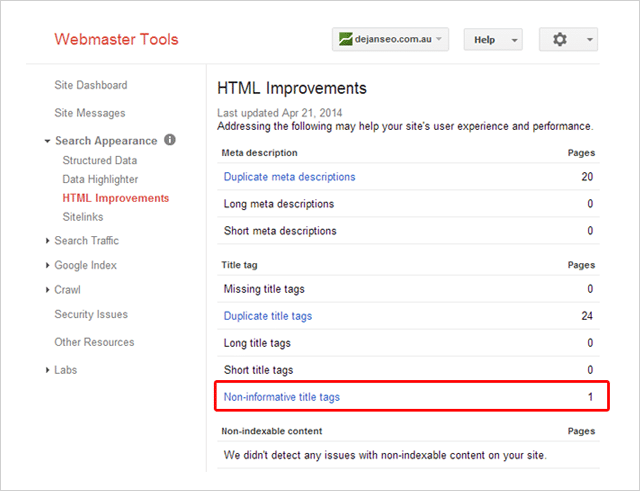

Here it is listed inside Dan's Search Console account:

Während des Tests überwachte Dan drei Suchanfragen:

- http://goo.gl/8uPrz0

- http://goo.gl/UzBOQh

- http://goo.gl/yW2iGi

Und hier ist das Ergebnis:

Der Titel des Dokuments wurde auf wundersame Weise als „Banane“ angezeigt.

Der Test beweist, dass Ankertext den von Google in den Suchergebnissen angezeigten Dokumenttitel beeinflussen kann.

Bedeutet das, dass Sie nicht für jede Seite Ihrer Website eindeutige und überzeugende Titel-Tags schreiben sollten?

Ich schlage vor, nicht.

Wie Brian Dean betont, ist das Titel-Tag Ihrer Seite vielleicht nicht mehr so wichtig wie früher, aber es zählt immer noch.

16. Negatives SEO: Wie Sie den Rankings Ihrer Konkurrenten schaden können (aber nicht sollten).

Es gibt kein Hinterfragen, negatives SEO ist möglich.

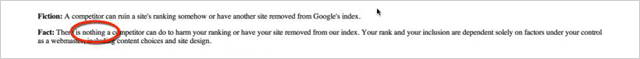

Im Jahr 2003 änderte Google seine Haltung von der Aussage, dass ein Konkurrent nichts tun kann, um Ihrem Ranking zu schaden:

Um zu sagen, dass sie fast nichts tun können:

![]()

Wenn es um Google geht, ist eine kleine Änderung wie diese eine ziemlich große Sache.

Da stellt sich die Frage…

Wie einfach ist es, das Ranking einer Website (negativ) zu beeinflussen?

Tasty Placement führte ein Experiment durch, um genau das herauszufinden.

Die negativen SEO-Experimente

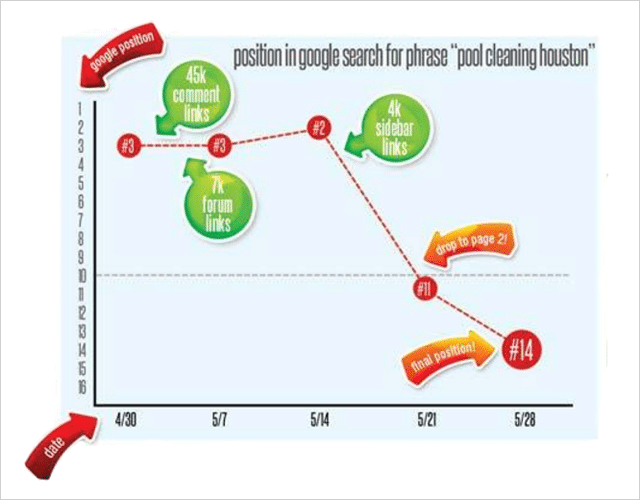

In einem Versuch, Suchrankings zu schädigen, kaufte Tasty Placement eine große Anzahl von Spam-Links, die sie auf ihre Ziel-Website Pool-Cleaning-Houston.com verwiesen.

Die Website war relativ etabliert und hatte vor dem Experiment einen guten Rang für mehrere Keywords, darunter „Pool Cleaning Houston“ und andere ähnliche Begriffe.

Während des Experiments wurden insgesamt 52 Schlüsselwortpositionen verfolgt.

Der Link-Spam

Sie kauften eine Vielzahl von Junk-Links für das Experiment zu sehr geringen Kosten:

45.000 Kommentarlinks. Ankertext „Pool Cleaning Houston“. Kosten: $15

7000 zweistufige Forenprofil-Links. Ankertext „Pool Cleaning Houston“. Kosten: 5 $

Sidebar-Blog-Links auf vier trashigen Blogs, was fast 4000 Links ergibt. Ankertext „Pool Cleaning Houston“. Kosten: $20

Gesamtkosten?

Satte 40 Dollar.

Im Laufe von 2 Wochen wurden die billigen Junk-Links auf Pool-Cleaning-Houston.com verwiesen

Zuerst die Kommentar-Links, dann die Forenprofil-Links und schließlich die Seitenleisten-Links.

Folgendes ist mit den Rankings für „Poolreinigung Houston“ passiert

Der Stapel von Kommentarlinks hatte überhaupt keine Wirkung.

7 Tage später wurden die Forenpost-Links platziert, was zu einem überraschenden Anstieg im Ranking der Seite von Position 3 auf Position 2 führte. Überhaupt nicht das, was erwartet wurde.

Weitere 7 Tage danach wurden die Sidebar-Links hinzugefügt.

Das Ergebnis…

Kaboom!

Ein fast augenblicklicher Absturz in der Rangliste.

Neben dem Hauptkeyword sind noch weitere 26 Keywords deutlich nach unten gerutscht .

Es scheint also ziemlich einfach (und billig) zu sein, die Rangliste eines Konkurrenten zu zerstören, wenn Sie so geneigt sind, was ich weiß, dass Sie es nicht sind!

Während das Experiment von Tasty Placement einige Fragen zur wahren Ursache des Ranking-Rückgangs offen lässt (sich wiederholender Ankertext oder Links aus einer schlechten Nachbarschaft vielleicht?), macht es deutlich, dass negatives SEO real ist.

Und wirklich einfach zu machen.

17. Schreibt Google bessere Beschreibungen als Sie?

Wenn Sie schon seit einiger Zeit im SEO tätig sind, haben Sie wahrscheinlich Hunderte, wenn nicht Tausende von Meta-Beschreibungen geschrieben.

Aber damit bist du cool.

Diese unzähligen Stunden des Schreibens von Meta-Beschreibungen sind gut investierte Zeit.

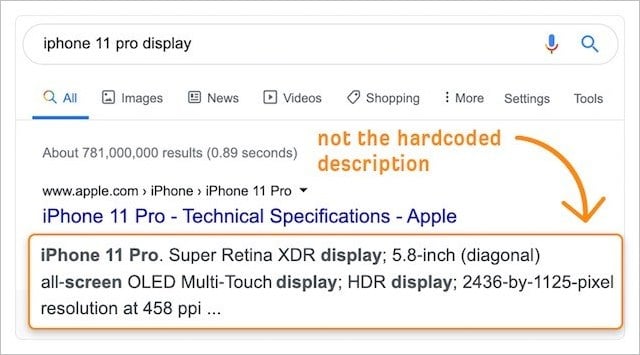

Mit der wachsenden Bedeutung der Klickrate für Rankings (siehe Experiment Nummer 2) werden alle Verbesserungen, die an den SERP-Snippets Ihrer Website über benutzerdefinierte (fest codierte) Beschreibungen vorgenommen werden, die Ergebnisse sicherlich verbessern.

Schließlich kennen wir unser Geschäft und unser Publikum am besten.

Das heißt, unsere Beschreibungen müssen die automatisch generierten Versionen von Google übertreffen, richtig?

Leider nicht.

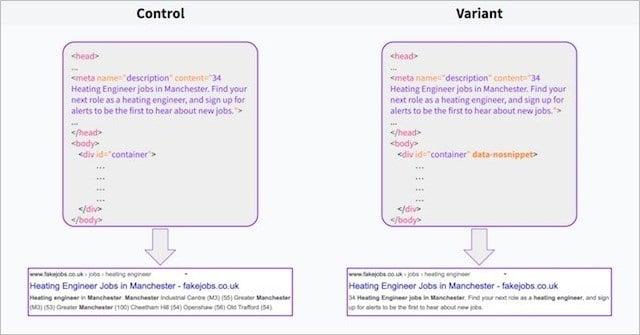

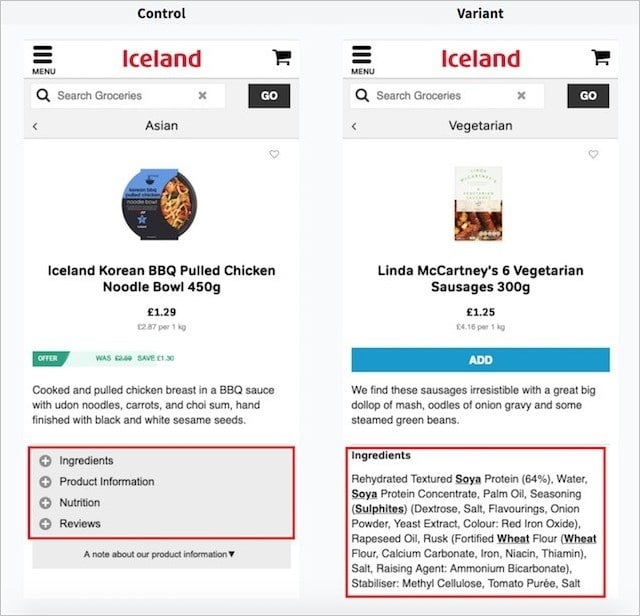

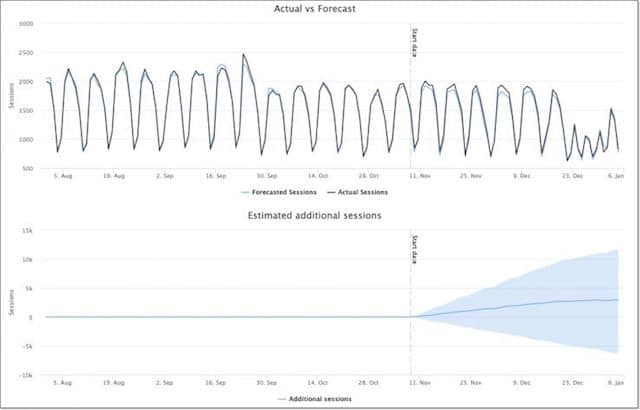

In einem kürzlich durchgeführten Experiment fand das Team von Search Pilot heraus, dass (zumindest in ihrem Fall) die automatisch generierten Beschreibungen von Google die benutzerdefinierten Meta-Beschreibungen um einen Faktor von 3 % übertrafen .

Mit dem Data-No-Snippet-Attribut auf dem body-Element der Hälfte ihrer Seiten konnte Search Pilot die von Google generierten Beschreibungen (die Kontrolle) gegen ihre eigenen benutzerdefinierten Beschreibungen (die Variante) testen.

Sehr bald nach Beginn des Tests ging der Click-Through-Trend nach unten, und innerhalb von zwei Wochen hatte der Test die statistische Signifikanz für ein negatives Ergebnis erreicht!

Kurz gesagt, die Beschreibungen von Google schnitten besser ab.

Was können Sie daraus mitnehmen?

Google hat Zugriff auf verdammt viele Benutzerdaten.

Dieser Datenvorteil hilft Google zu wissen, wonach die Nutzer suchen, und Beschreibungen zu erstellen, die für die Nutzer relevanter sind als die, die wir selbst schreiben – selbst wenn Googles eigene Beschreibungen verschrottet und oft wie Junk gelesen werden.

Dies wird durch Studien untermauert, die gezeigt haben, dass Google das Meta-Description-Tag bei 63 % der Suchanfragen ignoriert.

Wir können davon ausgehen, dass Google dies tut, wenn die vom Website-Inhaber erstellte Meta-Beschreibung für die Suchanfrage des Benutzers nicht vollständig relevant ist – und Google denkt, dass es einen besseren Job machen kann.

Die Studie von Search Pilot zeigt, dass dies der Fall ist.

Bedeutet das, dass Sie das Schreiben von Meta-Beschreibungen abschaffen und alles Google überlassen sollten?

Nicht komplett.

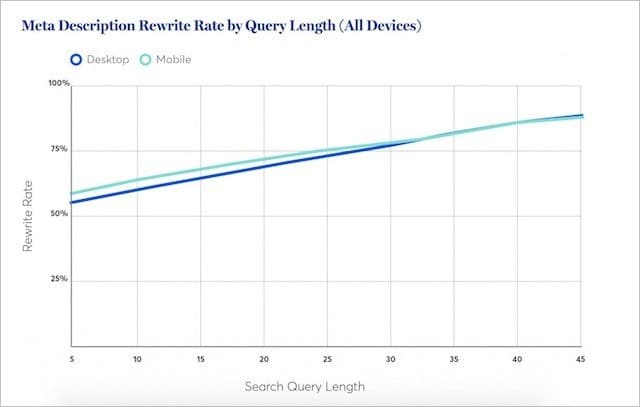

Untersuchungen von Portent deuten darauf hin, dass Google Meta-Beschreibungen für kurze (normalerweise hochvolumige) Keywords weniger umschreibt.

Tatsächlich kauft Google bei den kürzesten Suchanfragen mindestens die Hälfte der Zeit die eigentliche Meta-Beschreibung ein.

Dies deutet darauf hin, dass bei etwa 50 % der Suchanfragen Ihre Meta-Beschreibung am besten ist.

Mein Rat:

Schreiben Sie weiterhin maßgeschneiderte Meta-Beschreibungen für Ihre wichtigsten Inhalte.

Verzichten Sie aber dort auf Meta-Beschreibungen, wo das Traffic-Potenzial für Ihre Inhalte geringer ist.

Google leistet gute Arbeit bei der Erstellung relevanter Beschreibungen – die statistisch bewiesenermaßen Ihre übertreffen.

18. Experiment mit verstecktem Text

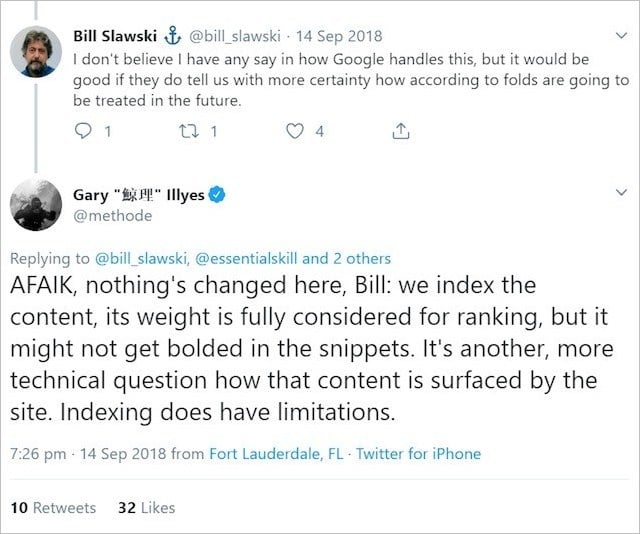

Google hat wiederholt gesagt, dass Sie, solange Sie den Text haben, den Sie auf Ihrer Webseite platzieren möchten;

Es wird „vollständig für das Ranking berücksichtigt“.

Mit anderen Worten, Sie können Text in Akkordeons, Registerkarten und anderen erweiterbaren Elementen anzeigen, und Google berücksichtigt diesen Text mit der gleichen Gewichtung wie Text, der beim Laden der Seite vollständig sichtbar ist.

Diese offizielle Google-Linie ist ein glücklicher Kompromiss für SEOs und Webentwickler, die ein Gleichgewicht zwischen textreichem Inhalt und eleganter visueller Attraktivität finden möchten.

Haben Sie eine lange Textpassage?

Platzieren Sie es einfach in einem erweiterbaren Inhaltsblock – und es ist perfekt für SEO geeignet.

Oder zumindest hat Google uns das glauben gemacht.

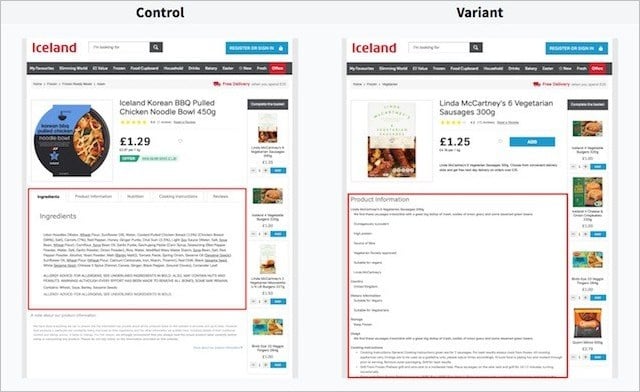

Geben Sie Search Pilot und ihr Experiment mit verstecktem Text ein.

In ihrem Experiment wollte Search Pilot die Leistung von Text in Registerkarten (das Steuerelement) im Vergleich zu Text testen, der beim Laden der Seite vollständig sichtbar ist (die Variante).

Hier sind die Seitenversionen auf dem Desktop:

Und hier sind die Seitenversionen auf Mobilgeräten;

Sie testeten diese beiden Versionen über viele Produktseiten der Website ihres Kunden und maßen die Veränderung des organischen Traffics im Laufe der Zeit.

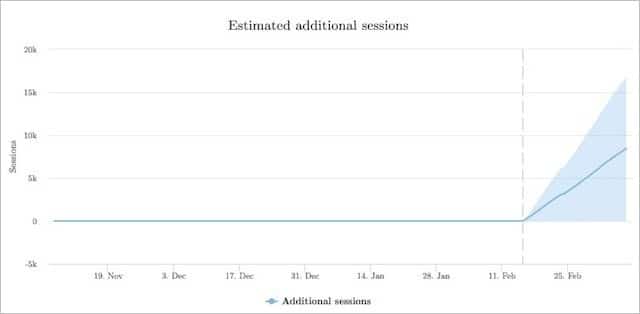

So hat sich die Variante (Text sichtbar) gegenüber dem Steuerelement (Text ist ausgeblendet) verhalten:

Die Version mit vollständig sichtbarem Text erzielte 12 % mehr organische Sitzungen als die Version mit verstecktem Text in Tabs.

Aus dem Test von Search Pilot geht hervor, dass es für Ihren organischen Traffic viel besser sein kann, wenn Ihre Inhalte auf der Seite sichtbar sind.

Search Pilot war nicht die einzige Partei, die die Hypothese testete, dass Text, der für den Benutzer sichtbar ist, mehr Gewicht beigemessen wird als Text, der außerhalb der unmittelbaren Sicht des Benutzers liegt.

Ein weiteres Experiment von Reboot ergab, dass vollständig sichtbarer Text (und Text, der in einem Textbereich enthalten ist) deutlich besser abschneidet als Text, der hinter JavaScript und CSS verborgen ist:

19. Die Seitengeschwindigkeit auf die Probe stellen (Die Ergebnisse könnten Sie überraschen)

Sie haben wahrscheinlich schon gehört, dass die Seitengeschwindigkeit ein wichtiger Rankingfaktor ist.

Es gibt buchstäblich Tausende von Blogs, die Ihnen sagen, je schneller Ihre Seite ist, desto wahrscheinlicher ist es, dass sie einen höheren Rang einnimmt.

Was ist mehr:

Vor nicht allzu langer Zeit veröffentlichte Google ein „Geschwindigkeitsupdate“, das angeblich Websites , die auf Mobilgeräten langsam geladen werden, herabstuft.

Da alle Informationen über Seitenladezeiten wichtig für höhere Rankings sind, ist die Leistung der Seitengeschwindigkeit sicherlich ein wichtiges Ranking-Signal!

Okay, lass uns nachsehen.

Genau das hat Brain Dean in seinem Seitengeschwindigkeitsexperiment auf die Probe gestellt :

Haben Sie die Ergebnisse überrascht?

20. H1-Tags und ihr Einfluss auf Rankings: Die Debatte ist abgeschlossen

Jeder SEO-Leitfaden da draußen bietet die gleichen Ratschläge:

(Wenden Sie den Titel Ihrer Seite oder Ihres Beitrags in ein H1-Tag ein)

Aber nicht alle Websites befolgen diese sogenannten Best Practices, Moz.com ist eine davon.

Seien wir ehrlich:

Moz ist eine der vertrauenswürdigsten (und am häufigsten besuchten) Websites zum Thema SEO.

Jetzt noch:

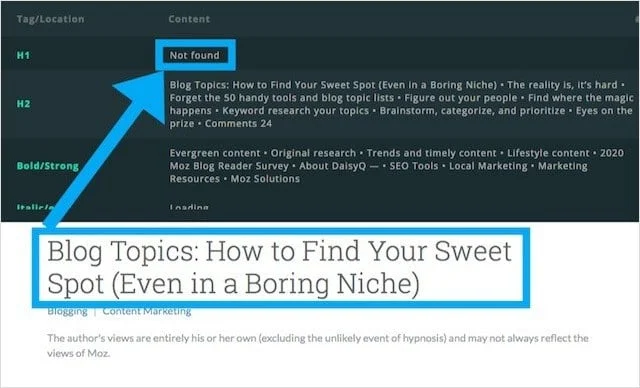

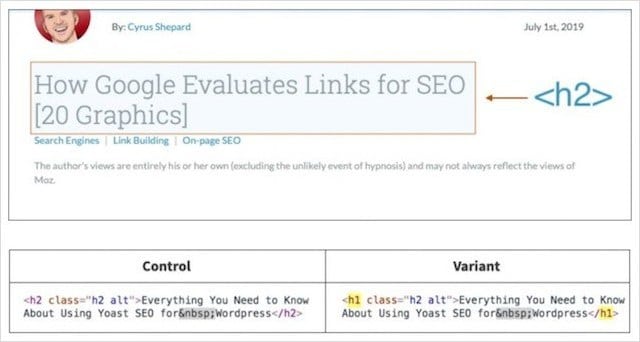

Das Blog von Moz hat kein H1-Tag und verwendet stattdessen ein H2-Tag für die Hauptüberschrift.

Nachdem Craig Bradford von Distilled bemerkt hatte, dass der Moz-Blog H2-Tags für Überschriften (anstelle von H1s) verwendete, wandte er sich an Cyrus Shepard bei Moz.

Gemeinsam beschlossen Craig und Cyrus, ein Header-Tag-Experiment durchzuführen, das hoffentlich ein für alle Mal bestimmen würde, ob H1-Tags die organischen Rankings beeinflussen.

Um dies zu tun, haben sie mit SearchPilot einen 50/50-Split-Test der Schlagzeilen des Moz-Blogs entwickelt.

Im Experiment wurde die Hälfte der Schlagzeilen von Moz in H1 geändert und die andere Hälfte als H2 beibehalten.

Cyrus und Crag maßen dann den Unterschied im organischen Traffic zwischen den beiden Gruppen.

Ergebnisse des Header-Tag-Experiments

Was ist Ihrer Meinung nach passiert, als die primären Überschriften vom falschen Überschriften-Tag (H2) in die richtige Überschrift (H1) geändert wurden?

Die Antwort:

Überhaupt nicht viel!

Nachdem sie acht Wochen lang Daten gesammelt hatten, stellten sie fest, dass die Änderung der Überschriften der Blogposts von H2s zu H1s keinen statistisch signifikanten Unterschied machte.

Was können wir daraus ableiten?

Lediglich, dass Google gleichermaßen in der Lage ist, den Kontext der Seite zu bestimmen, wenn Ihre Hauptüberschrift in H1 oder H2 eingeschlossen ist.

Bedeutet das, dass Sie jeden SEO-Best-Practice-Leitfaden aufgeben und H1s abschaffen sollten?

Nö!

Die Verwendung eines H1 als Hauptüberschrift bietet die richtige Inhaltsstruktur für Screenreading-Tools und hilft so sehbehinderten Lesern, sich besser in Ihren Inhalten zurechtzufinden.

Diesen und vier weitere, weniger bekannte Vorteile erkläre ich in meinem umfassenden Leitfaden zu Header-Tags.

Kommen wir zunächst zu unserem letzten SEO-Experiment.

21. Shared-Hosting-Experiment: Nachweis des „Bad Neighbourhood“-Effekts

Debatten über die Auswirkungen von Shared-Website-Hosting und seine Auswirkung auf Rankings haben in der SEO-Community seit Äonen gewütet.

Diese Debatten konzentrieren sich nicht nur auf den Leistungsaspekt von Shared Hosting (z. B. langsame Ladezeiten, die allgemein als negative Auswirkungen auf SEO angesehen werden), sondern auf ein Konzept, das als „schlechte Nachbarschaft“ bezeichnet wird.

Bad Neighborhoods beschreiben eine Hosting-Umgebung mit einer gemeinsamen IP und einer Sammlung von minderwertigen, nicht zusammenhängenden, bestraften und/oder potenziell problematischen (z. B. Pornos, Glücksspiele, Pillen) Websites.

Ebenso könnten Sie negative Auswirkungen haben, wenn Sie auf Spam-Websites verlinken oder Links von diesen erhalten;

Viele glaubten, dass das Finden Ihrer Website auf demselben Server wie minderwertige oder nicht verwandte Websites ähnliche Rank- Crushing-Effekte haben könnte.

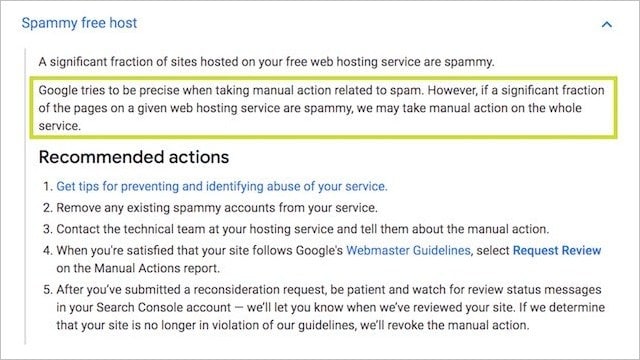

Diese Idee hat Substanz:

Googles eigene Dokumentation zu manuellen Maßnahmen besagt, dass alle Websites auf einem Server aufgrund des Rufs einiger Websites „bestraft“ werden könnten:

Es ist auch wahrscheinlich, dass die Algorithmen von Google nach Mustern bei Websites mit geringer Qualität suchen – und kostenloses/billiges Shared Hosting ist möglicherweise eines davon .

Seien wir ehrlich;

Finden Sie eher eine Wegwerf-PBN-Site auf einem billigen Shared-Hosting-Konto für 10 Dollar pro Monat oder einen dedizierten Premium-Server für 200 Dollar oder mehr?

Du verstehst es.

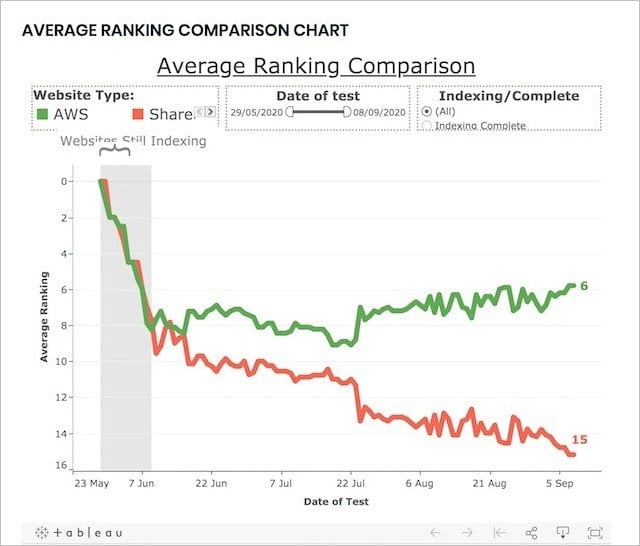

Um die Leistung von Shared Hosting (viele Websites auf einer IP) im Vergleich zu dediziertem Hosting (einzelne IP für eine Website) zu testen, führte Reboot dieses SEO-Experiment durch.

Langzeit-Shared-Hosting-Experiment:

Um das Experiment durchzuführen, erstellte Reboot Online 20 Websites – alle auf brandneuen .co.uk-Domains und mit einzigartigen, aber ähnlich optimierten Inhalten:

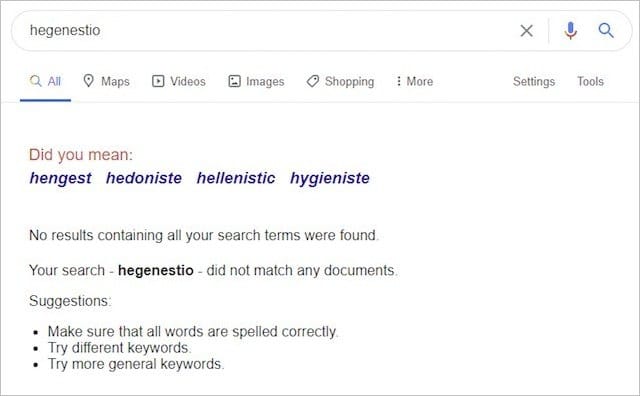

Alle zwanzig Websites zielten auf dasselbe Keyword („hegenestio“) ab, das vor dem Experiment keine Ergebnisse bei Google hatte:

Dann platzierten sie zehn Websites auf dedizierten AWS-Servern und zehn auf gemeinsam genutzten Servern, von denen einige Websites mit schlechter Nachbarschaft wie diese enthielten:

Und das:

Und nach der Indexierung überwachten die Websites ihre Platzierungen über einen Zeitraum von drei Monaten.

Um sicherzustellen, dass das Experiment nicht durch andere Faktoren beeinflusst werden kann, hat Reboot Folgendes getan:

- Sichergestellt, dass auf allen Domains keine vorherigen Inhalte von Google indexiert wurden.

- Alle Websites mit statischem HTML, aber unterschiedlichem CSS erstellt.

- Die Ladezeit jeder Website wurde regelmäßig gemessen, um sicherzustellen, dass sie kein Einflussfaktor war.

- Verwendet StatusCake, um die Verfügbarkeit der Websites täglich zu überprüfen.

- Geben Sie jeder Website einen einfachen, ähnlichen Meta-Titel und keine Meta-Beschreibung.

Diese Schritte wurden eingeführt, um zu zeigen, dass Geschwindigkeit, Zuverlässigkeit, Konsistenz, Inhalt, Code und Betriebszeit der Websites keinen Einfluss auf die Rankings hatten.

Okay, was ist passiert?

Am Ende des Experiments waren die Ergebnisse klar und schlüssig:

Websites mit einer dedizierten IP-Adresse rangierten VIEL besser als die mit einer gemeinsamen IP-Adresse.

Tatsächlich enthielten die Top-Ten-Ergebnisse für das erfundene Keyword am Ende des Experiments 80 % bis 90 % Websites mit dedizierten IPs:

Die Ergebnisse dieses Experiments deuten offensichtlich darauf hin, dass das Hosten Ihrer Website in einer gemeinsam genutzten Hosting-Umgebung (mit toxischen und minderwertigen Websites) einen nachteiligen Effekt auf Ihre organische Leistung haben kann.

Angesichts der Tatsache, dass alle anderen Ranking-Signale um wie viel entfernt wurden, wissen wir zu diesem Zeitpunkt nicht.

Wir können sicher sein, dass Shared Hosting isoliert ein negativer Faktor ist UND wenn Sie es mit Ihrem Geschäft ernst meinen, ist ein anständiger (dedizierter) Server der richtige Weg .

Fazit

Diese 21 SEO-Experimente lieferten einige sehr unerwartete Ergebnisse.

Einige haben sogar das, was wir über SEO für richtig hielten, komplett auf den Kopf gestellt.

Es beweist nur, dass wir bei so wenig Wissen über das Innenleben von Googles Algorithmus unbedingt testen müssen.

Nur durch Tests können wir sicher sein, dass die SEO-Strategien, die wir implementieren, tatsächlich zu Ergebnissen führen.

Wir beenden diesen Beitrag mit einer Erklärung, wie SEO-Tests durchgeführt werden, damit auch Sie SEO-Experimente durchführen und valide (vielleicht sogar bahnbrechende) Testergebnisse erhalten können.

Ein besonderer Dank geht an Eric Enge für diesen Beitrag:

„Wir investieren viel Energie in jeden Test, den wir durchführen. Dies liegt vor allem daran, dass eine solide Testarbeit erfordert, dass Sie verwirrende Variablen gründlich entfernen und sicherstellen, dass die Datengröße Ihrer Stichprobe ausreichend ist.

Einige der wichtigsten Dinge, die wir zu tun versuchen, sind:

1. Holen Sie sich eine einigermaßen große Datenprobe.

2. Scrubben Sie die Testparameter, um Faktoren zu entfernen, die den Test ungültig machen. Wenn wir beispielsweise versuchen zu testen, ob Google eine bestimmte Methode zum Indexieren einer Seite verwendet, müssen wir beispielsweise sicherstellen, dass nichts auf diese Seite verweist und dass im HTML dieser Seite keine Google-Tools referenziert werden (z. B. Google Analytics, AdSense, Google Plus, Google Tag Manager, …).

3. Sobald Sie die Ergebnisse haben, müssen Sie die Daten die Geschichte erzählen lassen. Als Sie mit dem Test begonnen haben, haben Sie wahrscheinlich ein bestimmtes Ergebnis erwartet, aber Sie müssen darauf vorbereitet sein, herauszufinden, dass Sie sich geirrt haben.

Kurz gesagt, es ist viel Arbeit, aber für uns rechtfertigen die Ergebnisse den Aufwand!“

Da haben Sie es also …

21 SEO-Experimente und ihre unerwarteten Ergebnisse. Was sollte Ihrer Meinung nach noch getestet werden?

Welches Ergebnis des SEO-Experiments hat Sie am meisten überrascht?

Sag es mir in den Kommentaren unten.