21 expériences de référencement qui changeront votre façon de penser le référencement (pour toujours)

Publié: 2020-11-10 Je pense que vous serez d'accord avec moi quand je dis :

Je pense que vous serez d'accord avec moi quand je dis :

Il y a PLUS d'idées fausses autour du SEO…

… que presque tous les autres aspects du marketing numérique.

Et ce n'est pas surprenant si l'on considère qu'il existe plus de 200 facteurs de classement , mais presque tous sont entourés de secret.

Étant donné que Google ne partage pas (et ne partagera probablement jamais) le fonctionnement interne de son algorithme, comment savez-vous ce qui fonctionne vraiment ?

Comment déchiffrez-vous les mythes SEO de la matière et les ouï-dire du fait ?

Vous vous tournez vers la science, c'est quoi !

BONUS : Téléchargez chaque expérience de référencement contenue dans cet article sous forme de guide PDF pratique que vous pouvez imprimer ou enregistrer sur votre ordinateur.

Dans cet article, je vais partager avec vous 21 expériences SEO incroyables (mises à jour pour l'année 2021) qui remettront en question ce que vous pensiez être vrai sur l'optimisation des moteurs de recherche.

J'irais même jusqu'à prédire que ces études de référencement changeront à jamais votre façon de faire du référencement.

Es-tu prêt? Parce que tout est sur le point de changer pour vous.

Bon, allons-y :

1. Le taux de clics affecte les classements organiques (et comment l'utiliser à votre avantage)

Cette première expérience est un doozy.

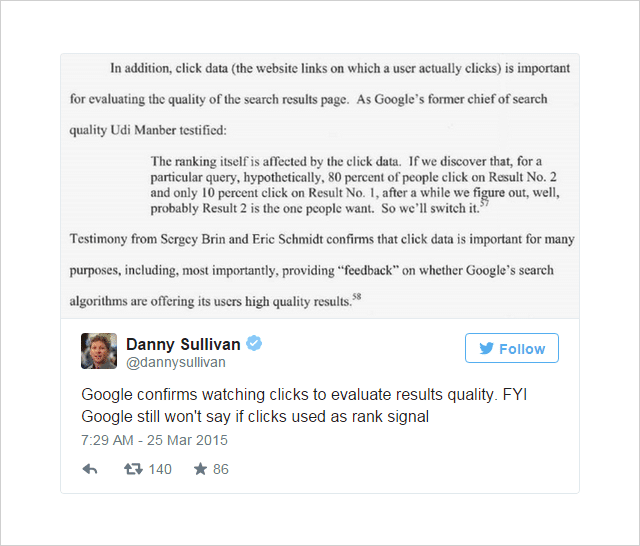

Depuis un certain temps, il existe une opinion dans le monde du référencement selon laquelle le taux de clics (CTR) peut influencer le classement de la recherche.

L'opinion était alimentée par des indices solides (mais pas concluants) de l'intérieur de Google :

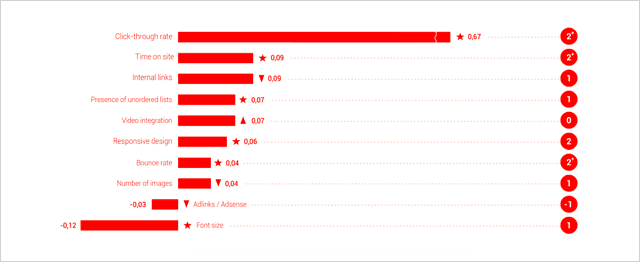

Et, les études sur les facteurs de classement de Searchmetrics ont de plus en plus considéré le CTR comme l'un des facteurs de classement les plus importants.

(Basé sur la corrélation, pas sur la causalité, l'esprit)

L'argument, comme le souligne Jamie Richards, est qu'un site Web recevant un taux de clics plus élevé que les sites Web au-dessus de lui, peut se signaler comme un résultat plus pertinent et inciter Google à le déplacer vers le haut dans les SERP.

L'idée discutée par WordStream ici s'apparente au niveau de qualité attribué aux annonces AdWords - un facteur déterminé en partie par le taux de clics relatif d'une annonce par rapport aux autres annonces qui l'entourent.

C'est l'idée que Rand Fishkin de Moz a entrepris de tester dans des expériences consécutives.

Numéro un : test de volume de requêtes et de clics

Le scénario de test utilisé par Rand Fishkin était assez simple.

- Demandez à un groupe de personnes de rechercher une requête spécifique sur Google.

- Demandez à ces personnes de cliquer sur un résultat particulier.

- Enregistrez les changements dans le classement pour déterminer si l'augmentation du volume de clics sur ce résultat influence sa position.

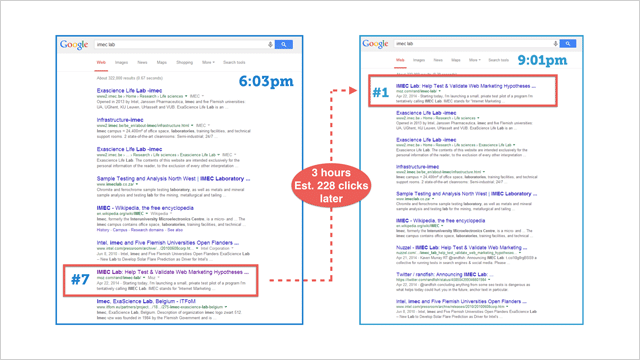

Pour lancer le bal, Rand a envoyé ce Tweet à ses 264 000 abonnés sur Twitter :

Souhaitez-vous aider avec une théorie ou un test Google ? Pourriez-vous rechercher "IMEC Lab" dans Google et cliquer sur le lien de mon blog ? J'ai une intuition.

— Rand Fishkin (@randfish) 1 mai 2014

Sur la base des données de Google Analytics, Rand estime que 175 à 250 personnes ont répondu à son appel à l'action et ont cliqué sur le résultat IMEC.

Voici ce qui s'est passé :

La page a atteint la position #1.

Cela indique clairement (au moins dans ce cas particulier) que le taux de clics influence de manière significative les classements .

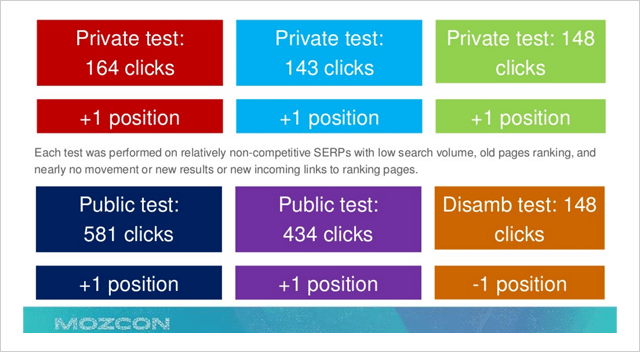

Dans une tentative de valider ces données, ce qui a suivi était une série de tests répétés qui ont montré une tendance globale à la hausse lorsque le volume de clics vers un résultat particulier a augmenté.

Malheureusement, cette fois, les données étaient beaucoup moins dramatiques et concluantes.

Pourquoi cela pourrait-il être?

Rand craignait qu'en réponse à son message public montrant comment les clics peuvent influencer les résultats de Google plus directement qu'on ne le pensait auparavant, Google pourrait avoir resserré ses critères autour de ce facteur particulier.

Pourtant, il ne s'est pas découragé...

Numéro 2 : test de volume de requêtes et de clics

Inspiré par une bouteille de whisky Sullivans Cove lors d'une pause lors d'un match de Coupe du monde, Rand Fishkin a envoyé un autre tweet :

Que devez-vous faire pendant cette accalmie du match de Coupe du monde ? Aidez-moi à faire un test ! Prend <30 secondes : http://t.co/PxXWNlVdTi

— Rand Fishkin (@randfish) 13 juillet 2014

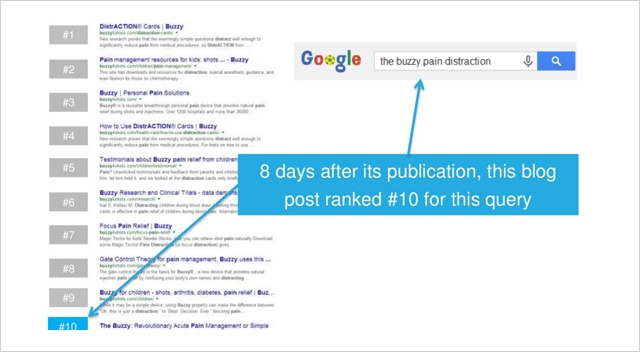

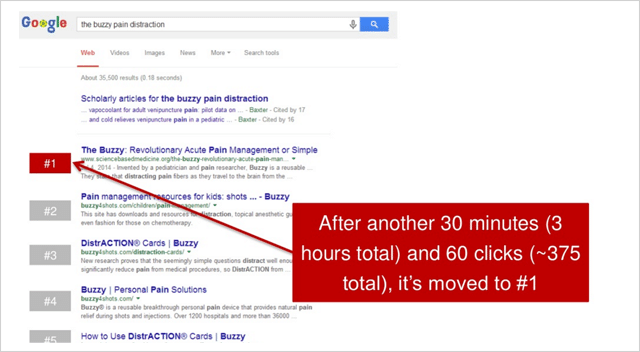

Le tweet indiquait à ses abonnés certaines instructions de base qui demandaient aux participants de rechercher «la distraction de la douleur bourdonnante», puis de cliquer sur le résultat pour sciencebasedmedicine.org.

Voici où le site Web cible apparaissait avant le début du test :

Au cours des 2,5 heures qui ont suivi le tweet initial de Rand, 375 participants au total ont cliqué sur le résultat.

L'effet a été dramatique.

sciencebasedmedicine.org est passé du numéro dix à la première place sur Google.

Eurêka !

Cet événement miraculeux, à son tour, a déclenché une réaction en chaîne…

Ce qui s'est terminé par ce moment de célébration pour Rand :

Il semble donc que le volume de clics (ou le taux de clics relatif) ait un impact sur le classement de recherche. Alors qu'il y a des gens comme Bartosz Goralewicz qui s'y opposent, je crois que c'est vrai.

Il y a plusieurs raisons pour lesquelles Google considérerait le taux de clics comme un signal de classement en dehors des signaux traditionnels comme le contenu et les liens.

Cette vidéo Whiteboard Friday fournit une excellente explication des raisons :

Le cas est donc convaincant, le taux de clics affecte certainement le classement de recherche de Google.

Une étude ultérieure de Larry Kim semble suggérer que si vous battez le taux de clics attendu de 20%, vous monterez en grade.

Super, c'est très bien.

Mais comment utilisez-vous ces informations à votre avantage ?

Voici 4 étapes d'action qui vous montreront exactement cela :

(1) Optimisez votre taux de clics - Pour ce faire, créez des titres de page et des méta descriptions convaincants pour vos pages qui vendent les gens en cliquant sur votre résultat par rapport à ceux qui le précèdent.

(2) Construisez votre marque – Une marque établie et reconnaissable attirera plus de clics. Si les utilisateurs connaissent votre marque (et, espérons-le, l'aiment et lui font également confiance), vous aurez plus de visibilité dans les SERP.

(3) Optimisez pour les clics longs - Ne vous contentez pas d'optimiser pour obtenir des clics, concentrez-vous sur le maintien des utilisateurs sur votre site pendant une longue période. Si vous obtenez plus de clics, mais que ces utilisateurs reviennent simplement aux résultats, tout avantage que vous avez obtenu d'un CTR plus élevé sera annulé.

(4) Utilisez de véritables tactiques - Les effets d'un pic soudain du CTR (tout comme l'expérience de Rand) ne dureront que peu de temps. Lorsque les taux de clics normaux reviendront, votre position de classement précédente le sera également. Utilisez les éléments 1 et 2 pour des résultats durables.

2. L'industrie s'est trompée. Mobilegeddon était énorme

Mobilegeddon était le nom non officiel donné à la mise à jour mobile de Google avant sa sortie le 21 avril 2015.

La mise à jour devait faire monter en flèche les classements de recherche mobile pour les sites Web lisibles et utilisables sur les appareils mobiles.

Il était prévu de couler des sites Web non adaptés aux mobiles.

Certaines personnes disaient même que ce serait un événement cataclysmique plus important que Google Penguin et Panda.

Pendant des mois, les webmasters se sont efforcés de mettre de l'ordre dans leurs sites. À l'approche de la journée, la ruée s'est transformée en panique lorsque les propriétaires de sites ont réalisé que leurs sites Web avaient échoué au test de compatibilité mobile de Google.

Que s'est-il donc passé le 21 avril 2015 ? Des millions de sites Web sont-ils tombés dans l'abîme de la recherche mobile ?

Selon la plupart des rapports, il ne s'est pas passé grand-chose.

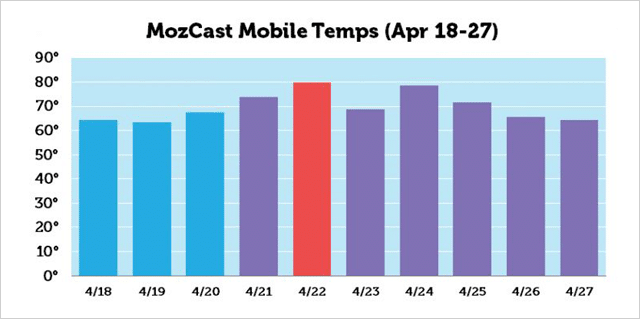

Bien sûr, il y a eu un pic d'activité vers le 22 avril selon MozCast, mais les changements de classement étaient loin d'être aussi importants que la plupart des SEO le pensaient.

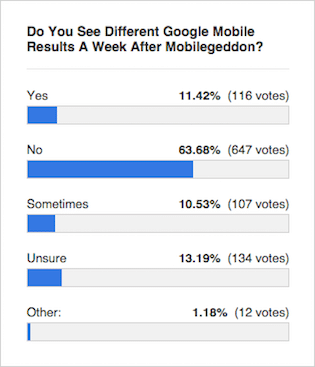

Le consensus des experts comme ce sondage de la table ronde sur les moteurs de recherche était que les résultats étaient à peu près inchangés :

Mais que montrent les résultats des tests ?

Mais que montrent les résultats des tests ?

Entrez Eric Enge et l'équipe de Stone Temple Consulting…

Étude de classement Mobilegeddon

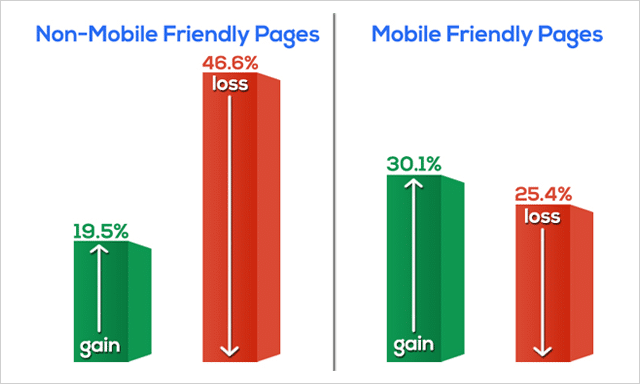

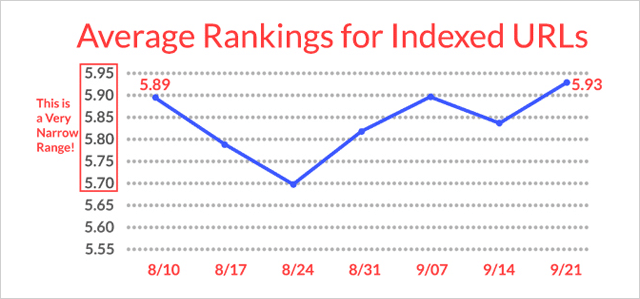

La semaine du 17 avril 2015 (avant Mobilegeddon), Stone Temple a extrait des données de classement sur les 10 premiers résultats pour 15 235 requêtes de recherche. Ils ont de nouveau extrait des données sur les mêmes 15 235 requêtes de recherche la semaine du 18 mai 2015 (après Mobilegeddon).

Ils ont enregistré les positions de classement et ont également identifié si les slugs d'URL dans les résultats étaient ou non désignés comme Mobile Friendly par Google ou non.

Voici ce qu'ils ont trouvé :

Les pages Web non adaptées aux mobiles ont considérablement perdu leur classement.

En fait, près de 50 % de toutes les pages Web non adaptées aux mobiles ont abandonné les SERP.

Les pages adaptées aux mobiles (dans l'ensemble) ont gagné en classement.

Les données qu'Eric et l'équipe ont recueillies lors de leur test Mobilegeddon vont clairement à l'encontre de l'opinion générale de la presse spécialisée.

Pourquoi la presse s'est-elle trompée ?

Il est probable que parce que la mise à jour de l'algorithme a été déployée lentement au fil du temps, il n'était pas immédiatement évident que des mouvements aussi importants se produisaient.

En outre, une mise à jour de la qualité a été publiée au cours de la même période, ce qui a peut-être brouillé les effets de Mobilegeddon sur les classements de recherche.

Alors, résumons rapidement Mobilegeddon avec trois points;

- C'était un gros problème.

- Si vous n'êtes pas encore « mobile », qu'attendez-vous ?

- Si vous ne savez pas si votre site Web est adapté aux mobiles ou non, faites ce test.

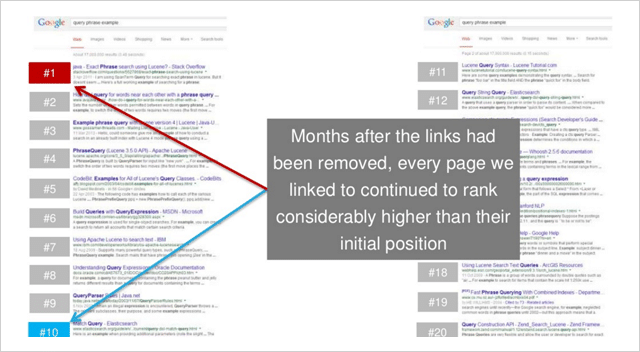

3. Link Echoes : comment fonctionnent les backlinks même après leur suppression

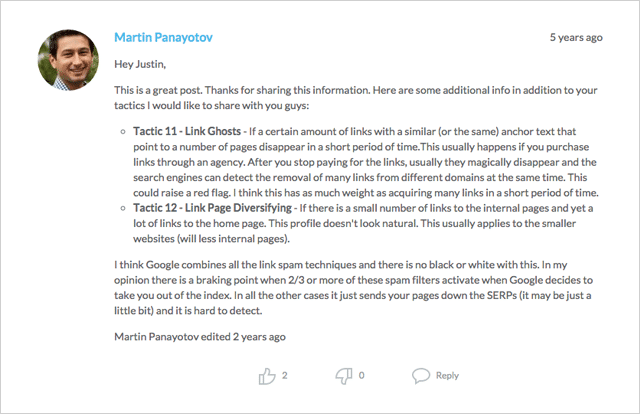

Crédit là où le crédit est dû.

L'idée des « échos de liens » (ou des « fantômes de liens », comme on les appelle également) a été identifiée pour la première fois par Martin Panayotov et aussi Mike King d'iPullRank dans les commentaires de ce post.

L'idée est que Google continuera à suivre les liens et à considérer la valeur de ceux-ci (positifs ou négatifs) même après la suppression des liens.

Si tel est le cas, un site Web dont le classement a augmenté après l'ajout d'un lien continue-t-il à se classer après la suppression du lien ?

Voyons voir.

Cette expérience particulière a été réalisée par l'équipe de Moz et faisait partie d'une série visant à tester l'effet des liens de texte d'ancrage riches (voir l'expérience SEO numéro 8) sur les classements de recherche.

Mais, comme c'est souvent le cas en science, les expériences ont abouti à des découvertes tout à fait inattendues.

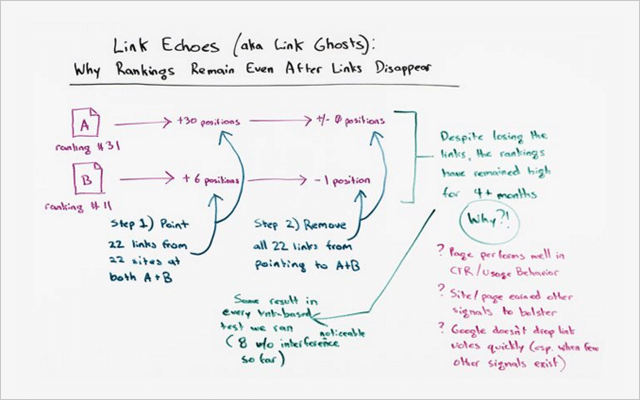

L'effet d'écho de lien

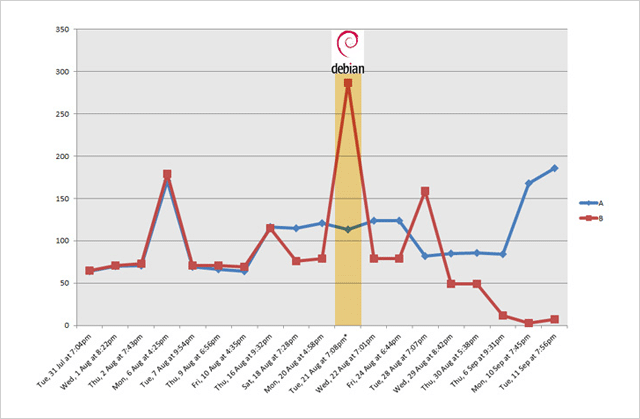

Il y avait 2 sites Web dans cette expérience ; Site Web A et site Web B.

Avant le test, voici comment ils se sont classés pour le même (mot clé peu compétitif):

- Site Web A – position 31

- Site Web B – position 11

Au cours du test, des liens ont été ajoutés à 22 pages sur divers sites Web pointant à la fois vers le site Web A et le site Web B.

Les deux sites Web, qui ont reçu 22 liens chacun, ont ensuite grimpé en flèche dans le classement :

- Le site Web A est passé de la position 31 à la position 1 (une augmentation de +30 positions)

- Le site Web B est passé de la position 11 à la position 5 (et augmentation de +6 positions)

En bref, les deux sites Web ont considérablement augmenté leur classement lorsque des liens ont été ajoutés.

Mais que s'est-il passé lorsque ces mêmes liens ont été supprimés ?

Répondre. Très peu du tout.

Le site Web A est resté en position numéro 1.

Le site Web B a légèrement chuté à la position 6 (une petite baisse de seulement 1 position)

Cette expérience valide l'hypothèse.

Il semble qu'une certaine valeur des liens (peut-être beaucoup) reste, même après la suppression des liens.

Cette expérience aurait-elle pu être un cas isolé ?

Pas selon Rand Fishkin :

"Cet effet de ces tests de lien, restant en place longtemps après la suppression du lien, s'est produit dans chaque test de lien que nous avons exécuté, dont j'en ai compté huit où je suis très confiant qu'il n'y avait pas de variables de confusion, se sentant vraiment bien que nous suivi un processus un peu comme celui-ci. Les liens pointaient, le classement montait. Les liens ont disparu, le classement est resté élevé.

Mais, voici ce qui est si remarquable…

Ces classements plus élevés n'ont pas été de courte durée.

Ils sont restés plusieurs mois après la suppression des liens.

Au moment de cette vidéo, les résultats étaient restés vrais pendant 4,5 mois.

En outre…

"Pas dans un seul test lorsque les liens ont été supprimés, les classements ne sont revenus à leur position d'origine", déclare Rand Fiskin.

Il y a plusieurs leçons que vous pouvez en tirer, mais je vais m'arrêter à ces deux :

(1) Les liens de qualité valent leur pesant d'or . Comme un investissement solide, les backlinks continueront à vous donner un bon retour. L'« écho » d'un vote une fois exprimé (comme le prouve ce test) offrira des avantages même lorsqu'il est supprimé.

(2) La valeur des liens DO reste pendant un certain temps . Donc, avant de vous laisser tenter par l'acquisition de liens illégitimes, demandez-vous si vous êtes prêt à conserver cette empreinte pendant des mois (voire des années) à venir.

En bref, passez votre temps à vous concentrer sur la construction de liens organiques naturels.

Les liens peuvent fonctionner pour vous ou contre vous. Alors, assurez-vous que c'est le premier.

À court de stratégies de création de liens ?

Consultez cet article qui contient des dizaines d'idées pour vous aider à démarrer.

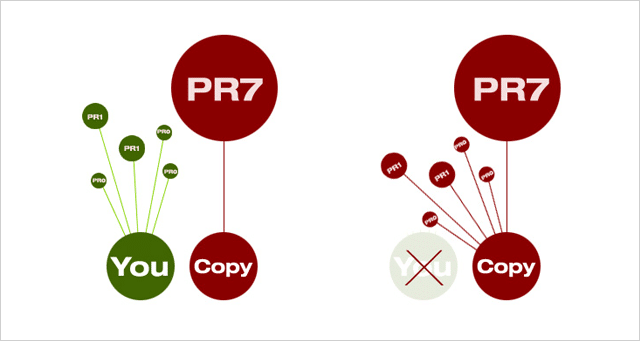

4. Vous pouvez classer avec du contenu en double. Fonctionne même sur des mots-clés concurrents

Divulgation complète, ce que je suis sur le point de partager avec vous ne fonctionnera peut -être que pendant une courte période. Mais, pour le moment où ça marche, ça marche comme des gangbusters.

D'abord la théorie.

Lorsqu'il y a deux documents identiques sur le Web, Google sélectionne celui avec un PageRank plus élevé et l'utilise dans les résultats de recherche.

Il transmettra également tous les liens de tout « duplicata » perçu vers le document « principal » sélectionné.

Pourquoi fait-il cela ?

À moins qu'il n'y ait une raison valable pour deux versions ou plus du même contenu, une seule doit exister.

Et, qu'est-ce que cela signifie pour vous?

Cela signifie que si vous créez un contenu unique et faisant autorité (qui attire des liens et des partages de qualité), vous devriez être le meilleur. Google conservera votre version dans l'index et pointera tous les liens destinés aux doublons vers votre site.

La mauvaise nouvelle (pour les gentils du moins), ce n'est pas toujours le cas.

De temps en temps, un site plus grand et plus autoritaire dépassera les sites Web plus petits dans les SERP pour leur propre contenu.

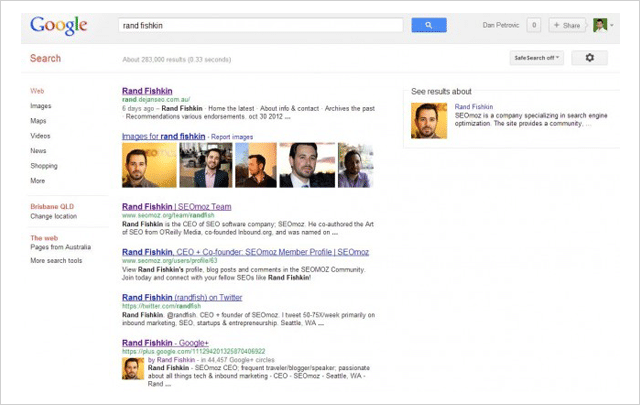

C'est ce que Dan Petrovic de Dejan SEO a décidé de tester dans sa désormais célèbre expérience de détournement de SERP.

À l'aide de quatre pages Web distinctes, il a testé si le contenu pouvait être « détourné » des résultats de recherche en le copiant et en le plaçant sur une page PageRank plus élevée, qui remplacerait alors l'original dans les SERP.

Voici ce qui s'est passé :

- Dans les quatre tests, la page de copie PR la plus élevée a battu l'original .

- Dans 3 cas sur 4, la page d'origine a été retirée des SERP .

Ses tests prouvent qu'une page PageRank supérieure battra une page PageRank inférieure avec le même contenu, même si la page PR inférieure est la source d'origine.

Et, même si la page originale a été créée par l'ancien magicien de Moz lui-même, Rand Fishkin.

( Image: Rand Fishkin a été surclassé pour son propre nom dans l'expérience de Dan Petrovic.)

Alors la question se pose, que pouvez-vous faire pour empêcher votre propre contenu d'être piraté ?

Bien qu'il n'y ait aucune garantie que vous puissiez empêcher que votre propre contenu durement gagné soit copié puis battu, Dan propose les mesures suivantes qui peuvent vous aider à vous défendre contre les voleurs de contenu :

(1) Ajoutez la balise rel="canonical" à votre contenu en utilisant le texte http:// complet.

(2) Lien vers des pages internes sur votre propre site Web.

(3) Ajoutez le balisage Google Authorship.

(4) Vérifiez régulièrement le contenu en double à l'aide d'un outil comme Copyscape.

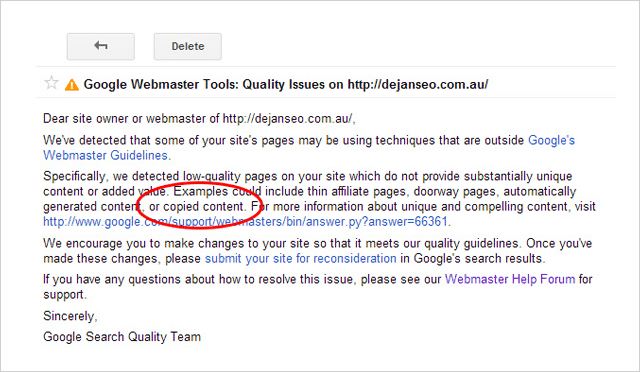

Attention aux plagiaires

Ce n'est pas parce que vous pouvez battre vos concurrents en volant leur contenu que vous devriez .

Non seulement il est contraire à l'éthique et carrément louche de revendiquer le contenu de quelqu'un d'autre comme le vôtre, mais le plagiat peut également vous causer des ennuis.

Peu de temps après avoir exécuté l'expérience, Dejan SEO a reçu un message d'avertissement dans son compte Google Search Console.

Le message citait le domaine dejanseo.com.au comme ayant des pages de mauvaise qualité, dont un exemple est le "contenu copié". À peu près au même moment, l'une des pages de test de copie a également cessé de s'afficher dans les SERP pour certains termes.

Cela a forcé Dan à supprimer les pages de test afin de résoudre le problème de qualité de son site.

Il semble donc que même si vous pouvez battre vos concurrents avec leur propre contenu, ce n'est certainement pas une bonne idée de le faire.

5. Le numéro un n'est PAS la "meilleure" place (et ce qui est maintenant)

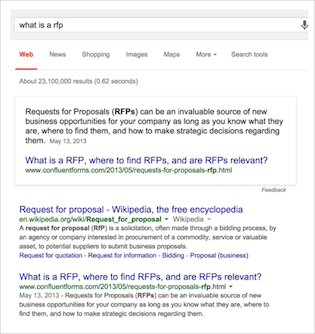

Dans ce test, Eric Enge et l'équipe de Stone Temple Consulting (qui fait maintenant partie de Perficient) ont entrepris de mesurer l'évolution de l'affichage des réponses enrichies dans les résultats de recherche de Google.

Juste au cas où vous ne seriez pas familier avec la terminologie…

Les réponses enrichies sont les réponses « dans la recherche » à vos requêtes que vous avez probablement vues plus souvent ces derniers temps. Ils visent à répondre à votre requête sans que vous ayez à cliquer sur un site Web.

Il existe de nombreuses variétés de réponses enrichies telles que celle-ci :

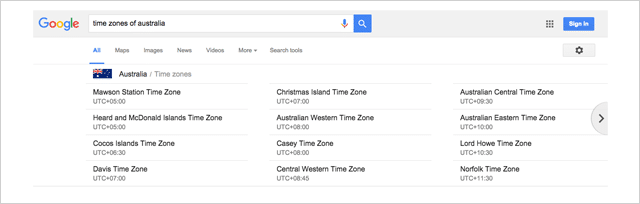

Ou ce carrousel qui s'est affiché pour moi lorsque j'ai cherché "fuseaux horaires d'australie"

Il existe littéralement des dizaines de variantes, dont beaucoup sont partagées par Google ici.

Stone Temple Consulting Étude Rich Answers

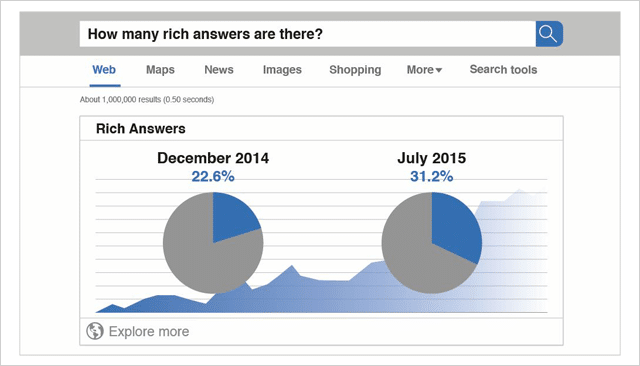

Les données de base de cette étude ont été recueillies en décembre 2014.

Au total, 855 243 requêtes ont été analysées.

Sur le nombre total de requêtes mesurées à ce moment-là, 22,6 % affichaient des réponses enrichies.

Plus tard en juillet 2015, les mêmes 855 243 requêtes ont été analysées à nouveau.

À cette époque (seulement 7 mois plus tard), le pourcentage total de requêtes affichant des réponses enrichies était passé à 31,2 %.

Étant donné que l'étude de Stone Temple Consulting a mesuré exactement les mêmes 855 243 requêtes, la comparaison entre ces deux ensembles de données est une comparaison stricte de pomme à pomme.

Les données sont claires.

Les réponses enrichies sont en augmentation et les résultats que vous voyez aujourd'hui sont bien loin des dix liens bleus du passé.

( Source : Quicksprout)

La vue changeante dans les résultats de recherche

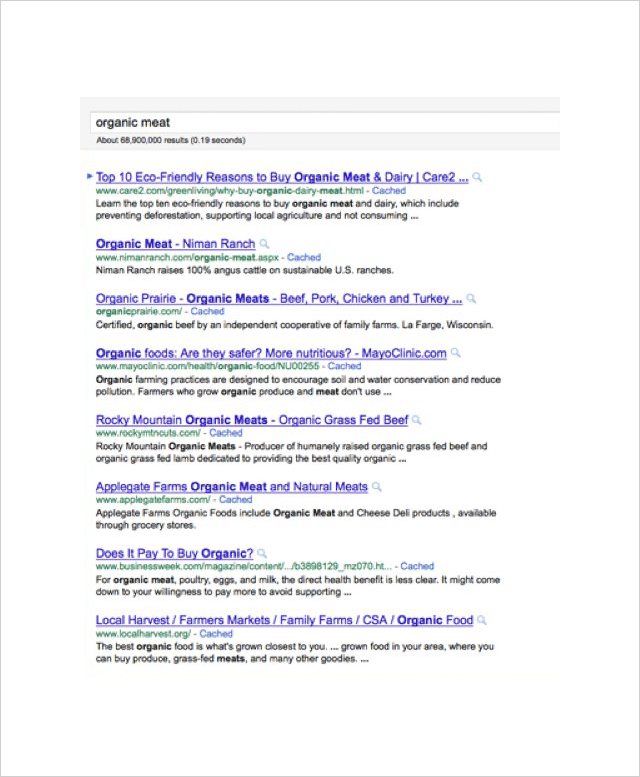

Lorsque les pages de résultats des moteurs de recherche n'étaient qu'une liste de sites Web classés en fonction de leur pertinence par rapport à une requête, il était clair que les propriétaires de sites Web feraient tout ce qu'ils pouvaient pour gagner la première place.

Plus vous montez dans les rangs, plus vous avez de clics.

Selon cette étude réalisée par Erez Barak chez Optify, en 2011, le site Web le mieux classé recevrait jusqu'à 37% du nombre total de clics.

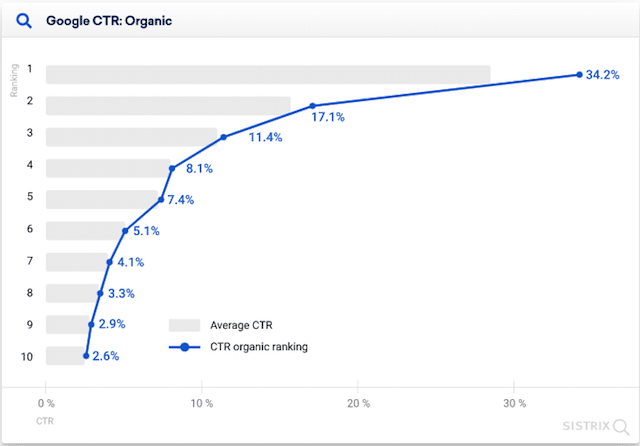

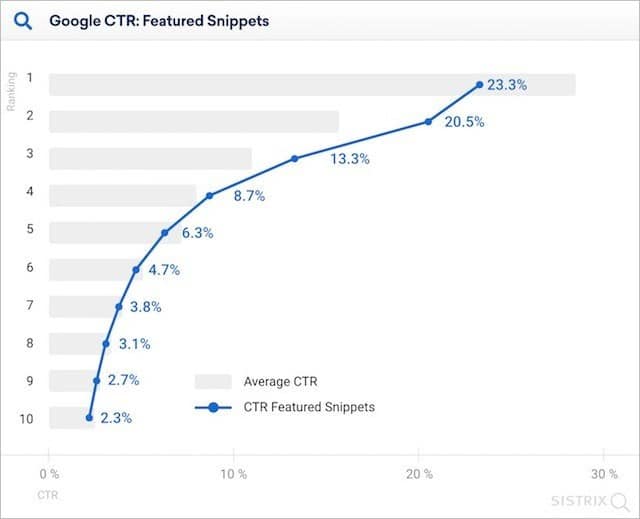

Même aussi récemment qu'en 2020, Sistrix a rapporté dans ses recherches que les sites les mieux classés (où aucun extrait de code n'est affiché) génèrent plus du double du nombre de clics par rapport aux sites Web de deuxième rang.

Mais, avec la croissance de Rich Answers, tout cela est en train de changer.

Le résultat organique "numéro un" est poussé de plus en plus bas sur la page. Les volumes de clics pour la « première place » sont en baisse.

Mais dans quelle mesure les réponses enrichies affectent-elles les taux de clics ?

La réponse courte est beaucoup.

Dans son étude de 2020, Sistrix a déterminé qu'en présence d'un extrait en vedette, le résultat Web numéro un obtenait 23,3 % des clics.

C'est onze pour cent de moins que lorsqu'il n'y a pas d'extrait de code.

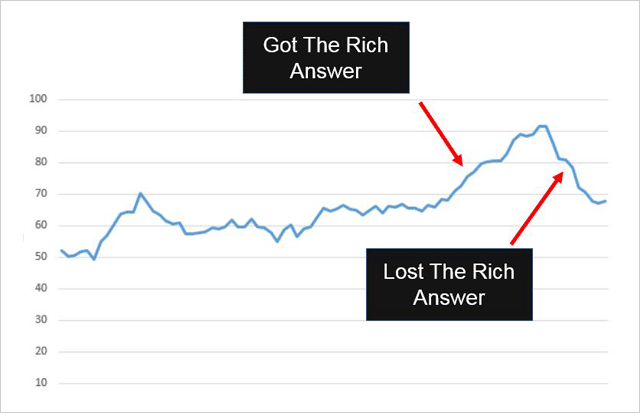

Il est clair de voir comment l'inclusion (et la suppression) d'une réponse d'extrait enrichi dans les SERP peut affecter le trafic de recherche global vers un site Web.

Voici un exemple :

Confluent Forms a obtenu un résultat Rich Snippet répertorié sur son site Web et voici ce qui est arrivé à son trafic :

Il a augmenté une fois que la réponse enrichie a été ajoutée.

Il a disparu lorsque la réponse enrichie a été supprimée.

Et, rappelez-vous ceci…

Les réponses enrichies sont destinées à résoudre les requêtes à partir des résultats de recherche. Pourtant, ils peuvent toujours envoyer du trafic supplémentaire vers votre site , tout comme ils l'ont fait pour Confluent Forms.

Comment utiliser les réponses enrichies à votre avantage

Les réponses enrichies sont généralement fournies pour les requêtes de recherche basées sur des questions.

Et, selon Eric Enge (qui a réussi à obtenir une réponse riche pour son propre site Web), répondre aux questions est la meilleure façon de procéder.

Si vous souhaitez bénéficier de Rich Answers (et qui ne le ferait pas), je vous suggère de suivre ses conseils :

(1) Identifiez une question simple - Assurez-vous que la question est sur le sujet. Vous pouvez vérifier cela en utilisant un outil de pertinence tel que nTopic.

(2) Fournissez une réponse directe - Assurez-vous que votre réponse est simple, claire et utile pour les utilisateurs et les moteurs de recherche.

(3) Offrez des informations à valeur ajoutée - En plus de votre réponse concise à la question, incluez plus de détails et de valeur. Assurez-vous de ne pas simplement re-citer Wikipedia car cela ne vous mènera pas très loin.

(4) Facilitez la recherche pour les utilisateurs et Google - Cela peut signifier le partager avec vos abonnés sur les réseaux sociaux ou y accéder à partir de vos propres sites Web ou de tiers.

6. L'utilisation de HTTPS peut en fait nuire à votre classement

Sécurisez votre site Web ou autre.

C'est le message que Google a présenté dans cet article de blog lorsqu'il a déclaré HTTPS comme signal de classement.

Et ça aurait du sens non ?

Les sites Web utilisant HTTPS sont plus sécurisés. Google veut que les sites auxquels les gens accèdent à partir du moteur de recherche soient sûrs. Les sites utilisant HTTPS devraient bénéficier d'un meilleur classement.

Mais voici la chose. Ils ne le font pas.

(C'est si l'étude de Stone Temple Consulting et seoClarity est quelque chose à faire.)

L'étude HTTPS a suivi les classements sur 50 000 recherches de mots clés et 218 000 domaines. Ils ont surveillé ces classements au fil du temps et observé quelles URL dans les SERP sont passées de HTTP à HTTPS.

Sur les 218 000 domaines suivis, seuls 630 (0,3%) d'entre eux sont passés au HTTPS.

Voici ce qui est arrivé aux sites Web HTTPS :

Ils ont en fait perdu le classement .

Plus tard, ils ont récupéré (lentement) à peu près là où ils avaient commencé.

À peine une raison de sauter dans le train en marche HTTPS.

Il semble que HTTPS (bien que Google veuille le rendre standard partout sur le Web) n'a aucun avantage de classement significatif pour l'instant et peut en fait nuire à votre classement à court terme.

Mon conseil : Continuez à utiliser HTTP sauf si vous avez vraiment besoin de changer.

7. Robots.txt NoIndex ne fonctionne pas (toujours)

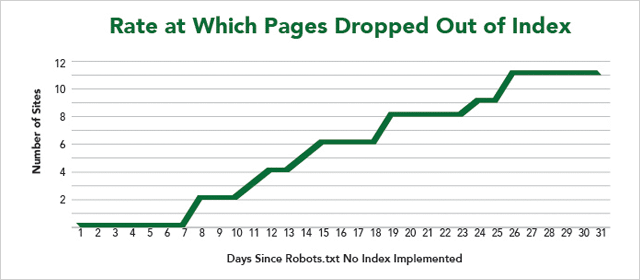

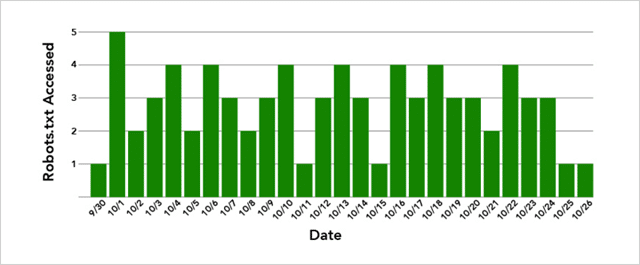

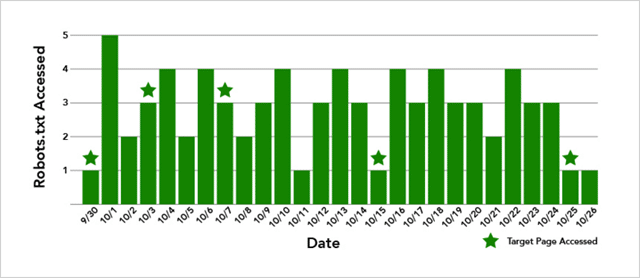

Dans une autre expérience du laboratoire IMEC, 12 sites Web ont proposé leurs pages afin de tester si l'utilisation de Robots.txt NoIndex empêche avec succès les moteurs de recherche d'explorer ET d'indexer une page.

D'abord les trucs techniques.

Comment empêcher les moteurs de recherche d'indexer votre page Web

L'approche courante adoptée par les webmasters consiste à ajouter une directive NoIndex à l'intérieur de la balise Robots Metatag sur une page. Lorsque les moteurs de recherche parcourent cette page, ils identifient la directive NoIndex dans l'en-tête de la page et suppriment la page de l'index.

En bref, ils explorent la page puis l' empêchent de s'afficher dans les résultats de recherche.

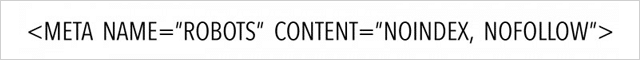

Le code ressemble à ceci :

D'autre part, la directive NoIndex placée à l'intérieur du fichier Robots.txt d'un site Web empêchera à la fois l'indexation de la page et l'exploration de la page.

Ou du moins il devrait…

Comme vous pouvez le voir dans les résultats, toutes les pages Web n'ont pas été supprimées de l'index.

Mauvaise nouvelle si vous souhaitez cacher le contenu de votre site aux regards indiscrets.

De plus, Google n'a supprimé aucune des pages immédiatement malgré l'exploration des fichiers Robots.txt du site Web plusieurs fois par jour.

Et, si vous pensez que c'est parce que Google doit également tenter une exploration de la page elle-même, ce n'est pas vrai non plus.

Dans le cas du site Web dont la page n'a pas été supprimée de l'index, la page cible a été explorée 5 fois :

Alors, qu'est-ce qui se joue ici ?

Eh bien, les résultats ne sont pas concluants.

Mais, ce que nous pouvons être sûrs de dire, c'est que (bien que Google montre la prise en charge de Robots.txt NoIndex), il est lent à fonctionner et parfois ne fonctionne pas du tout.

Mon conseil : utilisez Robots.txt NoIndex avec prudence.

8. Liens de texte d'ancrage à correspondance exacte Atout sur les liens de correspondance sans ancrage

Si vous avez lu une chose ou deux sur le référencement, vous aurez appris que le texte d'ancrage à correspondance exacte est mauvais .

Trop de liens disant la même chose ne sont pas naturels.

Et pourrait vous infliger une pénalité.

Depuis que Google Penguin a été lancé pour mettre un terme à la création de liens manipulateurs, les conseils des experts ont été de "maintenir les ratios de texte d'ancrage bas".

En termes simples, cela signifie que vous voulez un mélange de liens vers votre site afin qu'aucun texte d'ancrage riche en mots clés ne représente plus qu'un petit pourcentage du total.

Des liens bruts comme celui-ci : http//votredomaine.com, ainsi que des liens génériques comme « votre nom de marque », « cliquez ici » et « visitez ce site Web » sont tous bons.

Plus d'un petit pourcentage de liens riches en mots clés est mauvais.

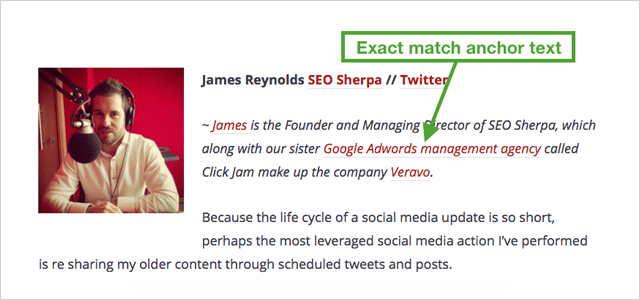

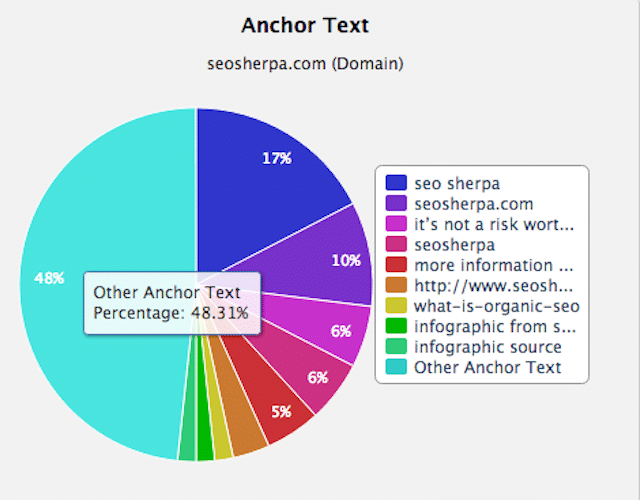

Un profil de lien varié et naturel ressemblera à quelque chose comme le mien :

Comme vous pouvez le voir, la majorité des liens sont pour mon nom de marque. Le reste est principalement constitué d'autres textes d'ancrage.

Dans cet esprit.

Que se passe-t-il lorsque vous pointez 20 liens vers un site Web, tous avec le même texte d'ancrage riche en mots clés ?

Vos classements montent en flèche, c'est quoi !

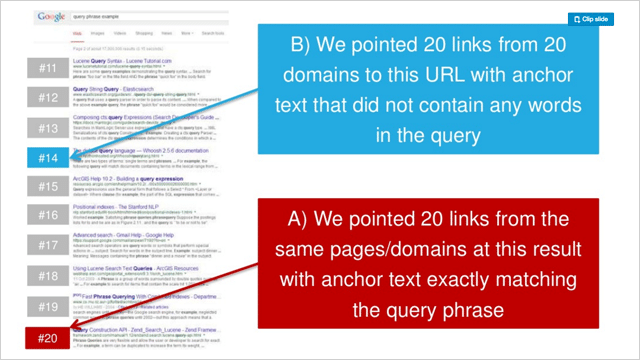

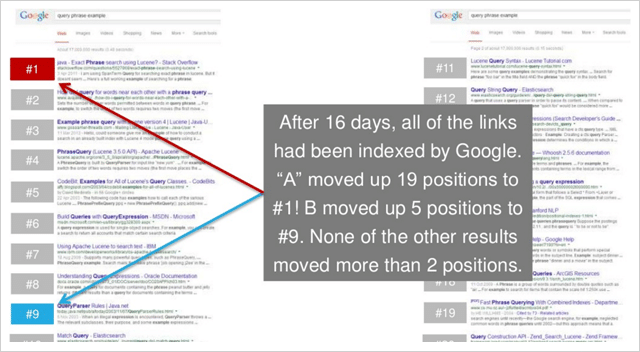

Dans une série de trois expériences, Rand Fishkin a testé le pointage de 20 liens d'ancrage génériques vers une page Web par rapport à 20 liens de texte d'ancrage de correspondance exacte.

Dans chaque cas, la correspondance exacte du texte d'ancrage a considérablement amélioré le classement des pages cibles.

Et, dans 2 tests sur 3, les sites Web de texte d'ancrage de correspondance exacte ont capitulé les sites Web de texte d'ancrage générique dans les résultats.

Voici les classements avant du test 2 dans la série de Rand :

Et voici le classement après :

C'est sacrément concluant.

Le texte d'ancrage de correspondance exacte est considérablement plus puissant que les liens de correspondance sans ancrage.

(Et étonnamment puissant dans l'ensemble)

9. Lien vers d'autres sites Web pour améliorer votre classement

Les liens sortants diluent l'autorité de votre site.

Cela a été la notion généralement conçue dans le monde du référencement depuis un certain temps.

Et cela malgré le fait que Google affirme que la création de liens vers des ressources connexes est une bonne pratique.

Alors pourquoi les référenceurs sont-ils si opposés aux liens sortants ?

L'idée est que les liens sortants vous font perdre votre PageRank. Plus il y a de liens sortants, plus vous donnez de PageRank.

Et puisque perdre le PageRank signifie perdre l'autorité, le résultat de la liaison est un classement inférieur. Droit

Eh bien, découvrons.

Shai Aharony et l'équipe de Reboot ont mis cette notion à l'épreuve dans leur expérience sur les liens sortants.

Pour l'expérience, Shai a configuré dix sites Web, tous avec des formats et une structure de domaine similaires.

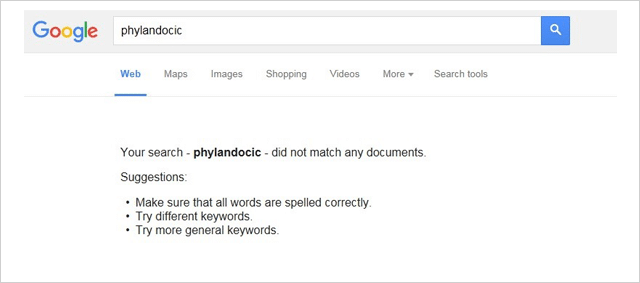

Chaque site Web contenait un article unique de 300 mots qui a été optimisé pour un mot inventé "phylandocic"

Avant le test, le mot "phylandocique" n'affichait aucun résultat sur Google.

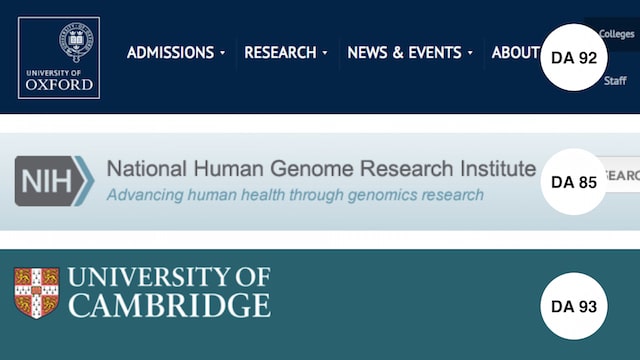

Afin de tester l'effet des liens sortants, 3 liens de suivi complets ont été ajoutés à 5 des 10 domaines.

Les liens pointaient vers des sites Web hautement fiables :

- Université d'Oxford (DA 92)

- Institut de recherche sur le génome (DA 85)

- Université de Cambridge (DA 93)

Une fois tous les sites Web de test indexés, les classements ont été enregistrés.

Voici les résultats :

Ils sont aussi clairs que le jour et la nuit.

CHAQUE site Web avec des liens sortants a surclassé ceux qui n'en ont pas.

Cela signifie que votre étape d'action est simple.

Chaque fois que vous publiez un article sur votre site, assurez-vous qu'il comprend une poignée de liens vers des ressources pertinentes et fiables.

Comme l'expérience de Reboot l'a prouvé. Il servira vos lecteurs ET vos classements.

10. Découverte étonnante que les liens Nofollow augmentent réellement votre classement

Une autre expérience du laboratoire IMEC a été menée pour répondre :

Les liens non suivis ont-ils un impact direct sur les classements ?

Étant donné que le but de l'utilisation d'un lien "non suivi" est d'empêcher la transmission de l'autorité, vous vous attendez à ce que les liens non suivis n'aient aucune valeur SEO (directe).

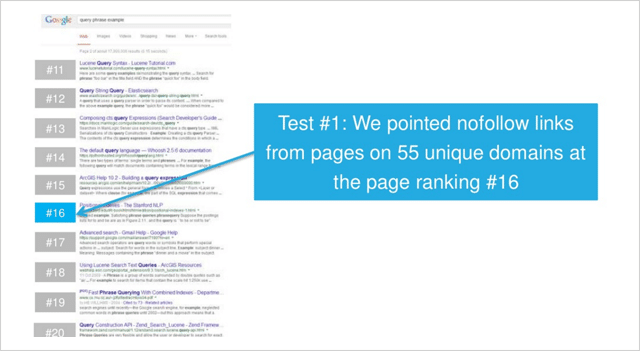

Cette expérience s'avère différente.

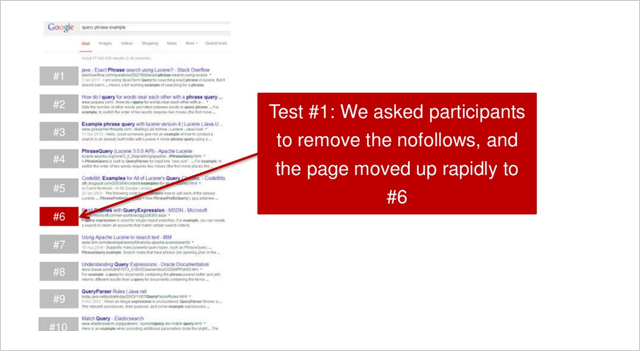

Dans le premier des deux tests, les participants au laboratoire IMEC ont pointé des liens de pages sur 55 domaines uniques vers une page se classant au 16e rang.

Une fois que tous les liens sans suivi ont été indexés, la page a très légèrement augmenté pour la requête compétitive à faible volume de recherche mesurée.

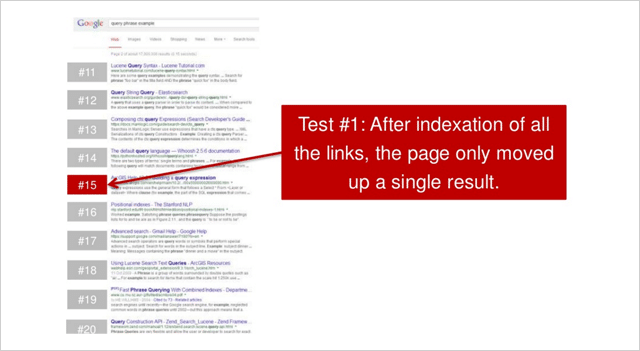

Les participants ont ensuite été invités à supprimer les liens de non-suivi qui ont abouti à ceci :

La page est montée rapidement à la position numéro 6.

Une augmentation cumulée de 10 positions, juste à partir de quelques liens non suivis.

Pas mal.

Cela pourrait-il être répété?

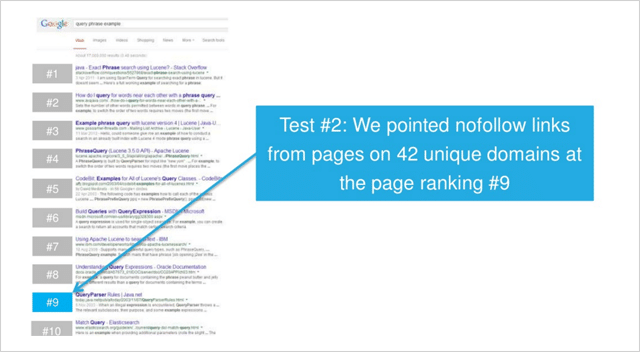

Dans un deuxième test, cette fois pour une requête à faible concurrence, des liens sans suivi ont été ajoutés à des pages sur 42 domaines uniques.

( Remarque - tous les liens étaient dans des liens de texte de page. Aucun lien d'en-tête, de pied de page, de barre latérale, de widget (ou similaire) n'a été utilisé dans les deux tests.)

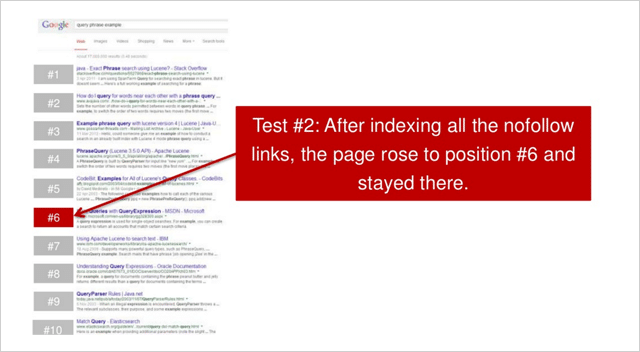

Après que tous les liens aient été indexés, la page a grimpé à la position numéro 6.

Une augmentation de 3 postes.

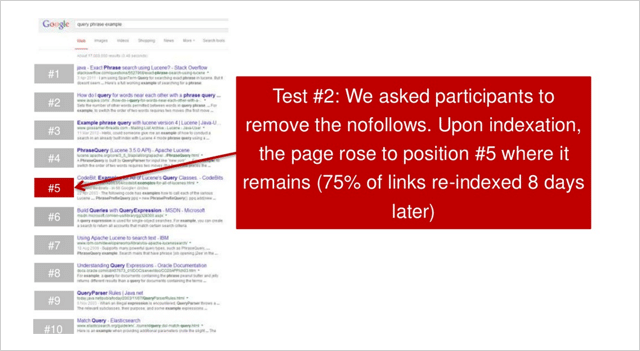

Ensuite, les participants ont été invités à supprimer tous les liens non suivis. Le site Web a ensuite grimpé d'une position au numéro 5.

Dans les deux tests; lorsque des liens non suivis ont été acquis, les sites Web ont considérablement amélioré leur classement

Le premier site Web a augmenté de 10 positions.

Le deuxième site Web a augmenté de 4 positions.

Alors encore une autre théorie SEO démystifiée ?

Rand Fishkin souligne que le test doit être répété plusieurs fois pour être concluant.

« Mes plats à emporter. Le test devrait être répété au moins 2 à 3 fois plus, mais les premières données suggèrent qu'il semble y avoir une relation entre les augmentations de classement et le contenu, pas de liens suivis », déclare Rand.

Quoi qu'il en soit, comme le souligne Nicole Kohler, il existe certainement un cas pour les liens sans suivi.

Les liens engendrent des liens.

Et (selon cette étude) pas de suivi ou suivi complet. Ils sont TOUS DEUX précieux pour vous.

11. Fait : les liens de pages Web avec des milliers de liens fonctionnent

Il existe une croyance dans le référencement selon laquelle les liens provenant de pages Web avec de nombreux liens sortants ne valent pas vraiment grand-chose.

La théorie ici est qu'avec de nombreux liens sortants, le «jus de lien» AKA PageRank de la page Web de liaison est réparti si finement que la valeur d'un lien vers votre site ne peut pas s'élever à beaucoup.

Plus le site Web contient de liens sortants, moins il y a de valeur transmise à votre site.

Cette théorie est renforcée par l'idée que les annuaires et autres sites de qualité inférieure qui ont de nombreux liens sortants ne devraient pas offrir un avantage significatif au classement des sites auxquels ils renvoient. À leur tour, les liens provenant de pages Web avec peu de liens sortants ont plus de valeur.

C'est exactement ce que Dan Petrovic a mis à l'épreuve dans son PageRank Split Experiment.

Le test fractionné du PageRank

Dans son expérience, Dan a créé 2 domaines (A et B).

Les deux domaines étaient .com et avaient tous deux des caractéristiques similaires et un contenu similaire mais unique.

La seule vraie différence était que pendant le test, le site Web B était lié à partir d'un site qui est lié à partir d'une sous-page sur http://www.debian.org (PR 7) qui a 4 225 liens suivis externes.

Le but du test était simplement de voir si un certain degré de PageRank est dépassé lorsqu'il existe autant de liens sortants, et quel effet (le cas échéant) cela a sur le classement des sites Web auxquels il renvoie.

Si la croyance de la plupart des référenceurs est quelque chose à dire, il ne devrait pas se passer grand-chose.

Voici ce qui s'est passé…

Immédiatement après que le site Web B ait été lié à partir du PR 7 debian.org (via le site Web du pont), le site Web B a grimpé en flèche dans les classements , atteignant finalement la position 2.

Et, selon la mise à jour la plus récente de Dan (3 mois après le test), le site Web B a maintenu sa position, seulement maintenu en tête par une page PageRank 4 beaucoup plus autoritaire.

Le site Web A (qui n'avait pas été lié) est resté stable pendant un certain temps, puis a chuté dans le classement.

Il apparaît donc que les liens provenant de pages qui ont de nombreux liens sortants sont en fait extrêmement précieux .

Quel mythe notre liste d’expériences SEO peut-elle dissiper ensuite…

12. Les liens d'image fonctionnent (vraiment) bien

Comme beaucoup d'expériences de référencement sur cette liste, celle-ci est née parce qu'un mec avait une intuition.

L'idée de Dan Petrovic était que le texte entourant un lien joue un rôle sémantique dans l'algorithme de recherche de Google.

Mais, Dan n'a jamais été en mesure de déterminer le degré de son influence ou si elle a un impact du tout .

Alors il a mis en place ce test pour savoir…

Expérience de proximité de texte d'ancrage

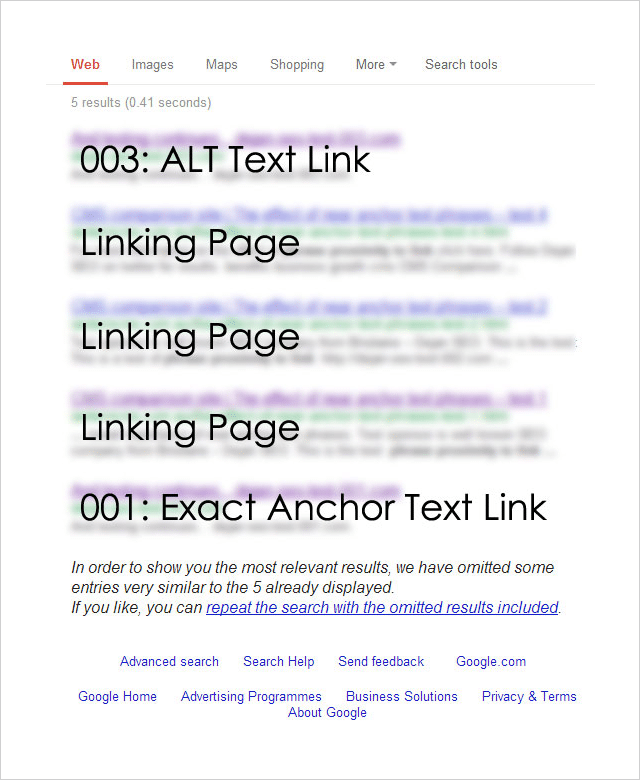

L'expérience a été conçue pour tester l'impact de divers types de liens (et leur contexte) sur les classements de recherche.

Pour réaliser le test Dan a enregistré 4 noms de domaine quasiment identiques :

http://********001.com.au

http://********002.com.au

http://********003.com.au

http://********004.com.au

Each of the 4 domains was then linked to from a separate page on a well-established website. Each page targeted the same exact phrase but had a different link type pointing to it:

001: [exact phrase]

Used the exact target keyword phrase in the anchor text of the link.

002: Surrounding text followed by the [exact phrase]: http://********002.com.au

Exact target keyword phrase inside a relevant sentence immediately followed by a raw http:// link to the target page.

003: Image link with an ALT as [exact phrase]

An image linking to the target page that used the exact target keyword phrase as the ALT text for the image.

004: Some surrounding text with [exact phrase] near the link which says click here .

This variation used the junk anchor text link “click here” and the exact target keyword phrase near to the link.

So which link type had the greatest effect on rankings?

Here are the results:

Unsurprisingly, the exact match anchor text link worked well.

But most surprisingly, the ALT text-based image link worked best .

And, what about the other two link types?

The junk link (“click here”) and the raw link (“http//”) results did not show up at all.

The Anchor Text Lessons You Can Take Away From This

This is just one isolated experiment, but it's obvious that image links work really well.

Consider creating SEO-optimized image assets that you can utilize to generate backlinks.

The team at Ahrefs put together a useful post about image asset link building here.

But don't leave it at that, best results will come from a varied and natural backlink profile.

Check out this post from Brian Dean which provides 17 untapped backlink sources for you to try.

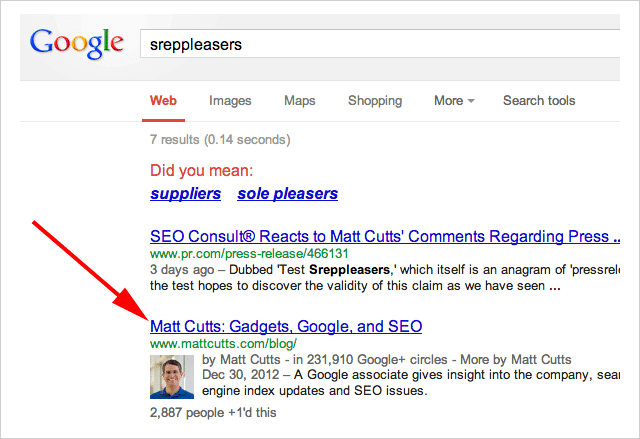

13. Press Release Links Work. Matt Cutts Take Note

Towards the end of 2014, Google's head of webspam publicly denounced press release links as holding no SEO value.

“Note: I wouldn't expect links from press release web sites to benefit your rankings” – Said Matt Cutts.

In an ironic (and brilliant) move, SEO Consult put Cutt's claim to the test this by issuing a press release which linked to, of all places….

Matt Cutts blog:

The anchor text used in the was the term “Sreppleasers”

The term is not present anywhere on Cutts's website.

Yet still, when you search “Sreppleasers” guess who's website comes up top?

There has been a lot of discussion about whether Press Release links work.

Is the jury still out on this?

I'll let you decide.

14. First Link Bias. Proven

First, let me say this…

This experiment is a few years old so things may now have changed. However, the results are so interesting it's very worthy of inclusion.

The theory for this experiment began with a post by Rand Fishkin which claimed that Google only counts one link to a URL from any given page.

Shortly after that post was published Rand's claims were debunked by David Eaves.

The opinion was rife in the SEO world as to whether either experiment was sound.

So, SEO Scientist set out to solve the argument once and for all.

The Test

The hypothesis goes something like this…

If a website is linked to twice (or more) from the same page, only the first link will affect rankings.

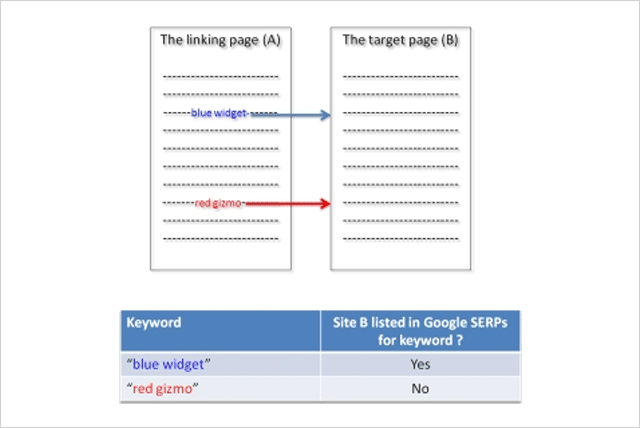

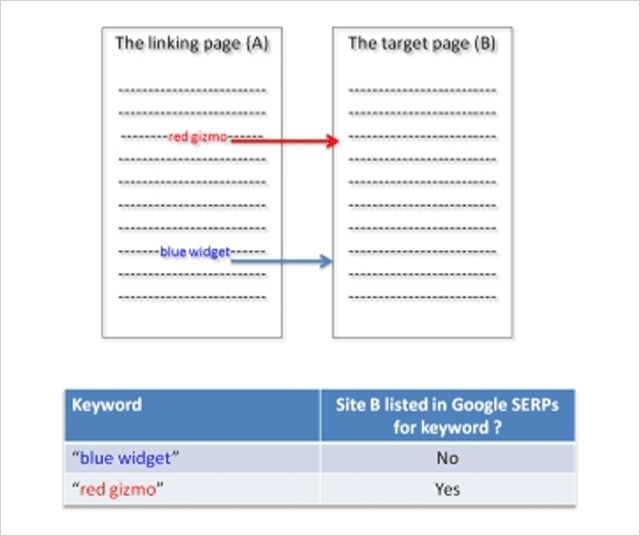

In order to conduct the test SEO Scientist set up two websites (A and B).

Website A links to website B with two links using different anchor texts.

Test Variation 1

The websites were set up, then after the links got indexed by Google, the rankings of site B were checked for the two phrases.

Result : Site B ranked for the first phrase and not for the second phrase.

Here is what the results looked like:

Test Variation 2

Next, the position of links to site B was switched. Now the second phrase appears above the previously first phrase on site A and visa versa.

Once Google had indexed the change, rankings were again checked for website B.

Result : Site B disappeared from the SERPs for the new second phrase (previously first) and appears for the new first phrase (previously second).

Rankings switched when the order of the links switched!

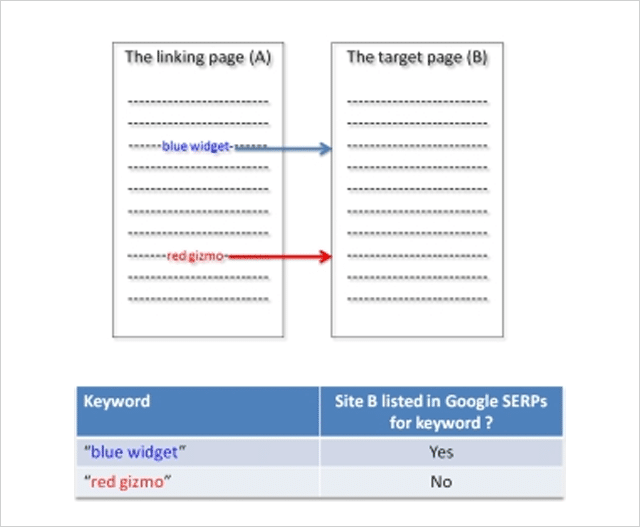

Test Variation 3

To check this was not some anomaly, in the third test variation the sites were reverted back to their original state.

Once the sites were re-indexed by Google, the rankings of website B were checked again.

Result : Site B reappeared for the initially first phrase and disappeared again for the initially second phrase:

The test proved that Google only counts the first link.

But, it gets even more interesting.

In a follow-up experiment, SEO Scientist made the first link “no follow” and still the second link was not counted!

The lesson from this experiment is clear.

If you are “self-creating” links ensure that your first link is to your most important target page.

15. The Surprising Influence of Anchor Text on Page Titles

Optimizing your Title tags has always been considered an important SEO activity and rightly so.

Numerous SEO studies have identified the title tag as a genuine ranking factor.

Since it's also what normally gets shown in the search results when Google lists your website, spending time on crafting well-optimized title tags is a good use of your time.

But, what if you don't bother?

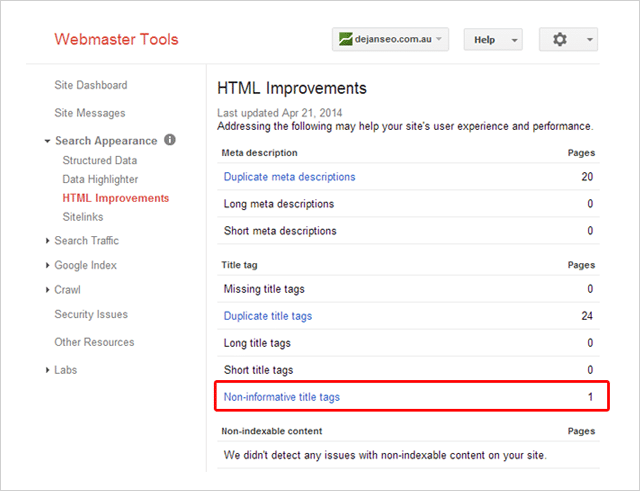

A few years ago Dejan SEO set out to test what factors Google considers when creating a document title when a title tag is not present.

They tested several factors including domain name, the header tag, and URLs – all of which did influence the document title shown in search results.

What about anchor text? Could that influence the title shown?

In this video Matt Cutts suggested it could:

But, wanting some real evidenc e Dan Petrovic put it to the test in this follow-up experiment.

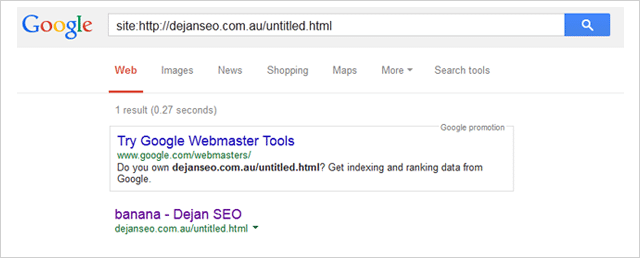

His experiment involved several participants linking to a page on his website using the anchor text “banana”.

The page being linked to had the non-informative title “Untitled Document”.

Here it is listed inside Dan's Search Console account:

Pendant le test, Dan a surveillé trois requêtes de recherche :

- http://goo.gl/8uPrz0

- http://goo.gl/UzBOQh

- http://goo.gl/yW2iGi

Et, voici le résultat :

Le titre du document s'est miraculeusement affiché comme "banane".

Le test prouve que le texte d'ancrage peut influencer le titre du document affiché par Google dans les résultats de recherche.

Cela signifie-t-il que vous ne devez pas écrire de balises de titre uniques et convaincantes pour chaque page de votre site ?

Je suggère que non.

Comme le souligne Brian Dean, la balise de titre de votre page n'est peut-être plus aussi importante qu'avant, mais elle compte toujours.

16. SEO négatif : comment vous pouvez (mais ne devriez pas) nuire au classement de vos concurrents

Il n'y a pas de questionnement, le référencement négatif est possible.

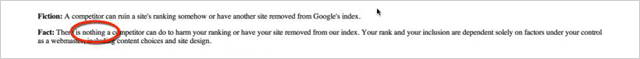

En 2003, Google a changé sa position en disant qu'il n'y a rien qu'un concurrent puisse faire pour nuire à votre classement :

Dire qu'ils ne peuvent presque rien faire :

![]()

En ce qui concerne Google, un petit changement comme celui-ci est une très grosse affaire.

Alors la question se pose…

Est-il facile d'affecter le classement d'un site (négativement) ?

Tasty Placement a mené une expérience pour déterminer exactement cela.

Les expériences de référencement négatives

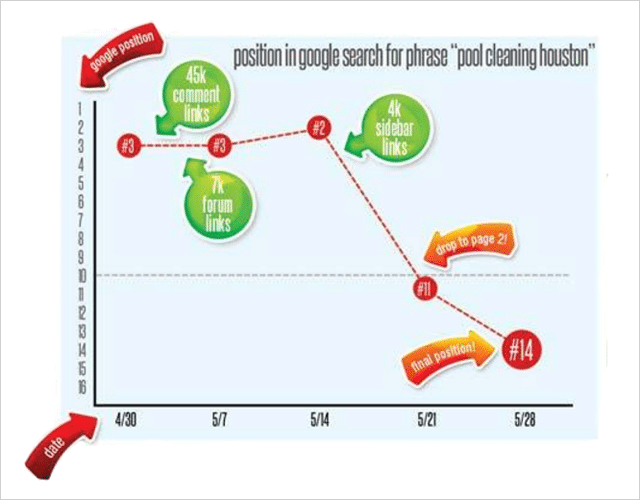

Dans une tentative de nuire aux classements de recherche, Tasty Placement a acheté un grand nombre de liens de spam qu'ils ont dirigés vers leur site Web cible Pool-Cleaning-Houston.com.

Le site était relativement bien établi et avant l'expérience, il se classait bien pour plusieurs mots-clés, y compris "pool cleaning Houston" et d'autres termes similaires.

Au total, 52 positions de mots-clés ont été suivies au cours de l'expérience.

Le spam de lien

Ils ont acheté une variété de liens indésirables pour l'expérience à un coût très bas :

45 000 liens de commentaires. Texte d'ancrage « Pool Cleaning Houston ». Coût : 15 $

7000 liens de profil de forum à deux niveaux. Texte d'ancrage « Pool Cleaning Houston ». Coût : 5 $

Liens de blog de la barre latérale sur quatre blogs trash, produisant près de 4000 liens. Texte d'ancrage « Pool Cleaning Houston ». Coût : 20 $

Coût total?

Un énorme 40 dollars.

Au cours de 2 semaines, les liens indésirables bon marché ont été dirigés vers Pool-Cleaning-Houston.com

D'abord les liens de commentaires, puis les liens de profil du forum, et enfin les liens de la barre latérale.

Voici ce qui est arrivé au classement pour "nettoyage de piscine Houston"

Le lot de liens de commentaires n'a eu aucun effet.

7 jours plus tard, les liens des messages du forum ont été placés, ce qui a été suivi d'une augmentation surprenante du classement du site de la position 3 à la position 2. Ce n'était pas du tout ce à quoi on s'attendait.

Encore 7 jours après cela, les liens de la barre latérale ont été ajoutés.

Le résultat…

Kaboom !

Une dégringolade quasi instantanée dans le classement.

Outre le mot-clé principal, 26 autres mots-clés ont également sensiblement diminué .

Il semble donc qu'il soit assez facile (et peu coûteux) de détruire le classement d'un concurrent si vous y étiez si enclin, ce que je sais que vous n'êtes pas !

Alors que l'expérience de Tasty Placement laisse quelques questions quant à la véritable cause de la baisse du classement (texte d'ancrage répétitif ou liens d'un mauvais voisinage peut-être ?), il est clair que le référencement négatif est réel.

Et, vraiment facile à faire.

17. Google rédige-t-il de meilleures descriptions que vous ?

Si vous êtes dans le référencement depuis un certain temps, vous avez probablement écrit des centaines, voire des milliers de méta-descriptions.

Mais, tu es cool avec ça.

Ces innombrables heures de rédaction de méta descriptions sont du temps bien utilisé.

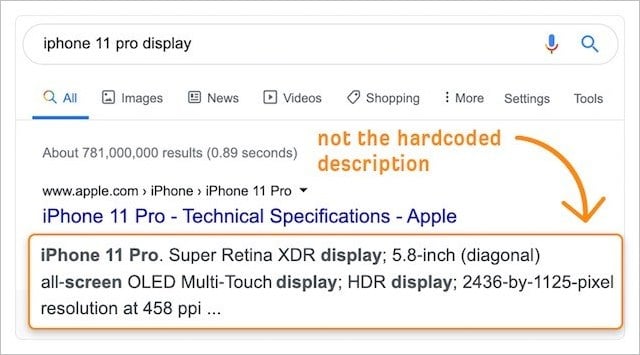

Avec l'importance croissante du taux de clics sur les classements (voir l'expérience numéro 2), toute amélioration apportée aux extraits SERP de votre site Web via des descriptions personnalisées (codées en dur) augmentera sûrement les résultats.

Après tout, nous connaissons mieux notre entreprise et notre public.

Ce qui signifie que nos descriptions doivent être plus performantes que les versions générées automatiquement par Google, n'est-ce pas ?

Malheureusement non.

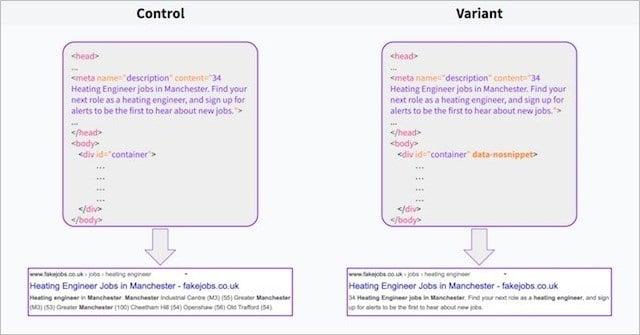

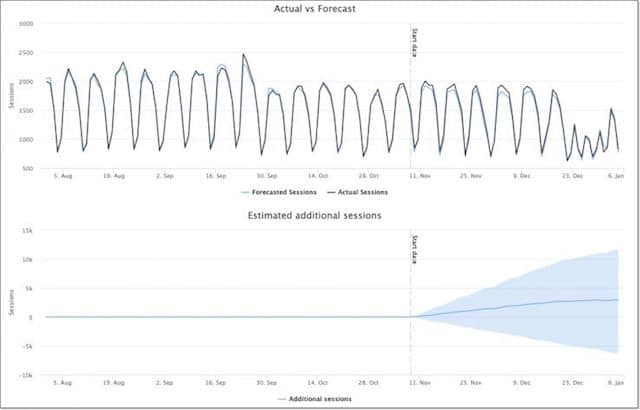

Dans une expérience récente , l'équipe de Search Pilot a constaté que (dans leur cas au moins) les descriptions générées automatiquement par Google surpassaient les méta-descriptions personnalisées d'un facteur de 3 % .

En utilisant l' attribut data-no snippet sur l'élément body de la moitié de leurs pages, Search Pilot a pu scinder les descriptions générées par Google (le contrôle) par rapport à leurs propres descriptions personnalisées (la variante).

Très peu de temps après le début du test, le nombre de clics a baissé et, en deux semaines, le test a atteint une signification statistique pour un résultat négatif !

En bref, les descriptions de Google ont mieux fonctionné.

Que pouvez-vous en tirer ?

Google a accès à une sacrée quantité de données d'utilisateurs.

Cet avantage en matière de données aide Google à savoir ce que les utilisateurs recherchent et à créer des descriptions plus pertinentes pour les utilisateurs que celles que nous écrivons nous-mêmes, même si les propres descriptions de Google sont grattées et se lisent souvent comme des déchets.

Ceci est renforcé par des études qui ont montré que Google ignore la balise meta description pour 63% des requêtes.

Nous pouvons supposer que Google le fait lorsque la méta description créée par le propriétaire du site Web n'est pas entièrement pertinente pour la requête de l'utilisateur - et Google pense qu'il peut faire un meilleur travail.

L'étude de Search Pilot indique que oui.

Cela signifie-t-il que vous devriez supprimer la rédaction de méta-description et laisser tout cela à Google ?

Pas entièrement.

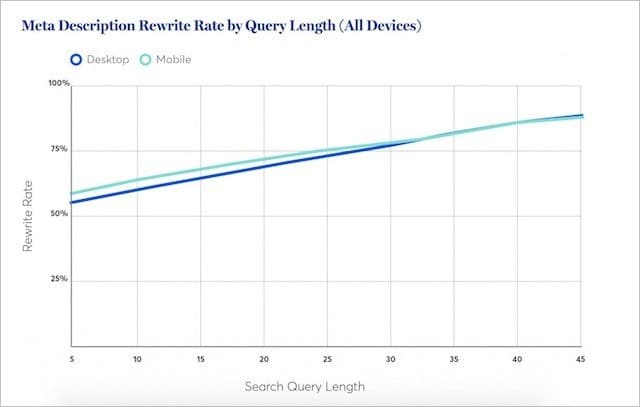

Les recherches de Portent suggèrent que Google réécrit moins les méta-descriptions pour les mots-clés courts (généralement à volume élevé).

En fait, pour les requêtes les plus courtes, Google achètera la méta description réelle au moins la moitié du temps.

Cela indique que dans environ 50% des recherches, votre méta description sera la meilleure.

Mon conseil:

Continuez à rédiger des méta descriptions personnalisées pour votre contenu le plus important.

Mais supprimez les méta descriptions où le potentiel de trafic pour votre contenu est plus faible.

Google fera un travail décent pour créer des descriptions pertinentes - qui sont statistiquement prouvées pour surpasser les vôtres.

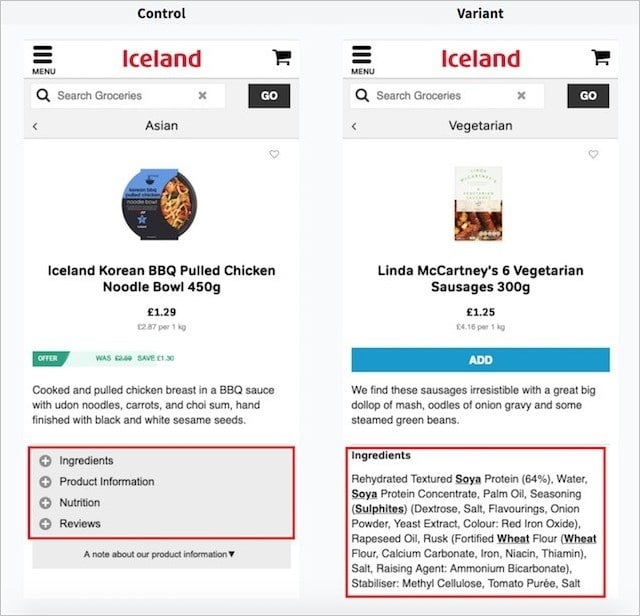

18. Expérience de texte caché

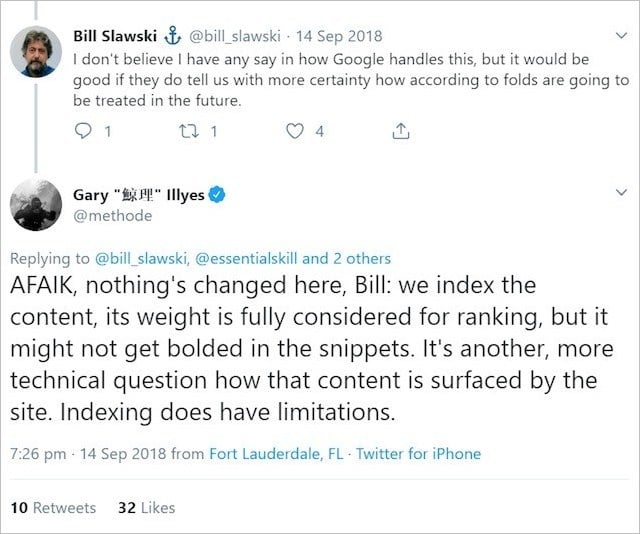

Google a répété à plusieurs reprises que tant que vous avez le texte que vous souhaitez classer sur votre page Web ;

Il sera "pleinement pris en compte pour le classement".

En d'autres termes, vous pouvez afficher du texte dans des accordéons, des onglets et d'autres éléments extensibles, et Google considérera ce texte avec une pondération égale au texte entièrement visible lors du chargement de la page.

Cette ligne officielle de Google a fourni un heureux compromis pour les référenceurs et les développeurs Web qui souhaitent trouver un équilibre entre un contenu riche en texte et un attrait visuel élégant.

Vous avez un long passage de texte ?

Placez-le simplement dans un bloc de contenu extensible – et ce sera parfaitement bon pour le référencement.

Ou, du moins, c'est ce que Google nous a fait croire.

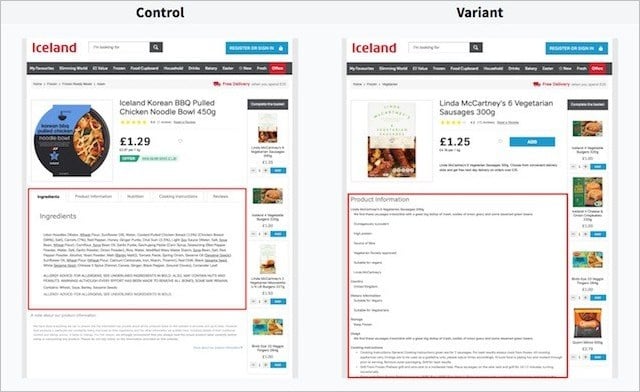

Entrez Search Pilot et leur expérience de texte caché.

Dans leur expérience, Search Pilot a cherché à tester les performances du texte dans les onglets (le contrôle) par rapport au texte entièrement visible lors du chargement de la page (la variante).

Voici les versions de page sur ordinateur :

Et, voici les versions de page sur mobile ;

Ils ont testé ces deux versions sur de nombreuses pages de produits du site Web de leur client et ont mesuré l'évolution du trafic organique au fil du temps.

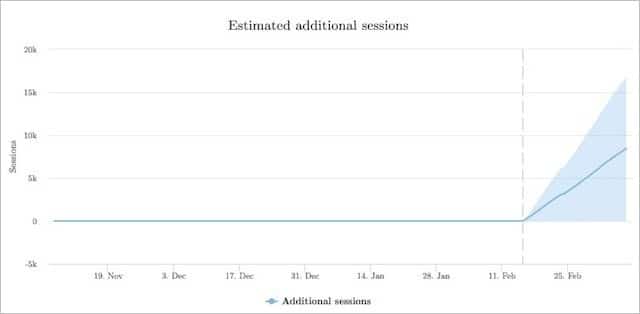

Voici comment la variante (texte visible) s'est comporté par rapport au contrôle (le texte est masqué) :

La version avec texte entièrement visible a obtenu 12 % de sessions organiques en plus que le texte caché dans les versions à onglets.

Il semble assez clair d'après le test de Search Pilot, que votre contenu soit visible sur la page peut être bien meilleur pour votre trafic organique.

Search Pilot n'était pas la seule partie à tester l'hypothèse selon laquelle plus de poids est accordé au texte visible par l'utilisateur plutôt qu'au texte qui est hors de la vue immédiate de l'utilisateur.

Une autre expérience de Reboot a révélé que le texte entièrement visible (et le texte contenu dans une zone de texte) surpassait de manière significative le texte caché derrière JavaScript et CSS :

19. Mettre la vitesse de la page à l'épreuve (les résultats peuvent vous surprendre)

Vous avez probablement entendu dire que la vitesse de la page est un facteur de classement important.

Il existe littéralement des milliers de blogs qui vous disent que plus votre page est rapide, plus elle a de chances d'être mieux classée.

Quoi de plus:

Il n'y a pas si longtemps, Google a publié une "mise à jour rapide" qui prétendait ralentir le chargement des sites Web sur les appareils mobiles.

Toutes les informations disponibles sur les temps de chargement des pages étant importantes pour un classement plus élevé, les performances en matière de vitesse de page sont sûrement un signal de classement important !

Voyons voir.

C'est exactement ce que Brain Dean a mis à l'épreuve dans son expérience de vitesse de page :

Les résultats vous ont-ils surpris ?

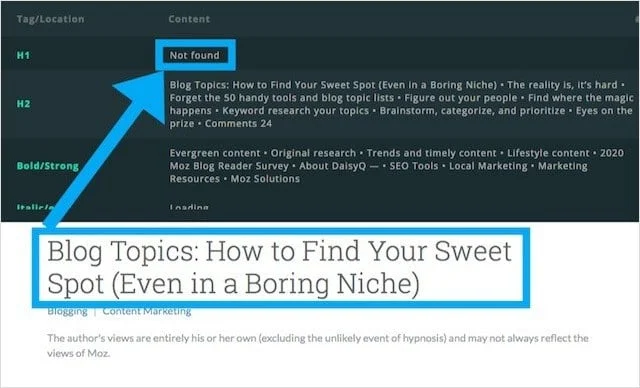

20. Les balises H1 et leur impact sur les classements : le débat est clos

Chaque guide SEO offre les mêmes conseils :

(Enveloppez le titre de votre page ou postez dans une balise H1)

Mais tous les sites Web ne suivent pas ces soi-disant meilleures pratiques, Moz.com étant l'un d'entre eux.

Avouons-le:

Moz est l'un des sites Web les plus fiables (et les plus fréquentés) sur le thème du référencement.

Mais encore:

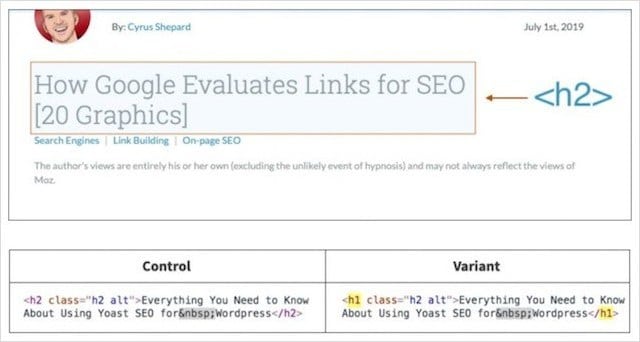

Le blog de Moz n'a pas de balise H1 et utilise à la place une balise H2 pour son titre principal.

Après avoir remarqué que le blog Moz utilisait des balises H2 pour les titres (au lieu des H1), Craig Bradford de Distilled a contacté Cyrus Shepard de Moz.

Ensemble, Craig et Cyrus ont décidé de mener une expérience de balise d'en-tête qui, espérons-le, déterminerait une fois pour toutes si les balises H1 avaient un impact sur les classements organiques.

Pour ce faire, ils ont conçu un test fractionné 50/50 des titres du blog Moz à l'aide de SearchPilot.

Dans l'expérience, la moitié des titres de Moz ont été changés en H1 et l'autre moitié en H2.

Cyrus et Crag ont ensuite mesuré la différence de trafic organique entre les deux groupes.

Résultats du test de balise d'en-tête

Alors, à votre avis, que s'est-il passé lorsque les titres principaux ont été remplacés par la mauvaise balise de titre (H2) par le bon titre (H1) ?

La réponse:

Pas grand-chose du tout !

Après huit semaines de collecte de données, ils ont déterminé que le fait de changer les titres des articles de blog de H2 à H1 ne faisait aucune différence statistiquement significative.

Que peut-on en déduire ?

Simplement que Google est également capable de déterminer le contexte de la page si votre titre principal est enveloppé dans un H1 ou un H2.

Cela signifie-t-il que vous devriez abandonner tous les guides de bonnes pratiques SEO et supprimer les H1 ?

Nan!

L'utilisation d'un H1 comme en-tête principal fournit la structure de contenu appropriée aux outils de lecture d'écran, aidant ainsi les lecteurs malvoyants à mieux naviguer dans votre contenu.

J'explique cela et quatre autres avantages moins connus dans mon guide complet sur les balises d'en-tête.

Pour l'instant, passons à notre dernière expérience de référencement.

21. Expérience d'hébergement mutualisé : prouver l'effet "mauvais voisinage"

Les débats sur l'impact de l'hébergement de sites Web partagés et ses effets sur les classements font rage dans la communauté SEO depuis des éternités.

Ces débats ne se concentrent pas uniquement sur l'aspect performance de l'hébergement mutualisé (par exemple, les temps de chargement lents qui sont généralement reconnus comme ayant des implications SEO négatives) mais sur un concept appelé « mauvais voisinage ».

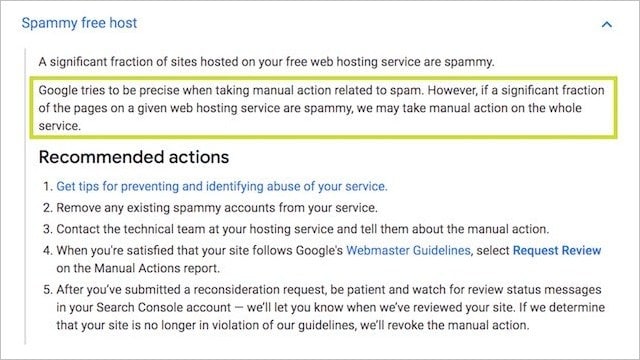

Les mauvais quartiers décrivent un environnement d'hébergement avec une adresse IP commune et une collection de sites Web de mauvaise qualité, non liés, pénalisés et/ou potentiellement problématiques (par exemple, pornographie, jeux d'argent, pilules).

De la même manière, vous pourriez être impacté négativement si vous avez lié ou reçu des liens provenant de sites Web contenant du spam ;

Beaucoup pensaient que trouver votre site Web sur le même serveur que des sites de mauvaise qualité ou sans rapport pourrait avoir des effets d'écrasement similaires.

Cette idée a du sens :

La propre documentation de Google sur les actions manuelles indique que tous les sites Web d'un serveur pourraient être « pénalisés » en raison de la réputation de certains :

Il est également probable que les algorithmes de Google recherchent des modèles parmi les sites de mauvaise qualité - et l'hébergement partagé gratuit/bon marché est potentiellement l'un d'entre eux .

Soyons réalistes;

Êtes-vous plus susceptible de trouver un site PBN jetable sur un compte d'hébergement partagé bon marché de 10 dollars par mois, ou un serveur dédié premium de 200 dollars et plus ?

Tu obtiens le point.

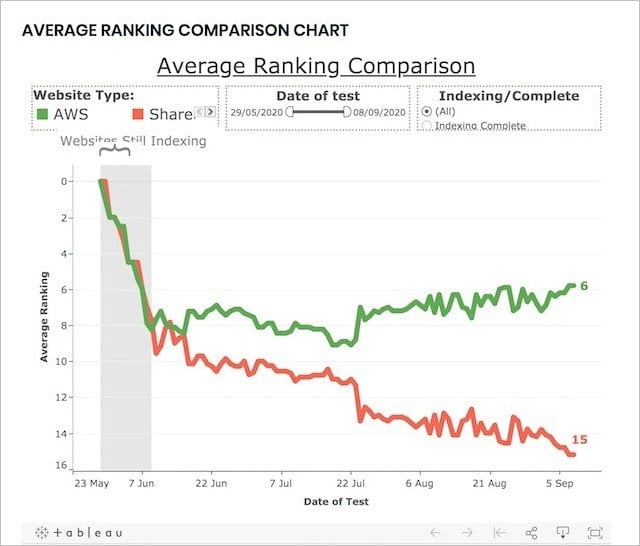

Pour tester les performances de l'hébergement partagé (plusieurs sites Web sur une seule adresse IP) par rapport à l'hébergement dédié (une seule adresse IP pour un site Web), Reboot a effectué cette expérience de référencement.

Expérience d'hébergement mutualisé à long terme :

Pour réaliser l'expérience, Reboot Online a créé 20 sites Web - tous sur de nouveaux domaines .co.uk et contenant un contenu unique mais optimisé de la même manière :

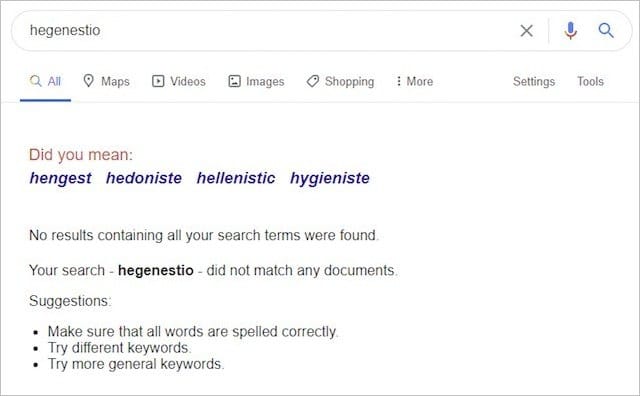

Les vingt sites Web ciblaient tous le même mot-clé ("hegenestio") qui, avant l'expérience, n'avait aucun résultat sur Google :

Ils ont ensuite placé dix sites Web sur des serveurs AWS dédiés et dix sur des serveurs partagés, dont certains contenaient des sites de mauvais voisinage comme celui-ci :

Et ça:

Et, après avoir indexé les sites Web, ils ont surveillé leur classement sur une période de trois mois.

Pour s'assurer que l'expérience ne puisse pas être biaisée par d'autres facteurs, Reboot a procédé comme suit :

- S'assurer que tous les domaines n'avaient aucun contenu précédent indexé par Google.

- Construit tous les sites Web avec du HTML statique mais des CSS variables.

- Mesurer régulièrement le temps de chargement de chaque site Web pour s'assurer qu'il n'est pas un facteur d'influence.

- Utiliser StatusCake pour vérifier quotidiennement la disponibilité des sites Web.

- A donné à chaque site Web un méta-titre de base similaire et aucune méta-description.

Ces étapes ont été mises en place pour démontrer que la vitesse, la fiabilité, la cohérence, le contenu, le code et la disponibilité des sites Web n'avaient pas d'incidence sur les classements.

Bon, alors que s'est-il passé ?

À la fin de l'expérience, les résultats étaient clairs et concluants :

Les sites Web sur une adresse IP dédiée sont BEAUCOUP mieux classés que ceux sur une adresse IP partagée.

En fait, à la fin de l'expérience, les dix premiers résultats pour le mot-clé inventé contenaient 80 % à 90 % de sites Web sur des adresses IP dédiées :

Les résultats de cette expérience suggèrent évidemment que l'hébergement de votre site Web sur un environnement d'hébergement mutualisé (contenant des sites Web toxiques et de mauvaise qualité) peut avoir un effet néfaste sur vos performances organiques.

Étant donné que tous les autres signaux de classement ont été supprimés, de combien, à ce stade, nous ne savons pas.

Ce dont nous pouvons être sûrs, c'est que, isolément, l'hébergement partagé est un facteur négatif ET si vous êtes sérieux au sujet de votre entreprise, un serveur décent (dédié) est la voie à suivre .

Conclusion

Ces 21 expériences SEO ont donné des résultats très inattendus.

Certains ont même complètement renversé ce que nous pensions être vrai à propos du référencement.

Cela prouve simplement qu'avec si peu de connaissances sur le fonctionnement interne de l'algorithme de Google, il est essentiel que nous testions.

Ce n'est que par des tests que nous pouvons être sûrs que les stratégies de référencement que nous mettons en œuvre donneront réellement des résultats.

Nous terminons cet article par une explication de la façon dont les tests de référencement sont effectués afin que vous puissiez également effectuer des expériences de référencement et obtenir des résultats de test valides (peut-être même révolutionnaires).

Un merci spécial à Eric Enge pour cette contribution :

« Nous investissons beaucoup d'énergie dans chaque test que nous effectuons. C'est en grande partie parce que faire un bon travail de test nécessite que vous supprimiez minutieusement les variables confusionnelles et que vous vous assuriez que la taille des données de votre échantillon est suffisante.

Certaines des choses clés que nous essayons de faire sont :

1. Obtenez un échantillon de données raisonnablement important.

2. Effacez les paramètres du test pour supprimer les facteurs qui invalideront le test. Par exemple, si nous essayons de tester si Google utilise une méthode particulière pour indexer une page, nous devons faire des choses comme nous assurer que rien ne renvoie à cette page et qu'il n'y a pas d'outils Google référencés dans le code HTML de cette page. (par exemple, Google Analytics, AdSense, Google Plus, Google Tag Manager, …).

3. Une fois que vous avez les résultats, vous devez laisser les données raconter l'histoire. Lorsque vous avez commencé le test, vous vous attendiez probablement à un résultat donné, mais vous devez être prêt à découvrir que vous vous êtes trompé.

Bref, c'est beaucoup de travail, mais pour nous, les résultats justifient l'effort !

Alors là vous l'avez…

21 expériences SEO et leurs résultats inattendus. Que pensez-vous d'autre devrait être testé?

Quel résultat d'expérience SEO vous a le plus surpris ?

Dites-le moi dans les commentaires ci-dessous.