21 eksperymentów SEO, które zmienią sposób, w jaki myślisz o SEO (na zawsze)

Opublikowany: 2020-11-10 Myślę, że zgodzisz się ze mną, gdy powiem:

Myślę, że zgodzisz się ze mną, gdy powiem:

Istnieje WIĘCEJ nieporozumień dotyczących SEO…

…niż prawie każdy inny aspekt marketingu cyfrowego.

I trudno się dziwić, jeśli weźmie się pod uwagę ponad 200 czynników rankingowych , ale prawie wszystkie są owiane tajemnicą.

Ponieważ Google nie udostępnia (i prawdopodobnie nigdy nie udostępni) wewnętrznych zasad działania swojego algorytmu, skąd możesz wiedzieć, co naprawdę działa?

Jak odszyfrować mity SEO z tematu, a pogłoski z faktu?

Zwracasz się do nauki, ot co!

BONUS: Pobierz każdy eksperyment SEO zawarty w tym poście jako podręczny przewodnik PDF, który możesz wydrukować lub zapisać na swoim komputerze.

W tym poście podzielę się z wami 21 niesamowitymi eksperymentami SEO (zaktualizowanymi na rok 2021), które podważą to, co uważacie za prawdziwe w kwestii optymalizacji pod kątem wyszukiwarek.

Posunąłbym się nawet do przewidzenia, że te badania SEO na zawsze zmienią sposób, w jaki robisz SEO.

Jesteś gotowy? Ponieważ wszystko się dla ciebie zmieni.

Dobra, wskoczmy:

1. Współczynnik klikalności wpływa na rankingi organiczne (i jak to wykorzystać na swoją korzyść)

Ten pierwszy eksperyment jest doozy.

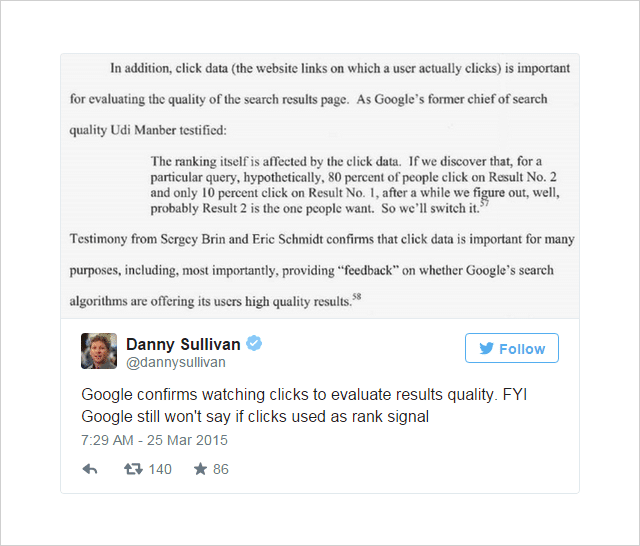

Od jakiegoś czasu w świecie SEO panuje opinia, że Click-Through-Rate (CTR) może wpływać na ranking wyszukiwania.

Opinię podsycały mocne (choć nie rozstrzygające) wskazówki z wnętrza Google:

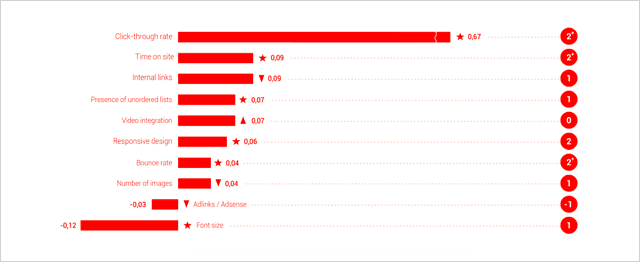

A badania Searchmetrics Ranking Factors w coraz większym stopniu uznają CTR za jeden z najważniejszych czynników rankingowych.

(Na podstawie korelacji, a nie związku przyczynowego, umysłu)

Argumentem, na który wskazuje Jamie Richards, jest to, że witryna otrzymująca wyższy współczynnik klikalności niż witryny powyżej niej, może sygnalizować się jako bardziej odpowiedni wynik i wpływać na Google, aby przesunąć go w górę w SERP.

Pomysł omawiany tutaj przez WordStream jest podobny do Wyniku Jakości przypisanego reklamom AdWords – czynnik określony częściowo przez względny współczynnik klikalności reklamy w porównaniu z innymi reklamami wokół niej.

To był pomysł, który Rand Fishkin z Moz postanowił przetestować w kolejnych eksperymentach.

Numer jeden: Eksperyment z liczbą zapytań i kliknięć

Scenariusz testowy, którego użył Rand Fishkin, był dość prosty.

- Zachęć grupę osób do wyszukania określonego zapytania w Google.

- Niech te osoby klikną konkretny wynik.

- Rejestruj zmiany w rankingu, aby określić, czy zwiększona liczba kliknięć tego wyniku wpływa na jego pozycję.

Aby rozkręcić piłkę, Rand wysłał ten tweet do swoich 264 tys. obserwujących na Twitterze:

Chcesz pomóc z teorią/testem Google? Czy możesz wyszukać „IMEC Lab” w Google i kliknąć link z mojego bloga? Mam przeczucie.

— Rand Fishkin (@randfish) 1 maja 2014 r.

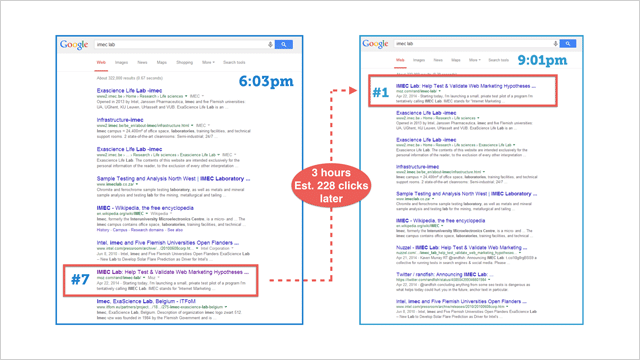

Na podstawie danych Google Analytics Rand szacuje, że 175-250 osób odpowiedziało na jego wezwanie do działania i kliknęło wynik IMEC.

Oto, co się stało:

Strona wystrzeliła na pierwszą pozycję.

To wyraźnie wskazuje (co najmniej w tym konkretnym przypadku), że współczynnik klikalności znacząco wpływa na rankingi .

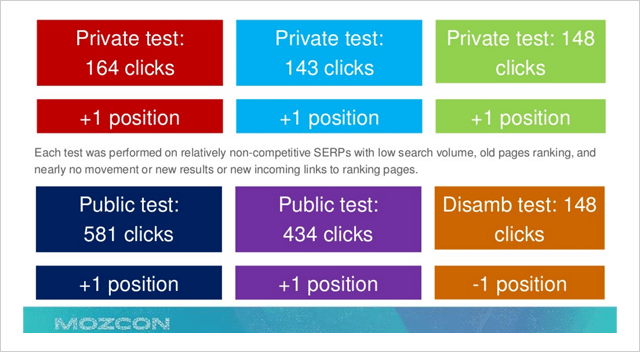

Próbując zweryfikować te dane, przeprowadzono serię powtórnych testów, które wykazały ogólną tendencję wzrostową, gdy liczba kliknięć wzrosła do określonego wyniku.

Niestety tym razem dane były znacznie mniej dramatyczne i rozstrzygające.

Dlaczego tak mogło być?

Rand był zaniepokojony, że w odpowiedzi na jego publiczny post pokazujący, w jaki sposób kliknięcia mogą wpływać na wyniki Google bardziej bezpośrednio niż wcześniej podejrzewano, Google mogło zaostrzyć kryteria dotyczące tego konkretnego czynnika.

Jednak nie dał się zniechęcić…

Po drugie: Eksperyment z liczbą zapytań i kliknięć

Zainspirowany butelką Sullivans Cove Whiskey podczas przerwy w meczu Pucharu Świata, Rand Fishkin wysłał kolejny tweet:

Co powinieneś zrobić podczas tej ciszy w meczu Mistrzostw Świata? Pomóż mi przeprowadzić test! Trwa <30 sekund: http://t.co/PxXWNlVdTi

— Rand Fishkin (@randfish) 13 lipca 2014 r.

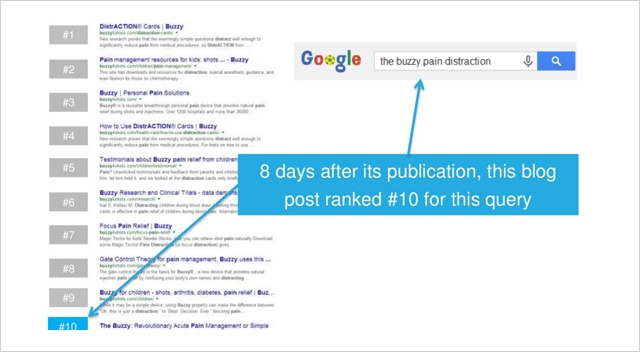

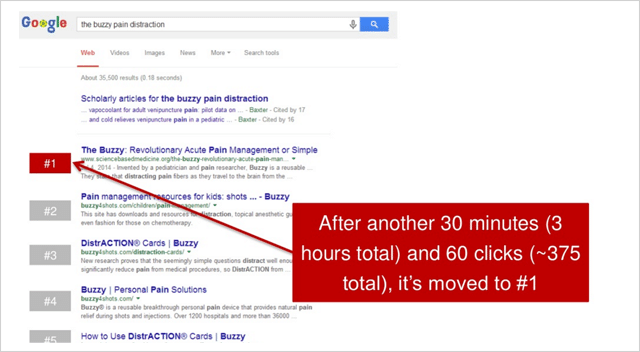

Tweet wskazywał jego obserwatorom kilka podstawowych instrukcji, w których proszono uczestników o wyszukanie „brzęczącego rozproszenia bólu”, a następnie kliknięcie wyniku na sciencebasedmedicine.org.

Oto miejsce, w którym docelowa witryna pojawiła się przed rozpoczęciem eksperymentu:

W ciągu następnych 2,5 godziny po pierwszym tweecie Randa łącznie 375 uczestników kliknęło wynik.

Efekt był dramatyczny.

Sciencebasedmedicine.org awansowała z dziesiątego miejsca na pierwsze miejsce w Google.

Eureko!

To cudowne wydarzenie z kolei zapoczątkowało reakcję łańcuchową…

Co zakończyło się w tym uroczystym momencie dla Rand:

Wygląda więc na to, że liczba kliknięć (lub względny współczynnik klikalności) ma wpływ na ranking wyszukiwania. Chociaż są tacy ludzie, jak Bartosz Góralewicz, którzy się temu sprzeciwiają, uważam, że to prawda.

Istnieje kilka powodów, dla których Google rozważałby współczynnik klikalności jako sygnał rankingowy, poza sygnałami z głównego nurtu, takimi jak treści i linki.

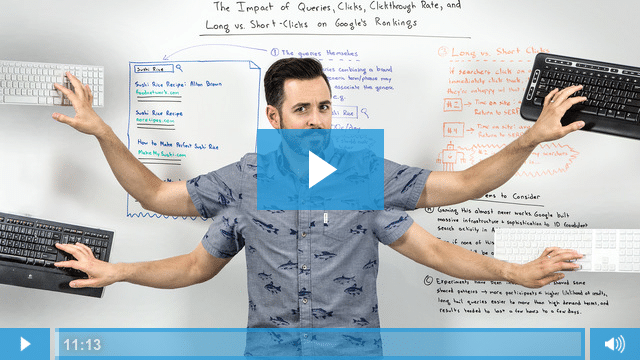

Ten film w piątek na tablicy stanowi doskonałe wyjaśnienie, dlaczego:

Tak więc sprawa jest przekonująca, współczynnik klikalności z pewnością wpływa na rankingi wyszukiwania Google.

Późniejsze badanie przeprowadzone przez Larry'ego Kima wydaje się sugerować, że jeśli pokonasz oczekiwany współczynnik klikalności o 20 procent, awansujesz w rankingu.

Świetnie, wszystko dobrze i dobrze.

Ale jak wykorzystać te informacje na swoją korzyść?

Oto 4 kroki działania, które pokażą Ci tylko to:

(1) Zoptymalizuj współczynnik klikalności — w tym celu utwórz atrakcyjne tytuły stron i opisy meta dla swoich stron, które sprzedają ludziom po kliknięciu Twojego wyniku zamiast tych powyżej.

(2) Zbuduj swoją markę – Ugruntowana i rozpoznawalna marka przyciągnie więcej kliknięć. Jeśli użytkownicy znają Twoją markę (i miejmy nadzieję, że również ją polubią i ufają), będziesz mieć większe znaczenie w SERP.

(3) Optymalizuj pod kątem długich kliknięć – nie kieruj się tylko optymalizacją, aby uzyskać kliknięcia, skup się na utrzymywaniu użytkowników w witrynie przez długi czas. Jeśli uzyskasz więcej kliknięć, ale ci użytkownicy po prostu powrócą do wyników, wszelkie korzyści, jakie uzyskałeś z wyższego CTR, zostaną anulowane.

(4) Stosuj autentyczną taktykę – Skutki nagłego wzrostu CTR (tak jak w eksperymencie Randa) będą trwać tylko przez krótki czas. Kiedy powrócą normalne współczynniki klikalności, zmieni się także Twoja poprzednia pozycja w rankingu. Użyj punktów 1 i 2, aby uzyskać długotrwałe rezultaty.

2. Branża się pomyliła. Mobilegeddon był ogromny

Mobilegeddon to nieoficjalna nazwa nadana przyjaznej dla urządzeń mobilnych aktualizacji Google przed jej wydaniem 21 kwietnia 2015 roku.

Oczekiwano, że aktualizacja poprawi rankingi wyszukiwania mobilnego dla stron internetowych, które są czytelne i użyteczne na urządzeniach mobilnych.

Oczekiwano, że zatopi strony internetowe nieprzyjazne dla urządzeń mobilnych.

Niektórzy mówili nawet, że będzie to katastrofalne wydarzenie większe niż Google Penguin i Panda.

Przez kilka miesięcy webmasterzy usiłowali uporządkować swoje witryny. Gdy zbliżał się dzień, zamieszanie przerodziło się w panikę, gdy właściciele witryn zdali sobie sprawę, że ich witryny nie przeszły testu zgodności z urządzeniami mobilnymi Google.

Co się więc stało 21 kwietnia 2015 roku? Czy miliony stron internetowych wpadły w otchłań wyszukiwarek mobilnych?

Według większości doniesień niewiele się wydarzyło.

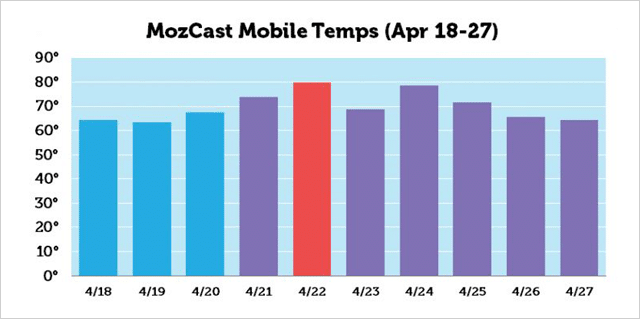

Oczywiście, według MozCast, szczyt aktywności nastąpił około 22 kwietnia, ale zmiany w rankingu nie były nawet tak duże, jak myślała większość SEO.

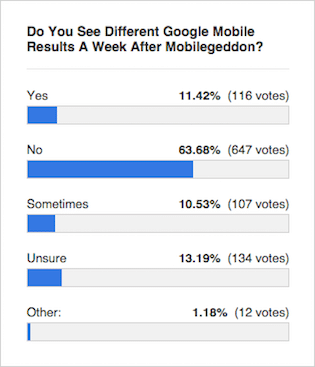

Konsensus ekspertów takich jak ta ankieta Okrągłego Stołu Wyszukiwarki był taki, że wyniki pozostały prawie niezmienione:

Ale co pokazały wyniki testu?

Ale co pokazały wyniki testu?

Wchodzi Eric Enge i zespół Stone Temple Consulting…

Badanie rankingu Mobilegeddon

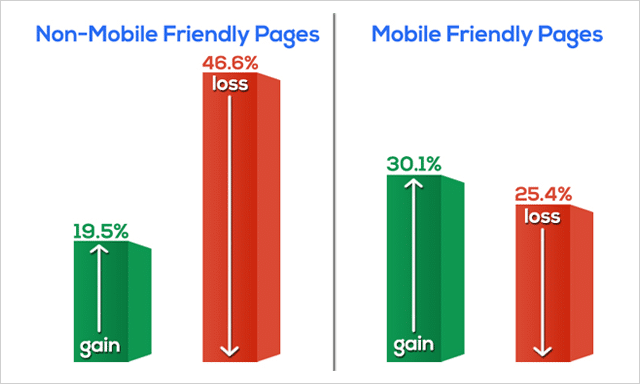

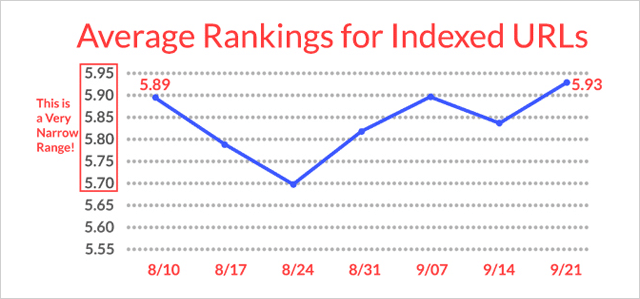

W tygodniu poprzedzającym 17 kwietnia 2015 r. (przed Mobilegeddon) Stone Temple pobrał dane z rankingu 10 najlepszych wyników dla 15 235 zapytań. Pobrali dane dotyczące tych samych 15 235 zapytań ponownie w tygodniu od 18 maja 2015 r. (po Mobilegeddon).

Zarejestrowali pozycje w rankingu, a także określili, czy fragmenty adresów URL w wynikach zostały oznaczone przez Google jako przyjazne dla urządzeń mobilnych, czy nie.

Oto, co znaleźli:

Strony internetowe nieprzyjazne dla urządzeń mobilnych drastycznie straciły w rankingach.

W rzeczywistości prawie 50% wszystkich stron internetowych nieprzyjaznych dla urządzeń mobilnych spadło z SERP.

Strony przyjazne dla urządzeń mobilnych (ogółem) zyskały w rankingu.

Dane, które Eric i zespół zebrali w teście Mobilegeddon, wyraźnie przeczą ogólnej opinii prasy branżowej.

Dlaczego prasa się myliła?

Jest prawdopodobne, że ponieważ aktualizacja algorytmu była wprowadzana powoli z biegiem czasu, nie było od razu oczywiste, że miały miejsce tak znaczące ruchy.

W tym samym okresie wydano również aktualizację jakości, która mogła zaciemnić wpływ Mobilegeddon na rankingi wyszukiwania.

Zakończmy więc szybko Mobilegeddon trzema punktami;

- To była wielka sprawa.

- Jeśli jeszcze nie jesteś „mobilny”, na co czekasz?

- Jeśli nie masz pewności, czy Twoja witryna jest przyjazna dla urządzeń mobilnych, wykonaj ten test.

3. Echa linków: jak działają linki zwrotne nawet po ich usunięciu

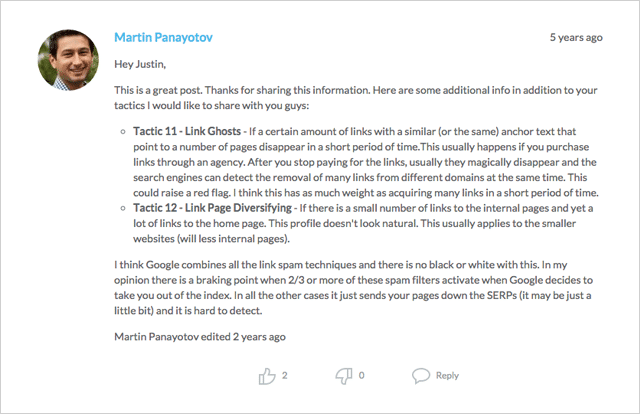

Kredyt, w przypadku którego należy się kredyt.

Pomysł „ech linków” (lub „duchów linków”, jak się o nich również mówi) został po raz pierwszy zidentyfikowany przez Martina Panayotova, a także przez Mike'a Kinga z iPullRank w komentarzach do tego posta.

Pomysł polega na tym, że Google będzie nadal śledzić linki i brać pod uwagę ich wartość (pozytywną lub negatywną) nawet po usunięciu linków.

Jeśli tak jest, czy witryna, która zyskała rangę po dodaniu linku, nadal ma rangę po usunięciu linku?

Więc, zobaczmy.

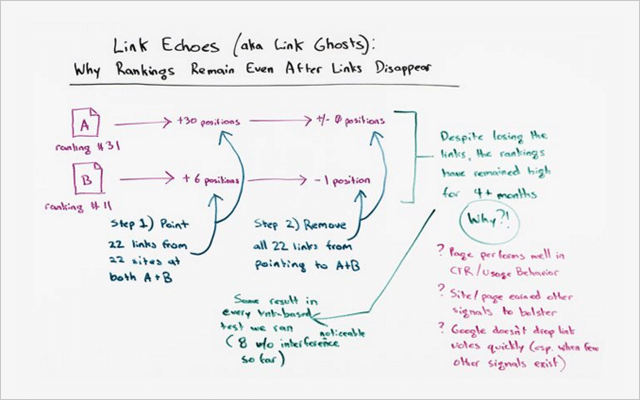

Ten konkretny eksperyment został przeprowadzony przez zespół z Moz i należał do serii, która miała na celu przetestowanie wpływu linków z tekstem zakotwiczenia (patrz numer eksperymentu SEO 8) na rankingi wyszukiwania.

Ale, jak to często bywa w nauce, eksperymenty przyniosły zupełnie nieoczekiwane odkrycia.

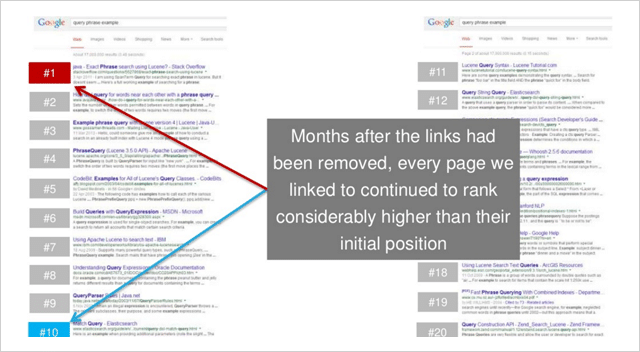

Efekt echa łącza

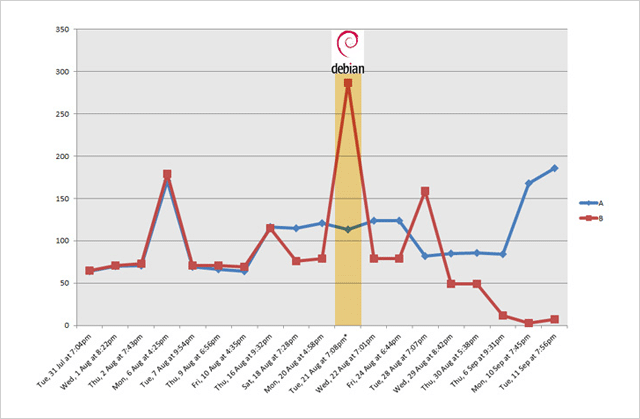

W tym eksperymencie były 2 strony internetowe; Witryna A i Witryna B.

Przed testem wyglądali tak, jak pozycjonowali się na to samo (niezbyt konkurencyjne słowo kluczowe):

- Strona A – pozycja 31

- Strona B – pozycja 11

Podczas testu dodano linki do 22 stron w różnych witrynach internetowych wskazujących zarówno na witrynę A, jak i witrynę B.

Obie strony, które otrzymały po 22 linki, następnie awansowały w rankingach:

- Strona A przeniesiona z pozycji 31 na pozycję 1 (wzrost o +30 pozycji)

- Strona B przeniesiona z pozycji 11 na pozycję 5 (i wzrost o +6 pozycji)

Krótko mówiąc, obie strony znacznie wzrosły w rankingu po dodaniu linków.

Ale co się stało, gdy te same linki zostały usunięte?

Odpowiedź. Bardzo mało.

Serwis A pozostał na pierwszym miejscu.

Witryna B spadła nieznacznie do pozycji 6 (niewielki spadek tylko o 1 pozycję)

Ten eksperyment potwierdza hipotezę.

Wygląda na to , że pewna wartość z linków (być może duża) pozostaje, nawet po usunięciu linków.

Czy ten eksperyment mógł być odosobnionym przypadkiem?

Nie według Randa Fishkina:

„Ten efekt tych testów linków, które pozostawały na miejscu długo po usunięciu linku, wystąpił w każdym przeprowadzonym przez nas teście linków, z których naliczyłem osiem, w których jestem bardzo pewny, że nie ma mylących zmiennych, czuję się naprawdę dobrze, że my podążał za procesem podobnym do tego. Wskazywane linki, ranking wzrósł. Linki zniknęły, ranking pozostał na wysokim poziomie.”

Ale oto, co jest tak niezwykłe…

Te wyższe rankingi nie były krótkotrwałe.

Pozostały przez wiele miesięcy po usunięciu linków.

W czasie tego filmu wyniki były prawdziwe przez 4,5 miesiąca.

Ponadto…

„W żadnym teście, gdy linki zostały usunięte, rankingi nie powróciły do swojej pierwotnej pozycji”, mówi Rand Fiskin.

Jest kilka lekcji, które możesz z tego wyciągnąć, ale zostawię to na tych dwóch:

(1) Linki wysokiej jakości są na wagę złota . Podobnie jak solidna inwestycja, linki zwrotne będą nadal zapewniać dobry zwrot. „Echo” raz oddanego głosu (jak udowodnił ten test) przyniesie korzyści nawet po usunięciu.

(2) Wartość linków pozostaje przez jakiś czas . Tak więc, zanim kusisz się na pozyskanie nielegalnych linków, zastanów się, czy jesteś gotowy, aby pozostawić to śladem przez miesiące (a nawet lata).

Krótko mówiąc, poświęć swój czas na budowanie naturalnych linków organicznych.

Linki mogą działać dla Ciebie lub przeciwko Tobie. Więc upewnij się, że to pierwsze.

Nie masz strategii budowania linków?

Sprawdź ten post, w którym znajdziesz dziesiątki pomysłów na dobry początek.

4. Możesz oceniać za pomocą zduplikowanych treści. Działa nawet na konkurencyjnych słowach kluczowych

Pełne ujawnienie tego, czym się z wami podzielę, może działać tylko przez krótki czas. Ale na razie działa , chłopak działa jak gangsterzy.

Najpierw teoria.

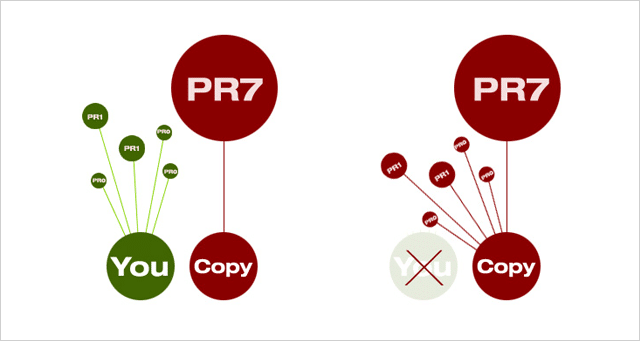

Gdy w sieci pojawią się dwa identyczne dokumenty, Google wybierze ten z wyższym PageRank i użyje go w wynikach wyszukiwania.

Przesyła również wszelkie linki z dowolnego postrzeganego „duplikatu” do wybranego „głównego” dokumentu.

Dlaczego to robi?

O ile nie ma ważnego powodu dla dwóch lub więcej wersji tej samej treści, istnieje tylko jedna potrzeba.

A co to oznacza dla Ciebie?

Oznacza to, że jeśli tworzysz unikatową i autorytatywną treść (która przyciąga linki i udostępnianie wysokiej jakości), powinieneś wyjść na szczyt. Google zachowa Twoją wersję w indeksie i wskaże wszystkie linki prowadzące do duplikatów do Twojej witryny.

Złe wieści (przynajmniej dla dobrych) nie zawsze tak jest.

Od czasu do czasu większa, bardziej autorytatywna witryna wyprzedzi mniejsze witryny w SERP o własną treść.

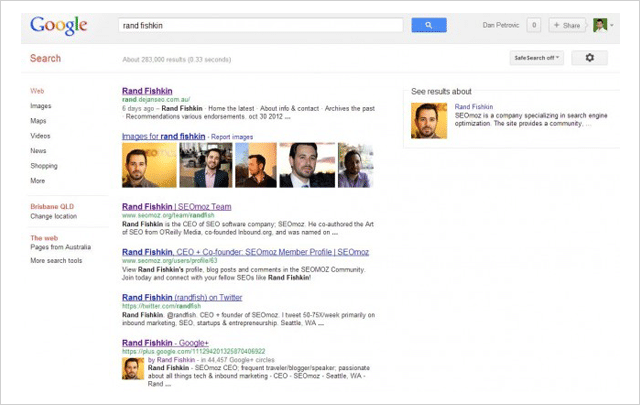

To właśnie Dan Petrovic z Dejan SEO postanowił przetestować w swoim słynnym eksperymencie z przejęciem SERP.

Korzystając z czterech oddzielnych stron internetowych, przetestował, czy treść może zostać „przechwycona” z wyników wyszukiwania, kopiując ją i umieszczając na wyższej stronie PageRank – która następnie zastąpiłaby oryginał w SERPach.

Oto, co się stało:

- We wszystkich czterech testach wyższa strona naśladująca PR pobiła oryginalną .

- W 3 na 4 przypadki oryginalna strona została usunięta z SERP .

Jego testy mają na celu udowodnienie, że wyższa strona PageRank pokona niższą stronę PageRank z tą samą treścią, nawet jeśli strona o niższym PR jest oryginalnym źródłem.

I nawet jeśli oryginalna strona została stworzona przez samego byłego Czarnoksiężnika z Moz, Randa Fishkina.

( Zdjęcie: Rand Fishkin został przewagi nad własnym nazwiskiem w eksperymencie Dana Petrovica.)

Powstaje więc pytanie, co możesz zrobić, aby zapobiec przejęciu własnych treści?

Chociaż nie ma gwarancji, że możesz zapobiec kopiowaniu, a następnie biciu własnych, ciężko zarobionych treści, Dan oferuje następujące środki, które mogą pomóc w obronie przed złodziejami treści:

(1) Dodaj tag rel="canonical" do treści, używając pełnego tekstu http://.

(2) Link do stron wewnętrznych w Twojej witrynie.

(3) Dodaj znacznik autorstwa Google.

(4) Regularnie sprawdzaj duplikaty treści za pomocą narzędzia takiego jak Copyscape.

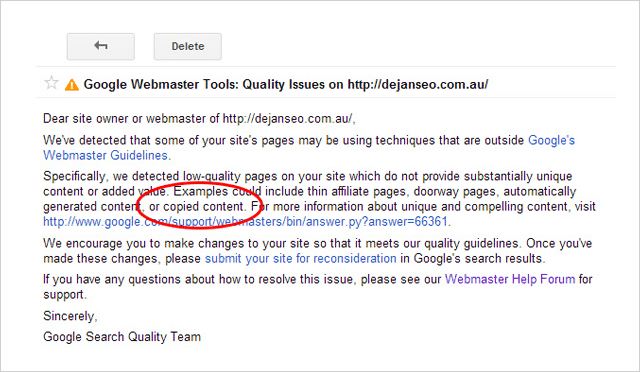

Plagiatorzy Uważaj

Tylko dlatego, że możesz pokonać swoich konkurentów, kradnąc ich zawartość, nie oznacza to, że powinieneś .

Twierdzenie, że treści należące do kogoś innego jako własne jest nie tylko nieetyczne i podejrzane, ale także plagiat może wpędzić Cię w kłopoty.

Wkrótce po przeprowadzeniu eksperymentu Dejan SEO otrzymał ostrzeżenie na swoim koncie Google Search Console.

W wiadomości podano, że domena dejanseo.com.au zawiera strony niskiej jakości, czego przykładem jest „skopiowana treść”. Mniej więcej w tym samym czasie jedna ze stron testowych naśladowców również przestała pojawiać się w SERP dla niektórych terminów.

To zmusiło Dana do usunięcia stron testowych w celu rozwiązania problemu z jakością jego witryny.

Wygląda więc na to, że chociaż możesz pokonać swoich konkurentów ich własnymi treściami, zdecydowanie nie jest to dobry pomysł.

5. Numer jeden NIE JEST „Top Miejsce” (i co jest teraz)

W tym teście Eric Enge i zespół Stone Temple Consulting (obecnie część Perficient) postanowili zmierzyć zmianę w wyświetlaniu Rich Answers w wynikach wyszukiwania Google.

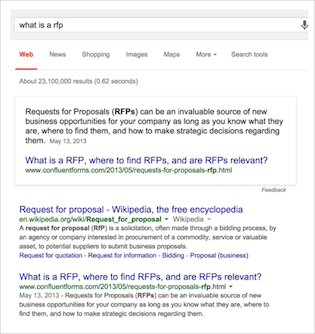

Na wypadek, gdybyś nie znał terminologii…

Bogate odpowiedzi to odpowiedzi „w wyszukiwaniu” na Twoje zapytania, których prawdopodobnie ostatnio częściej spotykasz. Mają na celu odpowiedzieć na Twoje zapytanie bez konieczności przechodzenia do witryny.

Istnieje wiele odmian bogatych odpowiedzi, takich jak ta:

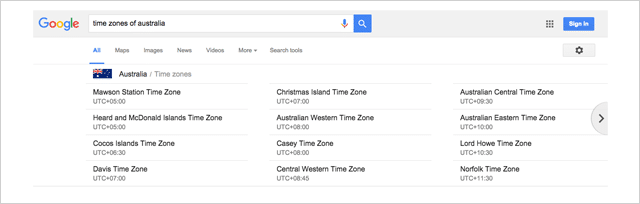

Albo ta karuzela, która mi się wyświetlała, gdy szukałem „strefy czasowe australii”

Istnieją dosłownie dziesiątki odmian, z których wiele udostępnia tutaj Google.

Stone Temple Consulting Studium bogatych odpowiedzi

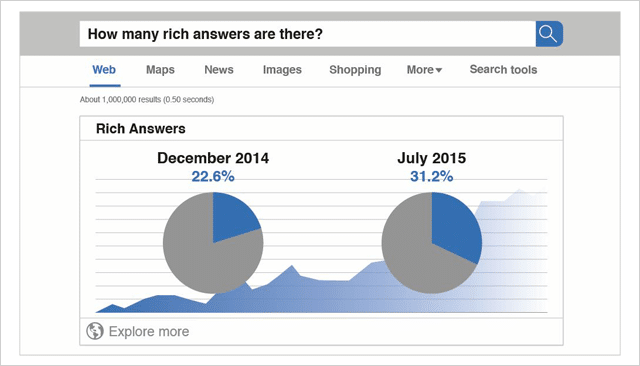

Dane wyjściowe dla tego badania zostały zebrane w grudniu 2014 roku.

Łącznie przeanalizowano 855 243 zapytania.

Spośród wszystkich zapytań zmierzonych w tym czasie 22,6% wyświetlało rozszerzone odpowiedzi.

Później w lipcu 2015 r. te same 855 243 zapytania zostały ponownie przeanalizowane.

W tym czasie (zaledwie 7 miesięcy później) łączny odsetek zapytań wyświetlających Rich Answers wzrósł do 31,2%.

Ponieważ badanie Stone Temple Consulting zmierzyło dokładnie te same 855 243 zapytania, porównanie między tymi dwoma zestawami danych jest ścisłym porównaniem jabłka do jabłka.

Dane są jasne.

Rich Answers rośnie, a wyniki, które widzisz dzisiaj, są dalekie od dziesięciu niebieskich linków z przeszłości.

( Źródło: Quicksprout)

Zmieniający się widok w wynikach wyszukiwania

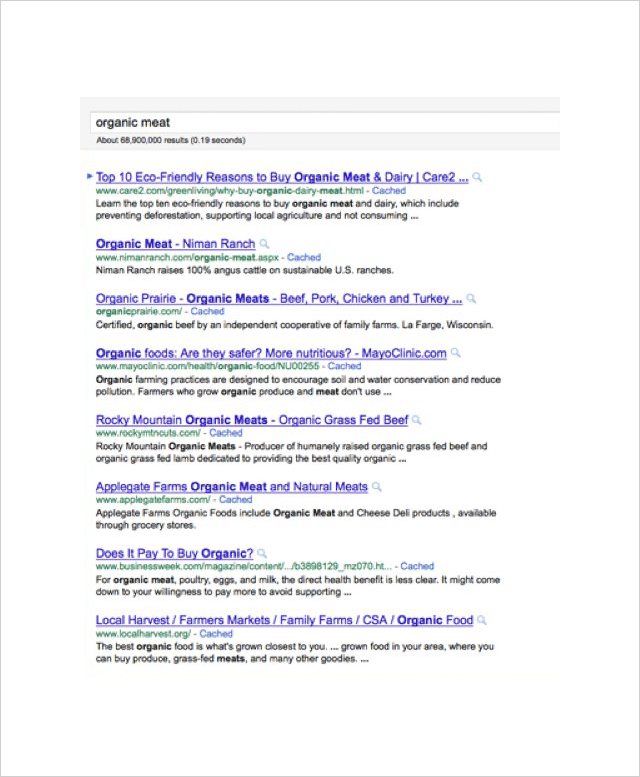

Kiedy strony wyników wyszukiwania były tylko listą witryn uporządkowanych według ich trafności do zapytania, jasne było, dlaczego właściciele witryn zrobiliby wszystko, co mogli, aby zdobyć pierwsze miejsce.

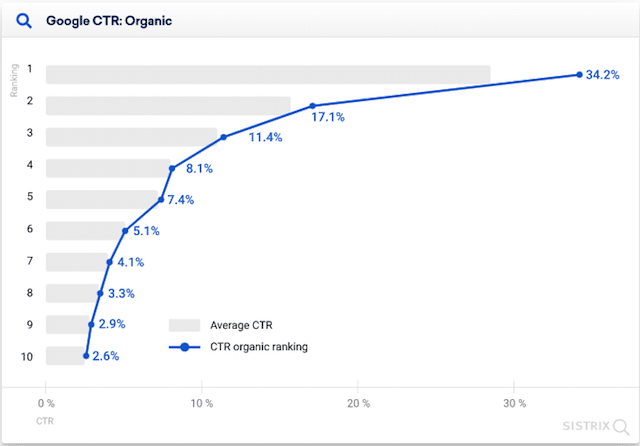

Im wyżej w rankingach, tym więcej masz kliknięć.

Według tego badania przeprowadzonego przez Erez Barak z Optify, w 2011 roku strona zajmująca najwyższe pozycje w rankingu uzyskała aż 37% wszystkich kliknięć.

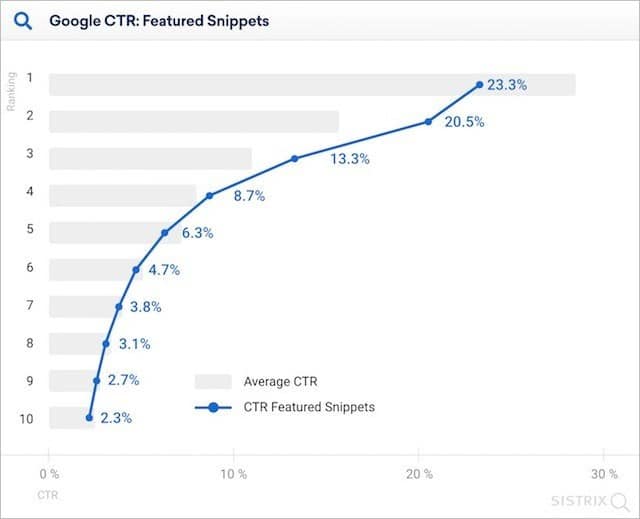

Nawet w 2020 r. Sistrix poinformował w swoich badaniach, że witryny zajmujące najwyższe pozycje w rankingu (w których nie są wyświetlane żadne fragmenty tekstu) generują ponad dwukrotnie więcej kliknięć w porównaniu do witryn umieszczonych na drugim miejscu.

Ale wraz z rozwojem Rich Answers wszystko się zmienia.

Wynik organiczny „numer jeden” jest przesuwany coraz dalej w dół strony. Liczba kliknięć na „najwyższym miejscu” spada.

Ale jak bardzo Rich Answers wpływa na współczynniki klikalności?

Krótka odpowiedź to dużo.

W badaniu z 2020 r. Sistrix ustalił, że w przypadku obecności polecanego fragmentu, numer jeden w rankingu stron internetowych uzyskał 23,3% kliknięć.

To o jedenaście procent mniej niż w przypadku braku polecanego fragmentu.

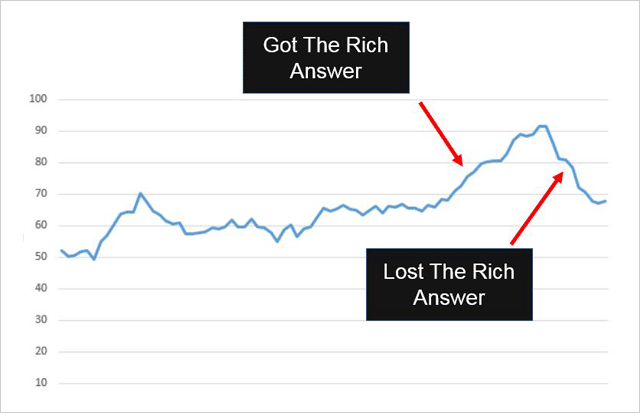

Wyraźnie widać, jak włączenie (i usunięcie) odpowiedzi z fragmentem rozszerzonym w SERP może wpłynąć na ogólny ruch wyszukiwania w witrynie.

Oto jeden przykład:

Confluent Forms uzyskał wynik Rich Snippet wymieniony na swojej stronie internetowej i oto, co stało się z ich ruchem:

Wzrosła po dodaniu Rich Answer.

Upadł, gdy usunięto Rich Answer.

I zapamiętaj to…

Rich Answers mają na celu rozwiązywanie zapytań z wyników wyszukiwania. Mogą jednak nadal wysyłać dodatkowy ruch do Twojej witryny , tak jak w przypadku formularzy Confluent Forms.

Jak korzystać z bogatych odpowiedzi na swoją korzyść

Rich Answers są zazwyczaj udostępniane w przypadku zapytań wyszukiwania opartych na pytaniach.

A według Erica Enge (który z powodzeniem umieścił obszerną odpowiedź na swojej własnej stronie internetowej) odpowiadanie na pytania jest najlepszym sposobem na to.

Jeśli chcesz skorzystać z Rich Answers (a kto by nie chciał), sugeruję, abyś posłuchał jego rady:

(1) Określ proste pytanie – Upewnij się, że pytanie jest na temat. Możesz to sprawdzić za pomocą narzędzia Relevance, takiego jak nTopic.

(2) Podaj bezpośrednią odpowiedź – Upewnij się, że Twoja odpowiedź jest prosta, jasna i przydatna zarówno dla użytkowników, jak i wyszukiwarek.

(3) Zaoferuj informacje o wartości dodanej – Oprócz zwięzłej odpowiedzi na pytanie, podaj więcej szczegółów i wartości. Pamiętaj, aby nie cytować ponownie Wikipedii, ponieważ nie zaprowadzi Cię to zbyt daleko.

(4) Ułatw wyszukiwanie użytkownikom i Google – może to oznaczać udostępnianie ich obserwatorom w mediach społecznościowych lub umieszczanie linków do nich w witrynach własnych lub stron trzecich.

6. Używanie HTTPS może w rzeczywistości zaszkodzić Twojej pozycji

Zabezpiecz swoją witrynę lub w inny sposób.

To była wiadomość, którą Google przedstawił w tym poście na blogu, gdy podało HTTPS jako sygnał rankingowy.

I to miałoby sens, prawda?

Strony internetowe korzystające z protokołu HTTPS są bezpieczniejsze. Google chce, aby witryny, do których użytkownicy uzyskiwali dostęp z wyszukiwarki, były bezpieczne. Witryny korzystające z protokołu HTTPS powinny otrzymać wyższą pozycję w rankingu.

Ale o to chodzi. Nie.

(To znaczy, jeśli badanie przeprowadzone przez Stone Temple Consulting i seoClarity jest czymś, przez co można przejść.)

Badanie HTTPS śledziło rankingi dla 50 000 wyszukiwań słów kluczowych i 218 000 domen. Monitorowali te rankingi w czasie i obserwowali, które adresy URL w SERP zmieniły się z HTTP na HTTPS.

Spośród 218 000 śledzonych domen tylko 630 (0,3%) przeszło na HTTPS.

Oto, co się stało ze stronami HTTPS:

Właściwie stracili pozycję w rankingu .

Później doszli do siebie (powoli) do miejsca, w którym zaczęli.

To nie jest powód, aby wskoczyć na modę HTTPS.

Wygląda na to, że HTTPS (pomimo tego, że Google chce, aby był standardem wszędzie w sieci) nie ma na razie znaczących korzyści w rankingu i może w rzeczywistości zaszkodzić twoim rankingom w krótkim okresie.

Moja rada : pozostań przy użyciu HTTP, chyba że naprawdę musisz zmienić.

7. Robots.txt NoIndex nie (zawsze) działa

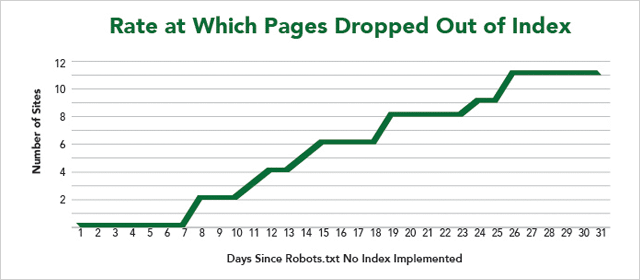

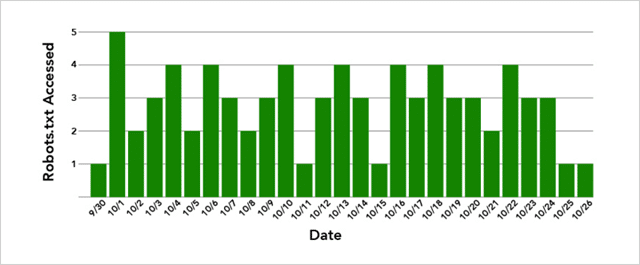

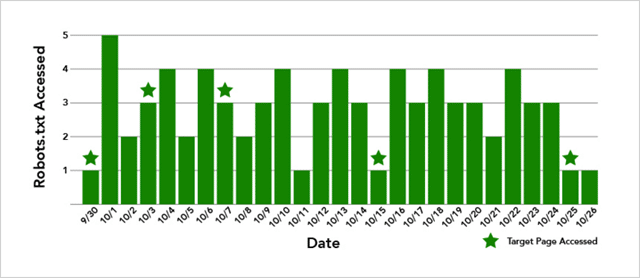

W innym eksperymencie przeprowadzonym przez laboratorium IMEC, 12 stron internetowych zaoferowało swoje strony w celu sprawdzenia, czy użycie pliku Robots.txt NoIndex skutecznie blokuje wyszukiwarkom indeksowanie ORAZ indeksowanie strony.

Najpierw sprawa techniczna.

Jak zatrzymać indeksowanie Twojej strony internetowej przez wyszukiwarki?

Typowym podejściem przyjętym przez webmasterów jest dodanie dyrektywy NoIndex do metatagu Robots na stronie. Gdy roboty-pająki wyszukiwarek indeksują tę stronę, identyfikują dyrektywę NoIndex w nagłówku strony i usuwają ją z indeksu.

Krótko mówiąc, indeksują stronę, a następnie przestają wyświetlać ją w wynikach wyszukiwania.

Kod wygląda tak:

Z drugiej strony dyrektywa NoIndex umieszczona w pliku Robots.txt witryny internetowej zarówno zatrzyma indeksowanie strony, jak i jej indeksowanie.

A przynajmniej powinno…

Jak widać z wyników, nie wszystkie strony internetowe zostały usunięte z indeksu.

Złe wieści, jeśli chcesz ukryć zawartość swojej witryny przed ciekawskimi oczami.

Co więcej, Google nie usunął żadnej ze stron od razu, mimo że pliki Robots.txt witryny były indeksowane kilka razy dziennie.

A jeśli uważasz, że dzieje się tak dlatego, że Google musi również spróbować zaindeksować samą stronę, to też nie jest to prawda.

W przypadku witryny, która nie została usunięta z indeksu, strona docelowa została zindeksowana 5 razy:

Więc o co tu chodzi?

Cóż, wyniki są niejednoznaczne.

Ale możemy być pewni, że możemy powiedzieć, że (pomimo Google pokazującego wsparcie dla Robots.txt NoIndex) działa wolno, a czasami w ogóle nie działa.

Moja rada: Używaj Robots.txt NoIndex z ostrożnością.

8. Linki tekstowe do kotwicy w dopasowaniu ścisłym Przebijają linki bez kotwicy w dopasowaniu

Jeśli czytałeś kilka rzeczy o SEO, wiesz, że tekst zakotwiczenia w dopasowaniu ścisłym jest zły .

Zbyt wiele linków mówiących o tym samym jest nienaturalnych.

I może wylądować z karą.

Odkąd wypuszczono Google Penguin, aby położyć kres manipulatywnemu tworzeniu linków, eksperci radzą, aby „utrzymać niskie współczynniki tekstu kotwicy”.

Mówiąc prościej, oznacza to, że chcesz mieć mieszankę linków do swojej witryny, aby żaden tekst kotwicy zawierający słowa kluczowe nie stanowił więcej niż niewielki procent całości.

Surowe linki, takie jak: http//twojadomena.com, a także ogólne linki, takie jak „nazwa Twojej marki”, „kliknij tutaj” i „odwiedź tę witrynę”, są dobre.

Więcej niż mały procent linków bogatych w słowa kluczowe jest zły.

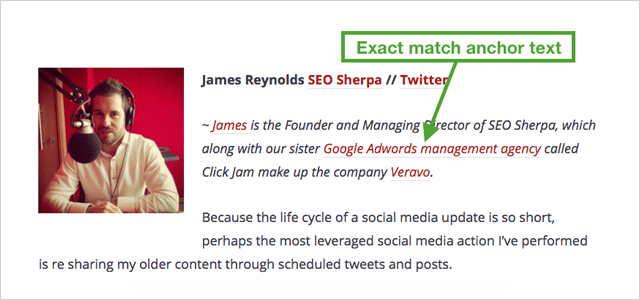

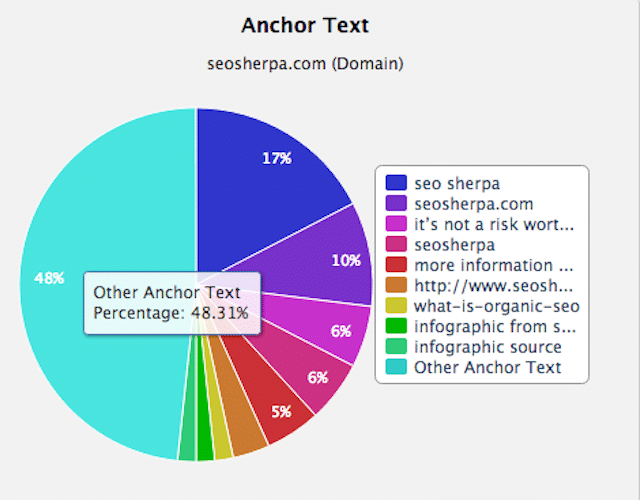

Zróżnicowany i naturalny profil linków będzie wyglądał podobnie do mojego:

Jak widać, większość linków dotyczy mojej marki. Reszta to w większości inny tekst zakotwiczenia.

Pamiętając o tym.

Co się stanie, gdy wskażesz 20 linków do witryny, wszystkie z tym samym tekstem kotwicy bogatym w słowa kluczowe?

Twoje rankingi gwałtownie rosną, ot co!

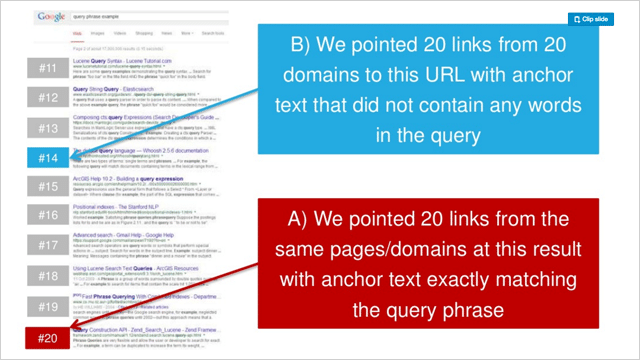

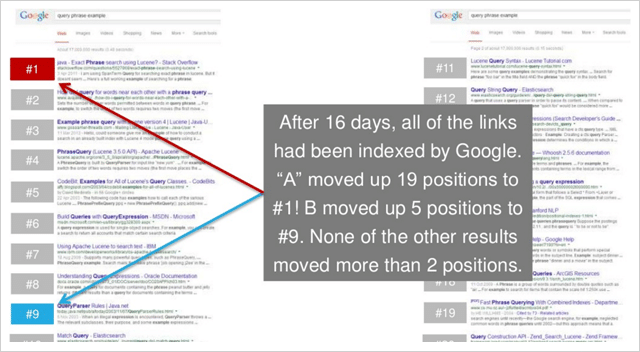

W serii trzech eksperymentów Rand Fishkin przetestował wskazywanie 20 ogólnych linków zakotwiczonych do strony internetowej w porównaniu z 20 linkami zakotwiczenia w dopasowaniu ścisłym.

W każdym przypadku tekst kotwicy w dopasowaniu ścisłym znacznie zwiększał ranking stron docelowych.

W 2 na 3 testy witryny z tekstem kotwicy z dokładnym dopasowaniem skapitulowały w wynikach ogólne witryny z tekstem kotwicy.

Oto rankingi sprzed testu 2 z serii Rand:

A oto rankingi po:

To cholernie rozstrzygające.

Tekst kotwicy w dopasowaniu ścisłym jest znacznie skuteczniejszy niż linki bez kotwicy.

(I zaskakująco potężny ogólnie)

9. Link do innych stron internetowych, aby podnieść swoje rankingi

Linki wychodzące osłabiają autorytet Twojej witryny.

Od pewnego czasu jest to powszechnie przyjęta koncepcja w świecie SEO.

I to pomimo tego, że Google twierdzi, że linkowanie do powiązanych zasobów to dobra praktyka.

Dlaczego więc SEO są tak przeciwne linkom wychodzącym?

Chodzi o to, że linki wychodzące tracą Twój PageRank. Im więcej linków wychodzących, tym więcej dajesz PageRank.

A ponieważ utrata PageRank oznacza utratę autorytetu, wynikiem linkowania są niższe rankingi. Prawidłowy

Cóż, dowiedzmy się.

Shai Aharony i zespół Reboot przetestowali to pojęcie w swoim eksperymencie z linkami wychodzącymi.

Na potrzeby eksperymentu Shai utworzył dziesięć stron internetowych, wszystkie z podobnymi formatami domen i strukturą.

Każda strona internetowa zawierała unikalny 300-wyrazowy artykuł, który został zoptymalizowany pod kątem wymyślonego słowa „phylandocic”

Przed testem słowo „phylandocic” wykazywało w Google zerowe wyniki.

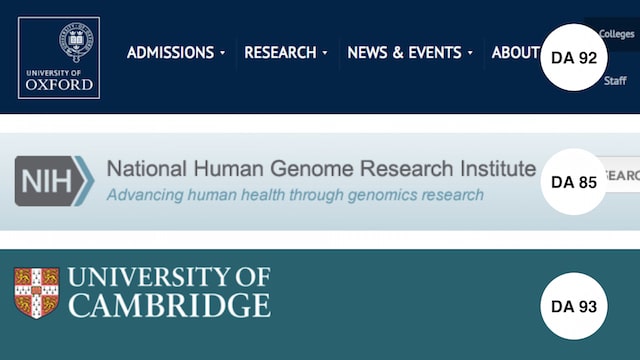

Aby przetestować działanie linków wychodzących, do 5 z 10 domen dodano 3 pełne linki śledzące.

Linki wskazywały na wysoce zaufane strony internetowe:

- Uniwersytet Oksfordzki (DA 92)

- Instytut Badań Genomu (DA 85)

- Uniwersytet Cambridge (DA 93)

Po zindeksowaniu wszystkich testowanych stron internetowych rejestrowano rankingi.

Oto wyniki:

Są jasne jak noc i dzień.

KAŻDA strona z linkami wychodzącymi przewyższała te bez.

Oznacza to, że krok działania jest prosty.

Za każdym razem, gdy publikujesz artykuł w swojej witrynie, upewnij się, że zawiera garść linków do odpowiednich i godnych zaufania zasobów.

Jak udowodnił eksperyment Reboota. Będzie służyć Twoim czytelnikom ORAZ Twoim rankingom.

10. Niesamowite odkrycie, które linki Nofollow faktycznie zwiększają Twoją pozycję

Kolejny eksperyment z laboratorium IMEC został przeprowadzony, aby odpowiedzieć:

Czy nieobserwowane linki mają bezpośredni wpływ na rankingi?

Ponieważ celem korzystania z linku „bez obserwowania” jest zatrzymanie przekazywania uprawnień, można oczekiwać, że linki „no-follow” nie będą miały żadnej (bezpośredniej) wartości SEO.

Ten eksperyment okazuje się inny.

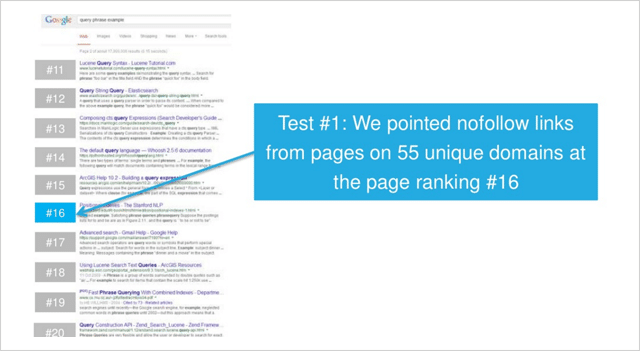

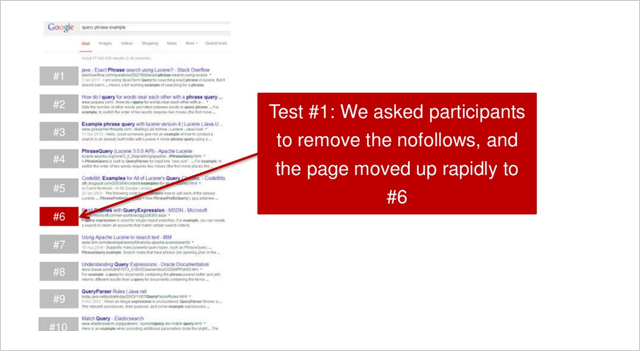

W pierwszym z dwóch testów uczestnicy IMEC Lab wskazali linki ze stron w 55 unikalnych domenach na 16 miejscu w rankingu.

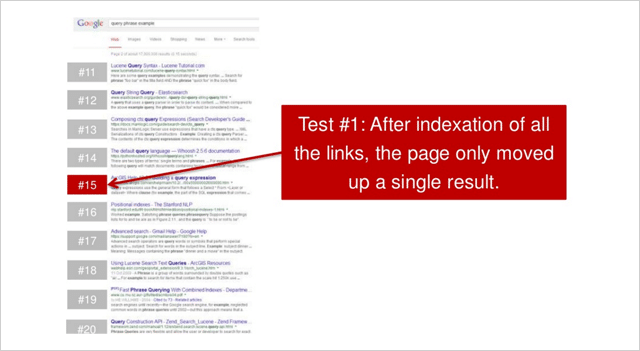

Po zindeksowaniu wszystkich linków nie obserwowanych, strona przesunęła się bardzo nieznacznie w górę dla konkurencyjnego zapytania o małej liczbie wyszukiwań, które jest mierzone.

Uczestników poproszono następnie o usunięcie linków, które nie pozwalają na obserwowanie, co skutkowało tym:

Strona szybko awansowała na szóstą pozycję.

Skumulowany wzrost o 10 pozycji, tylko z niektórych linków no-follow.

Nie jest zły.

Czy można to powtórzyć?

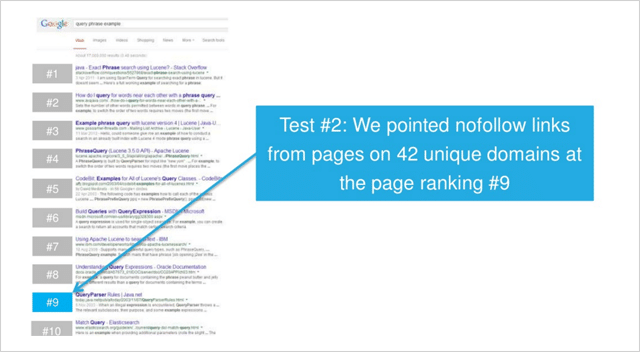

W drugim teście, tym razem w przypadku zapytania o niskiej konkurencji, do stron w 42 unikalnych domenach dodano linki „no-follow”.

( Uwaga – wszystkie linki znajdowały się w linkach tekstowych na stronie. Żaden nagłówek, stopka, pasek boczny, linki do widżetów (lub tym podobne) nie zostały użyte w żadnym teście.)

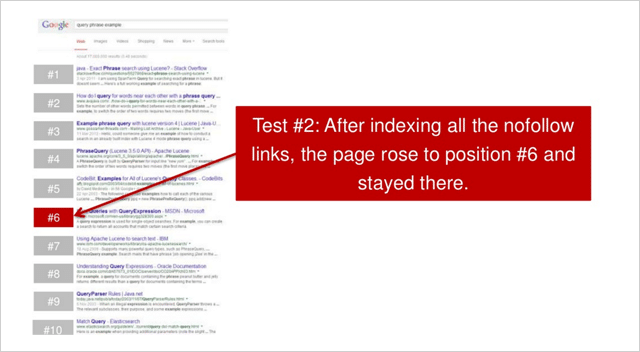

Po zindeksowaniu wszystkich linków strona wspięła się na 6. pozycję.

Wzrost o 3 pozycje.

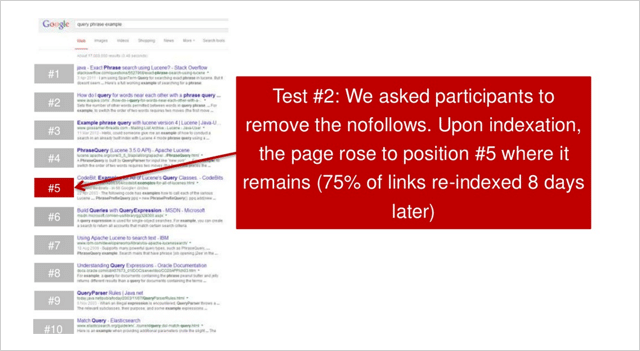

Następnie uczestnicy zostali poproszeni o usunięcie wszystkich linków, których nie można śledzić. Witryna następnie awansowała o jedną pozycję na 5. pozycję.

W obu testach; po pozyskaniu linków no-follow serwisy znacznie poprawiły swoje pozycje w rankingu

Pierwsza strona internetowa wzrosła o 10 pozycji.

Drugi serwis wzrósł o 4 pozycje.

A więc obalona kolejna teoria SEO?

Rand Fishkin zwraca uwagę, że test należy powtórzyć jeszcze kilka razy, aby był rozstrzygający.

„Moje na wynos. Test należy powtórzyć co najmniej 2-3 razy więcej, ale wczesne dane sugerują, że wydaje się, że istnieje związek między wzrostem rankingu a treścią, brakiem śledzonych linków” – mówi Rand.

Cóż, bez względu na to, jak wskazuje Nicole Kohler, z pewnością istnieje przypadek linków nie śledzących.

Linki rodzą linki.

I (zgodnie z tym badaniem) brak obserwowania lub pełne podążanie. OBYDWA są dla Ciebie wartościowe.

11. Fakt: linki ze stron internetowych z tysiącami linków działają

W SEO panuje przekonanie, że linki ze stron internetowych z wieloma linkami wychodzącymi nie są tak naprawdę wiele warte.

Teoria jest taka, że przy wielu linkach wychodzących „sok linków” AKA PageRank z linkowanej strony internetowej jest tak rozłożony, że wartość jednego linku do Twojej witryny nie może być zbyt duża.

Im więcej linków wychodzących ma witryna, tym mniejsza wartość jest przekazywana do Twojej witryny.

Teorię tę wzmacnia pogląd, że katalogi i inne witryny o niższej jakości, które mają wiele linków wychodzących, nie powinny zapewniać znaczących korzyści w rankingu witrynom, do których prowadzą linki. Z kolei linki ze stron internetowych z niewielką liczbą linków wychodzących są bardziej wartościowe.

Dokładnie to przetestował Dan Petrovic w swoim eksperymencie PageRank Split.

Test podziału PageRank

W swoim eksperymencie Dan utworzył 2 domeny (A i B).

Obie domeny to .com i obie miały podobne cechy i podobną, ale unikalną treść.

Jedyna rzeczywista różnica polegała na tym, że podczas testu do witryny B prowadziło łącze z witryny, do której prowadzi łącze z podstrony http://www.debian.org (PR 7), która zawiera 4225 zewnętrznych łączy.

Celem testu było po prostu sprawdzenie, czy w sytuacji, gdy istnieje tak wiele linków wychodzących, uzyskuje się jakikolwiek stopień PageRank i jaki wpływ (jeśli w ogóle) ma to na ranking stron, do których prowadzą linki.

Jeśli wiara większości SEO jest czymś, za czym można się kierować, niewiele powinno się wydarzyć.

Oto, co się stało…

Natychmiast po połączeniu się z witryną B z PR 7 debian.org (za pośrednictwem witryny bridge) witryna B wskoczyła w rankingu , ostatecznie osiągając pozycję 2.

I, jak wynika z ostatniej aktualizacji Dana (3 miesiące po teście), witryna B utrzymała swoją pozycję, utrzymując się na pierwszym miejscu jedynie dzięki znacznie bardziej autorytatywnej stronie PageRank 4.

Witryna A (do której nie podłączono) przez jakiś czas utrzymywała stałą pozycję, po czym spadła w rankingu.

Wygląda więc na to, że linki ze stron, które mają wiele linków wychodzących, są w rzeczywistości niezwykle cenne .

Jaki mit może następnie rozwiać nasza lista eksperymentów SEO…

12. Linki do obrazów działają (naprawdę) dobrze

Podobnie jak wiele eksperymentów SEO na tej liście, ten pojawił się, ponieważ jeden koleś miał przeczucie.

Pomysł Dana Petrovica polegał na tym, że tekst otaczający link odgrywa semantyczną rolę w algorytmie wyszukiwania Google.

Ale Dan nigdy nie był w stanie ustalić stopnia jego wpływu ani tego, czy w ogóle ma jakikolwiek wpływ .

Więc założył ten test, aby dowiedzieć się…

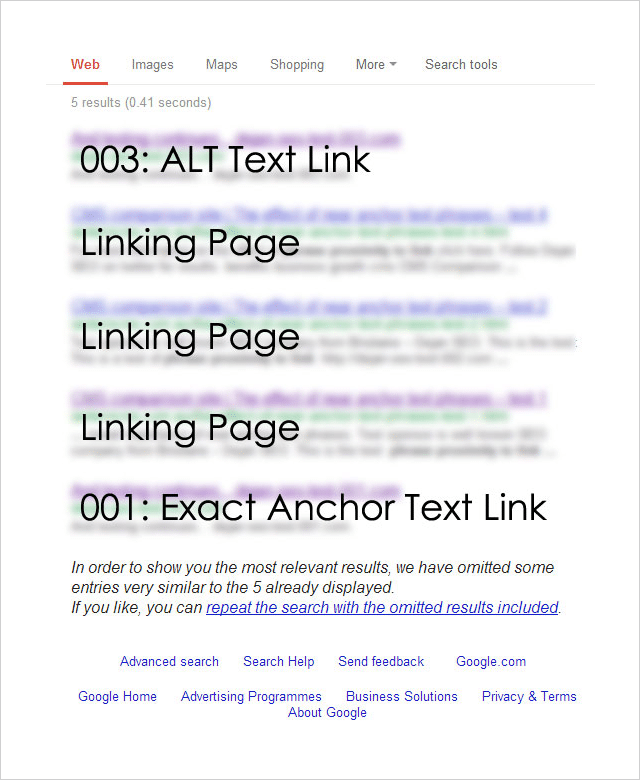

Eksperyment bliskości tekstu zakotwiczenia

Eksperyment miał na celu przetestowanie wpływu różnych typów linków (i ich kontekstu) na rankingi wyszukiwania.

Aby przeprowadzić test, Dan zarejestrował 4 prawie identyczne nazwy domen:

http://********001.com.au

http://********002.com.au

http://********003.com.au

http://********004.com.au

Each of the 4 domains was then linked to from a separate page on a well-established website. Each page targeted the same exact phrase but had a different link type pointing to it:

001: [exact phrase]

Used the exact target keyword phrase in the anchor text of the link.

002: Surrounding text followed by the [exact phrase]: http://********002.com.au

Exact target keyword phrase inside a relevant sentence immediately followed by a raw http:// link to the target page.

003: Image link with an ALT as [exact phrase]

An image linking to the target page that used the exact target keyword phrase as the ALT text for the image.

004: Some surrounding text with [exact phrase] near the link which says click here .

This variation used the junk anchor text link “click here” and the exact target keyword phrase near to the link.

So which link type had the greatest effect on rankings?

Here are the results:

Unsurprisingly, the exact match anchor text link worked well.

But most surprisingly, the ALT text-based image link worked best .

And, what about the other two link types?

The junk link (“click here”) and the raw link (“http//”) results did not show up at all.

The Anchor Text Lessons You Can Take Away From This

This is just one isolated experiment, but it's obvious that image links work really well.

Consider creating SEO-optimized image assets that you can utilize to generate backlinks.

The team at Ahrefs put together a useful post about image asset link building here.

But don't leave it at that, best results will come from a varied and natural backlink profile.

Check out this post from Brian Dean which provides 17 untapped backlink sources for you to try.

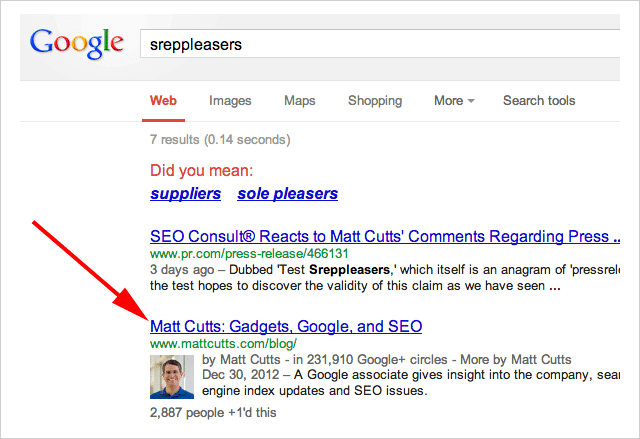

13. Press Release Links Work. Matt Cutts Take Note

Towards the end of 2014, Google's head of webspam publicly denounced press release links as holding no SEO value.

“Note: I wouldn't expect links from press release web sites to benefit your rankings” – Said Matt Cutts.

In an ironic (and brilliant) move, SEO Consult put Cutt's claim to the test this by issuing a press release which linked to, of all places….

Matt Cutts blog:

The anchor text used in the was the term “Sreppleasers”

The term is not present anywhere on Cutts's website.

Yet still, when you search “Sreppleasers” guess who's website comes up top?

There has been a lot of discussion about whether Press Release links work.

Is the jury still out on this?

I'll let you decide.

14. First Link Bias. Proven

First, let me say this…

This experiment is a few years old so things may now have changed. However, the results are so interesting it's very worthy of inclusion.

The theory for this experiment began with a post by Rand Fishkin which claimed that Google only counts one link to a URL from any given page.

Shortly after that post was published Rand's claims were debunked by David Eaves.

The opinion was rife in the SEO world as to whether either experiment was sound.

So, SEO Scientist set out to solve the argument once and for all.

The Test

The hypothesis goes something like this…

If a website is linked to twice (or more) from the same page, only the first link will affect rankings.

In order to conduct the test SEO Scientist set up two websites (A and B).

Website A links to website B with two links using different anchor texts.

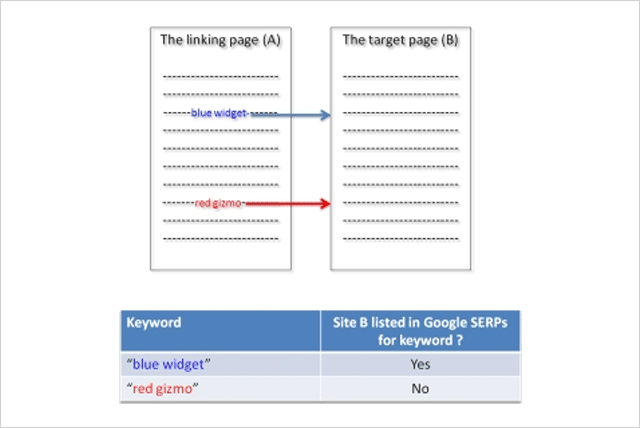

Test Variation 1

The websites were set up, then after the links got indexed by Google, the rankings of site B were checked for the two phrases.

Result : Site B ranked for the first phrase and not for the second phrase.

Here is what the results looked like:

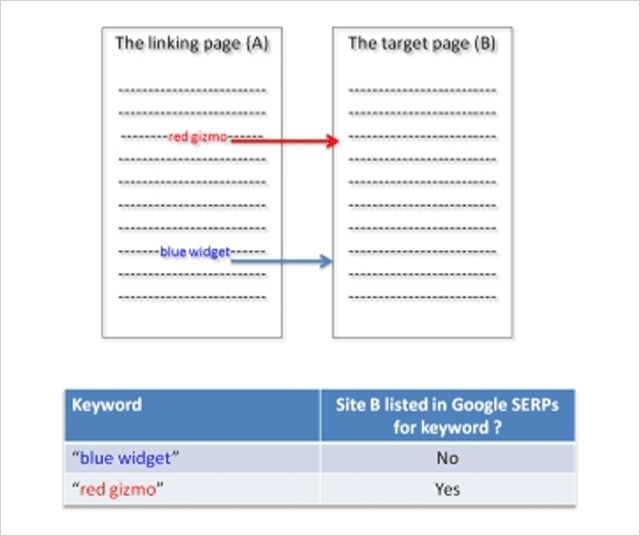

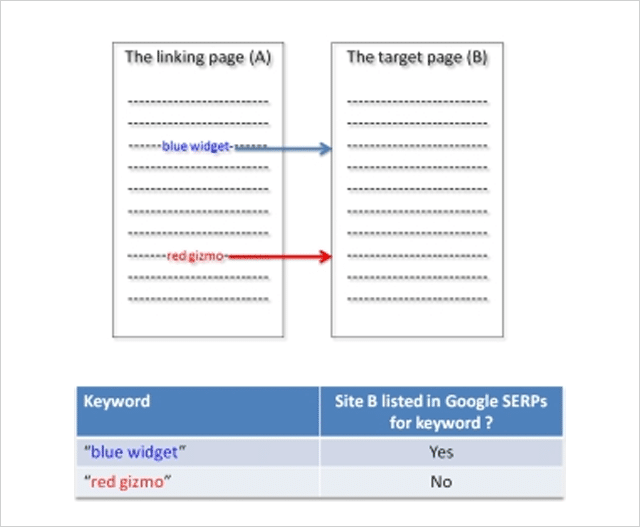

Test Variation 2

Next, the position of links to site B was switched. Now the second phrase appears above the previously first phrase on site A and visa versa.

Once Google had indexed the change, rankings were again checked for website B.

Result : Site B disappeared from the SERPs for the new second phrase (previously first) and appears for the new first phrase (previously second).

Rankings switched when the order of the links switched!

Test Variation 3

To check this was not some anomaly, in the third test variation the sites were reverted back to their original state.

Once the sites were re-indexed by Google, the rankings of website B were checked again.

Result : Site B reappeared for the initially first phrase and disappeared again for the initially second phrase:

The test proved that Google only counts the first link.

But, it gets even more interesting.

In a follow-up experiment, SEO Scientist made the first link “no follow” and still the second link was not counted!

The lesson from this experiment is clear.

If you are “self-creating” links ensure that your first link is to your most important target page.

15. The Surprising Influence of Anchor Text on Page Titles

Optimizing your Title tags has always been considered an important SEO activity and rightly so.

Numerous SEO studies have identified the title tag as a genuine ranking factor.

Since it's also what normally gets shown in the search results when Google lists your website, spending time on crafting well-optimized title tags is a good use of your time.

But, what if you don't bother?

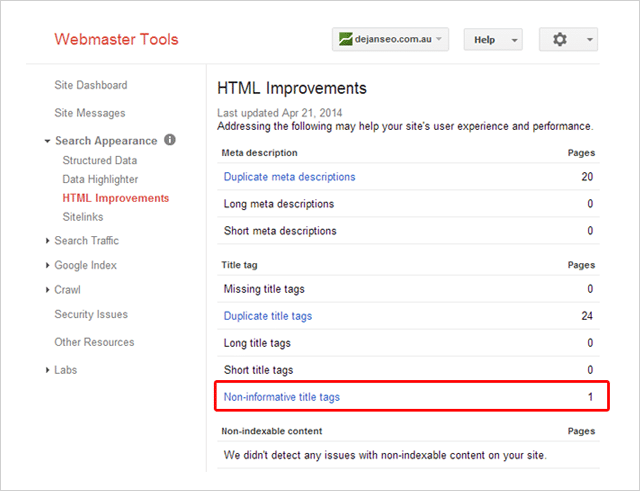

A few years ago Dejan SEO set out to test what factors Google considers when creating a document title when a title tag is not present.

They tested several factors including domain name, the header tag, and URLs – all of which did influence the document title shown in search results.

What about anchor text? Could that influence the title shown?

In this video Matt Cutts suggested it could:

But, wanting some real evidenc e Dan Petrovic put it to the test in this follow-up experiment.

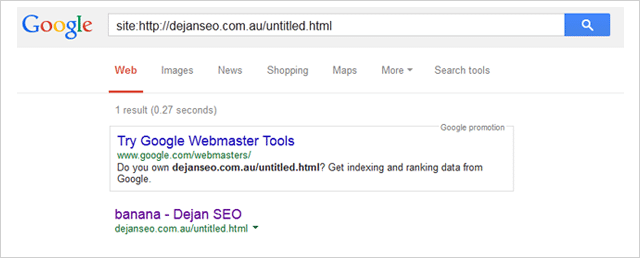

His experiment involved several participants linking to a page on his website using the anchor text “banana”.

The page being linked to had the non-informative title “Untitled Document”.

Here it is listed inside Dan's Search Console account:

Podczas testu Dan monitorował trzy zapytania:

- http://goo.gl/8uPrz0

- http://goo.gl/UzBOQh

- http://goo.gl/yW2iGi

A oto wynik:

Tytuł dokumentu cudownie ukazał się jako „banan”.

Test ma na celu udowodnienie, że tekst kotwicy może wpływać na tytuł dokumentu wyświetlany przez Google w wynikach wyszukiwania.

Czy to oznacza, że nie powinieneś pisać unikalnych i przekonujących tagów tytułowych dla każdej strony w swojej witrynie?

Proponuję nie.

Jak wskazuje Brian Dean, tag tytułowy Twojej strony może nie jest tak ważny jak kiedyś, ale nadal się liczy.

16. Negatywne SEO: jak możesz (ale nie powinieneś) szkodzić rankingom konkurencji

Nie ma wątpliwości, możliwe jest negatywne SEO.

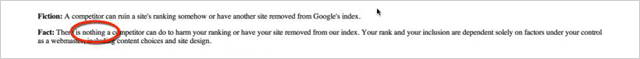

W 2003 roku Google zmienił swoje stanowisko z twierdzenia, że konkurencja nie może zrobić nic , aby zaszkodzić twojemu rankingowi:

Mówiąc, że prawie nic nie mogą zrobić:

![]()

Jeśli chodzi o Google, taka mała zmiana to całkiem DUŻA sprawa.

Powstaje więc pytanie…

Jak łatwo jest wpłynąć na ranking witryny (negatywnie)?

Tasty Placement przeprowadziło eksperyment, aby to ustalić.

Negatywne eksperymenty SEO

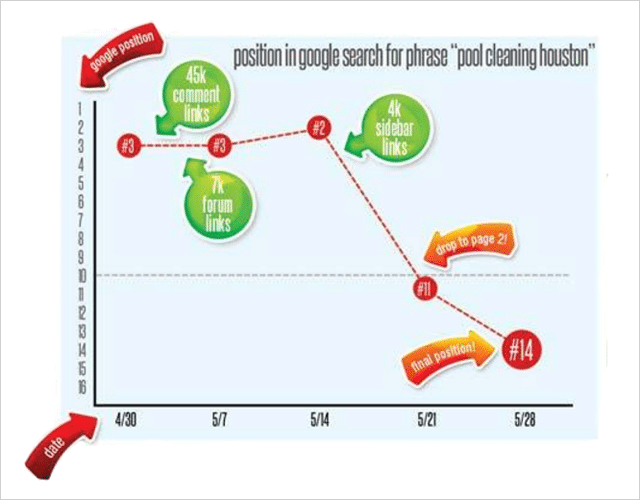

Próbując zaszkodzić rankingom wyszukiwania, Tasty Placement zakupiła dużą liczbę odsyłaczy spamowych, które wskazywały na swoją docelową witrynę Pool-Cleaning-Houston.com.

Witryna była stosunkowo ugruntowana i przed eksperymentem miała dobrą pozycję w rankingu kilku słów kluczowych, w tym „sprzątanie basenu” i innych podobnych.

Podczas eksperymentu śledzono łącznie 52 pozycje słów kluczowych.

Spam z linkami

Kupili różne niechciane linki do eksperymentu po bardzo niskich kosztach:

45 000 linków do komentarzy. Tekst zakotwiczenia „Sprzątanie basenu w Houston”. Koszt: $15

7000 dwupoziomowych linków do profilu forum. Tekst zakotwiczenia „Sprzątanie basenu w Houston”. Koszt: $ 5

Linki do blogów na pasku bocznym na czterech tandetnych blogach, które dają prawie 4000 linków. Tekst zakotwiczenia „Sprzątanie basenu w Houston”. Koszt: $20

Całkowity koszt?

Aż 40 dolców.

W ciągu 2 tygodni tanie łącza śmieci były wskazywane na Pool-Cleaning-Houston.com

Najpierw linki do komentarzy, następnie linki do profilu na forum, a na końcu linki do paska bocznego.

Oto, co stało się z rankingami „Houston czyszczenia basenów”

Partia linków do komentarzy nie przyniosła żadnego efektu.

7 dni później pojawiły się linki do postów na forum, po czym nastąpił zaskakujący wzrost rankingu witryny z pozycji 3 na pozycję 2. Wcale nie tego oczekiwano.

Kolejne 7 dni później dodano linki na pasku bocznym.

Wynik…

Bum!

Niemal natychmiast spadł w rankingach.

Oprócz głównego słowa kluczowego, kolejne 26 słów kluczowych również wyraźnie spadło .

Wygląda więc na to, że całkiem łatwo (i tanio) zniszczyć rankingi konkurentów, jeśli masz taką skłonność, a wiem, że tak nie jest!

Podczas gdy eksperyment Tasty Placement pozostawia kilka pytań dotyczących prawdziwej przyczyny spadku rankingu (powtarzający się tekst kotwicy lub może linki ze złego sąsiedztwa?), to jednak jasno pokazuje, że negatywne SEO jest prawdziwe.

I naprawdę łatwe do zrobienia.

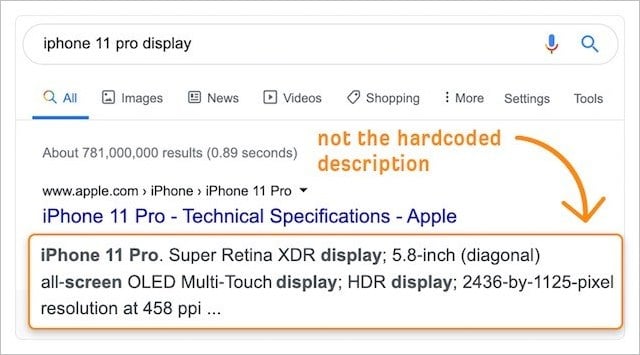

17. Czy Google pisze lepsze opisy niż Ty?

Jeśli zajmujesz się SEO od dłuższego czasu, prawdopodobnie napisałeś setki, jeśli nie tysiące metaopisów.

Ale jesteś z tym spoko.

Te niezliczone godziny pisania metaopisów to dobrze spędzony czas.

Wraz z rosnącym znaczeniem współczynnika klikalności w rankingach (patrz eksperyment nr 2) wszelkie ulepszenia fragmentów SERP witryny za pomocą niestandardowych (zakodowanych na stałe) opisów z pewnością poprawią wyniki.

W końcu najlepiej znamy nasz biznes i odbiorców.

Co oznacza, że nasze opisy muszą być lepsze od wersji generowanych automatycznie przez Google, prawda?

Niestety nie.

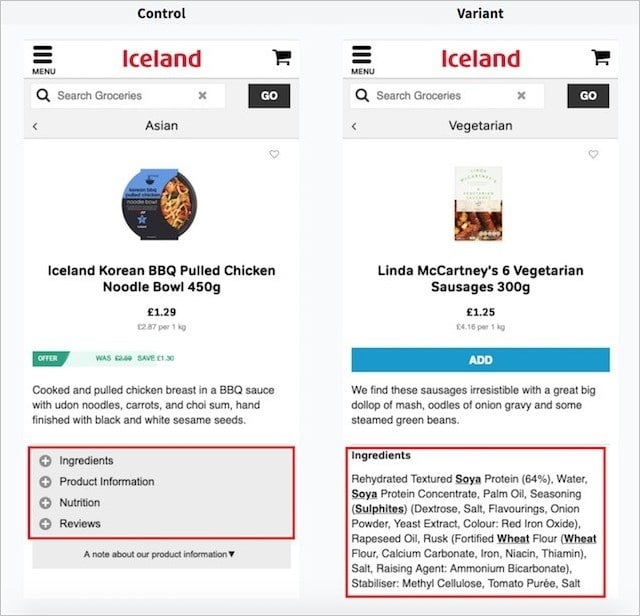

W niedawnym eksperymencie zespół Search Pilot stwierdził, że (przynajmniej w ich przypadku) automatycznie generowane opisy Google przewyższają niestandardowe metaopisy o współczynnik 3% .

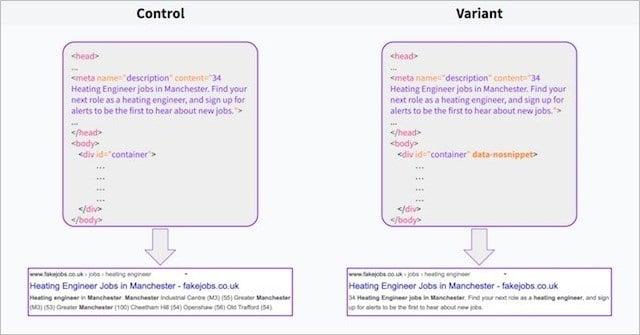

Używając atrybutu data-no snippet w elemencie treści połowy swoich stron, Search Pilot był w stanie przeprowadzić testy podziału opisów wygenerowanych przez Google (kontrola) z własnymi opisami niestandardowymi (wariant).

Bardzo szybko po rozpoczęciu testu klikalność spadała, aw ciągu dwóch tygodni test osiągnął istotność statystyczną dla wyniku negatywnego!

Krótko mówiąc, opisy Google działały lepiej.

Co możesz z tego wyciągnąć?

Google ma dostęp do ogromnej ilości danych użytkowników.

Ta przewaga danych pomaga Google wiedzieć, czego szukają użytkownicy, i tworzyć opisy, które są bardziej odpowiednie dla użytkowników niż te, które sami tworzymy – nawet jeśli własne opisy Google są wyskrobane i często czytane jak śmieci.

Potwierdzają to badania, które wykazały, że Google ignoruje tag meta description dla 63% zapytań.

Możemy założyć, że Google robi to, gdy metaopis utworzony przez właściciela witryny nie jest całkowicie związany z zapytaniem użytkownika – a Google uważa, że może wykonać lepszą pracę.

Badanie Search Pilot wskazuje, że tak.

Czy to oznacza, że powinieneś zrezygnować z pisania metaopisów i pozostawić to wszystko Google?

Nie zupełnie.

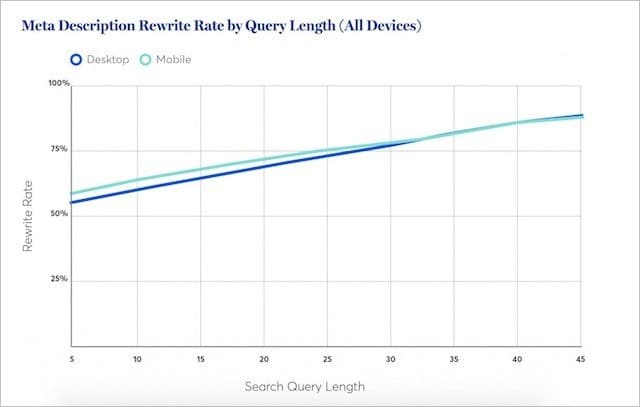

Badania Portent sugerują, że Google przepisuje mniej opisów meta dla krótkich (zwykle o dużej objętości) słów kluczowych.

W rzeczywistości, w przypadku najkrótszych zapytań, Google będzie kupować rzeczywisty opis meta co najmniej przez połowę czasu.

Oznacza to, że w około 50% wyszukiwań Twój metaopis będzie najlepszy.

Moja rada:

Kontynuuj pisanie niestandardowych opisów meta dla najważniejszych treści.

Ale pozbądź się opisów meta, w których potencjalny ruch dla Twoich treści jest mniejszy.

Google wykona dobrą robotę, tworząc odpowiednie opisy – statystycznie udowodnione, że przewyższają twoje.

18. Eksperyment z ukrytym tekstem

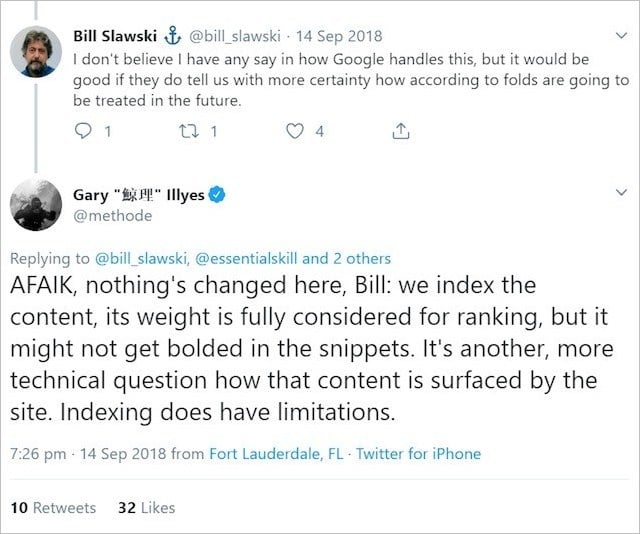

Google wielokrotnie powtarzało, że tak długo, jak masz tekst, który chcesz uszeregować na swojej stronie internetowej;

Będzie „w pełni uwzględniony w rankingu”.

Innymi słowy, możesz wyświetlać tekst w akordeonach, kartach i innych elementach rozwijanych, a Google uzna ten tekst z taką samą wagą jak tekst, który jest w pełni widoczny podczas ładowania strony.

Ta oficjalna linia Google zapewniła szczęśliwy kompromis dla SEO i twórców stron internetowych, którzy chcą zachować równowagę między treścią bogatą w tekst a eleganckim wyglądem.

Masz długi fragment tekstu?

Po prostu umieść go w rozwijanym bloku treści – i będzie to idealne rozwiązanie dla SEO.

A przynajmniej tak skłoniło nas Google.

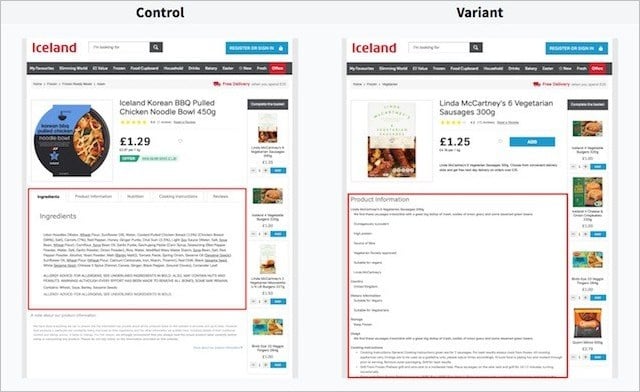

Wprowadź Search Pilot i ich eksperyment z ukrytym tekstem.

W swoim eksperymencie Search Pilot starał się przetestować skuteczność tekstu na kartach (kontrolka) w porównaniu z tekstem, który jest w pełni widoczny po wczytaniu strony (wariant).

Oto wersje strony na komputerze:

A oto wersje stron na urządzenia mobilne;

Podzielili się, przetestowali te dwie wersje na wielu stronach produktów w witrynie swojego klienta i zmierzyli zmianę ruchu organicznego w czasie.

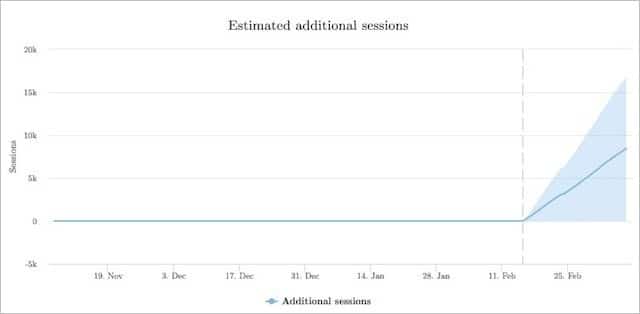

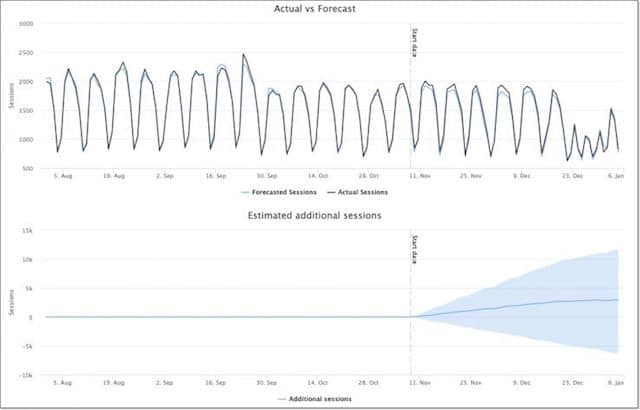

Oto, jak wariant (widoczny tekst) działał na kontrolce (tekst jest ukryty):

Wersja z w pełni widocznym tekstem uzyskała o 12% więcej sesji organicznych niż tekst ukryty w wersjach z zakładkami.

Z testu Search Pilot wynika, że widoczność treści na stronie może być znacznie lepsza dla ruchu organicznego.

Search Pilot nie był jedyną stroną, która przetestowała hipotezę, że większą wagę przywiązuje się do tekstu, który jest widoczny dla użytkownika, niż do tekstu, który jest poza bezpośrednim widokiem użytkownika.

Inny eksperyment przeprowadzony przez Reboot wykazał, że w pełni widoczny tekst (i tekst zawarty w obszarze tekstowym) znacznie przewyższa tekst ukryty za JavaScriptem i CSS:

19. Test szybkości strony (wyniki mogą Cię zaskoczyć)

Prawdopodobnie słyszałeś, że szybkość strony jest ważnym czynnikiem rankingowym.

Istnieją dosłownie tysiące blogów, które mówią, że im szybsza strona, tym większe prawdopodobieństwo, że będzie miała wyższą pozycję w rankingu.

Co więcej:

Nie tak dawno temu Google wydało „aktualizację prędkości”, która rzekomo powodowała powolne ładowanie witryn o niższej pozycji na urządzeniach mobilnych.

Ponieważ wszystkie informacje na temat czasu ładowania strony są ważne dla wyższych rankingów, z pewnością szybkość strony jest ważnym sygnałem rankingowym!

Więc, zobaczmy.

Dokładnie to przetestował Brain Dean w swoim eksperymencie dotyczącym szybkości strony :

Czy wyniki Cię zaskoczyły?

20. Tagi H1 i ich wpływ na rankingi: debata dobiegła końca

Każdy przewodnik SEO oferuje te same porady:

(Opakuj tytuł swojej strony lub posta w tag H1)

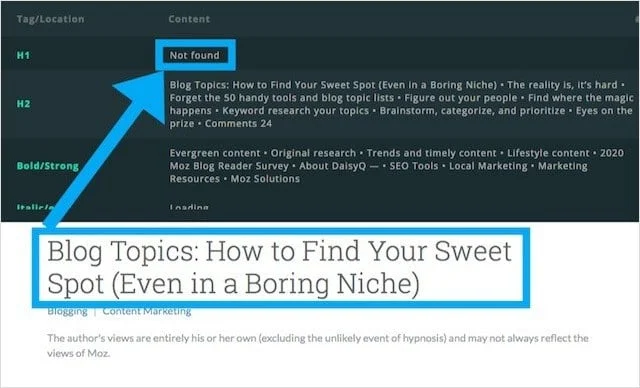

Ale nie wszystkie strony internetowe stosują te tak zwane najlepsze praktyki, a Moz.com jest jedną z nich.

Spojrzmy prawdzie w oczy:

Moz to jedna z najbardziej zaufanych (i często odwiedzanych) stron internetowych na temat SEO.

Ale nadal:

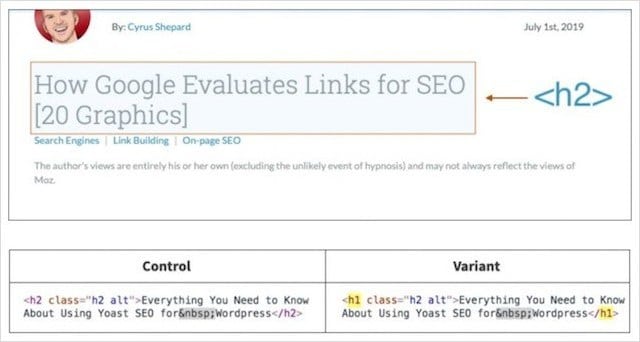

Blog Moz nie ma tagu H1 i zamiast tego używa tagu H2 w głównym nagłówku.

Po zauważeniu, że blog Moz używał tagów H2 jako nagłówków (zamiast H1), Craig Bradford z Distilled skontaktował się z Cyrusem Shepardem z Moz.

Craig i Cyrus postanowili wspólnie przeprowadzić eksperyment dotyczący tagów nagłówka, który, miejmy nadzieję, raz na zawsze określi, czy tagi H1 wpływają na rankingi organiczne.

W tym celu opracowali test podziału 50/50 nagłówków bloga Moz za pomocą SearchPilot.

W eksperymencie połowa nagłówków Moz została zmieniona na H1, a druga połowa została jako H2.

Cyrus i Crag zmierzyli następnie różnicę w ruchu organicznym między tymi dwiema grupami.

Wyniki eksperymentu z tagiem nagłówka

Jak myślisz, co się stało, gdy główne nagłówki zostały zmienione z nieprawidłowego tagu nagłówka (H2) na prawidłowy nagłówek (H1)?

Odpowiedź:

Niewiele!

Po ośmiu tygodniach zbierania danych ustalili, że zmiana nagłówków postów na blogu z H2 na H1 nie spowodowała statystycznie istotnej różnicy.

Co możemy z tego wywnioskować?

Po prostu Google jest w stanie określić kontekst strony w równym stopniu, jeśli główny nagłówek jest zawinięty w H1 lub H2.

Czy to oznacza, że powinieneś porzucić każdy przewodnik po najlepszych praktykach SEO i wyeliminować H1?

Nie!

Używanie H1 jako głównego nagłówka zapewnia odpowiednią strukturę treści narzędziom do czytania ekranu, pomagając tym samym osobom niedowidzącym lepiej poruszać się po treści.

Wyjaśnię tę i cztery inne mniej znane korzyści w moim obszernym przewodniku po tagach nagłówka.

Na razie przejdźmy do naszego ostatniego eksperymentu SEO.

21. Wspólny eksperyment hostingowy: udowodnienie efektu „złego sąsiedztwa”

Debaty na temat wpływu współdzielonego hostingu witryn i jego wpływu na rankingi szalały w społeczności SEO od eonów.

Debaty te skupiają się nie tylko na aspekcie wydajności hostingu współdzielonego (np. powolne czasy ładowania, które są ogólnie akceptowane jako mające negatywne skutki dla SEO), ale na koncepcji określanej jako „złe sąsiedztwo”.

Złe dzielnice, opisz środowisko hostingowe ze wspólnym adresem IP i zbiorem witryn niskiej jakości, niepowiązanych, ukaranych i/lub potencjalnie problematycznych (np. z pornografią, hazardem, tabletkami).

W ten sam sposób może to mieć negatywny wpływ, jeśli łączysz się lub otrzymujesz linki z witryn spamerskich;

Wielu uważało, że znalezienie Twojej witryny na tym samym serwerze, co witryny niskiej jakości lub niepowiązane, może mieć podobne skutki zmiażdżenia pozycji.

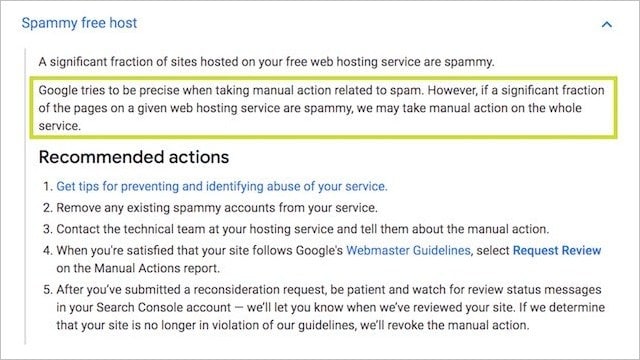

Ten pomysł ma treść:

Własna dokumentacja Google dotycząca ręcznych działań stwierdza, że wszystkie witryny na serwerze mogą zostać „ukarane” ze względu na reputację niektórych:

Jest również prawdopodobne, że algorytmy Google szukają wzorców wśród witryn o niskiej jakości – a darmowy/tani hosting współdzielony jest potencjalnie jednym z nich .

Bądźmy prawdziwi;

Czy bardziej prawdopodobne jest, że znajdziesz jednorazową witrynę PBN na tanim współdzielonym koncie hostingowym za 10 USD miesięcznie lub na serwerze dedykowanym premium 200 USD?

Dostajesz punkt.

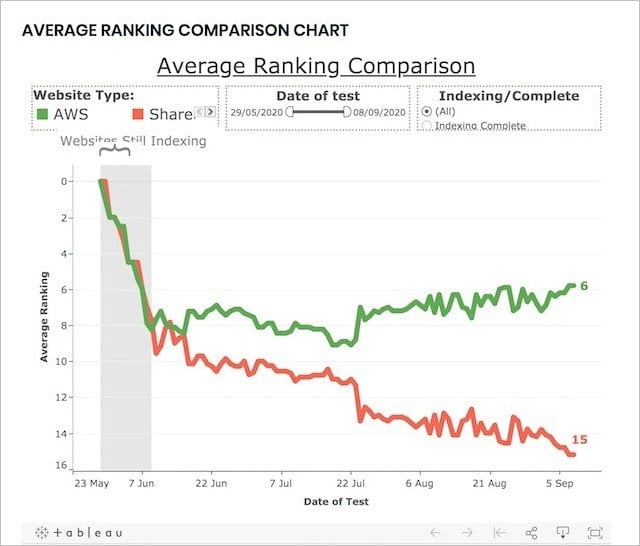

Aby przetestować wydajność hostingu współdzielonego (wiele witryn na jednym adresie IP) w porównaniu z hostingiem dedykowanym (pojedynczy adres IP dla jednej witryny), Reboot przeprowadził ten eksperyment SEO.

Eksperyment dotyczący długoterminowego hostingu współdzielonego:

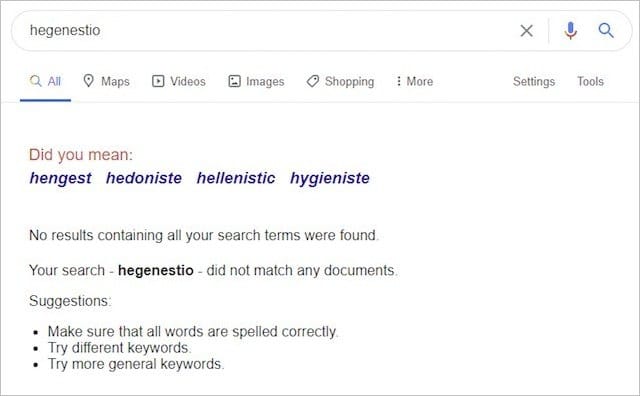

Aby przeprowadzić eksperyment, firma Reboot Online utworzyła 20 witryn — wszystkie w zupełnie nowych domenach .co.uk i zawierające unikalną, ale podobnie zoptymalizowaną zawartość:

Wszystkie dwadzieścia witryn kierowało się na to samo słowo kluczowe („hegenestio”), które przed eksperymentem miało zerowe wyniki w Google:

Następnie umieścili dziesięć witryn na dedykowanych serwerach AWS i dziesięć na serwerach współdzielonych, z których niektóre zawierały witryny o złym sąsiedztwie, takie jak ta:

I to:

A potem, po zindeksowaniu, witryny monitorowały swoje rankingi przez okres trzech miesięcy.

Aby upewnić się, że eksperyment nie może być obciążony innymi czynnikami, Reboot wykonał następujące czynności:

- Zapewniono, że wszystkie domeny nie były wcześniej indeksowane przez Google.

- Zbudowałem wszystkie strony internetowe ze statycznym HTML, ale z różnym CSS.

- Regularnie mierz czas ładowania każdej witryny, aby upewnić się, że nie jest to czynnik wpływający.

- Używał StatusCake do codziennego sprawdzania dostępności stron internetowych.

- Nadaliśmy każdej witrynie podstawowy, podobny tytuł meta i brak opisu meta.

Kroki te zostały wdrożone, aby wykazać, że szybkość, niezawodność, spójność, treść, kod i czas działania stron internetowych nie mają wpływu na rankingi.

OK, więc co się stało?

Pod koniec eksperymentu wyniki były jasne i jednoznaczne:

Witryny na dedykowanym adresie IP wypadły DUŻO lepiej niż te na wspólnym adresie IP.

W rzeczywistości pod koniec eksperymentu dziesięć najlepszych wyników dla wymyślonego słowa kluczowego zawierało 80%-90% witryn na dedykowanych adresach IP:

Wyniki tego eksperymentu ewidentnie sugerują, że hostowanie Twojej witryny na współdzielonym środowisku hostingowym (zawierającym toksyczne i niskiej jakości witryny) może mieć szkodliwy wpływ na Twoje wyniki organiczne.

Biorąc pod uwagę, że wszystkie inne sygnały rankingowe zostały usunięte, o ile na tym etapie nie wiemy.

Możemy być pewni, że w izolacji hosting współdzielony jest czynnikiem negatywnym I jeśli poważnie myślisz o swojej firmie, porządny (dedykowany) serwer jest drogą do zrobienia .

Wniosek

Te 21 eksperymentów SEO przyniosło bardzo nieoczekiwane wyniki.

Niektórzy nawet postawili na głowie to, co uważaliśmy za prawdziwe na temat SEO.

To tylko udowadnia, ponieważ tak mało wiemy o wewnętrznym działaniu algorytmu Google, że konieczne jest testowanie.

Tylko poprzez testy możemy być pewni, że wdrażane przez nas strategie SEO rzeczywiście przyniosą efekty.

Kończymy ten post wyjaśnieniem, w jaki sposób przeprowadza się testy SEO, abyś Ty również mógł przeprowadzać eksperymenty SEO i uzyskiwać prawidłowe (być może nawet przełomowe) wyniki testów.

Specjalne podziękowania dla Erica Enge za ten wkład:

„Inwestujemy dużo energii w każdy test, który przeprowadzamy. Dzieje się tak głównie dlatego, że wykonanie solidnej pracy polegającej na testowaniu wymaga dokładnego usunięcia mylących zmiennych i upewnienia się, że rozmiar danych próbki jest wystarczający.

Niektóre z kluczowych rzeczy, które staramy się zrobić, to:

1. Uzyskaj dość dużą próbkę danych.

2. Wyczyść parametry testu, aby usunąć czynniki, które unieważnią test. Na przykład, jeśli próbujemy sprawdzić, czy Google używa określonej metody do indeksowania strony, musimy upewnić się, że nic nie zawiera linków do tej strony i że nie ma żadnych narzędzi Google, do których odwołuje się kod HTML tej strony (na przykład Google Analytics, AdSense, Google Plus, Google Tag Manager, …).

3. Po uzyskaniu wyników musisz pozwolić, aby dane opowiedziały historię. Kiedy rozpoczynałeś test, prawdopodobnie spodziewałeś się danego wyniku, ale musisz być przygotowany na to, że się pomyliłeś.

Krótko mówiąc, to dużo pracy, ale dla nas wyniki uzasadniają wysiłek!”

Więc masz to…

21 eksperymentów SEO i ich nieoczekiwane rezultaty. Co jeszcze Twoim zdaniem powinno zostać przetestowane?

Jaki wynik eksperymentu SEO zaskoczył Cię najbardziej?

Powiedz mi w komentarzach poniżej.