Comment effectuer un audit de site SEO + liste de contrôle

Publié: 2022-06-29Que vous soyez novice ou expert dans le domaine, lors de la réalisation d'un audit de site, vous devez commencer par les bases pour identifier tout problème flagrant nécessitant une attention immédiate. Dans cet article, je ne vais pas plonger dans la recherche de mots-clés. Bien que la recherche de mots-clés soit une étape importante dans l'évaluation du référencement de votre site, elle nécessite une explication plus longue si vous voulez que votre recherche soit parfaite. Si vous souhaitez vous plonger dans la recherche de mots clés, l'un de nos experts en référencement, Joe Robledo, couvre ici les étapes d'un audit de mots clés à portée de main.

Pour les étapes d'un audit de site SEO que je vais couvrir, vous devrez utiliser quelques outils et plateformes. Voici mes plates-formes recommandées à utiliser pour cet audit.

- Grenouille hurlante

- Google Analytics

- Console de recherche

- GAchecker.com

- Test adapté aux mobiles

Dans les sections ci-dessous, je décomposerai ce qu'il faut rechercher, les outils nécessaires pour chaque section, et découvrirai également les problèmes potentiels.

Éléments d'un audit SEO

- Analytique

- Indexation

- Éléments sur la page

- Aspects techniques

Analytique

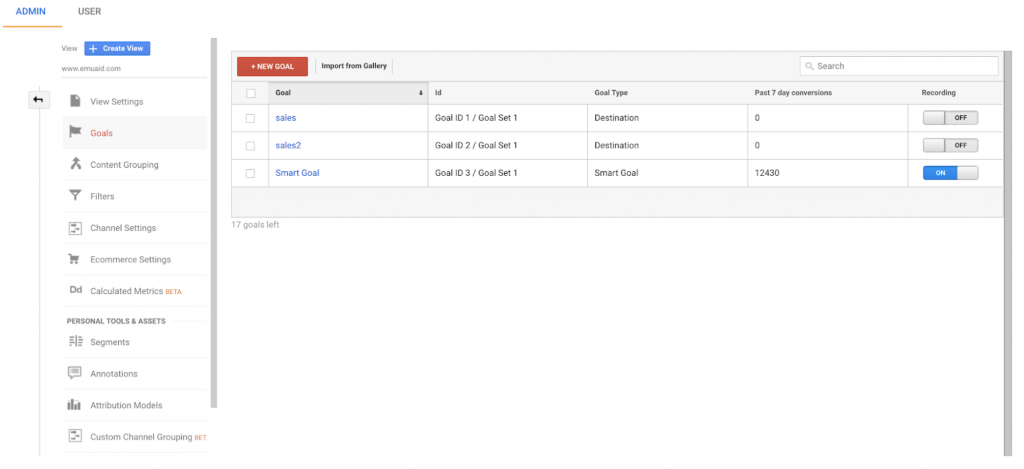

Pour bien comprendre le succès de vos efforts, vous devez disposer de données précises. De nombreux problèmes proviennent de données incorrectes ou d'un manque de données. Je parlerai spécifiquement de Google Analytics dans cette section. La première étape consiste à examiner les objectifs définis dans votre vue. Demandez-vous si ces objectifs sont précieux ? Représentent-ils les KPI de mon équipe ? Ces informations nous aident-elles à suivre les revenus et le retour sur investissement ?

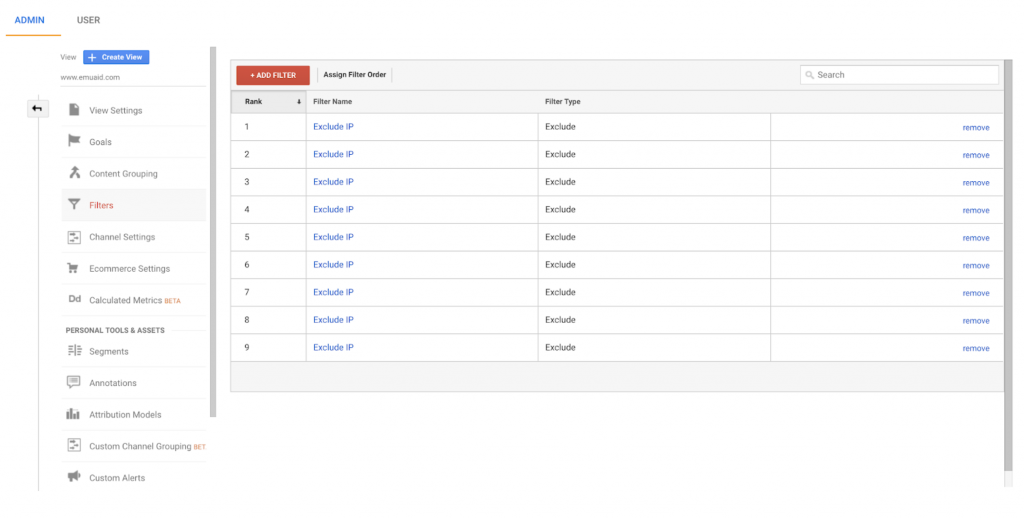

Une fois que vous vous êtes assuré que vos objectifs suivent les données exactes que vous recherchez, consultez l'onglet Filtres dans votre vue de rapport et examinez vos filtres. Si elle n'est pas actuellement ajoutée, prenez l'adresse IP de votre entreprise et ajoutez-la en tant que filtre à votre vue. Vous ne voulez pas que toutes les fois où les employés consultent vos pages Web faussent vos données.

Une fois que vous avez correctement filtré votre adresse IP, revenez à votre onglet d'accueil et affichez vos canaux de trafic situés sous le menu déroulant "Tout le trafic" dans votre onglet "Acquisition". Quelle est la répartition du trafic de vos chaînes ? Si vos canaux directs, autres ou non définis ont un pourcentage de trafic supérieur à 5 %, il est possible qu'une erreur de suivi se produise sur votre site Web. Un problème possible est que vous avez une page de connexion sur votre site Web et que vous n'avez pas inclus les utilisateurs actuels en tant que filtre exclu.

Ensuite, vérifiez votre trafic organique au cours des dernières années. Y a-t-il des baisses importantes de trafic ? S'il y a quelque chose de substantiel, votre site peut avoir subi une pénalité dans le passé. Rassemblez autant d'informations que possible sur les pénalités passées et déterminez comment elles ont été résolues.

La dernière étape pour vérifier que tout le trafic est correctement enregistré consiste à utiliser GAchecker.com. Cet outil vous permet de voir si des pages de votre site Web ne contiennent pas votre code de suivi UA. Assurez-vous que toutes les pages du site Web que vous souhaitez suivre sont incluses dans la liste des pages avec le code de suivi.

Indexation

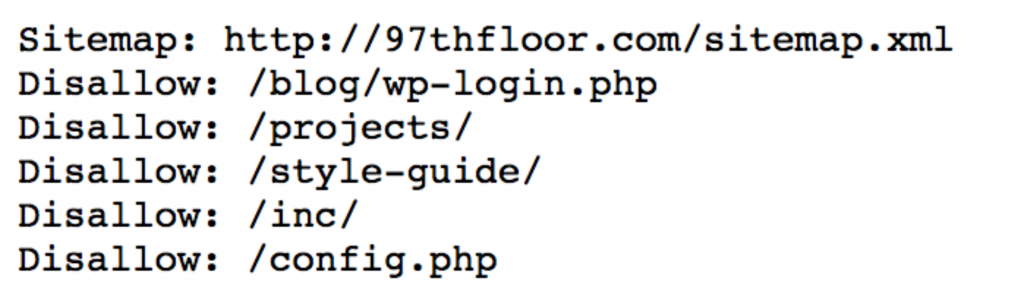

Une fois que vous avez vérifié que Google Analytics est correctement configuré, vous devez vérifier que votre site est indexé dans Google. Les premiers éléments à vérifier sont votre fichier robots.txt et votre sitemap. Le fichier robots.txt peut généralement être trouvé en tapant votredomaine.com/robots.txt. Votre fichier robots.txt devrait ressembler à ceci :

Fichier robots.txt

Votre fichier robots.txt indique aux robots Google ce qu'ils doivent et ne doivent pas indexer sur votre site. Toutes les pages que vous ne souhaitez pas afficher dans les SERP doivent être ajoutées en tant que Disallow. Ces pages incluent : les pages de connexion, les ressources internes ou toute page ne nécessitant pas d'indexation par le moteur de recherche de Google. Dans le fichier robots.txt, vous souhaitez également que votre sitemap soit répertorié pour que les robots Google puissent le localiser et l'explorer facilement.

Plan du site

Qu'est-ce qu'un sitemap ? Un sitemap est le référentiel de pages de votre site, soigneusement compilé pour que les robots de Google puissent les explorer. En bref, un sitemap est le fichier qui peut aider les robots de Google à naviguer sur votre site et à trouver les pages que vous souhaitez indexer. Même sans ce fichier, Google peut toujours explorer et indexer les pages de votre site, mais avec un sitemap, vous pouvez faciliter l'exploration de vos pages et améliorer vos chances d'envoyer Google vers les bonnes pages.

Contenu dupliqué

Un autre problème d'indexation que j'ai constaté sur la majorité des sites est le contenu dupliqué. Le contenu dupliqué peut se produire de plusieurs manières et peut amener Google à abandonner le classement de vos mots clés, car il n'est pas sûr de la page à classer pour certains mots clés. Les premiers problèmes de duplication à vérifier sont les URL. Existe-t-il des variantes de la même page qui affichent un code d'état 200 au lieu de rediriger vers une page ? Vous trouverez ci-dessous des exemples d'URL en double potentielles.

- https://www.exemple.com/

- http://www.exemple.com/

- https://exemple.com/

- http://exemple.com/

- https://exemple.com

- https://Example.com/

Chacune de ces pages est identique, mais elles s'affichent sous la forme d'URL différentes. Cela peut se produire sur votre site Web et il existe deux façons de résoudre ce problème. La première solution consiste à configurer des redirections à l'échelle du site pour envoyer toute variante d'une URL à une désignation spécifique. Si votre site est "HTTPS" sans "www" et contient une barre oblique finale, configurez toutes les variantes pour rediriger vers https://votredomaine.com/.

Si vous ne parvenez pas à configurer des redirections 301 en raison de la plate-forme que vous utilisez, ou si vous devez conserver ces pages, configurez une balise rel=canonical. La balise rel=canonical signale à Google qu'une page donnée est une page en double, mais pour référencer l'URL rel=canonical comme première page principale lors de l'indexation.

Javascript

JavaScript est un autre problème qui réduit vos chances d'apparaître dans les SERP de Google. Google a du mal à lire JavaScript, donc si vous avez des éléments sur la page en JavaScript, il est possible qu'ils ne s'affichent pas pour les bots Google. Matthew Barby de Hubspot a expliqué ce problème en décrivant une page de catégorie de contenu robuste que son équipe a construite et qui n'apparaissait pas dans les SERP de Google. Pour résoudre le problème, ils ont utilisé une extension JavaScript Switcher pour voir ce que la page a montré à Google et n'ont rien vu. Après avoir reconnu cette erreur, avec quelques ajustements à la page, ils ont pu se classer pour leurs mots clés prioritaires.

Convivialité mobile

Une dernière étape dans l'examen de l'indexation de votre site Web consiste à vérifier votre compatibilité avec les mobiles. Utilisez le test Google Mobile-Friendly Test pour voir comment Google valorise vos pages mobiles. Avec l'index mobile de Google, le contenu de la version mobile de votre site va affecter la façon dont Google classe vos pages. Si vous ne servez pas une page adaptée aux mobiles, vous pourriez nuire à votre classement.

Éléments sur la page

Après avoir examiné vos analyses et l'indexation de vos pages Web, il est temps d'approfondir le contenu de votre page. Lorsque Google explore votre page, vous voulez vous assurer que tout est en ordre de marche et optimisé pour correspondre à l'intention de recherche derrière les requêtes du chercheur. Lors de l'examen du contenu de votre page, l'utilisation de Screaming Frog vous aidera à découvrir les problèmes liés aux méta-informations. Exécutez votre domaine via l'outil d'araignée de Screaming Frog et passez en revue les éléments ci-dessous :

- Balises de titre en double : Une balise de titre est affichée dans les SERP de Google et si vous avez des pages affichant la même balise de titre, vous pouvez avoir des problèmes pour classer la bonne page dans Google.

- Balises de titre manquantes : Encore une fois, vous avez besoin d'une balise de titre qui correspond à l'intention de recherche des utilisateurs pour avoir une chance de se classer pour des mots-clés spécifiques.

- H1 en double : Semblable à une balise de titre en double, ne confondez pas les robots de Google quant à la page qui répond à l'intention de recherche de la requête autour de laquelle votre page est construite.

- Plusieurs H1 : un H1 indique à Google de quoi parle votre page. Supprimez tous les signaux contradictoires et restez fidèle à un H1 qui explique le contenu de votre page.

- H1 manquants : un H1 manquant est similaire à une balise de titre manquante. Vous voudrez envoyer à Google autant d'informations que possible sur votre page, et l'ajout d'un H1 aide à clarifier le contenu de la page.

Aspects techniques

La dernière étape de votre audit de site SEO consiste à examiner les aspects techniques supplémentaires de votre site Web qui pourraient améliorer le classement de votre site. L'identification et la résolution de problèmes techniques majeurs sur votre site peuvent faire la différence entre se classer en haut de la page deux ou atteindre le haut de la page un dans les SERP de Google.

- Vitesse de la page : faites passer vos pages Web par un outil tel que gtmetrix.com pour identifier les problèmes de vitesse du site. Google apprécie les pages à grande vitesse, car elles améliorent considérablement l'expérience utilisateur. Plus vos résultats se chargent rapidement pour un utilisateur, plus Google est susceptible de diffuser votre résultat au-dessus des autres. Les problèmes les plus corrélés à la lenteur du site incluent les images volumineuses, l'incapacité à tirer parti de la mise en cache du navigateur et l'excès de JavaScript.

- Liens internes brisés : Grâce à l'outil d'araignée de Screaming Frog, vous pouvez exporter une liste de toutes les erreurs 4XX sur votre site. Le rapport affichera toutes les destinations pour chacun des liens internes rompus sur votre page. À l'aide de ce rapport, vous pouvez soit corriger ces URL, rediriger les liens rompus, soit supprimer complètement les liens.

- 302 : Parfois, un webmaster aura une redirection 302 comme espace réservé au cas où la page d'origine serait réutilisée. Cependant, la plupart de ces 302 doivent être remplacés par des redirections 301 permanentes, à moins qu'il ne soit garanti que la page d'origine sera à nouveau utilisée.

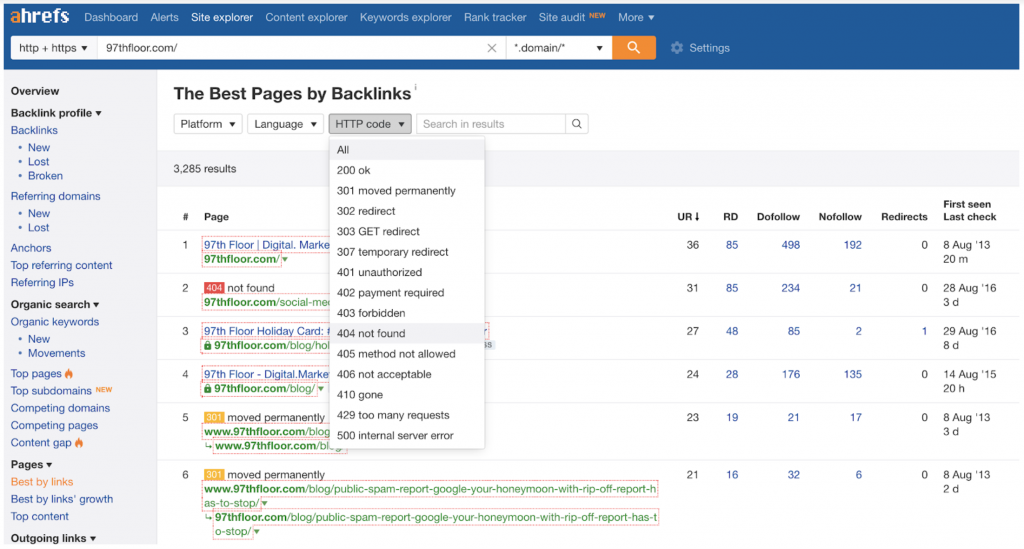

- Backlinks cassés : Un moyen simple d'identifier les backlinks cassés est de faire passer votre domaine par l' outil d'exploration de site d'ahrefs . Dans l'onglet de gauche, sélectionnez "Meilleur par liens", puis filtrez les résultats par codes 404 et vous aurez une liste de 404 pages sur votre site avec des backlinks pointant vers elles. Prenez cette liste et trouvez de nouvelles pages avec un contenu similaire et redirigez les URL 404 vers les nouvelles pages pour récupérer tout lien vers les pages cassées.

Réflexions finales : audit du site d'abord, création de contenu et optimisation ensuite

Avant de commencer à plonger dans le nouveau contenu et les optimisations hors page, passez en revue cette liste d'audit pour vous assurer que la santé du site est en parfait état. Une fois les problèmes techniques de votre site réglés, vous serez prêt à créer de nouveaux contenus.