كيفية إنشاء ملف Robots.txt (ولماذا تحتاج إلى ذلك)

نشرت: 2022-06-07قد يكون شرح مُحسّنات محرّكات البحث للناس أمرًا صعبًا نظرًا لوجود الكثير من الخطوات الصغيرة التي قد لا تبدو مهمة جدًا في البداية ، لكنها تضيف ما يصل إلى مكاسب كبيرة في تصنيفات البحث عند القيام بها بشكل صحيح.

إحدى الخطوات المهمة التي يسهل إغفالها هي السماح لبرامج زحف محركات البحث بمعرفة الصفحات التي يجب فهرستها - وأيها لا يجب. يمكنك القيام بذلك باستخدام ملف robots.txt.

في منشور اليوم ، سأشرح بالضبط كيفية إنشاء ملف robots.txt حتى تتمكن من الحصول على هذا الجزء التأسيسي من موقعك بعيدًا والتأكد من أن برامج الزحف تتفاعل مع موقعك بالطريقة التي تريدها.

ما هو ملف robots.txt؟

ملف robots.txt عبارة عن توجيه بسيط يخبر برامج زحف محركات البحث بالصفحات الموجودة على موقعك التي يجب الزحف إليها وفهرستها.

إنه جزء من بروتوكول استبعاد برامج الروبوت (REP) ، وهو عبارة عن مجموعة من الإجراءات القياسية التي تحكم كيفية قيام روبوتات محرك البحث بالزحف إلى الويب وتقييم محتوى الموقع وفهرسته ، ثم تقديم هذا المحتوى للمستخدمين. يحدد هذا الملف الأماكن التي يُسمح لبرامج الزحف بالزحف إليها والأماكن التي لا يُسمح لها بذلك. يمكن أن يحتوي أيضًا على معلومات يمكن أن تساعد برامج الزحف في الزحف إلى موقع الويب بكفاءة أكبر.

يتضمن REP أيضًا "علامات meta robots" ، وهي توجيهات مضمنة في HTML للصفحة تحتوي على إرشادات محددة حول كيفية قيام برامج زحف الويب بالزحف إلى صفحات ويب معينة وفهرستها والصور أو الملفات التي تحتوي عليها.

ما الفرق بين Robots.txt وعلامة Meta Robots؟

كما ذكرت ، يشتمل بروتوكول استبعاد برامج الروبوت أيضًا على "علامات تعريف برامج الروبوت" ، وهي عبارة عن أجزاء من التعليمات البرمجية مضمنة في HTML للصفحة. إنها تختلف عن ملفات robots.txt من حيث أنها توفر التوجيه لبرامج زحف الويب على صفحات ويب معينة ، مما يمنع الوصول إما إلى الصفحة الكاملة أو إلى ملفات معينة موجودة في الصفحة ، مثل الصور ومقاطع الفيديو.

في المقابل ، تهدف ملفات robots.txt إلى منع فهرسة أجزاء كاملة من موقع الويب ، مثل دليل فرعي مخصص للاستخدام الداخلي فقط. يوجد ملف robots.txt في المجال الجذر لموقعك بدلاً من صفحة معينة ، ويتم تنظيم التوجيهات بحيث تؤثر على جميع الصفحات الموجودة في الدلائل أو الدلائل الفرعية التي تشير إليها.

لماذا أحتاج إلى ملف Robots.txt؟

ملف robots.txt هو ملف نصي بسيط مخادع له أهمية كبيرة. بدونها ، ستقوم برامج زحف الويب ببساطة بفهرسة كل صفحة تعثر عليها.

لماذا هذا مهم؟

بالنسبة للمبتدئين ، يستغرق الزحف إلى موقع بأكمله وقتًا وموارد. كل هذا يكلف مالًا ، لذلك يحد Google من مقدار الزحف إلى موقع ما ، خاصة إذا كان هذا الموقع كبيرًا جدًا. يُعرف هذا باسم "ميزانية الزحف". ميزانية الزحف مقيدة بالعديد من العوامل الفنية ، بما في ذلك وقت الاستجابة وعناوين URL منخفضة القيمة وعدد الأخطاء التي يتم مواجهتها.

بالإضافة إلى ذلك ، إذا سمحت لمحركات البحث بالوصول غير المقيد إلى جميع صفحاتك وسمحت لبرامج الزحف الخاصة بهم بفهرستها ، فقد ينتهي بك الأمر مع تضخم الفهرس. هذا يعني أن محرك بحث Google قد يصنف الصفحات غير المهمة التي لا تريد ظهورها في نتائج البحث. يمكن أن توفر هذه النتائج للزائرين تجربة سيئة ، وقد ينتهي بهم الأمر إلى التنافس مع الصفحات التي تريد الترتيب لها.

عند إضافة ملف robots.txt إلى موقعك أو تحديث ملفك الحالي ، يمكنك تقليل إهدار ميزانية الزحف والحد من حجم الفهرس.

اقتراحات للقراءة

- دليل SEO الفني: ما هو Tech SEO؟

- ما هو مؤشر سخام؟ (وكيفية اصلاحها)

أين يمكنني العثور على ملف Robots.txt الخاص بي؟

هناك طريقة بسيطة لمعرفة ما إذا كان موقعك يحتوي على ملف robots.txt: ابحث عنه على الإنترنت.

ما عليك سوى كتابة عنوان URL الخاص بأي موقع وإضافة "/robots.txt" في النهاية. على سبيل المثال: يظهر لك victoriousseo.com/robots.txt بياناتنا.

جرب ذلك بنفسك عن طريق كتابة عنوان URL لموقعك وإضافة "/robots.txt" في النهاية. يجب أن ترى واحدًا من ثلاثة أشياء:

- يشير سطرين من النص إلى ملف robots.txt صالح

- صفحة فارغة تمامًا ، تشير إلى عدم وجود ملف robots.txt فعلي

- خطأ 404

إذا كنت تتحقق من موقعك وتحصل على أي من النتيجتين الثانيتين ، فستحتاج إلى إنشاء ملف robots.txt لمساعدة محركات البحث على فهم أفضل للمكان الذي ينبغي أن يركزوا فيه جهودهم.

كيفية إنشاء ملف Robots.txt

يتضمن ملف robots.txt أوامر معينة يمكن لروبوتات محرك البحث قراءتها واتباعها. فيما يلي بعض المصطلحات التي ستستخدمها عند إنشاء ملف robots.txt.

شروط Robots.txt الشائعة التي يجب معرفتها

وكيل المستخدم: وكيل المستخدم هو أي جزء من البرنامج مكلف باسترداد وتقديم محتوى الويب للمستخدمين النهائيين. بينما يمكن اعتبار جميع متصفحات الويب ومشغلات الوسائط والمكونات الإضافية أمثلة لوكلاء المستخدم ، في سياق ملفات robot.txt ، يكون وكيل المستخدم عبارة عن برنامج زحف أو عنكبوت لمحرك البحث (مثل Googlebot) يقوم بالزحف والفهرسة موقع الويب الخاص بك.

سماح: عند تضمينه في ملف robots.txt ، يسمح هذا الأمر لوكلاء المستخدم بالزحف إلى أي صفحات تتبعه. على سبيل المثال ، إذا كان الأمر يقرأ "السماح: /" ، فهذا يعني أن أي زاحف ويب يمكنه الوصول إلى أي صفحة تتبع الشرطة المائلة في "http://www.example.com/." لست بحاجة إلى إضافة هذا لكل ما تريد الزحف إليه ، حيث يُسمح ضمنيًا بأي شيء لا يمنعه ملف robots.txt. بدلاً من ذلك ، استخدمه للسماح بالوصول إلى دليل فرعي موجود في مسار غير مسموح به. على سبيل المثال ، غالبًا ما تحتوي مواقع WordPress على توجيه عدم السماح للمجلد / wp-admin / ، والذي بدوره يتطلب منهم إضافة توجيه للسماح لبرامج الزحف بالوصول إلى /wp-admin/admin-ajax.php دون الوصول إلى أي شيء آخر في المجلد الرئيسي.

Disallow: يمنع هذا الأمر وكلاء مستخدم معينين من الزحف إلى الصفحات التي تتبع المجلد المحدد. على سبيل المثال ، إذا كان الأمر يقرأ "Disallow: / blog /" ، فهذا يعني أن وكيل المستخدم لا يمكنه الزحف إلى أي عناوين URL تحتوي على الدليل الفرعي / blog / ، مما قد يستبعد المدونة بأكملها من البحث. ربما لن ترغب أبدًا في القيام بذلك ، لكن يمكنك ذلك. لهذا السبب من المهم جدًا مراعاة الآثار المترتبة على استخدام الأمر disallow في أي وقت تفكر فيه في إجراء تغييرات على ملف robots.txt الخاص بك.

تأخير الزحف: على الرغم من اعتبار هذا الأمر غير رسمي ، إلا أنه مصمم لمنع برامج زحف الويب من إغراق الخوادم بالطلبات. يتم تنفيذه عادةً على مواقع الويب حيث قد تتسبب الطلبات الكثيرة في حدوث مشكلات بالخادم. تدعمه بعض محركات البحث ، لكن Google لا تدعمه. يمكنك ضبط معدل الزحف لـ Google عن طريق فتح Google Search Console ، والانتقال إلى صفحة إعدادات معدل الزحف في مكان الإقامة الخاص بك ، وضبط شريط التمرير هناك. يعمل هذا فقط إذا اعتقدت Google أنه ليس الحل الأمثل. إذا كنت تعتقد أنه دون المستوى الأمثل ولم توافق Google على ذلك ، فقد تحتاج إلى تقديم طلب خاص لتعديله. ذلك لأن Google تفضل السماح لهم بتحسين معدل الزحف إلى موقع الويب الخاص بك.

خريطة موقع XML: هذا التوجيه يفعل بالضبط ما كنت تعتقد أنه يفعله: أخبر برامج زحف الويب بمكان خريطة موقع XML. يجب أن يظهر بالشكل التالي: "خريطة الموقع: http://www.example.com/sitemap.xml." يمكنك معرفة المزيد حول أفضل ممارسات خرائط الموقع هنا.

إرشادات خطوة بخطوة لإنشاء ملف robots.txt

لإنشاء ملف robots.txt الخاص بك ، ستحتاج إلى الوصول إلى محرر نصوص بسيط مثل Notepad أو TextEdit. من المهم عدم استخدام معالج النصوص ، حيث يقوم هذا عادةً بحفظ الملفات في أشكال خاصة وقد يضيف أحرفًا خاصة إلى الملف.

من أجل التبسيط ، سنستخدم "www.example.com".

سنبدأ بتعيين معلمات وكيل المستخدم. في السطر الأول ، اكتب:

وكيل المستخدم: *

تعني النجمة أنه يُسمح لجميع برامج زحف الويب بزيارة موقع الويب الخاص بك.

ستستخدم بعض مواقع الويب توجيهًا للسماح لبرامج الروبوت بالزحف ، ولكن هذا غير ضروري. يُسمح ضمنيًا بأي أجزاء لم تمنعها من الموقع.

بعد ذلك ، سندخل المعلمة disallow. اضغط على "رجوع" مرتين لإدخال فاصل بعد سطر وكيل المستخدم ، ثم اكتب:

عدم السماح: /

نظرًا لأننا لا ندخل أي أوامر بعد ذلك ، فهذا يعني أن برامج زحف الويب يمكنها زيارة كل صفحة على موقعك.

إذا كنت تريد حظر الوصول إلى محتوى معين ، فيمكنك إضافة الدليل بعد الأمر disallow. يحتوي ملف robots.txt الخاص بنا على أمري عدم السماح التاليين:

Disallow: / wp / wp-admin /

عدم السماح: /*؟*

الأول يضمن عدم الزحف إلى صفحات مسؤول WordPress الخاصة بنا (حيث نقوم بتحرير أشياء مثل هذه المقالة). هذه هي الصفحات التي لا نريد ترتيبها في البحث ، وسيكون أيضًا مضيعة لوقت Google في محاولة الزحف إليها لأنها محمية بكلمة مرور. والثاني يمنع الزحف إلى عناوين URL التي تحتوي على علامة استفهام ، مثل صفحات نتائج بحث المدونات.

بمجرد الانتهاء من أوامرك ، قم بالربط بخريطة الموقع الخاصة بك. على الرغم من أن هذه الخطوة ليست مطلوبة من الناحية الفنية ، إلا أنها من أفضل الممارسات الموصى بها لأنها توجه عناكب الويب إلى الصفحات الأكثر أهمية على موقعك وتجعل بنية موقعك واضحة. بعد إدخال فاصل أسطر آخر ، اكتب:

خريطة الموقع: http://www.example.com/sitemap.xml

الآن يمكن لمطور الويب الخاص بك تحميل ملفك إلى موقع الويب الخاص بك.

إنشاء ملف Robots.txt في WordPress

إذا كان لديك حق وصول المسؤول إلى WordPress الخاص بك ، فيمكنك تعديل ملف robots.txt الخاص بك باستخدام Yoast SEO Plugin أو AIOSEO. بدلاً من ذلك ، يمكن لمطور الويب الخاص بك استخدام عميل FTP أو SFTP للاتصال بموقع WordPress الخاص بك والوصول إلى الدليل الجذر.

لا تنقل ملف robots.txt في أي مكان بخلاف الدليل الجذر. بينما تقترح بعض المصادر وضعه في دليل فرعي أو مجال فرعي ، فمن الأفضل أن يكون موجودًا على نطاق الجذر الخاص بك: www.example.com/robots.txt.

كيفية اختبار ملف Robots.txt الخاص بك

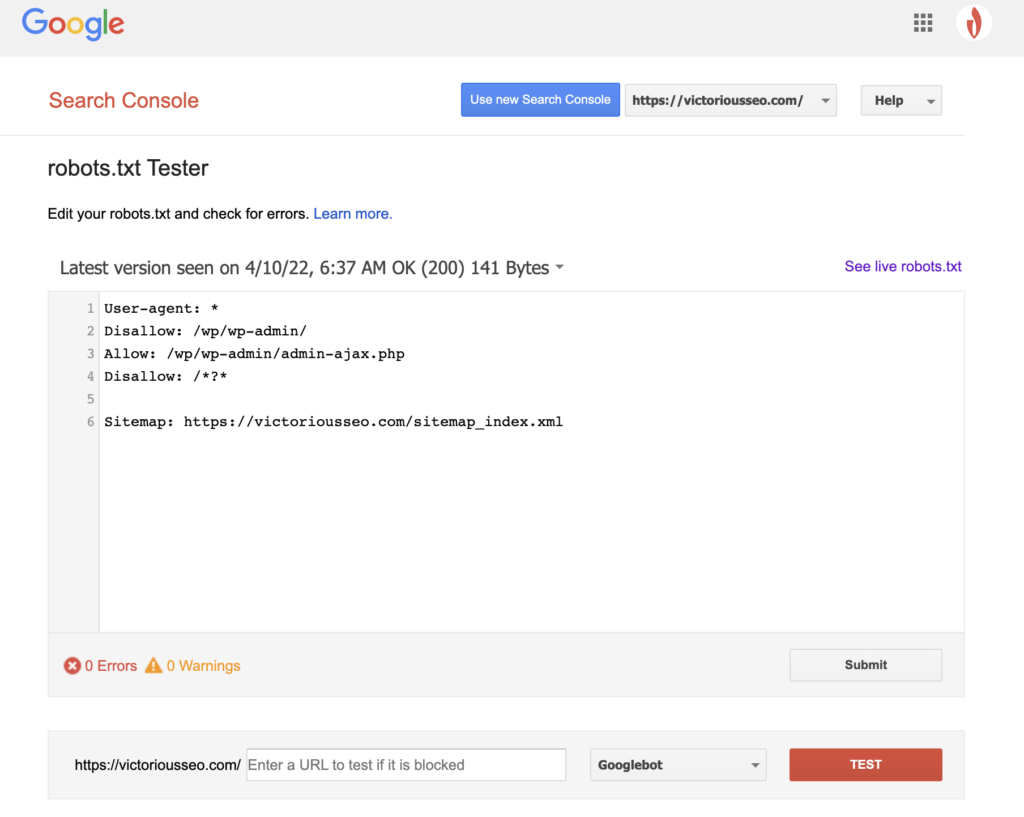

الآن بعد أن أنشأت ملف robots.txt ، حان الوقت لاختباره. لحسن الحظ ، تجعل Google الأمر سهلاً من خلال توفير أداة اختبار robots.txt كجزء من Google Search Console.

بعد فتح المختبر لموقعك ، سترى أي تحذيرات في بناء الجملة وأخطاء منطقية مميزة.

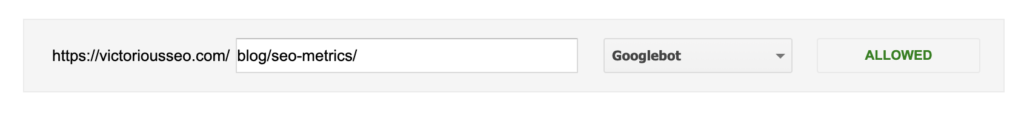

لاختبار كيف "يرى" برنامج Googlebot معين صفحتك ، أدخل عنوان URL من موقعك في مربع النص أسفل الصفحة ثم اختر من بين برامج Googlebot المتنوعة في القائمة المنسدلة الموجودة على اليسار. سيؤدي النقر على "TEST" إلى محاكاة سلوك الروبوت الذي حددته وإظهار ما إذا كانت هناك أية توجيهات تمنع Googlebot من الوصول إلى الصفحة.

عيوب Robots.txt

تعتبر ملفات Robots.txt مفيدة للغاية ، لكن لها حدودها.

يجب عدم استخدام ملفات Robots.txt لحماية أو إخفاء أجزاء من موقع الويب الخاص بك (قد يؤدي القيام بذلك إلى انتهاك قانون حماية البيانات). أتذكر عندما اقترحت عليك البحث عن ملف robots.txt الخاص بك؟ هذا يعني أنه يمكن لأي شخص الوصول إليه ، وليس أنت فقط. إذا كانت هناك معلومات تحتاج إلى حمايتها ، فإن أفضل طريقة هي حماية صفحات أو مستندات معينة بكلمة مرور.

بالإضافة إلى ذلك ، فإن توجيهات ملف robots.txt هي مجرد طلبات. يمكنك أن تتوقع أن يلتزم Googlebot وبرامج الزحف الشرعية الأخرى بتوجيهاتك ، ولكن قد تتجاهلها برامج الروبوت الأخرى ببساطة.

أخيرًا ، حتى إذا طلبت من برامج الزحف عدم فهرسة عناوين URL معينة ، فإنها ليست غير مرئية. مواقع أخرى قد ترتبط بهم. إذا كنت لا تريد إتاحة معلومات معينة على موقع الويب الخاص بك للعرض العام ، فيجب عليك حمايتها بكلمة مرور. إذا كنت تريد التأكد من عدم فهرستها ، ففكر في تضمين علامة noindex على الصفحة.

تعرف على المزيد حول Technical SEO: قم بتنزيل قائمة التحقق الخاصة بنا

هل ترغب في معرفة المزيد حول مُحسّنات محرّكات البحث ، بما في ذلك إرشادات خطوة بخطوة حول كيفية استخدام مُحسّنات محرّكات البحث لموقعك على الويب؟ قم بتنزيل قائمة مراجعة تحسين محركات البحث لعام 2022 الخاصة بنا للحصول على قائمة مهام شاملة ، بما في ذلك الموارد القيمة التي ستساعدك على تحسين تصنيفات البحث الخاصة بك وزيادة حركة المرور العضوية إلى موقع الويب الخاص بك.

قائمة مراجعة SEO وأدوات التخطيط

هل أنت مستعد لتحريك الإبرة في مُحسنات محركات البحث الخاصة بك؟ احصل على قائمة المراجعة التفاعلية وأدوات التخطيط وابدأ!