วิธีสร้างไฟล์ Robots.txt (และทำไมคุณถึงต้องการ)

เผยแพร่แล้ว: 2022-06-07การอธิบาย SEO แก่ผู้คนอาจเป็นเรื่องยาก เนื่องจากมีขั้นตอนเล็กๆ น้อยๆ มากมายที่อาจดูเหมือนไม่สำคัญในตอนแรก แต่ก็เพิ่มอันดับการค้นหาการค้นหาได้มากเมื่อทำถูกต้อง

ขั้นตอนสำคัญอย่างหนึ่งที่มองข้ามได้ง่ายคือการให้โปรแกรมรวบรวมข้อมูลของเครื่องมือค้นหาทราบว่าหน้าใดที่จะจัดทำดัชนี และหน้าใดที่ไม่ควรทำ คุณสามารถทำได้ด้วยไฟล์ robots.txt

ในโพสต์ของวันนี้ ฉันจะอธิบายวิธีสร้างไฟล์ robots.txt อย่างชัดเจน เพื่อให้คุณได้ส่วนพื้นฐานนี้ของไซต์ของคุณออกไป และตรวจสอบให้แน่ใจว่าโปรแกรมรวบรวมข้อมูลโต้ตอบกับไซต์ของคุณในแบบที่คุณต้องการ

ไฟล์ robots.txt คืออะไร

ไฟล์ robots.txt เป็นคำสั่งง่ายๆ ที่จะบอกโปรแกรมรวบรวมข้อมูลของเครื่องมือค้นหาว่าหน้าใดในเว็บไซต์ของคุณที่จะรวบรวมข้อมูลและจัดทำดัชนี

เป็นส่วนหนึ่งของโปรโตคอลการยกเว้นโรบ็อต (REP) ซึ่งเป็นกลุ่มของขั้นตอนมาตรฐานที่ควบคุมวิธีที่โรบ็อตของเครื่องมือค้นหารวบรวมข้อมูลเว็บ ประเมินและจัดทำดัชนีเนื้อหาไซต์ แล้วจึงแสดงเนื้อหานั้นต่อผู้ใช้ ไฟล์นี้ระบุตำแหน่งที่อนุญาตให้โปรแกรมรวบรวมข้อมูลรวบรวมข้อมูลและตำแหน่งที่ไม่อนุญาต นอกจากนี้ยังสามารถประกอบด้วยข้อมูลที่สามารถช่วยโปรแกรมรวบรวมข้อมูลได้อย่างมีประสิทธิภาพมากขึ้นในการรวบรวมข้อมูลเว็บไซต์

REP ยังรวมถึง "แท็ก meta robots" ซึ่งเป็นคำสั่งที่รวมอยู่ใน HTML ของหน้าเว็บที่มีคำแนะนำเฉพาะเกี่ยวกับวิธีการที่โปรแกรมรวบรวมข้อมูลเว็บควรรวบรวมข้อมูลและจัดทำดัชนีหน้าเว็บและรูปภาพหรือไฟล์ที่มีอยู่

แท็ก Robots.txt และ Meta Robots ต่างกันอย่างไร

ดังที่ฉันได้กล่าวไปแล้ว โปรโตคอลการยกเว้นโรบ็อตยังรวม “เมตาแท็กโรบ็อต” ซึ่งเป็นโค้ดบางส่วนที่รวมอยู่ใน HTML ของหน้า ต่างจากไฟล์ robots.txt ตรงที่พวกมันให้แนวทางแก่โปรแกรมรวบรวมข้อมูล เว็บในหน้าเว็บบางหน้า ไม่อนุญาตให้เข้าถึงทั้งหน้าทั้งหมดหรือไฟล์เฉพาะที่อยู่ในหน้า เช่น รูปภาพและวิดีโอ

ในทางตรงกันข้าม ไฟล์ robots.txt มีวัตถุประสงค์เพื่อป้องกันไม่ให้มีการจัดทำดัชนีทั้งกลุ่มของเว็บไซต์ เช่น ไดเรกทอรีย่อยที่มีจุดประสงค์เพื่อใช้ภายในเท่านั้น ไฟล์ robots.txt อยู่บนโดเมนรากของไซต์ของคุณแทนที่จะอยู่บนหน้าใดหน้าหนึ่ง และคำสั่งมีโครงสร้างที่ส่งผลต่อหน้าทั้งหมดที่อยู่ในไดเรกทอรีหรือไดเรกทอรีย่อยที่พวกเขาอ้างถึง

ทำไมฉันถึงต้องการไฟล์ Robots.txt

ไฟล์ robots.txt เป็นไฟล์ข้อความธรรมดาที่หลอกลวงซึ่งมีความสำคัญอย่างยิ่ง หากไม่มีโปรแกรมรวบรวมข้อมูลเว็บก็จะจัดทำดัชนีทุกหน้าที่พวกเขาพบ

ทำไมเรื่องนี้?

สำหรับผู้เริ่มต้น การรวบรวมข้อมูลทั้งไซต์ต้องใช้เวลาและทรัพยากร ทั้งหมดนั้นมีค่าใช้จ่าย ดังนั้น Google จึงจำกัดจำนวนที่จะรวบรวมข้อมูลไซต์ โดยเฉพาะอย่างยิ่งหากไซต์นั้นใหญ่มาก สิ่งนี้เรียกว่า "งบประมาณการรวบรวมข้อมูล" งบประมาณการรวบรวมข้อมูลถูกจำกัดโดยปัจจัยทางเทคนิคหลายประการ รวมถึงเวลาตอบสนอง URL ที่มีค่าต่ำ และจำนวนข้อผิดพลาดที่พบ

นอกจากนี้ หากคุณอนุญาตให้เสิร์ชเอ็นจิ้นเข้าถึงหน้าทั้งหมดของคุณโดยอิสระและปล่อยให้โปรแกรมรวบรวมข้อมูลจัดทำดัชนีหน้าเหล่านั้น คุณอาจจบลงด้วยดัชนีขยายตัว ซึ่งหมายความว่า Google อาจจัดอันดับหน้าที่ไม่สำคัญที่คุณไม่ต้องการให้ปรากฏในผลการค้นหา ผลลัพธ์เหล่านี้อาจทำให้ผู้เยี่ยมชมได้รับประสบการณ์ที่ไม่ดี และอาจจบลงด้วยการแข่งขันกับเพจที่คุณต้องการจัดอันดับ

เมื่อคุณเพิ่มไฟล์ robots.txt ลงในไซต์ของคุณหรืออัปเดตไฟล์ที่มีอยู่ คุณสามารถลดการสิ้นเปลืองงบประมาณในการรวบรวมข้อมูลและจำกัดการขยายดัชนี

การอ่านที่แนะนำ

- คู่มือ SEO ด้านเทคนิค: Tech SEO คืออะไร

- Index Bloat คืออะไร? (และวิธีการแก้ไข)

ฉันจะค้นหาไฟล์ Robots.txt ของฉันได้ที่ไหน

มีวิธีง่ายๆ ในการดูว่าเว็บไซต์ของคุณมีไฟล์ robots.txt หรือไม่: ค้นหาจากอินเทอร์เน็ต

เพียงพิมพ์ URL ของเว็บไซต์ใด ๆ และเพิ่ม “/robots.txt” ต่อท้าย ตัวอย่างเช่น: victoriousseo.com/robots.txt แสดงของคุณ

ลองด้วยตัวคุณเองโดยพิมพ์ URL ของไซต์และเพิ่ม “/robots.txt” ต่อท้าย คุณควรเห็นหนึ่งในสามสิ่งต่อไปนี้:

- ข้อความสองสามบรรทัดที่ระบุไฟล์ robots.txt ที่ถูกต้อง

- หน้าว่างเปล่า แสดงว่าไม่มีไฟล์ robots.txt จริง

- ข้อผิดพลาด 404

หากคุณกำลังตรวจสอบไซต์ของคุณและได้ผลลัพธ์อย่างใดอย่างหนึ่งจากสองส่วนที่สอง คุณจะต้องสร้างไฟล์ robots.txt เพื่อช่วยให้เครื่องมือค้นหาเข้าใจได้ดีขึ้นว่าควรเน้นที่จุดใด

วิธีสร้างไฟล์ Robots.txt

ไฟล์ robots.txt มีคำสั่งบางอย่างที่โรบ็อตของเครื่องมือค้นหาสามารถอ่านและปฏิบัติตามได้ ต่อไปนี้คือข้อกำหนดบางส่วนที่คุณจะใช้เมื่อสร้างไฟล์ robots.txt

ข้อกำหนดทั่วไปของ Robots.txt ที่ควรทราบ

User-Agent : user-agent คือซอฟต์แวร์ใดๆ ที่มีหน้าที่ในการดึงและนำเสนอเนื้อหาเว็บสำหรับผู้ใช้ปลายทาง แม้ว่าเว็บเบราว์เซอร์ โปรแกรมเล่นสื่อ และปลั๊กอินทั้งหมดถือเป็นตัวอย่างของตัวแทนผู้ใช้ ในบริบทของไฟล์ robot.txt User-agent คือโปรแกรมรวบรวมข้อมูลของเครื่องมือค้นหาหรือสไปเดอร์ (เช่น Googlebot) ที่รวบรวมข้อมูลและจัดทำดัชนี เว็บไซต์ของคุณ.

อนุญาต: เมื่ออยู่ในไฟล์ robots.txt คำสั่งนี้จะอนุญาตให้ user-agent รวบรวมข้อมูลหน้าใดๆ ที่ตามมา ตัวอย่างเช่น หากคำสั่งอ่านว่า "Allow: /" หมายความว่าโปรแกรมรวบรวมข้อมูลเว็บใด ๆ สามารถเข้าถึงหน้าใดก็ได้ที่ตามหลังเครื่องหมายทับใน "http://www.example.com/" คุณไม่จำเป็นต้องเพิ่มสิ่งนี้สำหรับทุกสิ่งที่คุณต้องการให้รวบรวมข้อมูล เนื่องจากสิ่งใดก็ตามที่ robots.txt ไม่อนุญาตจะอนุญาตโดยปริยาย ให้ใช้เพื่ออนุญาตการเข้าถึงไดเร็กทอรีย่อยที่อยู่ในเส้นทางที่ไม่อนุญาต ตัวอย่างเช่น ไซต์ WordPress มักจะมีคำสั่ง disallow สำหรับโฟลเดอร์ /wp-admin/ ซึ่งจะต้องเพิ่มคำสั่ง allow เพื่ออนุญาตให้โปรแกรมรวบรวมข้อมูลเข้าถึง /wp-admin/admin-ajax.php โดยไม่ต้องเข้าถึงสิ่งอื่นใดใน โฟลเดอร์หลัก

ไม่อนุญาต: คำสั่งนี้ห้ามไม่ให้ตัวแทนผู้ใช้เฉพาะรวบรวมข้อมูลหน้าที่ตามหลังโฟลเดอร์ที่ระบุ ตัวอย่างเช่น หากคำสั่งอ่านว่า “Disallow: /blog/” หมายความว่าตัวแทนผู้ใช้อาจไม่รวบรวมข้อมูล URL ใด ๆ ที่มีไดเร็กทอรีย่อย /blog/ ซึ่งจะแยกบล็อกทั้งหมดออกจากการค้นหา คุณอาจจะไม่ต้องการทำอย่างนั้น แต่คุณทำได้ ด้วยเหตุนี้จึงเป็นสิ่งสำคัญมากที่จะต้องพิจารณาผลกระทบของการใช้คำสั่ง disallow ทุกครั้งที่คุณคิดที่จะเปลี่ยนแปลงไฟล์ robots.txt ของคุณ

ความล่าช้าในการรวบรวมข้อมูล: แม้ว่าคำสั่งนี้จะถือว่าไม่เป็นทางการ แต่ก็ออกแบบมาเพื่อป้องกันไม่ให้โปรแกรมรวบรวมข้อมูลเว็บส่งคำขอจากเซิร์ฟเวอร์ที่อาจล้นหลาม โดยทั่วไปจะมีการใช้งานบนเว็บไซต์ที่มีคำขอมากเกินไปอาจทำให้เกิดปัญหาเซิร์ฟเวอร์ เครื่องมือค้นหาบางตัวรองรับ แต่ Google ไม่รองรับ คุณปรับอัตราการรวบรวมข้อมูลสำหรับ Google ได้โดยเปิด Google Search Console ไปที่หน้าการตั้งค่าอัตราการรวบรวมข้อมูลของพร็อพเพอร์ตี้ แล้วปรับแถบเลื่อนที่นั่น ใช้งานได้ก็ต่อเมื่อ Google คิดว่าไม่เหมาะสม หากคุณคิดว่าไม่เหมาะสมและ Google ไม่เห็นด้วย คุณอาจต้องส่งคำขอพิเศษเพื่อแก้ไข นั่นเป็นเพราะ Google ต้องการให้คุณอนุญาตให้เพิ่มประสิทธิภาพอัตราการรวบรวมข้อมูลสำหรับเว็บไซต์ของคุณ

XML Sitemap: คำสั่งนี้ทำสิ่งที่คุณเดาได้อย่างแน่นอน: บอกโปรแกรมรวบรวมข้อมูลเว็บว่าแผนผังเว็บไซต์ XML ของคุณอยู่ที่ไหน ควรมีลักษณะดังนี้: “แผนผังเว็บไซต์: http://www.example.com/sitemap.xml” คุณสามารถเรียนรู้เพิ่มเติมเกี่ยวกับแนวทางปฏิบัติที่ดีที่สุดสำหรับแผนผังเว็บไซต์ได้ที่นี่

คำแนะนำทีละขั้นตอนสำหรับการสร้าง Robots.txt

ในการสร้างไฟล์ robots.txt ของคุณเอง คุณจะต้องเข้าถึงโปรแกรมแก้ไขข้อความอย่างง่าย เช่น Notepad หรือ TextEdit สิ่งสำคัญคืออย่าใช้โปรแกรมประมวลผลคำ เนื่องจากโดยปกติแล้วจะบันทึกไฟล์ในรูปแบบที่เป็นกรรมสิทธิ์และอาจเพิ่มอักขระพิเศษลงในไฟล์

เพื่อความเรียบง่าย เราจะใช้ “www.example.com”

เราจะเริ่มต้นด้วยการตั้งค่าพารามิเตอร์ตัวแทนผู้ใช้ ในบรรทัดแรก พิมพ์:

ตัวแทนผู้ใช้: *

เครื่องหมายดอกจันหมายความว่าโปรแกรมรวบรวมข้อมูลเว็บทั้งหมดได้รับอนุญาตให้เยี่ยมชมเว็บไซต์ของคุณ

บางเว็บไซต์จะใช้คำสั่ง allow เพื่อบอกว่าบอทได้รับอนุญาตให้รวบรวมข้อมูลได้ แต่สิ่งนี้ไม่จำเป็น ส่วนใดๆ ของไซต์ที่คุณไม่อนุญาตจะได้รับอนุญาตโดยปริยาย

ต่อไป เราจะป้อนพารามิเตอร์ disallow กด "return" สองครั้งเพื่อแทรกตัวแบ่งหลังบรรทัด user-agent จากนั้นพิมพ์:

ไม่อนุญาต: /

เนื่องจากเราไม่ได้ป้อนคำสั่งใดๆ ต่อจากนี้ หมายความว่าโปรแกรมรวบรวมข้อมูลเว็บสามารถเข้าชมทุกหน้าในไซต์ของคุณได้

หากคุณต้องการบล็อกการเข้าถึงเนื้อหาบางอย่าง คุณสามารถเพิ่มไดเร็กทอรีหลังคำสั่ง disallow ไฟล์ robots.txt ของเรามีคำสั่ง disallow สองคำสั่งต่อไปนี้:

ไม่อนุญาต: /wp/wp-admin/

ไม่อนุญาต: /*?*

อันดับแรกทำให้มั่นใจได้ว่าหน้าผู้ดูแลระบบ WordPress ของเรา (ที่เราแก้ไขเนื้อหาเช่นบทความนี้) จะไม่ถูกรวบรวมข้อมูล หน้าเว็บเหล่านี้เป็นหน้าที่เราไม่ต้องการให้มีการจัดอันดับในการค้นหา และยังเป็นการเสียเวลาของ Google ในการพยายามรวบรวมข้อมูลเนื่องจากมีการป้องกันด้วยรหัสผ่าน ประการที่สองป้องกันไม่ให้มีการรวบรวมข้อมูล URL ที่มีเครื่องหมายคำถาม เช่น หน้าผลการค้นหาบล็อก

เมื่อคุณทำคำสั่งเสร็จแล้ว ให้เชื่อมโยงไปยังแผนผังไซต์ของคุณ แม้ว่าขั้นตอนนี้จะไม่จำเป็นในทางเทคนิค แต่ก็เป็นแนวทางปฏิบัติที่ดีที่สุดที่แนะนำ เนื่องจากจะชี้เว็บสไปเดอร์ไปยังหน้าที่สำคัญที่สุดในไซต์ของคุณและทำให้สถาปัตยกรรมไซต์ของคุณชัดเจน หลังจากแทรกตัวแบ่งบรรทัดอื่นแล้ว ให้พิมพ์:

แผนผังเว็บไซต์: http://www.example.com/sitemap.xml

ตอนนี้นักพัฒนาเว็บของคุณสามารถอัปโหลดไฟล์ของคุณไปยังเว็บไซต์ของคุณได้

การสร้างไฟล์ Robots.txt ใน WordPress

หากคุณมีสิทธิ์การเข้าถึงระดับผู้ดูแลระบบใน WordPress คุณสามารถแก้ไขไฟล์ robots.txt ด้วยปลั๊กอิน Yoast SEO หรือ AIOSEO อีกทางหนึ่ง นักพัฒนาเว็บของคุณสามารถใช้ไคลเอนต์ FTP หรือ SFTP เพื่อเชื่อมต่อกับไซต์ WordPress ของคุณและเข้าถึงไดเร็กทอรีราก

อย่าย้ายไฟล์ robots.txt ไปที่อื่นที่ไม่ใช่ไดเรกทอรีราก แม้ว่าบางแหล่งจะแนะนำให้วางไว้ในไดเรกทอรีย่อยหรือโดเมนย่อย แต่ควรอยู่ในโดเมนรากของคุณ: www.example.com/robots.txt

วิธีทดสอบไฟล์ Robots.txt ของคุณ

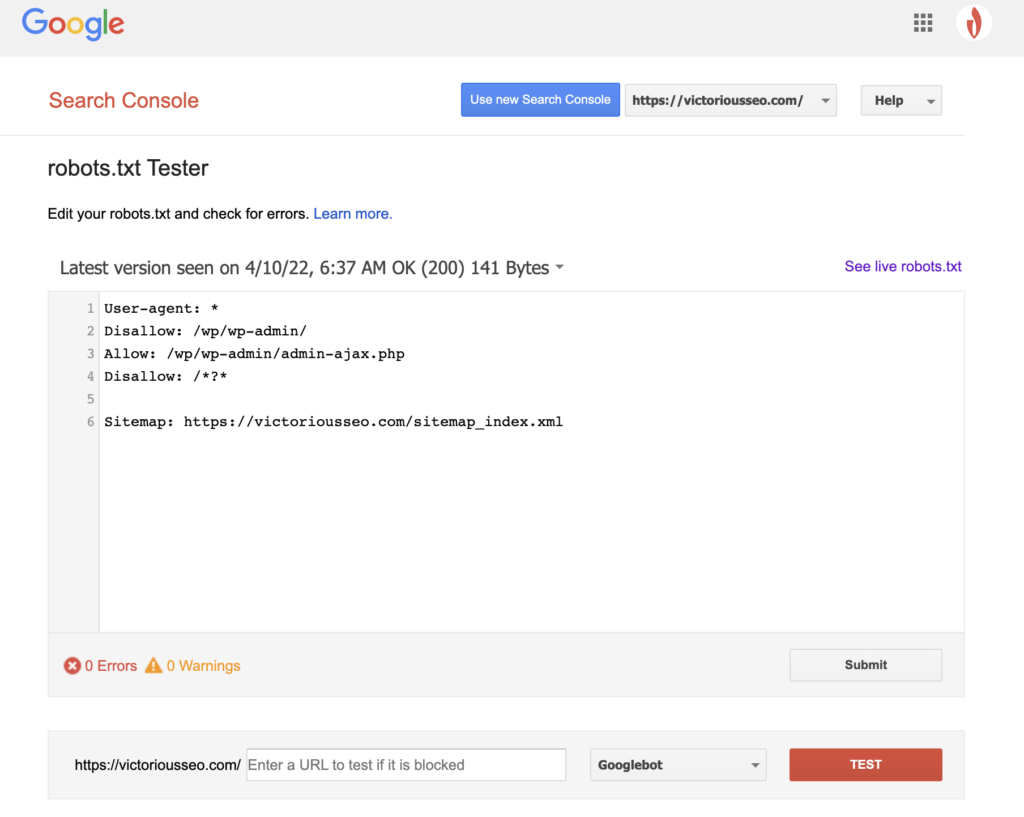

เมื่อคุณได้สร้างไฟล์ robots.txt แล้ว ก็ถึงเวลาทดสอบใช้งาน โชคดีที่ Google ช่วยให้ง่ายขึ้นด้วยการจัดหาเครื่องมือทดสอบ robots.txt ซึ่งเป็นส่วนหนึ่งของ Google Search Console

หลังจากที่คุณเปิดตัวทดสอบสำหรับไซต์ของคุณ คุณจะเห็นคำเตือนเกี่ยวกับไวยากรณ์และข้อผิดพลาดทางตรรกะที่ไฮไลต์ไว้

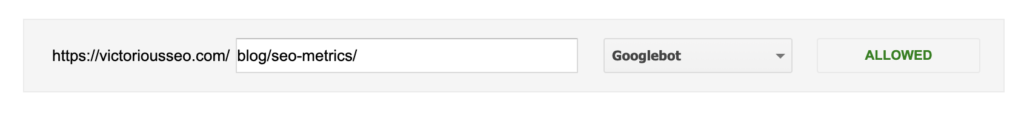

หากต้องการทดสอบว่า Googlebot "เห็น" หน้าเว็บของคุณอย่างไร ให้ป้อน URL จากไซต์ของคุณในกล่องข้อความที่ด้านล่างของหน้า แล้วเลือกจาก Googlebot ต่างๆ ในเมนูแบบเลื่อนลงทางด้านขวา การกดปุ่ม “TEST” จะจำลองพฤติกรรมของบอทที่คุณเลือก และแสดงว่ามีคำสั่งใดที่ขัดขวางไม่ให้ Googlebot เข้าถึงหน้า

ข้อบกพร่องของ Robots.txt

ไฟล์ Robots.txt มีประโยชน์มาก แต่ก็มีข้อจำกัด

ไม่ควรใช้ไฟล์ Robots.txt เพื่อป้องกันหรือซ่อนส่วนต่างๆ ของเว็บไซต์ของคุณ (การกระทำดังกล่าวอาจละเมิดกฎหมายคุ้มครองข้อมูล) จำได้ไหมว่าฉันแนะนำให้คุณค้นหาไฟล์ robots.txt ของคุณเอง นั่นหมายความว่าทุกคนสามารถเข้าถึงได้ ไม่ใช่แค่คุณ หากมีข้อมูลที่คุณต้องการป้องกัน วิธีที่ดีที่สุดคือการป้องกันหน้าหรือเอกสารด้วยรหัสผ่าน

นอกจากนี้ คำสั่งไฟล์ robots.txt ของคุณเป็นเพียงคำขอเท่านั้น คุณสามารถคาดหวังให้ Googlebot และโปรแกรมรวบรวมข้อมูลที่ถูกต้องตามกฎหมายอื่นๆ ปฏิบัติตามคำสั่งของคุณ แต่บ็อตอื่นๆ อาจเพิกเฉยต่อคำสั่งเหล่านั้น

สุดท้ายนี้ แม้ว่าคุณจะขอให้โปรแกรมรวบรวมข้อมูลไม่สร้างดัชนี URL เฉพาะ แต่ก็ไม่สามารถมองเห็นได้ เว็บไซต์อื่นๆ อาจเชื่อมโยงไปถึงพวกเขา ถ้าคุณไม่ต้องการให้ข้อมูลบางอย่างบนเว็บไซต์ของคุณปรากฏต่อสาธารณะ คุณควรป้องกันด้วยรหัสผ่าน หากคุณต้องการแน่ใจว่าจะไม่มีการทำดัชนี ให้พิจารณารวมแท็ก noindex ไว้บนหน้า

เรียนรู้เพิ่มเติมเกี่ยวกับเทคนิค SEO: ดาวน์โหลดรายการตรวจสอบของเรา

ต้องการเรียนรู้เพิ่มเติมเกี่ยวกับ SEO รวมถึงคำแนะนำทีละขั้นตอนเกี่ยวกับวิธีการทำ SEO ของเว็บไซต์ของคุณให้อยู่ในมือของคุณเองหรือ ดาวน์โหลดรายการตรวจสอบ SEO ปี 2022 ของเราเพื่อรับรายการสิ่งที่ต้องทำที่ครอบคลุม ซึ่งรวมถึงแหล่งข้อมูลอันมีค่าที่จะช่วยคุณปรับปรุงอันดับการค้นหาและเพิ่มปริมาณการเข้าชมเว็บไซต์ของคุณ

รายการตรวจสอบ SEO และเครื่องมือวางแผน

คุณพร้อมที่จะขยับเข็มใน SEO ของคุณหรือไม่? รับรายการตรวจสอบเชิงโต้ตอบและเครื่องมือวางแผน แล้วเริ่มต้น!