Cara Membuat File Robots.txt (Dan Mengapa Anda Perlu)

Diterbitkan: 2022-06-07Menjelaskan SEO kepada orang-orang bisa jadi sulit karena ada banyak langkah kecil yang mungkin tampak tidak terlalu penting pada awalnya, namun langkah itu menambah keuntungan besar dalam peringkat pencarian jika dilakukan dengan benar.

Satu langkah penting yang mudah diabaikan adalah membiarkan perayap mesin telusur mengetahui halaman mana yang akan diindeks — dan mana yang tidak. Anda dapat melakukannya dengan file robots.txt.

Dalam posting hari ini, saya akan menjelaskan dengan tepat bagaimana membuat file robots.txt sehingga Anda bisa mendapatkan bagian dasar dari situs Anda dan memastikan crawler berinteraksi dengan situs Anda seperti yang Anda inginkan.

Apa itu file robots.txt?

File robots.txt adalah perintah sederhana yang memberi tahu perayap mesin telusur halaman mana di situs Anda untuk dirayapi dan diindeks.

Ini adalah bagian dari protokol pengecualian robot (REP), keluarga prosedur standar yang mengatur bagaimana robot mesin pencari merayapi web, menilai dan mengindeks konten situs, lalu menyajikan konten itu kepada pengguna. File ini menentukan di mana perayap diizinkan untuk merayapi dan di mana mereka tidak diizinkan. Itu juga dapat berisi informasi yang dapat membantu perayap merayapi situs web dengan lebih efisien.

REP juga menyertakan "tag robot meta", yang merupakan arahan yang disertakan dalam HTML halaman yang berisi instruksi khusus tentang bagaimana perayap web harus merayapi dan mengindeks halaman web tertentu dan gambar atau file yang dikandungnya.

Apa Perbedaan Antara Tag Robots.txt dan Meta Robots?

Seperti yang saya sebutkan, protokol pengecualian robot juga menyertakan "tag meta robots", yang merupakan potongan kode yang disertakan dalam HTML halaman. Mereka berbeda dari file robots.txt karena memberikan arahan ke perayap web di halaman web tertentu , melarang akses ke halaman lengkap atau ke file tertentu yang ada di halaman, seperti foto dan video.

Sebaliknya, file robots.txt dimaksudkan untuk menjaga agar seluruh segmen situs web tidak diindeks, seperti subdirektori yang hanya ditujukan untuk penggunaan internal. File robots.txt berada di domain root situs Anda, bukan di halaman tertentu, dan arahan disusun sedemikian rupa sehingga memengaruhi semua halaman yang terdapat dalam direktori atau subdirektori yang dirujuk.

Mengapa Saya Membutuhkan File Robots.txt?

File robots.txt adalah file teks sederhana yang tampak sangat penting. Tanpa itu, perayap web hanya akan mengindeks setiap halaman yang mereka temukan.

Mengapa ini penting?

Sebagai permulaan, merayapi seluruh situs membutuhkan waktu dan sumber daya. Semua itu membutuhkan biaya, jadi Google membatasi seberapa banyak ia akan merayapi situs, terutama jika situs itu sangat besar. Ini dikenal sebagai "anggaran perayapan." Anggaran perayapan dibatasi oleh beberapa faktor teknis, termasuk waktu respons, URL bernilai rendah, dan jumlah kesalahan yang ditemukan.

Plus, jika Anda mengizinkan mesin telusur akses tanpa batas ke semua halaman Anda dan membiarkan perayap mereka mengindeksnya, Anda mungkin berakhir dengan indeks mengasapi. Ini berarti Google dapat memberi peringkat pada halaman yang tidak penting yang tidak ingin Anda tampilkan di hasil pencarian. Hasil ini dapat memberikan pengunjung pengalaman yang buruk, dan mereka bahkan dapat bersaing dengan halaman yang ingin Anda rangking.

Saat Anda menambahkan file robots.txt ke situs Anda atau memperbarui file yang ada, Anda dapat mengurangi pemborosan anggaran perayapan dan membatasi pengasapan indeks.

Bacaan yang Direkomendasikan

- Panduan Teknis SEO: Apa itu Tech SEO?

- Apa itu Index Kembung? (Dan Cara Memperbaikinya)

Di Mana Saya Dapat Menemukan File Robots.txt Saya?

Ada cara sederhana untuk melihat apakah situs Anda memiliki file robots.txt: Cari di internet.

Cukup ketik URL situs mana pun dan tambahkan “/ robots.txt” di bagian akhir. Misalnya: victoriousseo.com/robots.txt menunjukkan milik kami.

Cobalah sendiri dengan mengetikkan URL situs Anda dan menambahkan “/robots.txt” di akhir. Anda akan melihat salah satu dari tiga hal:

- Beberapa baris teks yang menunjukkan file robots.txt yang valid

- Halaman yang benar-benar kosong, menunjukkan tidak ada file robots.txt yang sebenarnya

- Kesalahan 404

Jika Anda memeriksa situs Anda dan mendapatkan salah satu dari dua hasil kedua, Anda sebaiknya membuat file robots.txt untuk membantu mesin telusur lebih memahami di mana mereka harus memfokuskan upaya mereka.

Cara Membuat File Robots.txt

File robots.txt menyertakan perintah tertentu yang dapat dibaca dan diikuti oleh robot mesin telusur. Berikut adalah beberapa istilah yang akan Anda gunakan saat membuat file robots.txt.

Persyaratan Umum Robots.txt untuk Diketahui

User-Agent : User-agent adalah perangkat lunak yang bertugas mengambil dan menyajikan konten web untuk pengguna akhir. Meskipun browser web, pemutar media, dan plugin semuanya dapat dianggap sebagai contoh agen pengguna, dalam konteks file robot.txt, agen pengguna adalah perayap atau spider mesin telusur (seperti Googlebot) yang merayapi dan mengindeks situs Anda.

Izinkan: Ketika terdapat dalam file robots.txt, perintah ini mengizinkan agen pengguna untuk merayapi halaman apa pun yang mengikutinya. Misalnya, jika perintah membaca "Izinkan: /" ini berarti perayap web mana pun dapat mengakses halaman apa pun yang mengikuti garis miring di "http://www.example.com/." Anda tidak perlu menambahkan ini untuk semua yang ingin dirayapi, karena apa pun yang tidak dilarang oleh robots.txt secara implisit diperbolehkan. Sebagai gantinya, gunakan untuk mengizinkan akses ke subdirektori yang berada di jalur yang tidak diizinkan. Misalnya, situs WordPress sering kali memiliki perintah disallow untuk folder /wp-admin/, yang pada gilirannya mengharuskan mereka untuk menambahkan perintah izinkan agar perayap dapat menjangkau /wp-admin/admin-ajax.php tanpa menjangkau apa pun di folder utama.

Larang: Perintah ini melarang agen pengguna tertentu merayapi halaman yang mengikuti folder tertentu. Misalnya, jika perintah berbunyi "Larang: /blog/", ini berarti agen pengguna tidak boleh merayapi URL apa pun yang berisi subdirektori /blog/, yang akan mengecualikan seluruh blog dari pencarian. Anda mungkin tidak akan pernah ingin melakukan itu, tetapi Anda bisa. Itulah mengapa sangat penting untuk mempertimbangkan implikasi penggunaan disallow directive setiap kali Anda berpikir untuk membuat perubahan pada file robots.txt Anda.

Penundaan perayapan: Meskipun perintah ini dianggap tidak resmi, perintah ini dirancang untuk menjaga perayap web dari server yang berpotensi membanjiri permintaan. Ini biasanya diterapkan di situs web di mana terlalu banyak permintaan dapat menyebabkan masalah server. Beberapa mesin pencari mendukungnya, tetapi Google tidak. Anda dapat menyesuaikan tingkat perayapan untuk Google dengan membuka Google Search Console, menavigasi ke halaman Pengaturan Tingkat Perayapan properti Anda, dan menyesuaikan bilah geser di sana. Ini hanya berfungsi jika Google menganggapnya tidak optimal. Jika menurut Anda itu kurang optimal dan Google tidak setuju, Anda mungkin perlu mengajukan permintaan khusus untuk menyesuaikannya. Itu karena Google lebih suka Anda mengizinkan mereka untuk mengoptimalkan tingkat perayapan untuk situs web Anda.

Peta Situs XML: Arahan ini melakukan persis seperti yang Anda duga: memberi tahu perayap web di mana peta situs XML Anda berada. Seharusnya terlihat seperti: “Peta Situs: http://www.example.com/sitemap.xml.” Anda dapat mempelajari lebih lanjut tentang praktik terbaik peta situs di sini.

Petunjuk Langkah demi Langkah untuk Membuat Robots.txt

Untuk membuat file robots.txt Anda sendiri, Anda memerlukan akses ke editor teks sederhana seperti Notepad atau TextEdit. Penting untuk tidak menggunakan pengolah kata, karena ini biasanya menyimpan file dalam bentuk kepemilikan dan dapat menambahkan karakter khusus ke file.

Demi kesederhanaan, kami akan menggunakan "www.example.com."

Kita akan mulai dengan menyetel parameter agen pengguna. Pada baris pertama, ketik:

Agen pengguna: *

Tanda bintang berarti semua perayap web diizinkan mengunjungi situs web Anda.

Beberapa situs web akan menggunakan perintah izinkan untuk mengatakan bahwa bot diizinkan untuk merayapi, tetapi ini tidak perlu. Setiap bagian dari situs yang tidak Anda larang secara implisit diizinkan.

Selanjutnya, kita akan memasukkan parameter disallow. Tekan "kembali" dua kali untuk menyisipkan jeda setelah baris agen-pengguna, lalu ketik:

Larang: /

Karena kami tidak memasukkan perintah apa pun setelahnya, itu berarti perayap web dapat mengunjungi setiap halaman di situs Anda.

Jika Anda ingin memblokir akses ke konten tertentu, Anda dapat menambahkan direktori setelah perintah disallow. File robots.txt kami memiliki dua perintah larangan berikut:

Larang: /wp/wp-admin/

Larang: /*?*

Yang pertama memastikan halaman admin WordPress kami (tempat kami mengedit hal-hal seperti artikel ini) tidak dirayapi. Ini adalah halaman yang tidak ingin kami rangking dalam pencarian, dan itu juga akan membuang-buang waktu Google untuk mencoba merayapinya karena dilindungi kata sandi. Yang kedua mencegah URL yang berisi tanda tanya, seperti halaman hasil pencarian blog, agar tidak dirayapi.

Setelah Anda menyelesaikan perintah Anda, tautkan ke peta situs Anda. Meskipun langkah ini secara teknis tidak diperlukan, ini adalah praktik terbaik yang disarankan karena ini mengarahkan spider web ke halaman paling penting di situs Anda dan membuat arsitektur situs Anda jelas. Setelah memasukkan jeda baris lain, ketik:

Peta Situs: http://www.example.com/sitemap.xml

Sekarang pengembang web Anda dapat mengunggah file Anda ke situs web Anda.

Membuat file Robots.txt di WordPress

Jika Anda memiliki akses Admin ke WordPress Anda, Anda dapat memodifikasi file robots.txt Anda dengan Plugin Yoast SEO atau AIOSEO. Atau, pengembang web Anda dapat menggunakan klien FTP atau SFTP untuk terhubung ke situs WordPress Anda dan mengakses direktori root.

Jangan pindahkan file robots.txt ke mana pun selain direktori root. Sementara beberapa sumber menyarankan untuk menempatkannya di subdirektori atau subdomain, idealnya, itu harus hidup di domain root Anda: www.example.com/robots.txt.

Cara Menguji File Robots.txt Anda

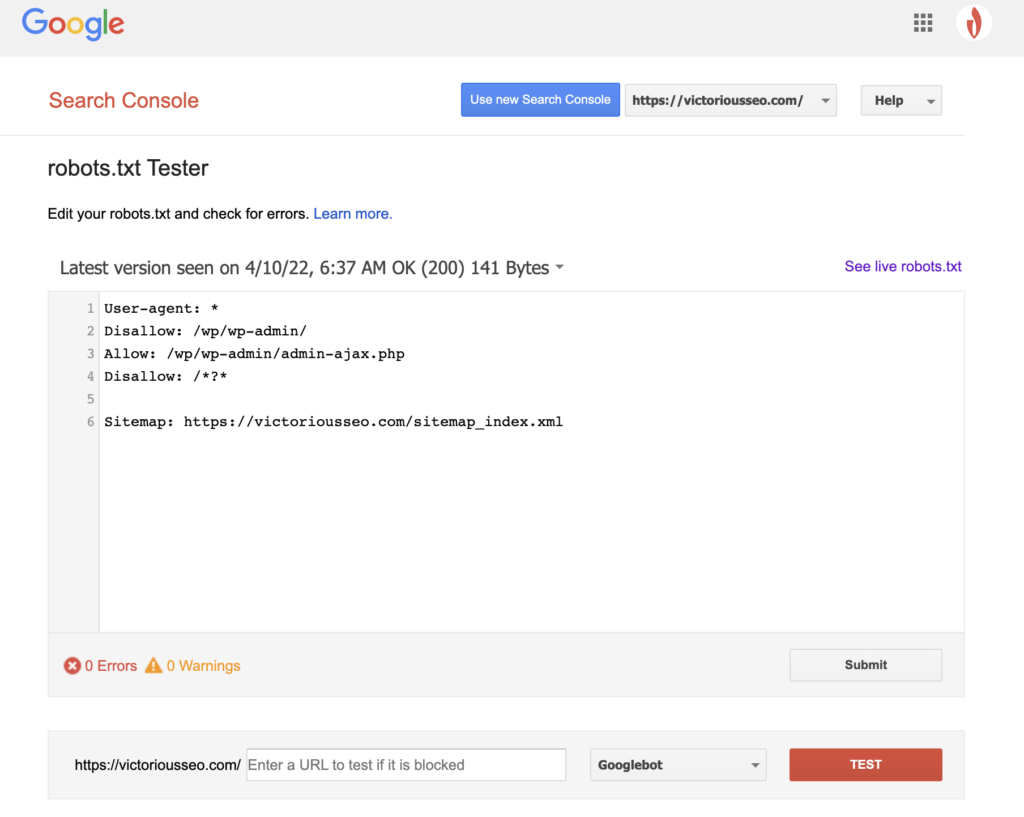

Sekarang setelah Anda membuat file robots.txt, saatnya untuk mengujinya. Untungnya, Google memudahkan dengan menyediakan Penguji robots.txt sebagai bagian dari Google Search Console.

Setelah Anda membuka penguji untuk situs Anda, Anda akan melihat peringatan sintaks dan kesalahan logika yang disorot.

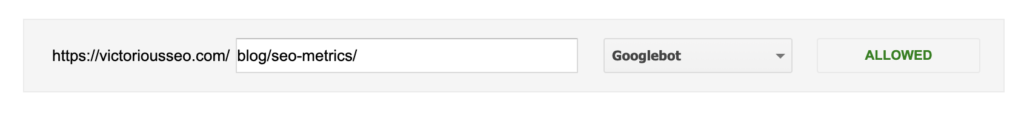

Untuk menguji bagaimana Googlebot tertentu “melihat” halaman Anda, masukkan URL dari situs Anda di kotak teks di bagian bawah halaman, lalu pilih di antara berbagai Googlebot di dropdown di sebelah kanan. Menekan "TEST" akan mensimulasikan perilaku bot yang Anda pilih dan menunjukkan jika ada arahan yang mencegah Googlebot mengakses halaman.

Kekurangan Robots.txt

File robots.txt sangat berguna, tetapi memiliki keterbatasan.

File robots.txt tidak boleh digunakan untuk melindungi atau menyembunyikan bagian situs web Anda (melakukannya dapat melanggar Undang-Undang Perlindungan Data). Ingat ketika saya menyarankan Anda mencari file robots.txt Anda sendiri? Itu berarti siapa pun dapat mengaksesnya, bukan hanya Anda. Jika ada informasi yang perlu Anda lindungi, pendekatan terbaik adalah melindungi halaman atau dokumen tertentu dengan kata sandi.

Selain itu, arahan file robots.txt Anda hanyalah permintaan. Anda dapat mengharapkan Googlebot dan perayap sah lainnya untuk mematuhi arahan Anda, tetapi bot lain mungkin mengabaikannya.

Terakhir, bahkan jika Anda meminta perayap untuk tidak mengindeks URL tertentu, mereka tidak terlihat. Situs web lain mungkin menautkannya. Jika Anda tidak ingin informasi tertentu di situs web Anda tersedia untuk dilihat publik, Anda harus melindunginya dengan kata sandi. Jika Anda ingin memastikan bahwa itu tidak akan diindeks, pertimbangkan untuk menyertakan tag noindex pada halaman.

Pelajari Lebih Lanjut Tentang SEO Teknis: Unduh Daftar Periksa Kami

Ingin mempelajari lebih lanjut tentang SEO, termasuk petunjuk langkah demi langkah tentang cara memanfaatkan SEO situs web Anda sendiri? Unduh Daftar Periksa SEO 2022 kami untuk mendapatkan daftar tugas yang komprehensif, termasuk sumber daya berharga yang akan membantu Anda meningkatkan peringkat pencarian dan mengarahkan lebih banyak lalu lintas organik ke situs web Anda.

Daftar Periksa & Alat Perencanaan SEO

Apakah Anda siap untuk menggerakkan jarum pada SEO Anda? Dapatkan daftar periksa interaktif dan alat perencanaan & mulailah!