I social media alimentano la divisione e l'angoscia, ma risolvere i problemi sottostanti in gioco è estremamente complesso

Pubblicato: 2022-04-08Nonostante vari studi e controstudi, in gran parte finanziati dalle reti stesse, i social media rimangono un veicolo estremamente problematico per messaggi divisivi e movimenti dannosi.

Ma la sua influenza è spesso fraintesa, o gli elementi vengono confusi per oscurare i fatti, per vari motivi. La vera influenza del social non dipende necessariamente dagli algoritmi né dall'amplificazione come elementi di focus. Il danno più significativo viene dalla connessione stessa e dalla capacità di collegarsi ai pensieri di persone che conosci, qualcosa che non era possibile in passato.

Ecco un esempio: diciamo che sei completamente vaccinato contro COVID, ti fidi completamente della scienza e stai facendo ciò che i funzionari sanitari hanno consigliato, nessun problema, nessuna preoccupazione per il processo. Ma poi vedi un post del tuo vecchio amico - chiamiamolo 'Dave' - in cui Dave esprime le sue preoccupazioni per il vaccino e perché è riluttante a riceverlo.

Forse non parli con Dave da anni, ma ti piace, rispetti la sua opinione. Improvvisamente, questo non è un attivista senza volto e senza nome che puoi facilmente liquidare, è qualcuno che conosci e ti fa dubitare se ci possa essere qualcosa di più nella spinta anti-vax di quanto pensassi. Dave non è mai sembrato stupido, né credulone, forse dovresti esaminarlo un po' di più.

Così fai: leggi i link pubblicati da Dave, dai un'occhiata ai post e agli articoli, magari sfogli anche alcuni gruppi per cercare di capire meglio. Forse inizi a pubblicare commenti anche su articoli anti-vax, e tutto questo dice agli algoritmi di Facebook che sei interessato a questo argomento e che è sempre più probabile che ti impegni con post simili. I consigli iniziano a cambiare nel tuo feed, diventi più coinvolto nell'argomento e tutto questo ti spinge ulteriormente da una parte all'altra della discussione, alimentando la divisione.

Ma non è iniziato con l'algoritmo, che è una confutazione fondamentale nelle controargomentazioni di Meta. È iniziato con Dave, qualcuno che conosci, che ha pubblicato un'opinione che ha suscitato il tuo interesse.

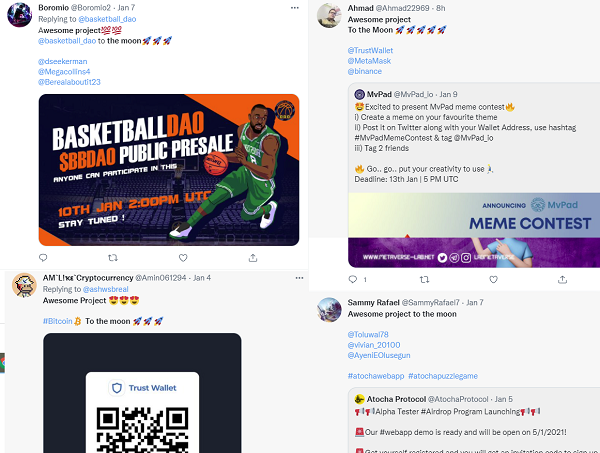

Ecco perché le campagne più ampie per manipolare l'opinione pubblica sono una tale preoccupazione. Le campagne di disturbo orchestrate dall'Agenzia russa per la ricerca su Internet in vista delle elezioni americane del 2016 sono l'esempio più pubblico, ma spinte simili si verificano continuamente. La scorsa settimana, sono emerse notizie secondo cui il governo indiano ha utilizzato campagne di forza bruta alimentate da bot sui social per "inondare la zona" e spostare il dibattito pubblico su determinati argomenti facendo in modo che argomenti alternativi di tendenza su Facebook e Twitter. Molti progetti NFT e cripto stanno ora cercando di incassare il clamore più ampio utilizzando i bot di Twitter per far sembrare le loro offerte più popolari e rispettabili di quanto non siano.

La maggior parte delle persone, ovviamente, ora è sempre più diffidente nei confronti di tali spinte e metterà più facilmente in discussione ciò che vede online. Ma proprio come la classica truffa via e-mail nigeriana, bastano pochissime persone per attaccarsi e ne vale la pena. I costi di manodopera sono bassi e il processo può essere ampiamente automatizzato. E solo pochi Dave possono finire per avere un grande impatto sul discorso pubblico.

Le motivazioni di queste campagne sono complesse. Nel caso del governo indiano si tratta di controllare il discorso pubblico e reprimere possibili dissensi, mentre per i truffatori si tratta di soldi. Ci sono molte ragioni per cui tali spinte vengono emanate, ma non c'è dubbio che i social media abbiano fornito un connettore valido e praticabile per questi sforzi.

Ma le controargomentazioni sono selettive. Meta afferma che il contenuto politico è solo una piccola parte del materiale complessivo condiviso su Facebook. Il che può essere vero, ma conta solo gli articoli condivisi, non i post personali e le discussioni di gruppo. Meta afferma anche che i contenuti divisivi in realtà sono dannosi per il business perché, come spiega il CEO Mark Zuckerberg:

“ Guadagniamo con gli annunci e gli inserzionisti ci dicono costantemente che non vogliono che i loro annunci siano accanto a contenuti dannosi o arrabbiati. E non conosco nessuna azienda tecnologica che si propone di costruire prodotti che facciano arrabbiare o deprimere le persone. Gli incentivi morali, commerciali e di prodotto puntano tutti nella direzione opposta. "

Eppure, allo stesso tempo, la stessa ricerca di Meta ha anche mostrato il potere di Facebook nell'influenzare l'opinione pubblica, in particolare nel contesto politico.

Nel 2010, circa 340.000 elettori in più hanno preso parte alle elezioni del Congresso degli Stati Uniti a causa di un singolo messaggio Facebook del giorno delle elezioni promosso da Facebook.

Secondo lo studio :

"Circa 611.000 utenti (1%) hanno ricevuto un 'messaggio informativo' nella parte superiore dei loro feed di notizie, che li incoraggiava a votare, forniva un collegamento a informazioni sui seggi elettorali locali e includeva un pulsante 'Ho votato' cliccabile e un contatore di Utenti di Facebook che l'hanno cliccato Circa 60 milioni di utenti (98%) hanno ricevuto un "messaggio sociale", che includeva gli stessi elementi ma mostrava anche le immagini del profilo di un massimo di sei amici di Facebook selezionati casualmente che avevano cliccato sul pulsante "Ho votato" . Il restante 1% degli utenti è stato assegnato a un gruppo di controllo che non ha ricevuto alcun messaggio."

I risultati hanno mostrato che coloro che hanno visto il secondo messaggio, con le immagini delle loro connessioni incluse, avevano sempre più probabilità di votare, il che alla fine ha portato altre 340.000 persone a dirigersi alle urne a causa del peer nudge. E questo è solo su piccola scala in termini di Facebook, tra 60 milioni di utenti, con la piattaforma che ora si avvicina a 3 miliardi di attivi mensili in tutto il mondo.

È chiaro, sulla base delle prove di Facebook, che la piattaforma detiene effettivamente un potere influente significativo attraverso le intuizioni tra pari e la condivisione personale.

Quindi non è specificamente Facebook, né il famigerato algoritmo del feed di notizie ad essere i principali colpevoli di questo processo. Sono le persone e ciò che le persone scelgono di condividere. Che è ciò che il CEO di Meta Mark Zuckerberg ha ripetutamente sottolineato:

“ Sì, abbiamo grandi disaccordi, forse più ora che in qualsiasi momento della storia recente. Ma parte di questo è perché stiamo mettendo sul tavolo i nostri problemi, problemi di cui per molto tempo non si è parlato. Più persone provenienti da più parti della nostra società hanno una voce che mai e ci vorrà del tempo per ascoltare queste voci e unirle insieme in una narrazione coerente. "

Contrariamente al suggerimento che sta causando più problemi, Meta vede Facebook come un veicolo per un vero cambiamento sociale, che attraverso la libertà di espressione possiamo raggiungere un punto di maggiore comprensione e che fornire una piattaforma per tutti dovrebbe, in teoria, garantire una migliore rappresentazione e connessione.

Il che è vero da un punto di vista ottimistico, ma comunque, la capacità dei cattivi attori di influenzare anche quelle opinioni condivise è ugualmente significativa, e questi sono altrettanto spesso i pensieri che vengono amplificati tra le connessioni delle tue reti.

Quindi cosa si può fare, oltre a ciò su cui stanno già lavorando i team di imposizione e moderazione di Meta?

Beh, probabilmente non molto. Per alcuni aspetti, il rilevamento del testo ripetuto nei post apparentemente funzionerebbe, cosa che le piattaforme già fanno in vari modi. Anche limitare la condivisione su determinati argomenti potrebbe avere un certo impatto, ma in realtà il modo migliore per procedere è quello che sta facendo Meta, nel lavorare per rilevare i creatori di tali argomenti e rimuovere le reti che amplificano i contenuti discutibili.

La rimozione dell'algoritmo funzionerebbe?

Forse. L'informatore Frances Haugen ha indicato l'algoritmo del feed di notizie e il suo focus sull'alimentare il coinvolgimento sopra ogni altra cosa, come un problema chiave, poiché il sistema è effettivamente progettato per amplificare i contenuti che incitano alla discussione.

Questo è decisamente problematico in alcune applicazioni, ma impedirebbe a Dave di condividere i suoi pensieri su un problema? No, non lo sarebbe, e allo stesso tempo, non c'è nulla che suggerisca che i Dave del mondo stiano ottenendo le loro informazioni tramite fonti discutibili, come quelle evidenziate qui. Ma le piattaforme dei social media e i loro algoritmi facilitano entrambi, migliorano tale processo e forniscono strade completamente nuove per la divisione.

Ci sono diverse misure che potrebbero essere emanate, ma l'efficacia di ciascuna è altamente discutibile. Perché gran parte di questo non è un problema di social media, è un problema di persone, come dice Meta. Il problema è che ora abbiamo accesso ai pensieri di tutti gli altri e con alcuni di loro non saremo d'accordo.

In passato potevamo andare avanti, beatamente inconsapevoli delle nostre differenze. Ma nell'era dei social media, questa non è più un'opzione.

Alla fine, come dice Zuckerberg, ci porterà a una società più comprensiva, integrata e civile? I risultati finora suggeriscono che abbiamo un modo per andare avanti.