Social Media schürt Spaltung und Angst – aber die Lösung der zugrunde liegenden Probleme ist äußerst komplex

Veröffentlicht: 2022-04-08Trotz verschiedener Studien und Gegenstudien, die größtenteils von den Netzwerken selbst finanziert werden, bleiben soziale Medien ein äußerst problematisches Instrument für spaltende Nachrichten und schädliche Bewegungen.

Aber sein Einfluss wird aus unterschiedlichen Gründen oft missverstanden oder Elemente werden verschleiert, um die Fakten zu verschleiern. Der wirkliche Einfluss von Social ist nicht unbedingt auf Algorithmen oder Verstärkung als Fokuselemente zurückzuführen. Der größte Schaden entsteht durch die Verbindung selbst und die Fähigkeit, sich in die Gedanken von Menschen einzuklinken, die Sie kennen, etwas, das in früheren Zeiten nicht möglich war.

Hier ist ein Beispiel – nehmen wir an, Sie sind vollständig gegen COVID geimpft, Sie vertrauen der Wissenschaft voll und ganz und Sie tun, was die Gesundheitsbehörden empfohlen haben, keine Probleme, keine Bedenken hinsichtlich des Verfahrens. Aber dann sehen Sie einen Beitrag Ihres alten Freundes – nennen wir ihn „Dave“ – in dem Dave seine Besorgnis über den Impfstoff zum Ausdruck bringt und warum er zögert, ihn zu bekommen.

Sie haben vielleicht jahrelang nicht mit Dave gesprochen, aber Sie mögen ihn, Sie respektieren seine Meinung. Plötzlich ist dies kein gesichtsloser, namenloser Aktivist, den Sie leicht abtun können, sondern jemand, den Sie kennen, und Sie fragen sich, ob hinter dem Anti-Impf-Vorstoß mehr steckt, als Sie dachten. Dave schien nie dumm oder leichtgläubig zu sein, vielleicht sollten Sie sich näher damit befassen.

Also tust du es – du liest Links, die von Dave gepostet wurden, du schaust dir Posts und Artikel an, vielleicht stöberst du sogar in ein paar Gruppen, um zu versuchen, sie besser zu verstehen. Vielleicht fangen Sie auch an, Kommentare zu Anti-Vax-Artikeln zu posten, und all dies sagt den Algorithmen von Facebook, dass Sie an diesem Thema interessiert sind und dass Sie sich zunehmend mit ähnlichen Posts beschäftigen werden. Die Empfehlungen beginnen sich in Ihrem Feed zu ändern, Sie beschäftigen sich mehr mit dem Thema, und all dies treibt Sie weiter auf die eine oder andere Seite des Arguments und heizt die Spaltung an.

Aber es begann nicht mit dem Algorithmus, der eine Kernwiderlegung in Metas Gegenargumenten darstellt. Es begann mit Dave, jemandem, den Sie kennen, der eine Meinung gepostet hat, die Ihr Interesse geweckt hat.

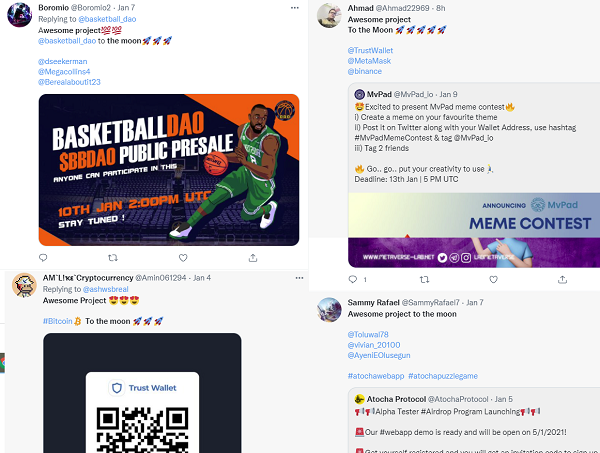

Aus diesem Grund sind breiter angelegte Kampagnen zur Manipulation der öffentlichen Meinung so besorgniserregend. Die von der russischen Internet Research Agency im Vorfeld der US-Wahlen 2016 orchestrierten Disruptionskampagnen sind das öffentlichste Beispiel, aber ähnliche Vorstöße finden ständig statt. Letzte Woche tauchten Berichte auf, dass die indische Regierung Bot-getriebene Brute-Force-Kampagnen im sozialen Bereich eingesetzt hat, um die Zone zu „fluten“ und die öffentliche Debatte zu bestimmten Themen zu verschieben, indem alternative Themen auf Facebook und Twitter zum Trend werden. Viele NFT- und Krypto-Projekte versuchen nun, von dem breiteren Hype zu profitieren, indem sie Twitter-Bots verwenden, um ihre Angebote beliebter und seriöser erscheinen zu lassen, als sie sind.

Die meisten Menschen sind jetzt natürlich zunehmend misstrauisch gegenüber solchen Vorstößen und werden bereitwilliger hinterfragen, was sie online sehen. Aber ähnlich wie beim klassischen nigerianischen E-Mail-Betrug braucht es nur eine sehr kleine Anzahl von Leuten, um sich daran zu gewöhnen, und all diese Bemühungen sind es wert. Die Arbeitskosten sind gering und der Prozess lässt sich weitgehend automatisieren. Und nur wenige Daves können am Ende einen großen Einfluss auf den öffentlichen Diskurs haben.

Die Beweggründe für diese Kampagnen sind komplex. Im Fall der indischen Regierung geht es darum, den öffentlichen Diskurs zu kontrollieren und möglichen Widerspruch zu unterdrücken, während es für Betrüger um Geld geht. Es gibt viele Gründe, warum solche Vorstöße durchgeführt werden, aber es steht außer Frage, dass soziale Medien eine wertvolle, tragfähige Verbindung für diese Bemühungen bereitgestellt haben.

Aber Gegenargumente sind selektiv. Meta sagt, dass politische Inhalte nur einen kleinen Teil des gesamten auf Facebook geteilten Materials ausmachen. Das mag stimmen, aber das zählt nur geteilte Artikel, nicht persönliche Posts und Gruppendiskussionen. Meta sagt auch, dass spaltende Inhalte eigentlich schlecht fürs Geschäft sind, denn wie CEO Mark Zuckerberg erklärt:

„ Wir verdienen Geld mit Anzeigen und Werbetreibende sagen uns ständig, dass sie ihre Anzeigen nicht neben schädlichen oder wütenden Inhalten haben möchten. Und ich kenne kein Technologieunternehmen, das sich zum Ziel gesetzt hat, Produkte zu entwickeln, die Menschen wütend oder depressiv machen. Die moralischen, geschäftlichen und produktbezogenen Anreize weisen alle in die entgegengesetzte Richtung. ”

Gleichzeitig hat Metas eigene Forschung jedoch auch die Macht von Facebook bei der Beeinflussung der öffentlichen Meinung gezeigt, insbesondere im politischen Kontext.

Im Jahr 2010 nahmen rund 340.000 zusätzliche Wähler an den US-Kongresswahlen teil, weil eine einzige Facebook-Nachricht am Wahltag von Facebook unterstützt wurde.

Laut Studie :

„Ungefähr 611.000 Benutzer (1 %) erhielten oben in ihren Newsfeeds eine ‚Informationsnachricht‘, die sie zur Stimmabgabe aufforderte, einen Link zu Informationen über lokale Wahllokale enthielt und eine anklickbare ‚Ich habe gewählt‘-Schaltfläche und einen Zähler enthielt Facebook-Nutzer, die darauf geklickt hatten Etwa 60 Millionen Nutzer (98 %) erhielten eine „Social Message“, die die gleichen Elemente enthielt, aber auch die Profilbilder von bis zu sechs zufällig ausgewählten Facebook-Freunden zeigte, die auf die Schaltfläche „Ich habe abgestimmt“ geklickt hatten . Die verbleibenden 1 % der Benutzer wurden einer Kontrollgruppe zugewiesen, die keine Nachricht erhielt."

Die Ergebnisse zeigten, dass diejenigen, die die zweite Nachricht mit Bildern ihrer Verbindungen sahen, mit zunehmender Wahrscheinlichkeit abstimmten, was schließlich dazu führte, dass 340.000 weitere Menschen aufgrund des Peer-Nudge zur Wahl gingen. Und das ist für Facebook nur ein kleiner Maßstab, unter 60 Millionen Nutzern, wobei die Plattform jetzt weltweit 3 Milliarden monatliche Aktivitäten erreicht.

Basierend auf den eigenen Beweisen von Facebook ist klar, dass die Plattform durch Peer-Insights und persönlichen Austausch tatsächlich eine erhebliche Einflusskraft besitzt.

Es ist also nicht speziell Facebook oder der berüchtigte Newsfeed-Algorithmus, die die Hauptschuldigen in diesem Prozess sind. Es sind Menschen und das, was Menschen teilen. Darauf hat Meta-CEO Mark Zuckerberg wiederholt hingewiesen:

„ Ja, wir haben große Meinungsverschiedenheiten, vielleicht mehr als je zuvor in der jüngeren Geschichte. Aber das liegt zum Teil daran, dass wir unsere Themen auf den Tisch bringen – Themen, über die lange Zeit nicht gesprochen wurde. Mehr Menschen aus mehr Teilen unserer Gesellschaft haben eine Stimme als je zuvor, und es wird einige Zeit dauern, diese Stimmen zu hören und sie zu einer kohärenten Erzählung zusammenzufügen. ”

Entgegen der Behauptung, dass es mehr Probleme verursacht, sieht Meta Facebook als ein Vehikel für echte soziale Veränderungen, dass wir durch Meinungsfreiheit einen Punkt des besseren Verständnisses erreichen können und dass die Bereitstellung einer Plattform für alle theoretisch eine bessere Repräsentation gewährleisten sollte und Verbindung.

Was von einem optimistischen Standpunkt aus zutrifft, aber dennoch ist die Fähigkeit von schlechten Schauspielern, diese gemeinsamen Meinungen ebenfalls zu beeinflussen, ebenso bedeutsam, und das sind genauso oft die Gedanken, die zwischen Ihren Netzwerkverbindungen verstärkt werden.

Was kann also getan werden, über das hinaus, woran die Durchsetzungs- und Moderationsteams von Meta bereits arbeiten?

Nun, wahrscheinlich nicht viel. In mancher Hinsicht scheint es zu funktionieren, wiederholten Text in Beiträgen zu erkennen, was Plattformen bereits auf unterschiedliche Weise tun. Das Einschränken des Teilens zu bestimmten Themen könnte ebenfalls einige Auswirkungen haben, aber der beste Weg nach vorne ist das, was Meta tut, indem es daran arbeitet, die Urheber solcher Inhalte zu erkennen und die Netzwerke zu entfernen, die fragwürdige Inhalte verstärken.

Würde das Entfernen des Algorithmus funktionieren?

Vielleicht. Die Whistleblowerin Frances Haugen hat auf den Newsfeed-Algorithmus und seinen Fokus darauf hingewiesen, vor allem das Engagement zu fördern, als ein Schlüsselproblem, da das System effektiv darauf ausgelegt ist, Inhalte zu verstärken, die zu Argumenten anregen.

Das ist in einigen Anwendungen definitiv problematisch, aber würde es Dave davon abhalten, seine Gedanken zu einem Thema zu teilen? Nein, würde es nicht, und gleichzeitig deutet nichts darauf hin, dass die Daves der Welt ihre Informationen über fragwürdige Quellen erhalten, wie die hier hervorgehobenen. Aber Social-Media-Plattformen und ihre Algorithmen erleichtern beides, sie verbessern diesen Prozess und bieten ganz neue Wege für die Spaltung.

Es gibt verschiedene Maßnahmen, die erlassen werden könnten, aber die Wirksamkeit jeder einzelnen ist höchst fraglich. Denn vieles davon ist kein Problem der sozialen Medien, sondern ein Problem der Menschen, wie Meta sagt. Das Problem ist, dass wir jetzt Zugang zu den Gedanken aller anderen haben, und einigen von ihnen werden wir nicht zustimmen.

In der Vergangenheit konnten wir weitermachen, ohne uns unserer Unterschiede bewusst zu sein. Aber im Social-Media-Zeitalter ist das keine Option mehr.

Wird uns das schließlich, wie Zuckerberg sagt, zu einer verständnisvolleren, integrierteren und zivileren Gesellschaft führen? Die bisherigen Ergebnisse deuten darauf hin, dass wir hier einen Weg gefunden haben.