8 Voice-Content-Trends für 2020

Veröffentlicht: 2019-08-01

Sprache ist die neue Schnittstelle, die uns bald an vielen Orten und auf vielfältige Weise umgeben wird. Sprachinhalte für Amazon Echo, Google Home und Samsung-Geräte werden von großen und kleinen Marken entwickelt.

Wir entwickeln hier bei Convince & Convert sprachaktivierte Content-Strategien für unsere Kunden – und helfen ihnen dabei, diese schnell wachsende Gelegenheit zur Interaktion mit Verbrauchern zu nutzen (mehr darüber, was wir mit Voice-Content tun, siehe Why The Time is Now for Voice- aktivierter Inhalt).

Wir entwickeln hier bei Convince & Convert sprachaktivierte Content-Strategien für unsere Kunden – und helfen ihnen dabei, diese schnell wachsende Gelegenheit zur Interaktion mit Verbrauchern zu nutzen (mehr darüber, was wir mit Voice-Content tun, siehe Why The Time is Now for Voice- aktivierter Inhalt).

Ich habe kürzlich am Voice Summit 2019 teilgenommen, dem Berichten zufolge das bisher größte Branchentreffen von Strategen, Entwicklern, Technologen, Anbietern und Hardwareplattformen für Sprachinhalte.

Hier sind die Top-8-Voice-Content-Trends, die ich während meiner Zeit auf der Veranstaltung und durch unsere Arbeit mit Kunden an Voice-Apps synthetisiert habe.

Der beste Voice-Content beginnt mit den Benutzeranforderungen

Ähnlich wie in den Anfängen mobiler Apps und sogar Websites gibt es unter Strategen und Entwicklern eine Tendenz zu denken: „Lasst uns eine Voice-App machen!“ Stattdessen besteht der bessere Ansatz darin, sorgfältig zu prüfen und zu untersuchen, wie Verbraucher mit der Marke interagieren, was sie tatsächlich von dieser Marke wissen müssen und ob/ob Sprachinhalte ein geeigneter Weg zur Bereitstellung sind. Schließlich gibt es kein Gesetz, das besagt, dass Sie sprachaktivierte Inhalte haben MÜSSEN. Ist es wirklich eine Jugendlichkeit? Wenn ja, bau es. Wenn nicht, nicht!

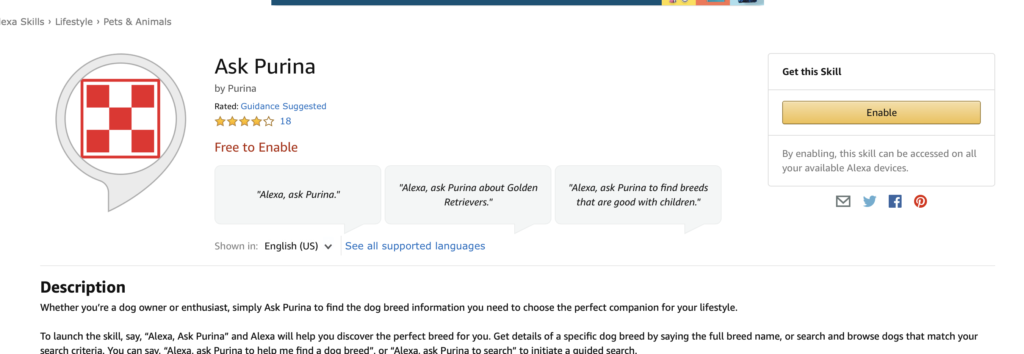

Purinas „Ask Purina“-Alexa-Skill zum Beispiel wurde aus dem Bedürfnis der Verbraucher heraus geboren, zu verstehen, wie sich verschiedene Hunderassen verhalten und welche Rasse sich als neues Haustier am besten eignet. Laut Vertretern von Mobiquity, der Firma, die die Fähigkeit entwickelt hat, erwogen sie, Audio-Werbung für den Kauf von Hundefutter aufzunehmen, verwarfen diese Idee jedoch, nachdem sie erkannt hatten, dass dies den Informationswert überladen würde.

Konvergenz von Sprache und Chat

Die effektivsten Sprachanwendungen sind heutzutage typischerweise Nachrichten, Fragen und Antworten zum Abrufen von Informationen oder Spiele. An der „Marken-Q&A“-Front ist der Interaktionsfluss dieser Apps, wie beim oben erwähnten Purina-Beispiel, sehr ähnlich wie die Verwendung von Chatbots durch Verbraucher.

Tatsächlich würde der Alexa-Skill „Fragen Sie Purina-Hunderasseninformationen“ ganz gut als Chatbot auf einer Website und/oder über Facebook Messenger oder WhatsApp funktionieren.

KLM Airlines sah diese Konvergenz auch, kam aber aus der entgegengesetzten Richtung darauf zu. Sie nahmen ihre sehr erfolgreiche (und oft genutzte) Messaging-App und portierten sie auf einen Alexa Voice Skill für Amazon Echo-Geräte.

Unabhängig davon, ob Sie von Sprache zu Chat oder von Chat zu Sprache wechseln, es stimmt, dass viele informationsbasierte Anwendungsfälle in beiden Szenarien ähnlich funktionieren.

Dies ist nur einer der Gründe, warum wir gerne mit Voicify zusammenarbeiten. Voicify ist ein Voice-Content-Management-System, mit dem Alexa Skills und Google Apps mit sehr geringem zusätzlichen Entwicklungsaufwand sofort auf einen Chatbot portiert werden können.

Konvergenz von Stimme und Bild

Wie auf der Bühne des Voice Summit 19 erwähnt wurde, fügen Schnittstellen, die in der Vergangenheit zunächst visuell waren (wie Ihr Laptop oder Ihr Fahrzeugdisplay), jetzt Sprache hinzu. Ich benutze Siri jeden Tag auf meinem MacBook. Umgekehrt beinhalten Schnittstellen, die in der Vergangenheit zuerst die Sprache waren (wie Amazon Echo), jetzt auch visuelle Elemente.

Viele der neu gekauften intelligenten Lautsprecher enthalten Bildschirme, und die Geräte Amazon Echo Show und Google Home Hub kosten routinemäßig weniger als 100 US-Dollar.

Viele der neu gekauften intelligenten Lautsprecher enthalten Bildschirme, und die Geräte Amazon Echo Show und Google Home Hub kosten routinemäßig weniger als 100 US-Dollar.

Dies hat einige Konsequenzen.

Erstens erhöht es geometrisch die Komplexität der Entwicklung von Voice-Apps.

Zweitens eröffnet es viel zusätzlichen Nutzen. Die Purina-App wäre nützlicher, wenn Sie Bilder von Hunderassen auf einem intelligenten Lautsprecher mit Bildschirm sehen könnten. Ganz zu schweigen von der Tatsache, dass Sprache als Eingabe schneller, aber als Ausgabe langsamer ist. Laut Tobias Dengel von Willowtree tippen wir durchschnittlich 40 Wörter pro Minute (wpm), sprechen aber 130. Umgekehrt können wir 250 wpm lesen, aber nur 130 hören. Das hat viel Potenzial, Sprachinhalte wirklich multifunktional zu gestalten -modal und benutzerfreundlich, wenn wir sprechen können, was wir wollen, und die Ergebnisse lesen können.

Wir tippen durchschnittlich 40 Wörter pro Minute (wpm), sprechen aber 130. #voice Click To TweetAber drittens, wenn intelligente Lautsprecher hauptsächlich zu Geräten mit Bildschirmen werden, was unterscheidet sie dann von Tablets, kleinen Laptops oder großen Telefonen?

Obwohl ich intelligente Lautsprecher mit einem Bildschirm bevorzuge (ich bin persönlich ein Anhänger von Google Home Hub), bin ich mir nicht sicher, ob das Verwischen der Unterschiede zwischen einem intelligenten Lautsprecher und einem iPad letztendlich ein Gewinn für diese Geräte ist.

Formatkonflikt wird zum Problem

In der kurzen Geschichte der Epoche der intelligenten Lautsprecher und Sprachinhalte war Amazon der große Boss. Ihre Echo-Geräte haben im Wesentlichen die Kategorie geschaffen, und dieser First-Mover-Vorteil sowie ihre massive Werbekraft ermöglichten es Amazon, in der Welt der intelligenten Lautsprecher weit vorne zu liegen.

In jüngerer Zeit sind jedoch Google (und in weit geringerem Maße Apple) mit ihren eigenen Hardwaregeräten in den Kampf gesprungen, um das Echo zu übertreffen, mit unterschiedlichem Erfolg. Jüngste Branchenberichte deuten darauf hin, dass der Marktanteil von Google bei intelligenten Lautsprechern jetzt fast 25 % beträgt, und angesichts ihrer tiefen Taschen und ihres Interesses, alles, was mit der Suche zu tun hat, zu dominieren (plus ihres Besitzes des Smart-Home-Unternehmens Nest), gehen sie nirgendwo hin.

Dies bietet den Verbrauchern eine wachsende Auswahl an intelligenten Lautsprechern auf der Hardwareseite, schafft jedoch einen mühsamen und ineffizienten Prozess für die Entwickler von Sprachinhalten. Heute sind die technologischen Grundlagen eines Amazon Alexa-Skills und einer Google Home-App ziemlich unterschiedlich. Ganz zu schweigen von der brandneuen Sprachplattform Samsung Bixby, die fast umgekehrt wie Amazon/Google aufgebaut ist.

Daher befindet sich die Welt der Sprachinhalte mitten in einem Standarddilemma, das an Betamax vs. VHS, Internet Explorer vs. Netscape, ios vs. Android und Joe Jonas vs. den Vornamen seiner Brüder erinnert.

Es wäre VIEL besser, wenn es einen einzigen Entwicklungspfad für Sprachinhalte gäbe. Aber ich halte nicht den Atem an, dass wir so etwas sehen werden, weshalb Voice-Content-Management-Systeme wie Voicify heute von entscheidender Bedeutung sind. Innerhalb von Voicify optimiert und verdreht die Voicify-Technologie beim Erstellen von Sprachinhalten automatisch die Interaktionen und Skripte, damit sie sowohl auf Amazon- als auch auf Google-Geräten funktionieren, ohne dass die Sprachanwendung neu geschrieben werden muss. Ein Gewinn, ganz klar.

Marketing und Rollout sind entscheidend

Als größtes und am längsten laufendes Ökosystem hat Amazon natürlich die meisten genehmigten und ausgeführten Sprachanwendungen, mehr als 60.000 allein in den Vereinigten Staaten. Jeden Tag kommen ein paar Dutzend neue Fähigkeiten hinzu. Und die Fähigkeit der Verbraucher, nützliche neue Fähigkeiten zu entdecken, ist kein Highlight des aktuellen Alexa-Systems. Es ist im Wesentlichen das Online- und/oder sprachaktivierte Äquivalent zum Gang durch eine sehr große Bibliothek mit einer erstaunlichen Vielfalt an Büchern, von denen viele beschissen sind, und einem viertklassigen Bibliothekar, der halbherzig Fragen zwischen Bissen von hausgemachtem Auflauf beantwortet.

Sagen Sie es so: Wenn Sie möchten, dass die Leute Ihre sprachaktivierten Inhalte finden und verwenden, liegt diese Verantwortung auf IHREN Schultern. Erwarten Sie NICHTS von Amazon und Google in Bezug auf Werbung und Auffindbarkeit. Auf diese Weise werden Sie nicht enttäuscht sein, wenn Sie genau das erhalten.

Wenn Sie Sprachinhalte starten, müssen Sie einfach eine gründliche, multimodale Sensibilisierungs- und Testkampagne aktivieren, die eine Kombination aus Out-of-Home, E-Mail, sozialen Medien, Direktwerbung, Geiselnotizen und Menschen, die sich wie Clowns verkleiden und stehen, nutzt an Straßenecken. Ihr Kilometerstand kann variieren.

Heutzutage übersteigen die Fähigkeiten von Sprachinhalten tatsächlich das Verständnis der Verbraucher für diese Fähigkeiten. Es ist eine interessante Umkehrung. Comcast (einer unserer Lieblingskunden) sprach auf einem Panel auf dem Voice Summit 19 und berichtete, dass seine Kunden im Jahr 2018 etwa 9 MILLIARDEN Befehle in ihre sprachaktivierten X1-Fernbedienungen ausgesprochen haben. Aber die überwiegende Mehrheit dieser Sprachbefehle sind für die gleichen kleinen Reihe von Anfragen. Sie arbeiten derzeit an neuen Möglichkeiten, Kunden all die anderen Dinge beizubringen, die die Sprachfernbedienung tun kann. Auf Ihre eigene Weise müssen Sie dasselbe tun, wenn Sie Ihre sprachaktivierten Inhalte bereitstellen.

Absichtlich eingeschränkte Funktionalität

Einer meiner Lieblingspunkte auf dem Voice Summit 19 kam von Martine van der Lee von KLM Airlines, die feststellte, dass die Arbeit mit Sprach-Apps frustrierender und nicht weniger wird, wenn Sprach-Apps viele Funktionen haben.

Sie betonte genau, dass Sprachinhalte mit mehreren Optionen (im Wesentlichen eine Sammlung von Apps innerhalb der Umbrella-App) eine IVReske Interaktion zwischen Verbraucher und Gerät erfordern. „Willst du dies oder dies oder dies oder dies oder dies tun?“ Es ist die Telefonbaumhölle, aber über einen intelligenten Lautsprecher. Nicht gut.

Im Moment ist der beste Ansatz, einen würdigen Anwendungsfall zu finden und Ihre Sprachinhalts-App so zu bauen, dass sie nur ein paar Dinge außerordentlich gut macht. Es ist besser, mehrere Apps oder Fähigkeiten zu haben, als mehr Optionen in eine vorhandene Sprachausführung zu stecken. Beachten Sie, dass die Verwendung von Bildschirmen in intelligenten Lautsprechern (siehe oben) dieses Problem möglicherweise verbessern kann.

Möglichkeiten für interne Voice-Inhalte gibt es zuhauf

Während die meisten Sprachfähigkeiten und Apps für den Verbrauchergebrauch entwickelt wurden, gibt es viele interessante Anwendungsfälle für intern ausgerichtete sprachaktivierte Inhalte. Insbesondere da die App-Nutzung gesperrt werden kann, sodass nur berechtigte Personen/E-Mail-Adressen Zugriff haben, ist das interne Kommunikationspotenzial erheblich.

Zum Beispiel eine Voice-App „Ask HR“, die häufige Fragen zu Gehaltsabrechnung, Versicherungen, Urlaubsrichtlinien usw. beantwortet. Oder eine „Meeting-Killer“-App, bei der die Teilnehmer eines Teams jeweils ein kurzes Projekt-Update aufzeichnen und alle Updates in einer einzigen Audiodatei zusammengefasst werden. Einfaches Hören, zeiteffizient und kein Konferenzraum erforderlich!

Ethik steht im Vordergrund

Auf dem Voice Summit 19 wurde viel über Ethik gesprochen. Es ist erfrischend zu sehen, wie die Pioniere in einer aufstrebenden Branche einige der gesellschaftlichen Auswirkungen ihrer Arbeit von Anfang an durchdenken, anstatt zu versuchen, ethische Überlegungen zu verbreiten, nachdem der Zug längst vorbei ist verließ die Station (hust, hust – soziale Medien – hust, hust).

Die New York Times führte eine gründliche Abonnentenstudie über die Realisierbarkeit von und Einstellungen zu intelligenten Lautsprechern und Sprachinhalten durch und stellte fest, dass die überwältigende Mehrheit der Benutzer von intelligenten Lautsprechern glaubt, dass die von den Lautsprechern verwendete Standardstimme in ihrem Tonfall und ihrer Einstellung „weiß“ ist. Dies hat an und für sich Konsequenzen.

Um dem entgegenzuwirken, hat KLM Airlines die Stimmen von Hunderten von Mitarbeitern aufgezeichnet und eine benutzerdefinierte Poly-Voice-Sprach-Engine entwickelt, die so neutral wie möglich sein soll.

Andere ethische Überlegungen in diesem frühen Stadium umfassen die Fähigkeit (oder deren Fehlen) von intelligenten Lautsprechern, auf die Tonalität zu hören und basierend auf wahrgenommenen Empathiebedürfnissen unterschiedlich zu reagieren usw.

Und natürlich ist das Misstrauen der Verbraucher gegenüber der Hörnatur von intelligenten Lautsprechern im Allgemeinen eine große Überlegung. Mein guter Freund Tom Webster von Edison Research präsentierte seine Daten, die zeigten, dass die Bedenken der Verbraucher in Bezug auf die Privatsphäre intelligenter Lautsprecher im vergangenen Jahr deutlich zugenommen haben.

60 % der Menschen sind besorgt über den Datenschutz und das Potenzial von Hackern, die über intelligente Lautsprecher auf ihre Informationen zugreifen. #voice Zum Tweeten klickenWarum das wichtig ist

Sprachaktivierte Inhalte über intelligente Lautsprecher und andere Geräte sind ein junges, aufstrebendes Gebiet. Die schnelle Akzeptanz dieser Geräte deutet jedoch darauf hin, dass Sprache als Interaktionsökosystem weiter wachsen wird. Wir werden Sie auf dem Laufenden halten, wenn wir sehen, dass sich diese Sprachtrends im Laufe der Zeit entwickeln und verschieben. Wenn wir Ihnen in der Zwischenzeit helfen können, Ihre eigene Herangehensweise an die Stimme zu überdenken, lassen Sie es uns bitte wissen.