SEO 指南:如何设置 Robots.txt 和 Meta Robots 标签

已发表: 2022-09-11虽然大多数 SEO 专家都知道 robots.txt 和 Meta Robots 标签用于管理搜索引擎机器人对网站的访问,但许多人也不知道如何有效地使用它们。 两者都有明显的优势和劣势,关键是要在使用什么和何时使用之间取得平衡。 为了解决这个问题,我们在本文中概述了设置 robots.txt 文件和 Meta Robots 标签的最佳实践。

机器人.txt

Robots.txt 是一个文本文件,它告诉搜索引擎机器人他们可以抓取网站的哪些部分,哪些部分不能。 它是机器人排除协议 (REP) 的一部分,该协议是一组关于机器人如何在互联网上抓取和索引信息的指南。 它可能看起来很复杂且技术性很强,但创建 robots.txt 文件很简单。 让我们开始吧!

以下是一个简单的 robots.txt 文件的示例:

用户代理: *

允许: /

禁止: /谢谢

站点地图: https://www.example.com/sitemap.xml

robots.txt 文件中用于引导机器人的最重要指令是 Allow 和 Disallow。 让我们来看看它们的含义。

句法

User-agent – 指令所针对的用户代理名称在此处指定。

符号 * 表示这些指令适用于所有爬虫。 此参数的其他可能值包括 Googlebot、yandexbot 和 bingbot 等。

允许:此命令告诉 Googlebot 指定的统一资源定位器是可抓取的 (URL)

禁止:此命令会阻止 Googlebot 抓取您指定的网址。

站点地图:此命令用于指定您网站的站点地图 URL。

在这种情况下,User-agent: * 表示该命令集与所有类型的机器人相关。

Allow: / 告诉爬虫他们可以爬取整个网站,除了文件中不允许的页面。 最后,Disallow: /thank-you 告诉 Googlebot 不要抓取任何包含 /thank-you 的网址。

User-agent、Allow 和 Disallow 指令执行 robots.txt 文件的主要功能,即允许和禁止爬虫。

最佳 Robots.txt 实践

以下是您在设置自己的 robots.txt 文件时应遵循的一些专业 SEO 提示。

- 首先,请做好功课并找出您不希望将网站的哪些部分编入索引。 请勿复制或重复使用他人的 robots.txt 文件。

- 确保您的 robots.txt 文件位于您网站的根目录中,以便搜索引擎爬虫可以轻松访问它。

- 因为它区分大小写,所以不要将您的文件称为“robots.txt”以外的任何名称。

- 在 robots.txt 中,始终包含您的站点地图 URL,以便搜索引擎机器人更容易找到您的网站页面。

- Robots.txt 不应用于隐藏私人信息或未来的活动页面。 任何人都可以通过将 /robots.txt 放在您的域名后访问您的 robots.txt 文件,因为它是一个公共文件。 因为任何人都可能看到您要隐藏的页面,所以最好不要使用机器人。

- 为每个根域的子域创建单独的自定义 robots.txt 文件。

- 在您上线之前,请仔细检查您是否没有阻止任何您不想阻止的内容。

- 要发现任何错误并确保您的指令正常运行,请使用 Google 的 robots.txt 测试工具测试和验证您的 robots.txt 文件。

- 为每个根域的子域创建单独的自定义 robots.txt 文件。

- 要发现任何错误并确保您的指令正常运行,请使用 Google 的 robots.txt 测试工具测试和验证您的 robots.txt 文件。

- 不要链接到 robots.txt 文件禁止的任何网站页面。 内部链接将导致 Google 抓取这些页面(如果它们是链接的)。

- 确保您的 robots.txt 文件格式正确。

- 在新行上,应定义每个指令。

- 允许或禁止 URL 时,请记住它们区分大小写。

- 除 * 和 $ 外,不应使用其他特殊字符。

- 为了更清楚,请使用 # 符号。 带有 # 字符的行会被爬虫忽略。

- 您应该使用 robots.txt 文件隐藏哪些页面?

- 分页页面

- 页面查询参数的变化

- 您的帐户或个人资料的页面

- 管理员页面

- 在购物车中

- 感谢页面

- 阻止未从任何位置链接且未使用 robots.txt 编入索引的页面。

- 谈到 robots.txt,网站管理员经常会犯错误。 这些将在另一篇文章中讨论。 检查并远离它们——典型的 robots.txt 错误

机器人标签

robots.txt 文件只是告诉爬虫它可以访问网站的哪些部分。 但是,它不会告诉爬虫它是否可以索引。 为此,您可以使用机器人标签来指导爬虫进行索引和各种其他任务。 Meta Robots 和 X-robots 标签是机器人标签的两种形式。

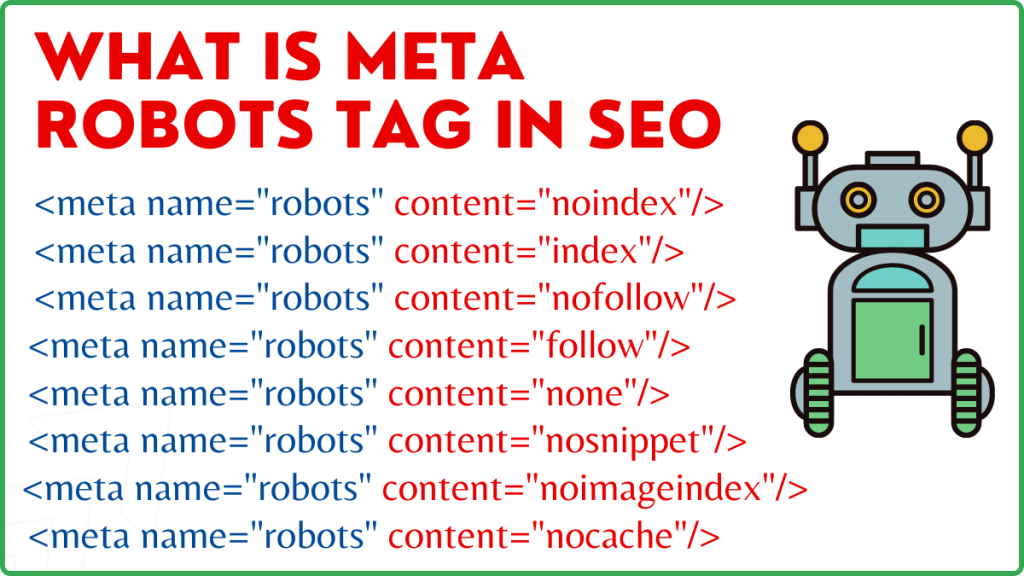

元机器人标签

Meta Robots 标签是一段 HTML 代码,它告诉搜索引擎如何抓取和索引页面。 它位于网页的 head> 部分。 Meta Robots 标签如下所示:

<元名称=”机器人” 内容=”noindex,nofollow”>

名称和内容是 Meta Robots 标签的两个属性。

名称属性

为 name 属性定义的值是机器人的名称,即(Googlebot、MSNbot 等)。 如上例所示,您可以简单地将值定义为 robots,这表明该指令将适用于各种爬行机器人。

内容属性

在内容字段中,您可以定义各种不同类型的值。 content 属性指示爬虫如何爬取和索引页面的内容。 如果没有 robots 元标记,抓取工具会将页面视为索引并默认跟随它。

以下是 content 属性的不同类型的值

- all:这个指令告诉爬虫他们可以爬取和索引他们想要的任何东西。 这与索引的工作方式相同,并遵循说明。

- index:索引指令告诉爬虫他们可以索引页面。 默认情况下会考虑到这一点。 不必将其添加到页面即可对其进行索引。

- noindex:不允许爬虫索引页面。 如果该页面已被索引,则该指令将指示爬虫将其从索引中删除。

- 跟随:指示搜索引擎跟随页面上的所有链接并传递链接权益。

- nofollow:不允许搜索引擎跟踪网站上的链接或传递任何股权。

- none:这类似于 noindex、nofollow 指令。

- noarchive:页面的缓存副本不显示在搜索引擎结果页面 (SERP) 上。

- nocache:此指令类似于 noarchive,但仅 Internet Explorer 和 Firefox 支持。

- nosnippet:页面的扩展描述(也称为元描述)不显示在搜索结果中。

- notranslate – 这会阻止 Google 在 SERP 中提供页面的翻译。

- noimageindex – 这可以防止 Googlebot 抓取网站上的任何图片。

- 不可用_after – 在指定的日期/时间之后,不在搜索结果中显示此页面。 它类似于带有计时器的 noindex 标签。

- max-snippet:此指令允许您指定 Google 应在页面的 SERP 中显示的最大字符数。 以下示例中的字符数将限制为 150 个。

- 例如 - <meta name=”robots” content=”max-snippet:150″/>

- max-video-preview - 将建立视频样本预览的最大秒数。 在下面的例子中,谷歌会显示一个 10 秒的预览——<meta name=”robots” content=”max-video-preview:10″ />

- max-image-preview - 这会指示 Google 应在 SERP 中的页面显示的图像大小。 有三个选项可用。

- 无 – 不显示图像片段。

- 标准 - 将使用默认图像预览

- large – 可能会显示最大的预览

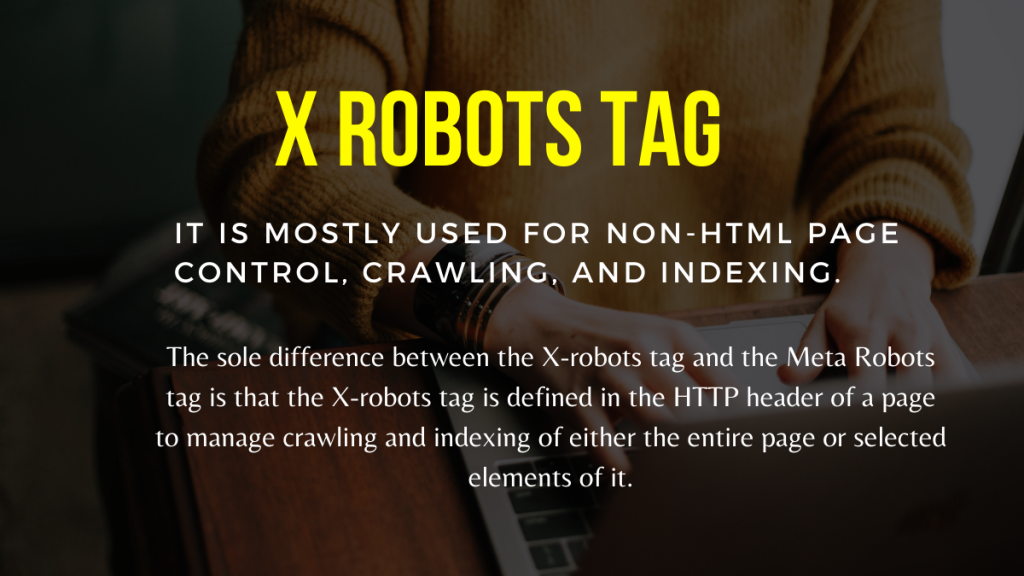

X 机器人标签

只有在页面级别,Meta Robots 标签才能规范爬取和索引。 X-robots 标签和 Meta Robots 标签之间的唯一区别在于,X-robots 标签是在页面的 HTTP 标头中定义的,用于管理整个页面或其中选定元素的抓取和索引。 它主要用于非 HTML 页面控制、爬取和索引。

X-Robots 标签示例

X-robots 标签使用与 Meta Robots 标签相同的指令集,如此屏幕截图所示。 您需要访问 a.htaccess、.php 或服务器配置文件来更改标头,以便使用 X-robots 标记。

机器人的最佳 SEO 实践标签

1) Meta Robots 和 x-robots 不应在同一页面上使用,因为其中一个会变得多余。

2)您可以将 Meta Robots 标记与 noindex 等指令一起使用,如果您不希望您的页面被索引但仍想将链接权益传达给链接页面,请遵循。 这是控制索引的理想方法,而不是使用 robots.txt 阻止索引。

3)要让您的网站被索引,您不需要包含索引或按照每个页面的说明进行操作。 默认情况下将其考虑在内。

4) 如果你的页面被索引,不要使用 robots.txt 来阻止它们,而是使用 Meta Robots。 因为爬虫需要爬取页面才能检查 Meta Robots 标记,而 robots.txt 阻止会阻止它们这样做。 换句话说,您的 Meta Robots 标签将过时。

在这些情况下,请先使用漫游器元标记,然后等待 Google 取消您网站的索引。 在它们被取消索引后,您可以使用 robots.txt 来阻止它们并节省抓取费用。 但是,因为它们可用于将链接公平性传达给您的重要页面,所以应该避免这种情况。 仅在完全无用的情况下使用 robots.txt 禁止取消索引的页面。

5) 使用 X-robots 标签控制对非 HTML 文件的抓取,例如照片、PDF、flash 或视频。

结论

控制网站的抓取和索引需要使用 robots.txt 和 robots 标签。 有几个选项可用于控制蜘蛛如何到达您的网站。 但是,并非所有这些都可以有效地解决您的问题。 例如,如果您希望从索引中删除某些页面,仅在 robots.txt 文件中禁止它们是行不通的。

这里要记住的最重要的事情是弄清楚您的网站需要什么,然后在网站被阻止时选择一个聪明的策略来处理它。 我们希望此建议能帮助您确定最适合您的选择。

您采用什么方法来防止页面被阻止? 请在下面的评论框中分享您的想法。

SEO有用的链接建设资源:

- 2021 年顶级社交书签网站列表

- 2021 年 SEO 的顶级图像提交站点列表

- 文章提交站点列表 2021

- 前 100 名高 DA 目录提交站点列表 2021

- 2021 年最佳新闻稿提交网站

- 2021 年最佳高 DA DoFollow 博客评论网站列表

- 2021年视频提交站点列表

- 2021 年高 DA 商业上市网站列表

- 2021 年高 DA 分类提交站点列表

- 2021 年高 DA 问答网站列表