Guide SEO : Comment définir Robots.txt et Meta Robots Tag

Publié: 2022-09-11Alors que la plupart des spécialistes du référencement savent que robots.txt et la balise Meta Robots sont utilisés pour régir l'accès des robots des moteurs de recherche à un site Web, beaucoup ne savent pas non plus comment les utiliser efficacement. Les deux ont des avantages et des inconvénients distincts, et il est essentiel de trouver un équilibre entre lequel employer et quand. Pour résoudre ce problème, nous avons décrit les meilleures pratiques pour configurer le fichier robots.txt et les balises Meta Robots dans cet article.

Robots.txt

Robots.txt est un fichier texte qui indique aux robots des moteurs de recherche quelles parties du site Web ils peuvent explorer et quelles parties ils ne peuvent pas. Cela fait partie du protocole d'exclusion des robots (REP), qui est un ensemble de directives sur la façon dont les robots peuvent explorer et indexer les informations sur Internet. Cela peut sembler compliqué et technique, mais créer un fichier robots.txt est simple. Commençons!

Voici un exemple de fichier robots.txt simple :

Agent utilisateur : *

Autoriser : /

Interdire : /merci

Plan du site : https://www.example.com/sitemap.xml

Les directives les plus importantes dans un fichier robots.txt pour guider les robots sont Autoriser et Interdire. Voyons ce qu'ils signifient.

Syntaxe

User-agent – Le nom de l'agent utilisateur auquel les directives sont destinées est spécifié ici.

Le symbole * indique que les directives sont destinées à tous les crawlers. D'autres valeurs possibles pour ce paramètre incluent Googlebot, yandexbot et bingbot, entre autres.

Autoriser : cette commande indique à Googlebot que les localisateurs de ressources uniformes spécifiés sont explorables (URL).

Interdire : cette commande empêche Googlebot d'explorer l'URL que vous spécifiez.

Plan du site : cette commande est utilisée pour spécifier l'URL du plan du site de votre site Web.

Dans ce cas, User-agent : * indique que l'ensemble de commandes est pertinent pour TOUS les types de bots.

Autoriser : / indique aux robots d'exploration qu'ils peuvent explorer l'intégralité du site Web, à l'exception des pages qui ne sont pas autorisées dans le fichier. Enfin, Disallow: /thank-you indique à Googlebot de ne pas explorer les URL contenant /thank-you.

Les instructions User-agent, Allow et Disallow exécutent la fonction principale d'un fichier robots.txt, qui est d'autoriser et d'interdire les crawlers.

Meilleures pratiques Robots.txt

Voici quelques conseils pro-SEO que vous devriez suivre lors de la configuration de votre propre fichier robots.txt.

- Tout d'abord, faites vos devoirs et déterminez les parties de votre site Web que vous ne voulez pas indexer. Ne copiez pas et ne réutilisez pas le fichier robots.txt d'une autre personne.

- Assurez-vous que votre fichier robots.txt se trouve dans le répertoire racine de votre site Web afin que les robots des moteurs de recherche puissent y accéder facilement.

- Parce qu'il est sensible à la casse, n'appelez pas votre fichier autrement que "robots.txt".

- Dans robots.txt, incluez toujours l'URL de votre sitemap pour permettre aux robots des moteurs de recherche de trouver plus facilement les pages de votre site Web.

- Robots.txt ne doit pas être utilisé pour masquer des informations privées ou de futures pages d'événements. Toute personne peut accéder à votre fichier robots.txt en mettant simplement /robots.txt après votre nom de domaine car il s'agit d'un fichier public. Étant donné que n'importe qui peut voir les pages que vous souhaitez masquer, il est préférable de ne pas utiliser de robots.

- Créez un fichier robots.txt séparé et personnalisé pour chacun des sous-domaines de votre domaine racine.

- Avant de mettre en ligne, vérifiez que vous ne bloquez rien que vous ne vouliez pas.

- Pour découvrir d'éventuelles erreurs et vous assurer que vos directives fonctionnent, testez et validez votre fichier robots.txt à l'aide de l'outil de test robots.txt de Google.

- Créez un fichier robots.txt séparé et personnalisé pour chacun des sous-domaines de votre domaine racine.

- Pour découvrir d'éventuelles erreurs et vous assurer que vos directives fonctionnent, testez et validez votre fichier robots.txt à l'aide de l'outil de test robots.txt de Google.

- Ne créez aucun lien vers les pages de votre site Web qui sont interdites par le fichier robots.txt. Les liens internes obligeront Google à explorer ces pages si elles sont liées.

- Assurez-vous que votre fichier robots.txt est correctement formaté.

- Sur une nouvelle ligne, chaque directive doit être définie.

- Lorsque vous autorisez ou refusez des URL, gardez à l'esprit qu'elles sont sensibles à la casse.

- À l'exception de * et $, aucun autre caractère spécial ne doit être utilisé.

- Pour plus de clarté, utilisez le symbole #. Les lignes avec le caractère # sont ignorées par les robots.

- Quelles pages devez-vous utiliser le fichier robots.txt pour masquer ?

- Pages pour la pagination

- Variations des paramètres de requête d'une page

- Pages pour votre compte ou profil

- Pages pour les administrateurs

- Dans le panier

- pages de remerciement

- Bloquez les pages qui ne sont liées nulle part et qui ne sont pas indexées avec robots.txt.

- En ce qui concerne robots.txt, les webmasters font souvent des gaffes. Ceux-ci sont discutés dans un article séparé. Vérifiez-le et restez à l'écart d'eux - Erreurs typiques de robots.txt

Balises robots

Un fichier robots.txt indique simplement au robot à quelles parties du site Web il peut accéder. Cependant, il ne dira pas au robot s'il peut indexer ou non. Pour vous aider, vous pouvez utiliser des balises de robots pour instruire les crawlers sur l'indexation et diverses autres tâches. Les balises Meta Robots et X-robots sont les deux formes de balises robot.

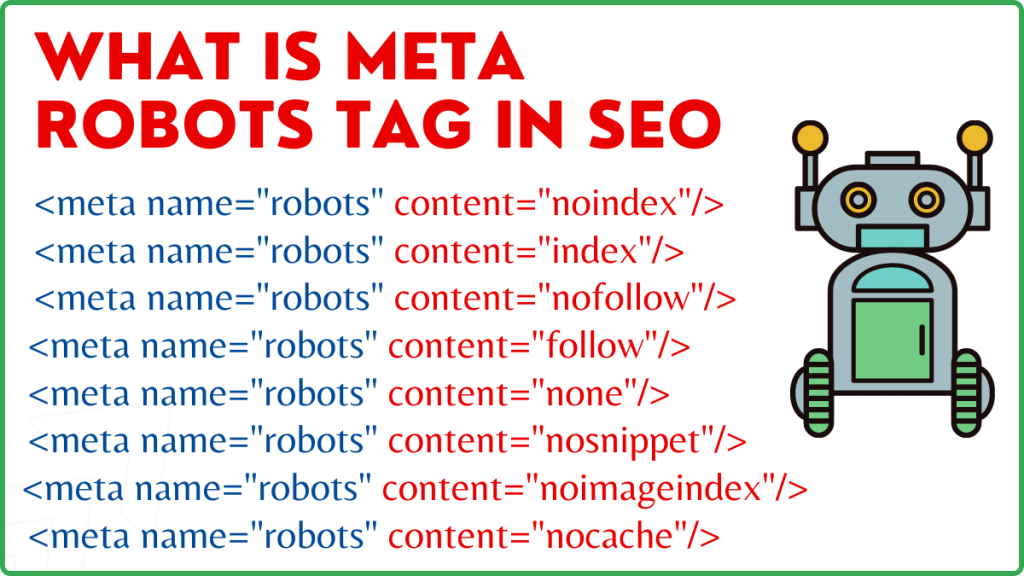

Balise Meta Robots

Une balise Meta Robots est un fragment de code HTML qui indique aux moteurs de recherche comment explorer et indexer une page. Il se trouve dans la section head> d'une page Web. Une balise Meta Robots ressemble à ceci :

<meta name=”robots” content=”noindex,nofollow”>

Le nom et le contenu sont les deux attributs de la balise Meta Robots.

Attribut de nom

Les valeurs définies pour l'attribut name sont les noms des robots, c'est-à-dire (Googlebot, MSNbot, etc.). Comme indiqué dans l'exemple ci-dessus, vous pouvez simplement définir la valeur comme robots, ce qui indique que la directive s'appliquera à toutes sortes de robots rampants.

Attribut de contenu

Dans le champ de contenu, vous pouvez définir différents types de valeurs. L'attribut content indique aux crawlers comment explorer et indexer le contenu de la page. Si aucune balise META robots n'est présente, les crawlers traiteront la page comme un index et la suivront par défaut.

Voici les différents types de valeurs pour l'attribut content

- all : cette directive indique aux crawlers qu'ils peuvent explorer et indexer tout ce qu'ils veulent. Cela fonctionne de la même manière que l'index et suivez les instructions.

- index : la directive index indique aux robots qu'ils peuvent indexer la page. Ceci est pris en compte par défaut. Cela n'a pas besoin d'être ajouté à une page pour qu'elle soit indexée.

- noindex : les robots d'indexation ne sont pas autorisés à indexer la page. Si la page a déjà été indexée, le crawler sera invité à la supprimer de l'index par cette directive.

- suivre : les moteurs de recherche ont pour instruction de suivre tous les liens d'une page et de transmettre l'équité des liens.

- nofollow : les moteurs de recherche ne sont pas autorisés à suivre les liens sur un site Web ni à transmettre d'équité.

- none : Ceci est similaire aux directives noindex, nofollow.

- noarchive : la copie en cache d'une page n'est pas affichée sur la page de résultats du moteur de recherche (SERP).

- nocache : cette directive est similaire à noarchive, mais elle n'est prise en charge que par Internet Explorer et Firefox.

- nosnippet : la description développée de la page (également appelée méta description) n'est pas affichée dans les résultats de la recherche.

- notranslate – Cela empêche Google de fournir une traduction de la page dans le SERP.

- noimageindex - Cela empêche Googlebot d'explorer les images du site Web.

- unavailable_after –Après la date/heure spécifiée, ne pas afficher cette page dans les résultats de la recherche. C'est similaire à une balise noindex avec une minuterie.

- max-snippet : Cette directive vous permet de spécifier le nombre maximum de caractères que Google doit afficher dans le SERP d'une page. Le nombre de caractères dans l'exemple ci-dessous sera limité à 150.

- Par exemple – <meta name="robots" content="max-snippet:150″/>

- max-video-preview – Un nombre maximum de secondes pour un aperçu d'échantillon vidéo sera établi. Dans le cas ci-dessous, Google affichera un aperçu de 10 secondes —– <meta name="robots" content=”max-video-preview:10″ />

- max-image-preview – Cela indique à Google la taille de l'image qu'il doit afficher pour une page dans le SERP. Trois options sont disponibles.

- Aucun - Aucun extrait d'image ne sera affiché.

- standard - L'aperçu d'image par défaut sera utilisé

- large - Le plus grand aperçu possible peut être affiché

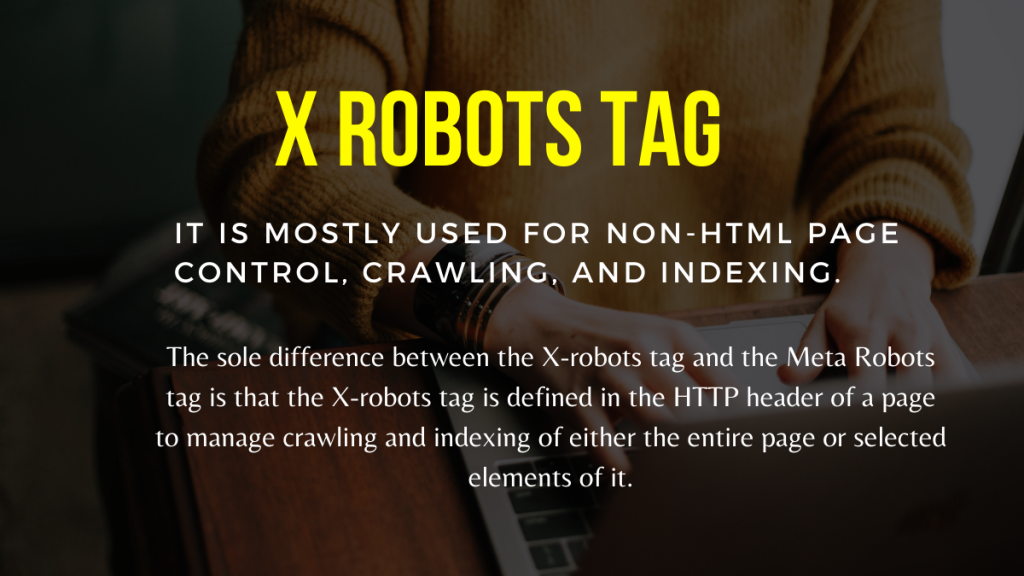

Balise X Robots

Ce n'est qu'au niveau de la page que la balise Meta Robots peut réguler l'exploration et l'indexation. La seule différence entre la balise X-robots et la balise Meta Robots est que la balise X-robots est définie dans l'en-tête HTTP d'une page pour gérer l'exploration et l'indexation de la page entière ou d'éléments sélectionnés de celle-ci. Il est principalement utilisé pour le contrôle, l'exploration et l'indexation des pages non HTML.

Exemple de balise X-Robots

La balise X-robots utilise le même ensemble de directives que la balise Meta Robots, comme illustré dans cette capture d'écran. Vous aurez besoin d'accéder à un fichier de configuration.htaccess,.php ou serveur pour modifier les en-têtes afin d'utiliser la balise X-robots.

Meilleures pratiques de référencement pour les balises robots

1) Les méta-robots et les x-robots ne doivent pas être utilisés sur la même page car l'un d'eux deviendra redondant.

2) Vous pouvez utiliser la balise Meta Robots avec des directives telles que noindex, suivez si vous ne voulez pas que vos pages soient indexées mais que vous souhaitiez toujours transmettre l'équité des liens aux pages liées. Au lieu d'empêcher l'indexation avec robots.txt, c'est la méthode idéale pour contrôler l'indexation.

3) Pour obtenir votre site Web indexé, vous n'avez pas besoin d'inclure l'index ou de suivre les instructions pour chaque page. Il est pris en compte par défaut.

4) Si vos pages sont indexées, n'utilisez pas robots.txt pour les arrêter et utilisez plutôt Meta Robots. Parce que les crawlers doivent explorer la page afin d'examiner la balise Meta Robots, et le blocage de robots.txt les empêche de le faire. En d'autres termes, votre balise Meta Robots sera obsolète.

Dans ces circonstances, utilisez d'abord la balise méta robots, puis attendez que Google désindexe vos sites. Une fois qu'ils ont été désindexés, vous pouvez utiliser robots.txt pour les empêcher et économiser de l'argent sur l'exploration. Cependant, comme ils peuvent être utilisés pour transmettre l'équité des liens vers vos pages vitales, cela devrait être évité. Utilisez uniquement robots.txt pour interdire les pages désindexées si elles sont complètement inutiles.

5) Contrôlez l'exploration de fichiers non HTML tels que des photos, des fichiers PDF, des fichiers flash ou des vidéos avec la balise X-robots.

Conclusion

Le contrôle de l'exploration et de l'indexation de votre site Web nécessite l'utilisation de robots.txt et de balises robots. Il existe plusieurs options pour contrôler la façon dont les araignées accèdent à votre site. Cependant, tous ne seront pas efficaces pour résoudre votre problème. Si vous souhaitez supprimer certaines pages de l'index, par exemple, les interdire simplement dans le fichier robots.txt ne fonctionnera pas.

La chose la plus importante à retenir ici est de déterminer ce dont votre site Web a besoin, puis de choisir une stratégie intelligente pour y faire face lorsque les sites sont bloqués. Nous espérons que ces conseils vous aideront à déterminer la meilleure option pour vous.

Quelle approche utilisez-vous pour empêcher le blocage des pages ? Veuillez partager vos réflexions dans la zone de commentaires ci-dessous.

Ressources de création de liens utiles pour le référencement :

- Liste des meilleurs sites de signets sociaux 2021

- Liste des meilleurs sites de soumission d'images 2021 pour le référencement

- Liste des sites de soumission d'articles 2021

- Liste des 100 meilleurs sites de soumission d'annuaire High DA 2021

- Meilleurs sites de soumission de communiqués de presse pour 2021

- Liste des meilleurs sites de commentaires de blog High DA DoFollow 2021

- Liste des sites de soumission de vidéos en 2021

- Liste des sites d'inscription d'entreprises High DA en 2021

- Liste des sites de soumission classés DA élevés en 2021

- Liste des sites Web de questions et réponses High DA 2021