Guida SEO: come impostare Robots.txt e Meta Robots Tag

Pubblicato: 2022-09-11Mentre la maggior parte degli specialisti SEO è consapevole del fatto che robots.txt e il tag Meta Robots sono utilizzati per governare l'accesso dei bot dei motori di ricerca a un sito Web, molti sono anche ignari di come utilizzarli in modo efficace. Entrambi hanno vantaggi e svantaggi distinti, ed è fondamentale trovare un equilibrio tra quale impiegare e quando. Per risolvere questo problema, in questo articolo abbiamo delineato le migliori pratiche per la configurazione del file robots.txt e dei tag Meta Robots.

Robot.txt

Robots.txt è un file di testo che indica ai robot dei motori di ricerca quali parti del sito Web possono scansionare e quali no. Fa parte del Robots Exclusion Protocol (REP), che è un insieme di linee guida su come i robot possono eseguire la scansione e indicizzare le informazioni su Internet. Può sembrare complicato e tecnico, ma creare un file robots.txt è semplice. Iniziamo!

Quello che segue è un esempio di un semplice file robots.txt:

User-agent: *

Consenti: /

Non consentire: /grazie

Mappa del sito: https://www.example.com/sitemap.xml

Le direttive più significative in un file robots.txt per guidare i robot sono Consenti e Non Consenti. Diamo un'occhiata a cosa significano.

Sintassi

User-agent – Qui viene specificato il nome dell'user agent a cui sono destinate le direttive.

Il simbolo * indica che le direttive sono destinate a tutti i crawler. Altri possibili valori per questo parametro includono Googlebot, yandexbot e bingbot, tra gli altri.

Consenti: questo comando indica a Googlebot che gli Uniform Resource Locator specificati sono scansionabili (URL)

Disallow: questo comando impedisce a Googlebot di eseguire la scansione dell'URL specificato (s).

Mappa del sito: questo comando viene utilizzato per specificare l'URL della mappa del sito del tuo sito web.

In questo caso, User-agent: * indica che l'insieme di comandi è rilevante per TUTTI i tipi di bot.

Consenti: / indica ai crawler che possono eseguire la scansione dell'intero sito Web ad eccezione delle pagine che non sono consentite nel file. Infine, Disallow: /grazie dice a Googlebot di non eseguire la scansione degli URL che includono /grazie.

Le istruzioni User-agent, Consenti e Non consentire svolgono la funzione principale di un file robots.txt, ovvero consentire e vietare i crawler.

Migliori pratiche di Robots.txt

Ecco alcuni suggerimenti pro-SEO che dovresti seguire quando imposti il tuo file robots.txt.

- Prima di tutto, per favore fai i compiti e scopri quali parti del tuo sito web non vuoi indicizzare. Non copiare o riutilizzare il file robots.txt di un'altra persona.

- Assicurati che il tuo file robots.txt si trovi nella directory principale del tuo sito web in modo che i crawler dei motori di ricerca possano accedervi facilmente.

- Poiché fa distinzione tra maiuscole e minuscole, non chiamare il tuo file in modo diverso da "robots.txt".

- In robots.txt, includi sempre l'URL della tua mappa del sito per consentire ai robot dei motori di ricerca di trovare più facilmente le pagine del tuo sito web.

- Robots.txt non deve essere utilizzato per nascondere informazioni private o pagine di eventi futuri. Qualsiasi persona può accedere al tuo file robots.txt semplicemente mettendo /robots.txt dopo il tuo nome di dominio perché è un file pubblico. Poiché chiunque può vedere le pagine che vuoi nascondere, è meglio non utilizzare robot.

- Crea un file robots.txt separato e personalizzato per ciascuno dei sottodomini del tuo dominio principale.

- Prima di andare in diretta, ricontrolla di non bloccare nulla che non desideri.

- Per scoprire eventuali errori e assicurarti che le tue direttive funzionino, verifica e convalida il tuo file robots.txt utilizzando lo strumento di test robots.txt di Google.

- Crea un file robots.txt separato e personalizzato per ciascuno dei sottodomini del tuo dominio principale.

- Per scoprire eventuali errori e assicurarti che le tue direttive funzionino, verifica e convalida il tuo file robots.txt utilizzando lo strumento di test robots.txt di Google.

- Non collegarti a nessuna delle pagine del tuo sito Web vietate dal file robots.txt. I collegamenti interni faranno eseguire a Google la scansione di quelle pagine se sono collegate.

- Assicurati che il tuo file robots.txt sia formattato correttamente.

- Su una nuova linea, ogni direttiva dovrebbe essere definita.

- Quando consenti o non consenti gli URL, tieni presente che fanno distinzione tra maiuscole e minuscole.

- Ad eccezione di * e $, non devono essere utilizzati altri caratteri speciali.

- Per fornire ulteriore chiarezza, utilizzare il simbolo #. Le righe con il carattere # vengono ignorate dai crawler.

- Quali pagine dovresti usare il file robots.txt per nascondere?

- Pagine per l'impaginazione

- Variazioni dei parametri di query di una pagina

- Pagine per il tuo account o profilo

- Pagine per gli amministratori

- Nel carrello

- Grazie pagine

- Blocca le pagine che non sono collegate da nessuna parte e non sono indicizzate con robots.txt.

- Quando si tratta di robots.txt, i webmaster spesso commettono errori. Questi sono discussi in un articolo separato. Dai un'occhiata e stai lontano da loro – Tipici errori di robots.txt

Tag robot

Un file robots.txt indica semplicemente al crawler a quali parti del sito Web può accedere. Tuttavia, non dirà al crawler se può indicizzare o meno. Per aiutarti in questo, puoi utilizzare i tag robots per istruire i crawler sull'indicizzazione e su una varietà di altre attività. I tag Meta Robots e X-robots sono le due forme di tag robot.

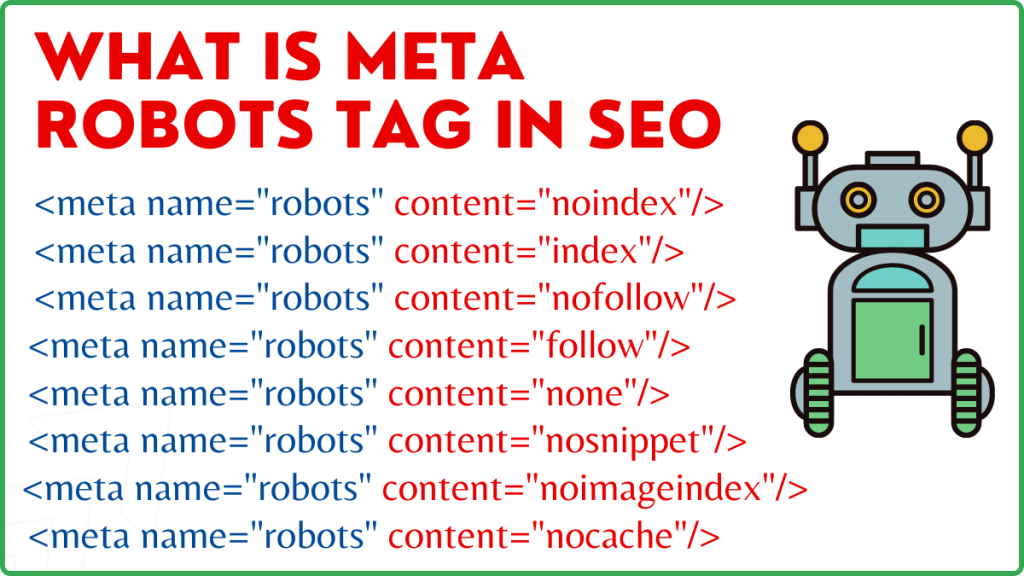

Tag Meta Robot

Un tag Meta Robots è un frammento di codice HTML che indica ai motori di ricerca come eseguire la scansione e l'indicizzazione di una pagina. Si trova nella sezione head> di una pagina web. Un tag Meta Robots ha il seguente aspetto:

<meta name=”robot” content=”noindex,nofollow”>

Nome e contenuto sono i due attributi del tag Meta Robots.

Attributo del nome

I valori definiti per l'attributo name sono i nomi dei robot, ad esempio (Googlebot, MSNbot, ecc.). Come mostrato nell'esempio sopra, puoi semplicemente definire il valore come robot, il che indica che la direttiva si applicherà a tutti i tipi di robot che eseguono la scansione.

Attributo del contenuto

Nel campo del contenuto è possibile definire una varietà di diversi tipi di valori. L'attributo content indica ai crawler come eseguire la scansione e indicizzare il contenuto della pagina. Se non è presente alcun meta tag robots, i crawler tratteranno la pagina come un indice e la seguiranno per impostazione predefinita.

Ecco i diversi tipi di valori per l'attributo content

- all: questa direttiva dice ai crawler che possono eseguire la scansione e indicizzare tutto ciò che vogliono. Funziona allo stesso modo dell'indice e segui le istruzioni.

- index: la direttiva index dice ai crawler che possono indicizzare la pagina. Questo viene preso in considerazione per impostazione predefinita. Non è necessario aggiungerlo a una pagina per indicizzarla.

- noindex: ai crawler non è consentito indicizzare la pagina. Se la pagina è già stata indicizzata, al crawler verrà richiesto di rimuoverla dall'indice da questa direttiva.

- segui: ai motori di ricerca viene richiesto di seguire tutti i collegamenti in una pagina e di passare l'equità del collegamento.

- nofollow: i motori di ricerca non sono autorizzati a seguire i collegamenti su un sito Web o a trasmettere azioni.

- none: è simile alle direttive noindex, nofollow.

- noarchive: la copia cache di una pagina non viene visualizzata nella pagina dei risultati del motore di ricerca (SERP).

- nocache: questa direttiva è simile a noarchive, tuttavia è supportata solo da Internet Explorer e Firefox.

- nosnippet: la descrizione estesa della pagina (nota anche come meta descrizione) non viene visualizzata nei risultati della ricerca.

- notranslate – Ciò impedisce a Google di fornire una traduzione della pagina nella SERP.

- noimageindex – Ciò impedisce a Googlebot di eseguire la scansione di qualsiasi immagine sul sito web.

- unavailable_after –Dopo la data/ora specificata, non mostrare questa pagina nei risultati della ricerca. È simile a un tag noindex con un timer.

- max-snippet: questa direttiva consente di specificare il numero massimo di caratteri che Google dovrebbe mostrare nella SERP di una pagina. La quantità di caratteri nell'esempio seguente sarà limitata a 150.

- Ad esempio – <meta name=”robot” content=”max-snippet:150″/>

- max-video-preview –Verrà stabilito un numero massimo di secondi per l'anteprima di un campione video. Nel caso seguente, Google visualizzerà un'anteprima di 10 secondi —– <meta name=”robots” content=”max-video-preview:10″ />

- max-image-preview – Questo indica a Google la dimensione dell'immagine che dovrebbe visualizzare per una pagina nella SERP. Sono disponibili tre opzioni.

- Nessuno: non verrà visualizzato alcuno snippet di immagine.

- standard – Verrà utilizzata l'anteprima dell'immagine predefinita

- grande – Potrebbe essere visualizzata l'anteprima più grande possibile

Etichetta X Robot

Solo a livello di pagina il tag Meta Robots può regolare la scansione e l'indicizzazione. L'unica differenza tra il tag X-robots e il tag Meta Robots è che il tag X-robots è definito nell'intestazione HTTP di una pagina per gestire la scansione e l'indicizzazione dell'intera pagina o di elementi selezionati di essa. Viene utilizzato principalmente per il controllo, la scansione e l'indicizzazione della pagina non HTML.

Esempio di tag X-Robots

Il tag X-robots utilizza lo stesso insieme di direttive del tag Meta Robots, come mostrato in questa schermata. Avrai bisogno dell'accesso a un file di configurazione.htaccess,.php o server per modificare le intestazioni in modo da utilizzare il tag X-robots.

Migliori pratiche SEO per tag robot

1) Meta Robot e x-robot non devono essere utilizzati nella stessa pagina perché uno di essi diventerà ridondante.

2) Puoi usare il tag Meta Robots con direttive come noindex, segui se non vuoi che le tue pagine siano indicizzate ma vuoi comunque trasmettere link equity alle pagine collegate. Invece di impedire l'indicizzazione con robots.txt, questo è il metodo ideale per controllare l'indicizzazione.

3) Per ottenere l'indicizzazione del tuo sito web, non è necessario includere l'indice o seguire le indicazioni per ciascuna pagina. Viene preso in considerazione per impostazione predefinita.

4) Se le tue pagine sono indicizzate, non utilizzare robots.txt per fermarle e utilizza invece Meta Robots. Perché i crawler devono eseguire la scansione della pagina per esaminare il tag Meta Robots e il blocco di robots.txt impedisce loro di farlo. In altre parole, il tuo tag Meta Robots sarà obsoleto.

In queste circostanze, utilizza prima il meta tag robots e poi attendi che Google deindicizzi i tuoi siti. Dopo che sono stati dei-indicizzati, puoi utilizzare robots.txt per prevenirli e risparmiare denaro durante la scansione. Tuttavia, poiché possono essere utilizzati per trasmettere link equity alle tue pagine vitali, questo dovrebbe essere evitato. Usa robots.txt per vietare le pagine deindicizzate solo se sono completamente inutili.

5) Controlla la scansione di file non HTML come foto, PDF, flash o video con il tag X-robots.

Conclusione

Il controllo della scansione e dell'indicizzazione del tuo sito web richiede l'uso di robots.txt e dei tag robots. Esistono diverse opzioni per controllare il modo in cui gli spider raggiungono il tuo sito. Tuttavia, non tutti saranno efficaci nel risolvere il tuo problema. Ad esempio, se desideri rimuovere alcune pagine dall'indice, non funzionerà semplicemente bannandole nel file robots.txt.

La cosa più importante da ricordare qui è capire cosa richiede il tuo sito Web e quindi scegliere una strategia intelligente per affrontarlo quando i siti sono bloccati. Ci auguriamo che questo consiglio ti aiuti a determinare l'opzione migliore per te.

Quale approccio utilizzi per evitare che le pagine vengano bloccate? Per favore condividi i tuoi pensieri nella casella dei commenti qui sotto.

Risorse utili per la creazione di link SEO:

- Elenco dei migliori siti di social bookmarking 2021

- Elenco dei migliori siti di invio di immagini 2021 per SEO

- Elenco dei siti di presentazione degli articoli 2021

- Elenco dei 100 migliori siti di presentazione di directory ad alto DA 2021

- I migliori siti per la presentazione di comunicati stampa per il 2021

- Miglior elenco di siti di commenti sul blog DoFollow con DA alto 2021

- Elenco dei siti di presentazione video nel 2021

- Elenco di siti di elenchi di attività commerciali ad alto DA nel 2021

- Elenco dei siti di presentazione classificati ad alto DA nel 2021

- Elenco di siti Web di domande e risposte con DA elevato 2021