SEO ガイド: Robots.txt と Meta Robots タグの設定方法

公開: 2022-09-11ほとんどの SEO スペシャリストは、robots.txt と Meta Robots タグが検索エンジン ボットによる Web サイトへのアクセスを制御するために使用されていることを認識していますが、それらを効果的に使用する方法も認識していません。 どちらにも明確な長所と短所があり、どちらを採用するか、いつ採用するかのバランスを取ることが重要です。 この問題に対処するために、この記事では robots.txt ファイルと Meta Robots タグを設定するためのベスト プラクティスを概説しました。

ロボット.txt

robots.txt は、検索エンジン ロボットに、ウェブサイトのどの部分をクロールでき、どの部分をクロールできないかを伝えるテキスト ファイルです。 これは、ロボットがインターネット上の情報をクロールしてインデックスを作成する方法に関する一連のガイドラインである Robots Exclusion Protocol (REP) の一部です。 複雑で技術的に見えるかもしれませんが、robots.txt ファイルの作成は簡単です。 始めましょう!

以下は、単純な robots.txt ファイルの例です。

ユーザーエージェント: *

許可: /

許可しない: /thank-you

サイトマップ: https://www.example.com/sitemap.xml

robots.txt ファイルでロボットを誘導するための最も重要なディレクティブは、Allow と Disallow です。 それらが意味するものを見てみましょう。

構文

ユーザー エージェント– ディレクティブの対象となるユーザー エージェント名をここで指定します。

記号 * は、ディレクティブがすべてのクローラーを対象としていることを示します。 このパラメーターのその他の可能な値には、Googlebot、yandexbot、bingbot などがあります。

許可:このコマンドは、指定された Uniform Resource Locator (URL) がクロール可能であることを Googlebot に伝えます。

Disallow:このコマンドは、指定した URL を Googlebot がクロールしないようにします。

サイトマップ:このコマンドは、Web サイトのサイトマップ URL を指定するために使用されます。

この場合、User-agent: * は、一連のコマンドがすべてのタイプのボットに関連していることを示します。

Allow: / は、ファイルで許可されていないページを除いて、Web サイト全体をクロールできることをクローラーに伝えます。 最後に、Disallow: /thank-you は、/thank-you を含む URL をクロールしないように Googlebot に指示します。

User-agent、Allow、および Disallow 命令は、robots.txt ファイルの主な機能である、クローラーの許可と禁止を実行します。

Robots.txt のベスト プラクティス

独自の robots.txt ファイルを設定する際に従うべき SEO に関するヒントをいくつか紹介します。

- 何よりもまず、下調べをして、インデックスに登録したくないウェブサイトの部分を見つけてください。 他人の robots.txt ファイルをコピーしたり、再利用したりしないでください。

- 検索エンジンのクローラーが簡単にアクセスできるように、robots.txt ファイルが Web サイトのルート ディレクトリにあることを確認してください。

- 大文字と小文字が区別されるため、「robots.txt」以外の名前を付けないでください。

- robots.txt には、常にサイトマップの URL を含めて、検索エンジン ボットがウェブサイトのページを見つけやすくするようにしてください。

- robots.txt を使用して、個人情報や今後のイベント ページを非表示にしないでください。 robots.txt ファイルは公開ファイルであるため、ドメイン名の後に /robots.txt を追加するだけで、誰でもアクセスできます。 非表示にしたいページは誰にでも見られる可能性があるため、ロボットを使用しないことをお勧めします。

- ルート ドメインのサブドメインごとに個別のカスタマイズされた robots.txt ファイルを作成します。

- ライブ配信を開始する前に、不要なものをブロックしていないことを再確認してください。

- 間違いを発見し、ディレクティブが機能していることを確認するには、Google の robots.txt テスト ツールを使用して robots.txt ファイルをテストおよび検証します。

- ルート ドメインのサブドメインごとに個別のカスタマイズされた robots.txt ファイルを作成します。

- 間違いを発見し、ディレクティブが機能していることを確認するには、Google の robots.txt テスト ツールを使用して robots.txt ファイルをテストおよび検証します。

- robots.txt ファイルで禁止されている Web サイトのページにはリンクしないでください。 内部リンクがリンクされている場合、Google はそれらのページをクロールします。

- robots.txt ファイルの形式が正しいことを確認してください。

- 新しい行で、各ディレクティブを定義する必要があります。

- URL を許可または禁止するときは、大文字と小文字が区別されることに注意してください。

- * と $ を除いて、その他の特殊文字は使用しないでください。

- さらに明確にするために、# 記号を使用します。 # 文字を含む行は、クローラーによって無視されます。

- robots.txt ファイルを使用して非表示にするページはどれですか?

- ページネーションのページ

- ページのクエリ パラメータのバリエーション

- アカウントまたはプロフィールのページ

- 管理者向けページ

- 買い物カゴの中

- ありがとうページ

- どこからもリンクされておらず、robots.txt でインデックス化されていないページをブロックします。

- robots.txt に関しては、ウェブマスターはしばしば失敗を犯します。 これらについては、別の記事で説明します。 確認して近づかないようにしてください – 典型的な robots.txt の失敗

ロボット タグ

robots.txt ファイルは、ウェブサイトのどの部分にアクセスできるかをクローラーに伝えるだけです。 ただし、インデックスに登録できるかどうかはクローラーに通知しません。 これを支援するために、ロボット タグを使用して、クローラーにインデックス作成やその他のさまざまなタスクを指示することができます。 Meta Robots タグと X-robots タグは、ロボット タグの 2 つの形式です。

メタロボットタグ

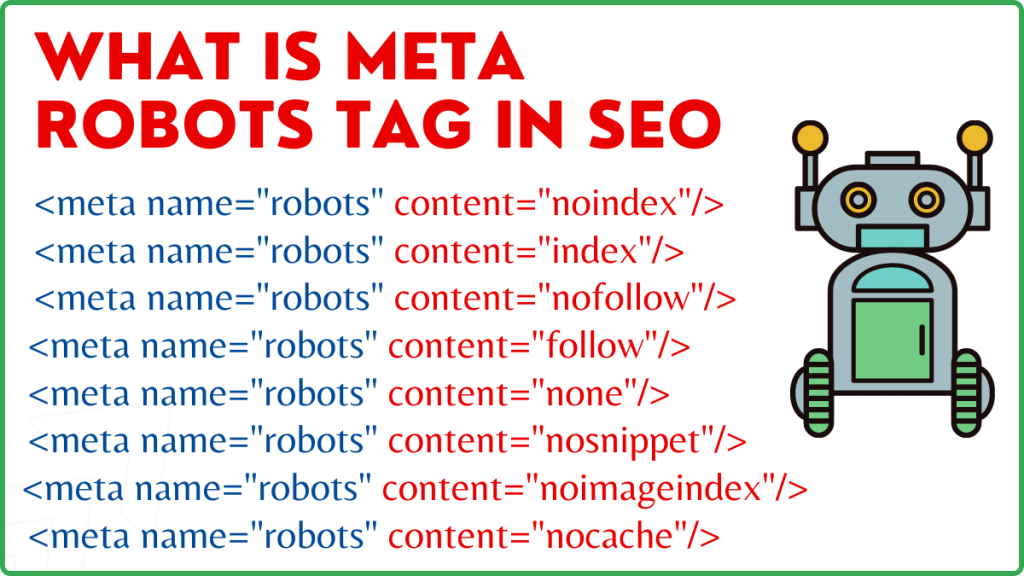

Meta Robots タグは、検索エンジンにページのクロール方法とインデックス作成方法を指示する HTML コードの断片です。 Web ページの head> セクションにあります。 Meta Robots タグは次のようになります。

<meta name="robots" content="noindex,nofollow">

Name と content は、Meta Robots タグの 2 つの属性です。

名前属性

name 属性に定義された値は、ロボットの名前 (Googlebot、MSNbot など) です。 上記の例に示すように、単純に値を robots として定義できます。これは、ディレクティブがあらゆる種類のクローリング ロボットに適用されることを示します。

コンテンツ属性

content フィールドでは、さまざまな種類の値を定義できます。 content 属性は、ページのコンテンツをクロールしてインデックスに登録する方法をクローラーに指示します。 robots メタ タグが存在しない場合、クローラーはページをインデックスとして扱い、デフォルトでそれに従います。

content 属性のさまざまなタイプの値を次に示します。

- all: このディレクティブは、必要なものをすべてクロールしてインデックスに登録できることをクローラーに伝えます。 これは、インデックスとフォローの指示と同じように機能します。

- index: index ディレクティブは、ページをインデックスに登録できることをクローラーに伝えます。 これはデフォルトで考慮されます。 これは、インデックスを作成するためにページに追加する必要はありません。

- noindex: クローラーはページのインデックスを作成できません。 ページがすでにインデックスに登録されている場合、クローラーはこのディレクティブによってインデックスからページを削除するように指示されます。

- follow: 検索エンジンは、ページ上のすべてのリンクをたどり、リンク エクイティを渡すように指示されます。

- nofollow: 検索エンジンは、Web サイトのリンクをたどったり、エクイティを渡したりすることを許可されていません。

- none: これは、noindex、nofollow ディレクティブに似ています。

- noarchive: ページのキャッシュされたコピーは、検索エンジンの結果ページ (SERP) に表示されません。

- nocache: このディレクティブは noarchive に似ていますが、Internet Explorer と Firefox でのみサポートされています。

- nosnippet: ページの拡張説明 (メタ説明とも呼ばれます) は検索結果に表示されません。

- notranslate – これにより、Google は SERP でページの翻訳を提供できなくなります。

- noimageindex – これにより、Googlebot はウェブサイト上の写真をクロールできなくなります。

- available_after – 指定した日時以降、このページを検索結果に表示しません。 タイマー付きの noindex タグに似ています。

- max-snippet: このディレクティブを使用すると、Google がページの SERP に表示する最大文字数を指定できます。 以下のサンプルの文字数は 150 に制限されます。

- 例 – <meta name="robots" content="max-snippet:150"/>

- max-video-preview – ビデオ サンプル プレビューの最大秒数が確立されます。 以下の場合、Google は 10 秒間のプレビューを表示します —– <meta name="robots" content="max-video-preview:10" />

- max-image-preview – SERP のページに表示する画像のサイズを Google に指示します。 3 つのオプションが利用可能です。

- なし – 画像スニペットは表示されません。

- standard – デフォルトの画像プレビューが使用されます

- large – 可能な限り大きなプレビューが表示される場合があります

X ロボット タグ

ページ レベルでのみ、Meta Robots タグがクロールとインデックス作成を規制できます。 X-robots タグと Meta Robots タグの唯一の違いは、X-robots タグがページの HTTP ヘッダーで定義され、ページ全体または選択された要素のクロールとインデックス作成を管理することです。 主に非 HTML ページの制御、クロール、およびインデックス作成に使用されます。

X-Robots タグの例

X-robots タグは、このスクリーンショットに示すように、Meta Robots タグと同じ一連のディレクティブを採用しています。 X-robots タグを使用するには、.htaccess、.php、またはサーバー構成ファイルにアクセスしてヘッダーを変更する必要があります。

ロボットタグのベスト SEO プラクティス

1) メタ ロボットと x-robot を同じページで使用しないでください。一方が冗長になるためです。

2) ページをインデックスに登録したくないが、リンクされたページにリンクの公平性を伝えたい場合は、noindex などのディレクティブで Meta Robots タグを使用できます。 これは、robots.txt でインデックス作成を防止する代わりに、インデックス作成を制御するための理想的な方法です。

3) ウェブサイトをインデックスに登録するには、インデックスを含めたり、各ページへの指示に従う必要はありません。 デフォルトで考慮されます。

4) ページがインデックスに登録されている場合は、robots.txt を使用してページを停止せず、代わりに Meta Robots を利用してください。 クローラーは Meta Robots タグを調べるためにページをクロールする必要がありますが、robots.txt のブロックによりクロールが妨げられます。 つまり、Meta Robots タグは廃止されます。

このような状況では、最初に robots メタ タグを使用してから、Google がサイトのインデックスを解除するのを待ちます。 それらがインデックスから削除された後、robots.txt を使用してそれらを防止し、クロールの費用を節約できます。 ただし、重要なページへのリンクの公平性を伝えるために利用できるため、これは避けるべきです。 完全に役に立たない場合にのみ、robots.txt を使用してインデックスから削除されたページを禁止してください。

5) X-robots タグを使用して、写真、PDF、フラッシュ、ビデオなどの HTML 以外のファイルのクロールを制御します。

結論

Web サイトのクロールとインデックス作成を制御するには、robots.txt と robots タグを使用する必要があります。 スパイダーがサイトに到達する方法を制御するには、いくつかのオプションがあります。 ただし、それらのすべてが問題の解決に効果的であるとは限りません。 たとえば、インデックスからいくつかのページを削除したい場合、robots.txt ファイルでそれらを禁止するだけでは機能しません。

ここで覚えておくべき最も重要なことは、Web サイトが必要とするものを把握し、サイトがブロックされたときにそれに対処するための巧妙な戦略を選択することです。 このアドバイスが、最適なオプションを決定するのに役立つことを願っています。

ページがブロックされないようにするために、どのようなアプローチを採用していますか? 下のコメント欄であなたの考えを共有してください。

SEO に役立つリンク構築リソース:

- トップソーシャルブックマークサイトリスト2021

- SEOのための2021年のトップ画像提出サイトリスト

- 記事投稿サイト一覧 2021

- 上位 100 の高 DA ディレクトリ提出サイト リスト 2021

- 2021 年のベスト プレス リリース提出サイト

- 最高の高 DA DoFollow ブログ コメント サイト リスト 2021

- 2021年の動画投稿サイト一覧

- 2021年のHigh DAビジネスリスティングサイトリスト

- 2021年の高DA分類提出サイトリスト

- 2021年の高DA質疑応答ウェブサイトリスト