Guía SEO: Cómo configurar la etiqueta Robots.txt y Meta Robots

Publicado: 2022-09-11Si bien la mayoría de los especialistas en SEO saben que robots.txt y la etiqueta Meta Robots se utilizan para controlar el acceso de los robots de los motores de búsqueda a un sitio web, muchos tampoco saben cómo usarlos de manera efectiva. Ambos tienen claras ventajas y desventajas, y es fundamental lograr un equilibrio entre cuál emplear y cuándo. Para solucionar este problema, describimos las mejores prácticas para configurar el archivo robots.txt y las etiquetas Meta Robots en este artículo.

Robots.txt

Robots.txt es un archivo de texto que le dice a los robots de los motores de búsqueda qué partes del sitio web pueden rastrear y qué partes no. Es parte del Protocolo de exclusión de robots (REP), que es un conjunto de pautas sobre cómo los robots pueden rastrear e indexar información en Internet. Puede parecer complicado y técnico, pero crear un archivo robots.txt es simple. ¡Empecemos!

El siguiente es un ejemplo de un archivo robots.txt simple:

Usuario-agente: *

Permitir: /

No permitir: /gracias

Mapa del sitio: https://www.example.com/sitemap.xml

Las directivas más importantes en un archivo robots.txt para guiar a los robots son Permitir y No permitir. Echemos un vistazo a lo que significan.

Sintaxis

Agente de usuario: aquí se especifica el nombre del agente de usuario para el que están destinadas las directivas.

El símbolo * indica que las directivas están destinadas a todos los rastreadores. Otros valores posibles para este parámetro incluyen Googlebot, yandexbot y bingbot, entre otros.

Permitir: este comando le dice a Googlebot que los localizadores uniformes de recursos especificados son rastreables (URL)

No permitir: este comando evita que Googlebot rastree la URL que especifique.

Mapa del sitio: este comando se utiliza para especificar la URL del mapa del sitio de su sitio web.

En este caso, User-agent: * indica que el conjunto de comandos es relevante para TODOS los tipos de bots.

Permitir: / les dice a los rastreadores que pueden rastrear todo el sitio web excepto las páginas que no están permitidas en el archivo. Finalmente, Disallow: /thank-you le indica a Googlebot que no rastree ninguna URL que incluya /gracias.

Las instrucciones User-agent, Allow y Disallow llevan a cabo la función principal de un archivo robots.txt, que es permitir y prohibir los rastreadores.

Mejores prácticas de Robots.txt

Estos son algunos consejos profesionales de SEO que debe seguir al configurar su propio archivo robots.txt.

- En primer lugar, haga su tarea y averigüe qué partes de su sitio web no desea indexar. No copie ni reutilice el archivo robots.txt de otra persona.

- Asegúrese de que su archivo robots.txt esté ubicado en el directorio raíz de su sitio web para que los rastreadores de los motores de búsqueda puedan acceder fácilmente a él.

- Debido a que distingue entre mayúsculas y minúsculas, no llame a su archivo de otra manera que no sea "robots.txt".

- En robots.txt, incluya siempre la URL de su mapa del sitio para que a los robots de los motores de búsqueda les resulte más fácil encontrar las páginas de su sitio web.

- Robots.txt no debe usarse para ocultar información privada o páginas de eventos futuros. Cualquier persona puede acceder a su archivo robots.txt simplemente colocando /robots.txt después de su nombre de dominio porque es un archivo público. Debido a que cualquiera puede ver las páginas que desea ocultar, es mejor no emplear robots.

- Cree un archivo robots.txt independiente y personalizado para cada uno de los subdominios de su dominio raíz.

- Antes de comenzar, verifique dos veces que no esté bloqueando nada que no desee.

- Para descubrir cualquier error y asegurarse de que sus directivas funcionen, pruebe y valide su archivo robots.txt con la herramienta de prueba de robots.txt de Google.

- Cree un archivo robots.txt independiente y personalizado para cada uno de los subdominios de su dominio raíz.

- Para descubrir cualquier error y asegurarse de que sus directivas funcionen, pruebe y valide su archivo robots.txt con la herramienta de prueba de robots.txt de Google.

- No enlace a ninguna de las páginas de su sitio web que estén prohibidas por el archivo robots.txt. Los enlaces internos harán que Google rastree esas páginas si están enlazadas.

- Asegúrese de que su archivo robots.txt tenga el formato correcto.

- En una nueva línea, se debe definir cada directiva.

- Al permitir o rechazar las URL, tenga en cuenta que distinguen entre mayúsculas y minúsculas.

- A excepción de * y $, no se deben utilizar otros caracteres especiales.

- Para proporcionar mayor claridad, utilice el símbolo #. Los rastreadores ignoran las líneas con el carácter #.

- ¿Qué páginas debería usar el archivo robots.txt para ocultar?

- Páginas para paginación

- Variaciones de los parámetros de consulta de una página

- Páginas para su cuenta o perfil

- Paginas para administradores

- en el carrito de compras

- páginas de agradecimiento

- Bloquee páginas que no estén vinculadas desde ningún lugar y que no estén indexadas con robots.txt.

- Cuando se trata de robots.txt, los webmasters suelen cometer errores garrafales. Estos se discuten en un artículo separado. Compruébelo y manténgase alejado de ellos: errores típicos de robots.txt

Etiquetas de robots

Un archivo robots.txt simplemente le dice al rastreador a qué partes del sitio web puede acceder. Sin embargo, no le dirá al rastreador si puede indexar o no. Para ayudar con esto, puede emplear etiquetas de robots para instruir a los rastreadores sobre la indexación y una variedad de otras tareas. Las etiquetas Meta Robots y X-robots son las dos formas de etiquetas de robot.

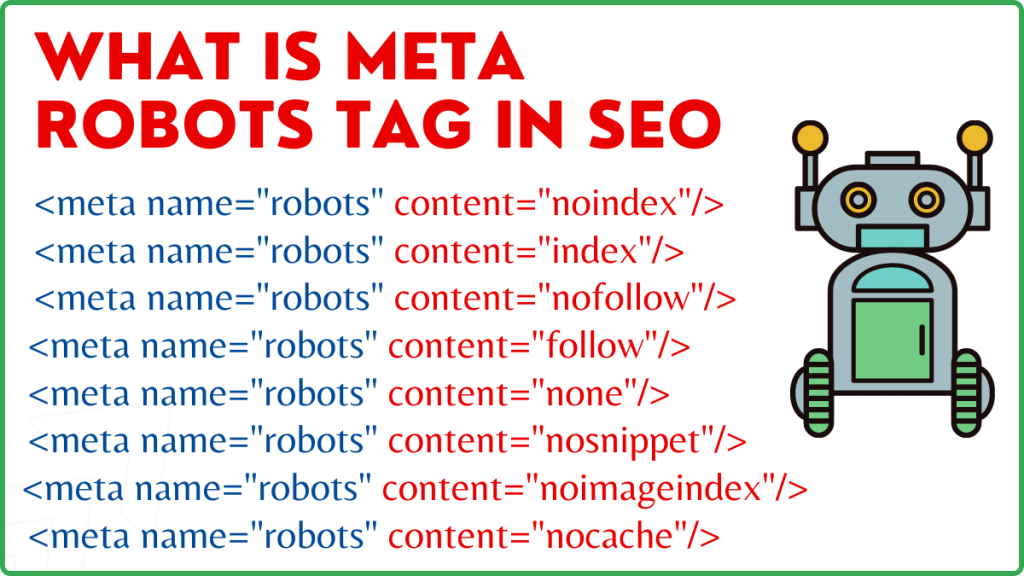

Etiqueta Meta Robots

Una etiqueta de Meta Robots es un fragmento de código HTML que le dice a los motores de búsqueda cómo rastrear e indexar una página. Se encuentra en la sección head> de una página web. Una etiqueta de Meta Robots se ve así:

<meta name=”robots” content=”noindex,nofollow”>

Nombre y contenido son los dos atributos de la etiqueta Meta Robots.

Atributo de nombre

Los valores definidos para el atributo de nombre son los nombres de los robots, es decir (Googlebot, MSNbot, etc.). Como se muestra en el ejemplo anterior, simplemente puede definir el valor como robots, lo que indica que la directiva se aplicará a todo tipo de robots rastreadores.

Atributo de contenido

En el campo de contenido, puede definir una variedad de diferentes tipos de valores. El atributo de contenido indica a los rastreadores cómo rastrear e indexar el contenido de la página. Si no hay una metaetiqueta de robots, los rastreadores tratarán la página como un índice y la seguirán de forma predeterminada.

Estos son los diferentes tipos de valores para el atributo de contenido

- all: esta directiva les dice a los rastreadores que pueden rastrear e indexar lo que quieran. Esto funciona de la misma manera que el índice y sigue las instrucciones.

- índice: la directiva de índice le dice a los rastreadores que pueden indexar la página. Esto se tiene en cuenta de forma predeterminada. Esto no tiene que agregarse a una página para que se indexe.

- noindex: los rastreadores no pueden indexar la página. Si la página ya ha sido indexada, esta directiva le indicará al rastreador que la elimine del índice.

- seguir: los motores de búsqueda tienen instrucciones de seguir todos los enlaces en una página y pasar la equidad del enlace.

- nofollow: los motores de búsqueda no pueden seguir enlaces en un sitio web ni transferir acciones.

- ninguno: Esto es similar a las directivas noindex, nofollow.

- noarchive: la copia en caché de una página no se muestra en la página de resultados del motor de búsqueda (SERP).

- nocache: esta directiva es similar a noarchive, sin embargo, solo es compatible con Internet Explorer y Firefox.

- nosnippet: la descripción ampliada de la página (también conocida como meta descripción) no se muestra en los resultados de búsqueda.

- notranslate: esto evita que Google proporcione una traducción de la página en el SERP.

- noimageindex: esto evita que Googlebot rastree cualquier imagen en el sitio web.

- no disponible_después: después de la fecha/hora especificada, no mostrar esta página en los resultados de búsqueda. Es similar a una etiqueta noindex con un temporizador.

- max-snippet: esta directiva le permite especificar la cantidad máxima de caracteres que Google debe mostrar en el SERP de una página. La cantidad de caracteres en la muestra a continuación estará limitada a 150.

- Por ejemplo: <meta name=”robots” content=”max-snippet:150″/>

- max-video-preview: se establecerá una cantidad máxima de segundos para una vista previa de muestra de video. En el caso a continuación, Google mostrará una vista previa de 10 segundos —– <meta name=”robots” content=”max-video-preview:10″ />

- max-image-preview: esto le indica a Google el tamaño de la imagen que debe mostrar para una página en el SERP. Hay tres opciones disponibles.

- Ninguno: no se mostrará ningún fragmento de imagen.

- estándar: se utilizará la vista previa de la imagen predeterminada

- grande: se puede mostrar la vista previa más grande posible

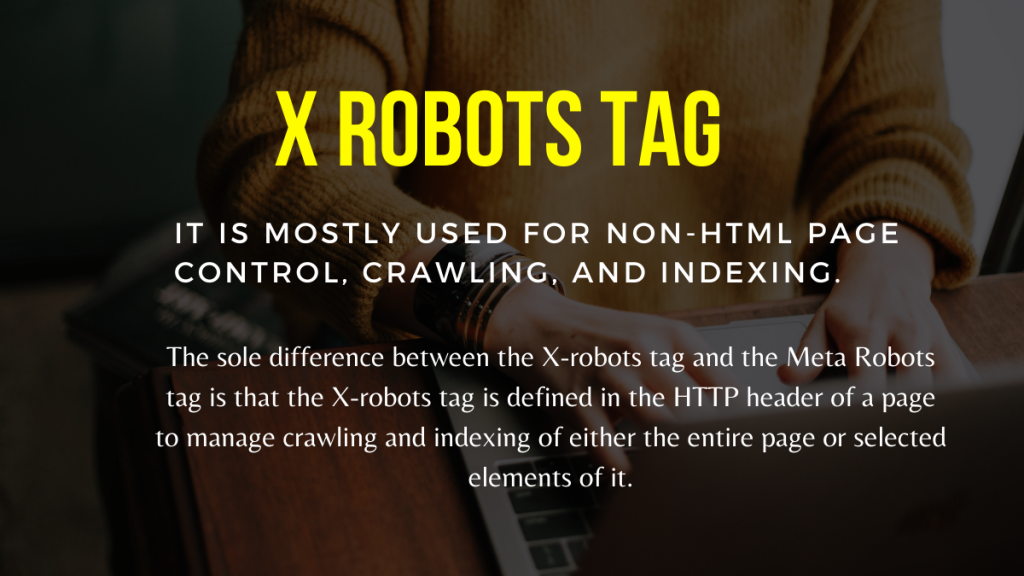

Etiqueta X Robots

Solo a nivel de página, la etiqueta Meta Robots puede regular el rastreo y la indexación. La única diferencia entre la etiqueta X-robots y la etiqueta Meta Robots es que la etiqueta X-robots se define en el encabezado HTTP de una página para gestionar el rastreo y la indexación de la página completa o de elementos seleccionados de la misma. Se utiliza principalmente para el control, el rastreo y la indexación de páginas que no son HTML.

Ejemplo de etiqueta X-Robots

La etiqueta X-robots emplea el mismo conjunto de directivas que la etiqueta Meta Robots, como se muestra en esta captura de pantalla. Necesitará acceso a un.htaccess,.php o al archivo de configuración del servidor para cambiar los encabezados a fin de usar la etiqueta X-robots.

Mejores prácticas de SEO para robots Tags

1) No se deben usar Meta Robots y x-robots en la misma página porque uno de ellos se volverá redundante.

2) Puede usar la etiqueta Meta Robots con directivas como noindex, siga si no desea que sus páginas se indexen pero aún desea transmitir la equidad del enlace a las páginas vinculadas. En lugar de evitar la indexación con robots.txt, este es el método ideal para controlar la indexación.

3) Para indexar su sitio web, no necesita incluir un índice o seguir las instrucciones para llegar a cada página. Se tiene en cuenta por defecto.

4) Si sus páginas están indexadas, no use robots.txt para detenerlas y, en su lugar, utilice Meta Robots. Porque los rastreadores necesitan rastrear la página para examinar la etiqueta Meta Robots, y el bloqueo de robots.txt les impide hacerlo. En otras palabras, su etiqueta Meta Robots quedará obsoleta.

En estas circunstancias, utilice primero la metaetiqueta de robots y luego espere a que Google desindexe sus sitios. Después de que se hayan desindexado, puede usar robots.txt para evitarlos y ahorrar dinero en el rastreo. Sin embargo, debido a que pueden utilizarse para transmitir equidad de enlace a sus páginas vitales, esto debe evitarse. Solo use robots.txt para prohibir las páginas desindexadas si son completamente inútiles.

5) Controle el rastreo de archivos que no sean HTML, como fotos, PDF, flash o video con la etiqueta X-robots.

Conclusión

Controlar el rastreo y la indexación de su sitio web requiere el uso de robots.txt y etiquetas de robots. Hay varias opciones para controlar cómo las arañas llegan a su sitio. Sin embargo, no todos serán efectivos para resolver su problema. Si desea eliminar algunas páginas del índice, por ejemplo, simplemente prohibirlas en el archivo robots.txt no funcionará.

Lo más importante que debe recordar aquí es averiguar qué requiere su sitio web y luego elegir una estrategia inteligente para lidiar con eso cuando los sitios están bloqueados. Esperamos que este consejo le ayude a determinar la mejor opción para usted.

¿Qué enfoque emplean para evitar que se bloqueen las páginas? Por favor, comparta sus pensamientos en el cuadro de comentarios a continuación.

Recursos útiles de construcción de enlaces SEO:

- Lista de los mejores sitios de marcadores sociales 2021

- Lista de los principales sitios de envío de imágenes 2021 para SEO

- Lista de sitios de envío de artículos 2021

- Lista de los 100 principales sitios de envío de directorios de alta DA 2021

- Los mejores sitios de envío de comunicados de prensa para 2021

- La mejor lista de sitios de comentarios de blog DoFollow de alta DA 2021

- Lista de sitios de envío de videos en 2021

- Lista de sitios de listado de negocios de alto DA en 2021

- Lista de sitios de envío clasificados de alta DA en 2021

- Lista de sitios web de preguntas y respuestas de alta DA 2021