คู่มือ SEO: วิธีตั้งค่า Robots.txt & Meta Robots Tag

เผยแพร่แล้ว: 2022-09-11แม้ว่าผู้เชี่ยวชาญด้าน SEO ส่วนใหญ่ทราบดีว่า robots.txt และแท็ก Meta Robots ใช้เพื่อควบคุมการเข้าถึงบอทของเครื่องมือค้นหาไปยังเว็บไซต์ แต่หลายคนก็ไม่ทราบวิธีใช้งานอย่างมีประสิทธิภาพ ทั้งสองมีข้อดีและข้อเสียที่แตกต่างกัน และสิ่งสำคัญคือต้องสร้างสมดุลระหว่างสิ่งที่จะจ้างและเวลา เพื่อแก้ไขปัญหานี้ เราได้สรุปแนวทางปฏิบัติที่ดีที่สุดสำหรับการตั้งค่าไฟล์ robots.txt และแท็ก Meta Robots ในบทความนี้

Robots.txt

Robots.txt เป็นไฟล์ข้อความที่บอกโรบ็อตของเครื่องมือค้นหาว่าส่วนใดของเว็บไซต์ที่พวกเขาสามารถรวบรวมข้อมูลได้และส่วนใดที่พวกเขาไม่สามารถ เป็นส่วนหนึ่งของ Robots Exclusion Protocol (REP) ซึ่งเป็นชุดแนวทางสำหรับวิธีที่หุ่นยนต์สามารถรวบรวมข้อมูลและจัดทำดัชนีข้อมูลบนอินเทอร์เน็ต อาจดูซับซ้อนและเป็นเรื่องทางเทคนิค แต่การสร้างไฟล์ robots.txt นั้นง่ายมาก มาเริ่มกันเลย!

ต่อไปนี้คือตัวอย่างไฟล์ robots.txt อย่างง่าย:

ตัวแทนผู้ใช้: *

อนุญาต: /

ไม่อนุญาต: / ขอบคุณ

แผนผังเว็บไซต์: https://www.example.com/sitemap.xml

คำสั่งที่สำคัญที่สุดในไฟล์ robots.txt สำหรับหุ่นยนต์นำทางคือ อนุญาต และ ไม่อนุญาต เรามาดูกันว่าพวกเขามีความหมายอย่างไร

ไวยากรณ์

User-agent – ชื่อตัวแทนผู้ใช้ที่มีการกำหนดคำสั่งไว้ที่นี่

สัญลักษณ์ * แสดงว่าคำสั่งมีไว้สำหรับโปรแกรมรวบรวมข้อมูลทั้งหมด ค่าที่เป็นไปได้อื่นๆ สำหรับพารามิเตอร์นี้ ได้แก่ Googlebot, yandexbot และ bingbot เป็นต้น

อนุญาต: คำสั่งนี้บอก Googlebot ว่า Uniform Resource Locators ที่ระบุสามารถรวบรวมข้อมูลได้ (URL)

ไม่อนุญาต: คำสั่งนี้ป้องกันไม่ให้ Googlebot รวบรวมข้อมูล URL ที่คุณระบุ

แผนผังเว็บไซต์: คำสั่งนี้ใช้เพื่อระบุ URL แผนผังเว็บไซต์ของเว็บไซต์ของคุณ

ในกรณีนี้ User-agent: * แสดงว่าชุดคำสั่งเกี่ยวข้องกับบอททุกประเภท

อนุญาต: / บอกโปรแกรมรวบรวมข้อมูลว่าสามารถรวบรวมข้อมูลเว็บไซต์ทั้งหมดได้ ยกเว้นหน้าที่ไม่ได้รับอนุญาตในไฟล์ สุดท้าย Disallow: /thank-you บอก Googlebot ไม่ให้รวบรวมข้อมูล URL ใดๆ ที่มี /thank-you

คำแนะนำ User-agent, Allow และ Disallow จะทำหน้าที่หลักของไฟล์ robots.txt ซึ่งก็คืออนุญาตและห้ามโปรแกรมรวบรวมข้อมูล

แนวทางปฏิบัติที่ดีที่สุดของ Robots.txt

ต่อไปนี้เป็นเคล็ดลับ pro-SEO ที่คุณควรปฏิบัติตามเมื่อตั้งค่าไฟล์ robots.txt ของคุณเอง

- ก่อนอื่น โปรดทำการบ้านและหาว่าส่วนใดของเว็บไซต์ของคุณที่คุณไม่ต้องการทำดัชนี ห้ามคัดลอกหรือนำไฟล์ robots.txt ของบุคคลอื่นมาใช้ซ้ำ

- ตรวจสอบให้แน่ใจว่าไฟล์ robots.txt ของคุณอยู่ในไดเรกทอรีรากของเว็บไซต์ของคุณ เพื่อให้โปรแกรมรวบรวมข้อมูลของเครื่องมือค้นหาสามารถเข้าถึงได้โดยง่าย

- เนื่องจากเป็นกรณีเล็ก ๆ อย่าเรียกไฟล์ของคุณอย่างอื่นนอกจาก “robots.txt”

- ใน robots.txt ให้ใส่ URL แผนผังเว็บไซต์เสมอเพื่อให้บอทของเครื่องมือค้นหาค้นหาหน้าเว็บไซต์ของคุณได้ง่ายขึ้น

- ไม่ควรใช้ Robots.txt เพื่อซ่อนข้อมูลส่วนตัวหรือหน้ากิจกรรมในอนาคต บุคคลใดก็ตามสามารถเข้าถึงไฟล์ robots.txt ของคุณได้โดยเพียงแค่ใส่ /robots.txt หลังชื่อโดเมนของคุณ เนื่องจากเป็นไฟล์สาธารณะ เนื่องจากทุกคนอาจเห็นหน้าที่คุณต้องการซ่อน จึงเป็นการดีที่สุดที่จะไม่ใช้หุ่นยนต์

- สร้างไฟล์ robots.txt แยกต่างหากและปรับแต่งสำหรับโดเมนย่อยของโดเมนรากแต่ละโดเมน

- ก่อนที่คุณจะถ่ายทอดสด ให้ตรวจสอบอีกครั้งว่าคุณไม่ได้บล็อกสิ่งที่คุณไม่ต้องการ

- หากต้องการค้นหาข้อผิดพลาดและตรวจสอบว่าคำสั่งของคุณทำงานอยู่ ให้ทดสอบและตรวจสอบไฟล์ robots.txt ของคุณโดยใช้เครื่องมือทดสอบ robots.txt ของ Google

- สร้างไฟล์ robots.txt แยกต่างหากและปรับแต่งสำหรับโดเมนย่อยของโดเมนรากแต่ละโดเมน

- หากต้องการค้นหาข้อผิดพลาดและตรวจสอบว่าคำสั่งของคุณทำงานอยู่ ให้ทดสอบและตรวจสอบไฟล์ robots.txt ของคุณโดยใช้เครื่องมือทดสอบ robots.txt ของ Google

- ห้ามเชื่อมโยงไปยังหน้าใดๆ ของเว็บไซต์ของคุณที่ไฟล์ robots.txt ไม่อนุญาต ลิงก์ภายในจะทำให้ Google รวบรวมข้อมูลหน้าเหล่านั้นหากมีการเชื่อมโยง

- ตรวจสอบให้แน่ใจว่าไฟล์ robots.txt ของคุณอยู่ในรูปแบบที่ถูกต้อง

- ในบรรทัดใหม่ ควรกำหนดแต่ละคำสั่ง

- เมื่ออนุญาตหรือไม่อนุญาต URL ให้คำนึงถึงตัวพิมพ์เล็กและตัวพิมพ์ใหญ่

- ยกเว้น * และ $ ไม่ควรใช้อักขระพิเศษอื่น ๆ

- เพื่อความชัดเจนยิ่งขึ้น ให้ใช้สัญลักษณ์ # บรรทัดที่มีอักขระ # จะถูกละเว้นโดยโปรแกรมรวบรวมข้อมูล

- คุณควรใช้ไฟล์ robots.txt เพื่อซ่อนหน้าใด

- หน้าสำหรับการแบ่งหน้า

- ตัวแปรของพารามิเตอร์การค้นหาของหน้า

- หน้าสำหรับบัญชีหรือโปรไฟล์ของคุณ

- เพจสำหรับผู้ดูแลระบบ

- ในตะกร้าสินค้า

- ขอบคุณเพจ

- บล็อกหน้าที่ไม่ได้ลิงก์จากทุกที่และไม่ได้จัดทำดัชนีด้วย robots.txt

- เมื่อพูดถึง robots.txt ผู้ดูแลเว็บมักทำผิดพลาด เหล่านี้จะกล่าวถึงในบทความแยกต่างหาก ลองดูและอยู่ห่างจากพวกเขา – ข้อผิดพลาดทั่วไปของ robots.txt

แท็กหุ่นยนต์

ไฟล์ robots.txt เพียงบอกโปรแกรมรวบรวมข้อมูลว่าสามารถเข้าถึงส่วนใดของเว็บไซต์ได้ อย่างไรก็ตาม มันจะไม่บอกโปรแกรมรวบรวมข้อมูลว่าสามารถสร้างดัชนีได้หรือไม่ เพื่อช่วยในเรื่องนี้ คุณอาจใช้แท็กโรบ็อตเพื่อสั่งโปรแกรมรวบรวมข้อมูลในการจัดทำดัชนีและงานอื่นๆ ที่หลากหลาย แท็ก Meta Robots และ X-robots เป็นแท็กหุ่นยนต์สองรูปแบบ

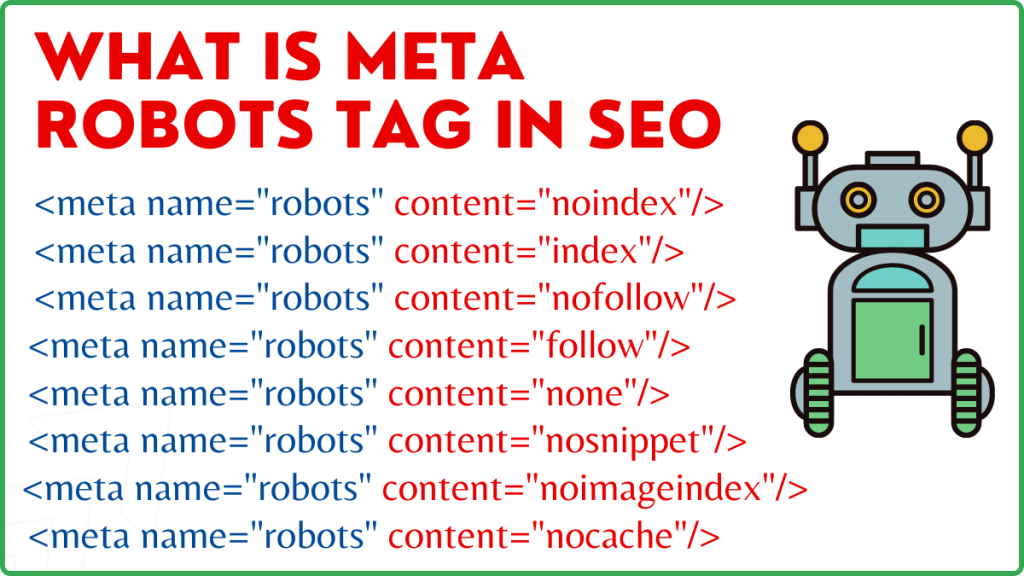

แท็ก Meta Robots

แท็ก Meta Robots คือส่วนย่อยของโค้ด HTML ที่บอกให้เครื่องมือค้นหาทราบถึงวิธีการรวบรวมข้อมูลและจัดทำดัชนีหน้าเว็บ พบได้ในส่วน head> ของหน้าเว็บ แท็ก Meta Robots มีลักษณะดังนี้:

<ชื่อเมตา=”หุ่นยนต์”เนื้อหา=”noindex,nofollow”>

ชื่อและเนื้อหาเป็นคุณลักษณะสองประการของแท็ก Meta Robots

แอตทริบิวต์ชื่อ

ค่าที่กำหนดไว้สำหรับแอตทริบิวต์ชื่อคือชื่อของโรบ็อต เช่น (Googlebot, MSNbot เป็นต้น) ดังที่แสดงในตัวอย่างข้างต้น คุณสามารถกำหนดค่าเป็นหุ่นยนต์ ซึ่งบ่งชี้ว่าคำสั่งจะนำไปใช้กับหุ่นยนต์รวบรวมข้อมูลทุกประเภท

แอตทริบิวต์เนื้อหา

ในฟิลด์เนื้อหา คุณสามารถกำหนดค่าประเภทต่างๆ ได้หลากหลาย แอตทริบิวต์เนื้อหาแนะนำโปรแกรมรวบรวมข้อมูลเกี่ยวกับวิธีการรวบรวมข้อมูลและจัดทำดัชนีเนื้อหาของหน้า หากไม่มีเมตาแท็กของโรบ็อต โปรแกรมรวบรวมข้อมูลจะถือว่าหน้านั้นเป็นดัชนีและติดตามโดยค่าเริ่มต้น

ค่าประเภทต่าง ๆ สำหรับแอตทริบิวต์เนื้อหา

- ทั้งหมด: คำสั่งนี้บอกโปรแกรมรวบรวมข้อมูลว่าสามารถรวบรวมข้อมูลและจัดทำดัชนีอะไรก็ได้ที่ต้องการ ทำงานในลักษณะเดียวกับดัชนีและปฏิบัติตามคำแนะนำ

- ดัชนี: คำสั่งดัชนีบอกโปรแกรมรวบรวมข้อมูลว่าสามารถจัดทำดัชนีหน้าเว็บได้ สิ่งนี้ถูกนำมาพิจารณาโดยค่าเริ่มต้น ไม่จำเป็นต้องเพิ่มข้อมูลนี้ในหน้าเพื่อจัดทำดัชนี

- noindex: ไม่อนุญาตให้โปรแกรมรวบรวมข้อมูลจัดทำดัชนีหน้า หากหน้าได้รับการจัดทำดัชนีแล้ว โปรแกรมรวบรวมข้อมูลจะได้รับคำแนะนำให้ลบออกจากดัชนีโดยคำสั่งนี้

- ติดตาม: เครื่องมือค้นหาได้รับคำสั่งให้ติดตามลิงก์ทั้งหมดบนหน้าเว็บและส่งผ่านส่วนของลิงก์

- nofollow: เครื่องมือค้นหาไม่ได้รับอนุญาตให้ติดตามลิงก์บนเว็บไซต์หรือส่งผ่านส่วนทุนใดๆ

- none: สิ่งนี้คล้ายกับ noindex, nofollow directives

- noarchive: สำเนาแคชของหน้าไม่แสดงบนหน้าผลลัพธ์ของเครื่องมือค้นหา (SERP)

- nocache: คำสั่งนี้คล้ายกับ noarchive แต่ได้รับการสนับสนุนโดย Internet Explorer และ Firefox เท่านั้น

- nosnippet: คำอธิบายแบบขยายของหน้า (หรือที่เรียกว่าคำอธิบายเมตา) จะไม่แสดงในผลการค้นหา

- notranslate – สิ่งนี้จะป้องกันไม่ให้ Google ให้บริการแปลหน้าใน SERP

- noimageindex – สิ่งนี้จะป้องกันไม่ให้ Googlebot รวบรวมข้อมูลรูปภาพใด ๆ บนเว็บไซต์

- ไม่พร้อมใช้งาน_หลังจากวันที่/เวลาที่ระบุ ไม่ต้องแสดงหน้านี้ในผลการค้นหา คล้ายกับแท็ก noindex ที่มีตัวจับเวลา

- max-snippet: คำสั่งนี้อนุญาตให้คุณระบุจำนวนอักขระสูงสุดที่ Google ควรแสดงใน SERP ของหน้า จำนวนอักขระในตัวอย่างด้านล่างจะจำกัดไว้ที่ 150 ตัว

- เช่น – <meta name=”robots” content=”max-snippet:150″/>

- max-video-preview – จำนวนวินาทีสูงสุดสำหรับตัวอย่างวิดีโอจะถูกสร้างขึ้น ในกรณีด้านล่าง Google จะแสดงตัวอย่าง 10 วินาที —– <meta name=”robots” content=”max-video-preview:10″ />

- max-image-preview – สิ่งนี้จะแนะนำ Google เกี่ยวกับขนาดของรูปภาพที่ควรแสดงสำหรับหน้าใน SERP มีสามตัวเลือกให้เลือก

- ไม่มี – จะไม่มีการแสดงตัวอย่างรูปภาพ

- มาตรฐาน – จะใช้การแสดงตัวอย่างรูปภาพเริ่มต้น

- ใหญ่ – อาจแสดงตัวอย่างที่ใหญ่ที่สุดเท่าที่จะเป็นไปได้

X Robots แท็ก

แท็ก Meta Robots ที่ระดับหน้าเว็บเท่านั้นที่จะควบคุมการรวบรวมข้อมูลและการจัดทำดัชนี ความแตกต่างเพียงอย่างเดียวระหว่างแท็ก X-robots และแท็ก Meta Robots คือแท็ก X-robots ถูกกำหนดไว้ในส่วนหัว HTTP ของหน้าเพื่อจัดการการรวบรวมข้อมูลและการจัดทำดัชนีของทั้งหน้าหรือองค์ประกอบที่เลือกไว้ ส่วนใหญ่จะใช้สำหรับการควบคุมหน้าที่ไม่ใช่ HTML การรวบรวมข้อมูลและการจัดทำดัชนี

ตัวอย่างแท็ก X-Robots

แท็ก X-robots ใช้ชุดคำสั่งเดียวกันกับแท็ก Meta Robots ดังที่แสดงในภาพหน้าจอนี้ คุณจะต้องเข้าถึงไฟล์การกำหนดค่า a.htaccess,.php หรือเซิร์ฟเวอร์เพื่อเปลี่ยนส่วนหัวเพื่อใช้แท็ก X-robots

แนวทางปฏิบัติ SEO ที่ดีที่สุดสำหรับ Robots Tags

1) ไม่ควรใช้ Meta Robots และ x-robots ในหน้าเดียวกัน เพราะตัวใดตัวหนึ่งจะกลายเป็นส่วนซ้ำซ้อน

2) คุณสามารถใช้แท็ก Meta Robots ที่มีคำสั่งเช่น noindex ปฏิบัติตามหากคุณไม่ต้องการให้หน้าเว็บของคุณได้รับการจัดทำดัชนี แต่ยังต้องการถ่ายทอดส่วนเชื่อมโยงไปยังหน้าที่เชื่อมโยง แทนที่จะป้องกันการจัดทำดัชนีด้วย robots.txt วิธีนี้เป็นวิธีที่เหมาะสำหรับการควบคุมการจัดทำดัชนี

3) ในการจัดทำดัชนีเว็บไซต์ของคุณ คุณไม่จำเป็นต้องรวมดัชนีหรือปฏิบัติตามคำแนะนำในแต่ละหน้า มันถูกนำมาพิจารณาโดยค่าเริ่มต้น

4) หากหน้าเว็บของคุณได้รับการจัดทำดัชนี อย่าใช้ robots.txt เพื่อหยุดพวกเขา และใช้ Meta Robots แทน เนื่องจากโปรแกรมรวบรวมข้อมูลจำเป็นต้องรวบรวมข้อมูลหน้าเพื่อตรวจสอบแท็ก Meta Robots และการบล็อก robots.txt ป้องกันไม่ให้ทำเช่นนั้น กล่าวอีกนัยหนึ่ง แท็ก Meta Robots ของคุณจะล้าสมัย

ในกรณีเหล่านี้ ให้ใช้เมตาแท็กของโรบ็อตก่อน จากนั้นรอให้ Google ยกเลิกการจัดทำดัชนีไซต์ของคุณ หลังจากที่ยกเลิกการสร้างดัชนีแล้ว คุณสามารถใช้ robots.txt เพื่อป้องกันและประหยัดเงินในการรวบรวมข้อมูล อย่างไรก็ตาม เนื่องจากสามารถใช้เพื่อถ่ายทอดส่วนลิงก์ไปยังหน้าสำคัญของคุณได้ คุณควรหลีกเลี่ยงสิ่งนี้ ใช้เฉพาะ robots.txt เพื่อห้ามหน้าที่ยกเลิกการจัดทำดัชนีหากไร้ประโยชน์โดยสิ้นเชิง

5) ควบคุมการรวบรวมข้อมูลไฟล์ที่ไม่ใช่ HTML เช่น รูปภาพ ไฟล์ PDF แฟลช หรือวิดีโอด้วยแท็ก X-robots

บทสรุป

การควบคุมการรวบรวมข้อมูลและการจัดทำดัชนีเว็บไซต์ของคุณต้องใช้ robots.txt และแท็ก robots มีหลายตัวเลือกในการควบคุมวิธีที่สไปเดอร์เข้าถึงไซต์ของคุณ อย่างไรก็ตาม ไม่ใช่ว่าทั้งหมดจะมีประสิทธิภาพในการแก้ไขปัญหาของคุณ หากคุณต้องการลบบางหน้าออกจากดัชนี ตัวอย่างเช่น เพียงแค่แบนหน้านั้นในไฟล์ robots.txt จะไม่ทำงาน

สิ่งสำคัญที่สุดที่ต้องจำไว้คือต้องค้นหาว่าเว็บไซต์ของคุณต้องการอะไร แล้วเลือกกลยุทธ์ที่ชาญฉลาดเพื่อจัดการกับมันเมื่อเว็บไซต์ถูกบล็อก เราหวังว่าคำแนะนำนี้จะช่วยคุณในการกำหนดตัวเลือกที่ดีที่สุดสำหรับคุณ

คุณใช้แนวทางใดในการป้องกันไม่ให้เพจถูกบล็อก กรุณาแบ่งปันความคิดของคุณในช่องแสดงความคิดเห็นด้านล่าง

แหล่งข้อมูลการสร้างลิงก์ที่มีประโยชน์ของ SEO:

- รายชื่อเว็บไซต์บุ๊กมาร์กโซเชียลยอดนิยม 2021

- รายชื่อไซต์ส่งรูปภาพยอดนิยม 2021 สำหรับ SEO

- รายชื่อเว็บไซต์ส่งบทความ 2021

- รายชื่อไซต์ส่งไดเรกทอรี DA สูง 100 อันดับแรก 2021

- ไซต์ส่งข่าวประชาสัมพันธ์ที่ดีที่สุดสำหรับปี 2021

- รายชื่อเว็บไซต์แสดงความคิดเห็นบล็อก DoFollow สูง DA ที่ดีที่สุด 2021

- รายชื่อไซต์ส่งวิดีโอในปี 2021

- รายชื่อเว็บไซต์รายชื่อธุรกิจ DA สูงในปี 2021

- รายชื่อไซต์ที่มีการจัดหมวดหมู่ DA สูงในปี 2564

- รายชื่อเว็บไซต์คำถามและคำตอบ DA สูง 2021