Ghid SEO: Cum să setați eticheta Robots.txt și Meta Robots

Publicat: 2022-09-11În timp ce majoritatea specialiștilor SEO sunt conștienți de faptul că robots.txt și eticheta Meta Robots sunt folosite pentru a guverna accesul botului motorului de căutare la un site web, mulți nu știu cum să le folosească eficient. Ambele au avantaje și dezavantaje distincte și este esențial să găsiți un echilibru între care să angajați și când. Pentru a rezolva această problemă, am subliniat cele mai bune practici pentru configurarea fișierului robots.txt și a etichetelor Meta Robots în acest articol.

Robots.txt

Robots.txt este un fișier text care le spune roboților motoarelor de căutare ce părți ale site-ului pot accesa cu crawlere și ce părți nu pot. Face parte din Robots Exclusion Protocol (REP), care este un set de linii directoare despre modul în care roboții pot accesa cu crawlere și indexează informațiile pe internet. Poate părea complicat și tehnic, dar crearea unui fișier robots.txt este simplă. Să începem!

Următorul este un exemplu de fișier robots.txt simplu:

Agent utilizator: *

Permite: /

Nu permite: /mulțumesc

Harta site-ului: https://www.example.com/sitemap.xml

Cele mai semnificative directive dintr-un fișier robots.txt pentru ghidarea roboților sunt Allow și Disallow. Să aruncăm o privire la ce înseamnă ele.

Sintaxă

User-agent – Numele agentului utilizator pentru care sunt destinate directivele este specificat aici.

Simbolul * indică faptul că directivele sunt destinate tuturor crawlerelor. Alte valori posibile pentru acest parametru includ Googlebot, yandexbot și bingbot, printre altele.

Permite: această comandă îi spune lui Googlebot că localizatorii uniforme de resurse specificate pot fi accesate cu crawlere (URL-uri)

Disallow: această comandă împiedică Googlebot să acceseze cu crawlere adresa URL pe care o specificați(e).

Sitemap: această comandă este utilizată pentru a specifica adresa URL a Sitemap-ului site-ului dvs. web.

În acest caz, User-agent: * indică faptul că setul de comenzi este relevant pentru TOATE tipurile de roboți.

Permite: / le spune crawlerilor că pot accesa cu crawlere întregul site web, cu excepția paginilor care nu sunt permise în fișier. În cele din urmă, Disallow: /thank-you îi spune lui Googlebot să nu acceseze cu crawlere nicio adresă URL care include /thank-you.

Instrucțiunile User-agent, Allow și Disallow îndeplinesc funcția principală a unui fișier robots.txt, care este de a permite și de a interzice crawlerele.

Cele mai bune practici Robots.txt

Iată câteva sfaturi pro-SEO pe care ar trebui să le urmați atunci când vă configurați propriul fișier robots.txt.

- În primul rând, vă rugăm să vă faceți temele și să vă dați seama ce părți ale site-ului dvs. nu doriți să fie indexate. Nu copiați și nu reutilizați fișierul robots.txt al altei persoane.

- Asigurați-vă că fișierul robots.txt se află în directorul rădăcină al site-ului dvs. web, astfel încât crawlerele motoarelor de căutare să îl poată accesa cu ușurință.

- Deoarece este sensibil la majuscule și minuscule, nu vă numiți fișierul altceva decât „robots.txt”.

- În robots.txt, includeți întotdeauna adresa URL a hărții dvs. de site, pentru a facilita găsirea paginilor site-ului dvs. de către roboții motoarelor de căutare.

- Robots.txt nu trebuie utilizat pentru a ascunde informații private sau pagini de evenimente viitoare. Orice persoană poate accesa fișierul dvs. robots.txt punând pur și simplu /robots.txt după numele domeniului dvs., deoarece este un fișier public. Pentru că oricine poate vedea paginile pe care doriți să le ascundeți, cel mai bine este să nu folosiți roboți.

- Creați un fișier robots.txt separat și personalizat pentru fiecare dintre subdomeniile domeniului dvs. rădăcină.

- Înainte de a intra în direct, verificați din nou dacă nu blocați nimic din ceea ce nu doriți.

- Pentru a descoperi orice greșeală și a vă asigura că directivele dvs. funcționează, testați și validați fișierul robots.txt folosind instrumentul de testare robots.txt de la Google.

- Creați un fișier robots.txt separat și personalizat pentru fiecare dintre subdomeniile domeniului dvs. rădăcină.

- Pentru a descoperi orice greșeală și a vă asigura că directivele dvs. funcționează, testați și validați fișierul robots.txt folosind instrumentul de testare robots.txt de la Google.

- Nu creați linkuri către niciuna dintre paginile site-ului dvs. web care sunt interzise de fișierul robots.txt. Link-urile interne vor face ca Google să acceseze cu crawlere acele pagini dacă acestea sunt legate.

- Asigurați-vă că fișierul robots.txt este formatat corect.

- Pe o linie nouă, fiecare directivă ar trebui definită.

- Când permiteți sau interziceți adresele URL, rețineți că acestea țin cont de majuscule și minuscule.

- Cu excepția * și $, nu trebuie folosite alte caractere speciale.

- Pentru a oferi mai multă claritate, utilizați simbolul #. Liniile cu caracterul # sunt ignorate de crawlerele.

- Ce pagini ar trebui să utilizați fișierul robots.txt pentru a ascunde?

- Pagini pentru paginare

- Variații ale parametrilor de interogare ai unei pagini

- Pagini pentru contul sau profilul dvs

- Pagini pentru administratori

- În coșul de cumpărături

- Va multumesc pagini

- Blocați paginile care nu sunt conectate de nicăieri și nu sunt indexate cu robots.txt.

- Când vine vorba de robots.txt, webmasterii fac adesea gafe. Acestea sunt discutate într-un articol separat. Verifică și stai departe de ei – gafe tipice robots.txt

Etichete roboți

Un fișier robots.txt spune doar crawler-ului ce părți ale site-ului poate accesa. Cu toate acestea, nu va spune crawler-ului dacă poate sau nu indexa. Pentru a ajuta acest lucru, puteți folosi etichete roboți pentru a instrui crawler-ii cu privire la indexare și o varietate de alte sarcini. Etichetele Meta Robots și X-robots sunt cele două forme de etichete robot.

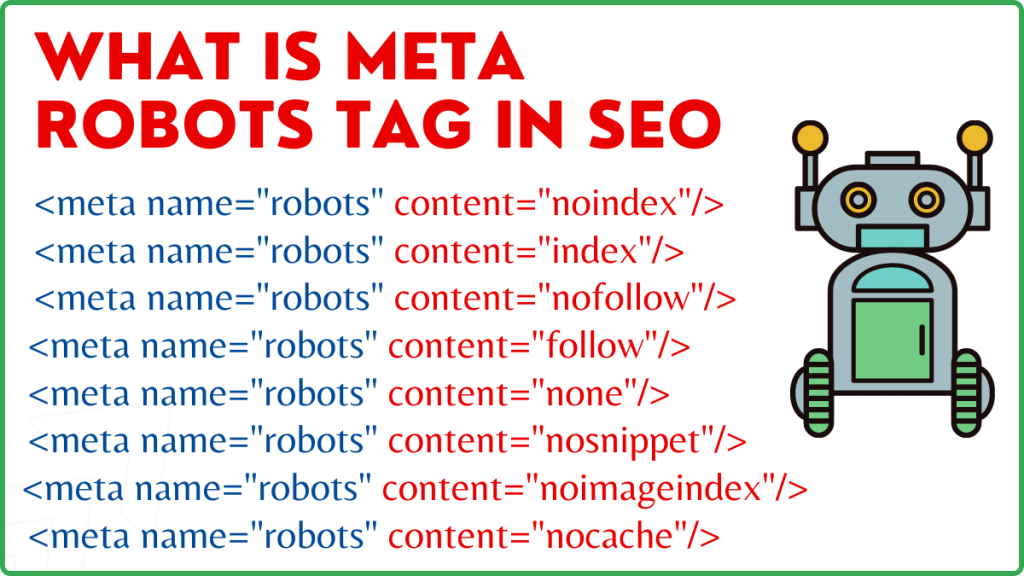

Etichetă Meta Robots

O etichetă Meta Robots este un fragment de cod HTML care le spune motoarelor de căutare cum să acceseze cu crawlere și să indexeze o pagină. Se găsește în secțiunea head> a unei pagini web. O etichetă Meta Robots arată astfel:

<meta name="roboți” conținut="noindex,nofollow”>

Numele și conținutul sunt cele două atribute ale etichetei Meta Robots.

Atributul numelui

Valorile definite pentru atributul name sunt numele roboților, adică (Googlebot, MSNbot etc.). După cum se arată în exemplul de mai sus, puteți defini pur și simplu valoarea ca roboți, ceea ce indică faptul că directiva se va aplica tuturor tipurilor de roboți cu crawlere.

Atribut de conținut

În câmpul de conținut, puteți defini o varietate de tipuri diferite de valori. Atributul de conținut îi instruiește pe crawlere despre cum să acceseze cu crawlere și să indexeze conținutul paginii. Dacă nu este prezentă metaetichetă roboți, crawlerele vor trata pagina ca pe un index și o vor urma în mod implicit.

Iată diferitele tipuri de valori pentru atributul conținut

- all: Această directivă le spune crawlerilor că pot accesa cu crawlere și indexează orice doresc. Acesta funcționează în același mod ca și indexul și urmează instrucțiunile.

- index: Directiva index le spune crawlerilor că pot indexa pagina. Acest lucru este luat în considerare în mod implicit. Acest lucru nu trebuie adăugat la o pagină pentru a putea fi indexat.

- noindex: crawlerele nu au voie să indexeze pagina. Dacă pagina a fost deja indexată, crawler-ul va fi instruit să o elimine din index prin această directivă.

- urmați: motoarele de căutare sunt instruite să urmărească toate linkurile dintr-o pagină și să transmită link-uri.

- nofollow: motoarelor de căutare nu le este permis să urmărească link-uri de pe un site web sau să transmită nicio acțiune.

- none: este similar cu directivele noindex, nofollow.

- noarchive: copia stocată în cache a unei pagini nu este afișată pe pagina de rezultate ale motorului de căutare (SERP).

- nocache: Această directivă este similară cu noarchive, totuși este acceptată doar de Internet Explorer și Firefox.

- nosnippet: descrierea extinsă a paginii (cunoscută și ca meta descriere) nu este afișată în rezultatele căutării.

- notranslate – Acest lucru împiedică Google să furnizeze o traducere a paginii în SERP.

- noimageindex – Acest lucru împiedică Googlebot să acceseze cu crawlere orice imagini de pe site.

- unavailable_after – După data/ora specificate, nu afișați această pagină în rezultatele căutării. Este similar cu o etichetă noindex cu un cronometru.

- max-snippet: Această directivă vă permite să specificați numărul maxim de caractere pe care Google ar trebui să le afișeze în SERP-ul unei pagini. Numărul de caractere din eșantionul de mai jos va fi limitat la 150.

- De exemplu, <meta name="roboți” conținut="max-snippet:150″/>

- max-video-preview – Se va stabili o cantitate maximă de secunde pentru previzualizarea unui eșantion video. În cazul de mai jos, Google va afișa o previzualizare de 10 secunde —– <meta name="robots” content="max-video-preview:10″ />

- max-image-preview – Acest lucru informează Google cu privire la dimensiunea imaginii pe care ar trebui să o afișeze pentru o pagină din SERP. Există trei opțiuni disponibile.

- Niciunul – Nu va fi afișat niciun fragment de imagine.

- standard – Se va utiliza previzualizarea implicită a imaginii

- mare – poate fi afișată cea mai mare previzualizare posibilă

Eticheta X Robots

Numai la nivel de pagină eticheta Meta Robots poate reglementa accesarea cu crawlere și indexarea. Singura diferență dintre eticheta X-robots și eticheta Meta Robots este că eticheta X-robots este definită în antetul HTTP al unei pagini pentru a gestiona accesarea cu crawlere și indexarea fie a întregii pagini, fie a elementelor selectate ale acesteia. Este folosit mai ales pentru controlul paginilor non-HTML, accesarea cu crawlere și indexare.

Exemplu de etichetă X-Robots

Eticheta X-roboți folosește același set de directive ca eticheta Meta Robots, așa cum se arată în această captură de ecran. Veți avea nevoie de acces la fișierul de configurare a.htaccess,.php sau server pentru a schimba antetele pentru a utiliza eticheta X-robots.

Cele mai bune practici SEO pentru etichete roboți

1) Meta-roboții și x-roboții nu trebuie folosiți pe aceeași pagină, deoarece unul dintre ei va deveni redundant.

2) Puteți folosi eticheta Meta Robots cu directive precum noindex, urmați dacă nu doriți ca paginile dvs. să fie indexate, dar doriți totuși să transmiteți echitatea link-urilor către paginile legate. În loc să împiedici indexarea cu robots.txt, aceasta este metoda ideală pentru controlul indexării.

3) Pentru a vă indexa site-ul web, nu trebuie să includeți index sau să urmați instrucțiunile către fiecare pagină. Este luat în considerare implicit.

4) Dacă paginile dvs. sunt indexate, nu utilizați robots.txt pentru a le opri și utilizați Meta Robots. Deoarece crawlerele trebuie să acceseze cu crawlere pagina pentru a examina eticheta Meta Robots, iar blocarea robots.txt îi împiedică să facă acest lucru. Cu alte cuvinte, eticheta dvs. Meta Robots va fi învechită.

În aceste circumstanțe, utilizați mai întâi metaeticheta robots și apoi așteptați ca Google să vă deindexeze site-urile. După ce au fost de-indexate, puteți utiliza robots.txt pentru a le preveni și a economisi bani la accesarea cu crawlere. Cu toate acestea, deoarece acestea pot fi utilizate pentru a transmite echitatea link-urilor către paginile dvs. vitale, acest lucru ar trebui evitat. Folosiți robots.txt pentru a interzice paginile de-indexate numai dacă sunt complet inutile.

5) Controlați accesarea cu crawlere a fișierelor non-HTML, cum ar fi fotografii, PDF-uri, flash sau videoclipuri cu eticheta X-robots.

Concluzie

Controlul accesării cu crawlere și indexării site-ului dvs. web necesită utilizarea robots.txt și a etichetelor robots. Există mai multe opțiuni pentru a controla modul în care păianjenii ajung pe site-ul dvs. Cu toate acestea, nu toate vor fi eficiente în rezolvarea problemei dvs. Dacă doriți să eliminați unele pagini din index, de exemplu, interzicerea lor în fișierul robots.txt nu va funcționa.

Cel mai important lucru de reținut aici este să vă dați seama ce necesită site-ul dvs. și apoi să alegeți o strategie inteligentă pentru a face față situației atunci când site-urile sunt blocate. Sperăm că acest sfat vă va ajuta să determinați cea mai bună opțiune pentru dvs.

Ce abordare folosiți pentru a preveni blocarea paginilor? Vă rugăm să vă împărtășiți gândurile în caseta de comentarii de mai jos.

Resurse utile pentru crearea de linkuri SEO:

- Topul site-urilor de marcaje sociale din 2021

- Topul site-urilor de trimitere a imaginilor din 2021 pentru SEO

- Lista site-urilor pentru trimiterea articolelor 2021

- Top 100 de site-uri de trimitere a directoarelor de top DA în 2021

- Cele mai bune site-uri de transmitere a comunicatelor de presă pentru 2021

- Cele mai bune liste de site-uri de comentarii pentru bloguri DA DoFollow 2021

- Lista site-urilor pentru trimiterea videoclipurilor în 2021

- Lista de site-uri cu înregistrări de companii cu DA înaltă în 2021

- Lista de site-uri de depunere cu clasa DA înaltă în 2021

- Lista de site-uri web cu întrebări și răspunsuri ridicate 2021