Przewodnik SEO: Jak ustawić Robots.txt i Meta Robots Tag

Opublikowany: 2022-09-11Podczas gdy większość specjalistów SEO zdaje sobie sprawę, że plik robots.txt i tag Meta Robots są używane do kontrolowania dostępu botów wyszukiwarki do witryny, wielu nie wie, jak skutecznie z nich korzystać. Oba mają wyraźne zalety i wady, dlatego bardzo ważne jest znalezienie równowagi między tym, co zastosować i kiedy. Aby rozwiązać ten problem, w tym artykule omówiliśmy sprawdzone metody konfigurowania pliku robots.txt i tagów Meta Robots.

Robots.txt

Robots.txt to plik tekstowy, który informuje roboty wyszukiwarek, które części witryny mogą zaindeksować, a które nie. Jest to część protokołu Robots Exclusion Protocol (REP), czyli zestawu wytycznych dotyczących sposobu, w jaki roboty mogą przeszukiwać i indeksować informacje w Internecie. Może się to wydawać skomplikowane i techniczne, ale utworzenie pliku robots.txt jest proste. Zacznijmy!

Oto przykład prostego pliku robots.txt:

Klient użytkownika: *

Zezwól: /

Odrzuć: /dziękuję

Mapa witryny: https://www.example.com/sitemap.xml

Najważniejsze dyrektywy w pliku robots.txt dotyczące kierowania robotami to Allow i Disallow. Przyjrzyjmy się, co one oznaczają.

Składnia

User-agent — w tym miejscu określa się nazwę agenta użytkownika, dla którego przeznaczone są dyrektywy.

Symbol * oznacza, że dyrektywy są przeznaczone dla wszystkich przeszukiwaczy. Inne możliwe wartości tego parametru to między innymi Googlebot, yandexbot i bingbot.

Zezwól: to polecenie informuje Googlebota, że określone jednolite lokalizatory zasobów są indeksowalne (adresy URL)

Disallow: to polecenie uniemożliwia Googlebotowi indeksowanie określonych adresów URL.

Mapa witryny: to polecenie służy do określenia adresu URL mapy witryny witryny.

W tym przypadku User-agent: * oznacza, że zestaw poleceń dotyczy WSZYSTKICH typów botów.

Zezwól: / informuje roboty indeksujące, że mogą indeksować całą witrynę z wyjątkiem stron, które nie są dozwolone w pliku. Na koniec polecenie Disallow: /thank-you informuje Googlebota, aby nie indeksował żadnych adresów URL zawierających /thank-you.

Instrukcje User-agent, Allow i Disallow pełnią podstawową funkcję pliku robots.txt, czyli zezwalanie na roboty indeksujące i ich blokowanie.

Najlepsze praktyki dotyczące pliku Robots.txt

Oto kilka wskazówek pro-SEO, których należy przestrzegać podczas konfigurowania własnego pliku robots.txt.

- Przede wszystkim odrób pracę domową i dowiedz się, których części witryny nie chcesz indeksować. Nie kopiuj ani nie używaj ponownie pliku robots.txt innej osoby.

- Upewnij się, że plik robots.txt znajduje się w katalogu głównym witryny, aby roboty indeksujące wyszukiwarki miały do niego łatwy dostęp.

- Ponieważ wielkość liter jest rozróżniana, nie nazywaj swojego pliku inaczej niż „robots.txt”.

- W pliku robots.txt zawsze dołączaj adres URL mapy witryny, aby ułatwić robotom wyszukiwarek znalezienie stron Twojej witryny.

- Pliku robots.txt nie należy używać do ukrywania prywatnych informacji ani stron przyszłych wydarzeń. Każda osoba może uzyskać dostęp do Twojego pliku robots.txt, umieszczając /robots.txt po nazwie domeny, ponieważ jest to plik publiczny. Ponieważ każdy może zobaczyć strony, które chcesz ukryć, najlepiej nie zatrudniać robotów.

- Utwórz osobny i dostosowany plik robots.txt dla każdej z subdomen domeny głównej.

- Zanim rozpoczniesz transmisję na żywo, upewnij się, że nie blokujesz niczego, czego nie chcesz.

- Aby wykryć ewentualne błędy i upewnić się, że instrukcje działają, przetestuj i zweryfikuj plik robots.txt za pomocą narzędzia Google do testowania robots.txt.

- Utwórz osobny i dostosowany plik robots.txt dla każdej z subdomen domeny głównej.

- Aby wykryć ewentualne błędy i upewnić się, że instrukcje działają, przetestuj i zweryfikuj plik robots.txt za pomocą narzędzia Google do testowania robots.txt.

- Nie umieszczaj linków do żadnych stron witryny, które są zabronione przez plik robots.txt. Linki wewnętrzne spowodują, że Google zaindeksuje te strony, jeśli są połączone.

- Upewnij się, że plik robots.txt jest poprawnie sformatowany.

- W nowym wierszu należy zdefiniować każdą dyrektywę.

- Przy zezwalaniu lub blokowaniu adresów URL pamiętaj, że rozróżniana jest wielkość liter.

- Z wyjątkiem * i $ nie należy używać żadnych innych znaków specjalnych.

- Aby zapewnić większą przejrzystość, użyj symbolu #. Wiersze ze znakiem # są ignorowane przez roboty.

- Jakie strony należy ukryć w pliku robots.txt?

- Strony do paginacji

- Odmiany parametrów zapytania strony

- Strony dla Twojego konta lub profilu

- Strony dla administratorów

- W koszyku

- Dziękuję strony

- Blokuj strony, do których nie ma linków z dowolnego miejsca i które nie są zindeksowane za pomocą pliku robots.txt.

- Jeśli chodzi o plik robots.txt, webmasterzy często popełniają błędy. Zostały one omówione w osobnym artykule. Sprawdź to i trzymaj się od nich z daleka – typowe błędy w pliku robots.txt

Roboty Tagi

Plik robots.txt informuje robota indeksującego, do których części witryny może uzyskać dostęp. Nie poinformuje jednak robota indeksującego, czy może indeksować. Aby w tym pomóc, możesz użyć tagów robotów, aby poinstruować roboty indeksujące o indeksowaniu i wielu innych zadaniach. Tagi Meta Robots i X-robots to dwie formy tagów robotów.

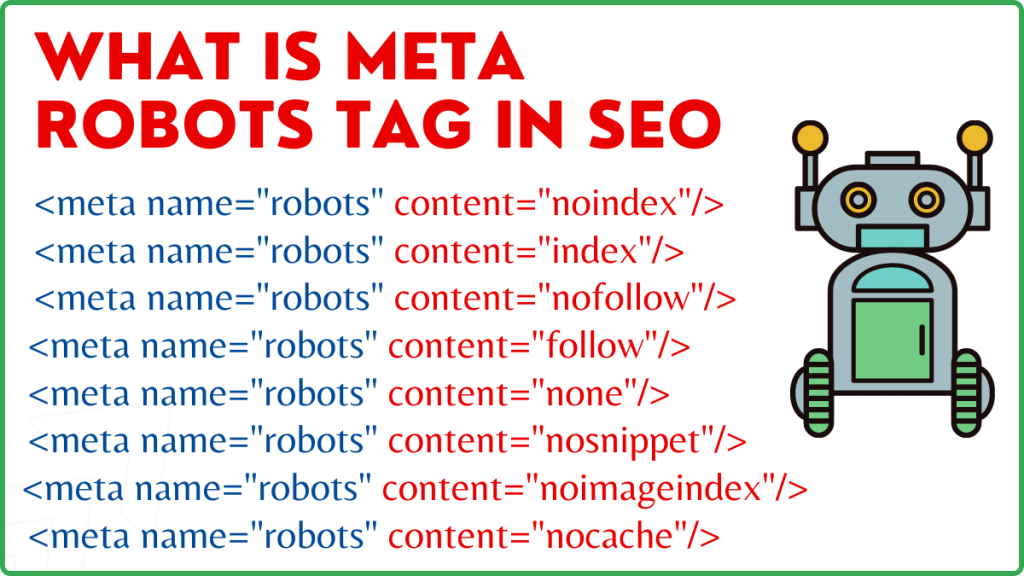

Znacznik Meta Robots

Znacznik Meta Robots to fragment kodu HTML, który informuje wyszukiwarki, jak przeszukiwać i indeksować stronę. Znajduje się w sekcji head> strony internetowej. Tag Meta Robots wygląda tak:

<nazwa meta=”robots” content=”noindex,nofollow”>

Nazwa i zawartość to dwa atrybuty znacznika Meta Robots.

Atrybut nazwy

Wartości zdefiniowane dla atrybutu name to nazwy robotów, tj. (Googlebot, MSNbot itp.). Jak pokazano w powyższym przykładzie, możesz po prostu zdefiniować wartość jako roboty, co oznacza, że dyrektywa będzie miała zastosowanie do wszystkich rodzajów robotów indeksujących.

Atrybut treści

W polu treści możesz zdefiniować wiele różnych typów wartości. Atrybut content informuje roboty indeksujące, jak przeszukiwać i indeksować zawartość strony. Jeśli nie ma metatagu robots, roboty indeksujące potraktują stronę jako indeks i będą ją domyślnie śledzić.

Oto różne typy wartości atrybutu treści

- all: Ta dyrektywa mówi robotom indeksującym, że mogą przeszukiwać i indeksować wszystko, co chcą. Działa to w taki sam sposób jak indeks i postępuj zgodnie z instrukcjami.

- index: dyrektywa index informuje roboty indeksujące, że mogą indeksować stronę. Jest to brane pod uwagę domyślnie. Nie trzeba tego dodawać do strony, aby mogła zostać zindeksowana.

- noindex: roboty indeksujące nie mogą indeksować strony. Jeśli strona została już zindeksowana, robot indeksujący zostanie poinstruowany przez tę dyrektywę, aby usunąć ją z indeksu.

- wykonaj: Wyszukiwarki są poinstruowane, aby podążały za wszystkimi linkami na stronie i przekazywały kapitał linków.

- nofollow: Wyszukiwarkom nie wolno klikać linków w witrynie ani przekazywać żadnych udziałów.

- none: Jest to podobne do dyrektyw noindex, nofollow.

- noarchive: Zbuforowana kopia strony nie jest wyświetlana na stronie wyników wyszukiwania (SERP).

- nocache: Ta dyrektywa jest podobna do noarchive, jednak jest obsługiwana tylko przez Internet Explorer i Firefox.

- nosnippet: rozszerzony opis strony (znany również jako opis meta) nie jest wyświetlany w wynikach wyszukiwania.

- notranslate – Uniemożliwia to Google dostarczenie tłumaczenia strony w SERP.

- noimageindex – uniemożliwia Googlebotowi indeksowanie jakichkolwiek zdjęć w witrynie.

- available_after – po określonej dacie/godzinie nie wyświetlaj tej strony w wynikach wyszukiwania. Jest podobny do tagu noindex z zegarem.

- max-snippet: Ta dyrektywa pozwala określić maksymalną liczbę znaków, które Google powinien pokazywać w SERP strony. Liczba znaków w poniższej próbce zostanie ograniczona do 150.

- Np. – <nazwa meta=”robots” content=”max-snippet:150″/>

- max-video-preview – zostanie ustalona maksymalna liczba sekund na podgląd próbki wideo. W poniższym przypadku Google wyświetli 10-sekundowy podgląd —– <meta name=”robots” content=”max-video-preview:10” />

- max-image-preview – informuje Google o rozmiarze obrazu, który powinien wyświetlić na stronie w SERP. Dostępne są trzy opcje.

- Brak — nie zostanie wyświetlony fragment obrazu.

- standard – zostanie użyty domyślny podgląd obrazu

- duży – może zostać wyświetlony największy możliwy podgląd

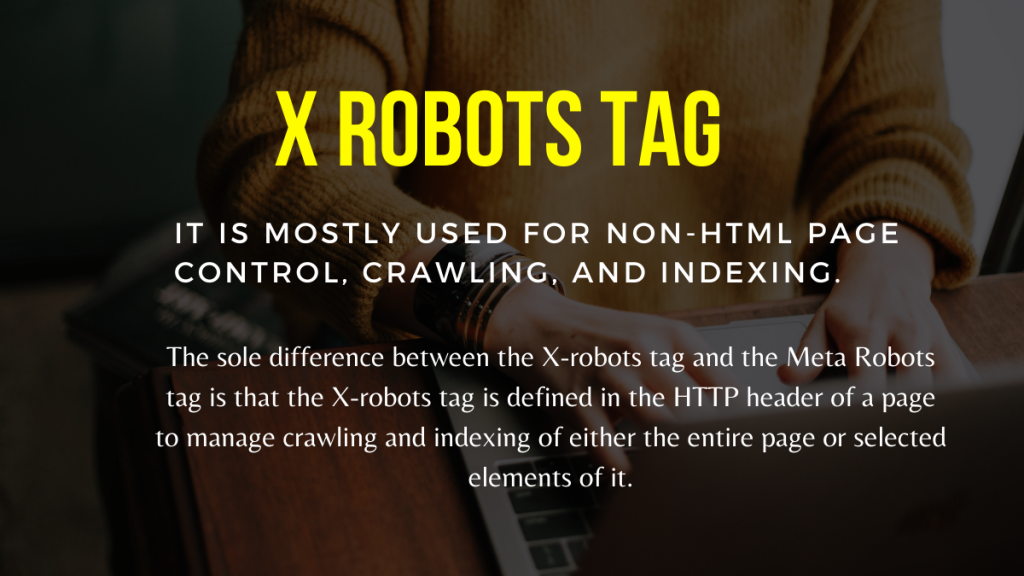

X Robots Tag

Tylko na poziomie strony tag Meta Robots może regulować przeszukiwanie i indeksowanie. Jedyna różnica między tagiem X-robots a tagiem Meta Robots polega na tym, że tag X-robots jest zdefiniowany w nagłówku HTTP strony w celu zarządzania przeszukiwaniem i indeksowaniem całej strony lub jej wybranych elementów. Jest używany głównie do kontroli, przeszukiwania i indeksowania stron innych niż HTML.

Przykład tagu X-Robots

Znacznik X-robots wykorzystuje ten sam zestaw dyrektyw, co znacznik Meta Robots, jak pokazano na tym zrzucie ekranu. Będziesz potrzebować dostępu do a.htaccess,.php lub pliku konfiguracyjnego serwera, aby zmienić nagłówki w celu użycia znacznika X-robots.

Najlepsze praktyki SEO dla robotów Tagi

1) Meta Robots i x-robots nie powinny być używane na tej samej stronie, ponieważ jeden z nich stanie się zbędny.

2) Możesz użyć tagu Meta Robots z dyrektywami, takimi jak noindex, postępuj zgodnie z instrukcjami, jeśli nie chcesz, aby Twoje strony były indeksowane, ale nadal chcesz przekazać wartość linków do powiązanych stron. Zamiast uniemożliwiać indeksowanie za pomocą pliku robots.txt, jest to idealna metoda kontrolowania indeksowania.

3) Aby zindeksować swoją witrynę, nie musisz dołączać indeksu ani podążać za wskazówkami na każdej stronie. Jest brany pod uwagę domyślnie.

4) Jeśli Twoje strony są indeksowane, nie używaj pliku robots.txt do ich zatrzymania, a zamiast tego używaj Meta Robots. Ponieważ roboty indeksujące muszą indeksować stronę, aby sprawdzić tag Meta Robots, a blokowanie pliku robots.txt uniemożliwia im to. Innymi słowy, Twój tag Meta Robots będzie przestarzały.

W takich okolicznościach najpierw użyj metatagu robots, a następnie poczekaj, aż Google zdeindeksuje Twoje witryny. Po ich wyindeksowaniu możesz użyć pliku robots.txt, aby im zapobiec i zaoszczędzić pieniądze na indeksowaniu. Jednakże, ponieważ mogą być wykorzystywane do przekazywania wartości linków do ważnych stron, należy tego unikać. Używaj pliku robots.txt do blokowania deindeksowanych stron tylko wtedy, gdy są one całkowicie bezużyteczne.

5) Kontroluj indeksowanie plików innych niż HTML, takich jak zdjęcia, pliki PDF, flash lub wideo za pomocą tagu X-robots.

Wniosek

Kontrolowanie przeszukiwania i indeksowania Twojej witryny wymaga użycia znaczników robots.txt i robots. Istnieje kilka opcji kontrolowania sposobu, w jaki pająki docierają do Twojej witryny. Jednak nie wszystkie z nich będą skuteczne w rozwiązaniu Twojego problemu. Jeśli na przykład chcesz usunąć niektóre strony z indeksu, samo zablokowanie ich w pliku robots.txt nie zadziała.

Najważniejszą rzeczą, o której należy pamiętać, jest ustalenie, czego wymaga Twoja witryna, a następnie wybranie sprytnej strategii radzenia sobie z tym, gdy witryny są blokowane. Mamy nadzieję, że niniejsza rada pomoże Ci wybrać najlepszą dla Ciebie opcję.

Jakie podejście stosujesz, aby zapobiec blokowaniu stron? Podziel się swoimi przemyśleniami w polu komentarzy poniżej.

SEO Przydatne zasoby do budowania linków:

- Lista najlepszych serwisów społecznościowych z zakładkami 2021

- Lista najlepszych witryn do przesyłania obrazów 2021 dla SEO

- Lista witryn do przesyłania artykułów 2021

- Lista 100 najlepszych witryn do składania katalogów o wysokiej DA 2021

- Najlepsze strony do przesyłania komunikatów prasowych na rok 2021

- Najlepsza lista witryn komentujących blog o wysokim DA DoFollow 2021

- Lista witryn do przesyłania filmów wideo w 2021 r.

- Lista witryn z listą firm o wysokiej wartości DA w 2021 r.

- Lista stron do składania zgłoszeń o wysokiej DA w 2021 r.

- Lista stron internetowych z pytaniami i odpowiedziami o wysokim DA 2021