Guia de SEO: Como definir Robots.txt e Meta Robots Tag

Publicados: 2022-09-11Embora a maioria dos especialistas em SEO esteja ciente de que o robots.txt e a tag Meta Robots são usados para controlar o acesso de bots de mecanismos de pesquisa a um site, muitos também não sabem como usá-los de maneira eficaz. Ambos têm vantagens e desvantagens distintas, e é fundamental encontrar um equilíbrio entre o que empregar e quando. Para resolver esse problema, descrevemos as práticas recomendadas para configurar o arquivo robots.txt e as tags Meta Robots neste artigo.

Robots.txt

Robots.txt é um arquivo de texto que informa aos robôs do mecanismo de pesquisa quais partes do site eles podem rastrear e quais partes eles não podem. Faz parte do Robots Exclusion Protocol (REP), que é um conjunto de diretrizes sobre como os robôs podem rastrear e indexar informações na Internet. Pode parecer complicado e técnico, mas criar um arquivo robots.txt é simples. Vamos começar!

Veja a seguir um exemplo de um arquivo robots.txt simples:

Agente do usuário: *

Permitir: /

Não permitir: /obrigado

Mapa do site: https://www.example.com/sitemap.xml

As diretivas mais significativas em um arquivo robots.txt para guiar robôs são Permitir e Não permitir. Vamos dar uma olhada no que eles significam.

Sintaxe

User-agent – O nome do user agent para o qual as diretivas se destinam é especificado aqui.

O símbolo * indica que as diretivas são destinadas a todos os crawlers. Outros valores possíveis para esse parâmetro incluem Googlebot, yandexbot e bingbot, entre outros.

Permitir: este comando informa ao Googlebot que os localizadores uniformes de recursos especificados são rastreáveis (URLs)

Disallow: este comando impede que o Googlebot rastreie o(s) URL(s) que você especificar.

Sitemap: Este comando é usado para especificar o URL do Sitemap do seu site.

Neste caso, User-agent: * denota que o conjunto de comandos é relevante para TODOS os tipos de bots.

Permitir: / informa aos rastreadores que eles podem rastrear todo o site, exceto as páginas que não são permitidas no arquivo. Por fim, Disallow: /thank-you diz ao Googlebot para não rastrear nenhum URL que inclua /thank-you.

As instruções User-agent, Allow e Disallow executam a função principal de um arquivo robots.txt, que é permitir e proibir rastreadores.

Práticas recomendadas para Robots.txt

Aqui estão algumas dicas pró-SEO que você deve seguir ao configurar seu próprio arquivo robots.txt.

- Em primeiro lugar, faça sua lição de casa e descubra quais partes do seu site você não deseja indexar. Não copie nem reutilize o arquivo robots.txt de outra pessoa.

- Certifique-se de que o arquivo robots.txt esteja localizado no diretório raiz do seu site para que os rastreadores dos mecanismos de pesquisa possam acessá-lo prontamente.

- Como diferencia maiúsculas de minúsculas, não chame seu arquivo de outra forma além de “robots.txt”.

- No robots.txt, sempre inclua o URL do seu mapa do site para que os bots dos mecanismos de pesquisa encontrem as páginas do seu site com mais facilidade.

- Robots.txt não deve ser usado para ocultar informações privadas ou páginas de eventos futuros. Qualquer pessoa pode acessar seu arquivo robots.txt simplesmente colocando /robots.txt após seu nome de domínio porque é um arquivo público. Como qualquer pessoa pode ver as páginas que você deseja ocultar, é melhor não empregar robôs.

- Crie um arquivo robots.txt separado e personalizado para cada um dos subdomínios do seu domínio raiz.

- Antes de entrar ao vivo, verifique se você não está bloqueando nada que não deseja.

- Para descobrir erros e garantir que suas diretivas estejam funcionando, teste e valide seu arquivo robots.txt usando a ferramenta de teste robots.txt do Google.

- Crie um arquivo robots.txt separado e personalizado para cada um dos subdomínios do seu domínio raiz.

- Para descobrir erros e garantir que suas diretivas estejam funcionando, teste e valide seu arquivo robots.txt usando a ferramenta de teste robots.txt do Google.

- Não vincule a nenhuma página do seu site que seja proibida pelo arquivo robots.txt. Os links internos farão com que o Google rastreie essas páginas se estiverem vinculadas.

- Verifique se o arquivo robots.txt está formatado corretamente.

- Em uma nova linha, cada diretiva deve ser definida.

- Ao permitir ou proibir URLs, lembre-se de que diferenciam maiúsculas de minúsculas.

- Exceto por * e $, nenhum outro caractere especial deve ser usado.

- Para fornecer mais clareza, use o símbolo #. Linhas com o caractere # são ignoradas pelos rastreadores.

- Quais páginas você deve usar o arquivo robots.txt para ocultar?

- Páginas para paginação

- Variações dos parâmetros de consulta de uma página

- Páginas para sua conta ou perfil

- Páginas para administradores

- No carrinho de compras

- Páginas de agradecimento

- Bloqueie páginas que não estão vinculadas de qualquer lugar e não são indexadas com robots.txt.

- Quando se trata de robots.txt, os webmasters frequentemente cometem erros. Estes são discutidos em um artigo separado. Confira e fique longe deles – Erros típicos do robots.txt

Etiquetas de robôs

Um arquivo robots.txt apenas informa ao rastreador quais partes do site ele pode acessar. No entanto, ele não informará ao rastreador se ele pode ou não indexar. Para ajudar com isso, você pode empregar tags robots para instruir os rastreadores sobre indexação e uma variedade de outras tarefas. Meta Robots e X-robots tags são as duas formas de tags de robô.

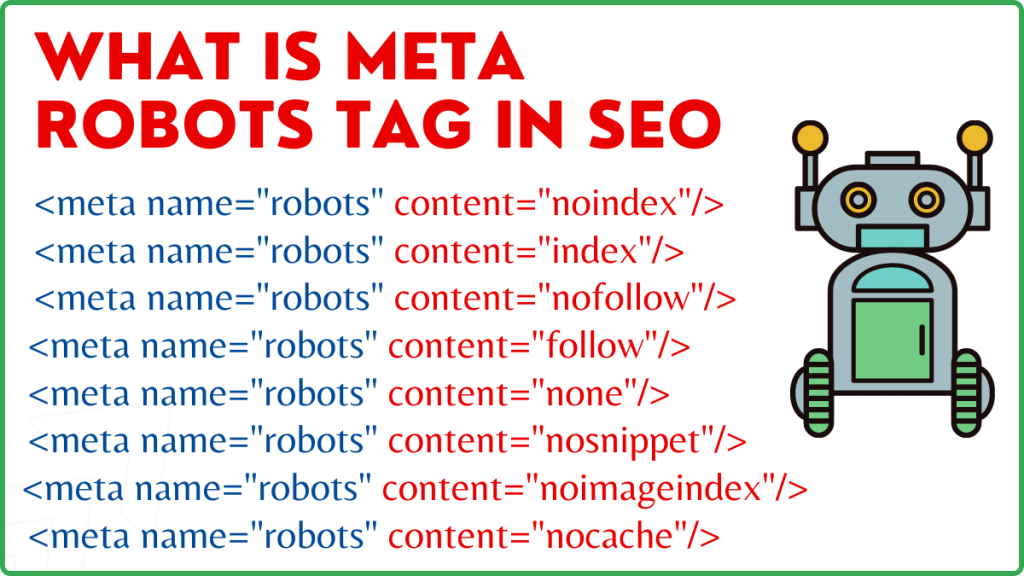

Meta Robôs Tag

Uma tag Meta Robots é um fragmento de código HTML que informa aos mecanismos de pesquisa como rastrear e indexar uma página. É encontrado na seção head> de uma página da web. Uma tag Meta Robots se parece com isso:

<meta name=”robots” content=”noindex,nofollow”>

Nome e conteúdo são os dois atributos da tag Meta Robots.

Atributo de nome

Os valores definidos para o atributo name são os nomes dos robôs, ou seja (Googlebot, MSNbot, etc.). Conforme mostrado no exemplo acima, você pode simplesmente definir o valor como robots, o que indica que a diretiva será aplicada a todos os tipos de robôs de rastreamento.

Atributo de conteúdo

No campo de conteúdo, você pode definir vários tipos diferentes de valores. O atributo content instrui os rastreadores sobre como rastrear e indexar o conteúdo da página. Se nenhuma metatag robots estiver presente, os rastreadores tratarão a página como um índice e a seguirão por padrão.

Aqui estão os diferentes tipos de valores para o atributo content

- all: Esta diretiva diz aos rastreadores que eles podem rastrear e indexar o que quiserem. Isso funciona da mesma forma que o índice e siga as instruções.

- index: A diretiva index informa aos rastreadores que eles podem indexar a página. Isso é levado em consideração por padrão. Isso não precisa ser adicionado a uma página para que ela seja indexada.

- noindex: rastreadores não têm permissão para indexar a página. Se a página já foi indexada, o rastreador será instruído a removê-la do índice por esta diretiva.

- seguir: Os mecanismos de pesquisa são instruídos a seguir todos os links em uma página e a passar o valor do link.

- nofollow: os mecanismos de pesquisa não podem seguir links em um site ou passar qualquer patrimônio.

- none: é semelhante às diretivas noindex, nofollow.

- noarchive: a cópia em cache de uma página não é exibida na página de resultados do mecanismo de pesquisa (SERP).

- nocache: Esta diretiva é semelhante ao noarchive, porém é suportada apenas pelo Internet Explorer e Firefox.

- nosnippet: a descrição expandida da página (também conhecida como meta descrição) não é exibida nos resultados da pesquisa.

- notranslate – Isso impede que o Google forneça uma tradução da página na SERP.

- noimageindex – Isso impede que o Googlebot rastreie qualquer imagem no site.

- unavailable_after –Após a data/hora especificada, não mostra esta página nos resultados da pesquisa. É semelhante a uma tag noindex com um timer.

- max-snippet: Esta diretiva permite especificar o número máximo de caracteres que o Google deve mostrar na SERP de uma página. A quantidade de caracteres na amostra abaixo será limitada a 150.

- Por exemplo – <meta name=”robots” content=”max-snippet:150″/>

- max-video-preview – Uma quantidade máxima de segundos para uma visualização de amostra de vídeo será estabelecida. No caso abaixo, o Google exibirá uma visualização de 10 segundos —– <meta name="robots" content="max-video-preview:10″ />

- max-image-preview – Isso instrui o Google sobre o tamanho da imagem que ele deve exibir para uma página na SERP. Existem três opções disponíveis.

- Nenhum – nenhum trecho de imagem será exibido.

- padrão – A visualização da imagem padrão será usada

- large – a maior visualização possível pode ser exibida

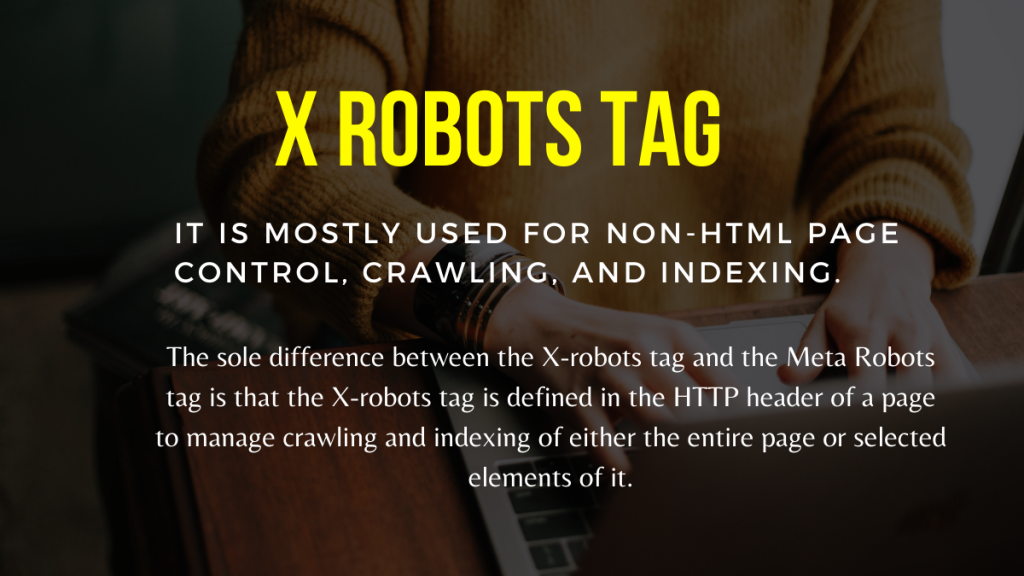

X Robots Tag

Somente no nível da página a tag Meta Robots pode regular o rastreamento e a indexação. A única diferença entre a tag X-robots e a tag Meta Robots é que a tag X-robots é definida no cabeçalho HTTP de uma página para gerenciar o rastreamento e a indexação de toda a página ou de elementos selecionados dela. É usado principalmente para controle de página não HTML, rastreamento e indexação.

Exemplo de tag X-Robots

A tag X-robots emprega o mesmo conjunto de diretivas que a tag Meta Robots, conforme mostrado nesta captura de tela. Você precisará de acesso a um arquivo de configuração do servidor.htaccess,.php ou para alterar os cabeçalhos para usar a tag X-robots.

Melhores práticas de SEO para tags de robôs

1) Meta Robots e x-robots não devem ser usados na mesma página porque um deles se tornará redundante.

2) Você pode usar a tag Meta Robots com diretivas como noindex, siga se não quiser que suas páginas sejam indexadas, mas ainda assim desejar transmitir o valor do link para as páginas vinculadas. Em vez de impedir a indexação com robots.txt, esse é o método ideal para controlar a indexação.

3) Para que seu site seja indexado, você não precisa incluir o índice ou seguir as instruções para cada página. É considerado por padrão.

4) Se suas páginas estiverem indexadas, não use robots.txt para interrompê-las e, em vez disso, utilize Meta Robots. Porque os rastreadores precisam rastrear a página para examinar a tag Meta Robots, e o bloqueio do robots.txt os impede de fazer isso. Em outras palavras, sua tag Meta Robots ficará obsoleta.

Nessas circunstâncias, use primeiro a metatag robots e espere que o Google desindexe seus sites. Depois que eles forem desindexados, você poderá usar o robots.txt para evitá-los e economizar dinheiro no rastreamento. No entanto, como eles podem ser utilizados para transmitir o valor do link para suas páginas vitais, isso deve ser evitado. Use somente o robots.txt para proibir páginas desindexadas se forem completamente inúteis.

5) Controle o rastreamento de arquivos não HTML, como fotos, PDFs, flash ou vídeo com a tag X-robots.

Conclusão

Controlar o rastreamento e a indexação do seu site requer o uso de robots.txt e tags robots. Existem várias opções para controlar como os spiders chegam ao seu site. No entanto, nem todos eles serão eficazes na resolução do seu problema. Se você deseja remover algumas páginas do índice, por exemplo, apenas bani-las no arquivo robots.txt não funcionará.

A coisa mais importante a lembrar aqui é descobrir o que seu site exige e, em seguida, escolher uma estratégia inteligente para lidar com isso quando os sites são bloqueados. Esperamos que este conselho o ajude a determinar a melhor opção para você.

Que abordagem você emprega para evitar que as páginas sejam bloqueadas? Por favor, compartilhe seus pensamentos na caixa de comentários abaixo.

Recursos úteis de construção de links de SEO:

- Lista dos principais sites de favoritos sociais 2021

- Lista dos principais sites de envio de imagens 2021 para SEO

- Lista de sites de envio de artigos 2021

- Lista dos 100 principais sites de envio de diretório de alta DA 2021

- Melhores sites de envio de comunicados de imprensa para 2021

- Melhor lista de sites de comentários do blog High DA DoFollow 2021

- Lista de sites de envio de vídeo em 2021

- Lista de sites de listagem de empresas de alta DA em 2021

- Lista de sites de submissão classificados de alta DA em 2021

- Lista de sites de perguntas e respostas de alta DA 2021