Panduan SEO: Cara mengatur Tag Robots.txt & Meta

Diterbitkan: 2022-09-11Sementara sebagian besar spesialis SEO menyadari bahwa robots.txt dan tag Meta Robot digunakan untuk mengatur akses bot mesin pencari ke situs web, banyak juga yang tidak mengetahui cara menggunakannya secara efektif. Keduanya memiliki kelebihan dan kekurangan yang berbeda, dan sangat penting untuk mencapai keseimbangan antara mana yang akan digunakan dan kapan. Untuk mengatasi masalah ini, kami telah menguraikan praktik terbaik untuk menyiapkan file robots.txt dan tag Meta Robots di artikel ini.

Robots.txt

Robots.txt adalah file teks yang memberi tahu robot mesin pencari bagian mana dari situs web yang dapat mereka jelajahi dan bagian mana yang tidak. Ini adalah bagian dari Robots Exclusion Protocol (REP), yang merupakan seperangkat pedoman tentang bagaimana robot dapat merayapi dan mengindeks informasi di internet. Ini mungkin tampak rumit dan teknis, tetapi membuat file robots.txt itu sederhana. Mari kita mulai!

Berikut ini adalah contoh file robots.txt sederhana:

Agen-pengguna: *

Izinkan: /

Larang: /terima kasih

Peta Situs: https://www.example.com/sitemap.xml

Arahan paling signifikan dalam file robots.txt untuk memandu robot adalah Allow dan Disallow. Mari kita lihat apa yang mereka maksudkan.

Sintaksis

Agen- pengguna – Nama agen pengguna yang menjadi tujuan arahan ditentukan di sini.

Simbol * menunjukkan bahwa arahan ditujukan untuk semua crawler. Nilai lain yang mungkin untuk parameter ini antara lain Googlebot, yandexbot, dan bingbot.

Izinkan: Perintah ini memberi tahu Googlebot bahwa Uniform Resource Locator yang ditentukan dapat dirayapi (URL)

Larang: Perintah ini mencegah Googlebot merayapi URL yang Anda tentukan.

Peta Situs: Perintah ini digunakan untuk menentukan URL Peta Situs situs web Anda.

Dalam hal ini, User-agent: * menunjukkan bahwa kumpulan perintah relevan dengan SEMUA jenis bot.

Izinkan: / memberi tahu perayap bahwa mereka dapat merayapi seluruh situs web kecuali untuk halaman yang tidak diizinkan dalam file. Terakhir, Disallow: /thank-you memberi tahu Googlebot untuk tidak merayapi URL apa pun yang menyertakan /thank-you.

Instruksi User-agent, Allow, dan Disallow menjalankan fungsi utama file robots.txt, yaitu mengizinkan dan melarang crawler.

Praktik Robots.txt Terbaik

Berikut adalah beberapa tip pro-SEO yang harus Anda ikuti saat menyiapkan file robots.txt Anda sendiri.

- Pertama dan terpenting, lakukan pekerjaan rumah Anda dan cari tahu bagian mana dari situs web Anda yang tidak ingin diindeks. Jangan menyalin atau menggunakan kembali file robots.txt orang lain.

- Pastikan bahwa file robots.txt Anda terletak di direktori root situs web Anda sehingga perayap mesin telusur dapat dengan mudah mengaksesnya.

- Karena peka huruf besar/kecil, jangan panggil file Anda selain "robots.txt".

- Di robots.txt, selalu sertakan URL peta situs Anda untuk memudahkan bot mesin pencari menemukan halaman situs web Anda.

- Robots.txt tidak boleh digunakan untuk menyembunyikan informasi pribadi atau halaman acara mendatang. Setiap orang dapat mengakses file robots.txt Anda hanya dengan meletakkan /robots.txt setelah nama domain Anda karena ini adalah file publik. Karena siapa pun dapat melihat halaman yang ingin Anda sembunyikan, sebaiknya jangan menggunakan robot.

- Buat file robots.txt terpisah dan khusus untuk setiap subdomain domain root Anda.

- Sebelum Anda melakukan siaran langsung, periksa kembali apakah Anda tidak memblokir apa pun yang tidak Anda inginkan.

- Untuk menemukan kesalahan dan memastikan bahwa perintah Anda berfungsi, uji dan validasi file robots.txt Anda menggunakan alat pengujian robots.txt Google.

- Buat file robots.txt terpisah dan khusus untuk setiap subdomain domain root Anda.

- Untuk menemukan kesalahan dan memastikan bahwa perintah Anda berfungsi, uji dan validasi file robots.txt Anda menggunakan alat pengujian robots.txt Google.

- Jangan menautkan ke halaman situs web Anda yang dilarang oleh file robots.txt. Tautan internal akan menyebabkan Google merayapi laman tersebut jika ditautkan.

- Pastikan file robots.txt Anda diformat dengan benar.

- Pada baris baru, setiap arahan harus didefinisikan.

- Saat mengizinkan atau melarang URL, perlu diingat bahwa URL peka huruf besar/kecil.

- Kecuali untuk * dan $, tidak ada karakter khusus lainnya yang boleh digunakan.

- Untuk memberikan kejelasan lebih lanjut, gunakan simbol #. Baris dengan karakter # diabaikan oleh crawler.

- Halaman apa yang harus Anda gunakan untuk menyembunyikan file robots.txt?

- Halaman untuk pagination

- Variasi parameter kueri halaman

- Halaman untuk akun atau profil Anda

- Halaman untuk administrator

- Di keranjang belanja

- Halaman terima kasih

- Blokir halaman yang tidak ditautkan dari mana pun dan tidak diindeks dengan robots.txt.

- Ketika datang ke robots.txt, webmaster sering membuat kesalahan. Ini dibahas dalam artikel terpisah. Lihat dan jauhi mereka – Kesalahan umum robots.txt

Robot Tags

File robots.txt hanya memberi tahu perayap bagian mana dari situs web yang dapat diaksesnya. Namun, itu tidak akan memberi tahu perayap apakah dapat mengindeks atau tidak. Untuk membantu hal ini, Anda dapat menggunakan tag robots untuk menginstruksikan crawler tentang pengindeksan dan berbagai tugas lainnya. Meta Robot dan tag X-robot adalah dua bentuk tag robot.

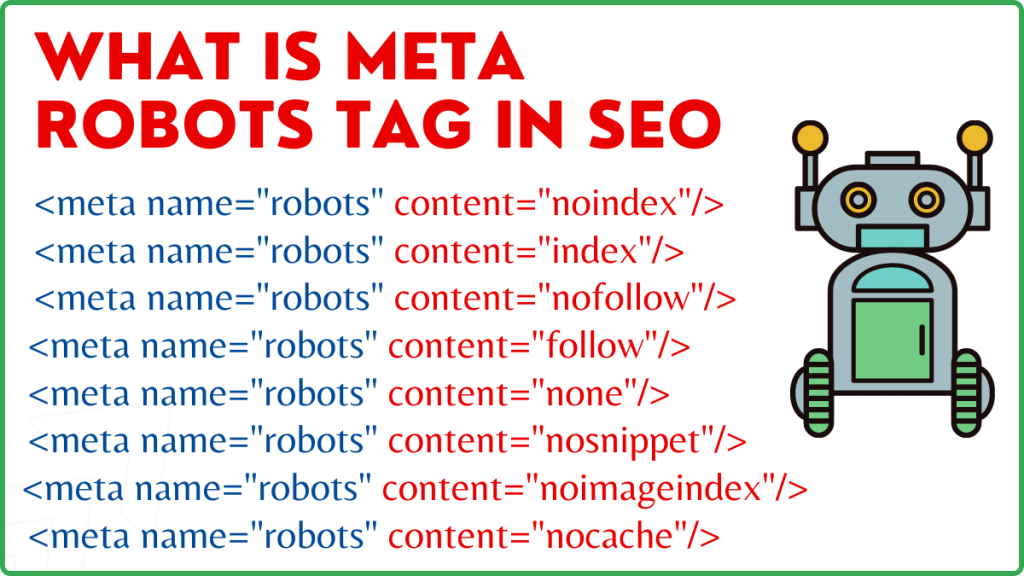

Tag Meta Robot

Tag Meta Robots adalah fragmen kode HTML yang memberi tahu mesin pencari cara merayapi dan mengindeks halaman. Itu ditemukan di bagian kepala> halaman web. Tag Meta Robots terlihat seperti ini:

<meta name="robots" content="noindex,nofollow">

Nama dan konten adalah dua atribut dari tag Meta Robots.

Nama atribut

Nilai yang ditentukan untuk atribut nama adalah nama robot, yaitu (Googlebot, MSNbot, dll.). Seperti yang ditunjukkan pada contoh di atas, Anda cukup mendefinisikan nilai sebagai robots, yang menunjukkan bahwa direktif akan berlaku untuk semua jenis robot perayapan.

Atribut Konten

Di bidang konten, Anda dapat menentukan berbagai tipe nilai yang berbeda. Atribut konten menginstruksikan perayap tentang cara merayapi dan mengindeks konten laman. Jika tidak ada tag meta robot, crawler akan memperlakukan halaman sebagai indeks dan mengikutinya secara default.

Berikut adalah berbagai jenis nilai untuk atribut konten

- all: Arahan ini memberi tahu perayap bahwa mereka dapat merayapi dan mengindeks apa pun yang mereka inginkan. Ini bekerja dengan cara yang sama seperti indeks dan ikuti instruksi.

- index: Arahan indeks memberi tahu perayap bahwa mereka dapat mengindeks halaman. Ini diperhitungkan secara default. Ini tidak harus ditambahkan ke halaman agar dapat diindeks.

- noindex: Crawler tidak diizinkan untuk mengindeks halaman. Jika halaman telah diindeks, crawler akan diinstruksikan untuk menghapusnya dari indeks dengan arahan ini.

- ikuti: Mesin pencari diinstruksikan untuk mengikuti semua tautan pada halaman dan melewati ekuitas tautan.

- nofollow: Mesin pencari tidak diizinkan mengikuti tautan di situs web atau melewati ekuitas apa pun.

- none: Ini mirip dengan arahan noindex, nofollow.

- noarchive: Salinan halaman yang di-cache tidak ditampilkan di Halaman Hasil Mesin Pencari (SERP).

- nocache: Direktif ini mirip dengan noarchive, namun hanya didukung oleh Internet Explorer dan Firefox.

- nosnippet: Deskripsi halaman yang diperluas (juga dikenal sebagai deskripsi meta) tidak ditampilkan dalam hasil pencarian.

- notranslate – Ini mencegah Google menyediakan terjemahan halaman di SERP.

- noimageindex – Ini mencegah Googlebot merayapi gambar apa pun di situs web.

- unavailable_after –Setelah tanggal/waktu yang ditentukan, jangan tampilkan halaman ini di hasil pencarian. Ini mirip dengan tag noindex dengan timer.

- max-snippet: Arahan ini memungkinkan Anda untuk menentukan jumlah maksimum karakter yang harus ditampilkan Google di SERP halaman. Jumlah karakter dalam sampel di bawah ini akan dibatasi hingga 150.

- Misalnya – <meta name=”robots” content="max-snippet:150″/>

- max-video-preview –Jumlah detik maksimum untuk pratinjau sampel video akan ditetapkan. Dalam kasus di bawah ini, Google akan menampilkan pratinjau 10 detik —– <meta name=”robots” content=”max-video-preview:10″ />

- max-image-preview – Ini menginstruksikan Google tentang ukuran gambar yang harus ditampilkan untuk halaman di SERP. Ada tiga pilihan yang tersedia.

- Tidak ada – Tidak ada cuplikan gambar yang akan ditampilkan.

- standar – Pratinjau gambar default akan digunakan

- besar – Pratinjau sebesar mungkin dapat ditampilkan

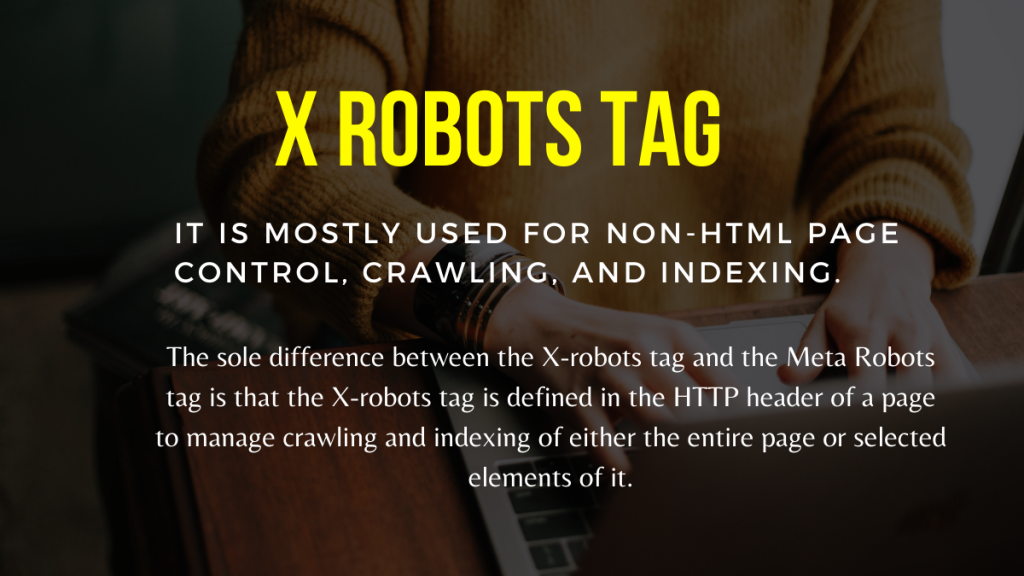

Tag Robot X

Hanya di tingkat halaman tag Meta Robots dapat mengatur perayapan dan pengindeksan. Satu-satunya perbedaan antara tag X-robots dan tag Meta Robots adalah bahwa tag X-robots didefinisikan di header HTTP halaman untuk mengelola perayapan dan pengindeksan seluruh halaman atau elemen yang dipilih. Ini sebagian besar digunakan untuk kontrol halaman non-HTML, perayapan, dan pengindeksan.

Contoh tag X-Robots

Tag X-robots menggunakan rangkaian arahan yang sama dengan tag Meta Robots, seperti yang ditunjukkan pada tangkapan layar ini. Anda memerlukan akses ke a.htaccess,.php, atau file konfigurasi server untuk mengubah header agar dapat menggunakan tag X-robots.

Praktik SEO Terbaik Untuk Robot Tags

1) Meta Robot dan x-robot tidak boleh digunakan pada halaman yang sama karena salah satunya akan menjadi mubazir.

2) Anda dapat menggunakan tag Meta Robots dengan arahan seperti noindex, ikuti jika Anda tidak ingin halaman Anda diindeks tetapi tetap ingin menyampaikan ekuitas tautan ke halaman yang ditautkan. Alih-alih mencegah pengindeksan dengan robots.txt, ini adalah metode yang ideal untuk mengontrol pengindeksan.

3) Untuk membuat situs web Anda diindeks, Anda tidak perlu menyertakan indeks atau mengikuti petunjuk ke setiap halaman. Ini diperhitungkan secara default.

4) Jika halaman Anda diindeks, jangan gunakan robots.txt untuk menghentikannya dan gunakan Meta Robots. Karena perayap perlu merayapi halaman untuk memeriksa tag Meta Robots, dan pemblokiran robots.txt mencegah mereka melakukannya. Dengan kata lain, tag Meta Robots Anda akan menjadi usang.

Dalam keadaan ini, gunakan tag meta robots terlebih dahulu dan kemudian tunggu Google untuk menghapus indeks situs Anda. Setelah diindeks, Anda dapat menggunakan robots.txt untuk mencegahnya dan menghemat uang untuk perayapan. Namun, karena mereka dapat digunakan untuk menyampaikan ekuitas tautan ke halaman penting Anda, ini harus dihindari. Hanya gunakan robots.txt untuk melarang halaman yang tidak diindeks jika sama sekali tidak berguna.

5) Kontrol perayapan file non-HTML seperti foto, PDF, flash, atau video dengan tag X-robot.

Kesimpulan

Mengontrol perayapan dan pengindeksan situs web Anda memerlukan penggunaan robots.txt dan tag robots. Ada beberapa opsi untuk mengontrol cara laba-laba menjangkau situs Anda. Namun, tidak semuanya akan efektif dalam menyelesaikan masalah Anda. Jika Anda ingin menghapus beberapa halaman dari indeks, misalnya, hanya melarangnya di file robots.txt tidak akan berfungsi.

Hal terpenting untuk diingat di sini adalah mencari tahu apa yang dibutuhkan situs web Anda dan kemudian memilih strategi cerdas untuk menghadapinya ketika situs diblokir. Kami berharap saran ini membantu Anda dalam menentukan pilihan terbaik untuk Anda.

Pendekatan apa yang Anda terapkan untuk mencegah halaman diblokir? Silakan bagikan pemikiran Anda di kotak komentar di bawah.

Sumber Daya Pembuatan Tautan Berguna SEO:

- Daftar Situs Bookmarking Sosial Teratas 2021

- Daftar Situs Pengiriman Gambar Teratas 2021 untuk SEO

- Daftar Situs Pengajuan Artikel 2021

- 100 Daftar Situs Pengajuan Direktori DA Tinggi Teratas 2021

- Situs Pengajuan Siaran Pers Terbaik untuk 2021

- Daftar Situs Komentar Blog DoFollow DA Tinggi Terbaik 2021

- Daftar Situs Pengiriman Video pada tahun 2021

- Daftar Situs Daftar Bisnis DA Tinggi pada tahun 2021

- Daftar Situs Pengajuan Rahasia DA Tinggi pada tahun 2021

- Daftar Situs Web Pertanyaan dan Jawaban DA Tinggi 2021