SEO-Leitfaden: So legen Sie Robots.txt & Meta Robots Tag fest

Veröffentlicht: 2022-09-11Während die meisten SEO-Spezialisten wissen, dass robots.txt und das Meta Robots-Tag verwendet werden, um den Zugriff von Suchmaschinen-Bots auf eine Website zu regeln, wissen viele auch nicht, wie sie effektiv eingesetzt werden können. Beide haben unterschiedliche Vor- und Nachteile, und es ist entscheidend, ein Gleichgewicht zwischen dem Einsatz und dem Zeitpunkt zu finden. Um dieses Problem zu beheben, haben wir in diesem Artikel die Best Practices für die Einrichtung der robots.txt-Datei und Meta Robots-Tags skizziert.

Robots.txt

Robots.txt ist eine Textdatei, die Suchmaschinenrobotern mitteilt, welche Teile der Website sie crawlen können und welche nicht. Es ist Teil des Robots Exclusion Protocol (REP), einer Reihe von Richtlinien dafür, wie Roboter Informationen im Internet crawlen und indizieren können. Es mag kompliziert und technisch erscheinen, aber das Erstellen einer robots.txt-Datei ist einfach. Lass uns anfangen!

Das Folgende ist ein Beispiel für eine einfache robots.txt-Datei:

Benutzeragent: *

Erlauben: /

Nicht zulassen: /Danke

Sitemap: https://www.example.com/sitemap.xml

Die wichtigsten Anweisungen in einer robots.txt-Datei zum Führen von Robotern sind Allow und Disallow. Schauen wir uns an, was sie bedeuten.

Syntax

User-agent – Hier wird der User-Agent-Name angegeben, für den die Direktiven bestimmt sind.

Das Symbol * zeigt an, dass die Anweisungen für alle Crawler bestimmt sind. Andere mögliche Werte für diesen Parameter sind unter anderem Googlebot, yandexbot und bingbot.

Zulassen: Dieser Befehl teilt dem Googlebot mit, dass die angegebenen Uniform Resource Locators gecrawlt werden können (URLs).

Disallow: Dieser Befehl hindert den Googlebot daran, die von Ihnen angegebene(n) URL(s) zu crawlen.

Sitemap: Dieser Befehl wird verwendet, um die Sitemap-URL Ihrer Website anzugeben.

In diesem Fall gibt User-agent: * an, dass der Befehlssatz für ALLE Arten von Bots relevant ist.

Allow: / teilt Crawlern mit, dass sie die gesamte Website crawlen können, mit Ausnahme der Seiten, die in der Datei nicht erlaubt sind. Schließlich weist Disallow: /thank-you den Googlebot an, keine URLs zu crawlen, die /thank-you enthalten.

Die Anweisungen User-agent, Allow und Disallow führen die primäre Funktion einer robots.txt-Datei aus, nämlich das Zulassen und Verbieten von Crawlern.

Beste Robots.txt-Praktiken

Hier sind einige professionelle SEO-Tipps, die Sie befolgen sollten, wenn Sie Ihre eigene robots.txt-Datei einrichten.

- Bitte machen Sie zuallererst Ihre Hausaufgaben und finden Sie heraus, welche Teile Ihrer Website nicht indexiert werden sollen. Kopieren oder verwenden Sie nicht die robots.txt-Datei einer anderen Person.

- Stellen Sie sicher, dass sich Ihre robots.txt-Datei im Stammverzeichnis Ihrer Website befindet, damit Suchmaschinen-Crawler problemlos darauf zugreifen können.

- Nennen Sie Ihre Datei nicht anders als „robots.txt“, da zwischen Groß- und Kleinschreibung unterschieden wird.

- Fügen Sie in robots.txt immer Ihre Sitemap-URL ein, damit Suchmaschinen-Bots Ihre Website-Seiten leichter finden können.

- Robots.txt sollte nicht verwendet werden, um private Informationen oder zukünftige Veranstaltungsseiten zu verbergen. Jede Person kann auf Ihre robots.txt-Datei zugreifen, indem sie einfach /robots.txt nach Ihrem Domainnamen setzt, da es sich um eine öffentliche Datei handelt. Da jeder die Seiten sehen kann, die Sie ausblenden möchten, ist es am besten, keine Roboter einzusetzen.

- Erstellen Sie für jede Subdomain Ihrer Root-Domain eine separate und angepasste robots.txt-Datei.

- Bevor Sie live gehen, vergewissern Sie sich noch einmal, dass Sie nichts blockieren, was Sie nicht möchten.

- Um Fehler zu entdecken und sicherzustellen, dass Ihre Anweisungen funktionieren, testen und validieren Sie Ihre robots.txt-Datei mit dem robots.txt-Testtool von Google.

- Erstellen Sie für jede Subdomain Ihrer Root-Domain eine separate und angepasste robots.txt-Datei.

- Um Fehler zu entdecken und sicherzustellen, dass Ihre Anweisungen funktionieren, testen und validieren Sie Ihre robots.txt-Datei mit dem robots.txt-Testtool von Google.

- Verlinken Sie keine Seiten Ihrer Website, die durch die robots.txt-Datei verboten sind. Interne Links veranlassen Google, diese Seiten zu crawlen, wenn sie verlinkt sind.

- Stellen Sie sicher, dass Ihre robots.txt-Datei richtig formatiert ist.

- In einer neuen Zeile sollte jede Direktive definiert werden.

- Beachten Sie beim Zulassen oder Ablehnen von URLs, dass zwischen Groß- und Kleinschreibung unterschieden wird.

- Außer * und $ dürfen keine weiteren Sonderzeichen verwendet werden.

- Verwenden Sie zur weiteren Verdeutlichung das Symbol #. Zeilen mit dem Zeichen # werden von Crawlern ignoriert.

- Welche Seiten sollten Sie mithilfe der robots.txt-Datei ausblenden?

- Seiten für Paginierung

- Variationen der Abfrageparameter einer Seite

- Seiten für Ihr Konto oder Profil

- Seiten für Administratoren

- Im Warenkorb

- Danke Seiten

- Blockieren Sie Seiten, die nirgendwo verlinkt und nicht mit robots.txt indiziert sind.

- Bei der robots.txt machen Webmaster häufig Fehler. Diese werden in einem separaten Artikel besprochen. Probieren Sie es aus und halten Sie sich von ihnen fern – Typische robots.txt-Fehler

Roboter-Tags

Eine robots.txt-Datei teilt dem Crawler lediglich mit, auf welche Teile der Website er zugreifen kann. Es teilt dem Crawler jedoch nicht mit, ob es indexieren kann oder nicht. Um dies zu unterstützen, können Sie Robots-Tags verwenden, um Crawler bei der Indizierung und einer Vielzahl anderer Aufgaben anzuweisen. Meta Robots- und X-Robots-Tags sind die beiden Formen von Robot-Tags.

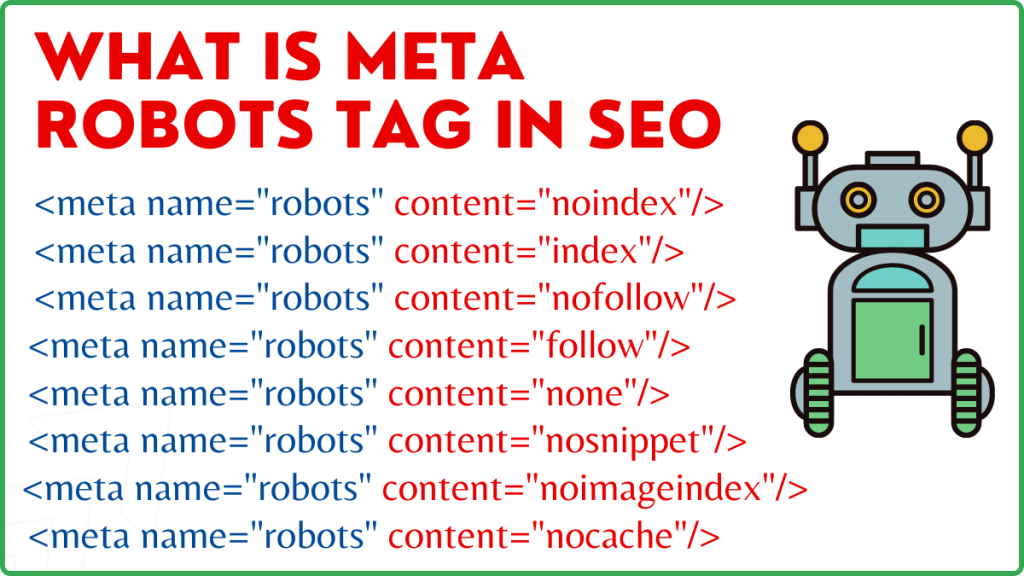

Meta Robots-Tag

Ein Meta Robots-Tag ist ein HTML-Codefragment, das Suchmaschinen mitteilt, wie eine Seite gecrawlt und indexiert werden soll. Es befindet sich im Head>-Abschnitt einer Webseite. Ein Meta Robots-Tag sieht folgendermaßen aus:

<meta name=“robots“ content=“noindex,nofollow“>

Name und Inhalt sind die beiden Attribute des Meta Robots-Tags.

Namensattribut

Die für das Namensattribut definierten Werte sind die Namen der Roboter, dh (Googlebot, MSNbot usw.). Wie im obigen Beispiel gezeigt, können Sie den Wert einfach als robots definieren, was darauf hinweist, dass die Anweisung für alle Arten von kriechenden Robotern gilt.

Inhaltsattribut

Im Inhaltsfeld können Sie eine Vielzahl unterschiedlicher Arten von Werten definieren. Das Inhaltsattribut weist Crawler an, wie der Inhalt der Seite gecrawlt und indexiert werden soll. Wenn kein Robots-Meta-Tag vorhanden ist, behandeln Crawler die Seite als Index und folgen ihr standardmäßig.

Hier sind die verschiedenen Arten von Werten für das Inhaltsattribut

- all: Diese Direktive teilt Crawlern mit, dass sie alles crawlen und indizieren können, was sie wollen. Dies funktioniert genauso wie die Index-and-Follow-Anweisungen.

- index: Die index-Direktive teilt Crawlern mit, dass sie die Seite indexieren können. Dies wird standardmäßig berücksichtigt. Dies muss nicht zu einer Seite hinzugefügt werden, damit sie indiziert wird.

- noindex: Crawler dürfen die Seite nicht indexieren. Wenn die Seite bereits indexiert wurde, wird der Crawler durch diese Anweisung angewiesen, sie aus dem Index zu entfernen.

- follow: Suchmaschinen werden angewiesen, allen Links auf einer Seite zu folgen und Link Equity weiterzugeben.

- nofollow: Suchmaschinen dürfen Links auf einer Website nicht folgen oder Aktien weitergeben.

- none: Dies ähnelt den Direktiven noindex, nofollow.

- noarchive: Die zwischengespeicherte Kopie einer Seite wird nicht auf der Search Engine Results Page (SERP) angezeigt.

- nocache: Diese Direktive ähnelt noarchive, wird jedoch nur von Internet Explorer und Firefox unterstützt.

- nosnippet: Die erweiterte Beschreibung der Seite (auch bekannt als Meta-Beschreibung) wird nicht in den Suchergebnissen angezeigt.

- notranslate – Dies verhindert, dass Google eine Übersetzung der Seite im SERP bereitstellt.

- noimageindex – Dies verhindert, dass der Googlebot Bilder auf der Website crawlt.

- unavailable_after – Diese Seite nach dem angegebenen Datum/der angegebenen Uhrzeit nicht mehr in den Suchergebnissen anzeigen. Es ähnelt einem noindex-Tag mit einem Timer.

- max-snippet: Mit dieser Anweisung können Sie die maximale Anzahl von Zeichen angeben, die Google im SERP einer Seite anzeigen soll. Die Anzahl der Zeichen im Beispiel unten ist auf 150 begrenzt.

- Beispiel: <meta name=“robots“ content=“max-snippet:150″/>

- max-video-preview – Es wird eine maximale Anzahl von Sekunden für eine Videobeispielvorschau festgelegt. Im folgenden Fall zeigt Google eine 10-Sekunden-Vorschau an —– <meta name=“robots“ content=“max-video-preview:10″ />

- max-image-preview – Dies weist Google an, wie groß das Bild ist, das es für eine Seite im SERP anzeigen soll. Es stehen drei Optionen zur Verfügung.

- Keine – Es wird kein Bildausschnitt angezeigt.

- standard – Standard Bildvorschau wird verwendet

- groß – Größtmögliche Vorschau kann angezeigt werden

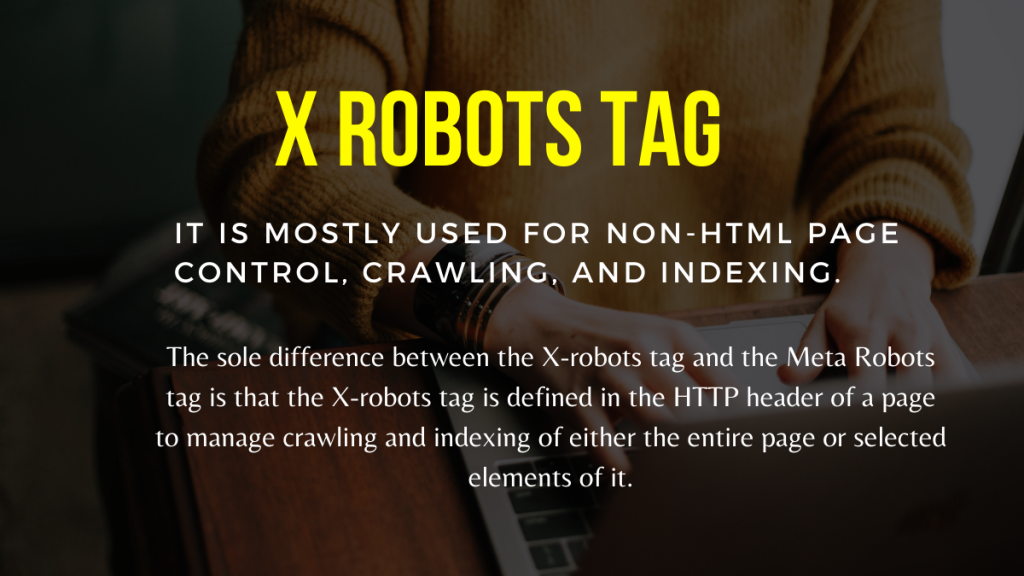

X-Roboter-Tag

Nur auf Seitenebene kann das Meta Robots-Tag das Crawlen und Indizieren regulieren. Der einzige Unterschied zwischen dem X-Robots-Tag und dem Meta-Robots-Tag besteht darin, dass das X-Robots-Tag im HTTP-Header einer Seite definiert ist, um das Crawlen und Indizieren entweder der gesamten Seite oder ausgewählter Elemente davon zu verwalten. Es wird hauptsächlich für Nicht-HTML-Seitensteuerung, Crawling und Indizierung verwendet.

Beispiel für X-Robots-Tag

Das X-Robots-Tag verwendet die gleichen Anweisungen wie das Meta Robots-Tag, wie in diesem Screenshot gezeigt. Sie benötigen Zugriff auf eine .htaccess-, .php- oder Serverkonfigurationsdatei, um die Header zu ändern, damit Sie das X-robots-Tag verwenden können.

Beste SEO-Praktiken für Roboter-Tags

1) Meta Robots und X-Robots sollten nicht auf derselben Seite verwendet werden, da einer von ihnen überflüssig wird.

2) Sie können das Meta Robots-Tag mit Anweisungen wie noindex, follow verwenden, wenn Sie nicht möchten, dass Ihre Seiten indexiert werden, aber trotzdem Link-Equity auf verlinkte Seiten übertragen möchten. Anstatt die Indizierung mit robots.txt zu verhindern, ist dies die ideale Methode, um die Indizierung zu steuern.

3) Um Ihre Website indexieren zu lassen, müssen Sie keinen Index hinzufügen oder den Anweisungen zu jeder Seite folgen. Es wird standardmäßig berücksichtigt.

4) Wenn Ihre Seiten indexiert sind, verwenden Sie nicht robots.txt, um sie zu stoppen, und verwenden Sie stattdessen Meta Robots. Weil Crawler die Seite crawlen müssen, um das Meta Robots-Tag zu untersuchen, und die robots.txt-Blockierung sie daran hindert. Mit anderen Worten, Ihr Meta Robots-Tag ist veraltet.

Verwenden Sie in diesem Fall zuerst das Robots-Meta-Tag und warten Sie dann, bis Google Ihre Websites deindexiert hat. Nachdem sie deindexiert wurden, können Sie robots.txt verwenden, um sie zu verhindern und beim Crawling Geld zu sparen. Da sie jedoch verwendet werden können, um Link-Equity auf Ihre wichtigen Seiten zu übertragen, sollte dies vermieden werden. Verwenden Sie die robots.txt nur, um de-indexierte Seiten zu verbieten, wenn sie völlig nutzlos sind.

5) Steuern Sie das Crawlen von Nicht-HTML-Dateien wie Fotos, PDFs, Flash oder Videos mit dem X-Robots-Tag.

Fazit

Um das Crawling und die Indexierung Ihrer Website zu steuern, müssen robots.txt und robots-Tags verwendet werden. Es gibt mehrere Optionen, um zu steuern, wie Spider Ihre Website erreichen. Allerdings werden nicht alle von ihnen bei der Lösung Ihres Problems wirksam sein. Wenn Sie beispielsweise einige Seiten aus dem Index entfernen möchten, wird es nicht funktionieren, sie einfach in der robots.txt-Datei zu verbieten.

Das Wichtigste, woran Sie hier denken sollten, ist, herauszufinden, was Ihre Website benötigt, und dann eine clevere Strategie zu wählen, um damit umzugehen, wenn Websites blockiert sind. Wir hoffen, dass dieser Rat Ihnen hilft, die beste Option für Sie zu finden.

Welchen Ansatz verfolgen Sie, um zu verhindern, dass Seiten blockiert werden? Bitte teilen Sie Ihre Gedanken im Kommentarfeld unten mit.

Nützliche SEO-Linkbuilding-Ressourcen:

- Top Social Bookmarking Sites Liste 2021

- Liste der besten Bildübermittlungsseiten 2021 für SEO

- Liste der Websites für die Einreichung von Artikeln 2021

- Liste der 100 besten DA-Verzeichnis-Einreichungsseiten 2021

- Beste Websites zum Einreichen von Pressemitteilungen für 2021

- Liste der besten High DA DoFollow-Blog-Kommentarseiten 2021

- Liste der Websites für die Einreichung von Videos im Jahr 2021

- High DA Business Listing Sites List im Jahr 2021

- Liste der hoch eingestuften DA-Einreichungsstellen im Jahr 2021

- Liste der Websites mit hoher DA-Frage und -Antwort 2021