Руководство по поисковой оптимизации: как установить Robots.txt и тег Meta Robots

Опубликовано: 2022-09-11Хотя большинство SEO-специалистов знают, что robots.txt и тег Meta Robots используются для управления доступом поисковых роботов к веб-сайту, многие также не знают, как их эффективно использовать. У обоих есть явные преимущества и недостатки, и очень важно найти баланс между тем, что использовать и когда. Чтобы решить эту проблему, мы изложили в этой статье рекомендации по настройке файла robots.txt и тегов Meta Robots.

Роботы.txt

Robots.txt — это текстовый файл, который сообщает роботам поисковых систем, какие части веб-сайта они могут сканировать, а какие — нет. Это часть протокола исключения роботов (REP), который представляет собой набор рекомендаций о том, как роботы могут сканировать и индексировать информацию в Интернете. Это может показаться сложным и техническим, но создать файл robots.txt просто. Давайте начнем!

Ниже приведен пример простого файла robots.txt:

Пользовательский агент: *

Разрешить: /

Запретить: /спасибо

Карта сайта: https://www.example.com/sitemap.xml

Наиболее важными директивами в файле robots.txt для управления роботами являются «Разрешить» и «Запретить». Давайте посмотрим, что они обозначают.

Синтаксис

User-agent — здесь указывается имя пользовательского агента, для которого предназначены директивы.

Символ * означает, что директивы предназначены для всех поисковых роботов. Среди других возможных значений этого параметра — Googlebot, yandexbot и bingbot.

Разрешить: эта команда сообщает роботу Googlebot, что указанные унифицированные указатели ресурсов доступны для сканирования (URL-адреса).

Disallow: эта команда запрещает роботу Googlebot сканировать указанные вами URL-адреса.

Карта сайта: эта команда используется для указания URL-адреса карты сайта вашего веб-сайта.

В данном случае User-agent: * означает, что набор команд актуален для ВСЕХ типов ботов.

Разрешить: / сообщает сканерам, что они могут сканировать весь веб-сайт, за исключением страниц, которые не разрешены в файле. Наконец, Disallow: /thank-you указывает роботу Googlebot не сканировать любые URL-адреса, содержащие /thank-you.

Инструкции User-agent, Allow и Disallow выполняют основную функцию файла robots.txt, а именно разрешают и запрещают поисковые роботы.

Лучшие практики robots.txt

Вот несколько советов по SEO, которым вы должны следовать при настройке собственного файла robots.txt.

- Прежде всего, сделайте домашнее задание и выясните, какие части вашего веб-сайта вы не хотите индексировать. Не копируйте и не используйте файл robots.txt другого человека.

- Убедитесь, что ваш файл robots.txt находится в корневом каталоге вашего веб-сайта, чтобы сканеры поисковых систем могли легко получить к нему доступ.

- Поскольку он чувствителен к регистру, не называйте файл иначе, чем «robots.txt».

- В файле robots.txt всегда указывайте URL-адрес вашей карты сайта, чтобы роботам поисковых систем было легче находить страницы вашего сайта.

- Robots.txt не следует использовать для сокрытия личной информации или страниц будущих событий. Любой человек может получить доступ к вашему файлу robots.txt, просто добавив /robots.txt после имени вашего домена, потому что это общедоступный файл. Поскольку любой может увидеть страницы, которые вы хотите скрыть, лучше не использовать роботов.

- Создайте отдельный настраиваемый файл robots.txt для каждого из поддоменов вашего корневого домена.

- Прежде чем начать трансляцию, убедитесь, что вы не блокируете ничего, что вам не нужно.

- Чтобы обнаружить любые ошибки и убедиться, что ваши директивы работают, протестируйте и проверьте файл robots.txt с помощью инструмента тестирования robots.txt от Google.

- Создайте отдельный настраиваемый файл robots.txt для каждого из поддоменов вашего корневого домена.

- Чтобы обнаружить любые ошибки и убедиться, что ваши директивы работают, протестируйте и проверьте файл robots.txt с помощью инструмента тестирования robots.txt от Google.

- Не размещайте ссылки на какие-либо страницы вашего веб-сайта, запрещенные файлом robots.txt. Внутренние ссылки заставят Google сканировать эти страницы, если на них есть ссылки.

- Убедитесь, что файл robots.txt имеет правильный формат.

- Каждая директива должна быть определена с новой строки.

- Разрешая или запрещая URL-адреса, имейте в виду, что они чувствительны к регистру.

- За исключением * и $, нельзя использовать никакие другие специальные символы.

- Для большей ясности используйте символ #. Строки с символом # игнорируются поисковыми роботами.

- Какие страницы следует скрывать с помощью файла robots.txt?

- Страницы для пагинации

- Варианты параметров запроса страницы

- Страницы для вашего аккаунта или профиля

- Страницы для администраторов

- В корзине

- Страницы благодарности

- Блокировать страницы, на которые нет ниоткуда ссылок и которые не проиндексированы с помощью robots.txt.

- Когда дело доходит до robots.txt, веб-мастера часто допускают грубые ошибки. Они обсуждаются в отдельной статье. Проверьте это и держитесь подальше от них — типичные ошибки robots.txt

Роботы Tags

Файл robots.txt просто сообщает сканеру, к каким частям веб-сайта он может получить доступ. Однако он не сообщает сканеру, может ли он индексировать. Чтобы помочь в этом, вы можете использовать теги robots, чтобы проинструктировать поисковые роботы об индексации и множестве других задач. Теги Meta Robots и X-robots — это две формы тегов роботов.

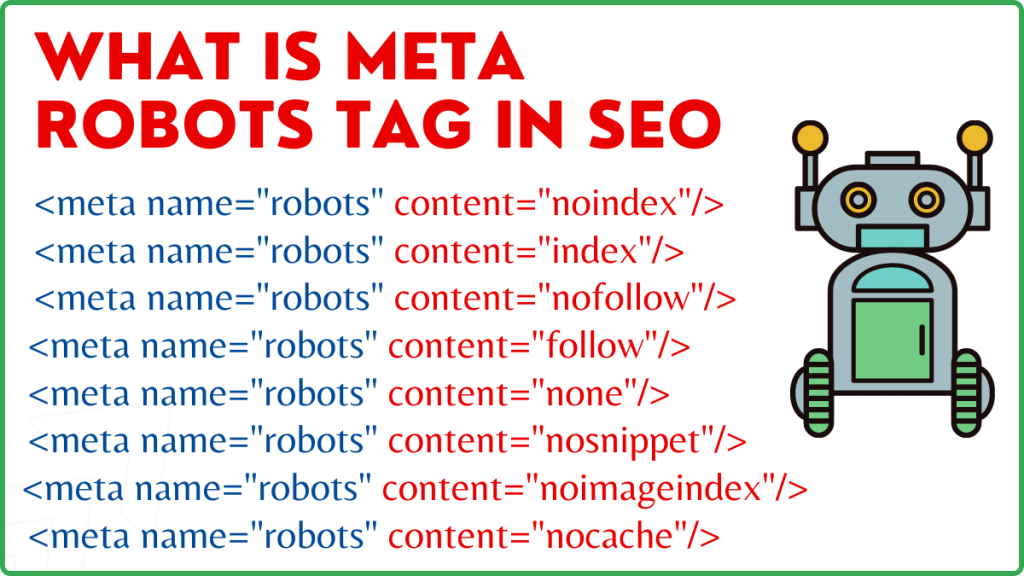

Мета Роботы Тег

Тег Meta Robots — это фрагмент HTML-кода, который сообщает поисковым системам, как сканировать и индексировать страницу. Он находится в разделе head> веб-страницы. Тег Meta Robots выглядит так:

<meta name="robots" content="noindex,nofollow">

Имя и содержимое — это два атрибута тега Meta Robots.

Атрибут имени

Значения, определенные для атрибута name, являются именами роботов, т. е. (Googlebot, MSNbot и т. д.). Как показано в приведенном выше примере, вы можете просто определить значение как robots, что указывает на то, что директива будет применяться ко всем видам сканирующих роботов.

Атрибут содержания

В поле содержимого вы можете определить различные типы значений. Атрибут содержимого указывает сканерам, как сканировать и индексировать содержимое страницы. Если метатег robots отсутствует, поисковые роботы будут рассматривать страницу как индекс и следовать ей по умолчанию.

Ниже приведены различные типы значений атрибута содержимого.

- all: эта директива сообщает поисковым роботам, что они могут сканировать и индексировать все, что захотят. Это работает так же, как индекс и следуйте инструкциям.

- index: директива index сообщает сканерам, что они могут индексировать страницу. Это учитывается по умолчанию. Его не нужно добавлять на страницу, чтобы она была проиндексирована.

- noindex: Сканеры не могут индексировать страницу. Если страница уже проиндексирована, краулер получит указание удалить ее из индекса с помощью этой директивы.

- следовать: поисковые системы получают указание переходить по всем ссылкам на странице и передавать ссылочный вес.

- nofollow: Поисковым системам не разрешается переходить по ссылкам на веб-сайте или передавать какую-либо долю.

- none: это похоже на директивы noindex, nofollow.

- noarchive: кэшированная копия страницы не отображается на странице результатов поисковой системы (SERP).

- nocache: эта директива похожа на noarchive, однако поддерживается только Internet Explorer и Firefox.

- nosnippet: расширенное описание страницы (также известное как метаописание) не отображается в результатах поиска.

- notranslate — не позволяет Google предоставлять перевод страницы в поисковой выдаче.

- noimageindex — не позволяет роботу Googlebot сканировать любые изображения на веб-сайте.

- unavailable_after – после указанной даты/времени не показывать эту страницу в результатах поиска. Это похоже на тег noindex с таймером.

- max-snippet: эта директива позволяет указать максимальное количество символов, которое Google должен отображать в поисковой выдаче страницы. Количество символов в примере ниже будет ограничено 150.

- Например – <meta name=”robots” content=”max-snippet:150″/>

- max-video-preview — будет установлено максимальное количество секунд для предварительного просмотра образца видео. В приведенном ниже случае Google отобразит 10-секундный предварительный просмотр —– <meta name="robots" content="max-video-preview:10" />

- max-image-preview — указывает Google размер изображения, которое он должен отображать на странице в поисковой выдаче. Доступны три варианта.

- Нет — фрагмент изображения отображаться не будет.

- стандартный — будет использоваться предварительный просмотр изображения по умолчанию.

- большой — может отображаться максимально возможный предварительный просмотр.

X Роботы Тег

Только на уровне страницы тег Meta Robots может регулировать сканирование и индексацию. Единственная разница между тегом X-robots и тегом Meta Robots заключается в том, что тег X-robots определяется в заголовке HTTP страницы для управления сканированием и индексированием либо всей страницы, либо выбранных ее элементов. Он в основном используется для управления страницами, не использующими HTML, а также для сканирования и индексирования.

Пример тега X-Robots

Тег X-robots использует тот же набор директив, что и тег Meta Robots, как показано на этом снимке экрана. Вам потребуется доступ к файлу конфигурации .htaccess, .php или сервера, чтобы изменить заголовки и использовать тег X-robots.

Лучшие практики SEO для тегов роботов

1) Мета-роботы и x-роботы не должны использоваться на одной странице, потому что один из них станет лишним.

2) Вы можете использовать тег Meta Robots с такими директивами, как noindex, следуйте, если вы не хотите, чтобы ваши страницы индексировались, но все же хотите передать ссылочный вес на связанные страницы. Вместо предотвращения индексации с помощью robots.txt это идеальный метод контроля индексации.

3) Чтобы ваш сайт проиндексировался, вам не нужно включать индекс или следовать указаниям на каждой странице. Он учитывается по умолчанию.

4) Если ваши страницы проиндексированы, не используйте robots.txt, чтобы остановить их, а вместо этого используйте Meta Robots. Потому что сканерам необходимо просканировать страницу, чтобы проверить тег Meta Robots, а блокировка robots.txt не позволяет им это сделать. Другими словами, ваш тег Meta Robots будет устаревшим.

В этих обстоятельствах сначала используйте метатег robots, а затем подождите, пока Google деиндексирует ваши сайты. После того, как они будут деиндексированы, вы можете использовать robots.txt, чтобы предотвратить их и сэкономить деньги на сканировании. Однако, поскольку их можно использовать для передачи ссылочного веса на важные страницы, этого следует избегать. Используйте robots.txt для запрета деиндексированных страниц только в том случае, если они совершенно бесполезны.

5) Контролируйте сканирование не-HTML-файлов, таких как фотографии, PDF-файлы, флэш-память или видео, с помощью тега X-robots.

Вывод

Для управления сканированием и индексированием вашего веб-сайта необходимо использовать robots.txt и теги robots. Существует несколько вариантов контроля того, как пауки попадают на ваш сайт. Однако не все из них будут эффективны в решении вашей проблемы. Если вы хотите удалить какие-то страницы из индекса, например, просто запретить их в файле robots.txt не получится.

Здесь важно помнить, что нужно выяснить, что требуется вашему веб-сайту, а затем выбрать разумную стратегию, чтобы справиться с этим, когда сайты заблокированы. Мы надеемся, что этот совет поможет вам определить лучший вариант для вас.

Какой подход вы используете для предотвращения блокировки страниц? Пожалуйста, поделитесь своими мыслями в поле для комментариев ниже.

Полезные SEO-ресурсы для построения ссылок:

- Список лучших сайтов социальных закладок 2021

- Список лучших сайтов для отправки изображений в 2021 году для SEO

- Список сайтов для подачи статей 2021

- Список 100 лучших сайтов для отправки каталогов High DA 2021 г.

- Лучшие сайты для размещения пресс-релизов на 2021 год

- Список лучших сайтов для комментирования блогов High DA DoFollow 2021

- Список сайтов для размещения видео в 2021 году

- Список сайтов с высокой DA в 2021 году

- Список засекреченных сайтов с высоким DA в 2021 г.

- Список сайтов вопросов и ответов с высоким DA 2021