Hadoop vs Spark: comparación cara a cara

Publicado: 2022-11-02Hadoop y Spark, ambos desarrollados por Apache Software Foundation, son marcos de código abierto ampliamente utilizados para arquitecturas de big data.

Estamos realmente en el corazón del fenómeno Big Data en este momento, y las empresas ya no pueden ignorar el impacto de los datos en su toma de decisiones.

Como recordatorio, los datos considerados Big Data cumplen con tres criterios: velocidad, velocidad y variedad. Sin embargo, no puede procesar Big Data con sistemas y tecnologías tradicionales.

Es con el fin de superar este problema que Apache Software Foundation ha propuesto las soluciones más utilizadas, a saber, Hadoop y Spark.

Sin embargo, las personas que son nuevas en el procesamiento de big data tienen dificultades para comprender estas dos tecnologías. Para despejar todas las dudas, en este artículo, conoce las diferencias clave entre Hadoop y Spark y cuándo debes elegir uno u otro, o usarlos juntos.

Hadoop

Hadoop es una utilidad de software compuesta por varios módulos que forman un ecosistema para el procesamiento de Big Data. El principio que utiliza Hadoop para este procesamiento es la distribución distribuida de datos para procesarlos en paralelo.

La configuración del sistema de almacenamiento distribuido de Hadoop se compone de varias computadoras ordinarias, formando así un grupo de varios nodos. La adopción de este sistema permite que Hadoop procese de manera eficiente la gran cantidad de datos disponibles mediante la realización de múltiples tareas de forma simultánea, rápida y eficiente.

Los datos procesados con Hadoop pueden tomar muchas formas. Se pueden estructurar como tablas de Excel o tablas en un DBMS convencional. Estos datos también se pueden presentar de forma semiestructurada, como archivos JSON o XML. Hadoop también admite datos no estructurados, como imágenes, videos o archivos de audio.

Componentes principales

Los principales componentes de Hadoop son:

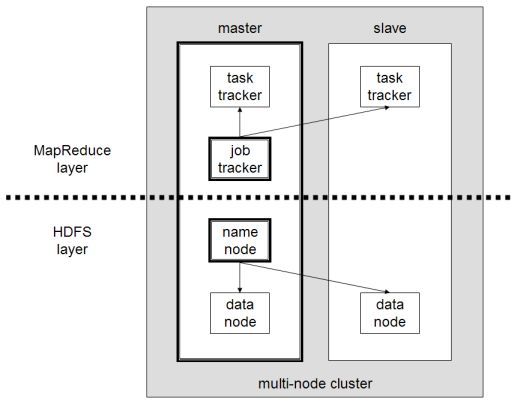

- HDFS o Hadoop Distributed File System es el sistema utilizado por Hadoop para realizar el almacenamiento de datos distribuidos. Está compuesto por un nodo maestro que contiene los metadatos del clúster y varios nodos esclavos en los que se almacenan los datos en sí;

- MapReduce es el modelo algorítmico utilizado para procesar estos datos distribuidos. Este patrón de diseño se puede implementar utilizando varios lenguajes de programación, como Java, R, Scala, Go, JavaScript o Python. Se ejecuta dentro de cada nodo en paralelo;

- Hadoop Common , en el que varias utilidades y bibliotecas admiten otros componentes de Hadoop;

- YARN es una herramienta de orquestación para administrar el recurso en el clúster de Hadoop y la carga de trabajo realizada por cada nodo. También soporta la implementación de MapReduce desde la versión 2.0 de este framework.

chispa apache

Apache Spark es un marco de código abierto creado inicialmente por el científico informático Matei Zaharia como parte de su doctorado en 2009. Luego se unió a Apache Software Foundation en 2010.

Spark es un motor de cálculo y procesamiento de datos distribuido de manera distribuida en varios nodos. La principal especificidad de Spark es que realiza procesamiento en memoria, es decir, utiliza RAM para almacenar en caché y procesar grandes datos distribuidos en el clúster. Le da un mayor rendimiento y una velocidad de procesamiento mucho mayor.

Spark admite varias tareas, incluido el procesamiento por lotes, el procesamiento de flujo real, el aprendizaje automático y el cálculo de gráficos. También podemos procesar datos de varios sistemas, como HDFS, RDBMS o incluso bases de datos NoSQL. La implementación de Spark se puede realizar con varios lenguajes como Scala o Python.

Componentes principales

Los componentes principales de Apache Spark son:

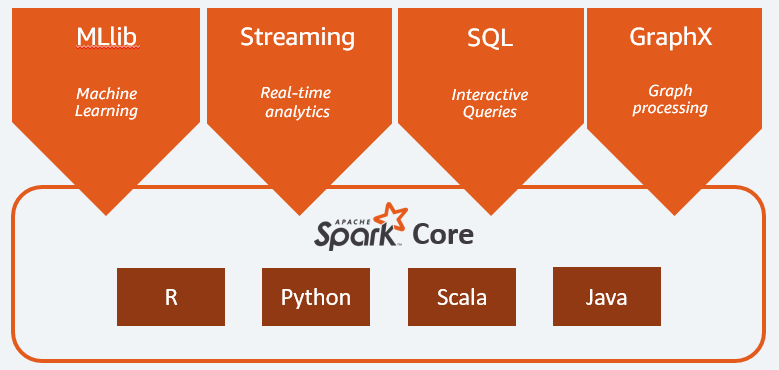

- Spark Core es el motor general de toda la plataforma. Se encarga de planificar y distribuir tareas, coordinar operaciones de entrada/salida o recuperarse de averías;

- Spark SQL es el componente que proporciona el esquema RDD que admite datos estructurados y semiestructurados. En particular, permite optimizar la recopilación y el procesamiento de datos de tipo estructurado mediante la ejecución de SQL o el acceso al motor SQL;

- Spark Streaming que permite el análisis de datos de transmisión. Spark Streaming admite datos de diferentes fuentes, como Flume, Kinesis o Kafka;

- MLib , la biblioteca integrada de Apache Spark para el aprendizaje automático. Proporciona varios algoritmos de aprendizaje automático, así como varias herramientas para crear canalizaciones de aprendizaje automático;

- GraphX combina un conjunto de API para realizar modelado, cálculos y análisis de gráficos dentro de una arquitectura distribuida.

Hadoop vs Spark: diferencias

Spark es un motor de cálculo y procesamiento de datos Big Data. Entonces, en teoría, es un poco como Hadoop MapReduce, que es mucho más rápido ya que se ejecuta en memoria. Entonces, ¿qué hace que Hadoop y Spark sean diferentes? Echemos un vistazo:

- Spark es mucho más eficiente, en particular gracias al procesamiento en memoria, mientras que Hadoop procede por lotes;

- Spark es mucho más caro en términos de costo ya que requiere una cantidad significativa de RAM para mantener su rendimiento. Hadoop, por otro lado, se basa únicamente en una máquina ordinaria para el procesamiento de datos;

- Hadoop es más adecuado para el procesamiento por lotes, mientras que Spark es más adecuado cuando se trata de transmisión de datos o flujos de datos no estructurados;

- Hadoop es más tolerante a fallas, ya que replica datos continuamente, mientras que Spark usa un conjunto de datos distribuido resistente (RDD) que a su vez se basa en HDFS.

- Hadoop es más escalable, ya que solo necesita agregar otra máquina si las existentes ya no son suficientes. Spark se basa en el sistema de otros marcos, como HDFS, para extenderse.

| Factor | Hadoop | Chispa - chispear |

| Procesando | Procesamiento por lotes | Procesamiento en memoria |

| Gestión de archivos | HDFS | Utiliza HDFS de Hadoop |

| Velocidad | Rápido | 10 a 1000 veces más rápido |

| Ayuda de idioma | Java, Python, Scala, R, Go y JavaScript | Java, Python, Scala y R |

| Tolerancia a fallos | Más tolerante | menos tolerante |

| Costo | Menos costoso | Más caro |

| Escalabilidad | Más escalable | Menos escalable |

Hadoop es bueno para

Hadoop es una buena solución si la velocidad de procesamiento no es crítica. Por ejemplo, si el procesamiento de datos se puede realizar durante la noche, tiene sentido considerar el uso de MapReduce de Hadoop.

Hadoop le permite descargar grandes conjuntos de datos de los almacenes de datos donde es comparativamente difícil de procesar, ya que HDFS de Hadoop brinda a las organizaciones una mejor manera de almacenar y procesar datos.

La chispa es buena para:

Los conjuntos de datos distribuidos (RDD) resilientes de Spark permiten múltiples operaciones de mapas en memoria, mientras que Hadoop MapReduce tiene que escribir resultados provisionales en el disco, lo que convierte a Spark en la opción preferida si desea realizar análisis de datos interactivos en tiempo real.

El procesamiento en memoria de Spark y la compatibilidad con bases de datos distribuidas como Cassandra o MongoDB es una excelente solución para la migración e inserción de datos, cuando los datos se recuperan de una base de datos de origen y se envían a otro sistema de destino.

Usar Hadoop y Spark juntos

A menudo tienes que elegir entre Hadoop y Spark; sin embargo, en la mayoría de los casos, elegir puede ser innecesario ya que estos dos marcos pueden coexistir y trabajar juntos muy bien. De hecho, la razón principal detrás del desarrollo de Spark fue mejorar Hadoop en lugar de reemplazarlo.

Como hemos visto en secciones anteriores, Spark se puede integrar con Hadoop utilizando su sistema de almacenamiento HDFS. De hecho, ambos realizan un procesamiento de datos más rápido dentro de un entorno distribuido. Del mismo modo, puede asignar datos en Hadoop y procesarlos con Spark o ejecutar trabajos dentro de Hadoop MapReduce.

Conclusión

Hadoop o Spark? Antes de elegir el marco, debe considerar su arquitectura y las tecnologías que la componen deben ser consistentes con el objetivo que desea lograr. Además, Spark es totalmente compatible con el ecosistema de Hadoop y funciona a la perfección con el sistema de archivos distribuidos de Hadoop y Apache Hive.

También puede explorar algunas herramientas de big data.