Yaygın veri kalitesi sorunları ve bunların üstesinden gelme yolları

Yayınlanan: 2022-04-12Veriye dayalı teknolojiler çağında olmamıza rağmen, üst düzey yöneticilerin %50'den fazlası genellikle analitikten elde edilen değerden memnun değil. Bunun ana nedenlerinden biri düşük veri kalitesidir . Ayrıca, herhangi bir görevin en başında düşük kaliteli verilere sahip olmak, daha sonraki eylemleri işe yaramaz hale getirir. Ek olarak, alınan herhangi bir karar hatalı bilgilere dayanacaktır ve işletmeler için bu kesinlikle kötü bir haberdir.

Bu nedenle, verilerle çalışma konusunda uzun yıllara dayanan deneyimimizi ve uzmanlığımızı paylaşmaya karar verdik. Geçen yıl boyunca, analist arkadaşlarımızla çok konuştuk ve birinci sınıf uzmanlarla çok sayıda röportaj gerçekleştirdik. Şimdi, verilerle çalışırken en sık karşılaşılan sorunlar ve bunların nasıl üstesinden gelineceği konusunda rehberlik sağlamak istiyoruz.

Makalede, bir veri iş akışının aşamalarını, hangi hataların oluşabileceğini ve nedenlerini tartışıyoruz. Ve en önemlisi, veri kalitesi zorluklarını çözmek için yaklaşımları paylaşıyoruz.

İçindekiler

- Veri kalitesi sorunları nereden geliyor?

- Adım 1. Ölçümleri planlayın

- Adım 2. Birincil verileri toplayın

- Adım 3. Ham verileri normalleştirin

- Adım 4. İşe hazır verileri hazırlayın

- OWOX BI ile verilerle ilişkinizi yeniden gözden geçirin

- Adım 5. Verileri görselleştirin

- Önemli çıkarımlar

Başlamadan önce bazı tanımlar:

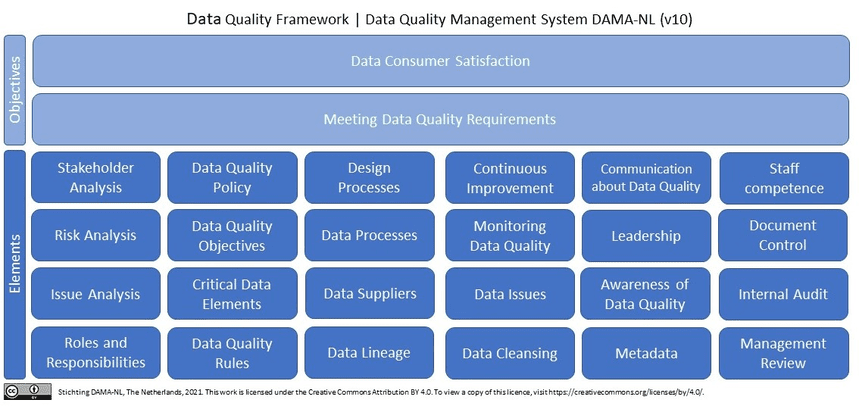

Kaliteli veri nedir? Özetle (ve pazarlama verileri açısından), kaliteli veriler, hatasız ve tutarsızlık içermeyen, alakalı, güncel verilerdir . Wikipedia'da veri kalitesine bakarsak, 10'dan fazla (!) tanım görürüz. Ayrıca Wikipedia, DAMA NL'nin ISO 9001'i referans çerçevesi olarak kullanan veri kalitesi boyutlarının tanımlarına ilişkin en son araştırmasını aktarır.

Pazarlamacılar, analistler ve karar vericiler için kaliteli veriler neden bir zorunluluktur? Kaliteli ve güvenilir veriler olmadan pazarlama analitiğine güvenerek karar vermek imkansızdır.

Veri kalitesi sorunları nereden geliyor?

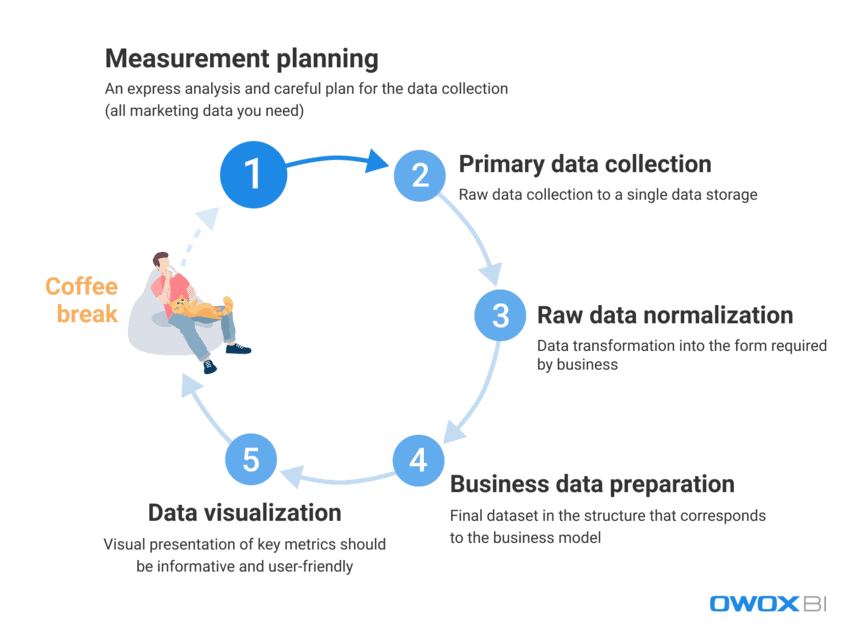

Pazarlamacıların ve analistlerin günlük olarak kullandığı çok büyük miktarda veriyle uğraşırken, hataları ve tutarsızlıkları tamamen ortadan kaldırmak zorlu bir iştir. Nitelikli verileri hemen bir son kullanıcıya sağlamak son derece zordur; ancak, veri hatalarıyla aktif olarak mücadele edilebilir ve proaktif olarak bulunabilir. Her şeyden önce, verilerle çalışma sürecine bakalım ve veri kalitesi sorunlarının ortaya çıkabileceği adımları ayırt edelim:

- Ölçüm planlaması

- Birincil veri toplama

- Ham veri normalleştirme

- İş verilerinin hazırlanması

- Veri goruntuleme

Deneyimlerimize göre, olgusal veri hataları genellikle ilk iki adımda ortaya çıkarken, son adımlarda veri kötüye kullanımı vakaları daha sık görülür.

Bu adımlarda hangi veri kalitesi sorunlarının ortaya çıkabileceğini ve bunların nasıl çözüleceğini daha ayrıntılı olarak görelim.

Adım 1. Ölçümleri planlayın

Bu adımda verilerde herhangi bir hata olmamasına rağmen, tamamen göz ardı edemeyiz. Şeytan ayrıntıda gizlidir ve analiz için veri toplamak ayrıntılı planlama ile başlar. Tavsiyemiz, her zaman hızlı bir analizle başlamanız ve ihtiyacınız olan tüm pazarlama verilerinin toplanmasını dikkatlice planlamanızdır.

Planlama adımını atlamak, yapılandırılmamış bir yaklaşıma ve yeni görevler veya projeler için yeterli veri olmamasına yol açarken amaç, birlikte çalıştığınız tüm veri kaynaklarından parçalı veriler toplamaktır. Tüm verilere sahip değilseniz, kararlarınızı ve eylemlerinizi en baştan hatalı yapar. Yeni projelere başlamadan önce hangi verileri toplamanız gerektiğini görelim:

- Web sitenizden ve/veya uygulamanızdan kullanıcı davranışı verileri

- Reklam platformlarından gelen maliyet verileri

- Çağrı izleme, sohbet robotu ve e-posta verileri

- CRM/ERP sistemlerinizden vb. gelen gerçek satış verileri.

Adım 2. Birincil verileri toplayın

Ölçüm planınızı oluşturduktan sonra birincil veri toplama adımına geçelim. Bu adım sırasında, üstesinden gelmeniz gereken diğer tüm zorlukların yanı sıra, verilerinize erişimi kontrol etmeyi (her şey veri güvenliği ile ilgilidir) ve veri deponuzun veya veri gölünüzün oluşturulması için önceden hazırlanmayı düşünmelisiniz.

Ham verileriniz üzerinde değişiklik yapmadan tam kontrol sahibi olmak istiyorsanız, tavsiyemiz otomatik veri içe aktarma özelliğine sahip tek bir depolama alanı kullanmaktır. Pazarlama ihtiyaçları için Google BigQuery en iyi seçeneklerden biri olmaya devam ediyor.

Bu adımda karşılaşabileceğiniz veri kalitesi zorlukları:

1.1 Bir reklam hizmetinin API'sinden eksik ve yanlış veri alma

Bu ne?

Reklam platformları ve hizmetleri çok büyük miktarda değerli kullanıcı davranışı verisi toplar ve sorun, tüm bu bilgileri eksiksizliğine zarar vermeden bu veri kaynaklarından eksiksiz olarak almaya çalıştığınızda ortaya çıkar.

*Uygulama Programlama Arayüzü (API), veri ileten (istekleri alan ve yanıtlar gönderen), kullanıcı web sitesindeki bir sayfayı her ziyaret ettiğinde kullanıcıyla etkileşime giren sunucunun bir parçasıdır. Çoğu modern web sitesi en az birkaç üçüncü taraf API kullanır.

Bunun ne sorunu var?

Bir reklam hizmeti, bir kullanıcının eylemleri hakkında veri toplar; ancak veriler aktarıldıktan sonra geriye dönük olarak değişebilir ve hizmet API'si güncellenebilir veya bir süre için kullanılamayabilir. Sonuç olarak, verilerin bir kısmı teslim edilmeyecek ve verilerin genel kalitesi bozulacaktır. Analist bunu bilmeyebilir ve iş verilerini hazırlamak için alakasız verileri kullanabilir. Ancak, eksik ve/veya yanlış verilere dayanarak faydalı öngörüler elde etmek veya doğru karar vermek mümkün değildir. Basitçe söylemek gerekirse, çok fazla zaman ve çaba harcayabilir ve yine de ne yararlı veriler ne de performansın işletme için başarılı ve karlı olduğuna dair kanıt olmadan kendinizi merdivenin en altında bulabilirsiniz.

Sebepler neler?

Veri kaybı, tutarsızlıklar veya kopyalar nedeniyle veriler eksik veya yanlış olabilir. Bu sorunların yaygın nedenleri şunlardır:

- Bir reklam platformunda yeni bir hesap oluşturulur, ancak analistler bilgilendirilmez ve bu hesaptan veri toplanmaz.

- API, UTM etiketlerinde dinamik parametreleri desteklemez ve bunları toplamaz veya aktarmaz. UTM etiketlerinde desteklenmeyen parametreler kullanırsanız, değerleri yerine parametre adlarını görürsünüz; örneğin, gerçek kampanya adı yerine {{geo}}.

- Geriye dönük veri güncellemeleri. Reklam hizmetleri genellikle verileri geriye dönük olarak günceller (reklam hesaplarındaki maliyetler, tıklamalar ve gösterimler hakkında). Ancak, tüm analistler bunun farkında değildir ve bunu dikkate almaz.

Bu sorun nasıl çözülür?

API'lerle çalışırken kodu doğrudan kontrol etmek imkansız olduğundan, bu sorunlarla şu yollarla mücadele edebilirsiniz:

- Veri toplama üzerinde daha iyi kontrol sağlamak için veri toplama sırasında sorumluluk alanlarını dağıtmak.

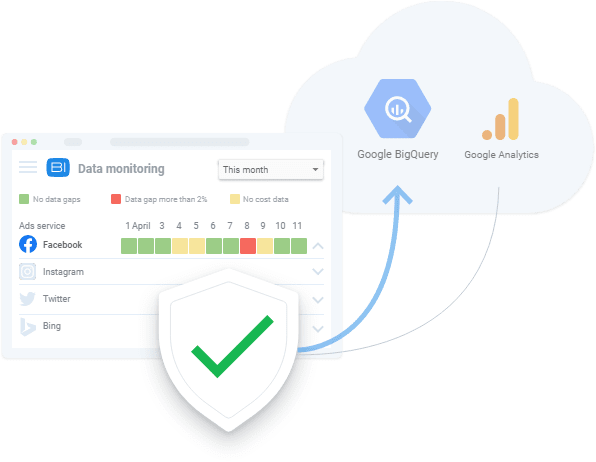

- API değişikliklerini, dinamik parametreleri vb. destekleyen otomatik veri içe aktarma araçlarını kullanma. Verilerin mevcut olmaması durumunda, bu araçlar mevcut veri boşluklarını gösterebilir ve verileri geriye dönük olarak indirebilir.

1.2 Bir web sitesinden eksik ve yanlış veri alınması

Bu ne?

Reklam hizmetlerinden gelen verileri analiz ederek, reklamlara ne kadar harcadığımızı biliyoruz. Web sitesi kullanıcı davranışı verilerinden ne kadar kazandığımız hakkında bilgi alıyoruz. İşle ilgili sorular genellikle “hangi reklamın karşılığını veriyor, hangisi vermiyor?” gibi göründüğünden. gelir/gider oranını bilmek önemlidir.

Bunun ne sorunu var?

Web sitesi kullanıcı davranışına ilişkin veriler, reklamcılık hizmetleri tarafından toplanan maliyet verilerinden farklıdır, çünkü web sitesi kullanıcı davranışına ilişkin veriler:

- doğrudan web sitesi sahipleri tarafından toplanır

- hacim olarak reklam hizmetlerinden gelen maliyet verilerinden önemli ölçüde daha büyüktür

Ayrıca, kullanıcı davranışı verilerinin toplanmadığını fark etmezsek ve sorunu ortadan kaldırmazsak, bu veriler sonsuza kadar kaybolur.

Reklam hizmeti API'lerinden veri toplama problemlerinde olduğu gibi, eksik veya yanlış bilgiler hatalı çözümlere yol açar. Yanlış yönetim kararları, sırayla, gelir kaybına yol açar.

Sebepler neler?

Web sitesi verileri toplanırken hatalar oluşabilir çünkü:

- Tüm web sitesi sayfalarında bir Google Etiket Yöneticisi (GTM) kapsayıcı bulunmaz. GTM, reklam kampanyalarının sonuçlarını ve kullanıcı davranışı verilerini toplar. Bu nedenle sayfada GTM kapsayıcı yoksa veri toplanmaz.

- Google Cloud projesine zamanında ödeme yapılmaz ve bu nedenle veri toplama işlemi beklemeye alınır.

- Web sitesi kullanıcıları tarafından başvuru formlarına girilen verilerin (isim, adres, e-posta vb.) doğruluğu onaylanmamaktadır.

Bu sorun nasıl çözülür?

Bir API'den veri toplamada olduğu gibi, web sitesi veri toplama çözümleri şunları içerir:

- Veri toplama üzerinde daha iyi kontrol sağlamak için veri toplama sırasında sorumluluk alanlarını dağıtmak

- otomatik veri içe aktarma araçlarını kullanma; verilerin mevcut olmaması durumunda, bu araçlar sizi mevcut veri hataları konusunda uyarabilir

2. Birleştirilmiş, örneklenmiş veriler

Bu ne?

Toplulaştırılmış ve örneklenmiş veriler, tüm verilerin işlenmediği ve analiz ve raporlama için kullanılmadığı durumlarda ortaya çıkan genelleştirilmiş verilerdir. Bu, Google Analytics gibi hizmetler, sunucular üzerindeki yükü azaltmak ve veri işleme hızı ile doğruluğunu dengelemek için verilerin yalnızca bir kısmını analiz ettiğinde gerçekleşir. Örnekleme genelleme ile sonuçlandığından, elde edilen sonuçlara güven eksikliğine yol açar.

Bunun ne sorunu var?

Örneklenmiş raporlar performans verilerini bozar ve bu, hedefler, dönüşümler ve gelir gibi parayla ilgili ölçümler söz konusu olduğunda size bir servete mal olabilir. Bu nedenle, karlı bir reklam kampanyası fark etmeme riskiniz vardır ve bir rapordaki çarpık veriler nedeniyle onu kapatabilir veya tam tersi - tüm paranızı verimsiz kampanyalara harcayabilirsiniz.

Başka bir deyişle, örnekleme her uygulandığında, yanlış sonuçlar elde etme riski vardır. Ve verilerin sadece bir kısmına dayanarak bir karar vermeye çalışırsanız, şirketin bütçesiyle tahmin oyunları oynarsınız.

Sebepler neler?

Mümkün olan en kısa sürede raporlar oluşturmak ve kaynakları kurtarmak için sistemler, büyük veri dizilerini işlemek yerine örnekleme, toplama ve filtreleme uygular.

Bu sorun nasıl çözülür?

Veri örneklemesinden kaçınmak için yapabileceğiniz tek şey, ham verileri toplamak ve tüm raporlarınız boyunca verilerin eksiksizliğini sürekli olarak kontrol etmektir. Bu süreç izleme, tercihen insan faktörlerinden kaçınmanın bir yolu olarak otomatik olarak yapılır. Örneğin, OZON'un OWOX BI yardımıyla yaptığı gibi, doğru metrik toplamanın otomatik testini web sitenizde uygulayabilirsiniz.

Adım 3. Ham verileri normalleştirin

Gerekli tüm verileri topladıktan sonra normalleştirme zamanı. Bu adımda, analistler mevcut bilgileri işletmenin gerektirdiği forma dönüştürürler. Örneğin, telefon numaralarını tek bir formatta almalıyız.

Veri normalleştirme, genellikle analistleri faydalı veri içgörüleri çıkarmak gibi daha heyecan verici görevlerden alıkoyan manuel ve rutin bir "maymun işidir". Normalleştirme güçlüklerinin genellikle bir analistin toplam çalışma süresinin %50'sini aldığından bahsetmiyorum bile.

Bu aşamada karşılaşılabilecek veri kalitesi zorlukları:

1. Ekleme, güncelleme ve silme bağımlılıkları

Bu ne?

Bunlar, yapılandırılmamış verilerin normalleştirilmesi sırasında ortaya çıkan zahmetli yan etkilerdir.

Bunun ne sorunu var?

Bu veri bağımlılıklarının ortak sonucu, raporlama sistemlerinin bu tür yanlış verileri analiz ederken atmasıdır. Sonuç olarak, tam verilere dayanmayan hatalı raporlar elde ederiz. Örneğin, bir oturum nesnemiz ve bir reklam nesnemiz olduğunu varsayalım. Seanslarda 10 ila 20 gün için verimiz var ve reklamlarda 10 ila 15 gün arasında veri var (nedense 16 ila 20 gün için herhangi bir maliyet verisi yok). Buna göre, 16 ila 20 gün arasında reklamlardan gelen verileri kaybederiz veya oturumlardan elde edilen veriler yalnızca 10 ila 15 gün arasında kullanılabilir olacaktır.

Sebepler neler?

Bir reklam hizmeti API'si değiştirildiğinde, kullanılamadığında veya yanlış veriler döndürdüğünde istenmeyen yan etkiler ortaya çıkar.

Bu sorun nasıl çözülür?

Aynı şekilde veri toplama hatalarını da kontrol ediyorsun, çalıştığın verileri her zaman doğrulaman gerekiyor. Ayrıca, veri birleştirmenin özellikleri kullanıcı tarafından bilinmiyorsa, veriler normalleştirilirken hatalar meydana gelebilir. Uygulamada, bu adımda en iyi karar, veri anormallikleri durumunda veri kalitesinden sorumlu kişiyi uyaran bir veri kalitesi izleme sistemi geliştirmektir. Bunun için gömülü veri izleme işlevine sahip OWOX BI gibi servisleri kullanabilirsiniz.

Müşterilerimiz

büyümek %22 daha hızlı

Pazarlamanızda en çok neyin işe yaradığını ölçerek daha hızlı büyüyün

Pazarlama verimliliğinizi analiz edin, büyüme alanlarını bulun, yatırım getirisini artırın

Demo alın2. Farklı veri biçimleri, yapıları ve ayrıntı düzeyleri

Bu ne?

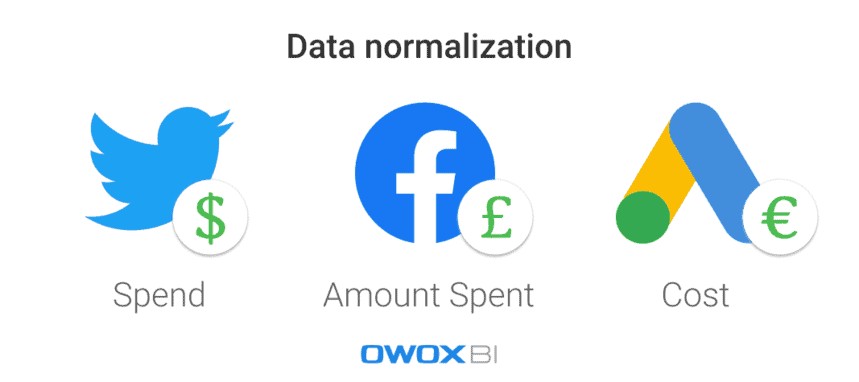

Her reklam platformu veya hizmeti farklı veri biçimleri, para birimleri ve yapılar kullanır. Sonuç olarak, tüm kaynaklardan veri topladıktan sonra, onu tek bir formatta/yapıda normalleştirmeniz gerekir.

Bunun ne sorunu var?

Sahip olduğunuz tek şey yuvarlak ve oval parçalar olduğunda üçgen bir kale inşa etmek zor bir iştir. Farklı formatlarda çok sayıda veri kümeniz olduğunda, verileri birleştirmeden önce bir rapor oluşturamazsınız.

Sebepler neler?

Reklamcılık hizmetlerinde farklı veri şemaları vardır. Örneğin, farklı platformlarda aynı sütuna Ürün Adı ve Ürün Kategorisi adı verilebilir. Başka bir örnek, maliyet verilerinde farklı para birimleri kullanmaktır: örneğin Twitter Reklamları için dolar ve Facebook'ta pound.

Bu sorun nasıl çözülür?

Verileri analiz etmeden önce tek bir formata dönüştürülmesi gerekir; Aksi takdirde, analizinizden iyi bir şey çıkmaz. Örneğin, her bir belirli trafik kaynağının veya pazarlama kanalının etkisini ölçmek ve hangi reklam kampanyalarının size daha fazla gelir getirdiğini görmek için kullanıcı oturumu verilerini reklam maliyeti verileriyle birleştirmelisiniz. Elbette bu, komut dosyaları ve SQL kullanılarak manuel olarak yapılabilir, ancak otomatik çözümler uygulamak daha iyi bir seçimdir.

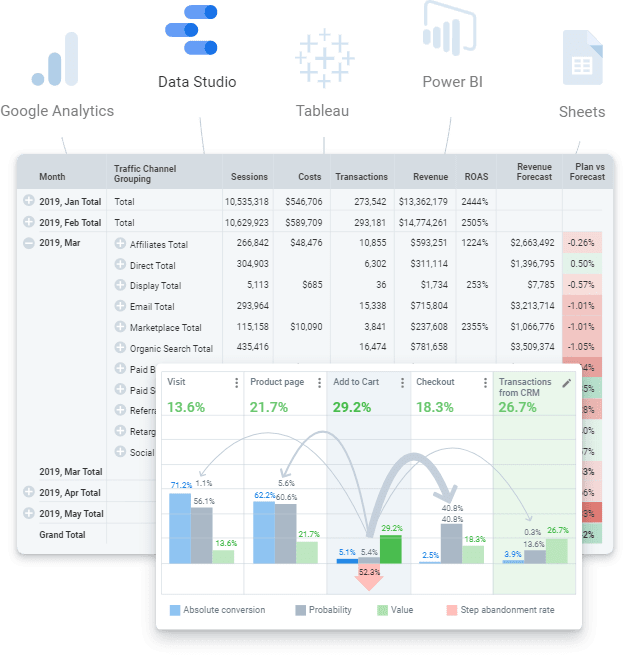

Adım 4. İşe hazır verileri hazırlayın

İş için hazır veriler, iş modeline karşılık gelen yapıda temizlenmiş nihai bir veri kümesidir. Başka bir deyişle, verilerle çalışmanın tüm adımlarını tamamladıysanız ve her şeyi tamamladıysanız, son veri kümesini almalısınız. Herhangi bir veri görselleştirme servisine (Power BI, Tableau, Google Data Studio, vb.) gönderilebilen hazır verileri.

Ancak, bunu, üzerinde bir rapor oluşturmaya çalışabileceğiniz ham verilerle karıştırmamalısınız. Bu, birçok tekrar eden soruna yol açacak hatalı bir yaklaşımdır: hataların ve tutarsızlıkların nedenlerinin bulunması uzun zaman alacaktır ve iş mantığının tüm SQL sorgularında sürekli olarak kopyalanması gerekecektir. Tabii ki, böyle bir ham, yapılandırılmamış veri hacmi, dönüşümlerin mantığındaki değişiklikleri güncel tutmak ve kontrol etmek için zordur. Örneğin, reklam hizmeti ayarladıktan sonra maliyet verileri geçmişini güncelleme gibi sorunlarla karşılaşabilirsiniz. Başka bir örnek, tamamlanmış işlemlerin yeniden satın alınması olabilir. Bu durumda, işlemin geri alınıp alınmadığını anlamak zaman alır, ancak bu durumu sipariş anına bağlamamız gerekir.

Ne yazık ki, bu adımı atlamak ve doğrudan raporu oluşturmaya geçmek yaygın bir uygulamadır. Ancak deneyimlerimiz, son bir veri kümesi kullanmanın ve modern analitik dünyası için iş için hazır verileri hazırlamanın bir zorunluluk olduğunu gösteriyor. Uzun vadede, aynı şeyleri tekrar tekrar yaparak ham veriler arasında dolaşmak yerine hazırlanmış verilerle çalışmak daha ucuz ve daha kolaydır.

Bu adımda hangi veri kalitesi zorlukları ortaya çıkabilir:

1. Veri tanımlarının eksikliği tutarsızlıklara yol açar

Bu ne?

Veri işleme boyunca gereken veri türlerinin tutarsız veya eksik tanımları nedeniyle dönüştürme mantığındaki değişiklikleri kontrol etmek zordur.

Bunun ne sorunu var?

Veriler açıkça tanımlanmadığında, kullanıcılar veri kullanımı konusunda aynı sayfada değildir: hangi tablo veya sütunu sorgulayacaklarından, hangi filtreyi kullanacaklarından veya veri nesneleri hakkında kimden bilgi isteyeceklerinden emin değildirler. Ayrıca, öznitelikleri, veri modelindeki yerleri ve birbirleriyle alakaları dahil olmak üzere ham verilerdeki tüm veri nesnelerinde gezinmek ve bunları anlamak çok uzun sürer.

Sebepler neler?

Bir işletme, temel verilerini ve veri modelini açıkça tanımlamamıştır. Bu nedenle, verileri birleştirme mantığı anlaşılmaz.

Bu sorun nasıl çözülür?

Her şeyden önce, her rapora veya veri kümesine iş mantığını uygulamayın, şirket düzeyinde veri modellemeyi kullanın. Şirket içinde şeffaf bir iş veri modeli ve veri yaşam döngüsünün kontrolü olmalıdır. Bu, kullanılan tüm tanımların açık olması gerektiği anlamına gelir. Örneğin, son kullanıcılar, dönüşüm ve web sitesi ziyaretçi metriklerinin neyi temsil ettiğini bilmelidir.

Bununla birlikte, güncel simüle edilmiş verileri hazırlamak ve sürdürmek zor olduğundan, yanıt, verilerinizi toplayabilen, temizleyebilen, normalleştirebilen ve kalitesini izleyebilen otomatik çözümler (ör. veri oluşturma aracı (dbt)) uygulamakta yatmaktadır. yani iş için hazır.

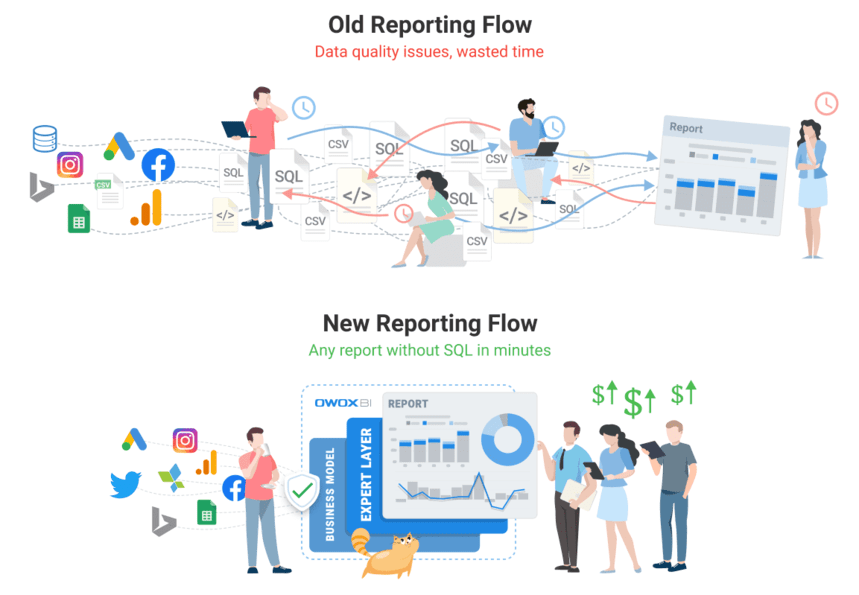

OWOX BI ile verilerle ilişkinizi yeniden gözden geçirin

OWOX BI ekibi, her müşterimiz bu sorunla karşılaştığı için veri sorununun ne kadar ciddi olduğunu herkesten daha iyi biliyor. Analistlerin rutini otomatikleştirmesine, verilerden iş değeri sağlamasına ve veri kalitesini sağlamasına olanak tanıyan bir ürün yaptık.

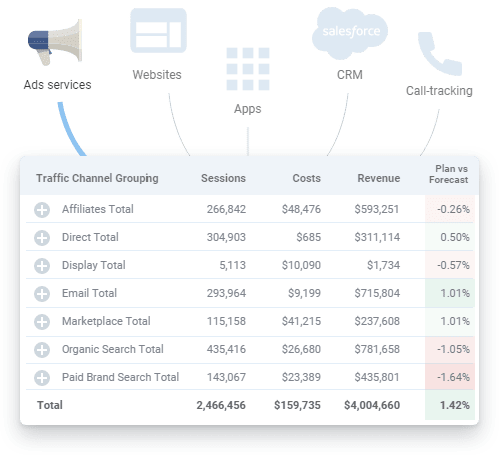

OWOX BI, tüm pazarlama verilerinizi toplamanızı, hazırlamanızı ve analiz etmenizi sağlayan birleşik bir platformdur. Silolanmış kaynaklardan analitik hedefinize veri teslimini otomatikleştirerek verilerin her zaman doğru ve güncel olmasını sağlar.

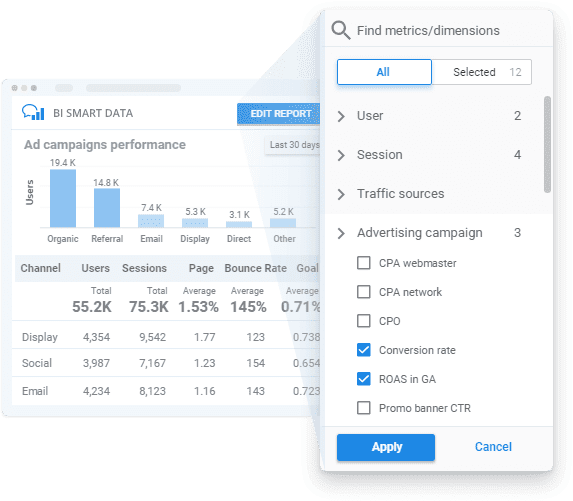

OWOX BI'ı uygulayarak, şeffaf veri kalitesi izleme ve SQL veya kod olmadan içgörülerin kilidini açmak için kullanımı kolay bir rapor oluşturucu ile iş modelinize göre iş için hazır veriler elde edebilirsiniz.

OWOX BI'ın yukarıda bahsettiğimiz tüm adımlarda size nasıl yardımcı olabileceğine bakalım.

- Ölçümlerinizi planlayın . Uzmanlarımızın yardımıyla işletmeniz için bir ölçüm planı oluşturun veya özellikle iş ihtiyaçlarınıza yönelik bir ölçüm sistemi geliştirin.

- Birincil verileri toplayın . OWOX BI, veri deponuzdaki Google Analytics'ten, reklam hizmetlerinden, web sitelerinden, çevrimdışı mağazalardan, çağrı izleme sistemlerinden ve CRM sistemlerinden ham veriler toplar. Platform, büyük reklam hesaplarıyla sorunsuz çalışır ve kampanya sayısı ne olursa olsun tüm verileri yükler. OWOX BI, maliyet verilerini otomatik olarak içe aktarmanın yanı sıra, UTM etiketlerindeki dinamik parametreleri tanır, maliyetleri tek bir para birimine dönüştürür ve verilerin alaka düzeyini izler.

Artık çeşitli bağlayıcılar aramanıza gerek yok ve gerekirse ekibimiz sizin için özel entegrasyonlar bile ayarlayabilir.

- Ham verileri normalleştirin . OWOX BI kullanırken verileri manuel olarak temizlemeniz, yapılandırmanız ve işlemeniz gerekmez. En net ve en uygun yapıda hazır veri setleri alacaksınız. Ayrıca, istediğiniz zaman Google Analytics'e yüklenen reklamcılık hizmetlerinden gelen verilerin alaka düzeyi hakkında görsel bir rapor alabilirsiniz.

- İş verilerini hazırlayın . OWOX BI ile, parmaklarınızın ucunda güvenilir iş için hazır verilere sahipsiniz. İş veri modelinize göre önceden oluşturulmuş nihai veri kümelerini aldığınız için artık her yeni rapor için yeni bir veri kümesi oluşturmaya gerek yoktur. Daha fazla veri segmentasyonu için hazır olan güncel ve birleştirilmiş verilerle, işletmenizin hızına ilişkin öngörüler elde edebilir ve verilerinizin değerini artırabilirsiniz.

- Verileri görselleştirin . OWOX BI platformu, verilerinizi istediğiniz yerde analiz etmenize ve görselleştirmenize olanak tanır. Pazarlama verileriniz hazır olduğunda, birkaç tıklama ile seçtiğiniz BI veya görselleştirme aracına gönderebilirsiniz.

OWOX BI'nin veri kalitesini nasıl garanti ettiğini ve tam otomatik veri yönetiminden bugün nasıl yararlanabileceğinizi görmek için ücretsiz bir demo rezervasyonu yapın!

Adım 5. Verileri görselleştirin

Temel metrikleri görsel olarak sunmak, verilerin çalışmasını sağlamak için son adımdır, bu nedenle veri sunumunuz hem bilgilendirici hem de kullanıcı dostu olmalıdır. Otomatikleştirilmiş ve uygun şekilde yapılandırılmış görselleştirmeler, bir sorun bulma süresini önemli ölçüde azaltabilir; diğer bir deyişle, veri kalitesini iyileştirmek için aynı dönemde daha az çabayla daha fazla yineleme gerçekleştirebilirsiniz.

Ayrıca, popüler Google Data Studio gibi veri görselleştirme hizmetlerinin verileri birleştiremediğini veya dönüştüremediğini hatırlamak önemlidir. Çok sayıda veri kaynağına dayalı raporlara ihtiyacınız varsa, herhangi bir zorluk yaşamamak için ihtiyacınız olan tüm verileri önceden tek bir veri deposunda toplamanız önerilir.

Bu adımda karşılaşabileceğiniz veri kalitesi zorlukları:

1. Gerçek veri hataları

Bunlar nedir?

Önceki veri toplama ve normalleştirme seviyelerinde bir şeyler ters gittiğinde, veri hataları, veri görselleştirme servisleri tarafından gösterilen raporlara dönüşebilir.

Bunun ne sorunu var?

Gerçek veri hatalarıyla oluşturulan raporlar zaman ve para kaybıdır. İşletme için risk ve büyüme bölgelerine ilişkin kâr veya değerli bilgiler sağlamazlar. Üzgünüm Mario, ama prenses başka bir kalede!

Sebepler neler?

Basitçe söylemek gerekirse, görselleştirilmiş veriler alakalı değildir. Ancak, bu hataların kaynağını bulmak için verilerinizi tekrar doğrulamaya kadar geri dönmelisiniz.

Bu sorun nasıl çözülür?

Bu sorunu çözmenin tek yolu, verileri kapsamlı bir şekilde hazırlamak ve raporları oluşturmadan önce kalitesini izlemek.

2. Bozuk SQL sorguları veya raporlarda (ve/veya SQL sorgularında) çok fazla düzenleme

Bu ne?

Veri gereksinimleri sürekli değişiyor ve SQL sorguları da değişiyor. Sonuç olarak, raporlama sistemi ne kadar karmaşık hale gelirse, bozulması o kadar kolay olur.

Bunun ne sorunu var?

Hangi değişikliklerin, nerede ve ne zaman yapıldığını hatırlamak imkansız olduğu sürece, değişikliklerde yanlış bir şey yoktur. Sonunda, SQL sorguları çalışmadığından ve görselleştirilecek doğru veri olmadığından, özenle oluşturulmuş tüm raporlama sistemleri ortadan kalkabilir.

Sebepler neler?

Her küçük şeyi hatırlamak oldukça zordur, bu nedenle tipik hata, gerekli olan tüm veri kümelerine düzenlemeleri uygulamayı unutmaktır.

Bu sorun nasıl çözülür?

İdeal olarak, kullanıcılar çok sayıda SQL sorgusu kullanmadan ve çok sayıda değişiklik ve/veya düzenleme uygulamadan pazarlama raporları oluşturabilmelidir.

3. Toplanan verilerin yanlış anlaşılması ve kötüye kullanılması

Bu ne?

En yaygın sorunlardan biri, verileri yanlış anlamaktır (ve bu nedenle, yanlış kullanmaktır). Bu, belirli bir metrik veya parametre birden fazla şekilde yorumlanabildiğinde gerçekleşir. Örneğin, bir raporda bir dönüşüm metriği olduğunu ve bu raporun farklı kullanıcılar tarafından kullanıldığını varsayalım. Kullanıcılardan biri, dönüşümün web sitesi ziyareti anlamına geldiğini düşünürken, diğeri sipariş vermek anlamına geldiğini düşünüyor. Ancak, bu dönüşüm metriğinin teslim edilen ve satın alınan siparişlerle ilgili olduğunu düşünen üçüncü bir kişi de var. Gördüğünüz gibi, birçok olası yorum var, bu nedenle raporda hangi bilgilerin sunulduğunu netleştirmelisiniz.

Bunun ne sorunu var?

Raporlarda ve gösterge tablolarında hangi verilerin kullanıldığı konusunda net bir anlayış yoksa, kararlarınızın sahadaki gerçeklere dayanacağının garantisi yoktur.

Sebepler neler?

Raporlarda kullanılan metriklerin ve parametrelerin net olmayan bir açıklaması veya uygun olmayan bir veri görselleştirme türü, hatalı kararlara yol açabilir.

Bu sorun nasıl çözülür?

Giriş verilerinizin doğru ve alakalı olduğundan emin olduğunuzda veri doğrulaması sona ermez. Bu veriler yine de kötüye kullanılabilir. Bu sorunu önlemek için, son kullanıcıların raporlarda hangi bilgilerin sunulduğuna dair açık ve kesin açıklamalar içeren eksiksiz, güncel, iş için hazır verilere erişmesi gerekir.

Müşterilerimiz

büyümek %22 daha hızlı

Pazarlamanızda en çok neyin işe yaradığını ölçerek daha hızlı büyüyün

Pazarlama verimliliğinizi analiz edin, büyüme alanlarını bulun, yatırım getirisini artırın

Demo alınÖnemli çıkarımlar

Kaliteli analitik, kaliteli verilerle başlar. Veri çabalarınız değerli ve güvenilir olmalıdır. Bu nedenle, bütünsel performans raporlaması elde etmek ve verilerinizin kalitesini artırmak için veri hatalarını ve tutarsızlıklarını proaktif olarak belirlemeli ve bunlarla mücadele etmelisiniz. Genel olarak, veri kalitesinin iyileştirilmesi, üç adımın ayırt edilebildiği yinelemeli bir süreçtir:

- Verilerinizin durumunu inceleme

- Veri kalitesini düşüren bir sorunu yerelleştirme

- sorunu düzeltme

En çok zaman alan ilk iki adımdır. Bir sorunun var olduğunu belirlemek ve hangi durumlarda bir hatanın ortaya çıktığını anlamak zordur. Sorunun ne olduğu ve nerede olduğu netleştikten sonra, onu düzeltmenin nispeten kolay olduğu ortaya çıkıyor.

Son olarak, verilerinizi geliştirmek için üç belge oluşturabilirsiniz:

- Veri taşıma şeması

- Sorumluluk matrisi (kim, neyden sorumlu)

- İş veri modeli