Problemas comunes de calidad de datos y cómo superarlos

Publicado: 2022-04-12Aunque estamos en la era de las tecnologías basadas en datos, más del 50 % de los altos ejecutivos generalmente no están satisfechos con el valor obtenido de la analítica. Una de las principales razones de esto es la mala calidad de los datos . Además, tener datos de mala calidad al comienzo de cualquier tarea hace que las acciones posteriores sean inútiles. Además, cualquier decisión que se tome se basará en información defectuosa, y para las empresas, esto sin duda es una mala noticia.

Es por eso que hemos decidido compartir nuestros muchos años de experiencia y conocimientos en el trabajo con datos. Durante el año pasado, hablamos mucho con nuestros compañeros analistas y realizamos muchas entrevistas con especialistas de clase mundial. Ahora queremos brindar una guía sobre los problemas más frecuentes al trabajar con datos y cómo superarlos.

En el artículo, discutimos las etapas de un flujo de trabajo de datos, qué errores pueden ocurrir y por qué. Y lo más importante, compartimos enfoques para resolver las dificultades de calidad de los datos.

Tabla de contenido

- ¿De dónde vienen los problemas de calidad de los datos?

- Paso 1. Mediciones del plan

- Paso 2. Recopilar datos primarios

- Paso 3. Normalice los datos sin procesar

- Paso 4. Prepare datos listos para el negocio

- Reconsidere su relación con los datos con OWOX BI

- Paso 5. Visualiza datos

- Conclusiones clave

Algunas definiciones antes de comenzar:

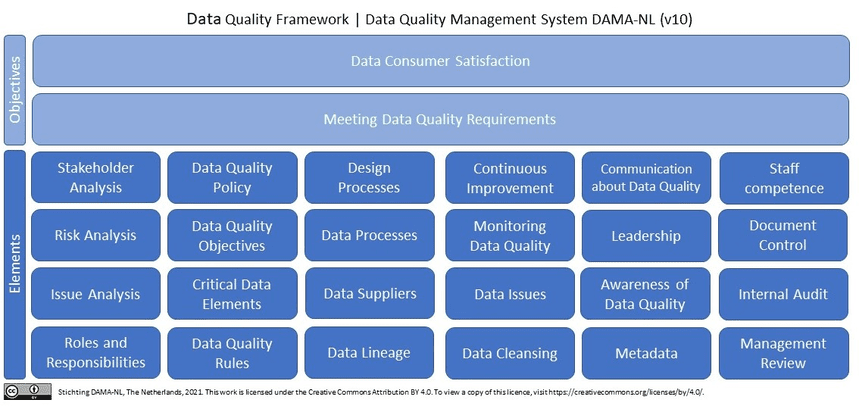

¿Qué son los datos de calidad? En pocas palabras (y en términos de datos de marketing), los datos de calidad son datos relevantes y actualizados sin errores ni discrepancias . Si buscamos la calidad de los datos en Wikipedia, veremos más de 10 (!) definiciones. Además, Wikipedia cita la última investigación de DAMA NL sobre las definiciones de las dimensiones de la calidad de los datos utilizando ISO 9001 como marco de referencia.

¿Por qué los datos de calidad son imprescindibles para los profesionales del marketing, los analistas y los responsables de la toma de decisiones? Sin datos confiables y de calidad, es imposible tomar decisiones basadas en análisis de marketing.

¿De dónde vienen los problemas de calidad de los datos?

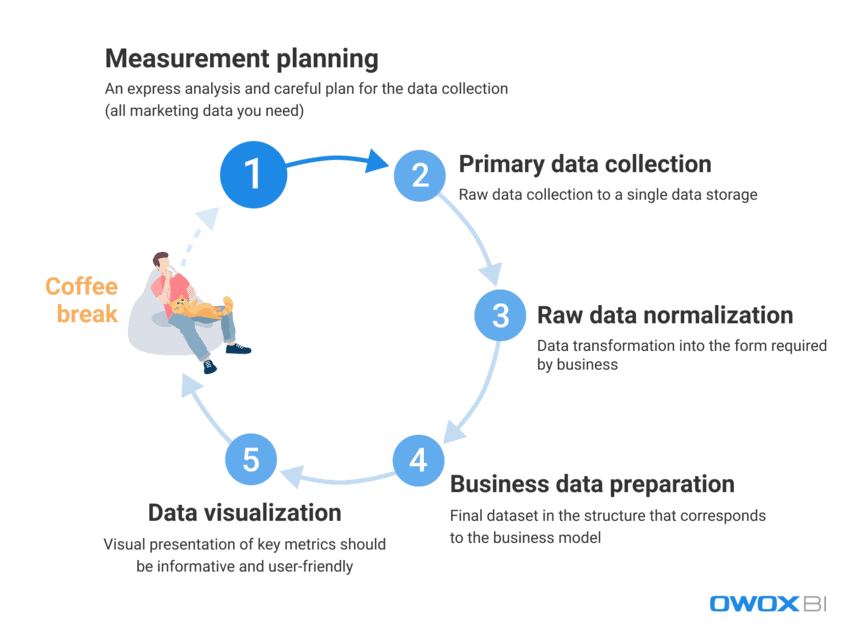

Al lidiar con la gran cantidad de datos que los especialistas en marketing y analistas usan a diario, es un desafío eliminar por completo los errores y las discrepancias. Es extremadamente difícil proporcionar inmediatamente datos de calidad a un usuario final; sin embargo, los errores de datos se pueden combatir activamente y encontrar de manera proactiva. En primer lugar, veamos el proceso de trabajar con datos y distingamos los pasos en los que pueden aparecer problemas de calidad de datos:

- Planificación de la medición

- Recopilación de datos primarios

- Normalización de datos sin procesar

- Preparación de datos comerciales

- Visualización de datos

En nuestra experiencia, los errores de datos fácticos suelen aparecer en los dos primeros pasos, mientras que los casos de uso indebido de datos ocurren con mayor frecuencia durante los últimos pasos.

Veamos con más detalle qué problemas de calidad de datos pueden surgir en estos pasos y cómo solucionarlos.

Paso 1. Mediciones del plan

Aunque no hay errores en los datos en este paso, no podemos omitirlos por completo. El diablo está en los detalles, y la recopilación de datos para el análisis comienza con una planificación detallada. Nuestra recomendación es comenzar siempre con un análisis rápido y planificar cuidadosamente la recopilación de todos los datos de marketing que necesita.

Omitir el paso de planificación conduce a un enfoque no estructurado y a la falta de datos suficientes para nuevas tareas o proyectos, mientras que el objetivo es recopilar datos fragmentados de todas las fuentes de datos con las que trabaja. Si no tiene todos los datos, hace que sus decisiones y acciones sean defectuosas desde el principio. Veamos qué datos debes recopilar antes de iniciar nuevos proyectos:

- Datos de comportamiento del usuario de su sitio web y/o aplicación

- Datos de costes de las plataformas publicitarias

- Seguimiento de llamadas, chatbot y datos de correo electrónico

- Datos de ventas reales de sus sistemas CRM/ERP, etc.

Paso 2. Recopilar datos primarios

Una vez que haya creado su plan de medición, pasemos al paso principal de recopilación de datos. Durante este paso, entre todos los demás desafíos que debe superar, debe considerar controlar el acceso a sus datos (se trata de la seguridad de los datos) y prepararse con anticipación para la creación de su almacenamiento de datos o lago de datos.

Si desea obtener un control completo sobre sus datos sin modificar, nuestra recomendación es utilizar un único almacenamiento con importación de datos automatizada. Para las necesidades de marketing, Google BigQuery sigue siendo una de las mejores opciones.

Qué dificultades de calidad de datos puede encontrar en este paso:

1.1 Obtener datos incompletos e incorrectos de la API de un servicio de publicidad

¿Que es esto?

Las plataformas y los servicios publicitarios recopilan grandes cantidades de datos valiosos sobre el comportamiento de los usuarios, y el problema ocurre cuando intenta obtener toda esta información de estas fuentes de datos sin dañar su integridad.

*Una Interfaz de Programación de Aplicaciones (API) es una parte del servidor que transmite datos (recibe solicitudes y envía respuestas), interactuando con el usuario cada vez que el usuario visita una página en el sitio web. La mayoría de los sitios web modernos utilizan al menos varias API de terceros.

¿Qué está mal con eso?

Un servicio de publicidad recopila datos sobre las acciones de un usuario; sin embargo, los datos pueden cambiar retrospectivamente después de que se transfieran, y la API del servicio puede actualizarse o no estar disponible durante algún tiempo. Como resultado, parte de los datos simplemente no se entregará y la calidad general de los datos se corromperá. El analista puede no saber acerca de esto y puede usar datos irrelevantes para preparar datos comerciales. Sin embargo, no es posible obtener información útil o tomar la decisión correcta en función de datos incompletos o inexactos. En pocas palabras, puede invertir mucho tiempo y esfuerzo y aun así volver a encontrarse en la parte inferior de la escalera sin datos útiles ni pruebas de que el rendimiento es exitoso y rentable para el negocio.

¿Cuales son las razones?

Los datos pueden estar incompletos o ser incorrectos debido a la pérdida de datos, discrepancias o duplicados. Las razones comunes para estos problemas incluyen:

- Se crea una nueva cuenta en una plataforma de publicidad, pero no se informa a los analistas y no se recopilan datos de ella.

- Una API no admite parámetros dinámicos en etiquetas UTM y no los recopila ni los transfiere. Si usa parámetros no admitidos en las etiquetas UTM, verá los nombres de los parámetros en lugar de sus valores; por ejemplo, {{geo}} en lugar del nombre real de la campaña.

- Actualizaciones retrospectivas de datos. Los servicios de publicidad a menudo actualizan retrospectivamente los datos (sobre costos, clics e impresiones en cuentas de publicidad). Sin embargo, no todos los analistas son conscientes de ello y lo tienen en cuenta.

¿Cómo resolver este problema?

Dado que es imposible controlar directamente el código cuando se trabaja con API, puede combatir estos problemas de la siguiente manera:

- distribuir áreas de responsabilidad durante la recopilación de datos para obtener un mejor control sobre la recopilación de datos.

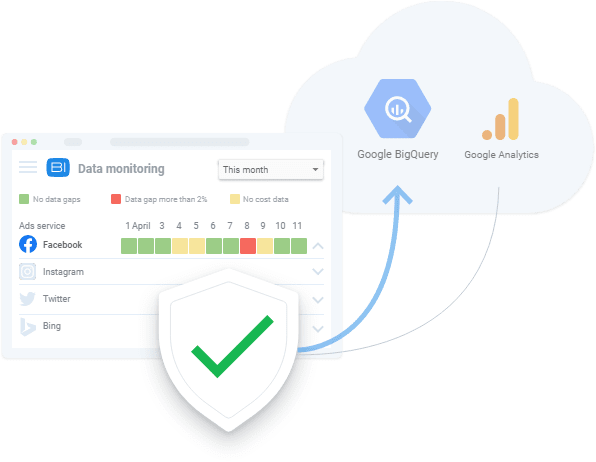

- utilizando herramientas de importación de datos automatizadas que admitan cambios de API, parámetros dinámicos, etc. En caso de que los datos no estén disponibles, estas herramientas pueden mostrar las brechas de datos existentes y descargar datos de forma retrospectiva.

1.2 Obtener datos incompletos e incorrectos de un sitio web

¿Que es esto?

Al analizar los datos de los servicios publicitarios, sabemos cuánto gastamos en publicidad. Mientras que de los datos de comportamiento de los usuarios del sitio web, obtenemos información sobre cuánto ganamos. Dado que las preguntas comerciales suelen sonar como "¿qué publicidad vale la pena y cuál no?" es fundamental conocer la relación ingresos/gastos.

¿Qué está mal con eso?

Los datos sobre el comportamiento del usuario del sitio web difieren de los datos de costos recopilados por los servicios de publicidad porque los datos sobre el comportamiento del usuario del sitio web:

- es recopilado directamente por los propietarios del sitio web

- es significativamente mayor en volumen que los datos de costos de los servicios de publicidad

Además, si no nos damos cuenta de que no hay recopilación de datos de comportamiento del usuario y no eliminamos el problema, entonces estos datos se perderán para siempre.

Al igual que con los problemas de recopilación de datos de las API de los servicios de publicidad, la información incompleta o incorrecta conduce a soluciones erróneas. Las decisiones de gestión incorrectas, a su vez, conducen a una pérdida de ingresos.

¿Cuales son las razones?

Pueden ocurrir errores al recopilar datos del sitio web porque:

- No todas las páginas del sitio web tienen un contenedor de Google Tag Manager (GTM). GTM recoge el resultado de campañas publicitarias y datos de comportamiento de los usuarios. Por lo tanto, si no hay un contenedor GTM en la página, no se recopilan datos.

- El proyecto de Google Cloud no se paga a tiempo y, por lo tanto, la recopilación de datos se suspende.

- No se valida la exactitud de los datos introducidos en los formularios de solicitud por los usuarios del sitio web (nombre, dirección, correo electrónico, etc.).

¿Cómo resolver este problema?

Al igual que con la recopilación de datos de una API, las soluciones para la recopilación de datos de sitios web incluyen:

- distribuir áreas de responsabilidad durante la recopilación de datos para obtener un mejor control sobre la recopilación de datos

- usar herramientas de importación de datos automatizadas; en caso de que los datos no estén disponibles, estas herramientas pueden advertirle sobre errores de datos existentes

2. Obtener datos agregados y muestreados

¿Que es esto?

Los datos agregados y muestreados son datos generalizados que aparecen en los casos en que no todos los datos se procesan y utilizan para el análisis y la elaboración de informes. Esto sucede cuando servicios como Google Analytics analizan solo una parte de los datos para reducir la carga en los servidores y equilibrar la velocidad y la precisión del procesamiento de datos. Dado que el muestreo resulta en generalización, conduce a una falta de confianza en los resultados obtenidos.

¿Qué está mal con eso?

Los informes de muestra distorsionan los datos de rendimiento y eso puede costarle una fortuna cuando se trata de métricas relacionadas con el dinero, como objetivos, conversiones e ingresos. Debido a esto, corre el riesgo de no notar una campaña publicitaria rentable y puede apagarla debido a datos distorsionados en un informe, o viceversa: puede gastar todo su dinero en campañas ineficientes.

En otras palabras, cada vez que se aplica el muestreo, existe el riesgo de obtener resultados inexactos. Y si intenta tomar una decisión basándose solo en una parte de los datos, juega a las adivinanzas con el presupuesto de la empresa.

¿Cuales son las razones?

En un intento por crear informes lo antes posible y ahorrar recursos, los sistemas aplican muestreo, agregación y filtrado en lugar de procesar conjuntos de datos masivos.

¿Cómo resolver este problema?

Lo único que puede hacer para evitar el muestreo de datos es recopilar datos sin procesar y verificar constantemente la integridad de los datos en todos sus informes. Esta monitorización del proceso se realiza preferiblemente de forma automática como una forma de eludir los factores humanos. Por ejemplo, puede aplicar pruebas automáticas de recopilación de métricas correctas en su sitio web como lo hizo OZON con la ayuda de OWOX BI.

Paso 3. Normalice los datos sin procesar

Después de recopilar todos los datos necesarios, es hora de normalizarlo. En este paso, los analistas convierten la información disponible en la forma requerida por el negocio. Por ejemplo, debemos obtener los números de teléfono en un solo formato.

La normalización de datos es un "trabajo de mono" manual y rutinario que generalmente evita que los analistas realicen tareas más emocionantes, como extraer información útil de datos. Sin mencionar que las dificultades de normalización suelen ocupar hasta el 50 % del tiempo de trabajo total de un analista.

Dificultades de calidad de datos que se pueden encontrar en esta etapa:

1. Dependencias de inserción, actualización y eliminación

¿Que es esto?

Estos son efectos secundarios problemáticos que aparecen durante la normalización de datos no estructurados.

¿Qué está mal con eso?

El resultado común de estas dependencias de datos es que los sistemas de informes descartan dichos datos incorrectos mientras los analizan. Como resultado, terminamos con informes inexactos que no se basan en datos completos. Por ejemplo, supongamos que tenemos un objeto de sesiones y un objeto de anuncios. En las sesiones, tenemos datos de los días 10 a 20, y en los anuncios, hay datos de los días 10 a 15 (por alguna razón, no hay datos de costos de los días 16 a 20). En consecuencia, perdemos los datos de los anuncios de los días 16 a 20, o los datos de las sesiones solo estarán disponibles durante los días 10 a 15.

¿Cuales son las razones?

Los efectos secundarios no deseados aparecen cuando se cambia una API de servicio de publicidad, no está disponible o devuelve datos incorrectos.

¿Cómo resolver este problema?

De la misma forma que verificas los errores de recopilación de datos, siempre debes verificar los datos con los que trabajas. Además, si el usuario no conoce los detalles de la combinación de datos, es probable que se produzcan errores al normalizar los datos. En la práctica, la mejor decisión en este paso es desarrollar un sistema de monitoreo de la calidad de los datos que alerte a la persona responsable de la calidad de los datos en caso de anomalías en los datos. Para ello, puede utilizar servicios como OWOX BI con su función de supervisión de datos integrada.

Nuestros clientes

crecer 22% más rápido

Crezca más rápido midiendo lo que funciona mejor en su marketing

Analice su eficiencia de marketing, encuentre las áreas de crecimiento, aumente el ROI

Obtener demostración2. Diferentes formatos de datos, estructuras y niveles de detalle

¿Que es esto?

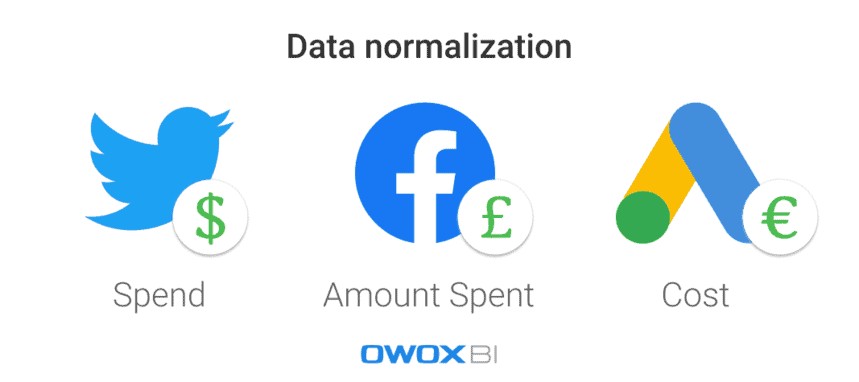

Cada plataforma o servicio de publicidad utiliza diferentes formatos de datos, monedas y estructuras. Como resultado, después de haber recopilado datos de todas las fuentes, debe normalizarlos en un solo formato/estructura.

¿Qué está mal con eso?

Es una tarea difícil construir una fortaleza triangular cuando todo lo que tienes son piezas redondas y ovaladas. Cuando tiene muchos conjuntos de datos en diferentes formatos, simplemente no puede crear un informe antes de unificar los datos.

¿Cuales son las razones?

Hay diferentes esquemas de datos en los servicios de publicidad. Por ejemplo, la misma columna en diferentes plataformas puede denominarse Nombre del producto y Categoría del producto. Otro ejemplo es el uso de diferentes monedas en los datos de costos: dólares para Twitter Ads y libras en Facebook, por ejemplo.

¿Cómo resolver este problema?

Antes de analizar los datos, se deben convertir a un solo formato; de lo contrario, nada bueno saldrá de su análisis. Por ejemplo, debe fusionar los datos de la sesión de usuario con los datos de costos publicitarios para medir el impacto de cada fuente de tráfico o canal de marketing en particular y para ver qué campañas publicitarias le generan más ingresos. Por supuesto, esto se puede hacer manualmente utilizando scripts y SQL, pero aplicar soluciones automatizadas es una mejor opción.

Paso 4. Prepare datos listos para el negocio

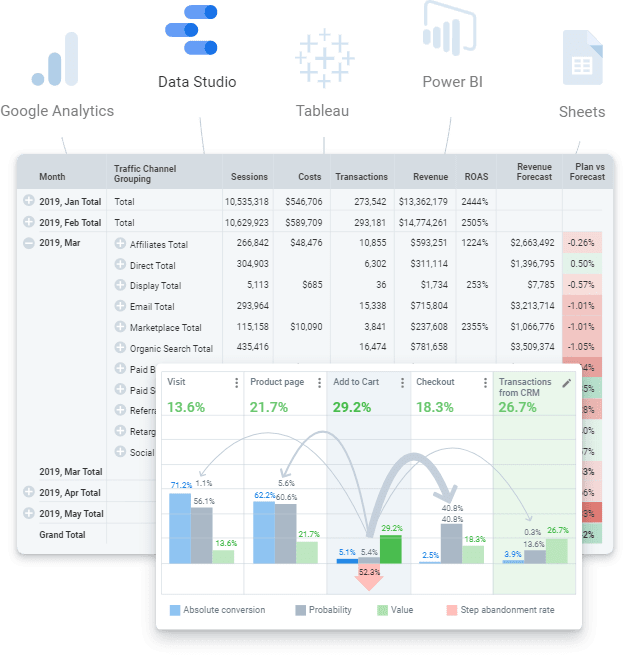

Los datos listos para el negocio son un conjunto de datos final limpio en la estructura que corresponde al modelo de negocio. En otras palabras, si ha realizado todos los pasos para trabajar con datos y ha completado todo, debe obtener el conjunto de datos final. Sus datos listos para usar que se pueden enviar a cualquier servicio de visualización de datos (Power BI, Tableau, Google Data Studio, etc.).

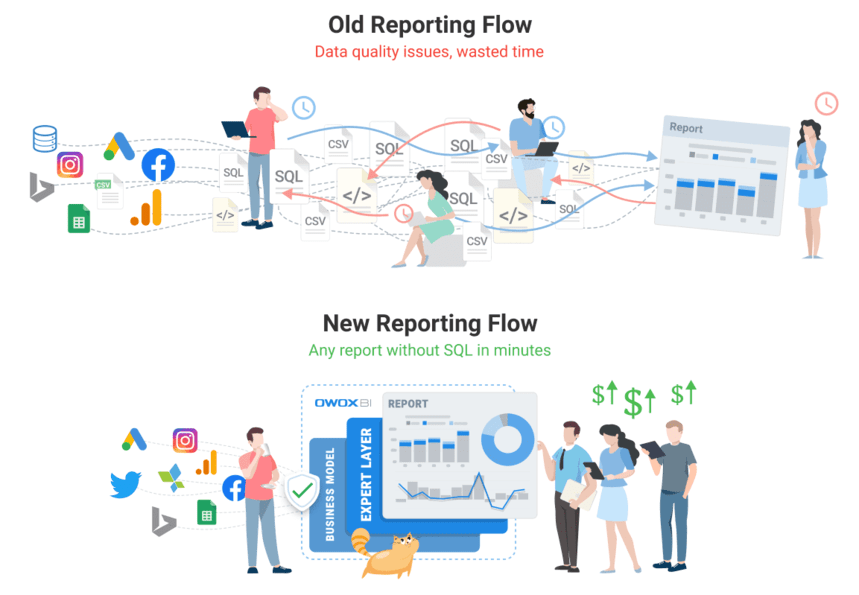

Sin embargo, no debe confundirlo con datos sin procesar sobre los que puede intentar crear un informe. Es un enfoque erróneo que implicará muchos problemas recurrentes: la búsqueda de errores y las causas de las discrepancias llevará mucho tiempo y la lógica empresarial deberá duplicarse constantemente en todas las consultas SQL. Por supuesto, es un desafío mantener actualizado y controlar los cambios en la lógica de las transformaciones un volumen tan grande de datos sin estructurar y sin procesar. Por ejemplo, puede encontrar problemas como actualizar el historial de datos de costos después de que el servicio de publicidad lo haya ajustado. Otro ejemplo podría ser la recompra de transacciones completadas. En este caso, se necesita tiempo para comprender si la transacción se ha canjeado, pero debemos atribuir este estado al momento del pedido.

Desafortunadamente, es una práctica común omitir este paso y pasar directamente a crear el informe. Sin embargo, nuestra experiencia demuestra que es imprescindible utilizar un conjunto de datos final y preparar datos listos para el negocio para el mundo moderno de la analítica. A la larga, es más barato y más fácil trabajar con datos preparados en lugar de trabajar con datos sin procesar haciendo las mismas cosas una y otra vez.

Qué dificultades de calidad de datos pueden aparecer durante este paso:

1. La falta de definiciones de datos conduce a discrepancias

¿Que es esto?

Es difícil controlar los cambios en la lógica de transformación debido a definiciones inconsistentes o ausentes de los tipos de datos requeridos durante el procesamiento de datos.

¿Qué está mal con eso?

Cuando los datos no están claramente definidos, los usuarios no están en la misma página sobre el uso de datos: no están seguros de qué tabla o columna consultar, qué filtro usar o a quién pedir información sobre los objetos de datos. Además, lleva demasiado tiempo navegar y comprender todos los objetos de datos a partir de datos sin procesar, incluidos sus atributos, su lugar en el modelo de datos y su relevancia entre sí.

¿Cuales son las razones?

Una empresa no ha definido claramente sus datos principales y su modelo de datos. Por lo tanto, la lógica para fusionar datos es incomprensible.

¿Cómo resolver este problema?

En primer lugar, no aplique la lógica empresarial a cada informe o conjunto de datos, sino que utilice el modelado de datos a nivel de empresa. Dentro de la empresa, debe haber un modelo de datos comerciales transparente y un control del ciclo de vida de los datos. Esto significa que todas las definiciones utilizadas deben ser claras. Por ejemplo, los usuarios finales deben saber qué representan las métricas de conversión y visitantes del sitio web.

Junto con eso, como es un desafío preparar y mantener datos simulados actualizados, la respuesta radica en aplicar soluciones automatizadas (por ejemplo, herramienta de creación de datos (dbt)) que pueden recopilar, limpiar, normalizar y monitorear la calidad de sus datos. así que está listo para el negocio.

Reconsidere su relación con los datos con OWOX BI

El equipo de BI de OWOX sabe mejor que nadie cuán grave es el problema de los datos, ya que cada uno de nuestros clientes se encuentra con él. Hemos creado un producto que permite a los analistas automatizar la rutina, ofrecer valor comercial a partir de los datos y garantizar la calidad de los datos.

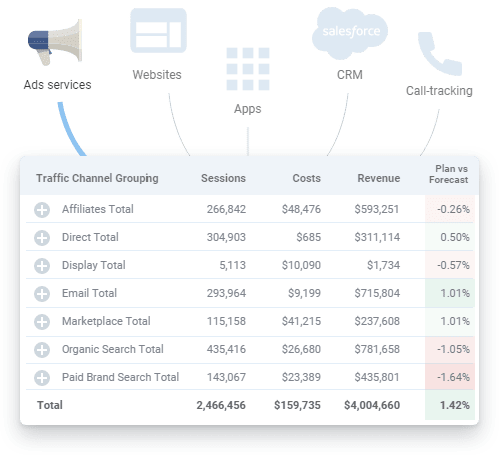

OWOX BI es una plataforma unificada que le permite recopilar, preparar y analizar todos sus datos de marketing. Automatiza la entrega de datos desde fuentes aisladas a su destino de análisis, asegurando que los datos sean siempre precisos y actualizados.

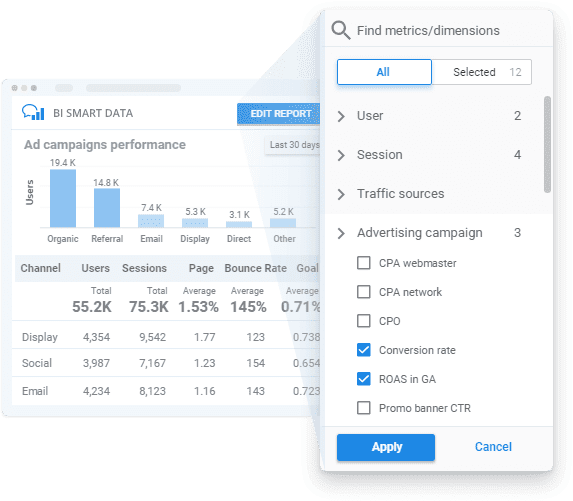

Al aplicar OWOX BI, puede obtener datos listos para el negocio de acuerdo con su modelo comercial con un monitoreo transparente de la calidad de los datos y un generador de informes fácil de usar para desbloquear información sin SQL ni código.

Veamos cómo OWOX BI puede ayudarlo en todos los pasos que mencionamos anteriormente.

- Planifica tus medidas . Cree un plan de medición para su negocio o desarrolle un sistema de métricas especialmente para las necesidades de su negocio con la ayuda de nuestros especialistas.

- Recolectar datos primarios . OWOX BI recopila datos sin procesar de Google Analytics, servicios de publicidad, sitios web, tiendas fuera de línea, sistemas de seguimiento de llamadas y sistemas CRM en su almacenamiento de datos. La plataforma funciona sin problemas con grandes cuentas publicitarias y carga todos los datos independientemente de la cantidad de campañas. Además de importar automáticamente los datos de costos, OWOX BI reconoce los parámetros dinámicos en las etiquetas UTM, convierte los costos a una moneda y monitorea la relevancia de los datos.

Ya no necesita buscar varios conectores y, si es necesario, nuestro equipo puede incluso configurar integraciones personalizadas para usted.

- Normalice los datos sin procesar . Al usar OWOX BI, no necesita limpiar, estructurar y procesar datos manualmente. Recibirá conjuntos de datos listos en la estructura más clara y conveniente. Además, en cualquier momento puede obtener un informe visual sobre la relevancia de los datos de los servicios publicitarios subidos a Google Analytics.

- Preparar datos comerciales . Con OWOX BI, tiene datos confiables listos para el negocio al alcance de su mano. Ya no es necesario crear un nuevo conjunto de datos para cada nuevo informe, ya que obtiene conjuntos de datos finales prediseñados preparados de acuerdo con su modelo de datos comerciales. Con datos actualizados y unificados listos para una mayor segmentación de datos, puede obtener información sobre la velocidad de su negocio y aumentar el valor de sus datos.

- Visualizar datos . La plataforma OWOX BI te permite analizar y visualizar tus datos donde quieras. Una vez que sus datos de marketing estén listos, puede enviarlos a la herramienta de visualización o BI de su elección con unos pocos clics.

¡Reserve una demostración gratuita para ver cómo OWOX BI garantiza la calidad de los datos y cómo puede beneficiarse de la gestión de datos totalmente automatizada hoy!

Paso 5. Visualiza datos

La presentación visual de métricas clave es el último paso para que los datos funcionen, por lo que su presentación de datos debe ser tanto informativa como fácil de usar. Las visualizaciones automatizadas y configuradas correctamente pueden reducir significativamente el tiempo para encontrar un problema; es decir, puede realizar más iteraciones con menos esfuerzo durante el mismo período para mejorar la calidad de los datos.

Además, es importante recordar que los servicios de visualización de datos como el popular Google Data Studio no pueden fusionar ni transformar datos. Si necesita informes basados en muchas fuentes de datos, nuestra recomendación es recopilar todos los datos que necesita de antemano en un solo almacenamiento de datos para evitar dificultades.

Dificultades de calidad de datos que puede encontrar en este paso:

1. Errores de datos fácticos

¿Que son estos?

Cuando algo sale mal en los niveles anteriores de recopilación y normalización de datos, los errores de datos pueden terminar en los informes que muestran los servicios de visualización de datos.

¿Qué está mal con eso?

Los informes creados con errores de datos reales son una pérdida de tiempo y dinero. No proporcionan ganancias ni información valiosa sobre las zonas de riesgo y crecimiento para el negocio. Lo siento, Mario, ¡pero la princesa está en otro castillo!

¿Cuales son las razones?

En pocas palabras, los datos visualizados no son relevantes. Sin embargo, para averiguar el origen de esos errores, debe volver a verificar sus datos nuevamente.

¿Cómo resolver este problema?

La única forma de resolver este problema es preparar los datos a fondo y controlar su calidad antes de crear informes.

2. Consultas SQL rotas o demasiadas modificaciones en los informes (y/o consultas SQL)

¿Que es esto?

Los requisitos de datos cambian constantemente y las consultas SQL también cambian. Como resultado, cuanto más complicado se vuelve el sistema de informes, más fácil es que se descomponga.

¿Qué está mal con eso?

Los cambios no tienen nada de malo, a menos que sean tantos que sea imposible recordar qué cambios se hicieron, dónde y cuándo. Eventualmente, todos los sistemas de informes creados cuidadosamente pueden desaparecer, ya que las consultas SQL no funcionan y no hay datos correctos para visualizar.

¿Cuales son las razones?

Es todo un desafío recordar cada pequeña cosa, por lo que el error típico es olvidar aplicar ediciones en todos los conjuntos de datos donde se necesitan.

¿Cómo resolver este problema?

Idealmente, los usuarios deberían poder generar informes de marketing sin usar muchas consultas SQL y sin necesidad de aplicar muchos cambios y/o ediciones.

3. Malentendido y mal uso de los datos recopilados

¿Que es esto?

Uno de los problemas más comunes es la mala interpretación de los datos (y, por lo tanto, su mal uso). Esto sucede cuando una métrica o parámetro en particular se puede interpretar de más de una manera. Por ejemplo, digamos que hay una métrica de conversión en un informe y este informe es utilizado por diferentes usuarios. Uno de los usuarios piensa que una conversión significa una visita al sitio web, mientras que otro piensa que significa realizar un pedido. Sin embargo, también hay una tercera persona que piensa que esta métrica de conversión se trata de pedidos entregados y comprados. Como puede ver, hay muchas interpretaciones potenciales, por lo que debe dejar en claro qué información se presenta en el informe.

¿Qué está mal con eso?

Si no hay una comprensión clara de qué datos se utilizan en los informes y paneles, no hay garantía de que sus decisiones se basen en los hechos sobre el terreno.

¿Cuales son las razones?

Una explicación poco clara de las métricas y parámetros utilizados en los informes o un tipo inadecuado de visualización de datos pueden conducir a malas decisiones.

¿Cómo resolver este problema?

La verificación de datos no termina cuando te aseguras de que tus datos de entrada sean correctos y relevantes. Estos datos todavía pueden ser mal utilizados. Para evitar este problema, los usuarios finales deben tener acceso a datos completos, actualizados y listos para el negocio con explicaciones claras y precisas de qué información se presenta en los informes.

Nuestros clientes

crecer 22% más rápido

Crezca más rápido midiendo lo que funciona mejor en su marketing

Analice su eficiencia de marketing, encuentre las áreas de crecimiento, aumente el ROI

Obtener demostraciónConclusiones clave

El análisis de calidad comienza con datos de calidad. Sus esfuerzos de datos deben ser valiosos y confiables. Es por eso que debe identificar y combatir de manera proactiva los errores y discrepancias de datos para obtener informes de rendimiento holísticos y mejorar la calidad de sus datos. En general, mejorar la calidad de los datos es un proceso iterativo en el que se pueden distinguir tres pasos:

- Examinar el estado de sus datos

- Localización de un problema que degrada la calidad de los datos

- arreglando el problema

Los que más tiempo consumen son los dos primeros pasos. Es difícil identificar que existe un problema y comprender en qué situaciones surge un error. Una vez que queda claro cuál es el problema y dónde se encuentra, resulta relativamente fácil solucionarlo.

Finalmente, puede crear tres documentos para mejorar sus datos:

- esquema de movimiento de datos

- Matriz de responsabilidad (quién es responsable de qué)

- modelo de datos de negocio