Распространенные проблемы с качеством данных и способы их преодоления

Опубликовано: 2022-04-12Хотя мы живем в эпоху технологий, основанных на данных, более 50% руководителей высшего звена в целом недовольны ценностью, получаемой от аналитики. Одной из основных причин этого является низкое качество данных . Более того, наличие некачественных данных в самом начале любой задачи делает дальнейшие действия бесполезными. Кроме того, любые принимаемые решения будут основаны на ложной информации, и для бизнеса это, безусловно, плохие новости.

Вот почему мы решили поделиться своим многолетним опытом и знаниями в области работы с данными. За последний год мы много общались с коллегами-аналитиками и провели множество интервью со специалистами мирового уровня. Теперь мы хотим предоставить руководство по наиболее частым проблемам в работе с данными и способам их преодоления.

В статье мы обсуждаем этапы рабочего процесса данных, какие ошибки могут возникать и почему. И самое главное, мы делимся подходами к решению проблем с качеством данных.

Оглавление

- Откуда берутся проблемы с качеством данных?

- Шаг 1. Спланируйте измерения

- Шаг 2. Соберите первичные данные

- Шаг 3. Нормализация необработанных данных

- Шаг 4. Подготовьте данные для бизнеса

- Пересмотрите свое отношение к данным с помощью OWOX BI

- Шаг 5. Визуализируйте данные

- Основные выводы

Некоторые определения, прежде чем мы начнем:

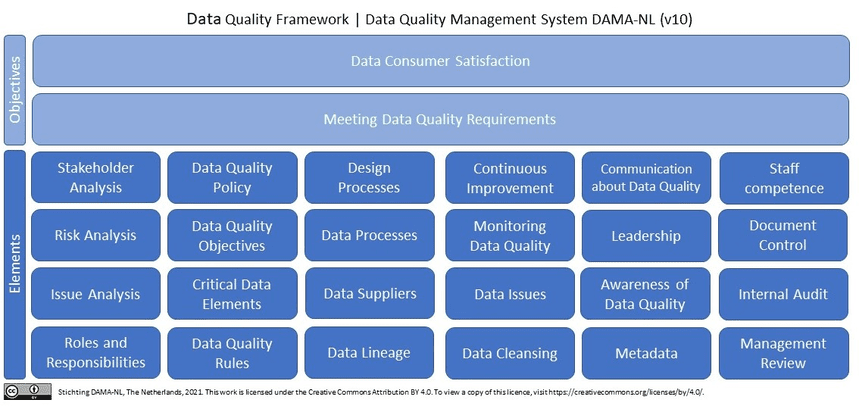

Что такое качественные данные? В двух словах (и с точки зрения маркетинговых данных) качественные данные актуальны, актуальные данные без ошибок и расхождений . Если мы посмотрим на качество данных в Википедии, мы увидим более 10 (!) определений. Кроме того, Википедия цитирует последнее исследование DAMA NL по определению аспектов качества данных с использованием ISO 9001 в качестве системы отсчета.

Почему качественные данные необходимы маркетологам, аналитикам и лицам, принимающим решения? Без качественных и достоверных данных невозможно принимать решения, опираясь на маркетинговую аналитику.

Откуда берутся проблемы с качеством данных?

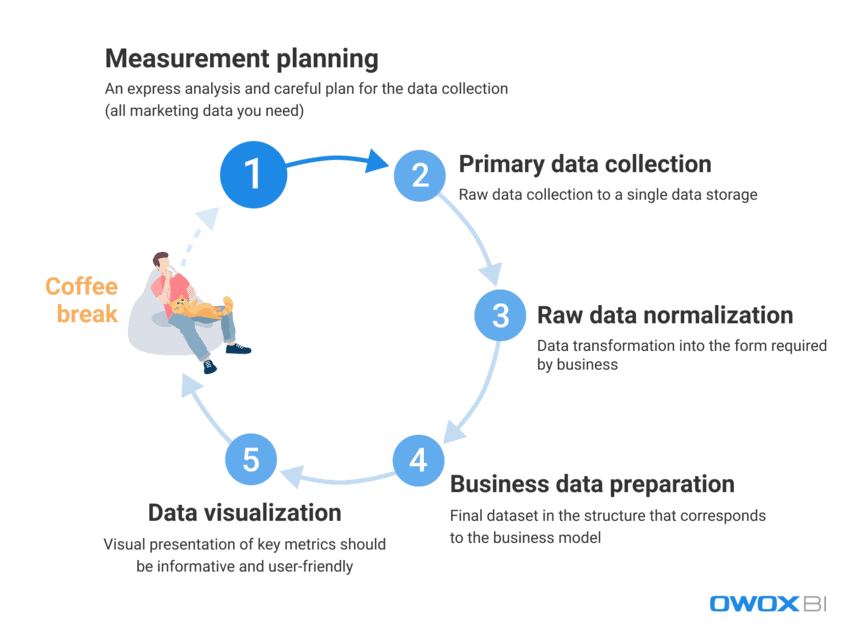

Имея дело с огромным объемом данных, которые ежедневно используют маркетологи и аналитики, сложно полностью исключить ошибки и несоответствия. Чрезвычайно сложно сразу предоставить качественные данные конечному пользователю; тем не менее, с ошибками данных можно активно бороться и обнаруживать их заранее. Прежде всего, давайте рассмотрим процесс работы с данными и выделим этапы, на которых могут возникнуть проблемы с качеством данных:

- Планирование измерений

- Сбор первичных данных

- Нормализация необработанных данных

- Подготовка бизнес-данных

- Визуализация данных

По нашему опыту, фактические ошибки в данных обычно появляются на первых двух этапах, тогда как случаи неправильного использования данных чаще случаются на последних этапах.

Рассмотрим подробнее, какие проблемы с качеством данных могут возникнуть на этих этапах и как их решить.

Шаг 1. Спланируйте измерения

Несмотря на то, что на этом шаге нет ошибок в данных, мы не можем его полностью пропустить. Дьявол кроется в деталях, и сбор данных для анализа начинается с детального планирования. Мы рекомендуем всегда начинать с экспресс-анализа и тщательно планировать сбор всех необходимых маркетинговых данных.

Пропуск этапа планирования приводит к неструктурированному подходу и нехватке данных для новых задач или проектов, в то время как цель состоит в том, чтобы собрать фрагментированные данные из всех источников данных, с которыми вы работаете. Если у вас нет всех данных, это делает ваши решения и действия ошибочными с самого начала. Давайте посмотрим, какие данные вы должны собрать перед запуском новых проектов:

- Данные о поведении пользователей с вашего сайта и/или приложения

- Данные о расходах с рекламных площадок

- Отслеживание звонков, чат-бот и данные электронной почты

- Фактические данные о продажах из ваших систем CRM/ERP и т. д.

Шаг 2. Соберите первичные данные

После того, как вы создали свой план измерения, давайте перейдем к основному этапу сбора данных. На этом этапе, среди всех других проблем, которые вам необходимо решить, вы должны рассмотреть возможность управления доступом к своим данным (все дело в безопасности данных) и заранее подготовиться к созданию вашего хранилища данных или озера данных.

Если вы хотите получить полный контроль над необработанными данными, не изменяя их, мы рекомендуем использовать единое хранилище с автоматическим импортом данных. Для нужд маркетинга Google BigQuery остается одним из лучших вариантов.

С какими трудностями с качеством данных вы можете столкнуться на этом этапе:

1.1 Получение неполных и некорректных данных из API рекламного сервиса

Что это?

Рекламные платформы и сервисы собирают огромное количество ценных данных о поведении пользователей, и проблема возникает, когда вы пытаетесь получить всю эту информацию в полном объеме из этих источников данных, не нарушая ее полноты.

* Интерфейс прикладного программирования (API) — это часть сервера, которая передает данные (получает запросы и отправляет ответы), взаимодействуя с пользователем каждый раз, когда пользователь посещает страницу на веб-сайте. Большинство современных веб-сайтов используют как минимум несколько сторонних API.

Что случилось с этим?

Рекламный сервис собирает данные о действиях пользователя; однако данные могут измениться задним числом после их передачи, а API службы может обновиться или быть недоступным в течение некоторого времени. В результате часть данных просто не будет доставлена, а общее качество данных будет испорчено. Аналитик может не знать об этом и использовать нерелевантные данные для подготовки бизнес-данных. Однако невозможно получить полезную информацию или принять правильное решение на основе неполных и/или неточных данных. Проще говоря, вы можете потратить много времени и усилий и все равно оказаться в самом низу лестницы, не имея ни полезных данных, ни доказательств того, что работа успешна и прибыльна для бизнеса.

Каковы причины?

Данные могут быть неполными или неправильными из-за потери данных, несоответствий или дубликатов. Общие причины этих проблем включают в себя:

- Создается новый аккаунт на рекламной площадке, но аналитики не информируются и данные с него не собираются.

- API не поддерживает динамические параметры в тегах UTM, не собирает и не передает их. Если вы используете неподдерживаемые параметры в тегах UTM, вы увидите названия параметров вместо их значений — например, {{geo}} вместо фактического названия кампании.

- Обновление ретроспективных данных. Рекламные сервисы часто задним числом обновляют данные (по затратам, кликам и показам в рекламных кабинетах). Однако не все аналитики осознают это и учитывают.

Как решить эту проблему?

Поскольку невозможно напрямую контролировать код при работе с API, вы можете бороться с этими проблемами следующим образом:

- распределение зон ответственности во время сбора данных для лучшего контроля над сбором данных.

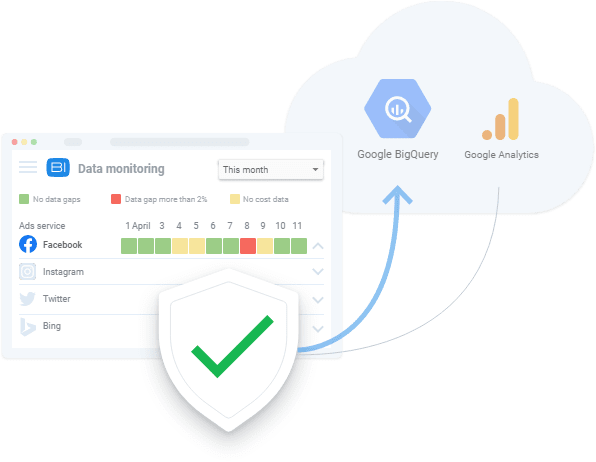

- с помощью инструментов автоматического импорта данных, которые поддерживают изменения API, динамические параметры и т. д. В случае отсутствия данных эти инструменты могут показывать существующие пробелы в данных и загружать данные задним числом.

1.2 Получение неполных и неверных данных с сайта

Что это?

Анализируя данные рекламных сервисов, мы знаем, сколько мы тратим на рекламу. А из данных о поведении пользователей сайта мы получаем информацию о том, сколько мы зарабатываем. Поскольку бизнес-вопросы обычно звучат как «какая реклама окупается, а какая нет?» Важно знать соотношение доходов и расходов.

Что случилось с этим?

Данные о поведении пользователей веб-сайта отличаются от данных о расходах, собираемых рекламными службами, поскольку данные о поведении пользователей веб-сайта:

- собирается непосредственно владельцами веб-сайтов

- значительно больше по объему, чем данные о расходах от рекламных сервисов

Кроме того, если мы не заметим, что нет сбора данных о поведении пользователей, и не устраним проблему, то эти данные будут потеряны навсегда.

Как и в случае с проблемами сбора данных из API рекламных служб, неполная или неверная информация приводит к ошибочным решениям. Неверные управленческие решения, в свою очередь, приводят к потере доходов.

Каковы причины?

При сборе данных веб-сайта могут возникать ошибки, потому что:

- Не на всех страницах веб-сайтов есть контейнер Диспетчера тегов Google (GTM). GTM собирает результаты рекламных кампаний и данные о поведении пользователей. Поэтому, если на странице нет контейнера GTM, данные не собираются.

- Проект Google Cloud не оплачивается вовремя, поэтому сбор данных приостановлен.

- Корректность данных, введенных в анкеты пользователями сайта (имя, адрес, адрес электронной почты и т. д.), не проверяется.

Как решить эту проблему?

Как и при сборе данных из API, решения для сбора данных веб-сайтов включают:

- распределение зон ответственности во время сбора данных для лучшего контроля над сбором данных

- использование автоматизированных средств импорта данных; в случае отсутствия данных эти инструменты могут предупредить вас о существующих ошибках данных

2. Получение агрегированных выборочных данных

Что это?

Агрегированные и выборочные данные — это обобщенные данные, которые появляются в случаях, когда не все данные обрабатываются и используются для анализа и отчетности. Это происходит, когда такие сервисы, как Google Analytics, анализируют только часть данных, чтобы снизить нагрузку на серверы и сбалансировать скорость и точность обработки данных. Так как выборка приводит к обобщению, это приводит к недоверию к полученным результатам.

Что случилось с этим?

Выборочные отчеты искажают данные об эффективности, и это может стоить вам целое состояние, когда речь идет о показателях, связанных с деньгами, таких как цели, конверсии и доход. Из-за этого вы рискуете не заметить прибыльную рекламную кампанию и можете отключить ее из-за искаженных данных в отчете или наоборот — потратить все деньги на неэффективные кампании.

Другими словами, каждый раз, когда применяется выборка, существует риск получения неточных результатов. И если вы пытаетесь принять решение, основываясь только на части данных, вы играете в угадайку с бюджетом компании.

Каковы причины?

В попытке создавать отчеты как можно быстрее и экономить ресурсы системы применяют выборку, агрегацию и фильтрацию вместо обработки огромных массивов данных.

Как решить эту проблему?

Единственное, что вы можете сделать, чтобы избежать выборки данных, — это собирать необработанные данные и постоянно проверять полноту данных во всех ваших отчетах. Этот мониторинг процесса предпочтительно выполняется автоматически, чтобы исключить влияние человеческого фактора. Например, вы можете применить автоматическое тестирование корректного сбора метрик на своем сайте, как это сделал OZON с помощью OWOX BI.

Шаг 3. Нормализация необработанных данных

После сбора всех необходимых данных пришло время его нормализовать. На этом этапе аналитики преобразовывают имеющуюся информацию в требуемую бизнесом форму. Например, мы должны привести номера телефонов в единый формат.

Нормализация данных — это ручная и рутинная «обезьянья работа», которая обычно удерживает аналитиков от более интересных задач, таких как извлечение полезной информации из данных. Не говоря уже о том, что трудности нормализации обычно занимают до 50% рабочего времени аналитика в целом.

Трудности с качеством данных, с которыми можно столкнуться на этом этапе:

1. Вставка, обновление и удаление зависимостей

Что это?

Это неприятные побочные эффекты, возникающие при нормализации неструктурированных данных.

Что случилось с этим?

Общим результатом этих зависимостей данных является то, что системы отчетности отбрасывают такие неверные данные при их анализе. В результате мы получаем неточные отчеты, которые не основаны на полных данных. Например, скажем, у нас есть объект сеансов и объект рекламы. В сессиях у нас есть данные с 10 по 20 дни, а в рекламе данные с 10 по 15 дни (почему-то нет данных о расходах с 16 по 20 дни). Соответственно, либо мы теряем данные из рекламы за 16-20 дней, либо данные из сессий будут доступны только за 10-15 дни.

Каковы причины?

Нежелательные побочные эффекты возникают, когда API рекламного сервиса изменен, недоступен или возвращает неверные данные.

Как решить эту проблему?

Точно так же, как вы проверяете ошибки сбора данных, вы всегда должны проверять данные, с которыми работаете. Более того, если особенности слияния данных пользователю неизвестны, то велика вероятность возникновения ошибок при нормализации данных. На практике лучшим решением на этом этапе является разработка системы мониторинга качества данных, которая оповещает лицо, ответственное за качество данных, в случае аномалий данных. Для этого можно использовать такие сервисы, как OWOX BI со встроенным функционалом мониторинга данных.

Наши клиенты

расти на 22% быстрее

Растите быстрее, измеряя, что лучше всего работает в вашем маркетинге

Проанализируйте эффективность вашего маркетинга, найдите точки роста, увеличьте рентабельность инвестиций

Получить демо2. Различные форматы данных, структуры и уровни детализации

Что это?

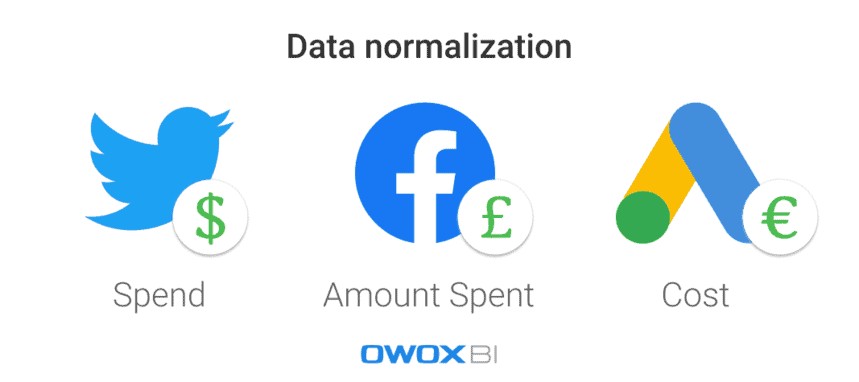

Каждая рекламная платформа или сервис использует разные форматы данных, валюты и структуры. В результате, собрав данные из всех источников, вы должны нормализовать их в единый формат/структуру.

Что случилось с этим?

Трудно построить треугольную крепость, когда у вас есть только круглые и овальные детали. Когда у вас много наборов данных в разных форматах, вы просто не можете создать отчет, не объединив данные.

Каковы причины?

В рекламных сервисах используются разные схемы данных. Например, один и тот же столбец на разных платформах может называться «Название продукта» и «Категория продукта». Другой пример — использование разных валют в данных о затратах: например, долларов для рекламы в Twitter и фунтов стерлингов для Facebook.

Как решить эту проблему?

Перед анализом данных их необходимо преобразовать в единый формат; иначе ничего хорошего из вашего анализа не выйдет. Например, вам следует объединить данные о сеансах пользователей с данными о затратах на рекламу, чтобы измерить влияние каждого конкретного источника трафика или маркетингового канала и увидеть, какие рекламные кампании приносят вам больше дохода. Конечно, это можно сделать вручную с помощью скриптов и SQL, но лучше использовать автоматизированные решения.

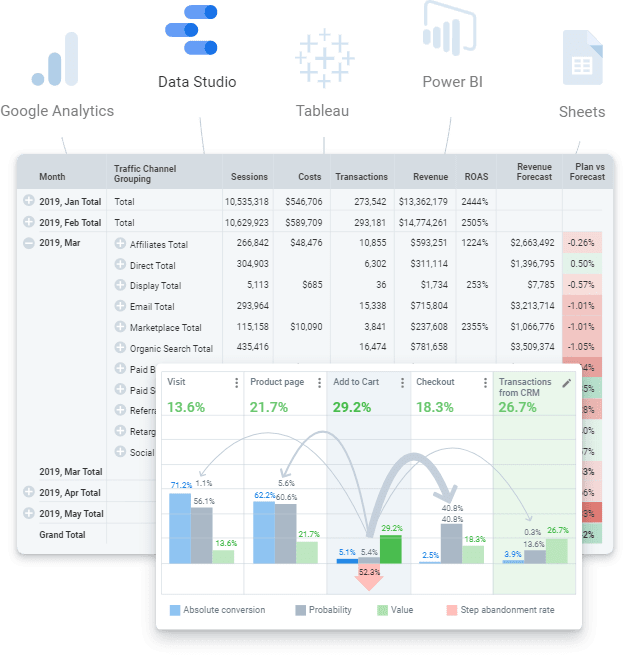

Шаг 4. Подготовьте данные для бизнеса

Готовые для бизнеса данные — это очищенный окончательный набор данных в структуре, соответствующей бизнес-модели. Другими словами, если вы прошли все этапы работы с данными и все выполнили, вы должны получить окончательный набор данных. Это готовые данные, которые можно отправить в любой сервис визуализации данных (Power BI, Tableau, Google Data Studio и т.д.).

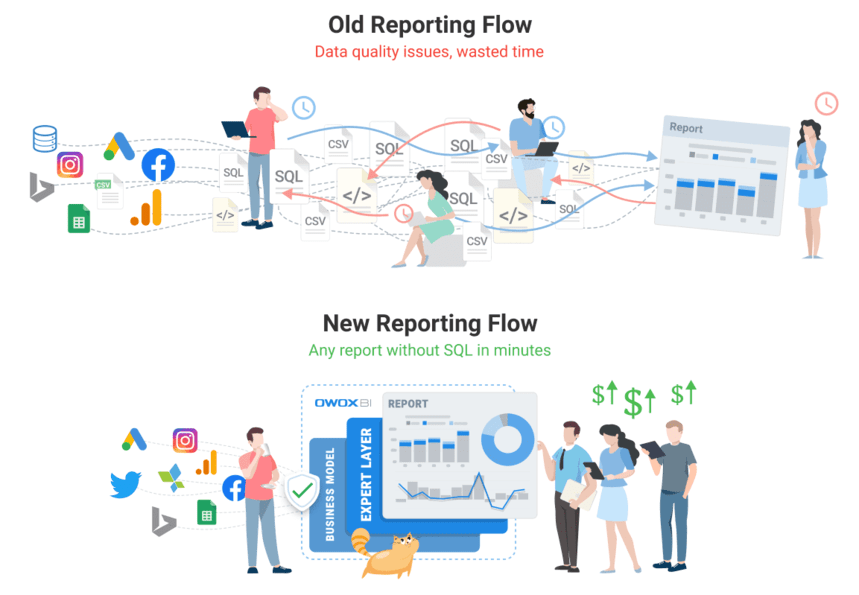

Однако не стоит путать его с необработанными данными, по которым можно попытаться построить отчет. Это ошибочный подход, который повлечет за собой множество повторяющихся проблем: поиск ошибок и причин расхождений займет много времени, а бизнес-логику нужно будет постоянно дублировать во всех SQL-запросах. Конечно, такой объем сырых, неструктурированных данных сложно поддерживать в актуальном состоянии и контролировать изменения в логике преобразований. Например, вы можете столкнуться с такими проблемами, как обновление истории данных о расходах после ее корректировки рекламным сервисом. Другим примером может быть выкуп завершенных транзакций. В этом случае нужно время, чтобы понять, погашена ли транзакция, но мы должны отнести этот статус к моменту заказа.

К сожалению, обычно этот шаг пропускают и сразу приступают к созданию отчета. Однако наш опыт показывает, что использование окончательного набора данных и подготовка бизнес-данных для современного мира аналитики являются обязательными. В долгосрочной перспективе дешевле и проще работать с подготовленными данными, чем снова и снова бегать по необработанным данным, выполняя одни и те же действия.

Какие трудности с качеством данных могут возникнуть на этом этапе:

1. Отсутствие определений данных приводит к расхождениям

Что это?

Трудно контролировать изменения в логике преобразования из-за противоречивых или отсутствующих определений типов данных, необходимых для обработки данных.

Что случилось с этим?

Когда данные четко не определены, пользователи не понимают, как использовать данные: они не уверены, какую таблицу или столбец запрашивать, какой фильтр использовать или у кого запрашивать информацию об объектах данных. Кроме того, требуется слишком много времени, чтобы просмотреть и понять все объекты данных из необработанных данных, включая их атрибуты, их место в модели данных и их взаимосвязь.

Каковы причины?

Бизнес не имеет четкого определения своих основных данных и своей модели данных. Поэтому логика слияния данных непонятна.

Как решить эту проблему?

Прежде всего, не применяйте бизнес-логику к каждому отчету или набору данных, а используйте моделирование данных на уровне компании. Внутри компании должна быть прозрачная бизнес-модель данных и контроль жизненного цикла данных. Это означает, что все используемые определения должны быть четкими. Например, конечные пользователи должны знать, что представляют собой показатели конверсии и посетителей веб-сайта.

Наряду с этим, поскольку сложно подготовить и поддерживать актуальные смоделированные данные, ответ заключается в применении автоматизированных решений (например, инструмента построения данных (dbt)), которые могут собирать, очищать, нормализовать и контролировать качество ваших данных. так что это бизнес готов.

Пересмотрите свое отношение к данным с помощью OWOX BI

Команда OWOX BI как никто знает, насколько серьезна проблема с данными, ведь с ней сталкивается каждый наш клиент. Мы создали продукт, который позволяет аналитикам автоматизировать рутинную работу, извлекать пользу из данных для бизнеса и обеспечивать качество данных.

OWOX BI — это единая платформа, которая позволяет собирать, подготавливать и анализировать все ваши маркетинговые данные. Он автоматизирует доставку данных из разрозненных источников в пункт назначения аналитики, гарантируя, что данные всегда будут точными и актуальными.

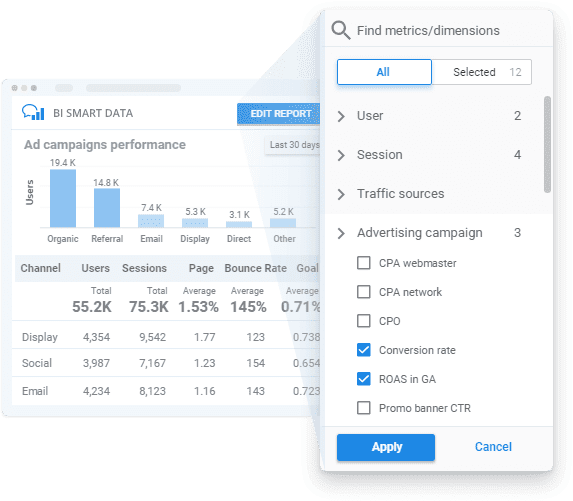

Применяя OWOX BI, вы можете получать бизнес-данные в соответствии с вашей бизнес-моделью с прозрачным мониторингом качества данных и простым в использовании конструктором отчетов для раскрытия информации без SQL или кода.

Давайте посмотрим, как OWOX BI может помочь вам на всех этапах, которые мы упоминали выше.

- Спланируйте свои измерения . Создайте план измерения для вашего бизнеса или разработайте систему метрик специально для нужд вашего бизнеса с помощью наших специалистов.

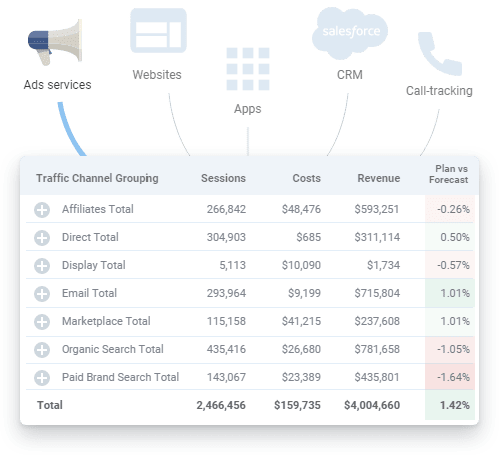

- Соберите первичные данные . OWOX BI собирает необработанные данные из Google Analytics, рекламных сервисов, сайтов, офлайн-магазинов, систем коллтрекинга и CRM-систем в ваше хранилище данных. Платформа безотказно работает с большими рекламными аккаунтами и выгружает все данные вне зависимости от количества кампаний. Помимо автоматического импорта данных о затратах, OWOX BI распознает динамические параметры в UTM-метках, переводит затраты в одну валюту и следит за актуальностью данных.

Вам больше не нужно искать различные коннекторы и, при необходимости, наша команда может даже настроить для вас индивидуальные интеграции.

- Нормализация необработанных данных . При использовании OWOX BI вам не нужно вручную очищать, структурировать и обрабатывать данные. Вы получите готовые наборы данных в максимально понятной и удобной структуре. Более того, в любой момент вы можете получить наглядный отчет об актуальности данных рекламных сервисов, загруженных в Google Analytics.

- Подготовьте бизнес-данные . С OWOX BI у вас всегда под рукой готовые для бизнеса данные. Больше нет необходимости создавать новый набор данных для каждого нового отчета, поскольку вы получаете готовые окончательные наборы данных, подготовленные в соответствии с вашей бизнес-моделью данных. Имея актуальные и унифицированные данные, готовые для дальнейшей сегментации данных, вы можете получить представление о скорости своего бизнеса и повысить ценность своих данных.

- Визуализируйте данные . Платформа OWOX BI позволяет анализировать и визуализировать данные в любом месте. Когда ваши маркетинговые данные будут готовы, вы можете отправить их в выбранный вами инструмент бизнес-аналитики или визуализации несколькими щелчками мыши.

Закажите бесплатную демонстрацию, чтобы узнать, как OWOX BI гарантирует качество данных и как вы можете извлечь выгоду из полностью автоматизированного управления данными уже сегодня!

Шаг 5. Визуализируйте данные

Визуальное представление ключевых показателей — это последний шаг к тому, чтобы данные работали, поэтому представление данных должно быть информативным и удобным для пользователя. Автоматизированные и правильно настроенные визуализации позволяют значительно сократить время на поиск проблемы; то есть вы можете выполнить больше итераций с меньшими усилиями за тот же период, чтобы улучшить качество данных.

Кроме того, важно помнить, что службы визуализации данных, такие как популярная Google Data Studio, не могут объединять или преобразовывать данные. Если вам нужны отчеты на основе множества источников данных, мы рекомендуем заранее собрать все необходимые данные в единое хранилище данных, чтобы избежать каких-либо трудностей.

Проблемы с качеством данных, с которыми вы можете столкнуться на этом этапе:

1. Фактические ошибки данных

Что это?

Когда что-то пойдет не так на предыдущих уровнях сбора и нормализации данных, ошибки данных могут оказаться в отчетах, отображаемых службами визуализации данных.

Что случилось с этим?

Отчеты, созданные с фактическими ошибками в данных, являются пустой тратой времени и денег. Они не приносят никакой прибыли или ценной информации о зонах риска и роста для бизнеса. Извини, Марио, но принцесса в другом замке!

Каковы причины?

Проще говоря, визуализированные данные не имеют значения. Однако, чтобы выяснить источник этих ошибок, вы должны вернуться к повторной проверке своих данных.

Как решить эту проблему?

Единственный способ решить эту проблему — тщательно подготовить данные и контролировать их качество перед созданием отчетов.

2. Неработающие SQL-запросы или слишком много правок в отчетах (и/или SQL-запросах).

Что это?

Требования к данным постоянно меняются, меняются и SQL-запросы. В результате, чем сложнее становится система отчетности, тем легче ей выйти из строя.

Что случилось с этим?

В изменениях нет ничего плохого, если только их не так много, что невозможно вспомнить, какие изменения были сделаны, где и когда. В конце концов, все тщательно выстроенные системы отчетности могут исчезнуть, поскольку SQL-запросы не работают и нет правильных данных для визуализации.

Каковы причины?

Довольно сложно запомнить каждую мелочь, поэтому типичная ошибка — забыть применить изменения ко всем наборам данных, где они необходимы.

Как решить эту проблему?

В идеале пользователи должны иметь возможность создавать маркетинговые отчеты без использования большого количества запросов SQL и без необходимости вносить множество изменений и/или правок.

3. Неправильное понимание и неправильное использование собранных данных

Что это?

Одной из самых распространенных проблем является неправильное понимание данных (и, следовательно, неправильное их использование). Это происходит, когда конкретная метрика или параметр могут быть интерпретированы более чем одним способом. Например, предположим, что в отчете есть показатель конверсии, и этот отчет используется разными пользователями. Один из пользователей считает, что конверсия означает посещение сайта, а другой считает, что это означает оформление заказа. Однако есть и третий человек, который считает, что эта метрика конверсии связана с доставленными и купленными заказами. Как видите, существует множество возможных интерпретаций, поэтому вы должны четко указать, какая информация представлена в отчете.

Что случилось с этим?

Если нет четкого понимания того, какие данные используются в отчетах и информационных панелях, нет гарантии, что ваши решения будут основаны на реальных фактах.

Каковы причины?

Нечеткое объяснение метрик и параметров, используемых в отчетах, или неподходящий тип визуализации данных могут привести к неправильным решениям.

Как решить эту проблему?

Проверка данных не заканчивается, когда вы убедитесь, что введенные вами данные верны и актуальны. Эти данные все еще могут быть использованы не по назначению. Чтобы избежать этой проблемы, конечные пользователи должны иметь доступ к полным, актуальным, готовым для бизнеса данным с четкими и точными пояснениями того, какая информация представлена в отчетах.

Наши клиенты

расти на 22% быстрее

Растите быстрее, измеряя, что лучше всего работает в вашем маркетинге

Проанализируйте эффективность вашего маркетинга, найдите точки роста, увеличьте рентабельность инвестиций

Получить демоОсновные выводы

Качественная аналитика начинается с качественных данных. Ваши усилия по сбору данных должны быть ценными и надежными. Вот почему вы должны заблаговременно выявлять ошибки и несоответствия в данных и устранять их, чтобы получать целостные отчеты о производительности и повышать качество ваших данных. В целом улучшение качества данных представляет собой итеративный процесс, в котором можно выделить три этапа:

- Изучение состояния ваших данных

- Локализация проблемы, ухудшающей качество данных

- Устранение проблемы

Самые трудоемкие — первые два шага. Трудно определить, что проблема существует, и понять, в каких ситуациях возникает ошибка. После того, как становится ясно, в чем проблема и где она находится, исправить ее оказывается сравнительно легко.

Наконец, вы можете создать три документа для улучшения ваших данных:

- Схема перемещения данных

- Матрица ответственности (кто за что отвечает)

- Модель бизнес-данных