Masalah umum kualitas data dan cara mengatasinya

Diterbitkan: 2022-04-12Meskipun kita berada di era teknologi berbasis data, lebih dari 50% eksekutif senior umumnya tidak puas dengan nilai yang diperoleh dari analitik. Salah satu alasan utama untuk ini adalah kualitas data yang buruk. Selain itu, memiliki data berkualitas buruk di awal tugas apa pun membuat tindakan lebih lanjut tidak berguna. Selain itu, setiap keputusan yang dibuat akan didasarkan pada informasi yang salah, dan untuk bisnis, ini pasti berita buruk.

Itulah mengapa kami memutuskan untuk membagikan pengalaman dan keahlian kami selama bertahun-tahun dalam bekerja dengan data. Selama setahun terakhir, kami telah berbicara banyak dengan rekan analis kami dan melakukan banyak wawancara dengan spesialis kelas dunia. Sekarang kami ingin memberikan panduan tentang masalah yang paling sering terjadi dalam bekerja dengan data dan cara mengatasinya.

Dalam artikel tersebut, kami membahas tahapan alur kerja data, kesalahan apa yang dapat terjadi, dan alasannya. Dan yang terpenting, kami berbagi pendekatan untuk memecahkan kesulitan kualitas data.

Daftar Isi

- Dari mana datangnya masalah kualitas data?

- Langkah 1. Rencanakan pengukuran

- Langkah 2. Kumpulkan data primer

- Langkah 3. Normalisasikan data mentah

- Langkah 4. Siapkan data siap bisnis

- Pertimbangkan kembali hubungan Anda dengan data dengan OWOX BI

- Langkah 5. Visualisasikan data

- takeaways kunci

Beberapa definisi sebelum kita mulai:

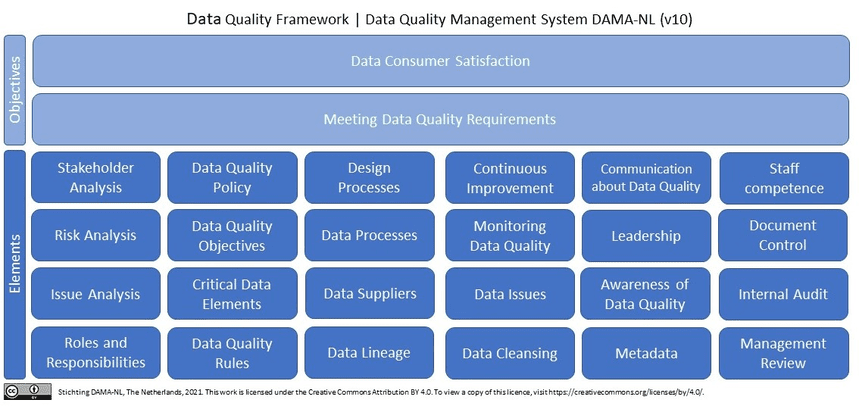

Apa itu data berkualitas? Singkatnya (dan dalam hal data pemasaran), data berkualitas adalah data yang relevan, terkini tanpa kesalahan dan perbedaan . Jika kita mencari kualitas data di Wikipedia, kita akan melihat lebih dari 10 definisi (!). Selanjutnya, Wikipedia mengutip penelitian terbaru oleh DAMA NL tentang definisi dimensi kualitas data menggunakan ISO 9001 sebagai kerangka acuan.

Mengapa data berkualitas merupakan keharusan bagi pemasar, analis, dan pembuat keputusan? Tanpa data yang berkualitas dan dapat dipercaya, tidak mungkin mengambil keputusan dengan mengandalkan analitik pemasaran.

Dari mana datangnya masalah kualitas data?

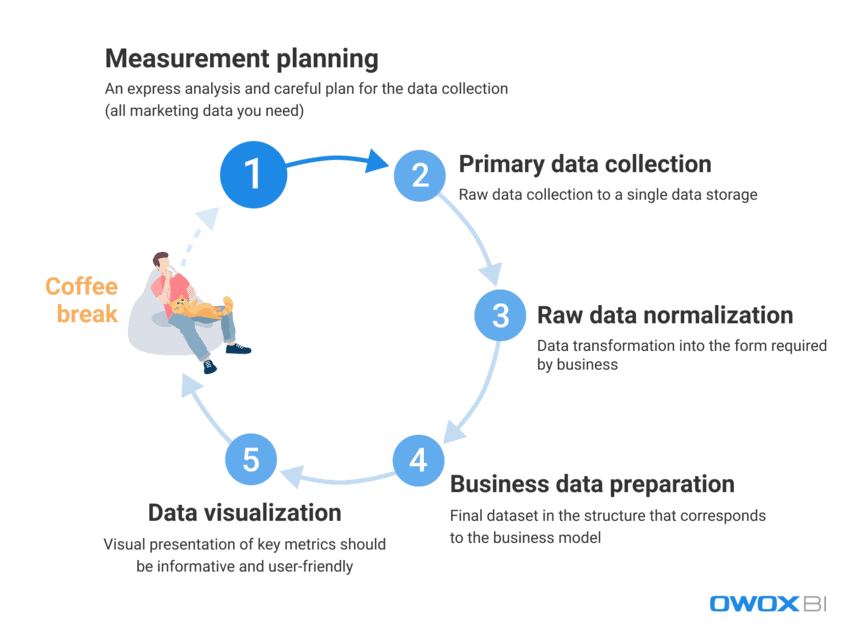

Dalam menangani sejumlah besar data yang digunakan pemasar dan analis setiap hari, merupakan tantangan untuk sepenuhnya menghilangkan kesalahan dan perbedaan. Sangat sulit untuk segera memberikan data berkualitas kepada pengguna akhir; namun, kesalahan data dapat diatasi secara aktif dan ditemukan secara proaktif. Pertama-tama, mari kita lihat proses bekerja dengan data dan membedakan langkah-langkah di mana masalah kualitas data dapat muncul:

- Perencanaan pengukuran

- Pengumpulan data primer

- Normalisasi data mentah

- Persiapan data bisnis

- Visualisasi data

Berdasarkan pengalaman kami, kesalahan data faktual biasanya muncul pada dua langkah pertama, sedangkan kasus penyalahgunaan data lebih sering terjadi pada langkah terakhir.

Mari kita lihat lebih detail masalah kualitas data apa yang dapat muncul pada langkah-langkah ini dan bagaimana menyelesaikannya.

Langkah 1. Rencanakan pengukuran

Meskipun tidak ada kesalahan dalam data pada langkah ini, kami tidak dapat sepenuhnya menghilangkannya. Iblis ada dalam perincian, dan pengumpulan data untuk analisis dimulai dengan perencanaan terperinci. Rekomendasi kami adalah selalu memulai dengan analisis cepat dan merencanakan pengumpulan semua data pemasaran yang Anda butuhkan dengan cermat.

Melewatkan langkah perencanaan mengarah ke pendekatan yang tidak terstruktur dan tidak cukup data untuk tugas atau proyek baru, sedangkan tujuannya adalah untuk mengumpulkan data yang terfragmentasi dari semua sumber data yang Anda gunakan. Jika Anda tidak memiliki semua data, itu membuat keputusan dan tindakan Anda salah sejak awal. Mari kita lihat data apa yang harus Anda kumpulkan sebelum memulai proyek baru:

- Data perilaku pengguna dari situs web dan/atau aplikasi Anda

- Data biaya dari platform periklanan

- Pelacakan panggilan, chatbot, dan data email

- Data penjualan aktual dari sistem CRM/ERP Anda, dll.

Langkah 2. Kumpulkan data primer

Setelah Anda membuat rencana pengukuran, mari lanjutkan ke langkah pengumpulan data utama. Selama langkah ini, di antara semua tantangan lain yang perlu Anda atasi, Anda harus mempertimbangkan untuk mengontrol akses ke data Anda (ini semua tentang keamanan data) dan mempersiapkan terlebih dahulu untuk pembuatan penyimpanan data atau data lake Anda.

Jika Anda ingin mendapatkan kontrol penuh atas data mentah Anda tanpa mengubahnya, rekomendasi kami adalah menggunakan penyimpanan tunggal dengan impor data otomatis. Untuk kebutuhan pemasaran, Google BigQuery tetap menjadi salah satu opsi terbaik.

Kesulitan kualitas data apa yang dapat Anda temui pada langkah ini:

1.1 Mendapatkan data yang tidak lengkap dan salah dari API layanan periklanan

Apa ini?

Platform dan layanan periklanan mengumpulkan sejumlah besar data perilaku pengguna yang berharga, dan masalah terjadi ketika Anda mencoba untuk mendapatkan semua informasi ini secara penuh dari sumber data ini tanpa merusak kelengkapannya.

*Application Programming Interface (API) adalah bagian dari server yang mengirimkan data (menerima permintaan dan mengirim tanggapan), berinteraksi dengan pengguna setiap kali pengguna mengunjungi halaman di situs web. Sebagian besar situs web modern menggunakan setidaknya beberapa API pihak ketiga.

Apa yang salah dengan itu?

Layanan periklanan mengumpulkan data tentang tindakan pengguna; namun, data dapat berubah secara retrospektif setelah ditransfer, dan API layanan mungkin diperbarui atau tidak tersedia untuk beberapa waktu. Akibatnya, sebagian data tidak akan terkirim, dan kualitas data secara keseluruhan akan rusak. Analis mungkin tidak mengetahui hal ini dan mungkin menggunakan data yang tidak relevan untuk menyiapkan data bisnis. Namun, tidak mungkin mendapatkan wawasan yang berguna atau membuat keputusan yang tepat berdasarkan data yang tidak lengkap dan/atau tidak akurat. Sederhananya, Anda dapat menginvestasikan banyak waktu dan usaha dan masih menemukan diri Anda kembali di bawah tangga tanpa data yang berguna atau bukti bahwa kinerja berhasil dan menguntungkan bagi bisnis.

Apa alasannya?

Data bisa tidak lengkap atau salah karena kehilangan data, perbedaan, atau duplikat. Alasan umum untuk masalah ini meliputi:

- Akun baru di platform periklanan dibuat, tetapi analis tidak diberi tahu dan data darinya tidak dikumpulkan.

- API tidak mendukung parameter dinamis dalam tag UTM dan tidak mengumpulkan atau mentransfernya. Jika Anda menggunakan parameter yang tidak didukung dalam tag UTM, Anda akan melihat nama parameter, bukan nilainya — misalnya, {{geo}} alih-alih nama kampanye yang sebenarnya.

- Pembaruan data retrospektif. Layanan periklanan sering kali memperbarui data secara retrospektif (biaya, klik, dan tayangan di akun periklanan). Namun, tidak semua analis menyadari hal ini dan memperhitungkannya.

Bagaimana cara mengatasi masalah ini?

Karena tidak mungkin mengontrol kode secara langsung saat bekerja dengan API, Anda dapat mengatasi masalah ini dengan:

- mendistribusikan area tanggung jawab selama pengumpulan data untuk mendapatkan kontrol yang lebih baik atas pengambilan data.

- menggunakan alat impor data otomatis yang mendukung perubahan API, parameter dinamis, dll. Jika data tidak tersedia, alat ini dapat menunjukkan kesenjangan data yang ada dan mengunduh data secara retrospektif.

1.2 Mendapatkan data yang tidak lengkap dan salah dari sebuah situs web

Apa ini?

Dengan menganalisis data dari layanan periklanan, kita tahu berapa banyak yang kita keluarkan untuk iklan. Sedangkan dari data perilaku pengguna website, kita mendapatkan informasi tentang berapa penghasilan yang kita peroleh. Karena pertanyaan bisnis biasanya terdengar seperti “iklan mana yang terbayar, dan mana yang tidak?” penting untuk mengetahui rasio pendapatan/pengeluaran.

Apa yang salah dengan itu?

Data tentang perilaku pengguna situs web berbeda dengan data biaya yang dikumpulkan oleh layanan periklanan karena data tentang perilaku pengguna situs web:

- dikumpulkan langsung oleh pemilik situs web

- secara signifikan lebih besar dalam volume daripada data biaya dari layanan periklanan

Selain itu, jika kami tidak menyadari bahwa tidak ada kumpulan data perilaku pengguna dan kami tidak menghilangkan masalah, maka data ini akan hilang selamanya.

Seperti halnya masalah pengumpulan data dari API layanan periklanan, informasi yang tidak lengkap atau salah mengarah ke solusi yang salah. Keputusan manajemen yang salah, pada gilirannya, menyebabkan hilangnya pendapatan.

Apa alasannya?

Kesalahan dapat terjadi saat mengumpulkan data situs web karena:

- Tidak semua laman situs web memiliki penampung Google Pengelola Tag (GTM). GTM mengumpulkan hasil kampanye iklan dan data perilaku pengguna. Oleh karena itu, jika tidak ada penampung GTM di halaman, tidak ada data yang dikumpulkan.

- Proyek Google Cloud tidak dibayar tepat waktu, sehingga pengumpulan data ditunda.

- Kebenaran data yang dimasukkan ke dalam formulir aplikasi oleh pengguna situs web (nama, alamat, email, dll.) tidak divalidasi.

Bagaimana cara mengatasi masalah ini?

Seperti halnya mengumpulkan data dari API, solusi untuk pengumpulan data situs web meliputi:

- mendistribusikan area tanggung jawab selama pengumpulan data untuk mendapatkan kontrol yang lebih baik atas pengambilan data

- menggunakan alat impor data otomatis; jika data tidak tersedia, alat ini dapat memperingatkan Anda tentang kesalahan data yang ada

2. Mendapatkan agregat, data sampel

Apa ini?

Data teragregasi dan sampel adalah data umum yang muncul jika tidak semua data diproses dan digunakan untuk analisis dan pelaporan. Ini terjadi ketika layanan seperti Google Analytics hanya menganalisis sebagian data untuk mengurangi beban di server dan menyeimbangkan kecepatan dan akurasi pemrosesan data. Karena pengambilan sampel menghasilkan generalisasi, hal itu menyebabkan kurangnya kepercayaan pada hasil yang diperoleh.

Apa yang salah dengan itu?

Laporan sampel mendistorsi data kinerja, dan itu dapat merugikan Anda dalam hal metrik terkait uang seperti sasaran, konversi, dan pendapatan. Karena itu, Anda berisiko tidak memperhatikan kampanye iklan yang menguntungkan dan dapat mematikannya karena data yang terdistorsi dalam laporan, atau sebaliknya — Anda dapat menghabiskan semua uang Anda untuk kampanye yang tidak efisien.

Dengan kata lain, setiap kali pengambilan sampel diterapkan, ada risiko mendapatkan hasil yang tidak akurat. Dan jika Anda mencoba membuat keputusan hanya berdasarkan sebagian data, Anda bermain tebak-tebakan dengan anggaran perusahaan.

Apa alasannya?

Dalam upaya untuk membuat laporan sesegera mungkin dan menghemat sumber daya, sistem menerapkan pengambilan sampel, agregasi, dan pemfilteran alih-alih memproses larik data besar-besaran.

Bagaimana cara mengatasi masalah ini?

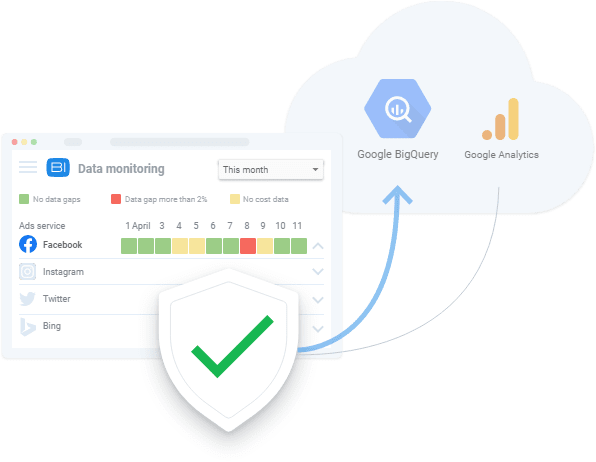

Satu-satunya hal yang dapat Anda lakukan untuk menghindari pengambilan sampel data adalah mengumpulkan data mentah dan terus-menerus memeriksa kelengkapan data di seluruh laporan Anda. Pemantauan proses ini sebaiknya dilakukan secara otomatis sebagai cara untuk menghindari faktor manusia. Misalnya, Anda dapat menerapkan pengujian otomatis pengumpulan metrik yang benar di situs web Anda seperti yang dilakukan OZON dengan bantuan OWOX BI.

Langkah 3. Normalisasikan data mentah

Setelah mengumpulkan semua data yang diperlukan, saatnya untuk menormalkannya. Pada langkah ini, analis mengubah informasi yang tersedia ke dalam bentuk yang dibutuhkan oleh bisnis. Misalnya, kita harus memasukkan nomor telepon ke dalam satu format.

Normalisasi data adalah "pekerjaan monyet" manual dan rutin yang biasanya menjauhkan analis dari tugas yang lebih menarik seperti mengekstraksi wawasan data yang berguna. Belum lagi kesulitan normalisasi biasanya memakan waktu hingga 50% dari waktu kerja analis secara keseluruhan.

Kesulitan kualitas data yang dapat ditemui pada tahap ini:

1. Ketergantungan penyisipan, pembaruan, dan penghapusan

Apa ini?

Ini adalah efek samping merepotkan yang muncul selama normalisasi data tidak terstruktur.

Apa yang salah dengan itu?

Hasil umum dari ketergantungan data ini adalah bahwa sistem pelaporan membuang data yang salah saat menganalisisnya. Akibatnya, kami mendapatkan laporan yang tidak akurat yang tidak didasarkan pada data lengkap. Misalnya, kita memiliki objek sesi dan objek iklan. Dalam sesi, kami memiliki data untuk hari 10 hingga 20, dan dalam iklan, ada data dari hari 10 hingga 15 (untuk beberapa alasan tidak ada data biaya untuk hari 16 hingga 20). Oleh karena itu, kami kehilangan data dari iklan selama hari ke 16 hingga 20, atau data dari sesi hanya akan tersedia untuk hari ke 10 hingga 15.

Apa alasannya?

Efek samping yang tidak diinginkan muncul saat API layanan periklanan diubah, tidak tersedia, atau mengembalikan data yang salah.

Bagaimana cara mengatasi masalah ini?

Dengan cara yang sama, Anda memeriksa kesalahan pengumpulan data, Anda harus selalu memverifikasi data yang Anda kerjakan. Apalagi jika spesifikasi penggabungan data tidak diketahui oleh pengguna, maka kemungkinan akan terjadi kesalahan saat melakukan normalisasi data. Dalam praktiknya, keputusan terbaik pada langkah ini adalah mengembangkan sistem pemantauan kualitas data yang memperingatkan orang yang bertanggung jawab atas kualitas data jika terjadi anomali data. Untuk ini, Anda dapat menggunakan layanan seperti OWOX BI dengan fungsi pemantauan data yang disematkan.

Klien kami

tumbuh 22% lebih cepat

Tumbuh lebih cepat dengan mengukur apa yang paling berhasil dalam pemasaran Anda

Analisis efisiensi pemasaran Anda, temukan area pertumbuhan, tingkatkan ROI

Dapatkan demo2. Format, struktur, dan tingkat detail data yang berbeda

Apa ini?

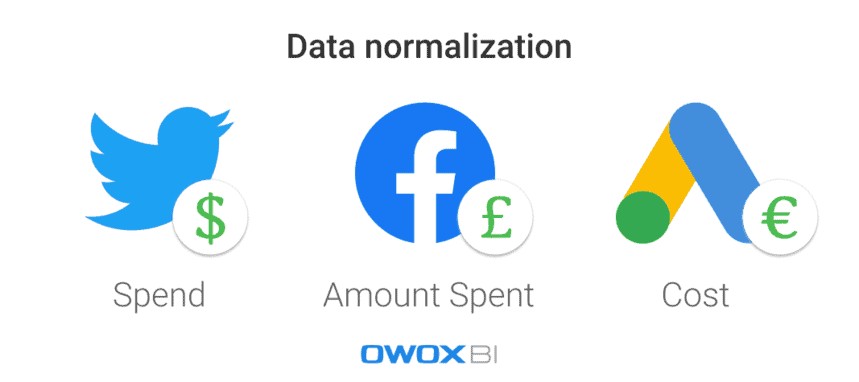

Setiap platform atau layanan periklanan menggunakan format data, mata uang, dan struktur yang berbeda. Akibatnya, setelah mengumpulkan data dari semua sumber, Anda harus menormalkannya ke dalam satu format/struktur.

Apa yang salah dengan itu?

Ini adalah tugas yang sulit untuk membangun benteng segitiga ketika semua yang Anda miliki adalah potongan bulat dan oval. Bila Anda memiliki banyak kumpulan data dalam format yang berbeda, Anda tidak dapat membuat laporan sebelum menyatukan data.

Apa alasannya?

Ada skema data yang berbeda di seluruh layanan periklanan. Misalnya, kolom yang sama di platform yang berbeda dapat diberi nama Nama Produk dan Kategori Produk. Contoh lain adalah menggunakan mata uang yang berbeda dalam data biaya: dolar untuk Iklan Twitter dan pound di Facebook, misalnya.

Bagaimana cara mengatasi masalah ini?

Sebelum menganalisis data, itu harus dikonversi ke format tunggal; jika tidak, tidak ada hal baik yang akan keluar dari analisis Anda. Misalnya, Anda harus menggabungkan data sesi pengguna dengan data biaya iklan untuk mengukur dampak dari setiap sumber lalu lintas atau saluran pemasaran tertentu dan untuk melihat kampanye iklan mana yang memberi Anda lebih banyak pendapatan. Tentu saja, ini dapat dilakukan secara manual dengan menggunakan skrip dan SQL, tetapi menerapkan solusi otomatis adalah pilihan yang lebih baik.

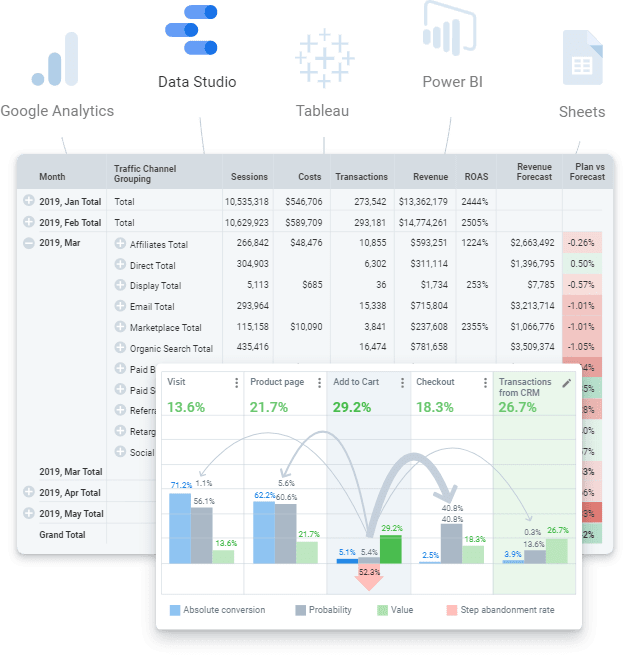

Langkah 4. Siapkan data siap bisnis

Data siap-bisnis adalah kumpulan data akhir yang dibersihkan dalam struktur yang sesuai dengan model bisnis. Dengan kata lain, jika Anda telah melalui semua langkah dalam bekerja dengan data dan telah menyelesaikan semuanya, Anda harus mendapatkan dataset akhir. Data siap pakai yang dapat dikirim ke layanan visualisasi data apa pun (Power BI, Tableau, Google Data Studio, dll.).

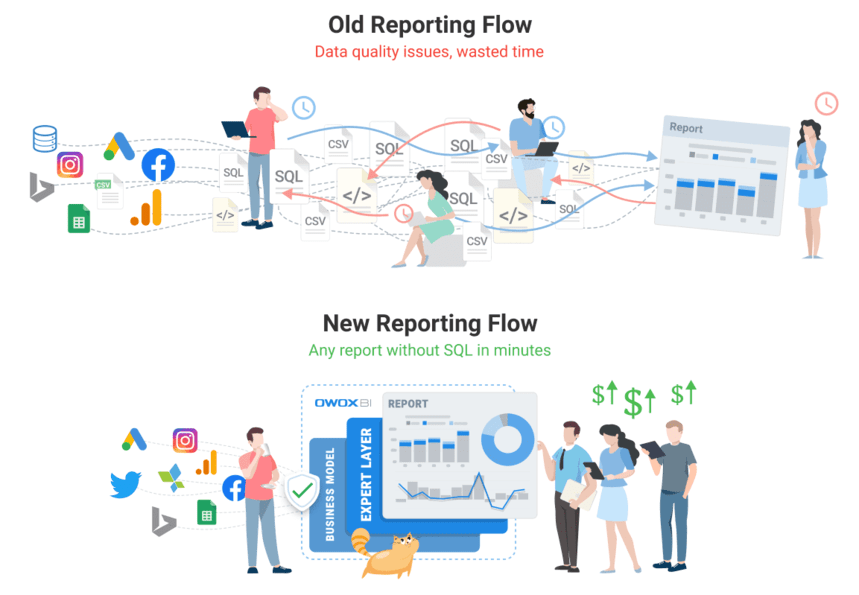

Namun, Anda tidak boleh bingung dengan data mentah yang dapat digunakan untuk membuat laporan. Ini adalah pendekatan yang salah yang akan menyebabkan banyak masalah berulang: menemukan kesalahan dan penyebab perbedaan akan memakan waktu lama, dan logika bisnis perlu terus-menerus diduplikasi di semua kueri SQL. Tentu saja, volume data mentah yang tidak terstruktur seperti itu menantang untuk tetap up to date dan mengontrol perubahan dalam logika transformasi. Misalnya, Anda mungkin mengalami masalah seperti memperbarui riwayat data biaya setelah layanan periklanan menyesuaikannya. Contoh lain adalah pembelian kembali transaksi yang telah selesai. Dalam hal ini, perlu waktu untuk memahami apakah transaksi telah ditukarkan, tetapi kita harus mengaitkan status ini dengan momen pemesanan.

Sayangnya, adalah praktik umum untuk melewati langkah ini dan langsung membuat laporan. Namun, pengalaman kami menunjukkan bahwa menggunakan kumpulan data akhir dan menyiapkan data siap bisnis untuk dunia analitik modern adalah suatu keharusan. Dalam jangka panjang, lebih murah dan lebih mudah untuk bekerja dengan data yang telah disiapkan daripada menggunakan data mentah untuk melakukan hal yang sama berulang kali.

Kesulitan kualitas data apa yang dapat muncul selama langkah ini:

1. Kurangnya definisi data menyebabkan perbedaan

Apa ini?

Sulit untuk mengontrol perubahan dalam logika transformasi karena definisi yang tidak konsisten atau tidak ada dari jenis data yang diperlukan selama pemrosesan data.

Apa yang salah dengan itu?

Saat data tidak didefinisikan dengan jelas, pengguna tidak berada di halaman yang sama tentang penggunaan data: mereka tidak yakin tabel atau kolom mana yang akan dikueri, filter mana yang digunakan, atau siapa yang harus ditanyai informasi tentang objek data. Selain itu, terlalu lama untuk menavigasi dan memahami semua objek data dari data mentah, termasuk atributnya, tempatnya dalam model data, dan relevansinya satu sama lain.

Apa alasannya?

Sebuah bisnis belum secara jelas mendefinisikan data inti dan model datanya. Oleh karena itu, logika untuk menggabungkan data tidak dapat dipahami.

Bagaimana cara mengatasi masalah ini?

Pertama-tama, jangan terapkan logika bisnis ke setiap laporan atau kumpulan data tetapi gunakan pemodelan data di tingkat perusahaan. Di dalam perusahaan, harus ada model data bisnis yang transparan dan kontrol siklus hidup data. Artinya semua definisi yang digunakan harus jelas. Misalnya, pengguna akhir harus mengetahui apa yang diwakili oleh metrik konversi dan pengunjung situs web.

Selain itu, karena sulitnya mempersiapkan dan memelihara data simulasi terkini, jawabannya terletak pada penerapan solusi otomatis (misalnya alat pembuatan data (dbt)) yang dapat mengumpulkan, membersihkan, menormalkan, dan memantau kualitas data Anda. jadi bisnis-siap.

Pertimbangkan kembali hubungan Anda dengan data dengan OWOX BI

Tim OWOX BI tahu lebih dari siapa pun seberapa parah masalah data, karena setiap klien kami mengalaminya. Kami telah membuat produk yang memungkinkan analis untuk mengotomatisasi rutinitas, memberikan nilai bisnis dari data, dan memastikan kualitas data.

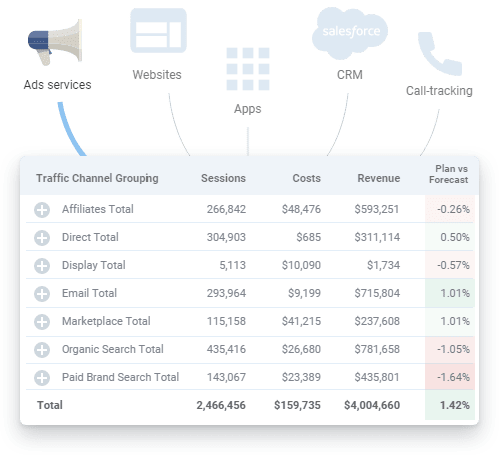

OWOX BI adalah platform terpadu yang memberdayakan Anda untuk mengumpulkan, menyiapkan, dan menganalisis semua data pemasaran Anda. Ini mengotomatiskan pengiriman data dari sumber tersembunyi ke tujuan analitik Anda, memastikan data selalu akurat dan terbaru.

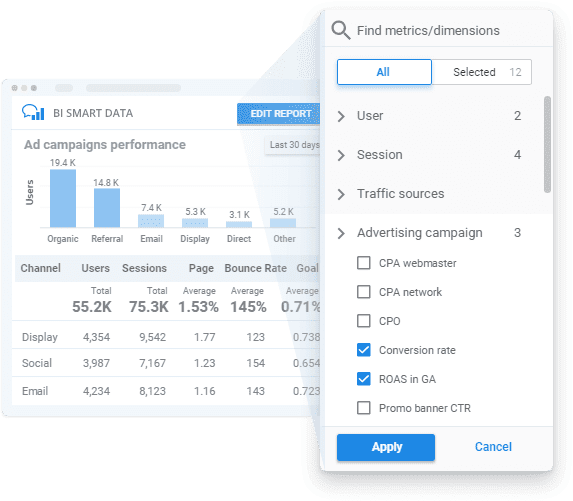

Dengan menerapkan OWOX BI, Anda bisa mendapatkan data siap-bisnis sesuai model bisnis Anda dengan pemantauan kualitas data yang transparan dan pembuat laporan yang mudah digunakan untuk membuka wawasan tanpa SQL atau kode.

Mari kita lihat bagaimana OWOX BI dapat membantu Anda di semua langkah yang kami sebutkan di atas.

- Rencanakan pengukuran Anda . Buat rencana pengukuran untuk bisnis Anda atau kembangkan sistem metrik khusus untuk kebutuhan bisnis Anda dengan bantuan spesialis kami.

- Mengumpulkan data primer . OWOX BI mengumpulkan data mentah dari Google Analytics, layanan periklanan, situs web, toko offline, sistem pelacakan panggilan, dan sistem CRM di penyimpanan data Anda. Platform bekerja dengan lancar dengan akun iklan besar dan mengunggah semua data terlepas dari jumlah kampanye. Selain mengimpor data biaya secara otomatis, OWOX BI mengenali parameter dinamis dalam tag UTM, mengubah biaya menjadi satu mata uang, dan memantau relevansi data.

Anda tidak perlu lagi mencari berbagai konektor dan, jika perlu, tim kami bahkan dapat menyiapkan integrasi khusus untuk Anda.

- Normalisasi data mentah . Saat menggunakan OWOX BI, Anda tidak perlu membersihkan, menyusun, dan memproses data secara manual. Anda akan menerima kumpulan data siap pakai dalam struktur yang paling jelas dan paling nyaman. Selain itu, setiap saat Anda bisa mendapatkan laporan visual tentang relevansi data dari layanan periklanan yang diunggah ke Google Analytics.

- Siapkan data bisnis . Dengan OWOX BI, Anda memiliki data siap pakai yang tepercaya di ujung jari Anda. Anda tidak perlu lagi membuat set data baru untuk setiap laporan baru, karena Anda mendapatkan set data final bawaan yang disiapkan sesuai dengan model data bisnis Anda. Dengan data terbaru dan terpadu yang siap untuk segmentasi data lebih lanjut, Anda bisa mendapatkan wawasan tentang kecepatan bisnis Anda dan meningkatkan nilai data Anda.

- Memvisualisasikan data . Platform OWOX BI memungkinkan Anda menganalisis dan memvisualisasikan data Anda di mana pun Anda inginkan. Setelah data pemasaran Anda siap, Anda dapat mengirimkannya ke BI atau alat visualisasi pilihan Anda dengan beberapa klik.

Pesan demo gratis untuk melihat bagaimana OWOX BI menjamin kualitas data dan bagaimana Anda dapat memperoleh manfaat dari pengelolaan data yang sepenuhnya otomatis hari ini!

Langkah 5. Visualisasikan data

Menyajikan metrik utama secara visual adalah langkah terakhir untuk membuat data berfungsi, jadi presentasi data Anda harus informatif dan ramah pengguna. Visualisasi otomatis dan dikonfigurasi dengan benar dapat secara signifikan mengurangi waktu untuk menemukan masalah; yaitu, Anda dapat melakukan lebih banyak iterasi dengan sedikit usaha selama periode yang sama untuk meningkatkan kualitas data.

Selain itu, penting untuk diingat bahwa layanan visualisasi data seperti Google Data Studio yang populer tidak dapat menggabungkan atau mengubah data. Jika Anda membutuhkan laporan berdasarkan banyak sumber data, rekomendasi kami adalah mengumpulkan semua data yang Anda butuhkan terlebih dahulu ke dalam satu penyimpanan data untuk menghindari kesulitan.

Kesulitan kualitas data yang dapat Anda temui pada langkah ini:

1. Kesalahan data faktual

Apa ini?

Ketika terjadi kesalahan pada tingkat pengumpulan dan normalisasi data sebelumnya, kesalahan data dapat berakhir dalam laporan yang ditampilkan oleh layanan visualisasi data.

Apa yang salah dengan itu?

Laporan yang dibuat dengan kesalahan data faktual hanya membuang-buang waktu dan uang. Mereka tidak memberikan keuntungan atau wawasan berharga tentang risiko dan zona pertumbuhan untuk bisnis. Maaf, Mario, tapi sang putri ada di kastil lain!

Apa alasannya?

Sederhananya, data yang divisualisasikan tidak relevan. Namun, untuk mengetahui sumber kesalahan tersebut, Anda harus kembali memverifikasi data Anda lagi.

Bagaimana cara mengatasi masalah ini?

Satu-satunya cara untuk mengatasi masalah ini adalah menyiapkan data secara menyeluruh dan memantau kualitasnya sebelum membuat laporan.

2. Kueri SQL rusak atau terlalu banyak pengeditan pada laporan (dan/atau kueri SQL)

Apa ini?

Persyaratan data terus berubah, dan kueri SQL juga berubah. Akibatnya, semakin rumit sistem pelaporan, semakin mudah rusak.

Apa yang salah dengan itu?

Tidak ada yang salah dengan perubahan, kecuali ada begitu banyak sehingga tidak mungkin untuk mengingat perubahan apa yang dilakukan, di mana, dan kapan. Akhirnya, semua sistem pelaporan yang dibuat dengan hati-hati dapat menghilang, karena kueri SQL tidak berfungsi dan tidak ada data yang benar untuk divisualisasikan.

Apa alasannya?

Cukup sulit untuk mengingat setiap hal kecil, jadi kesalahan umum adalah lupa menerapkan pengeditan pada semua kumpulan data di mana mereka dibutuhkan.

Bagaimana cara mengatasi masalah ini?

Idealnya, pengguna harus dapat membuat laporan pemasaran tanpa menggunakan banyak kueri SQL dan tanpa perlu menerapkan banyak perubahan dan/atau pengeditan.

3. Kesalahpahaman dan penyalahgunaan data yang dikumpulkan

Apa ini?

Salah satu masalah yang paling umum adalah kesalahpahaman data (dan, oleh karena itu, menyalahgunakannya). Ini terjadi ketika metrik atau parameter tertentu dapat diinterpretasikan dalam lebih dari satu cara. Misalnya, ada metrik konversi dalam laporan dan laporan ini digunakan oleh pengguna yang berbeda. Salah satu pengguna berpikir bahwa konversi berarti kunjungan situs web, sementara yang lain berpikir itu berarti melakukan pemesanan. Namun, ada juga orang ketiga yang berpikir bahwa metrik konversi ini adalah tentang pesanan yang dikirim dan dibeli. Seperti yang Anda lihat, ada banyak interpretasi potensial, jadi Anda harus memperjelas informasi apa yang disajikan dalam laporan.

Apa yang salah dengan itu?

Jika tidak ada pemahaman yang jelas tentang data apa yang digunakan dalam laporan dan dasbor, tidak ada jaminan bahwa keputusan Anda akan didasarkan pada fakta di lapangan.

Apa alasannya?

Penjelasan yang tidak jelas tentang metrik dan parameter yang digunakan dalam laporan atau jenis visualisasi data yang tidak tepat dapat menyebabkan keputusan yang buruk.

Bagaimana cara mengatasi masalah ini?

Verifikasi data tidak berakhir ketika Anda memastikan data input Anda benar dan relevan. Data ini masih bisa disalahgunakan. Untuk menghindari masalah ini, pengguna akhir harus memiliki akses ke data bisnis yang lengkap, terkini, dengan penjelasan yang jelas dan tepat tentang informasi apa yang disajikan dalam laporan.

Klien kami

tumbuh 22% lebih cepat

Tumbuh lebih cepat dengan mengukur apa yang paling berhasil dalam pemasaran Anda

Analisis efisiensi pemasaran Anda, temukan area pertumbuhan, tingkatkan ROI

Dapatkan demotakeaways kunci

Analisis kualitas dimulai dengan data berkualitas. Upaya data Anda harus berharga dan tepercaya. Itulah mengapa Anda harus secara proaktif mengidentifikasi dan melawan kesalahan dan ketidaksesuaian data untuk mendapatkan pelaporan kinerja holistik dan meningkatkan kualitas data Anda. Secara umum, meningkatkan kualitas data adalah proses berulang di mana tiga langkah dapat dibedakan:

- Memeriksa status data Anda

- Melokalisasi masalah yang menurunkan kualitas data

- Memperbaiki masalah

Yang paling memakan waktu adalah dua langkah pertama. Sulit untuk mengidentifikasi bahwa ada masalah dan memahami di mana situasi kesalahan muncul. Setelah menjadi jelas apa masalahnya dan di mana letaknya, ternyata relatif mudah untuk memperbaikinya.

Terakhir, Anda dapat membuat tiga dokumen untuk meningkatkan data Anda:

- Skema perpindahan data

- Matriks tanggung jawab (siapa yang bertanggung jawab atas apa)

- Model data bisnis