Häufige Probleme mit der Datenqualität und wie man sie überwindet

Veröffentlicht: 2022-04-12Obwohl wir uns im Zeitalter datengesteuerter Technologien befinden, sind mehr als 50 % der Führungskräfte im Allgemeinen unzufrieden mit dem Wert, den Analysen bieten. Einer der Hauptgründe dafür ist die schlechte Datenqualität . Darüber hinaus macht eine schlechte Datenqualität zu Beginn einer Aufgabe weitere Maßnahmen nutzlos. Darüber hinaus basieren alle getroffenen Entscheidungen auf fehlerhaften Informationen, und für Unternehmen sind dies sicherlich schlechte Nachrichten.

Deshalb haben wir uns entschlossen, unsere langjährige Erfahrung und Expertise im Umgang mit Daten zu teilen. Im vergangenen Jahr haben wir viel mit unseren Analystenkollegen gesprochen und viele Interviews mit Weltklasse-Spezialisten geführt. Nun wollen wir eine Anleitung zu den häufigsten Problemen bei der Arbeit mit Daten und deren Überwindung geben.

In dem Artikel besprechen wir die Phasen eines Daten-Workflows, welche Fehler auftreten können und warum. Und was am wichtigsten ist, wir teilen Ansätze zur Lösung von Datenqualitätsproblemen.

Inhaltsverzeichnis

- Woher kommen Datenqualitätsprobleme?

- Schritt 1. Messungen planen

- Schritt 2. Sammeln Sie Primärdaten

- Schritt 3. Rohdaten normalisieren

- Schritt 4. Bereiten Sie betriebsbereite Daten vor

- Überdenken Sie Ihre Beziehung zu Daten mit OWOX BI

- Schritt 5. Daten visualisieren

- Die zentralen Thesen

Einige Definitionen, bevor wir beginnen:

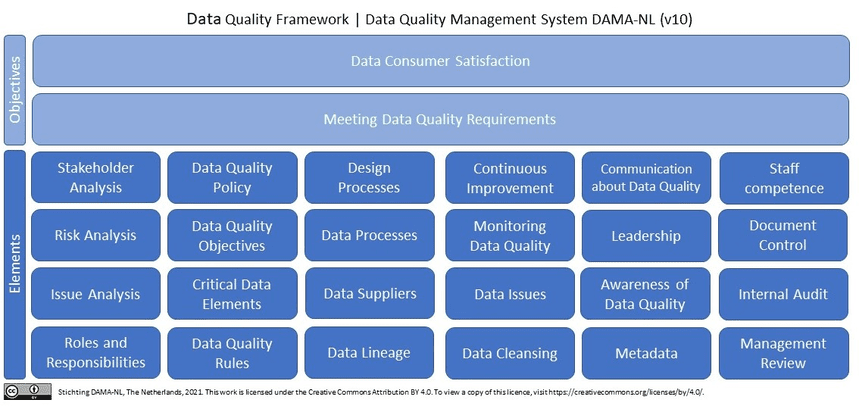

Was sind Qualitätsdaten? Kurz gesagt (und in Bezug auf Marketingdaten): Qualitätsdaten sind relevante, aktuelle Daten ohne Fehler und Abweichungen . Wenn wir bei Wikipedia nach Datenqualität suchen, sehen wir mehr als 10 (!) Definitionen. Darüber hinaus zitiert Wikipedia die neuesten Forschungsergebnisse von DAMA NL zu Definitionen von Dimensionen der Datenqualität unter Verwendung von ISO 9001 als Bezugsrahmen.

Warum sind Qualitätsdaten ein Muss für Marketer, Analysten und Entscheidungsträger? Ohne qualitativ hochwertige und vertrauenswürdige Daten ist es unmöglich, Entscheidungen auf der Grundlage von Marketinganalysen zu treffen.

Woher kommen Datenqualitätsprobleme?

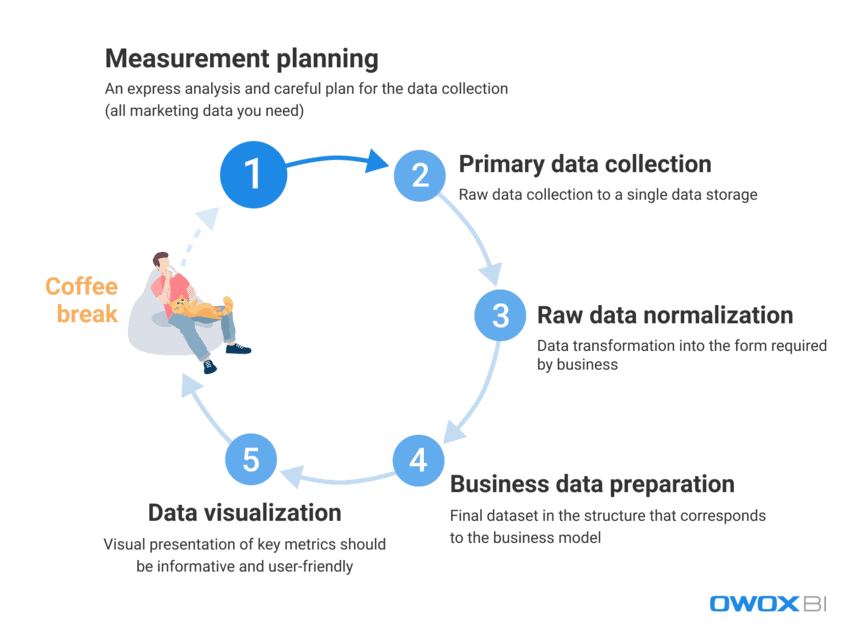

Im Umgang mit der riesigen Datenmenge, die Marketer und Analysten täglich verwenden, ist es eine Herausforderung, Fehler und Diskrepanzen vollständig zu eliminieren. Es ist äußerst schwierig, einem Endbenutzer sofort hochwertige Daten bereitzustellen. Datenfehler können jedoch aktiv bekämpft und proaktiv gefunden werden. Lassen Sie uns zunächst den Prozess der Arbeit mit Daten betrachten und die Schritte unterscheiden, bei denen Datenqualitätsprobleme auftreten können:

- Messplanung

- Primäre Datenerhebung

- Normalisierung von Rohdaten

- Aufbereitung von Geschäftsdaten

- Datenvisualisierung

Sachliche Datenfehler treten unserer Erfahrung nach meist in den ersten beiden Schritten auf, während es in den letzten Schritten häufiger zu Fällen von Datenmissbrauch kommt.

Sehen wir uns genauer an, welche Datenqualitätsprobleme bei diesen Schritten auftreten können und wie sie gelöst werden können.

Schritt 1. Messungen planen

Obwohl in diesem Schritt keine Datenfehler vorliegen, können wir ihn nicht vollständig auslassen. Der Teufel steckt im Detail, und das Sammeln von Daten für die Analyse beginnt mit einer detaillierten Planung. Unsere Empfehlung ist, immer mit einer Express-Analyse zu beginnen und die Erhebung aller Marketingdaten, die Sie benötigen, sorgfältig zu planen.

Das Überspringen des Planungsschritts führt zu einem unstrukturierten Ansatz und nicht genügend Daten für neue Aufgaben oder Projekte, während das Ziel darin besteht, fragmentierte Daten aus allen Datenquellen zu sammeln, mit denen Sie arbeiten. Wenn Sie nicht über alle Daten verfügen, werden Ihre Entscheidungen und Handlungen von Anfang an fehlerhaft. Sehen wir uns an, welche Daten Sie sammeln sollten, bevor Sie neue Projekte starten:

- Daten zum Benutzerverhalten von Ihrer Website und/oder Anwendung

- Kostendaten von Werbeplattformen

- Anrufverfolgung, Chatbot und E-Mail-Daten

- Aktuelle Verkaufsdaten aus Ihren CRM-/ERP-Systemen etc.

Schritt 2. Sammeln Sie Primärdaten

Nachdem Sie Ihren Messplan erstellt haben, fahren wir mit dem primären Schritt der Datenerfassung fort. Während dieses Schritts müssen Sie neben allen anderen Herausforderungen, die Sie bewältigen müssen, die Kontrolle des Zugriffs auf Ihre Daten (alles dreht sich um Datensicherheit) und die Vorbereitung auf die Erstellung Ihres Datenspeichers oder Data Lake im Voraus berücksichtigen.

Wenn Sie die vollständige Kontrolle über Ihre Rohdaten erhalten möchten, ohne sie zu verändern, empfehlen wir die Verwendung eines einzelnen Speichers mit automatischem Datenimport. Für Marketingzwecke bleibt Google BigQuery eine der besten Optionen.

Auf welche Datenqualitätsschwierigkeiten können Sie bei diesem Schritt stoßen:

1.1 Erhalten unvollständiger und falscher Daten von der API eines Werbedienstes

Was ist das?

Werbeplattformen und -dienste sammeln riesige Mengen an wertvollen Daten zum Nutzerverhalten, und das Problem tritt auf, wenn Sie versuchen, alle diese Informationen vollständig aus diesen Datenquellen zu erhalten, ohne ihre Vollständigkeit zu beeinträchtigen.

*Eine Anwendungsprogrammierschnittstelle (API) ist ein Teil des Servers, der Daten überträgt (Anfragen empfängt und Antworten sendet) und jedes Mal, wenn der Benutzer eine Seite auf der Website besucht, mit dem Benutzer interagiert. Die meisten modernen Websites verwenden mindestens mehrere APIs von Drittanbietern.

Was stimmt damit nicht?

Ein Werbedienst sammelt Daten über die Aktionen eines Benutzers; Daten können sich jedoch nach der Übertragung nachträglich ändern, und die Service-API kann aktualisiert werden oder für einige Zeit nicht verfügbar sein. Infolgedessen wird ein Teil der Daten einfach nicht geliefert und die Gesamtqualität der Daten wird beeinträchtigt. Der Analyst weiß möglicherweise nichts davon und verwendet möglicherweise irrelevante Daten, um Geschäftsdaten aufzubereiten. Es ist jedoch nicht möglich, auf der Grundlage unvollständiger und/oder ungenauer Daten nützliche Erkenntnisse zu gewinnen oder die richtige Entscheidung zu treffen. Einfach ausgedrückt, Sie können viel Zeit und Mühe investieren und sich trotzdem am Ende der Leiter wiederfinden, ohne nützliche Daten oder Beweise dafür, dass die Leistung für das Unternehmen erfolgreich und rentabel ist.

Was sind die Gründe?

Daten können aufgrund von Datenverlust, Diskrepanzen oder Duplikaten unvollständig oder falsch sein. Häufige Gründe für diese Probleme sind:

- Ein neues Konto auf einer Werbeplattform wird erstellt, aber Analysten werden nicht informiert und Daten werden nicht gesammelt.

- Eine API unterstützt keine dynamischen Parameter in UTM-Tags und sammelt oder überträgt sie nicht. Wenn Sie nicht unterstützte Parameter in UTM-Tags verwenden, sehen Sie die Parameternamen anstelle ihrer Werte – beispielsweise {{geo}} anstelle des tatsächlichen Kampagnennamens.

- Rückwirkende Datenaktualisierungen. Werbedienste aktualisieren Daten (zu Kosten, Klicks und Impressionen in Werbekonten) häufig nachträglich. Allerdings sind sich nicht alle Analysten dessen bewusst und berücksichtigen es.

Wie kann man dieses Problem lösen?

Da es bei der Arbeit mit APIs unmöglich ist, Code direkt zu steuern, können Sie diese Probleme folgendermaßen bekämpfen:

- Verteilung von Verantwortungsbereichen während der Datenerhebung, um eine bessere Kontrolle über die Datenerhebung zu erhalten.

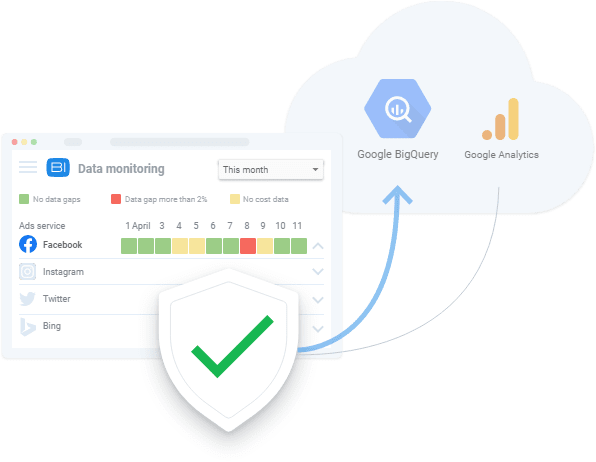

- Verwendung automatisierter Datenimport-Tools, die API-Änderungen, dynamische Parameter usw. unterstützen. Falls Daten nicht verfügbar sind, können diese Tools vorhandene Datenlücken anzeigen und Daten nachträglich herunterladen.

1.2 Unvollständige und falsche Daten von einer Website erhalten

Was ist das?

Durch die Analyse von Daten von Werbediensten wissen wir, wie viel wir für Werbung ausgeben. Aus den Daten zum Website-Benutzerverhalten erhalten wir Informationen darüber, wie viel wir verdienen. Denn betriebswirtschaftliche Fragen klingen meist nach „Welche Werbung rechnet sich und welche nicht?“. Es ist wichtig, das Einnahmen-Ausgaben-Verhältnis zu kennen.

Was stimmt damit nicht?

Daten zum Website-Benutzerverhalten unterscheiden sich von Kostendaten, die von Werbediensten erhoben werden, da Daten zum Website-Benutzerverhalten:

- wird direkt von Website-Eigentümern erhoben

- ist mengenmäßig deutlich größer als Kostendaten von Werbediensten

Wenn wir außerdem nicht bemerken, dass keine Daten zum Benutzerverhalten erfasst werden, und wir das Problem nicht beseitigen, sind diese Daten für immer verloren.

Wie bei Datenerfassungsproblemen von Werbedienst-APIs führen unvollständige oder falsche Informationen zu fehlerhaften Lösungen. Falsche Managemententscheidungen wiederum führen zu Einnahmeausfällen.

Was sind die Gründe?

Beim Sammeln von Website-Daten können Fehler auftreten, weil:

- Nicht alle Webseiten haben einen Google Tag Manager (GTM)-Container. GTM sammelt das Ergebnis von Werbekampagnen und Daten zum Nutzerverhalten. Wenn also kein GTM-Container auf der Seite vorhanden ist, werden keine Daten erfasst.

- Das Google Cloud-Projekt wird nicht rechtzeitig bezahlt und daher wird die Datenerfassung ausgesetzt.

- Die Richtigkeit der von Website-Benutzern in Bewerbungsformulare eingegebenen Daten (Name, Adresse, E-Mail usw.) wird nicht validiert.

Wie kann man dieses Problem lösen?

Wie bei der Erfassung von Daten über eine API umfassen die Lösungen für die Erfassung von Website-Daten:

- Verteilung von Verantwortungsbereichen während der Datenerhebung, um eine bessere Kontrolle über die Datenerhebung zu erhalten

- Verwendung automatisierter Datenimport-Tools; Falls Daten nicht verfügbar sind, können diese Tools Sie vor vorhandenen Datenfehlern warnen

2. Aggregierte, abgetastete Daten erhalten

Was ist das?

Aggregierte und abgetastete Daten sind verallgemeinerte Daten, die in Fällen angezeigt werden, in denen nicht alle Daten verarbeitet und für Analysen und Berichte verwendet werden. Dies geschieht, wenn Dienste wie Google Analytics nur einen Teil der Daten analysieren, um die Belastung der Server zu reduzieren und die Geschwindigkeit und Genauigkeit der Datenverarbeitung auszugleichen. Da das Sampling zu einer Verallgemeinerung führt, führt dies zu einem Mangel an Vertrauen in die erhaltenen Ergebnisse.

Was stimmt damit nicht?

Stichprobenberichte verzerren die Leistungsdaten, und das kann Sie ein Vermögen kosten, wenn es um geldbezogene Kennzahlen wie Ziele, Conversions und Einnahmen geht. Aus diesem Grund riskieren Sie, eine profitable Werbekampagne nicht zu bemerken und sie aufgrund verzerrter Daten in einem Bericht abzuschalten oder umgekehrt – Sie geben möglicherweise Ihr gesamtes Geld für ineffiziente Kampagnen aus.

Mit anderen Worten, jedes Mal, wenn Stichproben angewendet werden, besteht das Risiko, ungenaue Ergebnisse zu erhalten. Und wenn Sie versuchen, eine Entscheidung nur anhand eines Teils der Daten zu treffen, spielen Sie Ratespiele mit dem Budget des Unternehmens.

Was sind die Gründe?

Um Berichte so schnell wie möglich zu erstellen und Ressourcen zu sparen, wenden Systeme Stichproben, Aggregation und Filterung an, anstatt riesige Datenfelder zu verarbeiten.

Wie kann man dieses Problem lösen?

Das einzige, was Sie tun können, um Datenstichproben zu vermeiden, besteht darin, Rohdaten zu sammeln und die Datenvollständigkeit in allen Ihren Berichten ständig zu überprüfen. Diese Prozessüberwachung erfolgt vorzugsweise automatisch, um menschliche Faktoren zu umgehen. Sie können beispielsweise automatische Tests der korrekten Erfassung von Metriken auf Ihrer Website anwenden, wie es OZON mit Hilfe von OWOX BI getan hat.

Schritt 3. Rohdaten normalisieren

Nachdem Sie alle erforderlichen Daten gesammelt haben, ist es an der Zeit, sie zu normalisieren. In diesem Schritt wandeln Analysten verfügbare Informationen in die vom Unternehmen benötigte Form um. Zum Beispiel müssen wir Telefonnummern in ein einziges Format bringen.

Die Datennormalisierung ist ein manueller und routinemäßiger „Affenjob“, der Analysten normalerweise von aufregenderen Aufgaben wie dem Extrahieren nützlicher Dateneinblicke abhält. Ganz zu schweigen davon, dass Normalisierungsschwierigkeiten in der Regel bis zu 50 % der Arbeitszeit eines Analysten insgesamt in Anspruch nehmen.

Datenqualitätsprobleme, auf die man in dieser Phase stoßen kann:

1. Einfügungs-, Aktualisierungs- und Löschabhängigkeiten

Was ist das?

Dies sind störende Nebenwirkungen, die während der Normalisierung von unstrukturierten Daten auftreten.

Was stimmt damit nicht?

Die häufige Folge dieser Datenabhängigkeiten ist, dass Berichtssysteme solche falschen Daten bei der Analyse verwerfen. Infolgedessen erhalten wir am Ende ungenaue Berichte, die nicht auf vollständigen Daten basieren. Angenommen, wir haben ein Session-Objekt und ein Advertisement-Objekt. In Sitzungen haben wir Daten für die Tage 10 bis 20 und in Werbeanzeigen Daten von den Tagen 10 bis 15 (aus irgendeinem Grund gibt es keine Kostendaten für die Tage 16 bis 20). Dementsprechend verlieren wir entweder Daten aus Werbeanzeigen für die Tage 16 bis 20 oder Daten aus Sitzungen sind nur für die Tage 10 bis 15 verfügbar.

Was sind die Gründe?

Unerwünschte Nebenwirkungen treten auf, wenn eine Werbedienst-API geändert wird, nicht verfügbar ist oder falsche Daten zurückgibt.

Wie kann man dieses Problem lösen?

Auf die gleiche Weise wie Sie nach Datenerfassungsfehlern suchen, sollten Sie immer die Daten überprüfen, mit denen Sie arbeiten. Wenn die Einzelheiten der Datenzusammenführung dem Benutzer nicht bekannt sind, können außerdem beim Normalisieren der Daten Fehler auftreten. In der Praxis ist die beste Entscheidung in diesem Schritt, ein Datenqualitätsüberwachungssystem zu entwickeln, das die für die Datenqualität verantwortliche Person im Falle von Datenanomalien warnt. Dazu können Sie Dienste wie OWOX BI mit seiner eingebetteten Datenüberwachungsfunktion verwenden.

Unsere Kunden

zunehmen 22 % schneller

Wachsen Sie schneller, indem Sie messen, was in Ihrem Marketing am besten funktioniert

Analysieren Sie Ihre Marketingeffizienz, finden Sie die Wachstumsbereiche, steigern Sie den ROI

Demo erhalten2. Unterschiedliche Datenformate, Strukturen und Detaillierungsgrade

Was ist das?

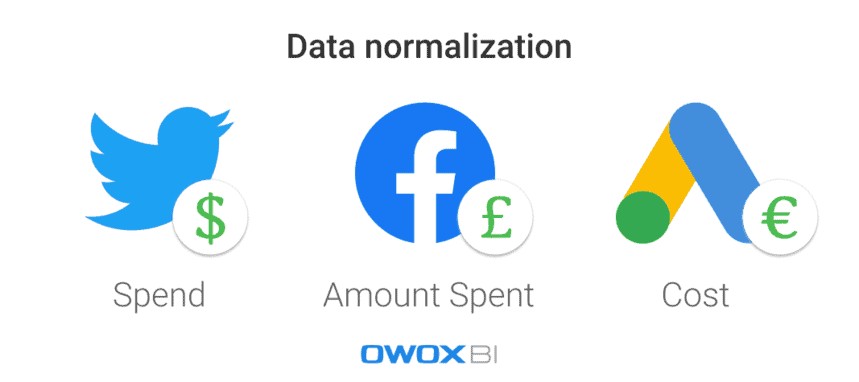

Jede Werbeplattform oder jeder Dienst verwendet unterschiedliche Datenformate, Währungen und Strukturen. Nachdem Sie Daten aus allen Quellen gesammelt haben, müssen Sie sie daher in ein einziges Format/eine einzige Struktur normalisieren.

Was stimmt damit nicht?

Es ist eine schwierige Aufgabe, eine dreieckige Festung zu bauen, wenn man nur runde und ovale Teile hat. Wenn Sie viele Datensätze in verschiedenen Formaten haben, können Sie einfach keinen Bericht erstellen, bevor Sie die Daten vereinheitlicht haben.

Was sind die Gründe?

Es gibt unterschiedliche Datenschemata für Werbedienste. Beispielsweise kann dieselbe Spalte auf verschiedenen Plattformen Produktname und Produktkategorie heißen. Ein weiteres Beispiel ist die Verwendung unterschiedlicher Währungen in Kostendaten: Dollar beispielsweise für Twitter Ads und Pfund für Facebook.

Wie kann man dieses Problem lösen?

Vor der Analyse von Daten müssen diese in ein einziges Format konvertiert werden; Andernfalls wird aus Ihrer Analyse nichts Gutes herauskommen. Beispielsweise sollten Sie Benutzersitzungsdaten mit Werbekostendaten zusammenführen, um die Wirkung jeder einzelnen Verkehrsquelle oder jedes Marketingkanals zu messen und zu sehen, welche Werbekampagnen Ihnen mehr Umsatz bringen. Natürlich kann dies manuell mithilfe von Skripten und SQL erfolgen, aber die Anwendung automatisierter Lösungen ist eine bessere Wahl.

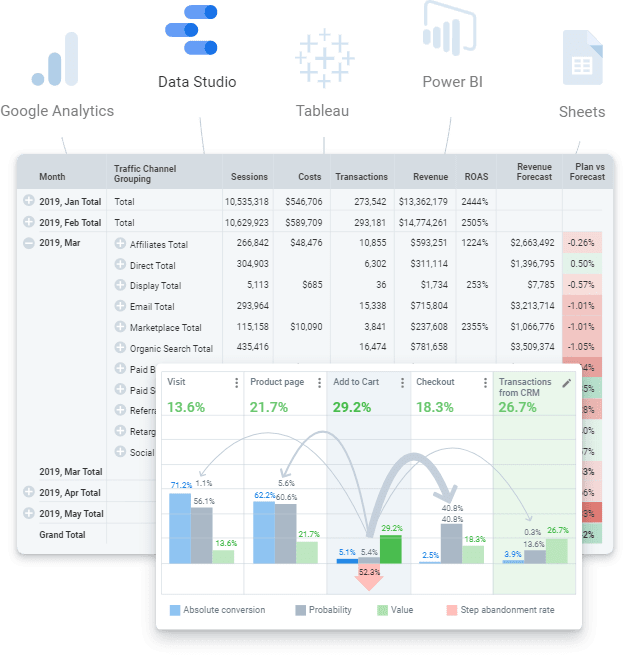

Schritt 4. Bereiten Sie betriebsbereite Daten vor

Business-Ready-Daten sind ein bereinigter finaler Datensatz in der Struktur, die dem Geschäftsmodell entspricht. Mit anderen Worten, wenn Sie alle Schritte bei der Arbeit mit Daten durchlaufen und alles abgeschlossen haben, sollten Sie den endgültigen Datensatz erhalten. Seine vorgefertigten Daten, die an jeden Datenvisualisierungsdienst (Power BI, Tableau, Google Data Studio usw.) gesendet werden können.

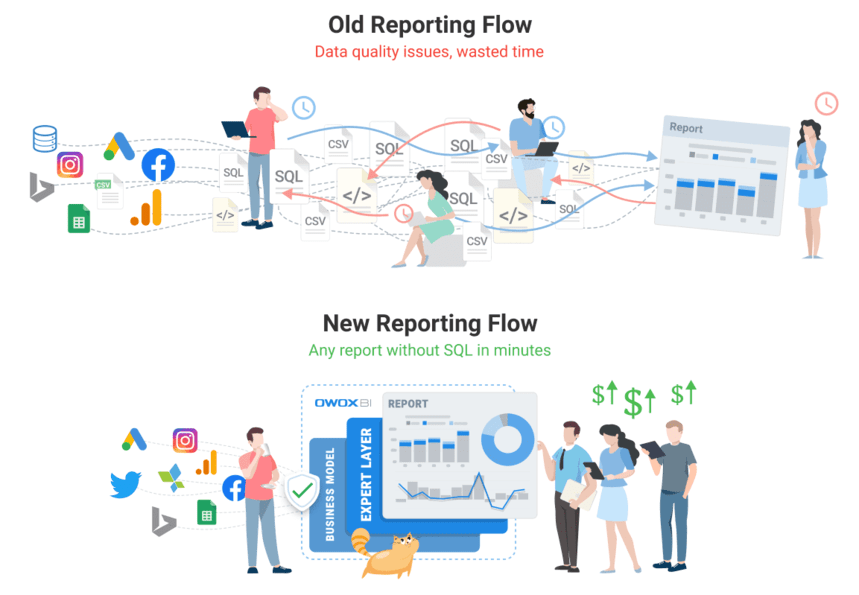

Sie sollten es jedoch nicht mit Rohdaten verwechseln, auf deren Grundlage Sie versuchen können, einen Bericht zu erstellen. Es ist ein fehlerhafter Ansatz, der viele wiederkehrende Probleme mit sich bringt: Das Auffinden von Fehlern und Ursachen für Abweichungen wird lange dauern, und die Geschäftslogik muss ständig in allen SQL-Abfragen dupliziert werden. Natürlich ist es schwierig, eine solche Menge an rohen, unstrukturierten Daten auf dem Laufenden zu halten und Änderungen in der Transformationslogik zu kontrollieren. Beispielsweise können Sie auf Probleme wie das Aktualisieren des Kostendatenverlaufs stoßen, nachdem der Werbedienst ihn angepasst hat. Ein weiteres Beispiel könnte der Rückkauf abgeschlossener Transaktionen sein. In diesem Fall braucht es Zeit, um zu verstehen, ob die Transaktion eingelöst wurde, aber wir müssen diesen Status dem Moment der Bestellung zuordnen.

Leider ist es üblich, diesen Schritt zu überspringen und direkt mit der Erstellung des Berichts zu beginnen. Unsere Erfahrung zeigt jedoch, dass die Verwendung eines endgültigen Datensatzes und die Aufbereitung geschäftsfähiger Daten für die moderne Welt der Analytik ein Muss ist. Auf lange Sicht ist es billiger und einfacher, mit aufbereiteten Daten zu arbeiten, anstatt immer wieder mit Rohdaten herumzulaufen und die gleichen Dinge zu tun.

Welche Datenqualitätsprobleme können während dieses Schritts auftreten:

1. Fehlende Datendefinitionen führen zu Diskrepanzen

Was ist das?

Aufgrund inkonsistenter oder fehlender Definitionen der Datentypen, die während der gesamten Datenverarbeitung erforderlich sind, ist es schwierig, Änderungen in der Transformationslogik zu kontrollieren.

Was stimmt damit nicht?

Wenn Daten nicht klar definiert sind, sind sich Benutzer bezüglich der Datennutzung nicht einig: Sie sind sich nicht sicher, welche Tabelle oder Spalte sie abfragen, welchen Filter sie verwenden oder wen sie nach Informationen zu Datenobjekten fragen sollen. Außerdem dauert es zu lange, alle Datenobjekte aus Rohdaten zu durchsuchen und zu verstehen, einschließlich ihrer Attribute, ihres Platzes im Datenmodell und ihrer Relevanz zueinander.

Was sind die Gründe?

Ein Unternehmen hat seine Kerndaten und sein Datenmodell nicht klar definiert. Daher ist die Logik zum Zusammenführen von Daten nicht nachvollziehbar.

Wie kann man dieses Problem lösen?

Wenden Sie zunächst keine Geschäftslogik auf jeden Bericht oder Datensatz an, sondern verwenden Sie die Datenmodellierung auf Unternehmensebene. Innerhalb des Unternehmens sollte es ein transparentes Geschäftsdatenmodell und eine Kontrolle des Datenlebenszyklus geben. Das bedeutet, dass alle verwendeten Definitionen eindeutig sein müssen. Beispielsweise sollten sich Endbenutzer darüber im Klaren sein, was Konversions- und Website-Besuchermetriken darstellen.

Da es außerdem schwierig ist, simulierte Daten auf dem neuesten Stand zu erstellen und zu pflegen, liegt die Antwort in der Anwendung automatisierter Lösungen (z. B. Data Build Tool (dbt)), die die Qualität Ihrer Daten erfassen, bereinigen, normalisieren und überwachen können es ist also betriebsbereit.

Überdenken Sie Ihre Beziehung zu Daten mit OWOX BI

Das OWOX BI-Team weiß mehr als jeder andere, wie schwerwiegend das Datenproblem ist, da jeder unserer Kunden damit konfrontiert wird. Wir haben ein Produkt entwickelt, das es Analysten ermöglicht, Routinen zu automatisieren, aus Daten geschäftlichen Nutzen zu ziehen und die Datenqualität sicherzustellen.

OWOX BI ist eine einheitliche Plattform, mit der Sie alle Ihre Marketingdaten sammeln, aufbereiten und analysieren können. Es automatisiert die Datenbereitstellung aus isolierten Quellen an Ihr Analyseziel und stellt sicher, dass die Daten immer genau und aktuell sind.

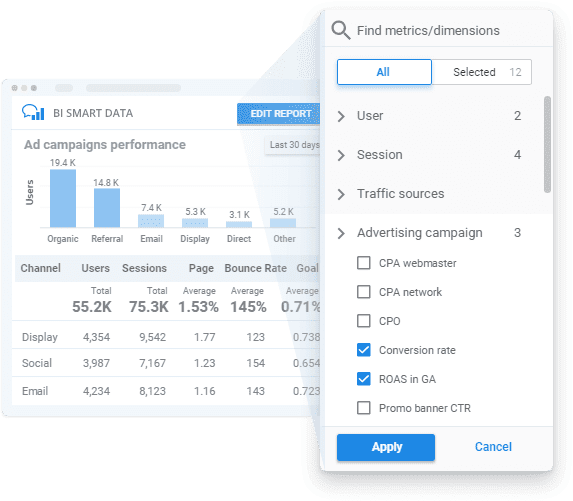

Durch die Anwendung von OWOX BI erhalten Sie betriebsbereite Daten gemäß Ihrem Geschäftsmodell mit transparenter Datenqualitätsüberwachung und einem benutzerfreundlichen Report Builder, um Erkenntnisse ohne SQL oder Code zu gewinnen.

Schauen wir uns an, wie OWOX BI Ihnen bei allen oben genannten Schritten helfen kann.

- Planen Sie Ihre Messungen . Erstellen Sie mit Hilfe unserer Spezialisten einen Messplan für Ihr Unternehmen oder entwickeln Sie ein Metriksystem speziell für Ihre Geschäftsanforderungen.

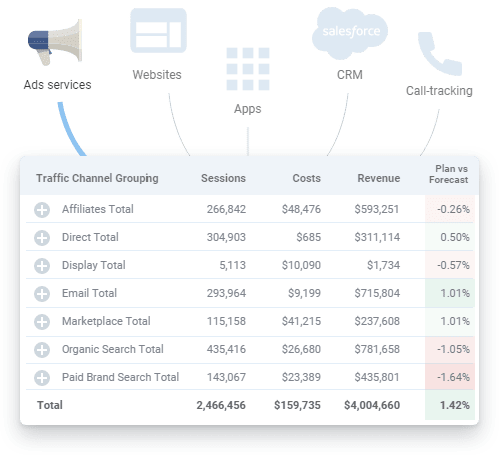

- Sammeln Sie Primärdaten . OWOX BI sammelt Rohdaten von Google Analytics, Werbediensten, Websites, Offline-Shops, Anrufverfolgungssystemen und CRM-Systemen in Ihrem Datenspeicher. Die Plattform funktioniert reibungslos mit großen Werbekonten und lädt alle Daten unabhängig von der Anzahl der Kampagnen hoch. Neben dem automatischen Import von Kostendaten erkennt OWOX BI dynamische Parameter in UTM-Tags, rechnet Kosten in eine Währung um und überwacht die Relevanz der Daten.

Sie müssen nicht mehr nach verschiedenen Konnektoren suchen und unser Team kann bei Bedarf sogar benutzerdefinierte Integrationen für Sie einrichten.

- Rohdaten normalisieren . Wenn Sie OWOX BI verwenden, müssen Sie Daten nicht manuell bereinigen, strukturieren und verarbeiten. Sie erhalten fertige Datensätze in der übersichtlichsten und bequemsten Struktur. Darüber hinaus können Sie jederzeit einen visuellen Bericht über die Relevanz von Daten von Werbediensten erhalten, die in Google Analytics hochgeladen wurden.

- Geschäftsdaten vorbereiten . Mit OWOX BI haben Sie vertrauenswürdige, geschäftsbereite Daten zur Hand. Sie müssen nicht mehr für jeden neuen Bericht einen neuen Datensatz erstellen, da Sie vorgefertigte endgültige Datensätze erhalten, die gemäß Ihrem Geschäftsdatenmodell erstellt wurden. Mit aktuellen und einheitlichen Daten, die für eine weitere Datensegmentierung bereit sind, können Sie Einblicke in die Geschwindigkeit Ihres Unternehmens erhalten und den Wert Ihrer Daten steigern.

- Daten visualisieren . Mit der OWOX BI-Plattform können Sie Ihre Daten analysieren und visualisieren, wo immer Sie wollen. Sobald Ihre Marketingdaten fertig sind, können Sie sie mit wenigen Klicks an das BI- oder Visualisierungstool Ihrer Wahl senden.

Buchen Sie eine kostenlose Demo, um zu sehen, wie OWOX BI die Datenqualität garantiert und wie Sie noch heute von einem vollautomatisierten Datenmanagement profitieren können!

Schritt 5. Daten visualisieren

Die visuelle Darstellung von Schlüsselmetriken ist der letzte Schritt, damit Daten funktionieren, daher sollte Ihre Datenpräsentation sowohl informativ als auch benutzerfreundlich sein. Automatisierte und richtig konfigurierte Visualisierungen können die Zeit zum Auffinden eines Problems erheblich verkürzen; Das heißt, Sie können im selben Zeitraum mit weniger Aufwand mehr Iterationen durchführen, um die Datenqualität zu verbessern.

Denken Sie auch daran, dass Datenvisualisierungsdienste wie das beliebte Google Data Studio keine Daten zusammenführen oder transformieren können. Wenn Sie Berichte benötigen, die auf vielen Datenquellen basieren, empfehlen wir Ihnen, alle benötigten Daten vorab in einem einzigen Datenspeicher zu sammeln, um Schwierigkeiten zu vermeiden.

Datenqualitätsprobleme, auf die Sie bei diesem Schritt stoßen können:

1. Tatsächliche Datenfehler

Was ist das?

Wenn auf den vorherigen Ebenen der Datenerfassung und -normalisierung etwas schief geht, können Datenfehler in Berichten landen, die von Datenvisualisierungsdiensten angezeigt werden.

Was stimmt damit nicht?

Berichte, die mit sachlichen Datenfehlern erstellt wurden, sind Zeit- und Geldverschwendung. Sie bieten keinen Gewinn oder wertvolle Einblicke in Risiko- und Wachstumszonen für das Unternehmen. Tut mir leid, Mario, aber die Prinzessin ist in einem anderen Schloss!

Was sind die Gründe?

Einfach ausgedrückt, die visualisierten Daten sind nicht relevant. Um jedoch die Quelle dieser Fehler herauszufinden, sollten Sie den ganzen Weg zurückgehen, um Ihre Daten erneut zu überprüfen.

Wie kann man dieses Problem lösen?

Die einzige Möglichkeit, dieses Problem zu lösen, besteht darin, die Daten gründlich aufzubereiten und ihre Qualität zu überwachen, bevor Berichte erstellt werden.

2. Fehlerhafte SQL-Abfragen oder zu viele Änderungen an Berichten (und/oder SQL-Abfragen)

Was ist das?

Die Datenanforderungen ändern sich ständig, und auch die SQL-Abfragen ändern sich. Je komplizierter das Berichtssystem wird, desto leichter kann es zusammenbrechen.

Was stimmt damit nicht?

An Änderungen ist nichts auszusetzen, es sei denn, es gibt so viele, dass es unmöglich ist, sich daran zu erinnern, welche Änderungen wann und wo vorgenommen wurden. Schließlich können alle sorgfältig aufgebauten Berichtssysteme verschwinden, da die SQL-Abfragen nicht funktionieren und es keine korrekten Daten zum Visualisieren gibt.

Was sind die Gründe?

Es ist eine ziemliche Herausforderung, sich an jede Kleinigkeit zu erinnern, daher besteht der typische Fehler darin, zu vergessen, Änderungen an allen Datensätzen vorzunehmen, wo sie benötigt werden.

Wie kann man dieses Problem lösen?

Idealerweise sollten Benutzer in der Lage sein, Marketingberichte zu erstellen, ohne viele SQL-Abfragen zu verwenden und ohne viele Änderungen und/oder Bearbeitungen vornehmen zu müssen.

3. Missverständnis und Missbrauch gesammelter Daten

Was ist das?

Eines der häufigsten Probleme besteht darin, Daten falsch zu verstehen (und sie daher zu missbrauchen). Dies geschieht, wenn eine bestimmte Metrik oder ein bestimmter Parameter auf mehr als eine Weise interpretiert werden kann. Angenommen, ein Bericht enthält einen Conversion-Messwert und dieser Bericht wird von verschiedenen Benutzern verwendet. Einer der Benutzer denkt, dass eine Conversion einen Website-Besuch bedeutet, während ein anderer denkt, dass es eine Bestellung bedeutet. Es gibt jedoch auch eine dritte Person, die glaubt, dass es bei dieser Konversionsmetrik um gelieferte und gekaufte Bestellungen geht. Wie Sie sehen können, gibt es viele mögliche Interpretationen, daher müssen Sie deutlich machen, welche Informationen im Bericht enthalten sind.

Was stimmt damit nicht?

Wenn es kein klares Verständnis dafür gibt, welche Daten in Berichten und Dashboards verwendet werden, gibt es keine Garantie dafür, dass Ihre Entscheidungen auf den Fakten vor Ort basieren.

Was sind die Gründe?

Eine unklare Erläuterung von Metriken und Parametern, die in Berichten verwendet werden, oder eine unangemessene Art der Datenvisualisierung können zu schlechten Entscheidungen führen.

Wie kann man dieses Problem lösen?

Die Datenüberprüfung endet nicht, wenn Sie sicherstellen, dass Ihre Eingabedaten korrekt und relevant sind. Diese Daten können immer noch missbraucht werden. Um dieses Problem zu vermeiden, müssen Endbenutzer Zugriff auf vollständige, aktuelle und betriebsbereite Daten mit klaren und präzisen Erläuterungen zu den in den Berichten enthaltenen Informationen haben.

Unsere Kunden

zunehmen 22 % schneller

Wachsen Sie schneller, indem Sie messen, was in Ihrem Marketing am besten funktioniert

Analysieren Sie Ihre Marketingeffizienz, finden Sie die Wachstumsbereiche, steigern Sie den ROI

Demo erhaltenDie zentralen Thesen

Qualitätsanalysen beginnen mit Qualitätsdaten. Ihre Datenbemühungen sollten wertvoll und vertrauenswürdig sein. Aus diesem Grund sollten Sie Datenfehler und Diskrepanzen proaktiv identifizieren und bekämpfen, um ganzheitliche Leistungsberichte zu erhalten und die Qualität Ihrer Daten zu verbessern. Generell ist die Verbesserung der Datenqualität ein iterativer Prozess, bei dem drei Schritte unterschieden werden können:

- Überprüfung des Status Ihrer Daten

- Lokalisieren eines Problems, das die Datenqualität beeinträchtigt

- Behebung des Problems

Am zeitaufwändigsten sind die ersten beiden Schritte. Es ist schwierig zu erkennen, dass ein Problem vorliegt, und zu verstehen, in welchen Situationen ein Fehler auftritt. Nachdem klar ist, was das Problem ist und wo es sich befindet, stellt es sich als relativ einfach heraus, es zu beheben.

Schließlich können Sie drei Dokumente erstellen, um Ihre Daten zu verbessern:

- Datenbewegungsschema

- Verantwortungsmatrix (wer ist wofür verantwortlich)

- Geschäftsdatenmodell