Problèmes courants de qualité des données et comment les surmonter

Publié: 2022-04-12Bien que nous soyons à l'ère des technologies axées sur les données, plus de 50 % des cadres supérieurs sont généralement insatisfaits de la valeur obtenue à partir de l'analyse. L'une des principales raisons à cela est la mauvaise qualité des données . De plus, avoir des données de mauvaise qualité au tout début de toute tâche rend les actions ultérieures inutiles. De plus, toute décision prise sera basée sur des informations erronées, et pour les entreprises, c'est certainement une mauvaise nouvelle.

C'est pourquoi nous avons décidé de partager nos nombreuses années d'expérience et d'expertise dans le domaine des données. Au cours de la dernière année, nous avons beaucoup discuté avec nos collègues analystes et mené de nombreuses entrevues avec des spécialistes de classe mondiale. Nous voulons maintenant fournir des conseils sur les problèmes les plus fréquents liés au travail avec les données et sur la manière de les surmonter.

Dans l'article, nous discutons des étapes d'un flux de travail de données, des erreurs qui peuvent se produire et pourquoi. Et surtout, nous partageons des approches pour résoudre les problèmes de qualité des données.

Table des matières

- D'où viennent les problèmes de qualité des données ?

- Étape 1. Planifier les mesures

- Étape 2. Collecter les données primaires

- Étape 3. Normaliser les données brutes

- Étape 4. Préparez des données prêtes pour l'entreprise

- Repensez votre rapport aux données avec OWOX BI

- Étape 5. Visualisez les données

- Points clés à retenir

Quelques définitions avant de commencer :

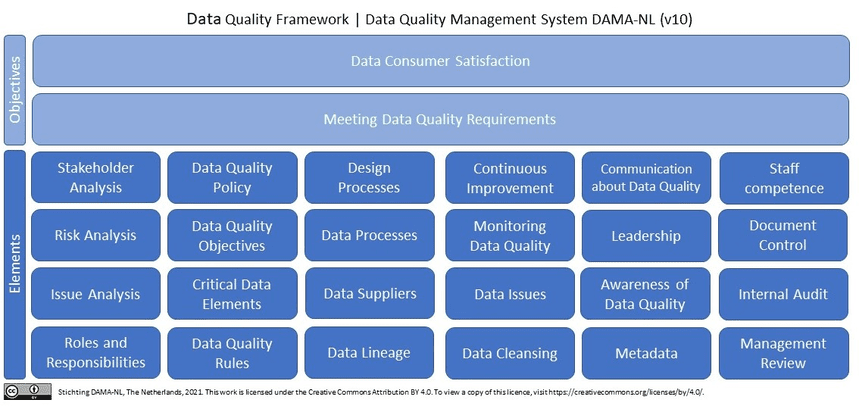

Qu'est-ce qu'une donnée de qualité ? En un mot (et en termes de données marketing), des données de qualité sont des données pertinentes, à jour, sans erreurs ni écarts . Si nous recherchons la qualité des données sur Wikipedia, nous verrons plus de 10 (!) définitions. En outre, Wikipedia cite les dernières recherches de DAMA NL sur les définitions des dimensions de la qualité des données en utilisant ISO 9001 comme cadre de référence.

Pourquoi les données de qualité sont-elles indispensables pour les spécialistes du marketing, les analystes et les décideurs ? Sans données de qualité et fiables, il est impossible de prendre des décisions en s'appuyant sur des analyses marketing.

D'où viennent les problèmes de qualité des données ?

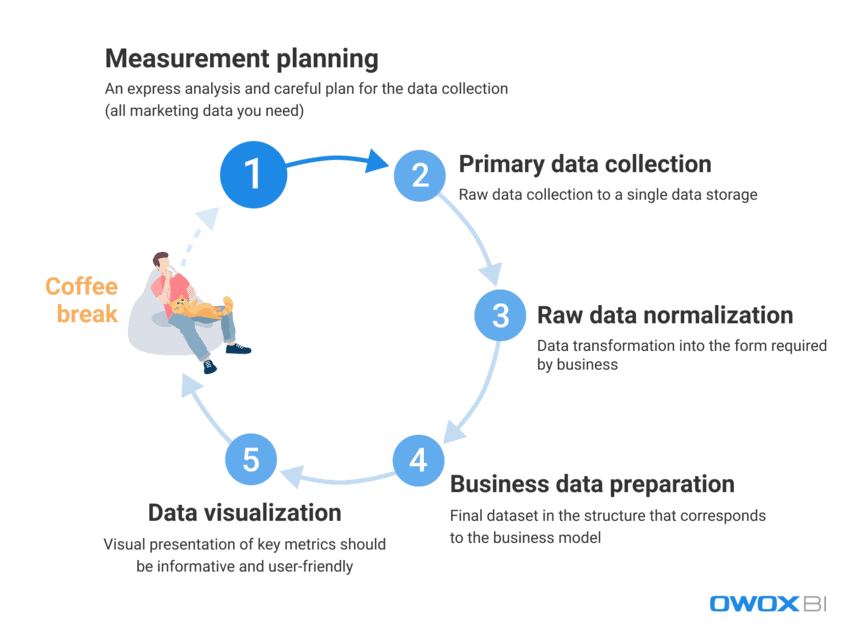

Face à la grande quantité de données que les spécialistes du marketing et les analystes utilisent quotidiennement, il est difficile d'éliminer complètement les erreurs et les écarts. Il est extrêmement difficile de fournir immédiatement des données de qualité à un utilisateur final ; cependant, les erreurs de données peuvent être combattues activement et trouvées de manière proactive. Tout d'abord, examinons le processus de travail avec les données et distinguons les étapes où les problèmes de qualité des données peuvent apparaître :

- Planification des mesures

- Collecte de données primaires

- Normalisation des données brutes

- Préparation des données commerciales

- Visualisation de données

D'après notre expérience, les erreurs de données factuelles apparaissent généralement au cours des deux premières étapes, tandis que les cas d'utilisation abusive des données se produisent plus fréquemment au cours des dernières étapes.

Voyons plus en détail quels problèmes de qualité des données peuvent survenir à ces étapes et comment les résoudre.

Étape 1. Planifier les mesures

Même s'il n'y a pas d'erreurs dans les données à cette étape, nous ne pouvons pas complètement l'omettre. Le diable est dans les détails, et la collecte de données pour l'analyse commence par une planification détaillée. Notre recommandation est de toujours commencer par une analyse expresse et de planifier soigneusement la collecte de toutes les données marketing dont vous avez besoin.

Sauter l'étape de planification conduit à une approche non structurée et à un manque de données pour de nouvelles tâches ou projets, alors que l'objectif est de collecter des données fragmentées à partir de toutes les sources de données avec lesquelles vous travaillez. Si vous ne disposez pas de toutes les données, cela rend vos décisions et vos actions erronées dès le début. Voyons quelles données vous devez collecter avant de démarrer de nouveaux projets :

- Données sur le comportement des utilisateurs de votre site Web et/ou application

- Données de coût des plateformes publicitaires

- Suivi des appels, chatbot et données de messagerie

- Données de ventes réelles de vos systèmes CRM/ERP, etc.

Étape 2. Collecter les données primaires

Une fois que vous avez créé votre plan de mesure, passons à l'étape principale de collecte de données. Au cours de cette étape, parmi tous les autres défis que vous devez surmonter, vous devez envisager de contrôler l'accès à vos données (tout est question de sécurité des données) et de préparer en amont la création de votre stockage de données ou lac de données.

Si vous souhaitez avoir un contrôle total sur vos données brutes sans les modifier, notre recommandation est d'utiliser un stockage unique avec importation automatisée des données. Pour les besoins marketing, Google BigQuery reste l'une des meilleures options.

Quelles difficultés de qualité des données vous pouvez rencontrer à cette étape :

1.1 Obtenir des données incomplètes et incorrectes de l'API d'un service publicitaire

Qu'est-ce que c'est?

Les plates-formes et services publicitaires collectent de grandes quantités de données précieuses sur le comportement des utilisateurs, et le problème se produit lorsque vous essayez d'obtenir toutes ces informations dans leur intégralité à partir de ces sources de données sans nuire à leur exhaustivité.

*Une interface de programmation d'application (API) est une partie du serveur qui transmet des données (reçoit des demandes et envoie des réponses), interagissant avec l'utilisateur chaque fois que l'utilisateur visite une page du site Web. La plupart des sites Web modernes utilisent au moins plusieurs API tierces.

Qu'est-ce qui ne va pas avec ça?

Un service publicitaire collecte des données sur les actions d'un utilisateur ; cependant, les données peuvent changer rétrospectivement après leur transfert et l'API de service peut être mise à jour ou être indisponible pendant un certain temps. En conséquence, une partie des données ne sera tout simplement pas livrée et la qualité globale des données sera corrompue. L'analyste peut ne pas le savoir et utiliser des données non pertinentes pour préparer les données commerciales. Cependant, il n'est pas possible d'obtenir des informations utiles ou de prendre la bonne décision sur la base de données incomplètes et/ou inexactes. En termes simples, vous pouvez investir beaucoup de temps et d'efforts et vous retrouver au bas de l'échelle sans données utiles ni preuve que la performance est réussie et rentable pour l'entreprise.

Quelles sont les raisons?

Les données peuvent être incomplètes ou incorrectes en raison de pertes de données, de divergences ou de doublons. Les raisons courantes de ces problèmes incluent :

- Un nouveau compte sur une plateforme publicitaire est créé, mais les analystes ne sont pas informés et les données ne sont pas collectées.

- Une API ne prend pas en charge les paramètres dynamiques dans les balises UTM et ne les collecte ni ne les transfère. Si vous utilisez des paramètres non pris en charge dans les balises UTM, vous verrez les noms des paramètres au lieu de leurs valeurs, par exemple, {{geo}} au lieu du nom réel de la campagne.

- Mises à jour rétrospectives des données. Les services publicitaires mettent souvent à jour rétrospectivement les données (sur les coûts, les clics et les impressions dans les comptes publicitaires). Cependant, tous les analystes n'en sont pas conscients et n'en tiennent pas compte.

Comment résoudre ce problème?

Puisqu'il est impossible de contrôler directement le code lorsque vous travaillez avec des API, vous pouvez résoudre ces problèmes en :

- répartir les domaines de responsabilité lors de la collecte de données pour mieux contrôler la collecte de données.

- en utilisant des outils d'importation de données automatisés qui prennent en charge les modifications d'API, les paramètres dynamiques, etc. En cas d'indisponibilité des données, ces outils peuvent afficher les lacunes existantes dans les données et télécharger les données rétrospectivement.

1.2 Obtenir des données incomplètes et incorrectes d'un site Web

Qu'est-ce que c'est?

En analysant les données des services publicitaires, nous savons combien nous dépensons en publicité. À partir des données sur le comportement des utilisateurs du site Web, nous obtenons des informations sur nos revenus. Étant donné que les questions commerciales ressemblent généralement à "quelle publicité est payante et laquelle ne l'est pas?" il est essentiel de connaître le ratio revenus/dépenses.

Qu'est-ce qui ne va pas avec ça?

Les données sur le comportement des utilisateurs du site Web diffèrent des données sur les coûts collectées par les services publicitaires, car les données sur le comportement des utilisateurs du site Web :

- est collecté directement par les propriétaires de sites Web

- est beaucoup plus important en volume que les données sur les coûts des services publicitaires

De plus, si nous ne remarquons pas qu'il n'y a pas de collecte de données sur le comportement des utilisateurs et que nous n'éliminons pas le problème, ces données sont perdues à jamais.

Comme pour les problèmes de collecte de données à partir des API des services publicitaires, des informations incomplètes ou incorrectes conduisent à des solutions erronées. Des décisions de gestion incorrectes entraînent à leur tour une perte de revenus.

Quelles sont les raisons?

Des erreurs peuvent se produire lors de la collecte des données du site Web car :

- Toutes les pages du site Web n'ont pas de conteneur Google Tag Manager (GTM). GTM collecte le résultat des campagnes publicitaires et les données de comportement des utilisateurs. Par conséquent, s'il n'y a pas de conteneur GTM sur la page, aucune donnée n'est collectée.

- Le projet Google Cloud n'est pas payé à temps et la collecte des données est donc suspendue.

- L'exactitude des données saisies dans les formulaires de candidature par les utilisateurs du site Web (nom, adresse, e-mail, etc.) n'est pas validée.

Comment résoudre ce problème?

Comme pour la collecte de données à partir d'une API, les solutions de collecte de données de site Web incluent :

- répartir les domaines de responsabilité lors de la collecte de données pour mieux contrôler la collecte de données

- utiliser des outils d'importation de données automatisés ; en cas d'indisponibilité des données, ces outils peuvent vous avertir des erreurs de données existantes

2. Obtenir des données agrégées et échantillonnées

Qu'est-ce que c'est?

Les données agrégées et échantillonnées sont des données généralisées qui apparaissent dans les cas où toutes les données ne sont pas traitées et utilisées pour l'analyse et les rapports. Cela se produit lorsque des services comme Google Analytics n'analysent qu'une partie des données pour réduire la charge sur les serveurs et équilibrer la vitesse et la précision du traitement des données. Étant donné que l'échantillonnage aboutit à une généralisation, il conduit à un manque de confiance dans les résultats obtenus.

Qu'est-ce qui ne va pas avec ça?

Les rapports échantillonnés déforment les données de performance, ce qui peut vous coûter une fortune en ce qui concerne les mesures liées à l'argent telles que les objectifs, les conversions et les revenus. Pour cette raison, vous risquez de ne pas remarquer une campagne publicitaire rentable et de la désactiver en raison de données déformées dans un rapport, ou vice versa - vous risquez de dépenser tout votre argent dans des campagnes inefficaces.

En d'autres termes, chaque fois qu'un échantillonnage est appliqué, il y a un risque d'obtenir des résultats inexacts. Et si vous essayez de prendre une décision basée sur une partie seulement des données, vous jouez à des devinettes avec le budget de l'entreprise.

Quelles sont les raisons?

Afin de créer des rapports dès que possible et d'économiser des ressources, les systèmes appliquent l'échantillonnage, l'agrégation et le filtrage au lieu de traiter des tableaux de données volumineux.

Comment résoudre ce problème?

La seule chose que vous puissiez faire pour éviter l'échantillonnage des données est de collecter des données brutes et de vérifier en permanence l'exhaustivité des données dans tous vos rapports. Cette surveillance du processus est de préférence effectuée automatiquement afin d'éluder les facteurs humains. Par exemple, vous pouvez appliquer des tests automatiques de collecte de métriques correctes sur votre site Web comme OZON l'a fait avec l'aide d'OWOX BI.

Étape 3. Normaliser les données brutes

Après avoir collecté toutes les données nécessaires, il est temps de les normaliser. À cette étape, les analystes transforment les informations disponibles sous la forme requise par l'entreprise. Par exemple, nous devons obtenir des numéros de téléphone dans un format unique.

La normalisation des données est un « travail de singe » manuel et routinier qui empêche généralement les analystes de réaliser des tâches plus passionnantes telles que l'extraction d'informations utiles sur les données. Sans compter que les difficultés de normalisation occupent généralement jusqu'à 50 % du temps de travail global d'un analyste.

Les difficultés de qualité des données que l'on peut rencontrer à ce stade :

1. Dépendances d'insertion, de mise à jour et de suppression

Qu'est-ce que c'est?

Ce sont des effets secondaires gênants qui apparaissent lors de la normalisation de données non structurées.

Qu'est-ce qui ne va pas avec ça?

Le résultat commun de ces dépendances de données est que les systèmes de reporting éliminent ces données incorrectes lors de leur analyse. Par conséquent, nous nous retrouvons avec des rapports inexacts qui ne sont pas basés sur des données complètes. Par exemple, disons que nous avons un objet sessions et un objet ads. Dans les sessions, nous avons des données pour les jours 10 à 20, et dans les publicités, il y a des données des jours 10 à 15 (pour une raison quelconque, il n'y a pas de données de coût pour les jours 16 à 20). En conséquence, soit nous perdons les données des publicités pendant les jours 16 à 20, soit les données des sessions ne seront disponibles que pendant les jours 10 à 15.

Quelles sont les raisons?

Des effets secondaires indésirables apparaissent lorsqu'une API de service publicitaire est modifiée, n'est pas disponible ou renvoie des données incorrectes.

Comment résoudre ce problème?

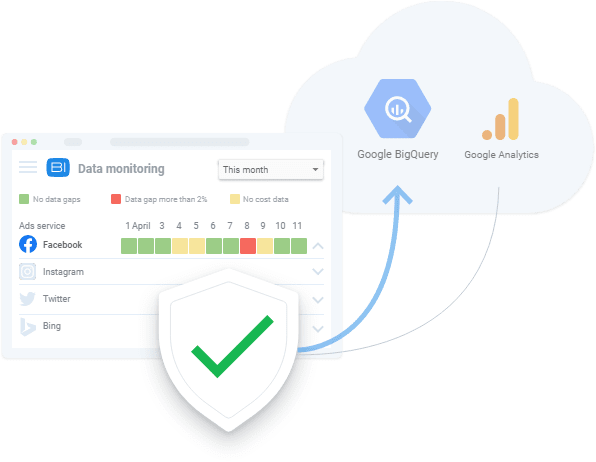

De la même manière, vous vérifiez les erreurs de collecte de données, vous devez toujours vérifier les données avec lesquelles vous travaillez. De plus, si les spécificités de la fusion de données ne sont pas connues de l'utilisateur, il est probable que des erreurs se produiront lors de la normalisation des données. En pratique, la meilleure décision à cette étape est de développer un système de surveillance de la qualité des données qui alerte la personne responsable de la qualité des données en cas d'anomalies des données. Pour cela, vous pouvez utiliser des services tels que OWOX BI avec sa fonctionnalité de surveillance des données intégrée.

Nos clients

croître 22 % plus rapide

Développez-vous plus rapidement en mesurant ce qui fonctionne le mieux dans votre marketing

Analysez votre efficacité marketing, trouvez les zones de croissance, augmentez le ROI

Obtenir une démo2. Différents formats de données, structures et niveaux de détail

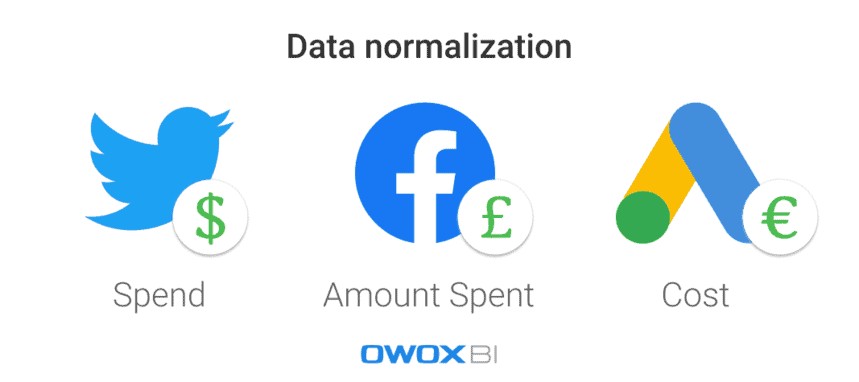

Qu'est-ce que c'est?

Chaque plate-forme ou service publicitaire utilise différents formats de données, devises et structures. Par conséquent, après avoir collecté des données de toutes les sources, vous devez les normaliser dans un format/une structure unique.

Qu'est-ce qui ne va pas avec ça?

C'est une tâche difficile de construire une forteresse triangulaire quand tout ce que vous avez est des pièces rondes et ovales. Lorsque vous disposez de nombreux ensembles de données dans différents formats, vous ne pouvez tout simplement pas créer un rapport avant d'avoir unifié les données.

Quelles sont les raisons?

Il existe différents schémas de données dans les services publicitaires. Par exemple, la même colonne sur différentes plates-formes peut être nommée Product Name et Product Category. Un autre exemple consiste à utiliser différentes devises dans les données de coût : dollars pour les publicités Twitter et livres sur Facebook, par exemple.

Comment résoudre ce problème?

Avant d'analyser les données, elles doivent être converties dans un format unique ; sinon, rien de bon ne sortira de votre analyse. Par exemple, vous devez fusionner les données de session utilisateur avec les données de coût publicitaire pour mesurer l'impact de chaque source de trafic ou canal marketing particulier et pour voir quelles campagnes publicitaires vous rapportent le plus de revenus. Bien sûr, cela peut être fait manuellement en utilisant des scripts et SQL, mais l'application de solutions automatisées est un meilleur choix.

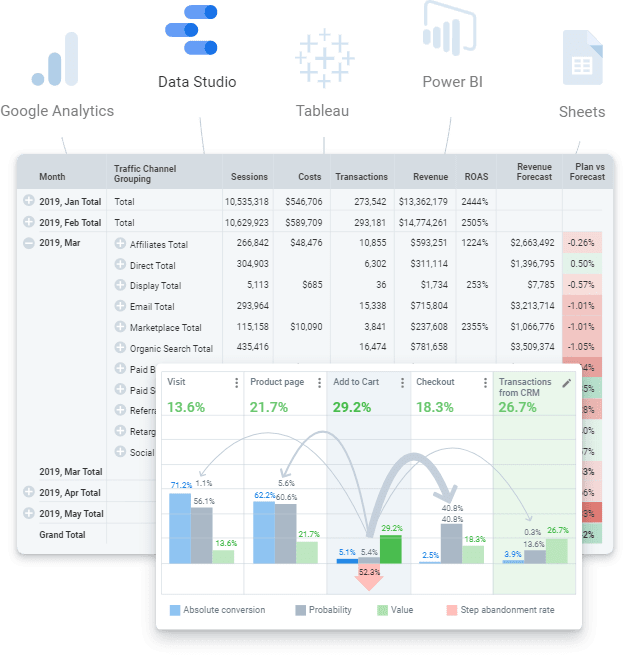

Étape 4. Préparez des données prêtes pour l'entreprise

Les données prêtes pour l'entreprise sont un ensemble de données final nettoyé dans la structure qui correspond au modèle commercial. En d'autres termes, si vous avez suivi toutes les étapes de travail avec les données et que vous avez tout terminé, vous devriez obtenir l'ensemble de données final. Ses données prêtes à l'emploi qui peuvent être envoyées à n'importe quel service de visualisation de données (Power BI, Tableau, Google Data Studio, etc.).

Cependant, il ne faut pas le confondre avec des données brutes sur lesquelles vous pouvez essayer de construire un rapport. C'est une approche erronée qui entraînera de nombreux problèmes récurrents : trouver les erreurs et les causes des écarts prendra beaucoup de temps, et la logique métier devra être constamment dupliquée dans toutes les requêtes SQL. Bien sûr, un tel volume de données brutes et non structurées est difficile à maintenir à jour et à contrôler les changements dans la logique des transformations. Par exemple, vous pouvez rencontrer des problèmes tels que la mise à jour de l'historique des données de coût après que le service de publicité l'a ajusté. Un autre exemple pourrait être le rachat de transactions terminées. Dans ce cas, il faut du temps pour comprendre si la transaction a été remboursée, mais nous devons attribuer ce statut au moment de la commande.

Malheureusement, il est courant de sauter cette étape et de passer directement à la création du rapport. Cependant, notre expérience démontre que l'utilisation d'un ensemble de données final et la préparation de données prêtes à l'emploi pour le monde moderne de l'analyse sont indispensables. À long terme, il est moins cher et plus facile de travailler avec des données préparées au lieu de parcourir des données brutes en faisant les mêmes choses encore et encore.

Quelles difficultés de qualité des données peuvent apparaître lors de cette étape :

1. Le manque de définitions des données entraîne des divergences

Qu'est-ce que c'est?

Il est difficile de contrôler les changements dans la logique de transformation en raison de définitions incohérentes ou absentes des types de données nécessaires tout au long du traitement des données.

Qu'est-ce qui ne va pas avec ça?

Lorsque les données ne sont pas clairement définies, les utilisateurs ne sont pas sur la même longueur d'onde concernant l'utilisation des données : ils ne savent pas quelle table ou colonne interroger, quel filtre utiliser ou à qui demander des informations sur les objets de données. En outre, il faut trop de temps pour parcourir et comprendre tous les objets de données à partir de données brutes, y compris leurs attributs, leur place dans le modèle de données et leur pertinence les uns par rapport aux autres.

Quelles sont les raisons?

Une entreprise n'a pas clairement défini ses données de base et son modèle de données. Par conséquent, la logique de fusion des données est incompréhensible.

Comment résoudre ce problème?

Tout d'abord, n'appliquez pas de logique métier à chaque rapport ou ensemble de données, mais utilisez la modélisation des données au niveau de l'entreprise. Au sein de l'entreprise, il devrait y avoir un modèle de données commerciales transparent et un contrôle du cycle de vie des données. Cela signifie que toutes les définitions utilisées doivent être claires. Par exemple, les utilisateurs finaux doivent être conscients de ce que représentent les mesures de conversion et de visite du site Web.

Parallèlement à cela, comme il est difficile de préparer et de maintenir à jour des données simulées, la réponse réside dans l'application de solutions automatisées (par exemple, l'outil de création de données (dbt)) qui peuvent collecter, nettoyer, normaliser et surveiller la qualité de vos données. il est donc prêt pour l'entreprise.

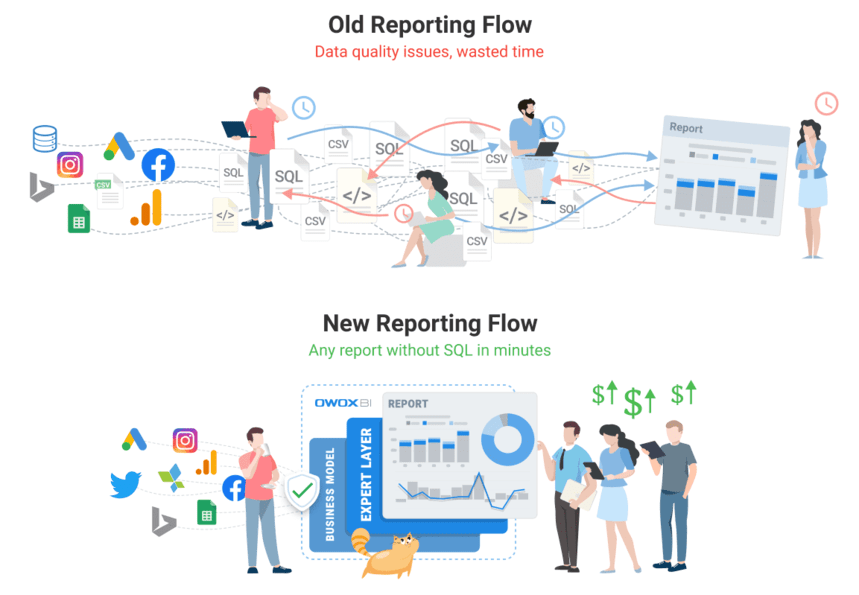

Repensez votre rapport aux données avec OWOX BI

L'équipe OWOX BI connaît mieux que quiconque la gravité du problème de données, puisque chacun de nos clients le rencontre. Nous avons créé un produit qui permet aux analystes d'automatiser la routine, de fournir une valeur commerciale à partir des données et d'assurer la qualité des données.

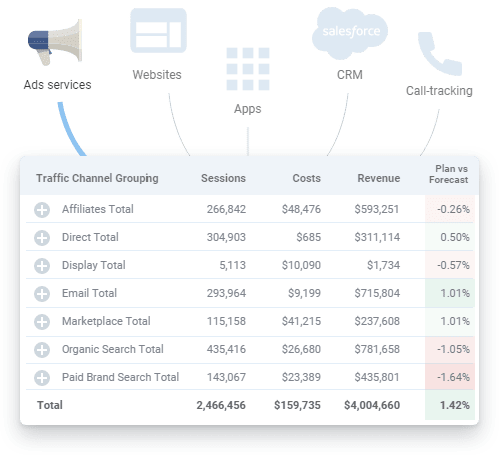

OWOX BI est une plateforme unifiée qui vous permet de collecter, préparer et analyser toutes vos données marketing. Il automatise la livraison des données à partir de sources cloisonnées vers votre destination d'analyse, garantissant que les données sont toujours exactes et à jour.

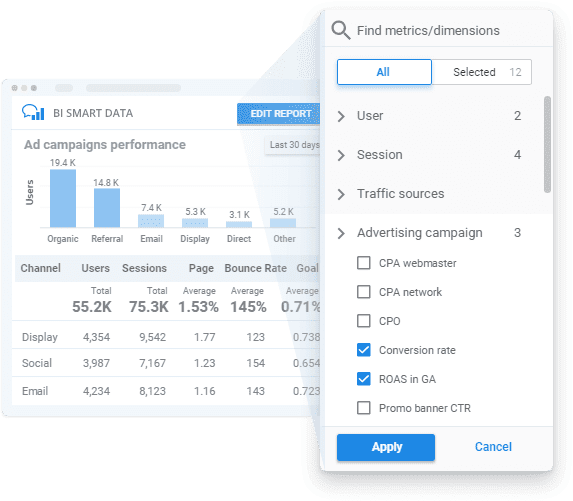

En appliquant OWOX BI, vous pouvez obtenir des données prêtes pour l'entreprise en fonction de votre modèle commercial avec une surveillance transparente de la qualité des données et un générateur de rapports facile à utiliser pour débloquer des informations sans SQL ni code.

Voyons comment OWOX BI peut vous aider à toutes les étapes que nous avons mentionnées ci-dessus.

- Planifiez vos mensurations . Créez un plan de mesure pour votre entreprise ou développez un système de mesures spécialement pour les besoins de votre entreprise avec l'aide de nos spécialistes.

- Recueillir des données primaires . OWOX BI collecte des données brutes de Google Analytics, des services publicitaires, des sites Web, des magasins hors ligne, des systèmes de suivi des appels et des systèmes CRM dans votre stockage de données. La plate-forme fonctionne sans problème avec les grands comptes publicitaires et télécharge toutes les données quel que soit le nombre de campagnes. Outre l'importation automatique des données de coût, OWOX BI reconnaît les paramètres dynamiques dans les balises UTM, convertit les coûts en une seule devise et surveille la pertinence des données.

Vous n'avez plus besoin de chercher divers connecteurs et, si nécessaire, notre équipe peut même mettre en place pour vous des intégrations personnalisées.

- Normaliser les données brutes . Lorsque vous utilisez OWOX BI, vous n'avez pas besoin de nettoyer, structurer et traiter manuellement les données. Vous recevrez des ensembles de données prêts dans la structure la plus claire et la plus pratique. De plus, vous pouvez à tout moment obtenir un rapport visuel sur la pertinence des données des services publicitaires téléchargées sur Google Analytics.

- Préparer les données commerciales . Avec OWOX BI, vous avez à portée de main des données fiables prêtes à l'emploi. Il n'est plus nécessaire de créer un nouvel ensemble de données pour chaque nouveau rapport, car vous obtenez des ensembles de données finaux prédéfinis préparés selon votre modèle de données d'entreprise. Avec des données à jour et unifiées prêtes pour une segmentation plus poussée des données, vous pouvez obtenir des informations sur la vitesse de votre entreprise et augmenter la valeur de vos données.

- Visualisez les données . La plateforme OWOX BI vous permet d'analyser et de visualiser vos données où vous le souhaitez. Une fois vos données marketing prêtes, vous pouvez les envoyer vers l'outil de BI ou de visualisation de votre choix en quelques clics.

Réservez une démo gratuite pour voir comment OWOX BI garantit la qualité des données et comment vous pouvez bénéficier dès aujourd'hui d'une gestion des données entièrement automatisée !

Étape 5. Visualisez les données

La présentation visuelle des indicateurs clés est la dernière étape pour que les données fonctionnent, votre présentation de données doit donc être à la fois informative et conviviale. Des visualisations automatisées et correctement configurées peuvent réduire considérablement le temps nécessaire pour trouver un problème ; c'est-à-dire que vous pouvez effectuer plus d'itérations avec moins d'effort sur la même période pour améliorer la qualité des données.

De plus, il est important de se rappeler que les services de visualisation de données comme le populaire Google Data Studio ne peuvent pas fusionner ou transformer des données. Si vous avez besoin de rapports basés sur de nombreuses sources de données, notre recommandation est de collecter toutes les données dont vous avez besoin au préalable dans un seul stockage de données pour éviter toute difficulté.

Difficultés de qualité des données que vous pouvez rencontrer à cette étape :

1. Erreurs de données factuelles

Qu'est-ce que c'est?

En cas de problème aux niveaux précédents de collecte et de normalisation des données, des erreurs de données peuvent se retrouver dans les rapports affichés par les services de visualisation de données.

Qu'est-ce qui ne va pas avec ça?

Les rapports créés avec des erreurs de données factuelles sont une perte de temps et d'argent. Ils ne fournissent aucun profit ou des informations précieuses sur les zones de risque et de croissance de l'entreprise. Désolé, Mario, mais la princesse est dans un autre château !

Quelles sont les raisons?

Autrement dit, les données visualisées ne sont pas pertinentes. Cependant, pour découvrir la source de ces erreurs, vous devez revenir en arrière pour vérifier à nouveau vos données.

Comment résoudre ce problème?

La seule façon de résoudre ce problème est de bien préparer les données et de surveiller leur qualité avant de créer des rapports.

2. Requêtes SQL interrompues ou trop de modifications apportées aux rapports (et/ou requêtes SQL)

Qu'est-ce que c'est?

Les exigences en matière de données changent constamment et les requêtes SQL changent également. En conséquence, plus le système de déclaration devient compliqué, plus il est facile de le casser.

Qu'est-ce qui ne va pas avec ça?

Il n'y a rien de mal avec les changements, à moins qu'il y en ait tellement qu'il est impossible de se rappeler quels changements ont été apportés, où et quand. Finalement, tous les systèmes de reporting soigneusement construits peuvent disparaître, car les requêtes SQL ne fonctionnent pas et il n'y a pas de données correctes à visualiser.

Quelles sont les raisons?

C'est tout un défi de se souvenir de chaque petite chose, donc l'erreur typique est d'oublier d'appliquer des modifications sur tous les ensembles de données où elles sont nécessaires.

Comment résoudre ce problème?

Idéalement, les utilisateurs devraient pouvoir générer des rapports marketing sans utiliser de nombreuses requêtes SQL et sans avoir besoin d'appliquer de nombreux changements et/ou modifications.

3. Incompréhension et mauvaise utilisation des données collectées

Qu'est-ce que c'est?

L'un des problèmes les plus courants est la mauvaise compréhension des données (et, par conséquent, leur mauvaise utilisation). Cela se produit lorsqu'une métrique ou un paramètre particulier peut être interprété de plusieurs façons. Par exemple, supposons qu'il existe une statistique de conversion dans un rapport et que ce rapport est utilisé par différents utilisateurs. L'un des utilisateurs pense qu'une conversion signifie une visite sur le site Web, tandis qu'un autre pense que cela signifie passer une commande. Cependant, il y a aussi une troisième personne qui pense que cette métrique de conversion concerne les commandes livrées et achetées. Comme vous pouvez le voir, il existe de nombreuses interprétations potentielles, vous devez donc indiquer clairement quelles informations sont présentées dans le rapport.

Qu'est-ce qui ne va pas avec ça?

S'il n'y a pas de compréhension claire des données utilisées dans les rapports et les tableaux de bord, il n'y a aucune garantie que vos décisions seront basées sur les faits sur le terrain.

Quelles sont les raisons?

Une explication peu claire des métriques et des paramètres utilisés dans les rapports ou un type inapproprié de visualisation des données peut conduire à de mauvaises décisions.

Comment résoudre ce problème?

La vérification des données ne s'arrête pas lorsque vous vous assurez que vos données d'entrée sont correctes et pertinentes. Ces données peuvent toujours être utilisées à mauvais escient. Pour éviter ce problème, les utilisateurs finaux doivent avoir accès à des données complètes, à jour et prêtes à l'emploi avec des explications claires et précises sur les informations présentées dans les rapports.

Nos clients

croître 22 % plus rapide

Développez-vous plus rapidement en mesurant ce qui fonctionne le mieux dans votre marketing

Analysez votre efficacité marketing, trouvez les zones de croissance, augmentez le ROI

Obtenir une démoPoints clés à retenir

L'analyse de qualité commence par des données de qualité. Vos efforts en matière de données doivent être précieux et fiables. C'est pourquoi vous devez identifier et combattre de manière proactive les erreurs et les écarts de données pour obtenir des rapports de performance holistiques et améliorer la qualité de vos données. En général, l'amélioration de la qualité des données est un processus itératif dans lequel trois étapes peuvent être distinguées :

- Examen de l'état de vos données

- Localisation d'un problème qui dégrade la qualité des données

- Résoudre le problème

Les plus chronophages sont les deux premières étapes. Il est difficile d'identifier qu'un problème existe et de comprendre dans quelles situations une erreur survient. Une fois qu'il est clair quel est le problème et où il se trouve, il s'avère relativement facile de le résoudre.

Enfin, vous pouvez créer trois documents pour améliorer vos données :

- Schéma de déplacement des données

- Matrice de responsabilité (qui est responsable de quoi)

- Modèle de données métier