Problemas comuns de qualidade de dados e como superá-los

Publicados: 2022-04-12Embora estejamos na era das tecnologias orientadas por dados, mais de 50% dos executivos seniores geralmente estão insatisfeitos com o valor obtido com a análise. Uma das principais razões para isso é a baixa qualidade dos dados . Além disso, ter dados de baixa qualidade no início de qualquer tarefa torna inúteis outras ações. Além disso, quaisquer decisões tomadas serão baseadas em informações incorretas e, para as empresas, isso certamente é uma má notícia.

É por isso que decidimos compartilhar nossos muitos anos de experiência e conhecimento trabalhando com dados. Ao longo do ano passado, conversamos muito com nossos colegas analistas e realizamos muitas entrevistas com especialistas de classe mundial. Agora queremos fornecer orientação sobre os problemas mais frequentes no trabalho com dados e como superá-los.

No artigo, discutimos os estágios de um fluxo de trabalho de dados, quais erros podem ocorrer e por quê. E o mais importante, compartilhamos abordagens para resolver problemas de qualidade de dados.

Índice

- De onde vêm os problemas de qualidade de dados?

- Etapa 1. Planeje as medições

- Etapa 2. Colete dados primários

- Etapa 3. Normalizar dados brutos

- Etapa 4. Preparar dados prontos para negócios

- Reconsidere sua relação com os dados com o OWOX BI

- Etapa 5. Visualize os dados

- Principais conclusões

Algumas definições antes de começarmos:

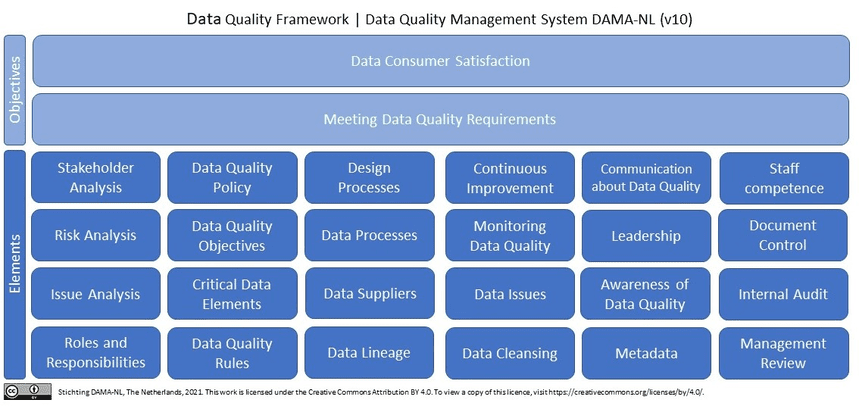

O que são dados de qualidade? Em poucas palavras (e em termos de dados de marketing), dados de qualidade são dados relevantes, atualizados, sem erros e discrepâncias . Se procurarmos qualidade de dados na Wikipedia, veremos mais de 10 (!) definições. Além disso, a Wikipedia cita a pesquisa mais recente da DAMA NL em definições de dimensões de qualidade de dados usando a ISO 9001 como um quadro de referência.

Por que os dados de qualidade são essenciais para profissionais de marketing, analistas e tomadores de decisão? Sem dados confiáveis e de qualidade, é impossível tomar decisões com base em análises de marketing.

De onde vêm os problemas de qualidade de dados?

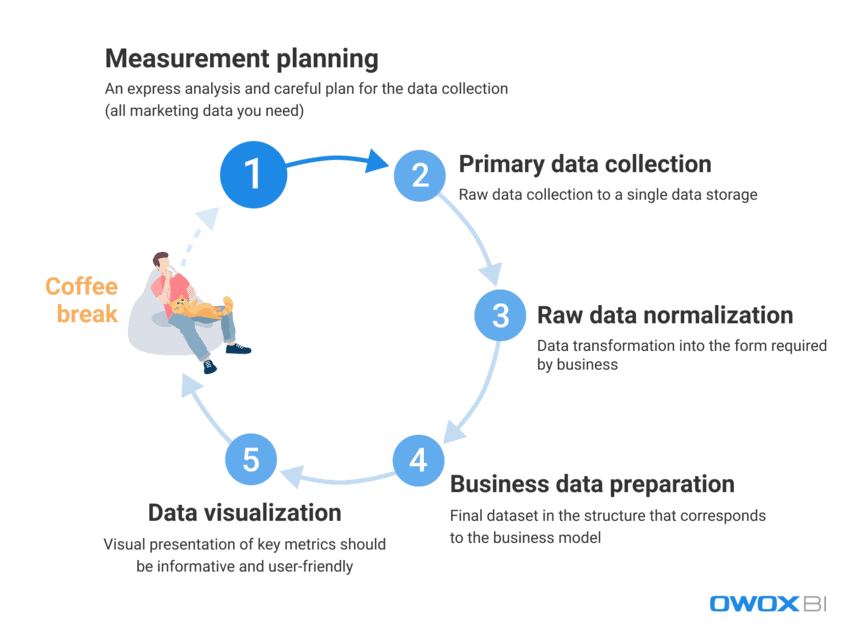

Ao lidar com a grande quantidade de dados que profissionais de marketing e analistas usam diariamente, é um desafio eliminar completamente erros e discrepâncias. É extremamente difícil fornecer dados de qualidade imediatamente a um usuário final; no entanto, os erros de dados podem ser combatidos ativamente e encontrados de forma proativa. Em primeiro lugar, vamos analisar o processo de trabalho com dados e distinguir as etapas em que os problemas de qualidade de dados podem aparecer:

- Planejamento de medição

- Coleta de dados primários

- Normalização de dados brutos

- Preparação de dados de negócios

- Visualização de dados

Em nossa experiência, os erros de dados factuais geralmente aparecem nas duas primeiras etapas, enquanto os casos de uso indevido de dados ocorrem com mais frequência durante as últimas etapas.

Vamos ver com mais detalhes quais problemas de qualidade de dados podem surgir nessas etapas e como resolvê-los.

Etapa 1. Planeje as medições

Mesmo que não haja erros nos dados nesta etapa, não podemos omiti-los completamente. O diabo está nos detalhes, e a coleta de dados para análise começa com um planejamento detalhado. Nossa recomendação é sempre começar com uma análise expressa e planejar cuidadosamente a coleta de todos os dados de marketing que você precisa.

Ignorar a etapa de planejamento leva a uma abordagem não estruturada e a dados insuficientes para novas tarefas ou projetos, enquanto o objetivo é coletar dados fragmentados de todas as fontes de dados com as quais você trabalha. Se você não tiver todos os dados, suas decisões e ações serão falhas desde o início. Vamos ver quais dados você deve coletar antes de iniciar novos projetos:

- Dados de comportamento do usuário do seu site e/ou aplicativo

- Dados de custo de plataformas de publicidade

- Rastreamento de chamadas, chatbot e dados de e-mail

- Dados reais de vendas de seus sistemas CRM/ERP, etc.

Etapa 2. Colete dados primários

Depois de criar seu plano de medição, vamos para a etapa principal de coleta de dados. Durante esta etapa, entre todos os outros desafios que você precisa superar, você deve considerar controlar o acesso aos seus dados (é tudo uma questão de segurança de dados) e se preparar com antecedência para a criação de seu armazenamento de dados ou data lake.

Se você deseja obter controle total sobre seus dados brutos sem modificá-los, nossa recomendação é usar um único armazenamento com importação automatizada de dados. Para necessidades de marketing, o Google BigQuery continua sendo uma das melhores opções.

Quais dificuldades de qualidade de dados você pode encontrar nesta etapa:

1.1 Obtendo dados incompletos e incorretos da API de um serviço de publicidade

O que é isto?

Plataformas e serviços de publicidade coletam grandes quantidades de dados valiosos sobre o comportamento do usuário, e o problema ocorre quando você tenta obter todas essas informações na íntegra dessas fontes de dados sem prejudicar sua integridade.

*Uma Application Programming Interface (API) é uma parte do servidor que transmite dados (recebe solicitações e envia respostas), interagindo com o usuário toda vez que este visita uma página do site. A maioria dos sites modernos usa pelo menos várias APIs de terceiros.

O que há de errado com isso?

Um serviço de publicidade coleta dados sobre as ações de um usuário; no entanto, os dados podem ser alterados retrospectivamente após a transferência e a API de serviço pode ser atualizada ou ficar indisponível por algum tempo. Como resultado, parte dos dados simplesmente não será entregue e a qualidade geral dos dados será corrompida. O analista pode não saber disso e pode usar dados irrelevantes para preparar dados de negócios. No entanto, não é possível obter informações úteis ou tomar a decisão certa com base em dados incompletos e/ou imprecisos. Simplificando, você pode investir muito tempo e esforço e ainda se encontrar na base da escada sem dados úteis nem provas de que o desempenho é bem-sucedido e lucrativo para o negócio.

Quais são as razões?

Os dados podem estar incompletos ou incorretos devido à perda de dados, discrepâncias ou duplicatas. Os motivos comuns para esses problemas incluem:

- Uma nova conta em uma plataforma de publicidade é criada, mas os analistas não são informados e os dados dela não são coletados.

- Uma API não oferece suporte a parâmetros dinâmicos em tags UTM e não os coleta nem os transfere. Se você usar parâmetros sem suporte em tags UTM, verá os nomes dos parâmetros em vez de seus valores — por exemplo, {{geo}} em vez do nome real da campanha.

- Atualizações de dados retrospectivas. Os serviços de publicidade geralmente atualizam dados retrospectivamente (sobre custos, cliques e impressões em contas de publicidade). No entanto, nem todos os analistas estão cientes disso e levam isso em consideração.

Como resolver este problema?

Como é impossível controlar diretamente o código ao trabalhar com APIs, você pode combater esses problemas:

- distribuir áreas de responsabilidade durante a coleta de dados para obter melhor controle sobre a coleta de dados.

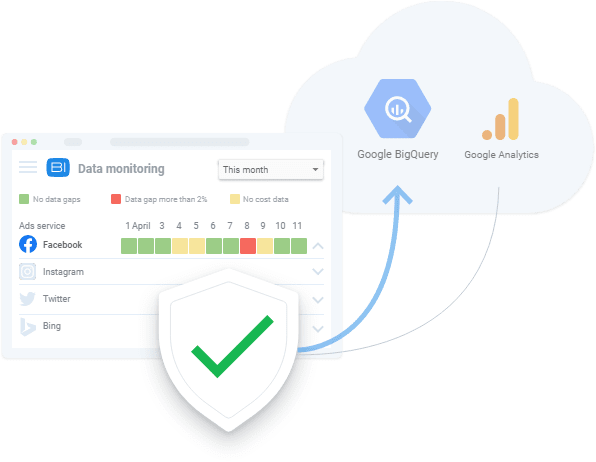

- usando ferramentas automatizadas de importação de dados que suportam alterações de API, parâmetros dinâmicos etc. Caso os dados não estejam disponíveis, essas ferramentas podem mostrar as lacunas de dados existentes e fazer o download dos dados retrospectivamente.

1.2 Obtendo dados incompletos e incorretos de um site

O que é isto?

Ao analisar os dados dos serviços de publicidade, sabemos quanto gastamos em publicidade. Enquanto dos dados de comportamento do usuário do site, obtemos informações sobre quanto ganhamos. Como as perguntas de negócios geralmente soam como “qual publicidade compensa e qual não?” é essencial conhecer a relação receita/despesa.

O que há de errado com isso?

Os dados sobre o comportamento do usuário do site diferem dos dados de custo coletados pelos serviços de publicidade porque os dados sobre o comportamento do usuário do site:

- é coletado diretamente pelos proprietários do site

- é significativamente maior em volume do que os dados de custo dos serviços de publicidade

Além disso, se não percebermos que não há coleta de dados de comportamento do usuário e não eliminarmos o problema, esses dados serão perdidos para sempre.

Assim como os problemas de coleta de dados de APIs de serviços de publicidade, informações incompletas ou incorretas levam a soluções errôneas. Decisões de gestão incorretas, por sua vez, levam a uma perda de receita.

Quais são as razões?

Podem ocorrer erros ao coletar dados do site porque:

- Nem todas as páginas do site têm um contêiner do Google Tag Manager (GTM). O GTM coleta o resultado de campanhas publicitárias e dados de comportamento do usuário. Portanto, se não houver um contêiner GTM na página, nenhum dado será coletado.

- O projeto do Google Cloud não é pago no prazo e, portanto, a coleta de dados é suspensa.

- A exatidão dos dados inseridos nos formulários de inscrição pelos usuários do site (nome, endereço, e-mail, etc.) não é validada.

Como resolver este problema?

Assim como na coleta de dados de uma API, as soluções para coleta de dados do site incluem:

- distribuir áreas de responsabilidade durante a coleta de dados para obter melhor controle sobre a coleta de dados

- usando ferramentas automatizadas de importação de dados; caso os dados não estejam disponíveis, essas ferramentas podem avisá-lo sobre erros de dados existentes

2. Obtendo dados agregados e amostrados

O que é isto?

Dados agregados e amostrados são dados generalizados que aparecem nos casos em que nem todos os dados são processados e usados para análise e relatórios. Isso acontece quando serviços como o Google Analytics analisam apenas parte dos dados para reduzir a carga nos servidores e equilibrar a velocidade e a precisão do processamento de dados. Uma vez que a amostragem resulta em generalização, leva a uma falta de confiança nos resultados obtidos.

O que há de errado com isso?

Os relatórios de amostra distorcem os dados de desempenho, e isso pode custar uma fortuna quando se trata de métricas relacionadas a dinheiro, como metas, conversões e receita. Por causa disso, você corre o risco de não perceber uma campanha publicitária lucrativa e pode desativá-la devido a dados distorcidos em um relatório, ou vice-versa – você pode gastar todo o seu dinheiro em campanhas ineficientes.

Em outras palavras, toda vez que a amostragem é aplicada, há o risco de obter resultados imprecisos. E se você tentar tomar uma decisão com base apenas em parte dos dados, você joga jogos de adivinhação com o orçamento da empresa.

Quais são as razões?

Na tentativa de criar relatórios o mais rápido possível e economizar recursos, os sistemas aplicam amostragem, agregação e filtragem em vez de processar grandes matrizes de dados.

Como resolver este problema?

A única coisa que você pode fazer para evitar a amostragem de dados é coletar dados brutos e verificar constantemente a integridade dos dados em todos os seus relatórios. Esse monitoramento do processo é feito preferencialmente de forma automática como forma de iludir os fatores humanos. Por exemplo, você pode aplicar testes automáticos de coleta de métricas corretas em seu site como a OZON fez com a ajuda do OWOX BI.

Etapa 3. Normalizar dados brutos

Depois de coletar todos os dados necessários, é hora de normalizá-los. Nesta etapa, os analistas transformam as informações disponíveis na forma exigida pelo negócio. Por exemplo, devemos obter números de telefone em um único formato.

A normalização de dados é um “trabalho de macaco” manual e rotineiro que geralmente impede os analistas de tarefas mais interessantes, como extrair informações úteis de dados. Sem contar que as dificuldades de normalização costumam levar até 50% do tempo total de trabalho de um analista.

Dificuldades de qualidade de dados podem ser encontradas nesta fase:

1. Dependências de inserção, atualização e exclusão

O que é isto?

Esses são efeitos colaterais problemáticos que aparecem durante a normalização de dados não estruturados.

O que há de errado com isso?

O resultado comum dessas dependências de dados é que os sistemas de relatórios descartam esses dados incorretos ao analisá-los. Como resultado, acabamos com relatórios imprecisos que não são baseados em dados completos. Por exemplo, digamos que temos um objeto de sessões e um objeto de anúncios. Nas sessões, temos dados para os dias 10 a 20, e nas propagandas, dados dos dias 10 a 15 (por algum motivo não há dados de custo para os dias 16 a 20). Assim, ou perdemos os dados de anúncios dos dias 16 a 20, ou os dados das sessões só estarão disponíveis nos dias 10 a 15.

Quais são as razões?

Efeitos colaterais indesejáveis aparecem quando uma API de serviço de publicidade é alterada, não está disponível ou retorna dados incorretos.

Como resolver este problema?

Da mesma forma que você verifica erros de coleta de dados, deve sempre verificar os dados com os quais trabalha. Além disso, se as especificidades da mesclagem de dados não forem conhecidas pelo usuário, é provável que ocorram erros ao normalizar os dados. Na prática, a melhor decisão nesta etapa é desenvolver um sistema de monitoramento da qualidade dos dados que alerte o responsável pela qualidade dos dados em caso de anomalias nos dados. Para isso, você pode usar serviços como OWOX BI com sua funcionalidade de monitoramento de dados incorporado.

Nossos clientes

crescer 22% mais rápido

Cresça mais rápido medindo o que funciona melhor em seu marketing

Analise sua eficiência de marketing, encontre as áreas de crescimento, aumente o ROI

Obter demonstração2. Diferentes formatos de dados, estruturas e níveis de detalhes

O que é isto?

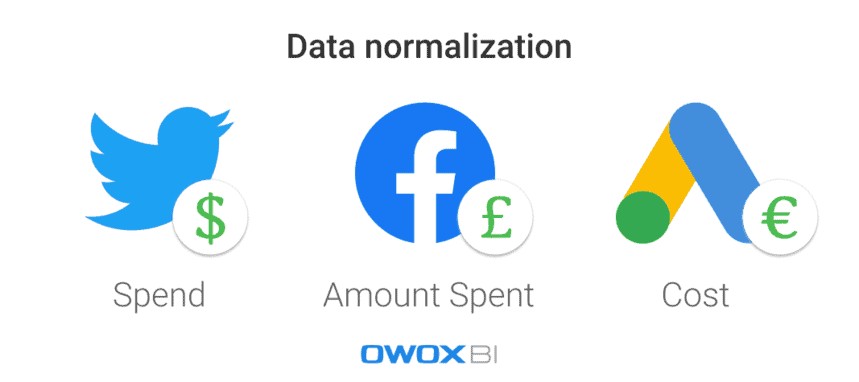

Cada plataforma ou serviço de publicidade usa diferentes formatos de dados, moedas e estruturas. Como resultado, depois de coletar dados de todas as fontes, você precisa normalizá-los em um único formato/estrutura.

O que há de errado com isso?

É uma tarefa difícil construir uma fortaleza triangular quando tudo o que você tem são peças redondas e ovais. Quando você tem muitos conjuntos de dados em formatos diferentes, simplesmente não pode criar um relatório antes de unificar os dados.

Quais são as razões?

Existem diferentes esquemas de dados nos serviços de publicidade. Por exemplo, a mesma coluna em plataformas diferentes pode ser nomeada Nome do produto e Categoria do produto. Outro exemplo é usar moedas diferentes nos dados de custo: dólares para anúncios no Twitter e libras no Facebook, por exemplo.

Como resolver este problema?

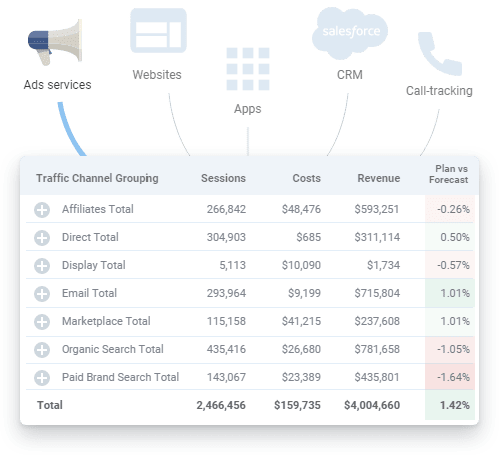

Antes de analisar os dados, eles devem ser convertidos para um único formato; caso contrário, nada de bom resultará de sua análise. Por exemplo, você deve mesclar dados de sessão do usuário com dados de custo de publicidade para medir o impacto de cada fonte de tráfego ou canal de marketing específico e ver quais campanhas publicitárias geram mais receita. Claro, isso pode ser feito manualmente utilizando scripts e SQL, mas aplicar soluções automatizadas é uma escolha melhor.

Etapa 4. Preparar dados prontos para negócios

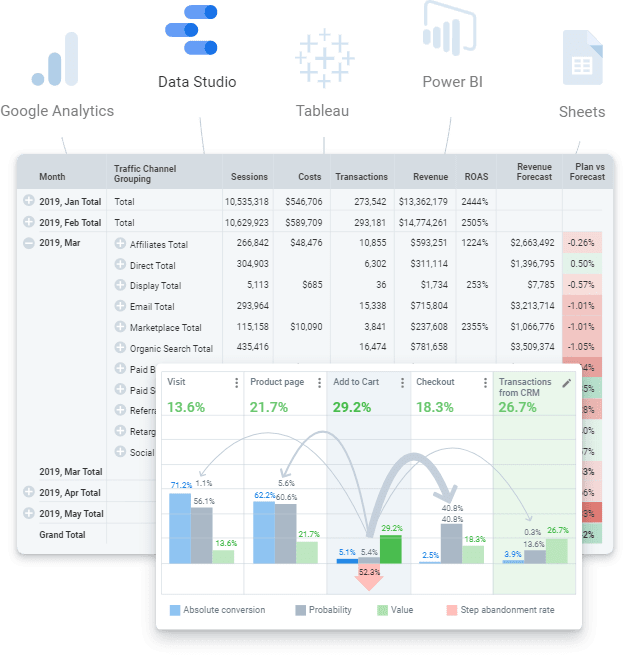

Os dados prontos para negócios são um conjunto de dados final limpo na estrutura que corresponde ao modelo de negócios. Em outras palavras, se você passou por todas as etapas do trabalho com dados e concluiu tudo, deve obter o conjunto de dados final. Seus dados prontos que podem ser enviados para qualquer serviço de visualização de dados (Power BI, Tableau, Google Data Studio, etc.).

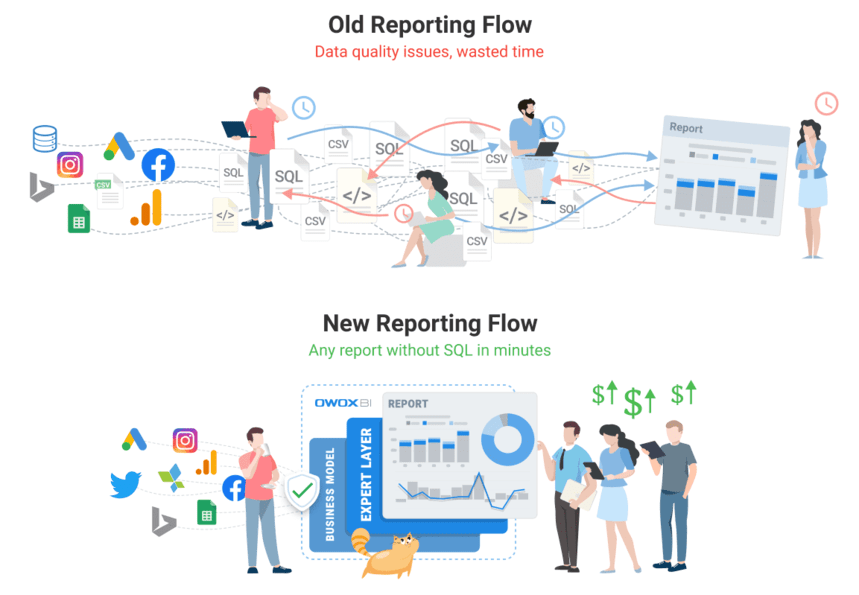

No entanto, você não deve confundi-lo com dados brutos sobre os quais você pode tentar construir um relatório. É uma abordagem errônea que acarretará muitos problemas recorrentes: encontrar erros e causas de discrepâncias levará muito tempo e a lógica de negócios precisará ser constantemente duplicada em todas as consultas SQL. É claro que esse volume de dados brutos e não estruturados é um desafio para se manter atualizado e controlar as mudanças na lógica das transformações. Por exemplo, você pode encontrar problemas como atualizar o histórico de dados de custo após o serviço de publicidade ajustá-lo. Outro exemplo poderia ser a recompra de transações concluídas. Nesse caso, leva tempo para entender se a transação foi resgatada, mas temos que atribuir esse status ao momento do pedido.

Infelizmente, é uma prática comum pular essa etapa e ir direto para a criação do relatório. No entanto, nossa experiência demonstra que usar um conjunto de dados final e preparar dados prontos para os negócios para o mundo moderno da análise é uma obrigação. A longo prazo, é mais barato e mais fácil trabalhar com dados preparados em vez de rodar dados brutos fazendo sempre as mesmas coisas.

Quais dificuldades de qualidade de dados podem aparecer durante esta etapa:

1. A falta de definições de dados leva a discrepâncias

O que é isto?

É difícil controlar as mudanças na lógica de transformação devido a definições inconsistentes ou ausentes dos tipos de dados necessários em todo o processamento de dados.

O que há de errado com isso?

Quando os dados não estão claramente definidos, os usuários não estão na mesma página sobre o uso de dados: eles não têm certeza de qual tabela ou coluna consultar, qual filtro usar ou a quem solicitar informações sobre objetos de dados. Além disso, leva muito tempo para navegar e entender todos os objetos de dados de dados brutos, incluindo seus atributos, seu lugar no modelo de dados e sua relevância entre si.

Quais são as razões?

Uma empresa não definiu claramente seus dados principais e seu modelo de dados. Portanto, a lógica para mesclar dados é incompreensível.

Como resolver este problema?

Em primeiro lugar, não aplique lógica de negócios a cada relatório ou conjunto de dados, mas use a modelagem de dados no nível da empresa. Dentro da empresa, deve haver um modelo de dados de negócios transparente e controle do ciclo de vida dos dados. Isso significa que todas as definições usadas devem ser claras. Por exemplo, os usuários finais devem estar cientes do que as métricas de conversão e visitantes do site representam.

Junto com isso, como é desafiador preparar e manter dados simulados atualizados, a resposta está na aplicação de soluções automatizadas (por exemplo, ferramenta de construção de dados (dbt)) que podem coletar, limpar, normalizar e monitorar a qualidade de seus dados então está pronto para o negócio.

Reconsidere sua relação com os dados com o OWOX BI

A equipe OWOX BI sabe mais do que ninguém a gravidade do problema de dados, pois cada um de nossos clientes o encontra. Criamos um produto que permite aos analistas automatizar a rotina, entregar valor comercial a partir dos dados e garantir a qualidade dos dados.

OWOX BI é uma plataforma unificada que permite coletar, preparar e analisar todos os seus dados de marketing. Ele automatiza a entrega de dados de fontes isoladas para seu destino de análise, garantindo que os dados estejam sempre precisos e atualizados.

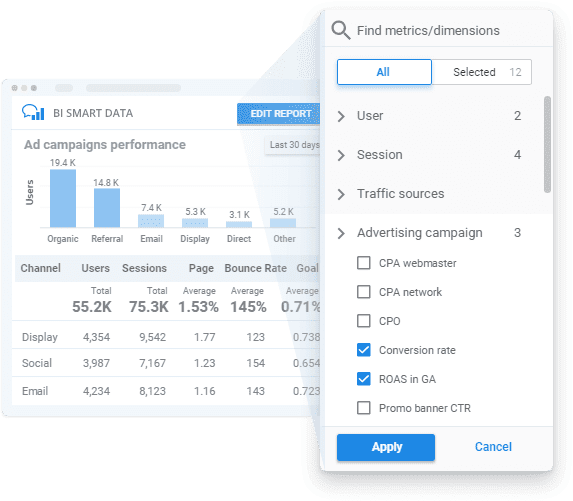

Ao aplicar o OWOX BI, você pode obter dados prontos para os negócios de acordo com seu modelo de negócios com monitoramento transparente de qualidade de dados e um construtor de relatórios fácil de usar para desbloquear insights sem SQL ou código.

Vejamos como o OWOX BI pode ajudá-lo em todas as etapas que mencionamos acima.

- Planeje suas medidas . Crie um plano de medição para o seu negócio ou desenvolva um sistema de métricas especialmente para as necessidades do seu negócio com a ajuda dos nossos especialistas.

- Colete dados primários . OWOX BI coleta dados brutos do Google Analytics, serviços de publicidade, sites, lojas offline, sistemas de rastreamento de chamadas e sistemas de CRM em seu armazenamento de dados. A plataforma funciona sem problemas com grandes contas de anúncios e carrega todos os dados, independentemente do número de campanhas. Além de importar dados de custo automaticamente, o OWOX BI reconhece parâmetros dinâmicos em tags UTM, converte custos em uma moeda e monitora a relevância dos dados.

Você não precisa mais procurar vários conectores e, se necessário, nossa equipe pode até configurar integrações personalizadas para você.

- Normalize dados brutos . Ao usar o OWOX BI, você não precisa limpar, estruturar e processar dados manualmente. Você receberá conjuntos de dados prontos na estrutura mais clara e conveniente. Além disso, a qualquer momento você pode obter um relatório visual sobre a relevância dos dados dos serviços de publicidade carregados no Google Analytics.

- Preparar dados de negócios . Com o OWOX BI, você tem dados confiáveis e prontos para negócios ao seu alcance. Não há mais necessidade de criar um novo conjunto de dados para cada novo relatório, pois você obtém conjuntos de dados finais pré-criados preparados de acordo com seu modelo de dados de negócios. Com dados atualizados e unificados prontos para segmentação adicional de dados, você pode obter insights sobre a velocidade de seus negócios e aumentar o valor de seus dados.

- Visualize dados . A plataforma OWOX BI permite que você analise e visualize seus dados onde quiser. Assim que seus dados de marketing estiverem prontos, você poderá enviá-los para a ferramenta de BI ou visualização de sua escolha com apenas alguns cliques.

Reserve uma demonstração gratuita para ver como o OWOX BI garante a qualidade dos dados e como você pode se beneficiar do gerenciamento de dados totalmente automatizado hoje mesmo!

Etapa 5. Visualize os dados

A apresentação visual das principais métricas é a última etapa para fazer os dados funcionarem, portanto, sua apresentação de dados deve ser informativa e fácil de usar. Visualizações automatizadas e configuradas corretamente podem reduzir significativamente o tempo para encontrar um problema; ou seja, você pode realizar mais iterações com menos esforço no mesmo período para melhorar a qualidade dos dados.

Além disso, é importante lembrar que serviços de visualização de dados, como o popular Google Data Studio, não podem mesclar ou transformar dados. Se você precisar de relatórios baseados em muitas fontes de dados, nossa recomendação é coletar todos os dados necessários de antemão em um único armazenamento de dados para evitar dificuldades.

Dificuldades de qualidade de dados que você pode encontrar nesta etapa:

1. Erros de dados factuais

Quem são esses?

Quando algo dá errado nos níveis anteriores de coleta e normalização de dados, os erros de dados podem acabar nos relatórios mostrados pelos serviços de visualização de dados.

O que há de errado com isso?

Relatórios criados com erros de dados factuais são uma perda de tempo e dinheiro. Eles não fornecem lucro ou insights valiosos sobre zonas de risco e crescimento para o negócio. Desculpe, Mario, mas a princesa está em outro castelo!

Quais são as razões?

Simplificando, os dados visualizados não são relevantes. No entanto, para descobrir a origem desses erros, você deve voltar e verificar seus dados novamente.

Como resolver este problema?

A única maneira de resolver esse problema é preparar minuciosamente os dados e monitorar sua qualidade antes de criar relatórios.

2. Consultas SQL quebradas ou muitas edições nos relatórios (e/ou consultas SQL)

O que é isto?

Os requisitos de dados mudam constantemente e as consultas SQL também mudam. Como resultado, quanto mais complicado o sistema de relatórios se torna, mais fácil é para quebrar.

O que há de errado com isso?

Não há nada de errado com as mudanças, a menos que haja tantas que seja impossível lembrar quais mudanças foram feitas, onde e quando. Eventualmente, todos os sistemas de relatórios cuidadosamente construídos podem desaparecer, já que as consultas SQL não estão funcionando e não há dados corretos para visualizar.

Quais são as razões?

É um grande desafio lembrar de cada pequena coisa, então o erro típico é esquecer de aplicar edições em todos os conjuntos de dados onde elas são necessárias.

Como resolver este problema?

Idealmente, os usuários devem ser capazes de gerar relatórios de marketing sem usar muitas consultas SQL e sem precisar aplicar muitas alterações e/ou edições.

3. Incompreensão e uso indevido dos dados coletados

O que é isto?

Um dos problemas mais comuns é a incompreensão dos dados (e, portanto, o uso indevido deles). Isso acontece quando uma determinada métrica ou parâmetro pode ser interpretado de mais de uma maneira. Por exemplo, digamos que haja uma métrica de conversão em um relatório e esse relatório seja usado por diferentes usuários. Um dos usuários pensa que uma conversão significa uma visita ao site, enquanto outro pensa que significa fazer um pedido. No entanto, há também uma terceira pessoa que pensa que essa métrica de conversão é sobre pedidos entregues e comprados. Como você pode ver, existem muitas interpretações possíveis, então você deve deixar claro quais informações são apresentadas no relatório.

O que há de errado com isso?

Se não houver uma compreensão clara de quais dados são usados em relatórios e painéis, não há garantia de que suas decisões serão baseadas em fatos reais.

Quais são as razões?

Uma explicação pouco clara das métricas e parâmetros usados nos relatórios ou um tipo inadequado de visualização de dados pode levar a más decisões.

Como resolver este problema?

A verificação de dados não termina quando você verifica se os dados de entrada estão corretos e relevantes. Esses dados ainda podem ser mal utilizados. Para evitar esse problema, os usuários finais precisam ter acesso a dados completos, atualizados e prontos para o negócio, com explicações claras e precisas sobre quais informações são apresentadas nos relatórios.

Nossos clientes

crescer 22% mais rápido

Cresça mais rápido medindo o que funciona melhor em seu marketing

Analise sua eficiência de marketing, encontre as áreas de crescimento, aumente o ROI

Obter demonstraçãoPrincipais conclusões

A análise de qualidade começa com dados de qualidade. Seus esforços de dados devem ser valiosos e confiáveis. É por isso que você deve identificar e combater proativamente erros e discrepâncias de dados para obter relatórios de desempenho holísticos e melhorar a qualidade de seus dados. Em geral, melhorar a qualidade dos dados é um processo iterativo no qual três etapas podem ser distinguidas:

- Examinando o status de seus dados

- Localizando um problema que degrada a qualidade dos dados

- Corrigindo o problema

As mais demoradas são as duas primeiras etapas. É difícil identificar que existe um problema e entender em que situações surge um erro. Depois que fica claro qual é o problema e onde ele está localizado, é relativamente fácil corrigi-lo.

Por fim, você pode criar três documentos para melhorar seus dados:

- Esquema de movimentação de dados

- Matriz de responsabilidade (quem é responsável pelo quê)

- Modelo de dados de negócios