Typowe problemy z jakością danych i sposoby ich rozwiązywania

Opublikowany: 2022-04-12Chociaż żyjemy w dobie technologii opartych na danych, ponad 50% kadry kierowniczej jest generalnie niezadowolonych z wartości uzyskanych dzięki analityce. Jedną z głównych przyczyn tego stanu rzeczy jest niska jakość danych . Co więcej, posiadanie słabej jakości danych na samym początku każdego zadania sprawia, że dalsze działania stają się bezużyteczne. Dodatkowo wszelkie podejmowane decyzje będą oparte na błędnych informacjach, a dla firm jest to z pewnością zła wiadomość.

Dlatego zdecydowaliśmy się podzielić naszym wieloletnim doświadczeniem i wiedzą w pracy z danymi. W ciągu ostatniego roku dużo rozmawialiśmy z naszymi kolegami analitykami i przeprowadziliśmy wiele wywiadów ze światowej klasy specjalistami. Teraz chcemy udzielić wskazówek dotyczących najczęstszych problemów w pracy z danymi i sposobów ich rozwiązywania.

W artykule omawiamy etapy obiegu danych, jakie błędy mogą wystąpić i dlaczego. A co najważniejsze, dzielimy się podejściami do rozwiązywania problemów z jakością danych.

Spis treści

- Skąd biorą się problemy z jakością danych?

- Krok 1. Zaplanuj pomiary

- Krok 2. Zbierz podstawowe dane

- Krok 3. Normalizuj surowe dane

- Krok 4. Przygotuj dane biznesowe

- Ponownie rozważ swój związek z danymi z OWOX BI

- Krok 5. Wizualizuj dane

- Kluczowe dania na wynos

Kilka definicji, zanim zaczniemy:

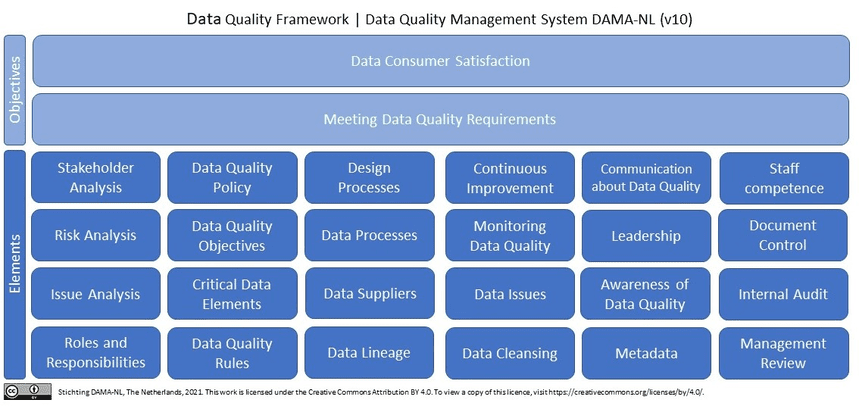

Czym są dane wysokiej jakości? W skrócie (i w kategoriach danych marketingowych) dane jakościowe są istotne, aktualne dane bez błędów i rozbieżności . Jeśli sprawdzimy jakość danych w Wikipedii, zobaczymy ponad 10 (!) definicji. Ponadto Wikipedia przytacza najnowsze badania przeprowadzone przez DAMA NL dotyczące definicji wymiarów jakości danych przy użyciu normy ISO 9001 jako układu odniesienia.

Dlaczego dane wysokiej jakości są koniecznością dla marketerów, analityków i decydentów? Bez wysokiej jakości i wiarygodnych danych nie da się podejmować decyzji w oparciu o analitykę marketingową.

Skąd biorą się problemy z jakością danych?

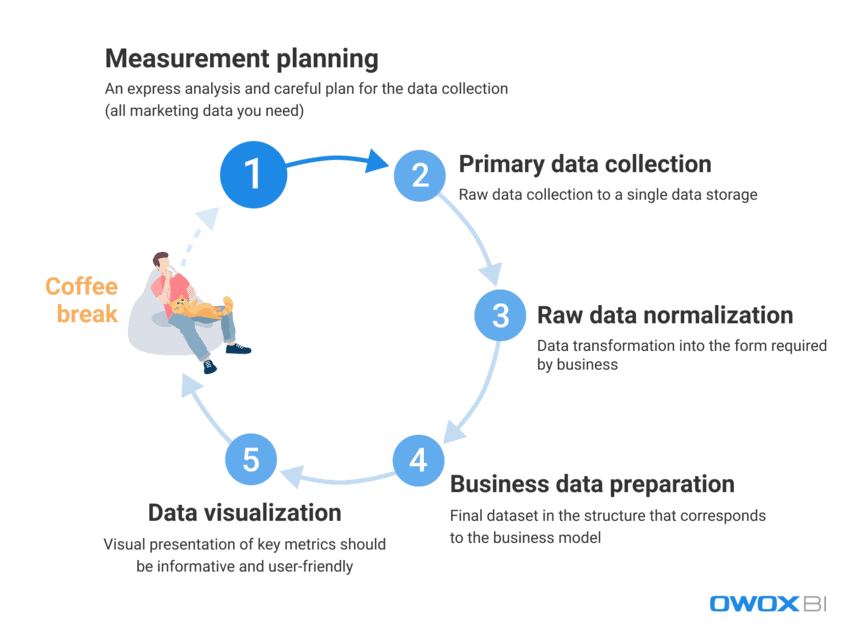

W radzeniu sobie z ogromną ilością danych, z których codziennie korzystają marketerzy i analitycy, wyzwaniem jest całkowite wyeliminowanie błędów i rozbieżności. Niezwykle trudno jest natychmiast dostarczyć użytkownikowi końcowemu dane wysokiej jakości; jednak błędy danych można aktywnie zwalczać i proaktywnie znajdować. Przede wszystkim przyjrzyjmy się procesowi pracy z danymi i rozróżnijmy kroki, w których mogą pojawić się problemy z jakością danych:

- Planowanie pomiarów

- Zbieranie danych pierwotnych

- Normalizacja surowych danych

- Przygotowanie danych biznesowych

- Wizualizacja danych

Z naszego doświadczenia wynika, że błędy w danych rzeczowych zwykle pojawiają się w pierwszych dwóch krokach, podczas gdy przypadki niewłaściwego wykorzystania danych zdarzają się częściej w ostatnich krokach.

Zobaczmy bardziej szczegółowo, jakie problemy z jakością danych mogą pojawić się na tych etapach i jak je rozwiązać.

Krok 1. Zaplanuj pomiary

Mimo że na tym etapie nie ma błędów w danych, nie możemy ich całkowicie pominąć. Diabeł tkwi w szczegółach, a zbieranie danych do analizy zaczyna się od szczegółowego planowania. Zalecamy, aby zawsze zaczynać od ekspresowej analizy i starannie zaplanować gromadzenie wszystkich potrzebnych danych marketingowych.

Pominięcie etapu planowania prowadzi do nieustrukturyzowanego podejścia i niewystarczającej ilości danych dla nowych zadań lub projektów, podczas gdy celem jest zebranie pofragmentowanych danych ze wszystkich źródeł danych, z którymi pracujesz. Jeśli nie masz wszystkich danych, od samego początku Twoje decyzje i działania będą błędne. Zobaczmy, jakie dane powinieneś zebrać przed rozpoczęciem nowych projektów:

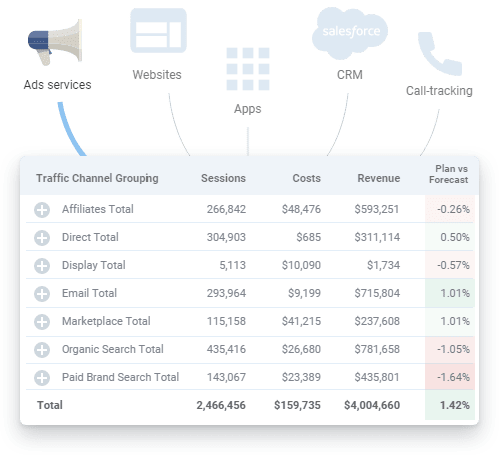

- Dane dotyczące zachowań użytkowników z Twojej witryny i/lub aplikacji

- Dane o kosztach z platform reklamowych

- Śledzenie połączeń, chatbot i dane e-mail

- Rzeczywiste dane sprzedażowe z Twoich systemów CRM/ERP itp.

Krok 2. Zbierz podstawowe dane

Po utworzeniu planu pomiarów przejdź do etapu zbierania danych podstawowych. Podczas tego kroku, wśród wszystkich innych wyzwań, które musisz pokonać, musisz rozważyć kontrolowanie dostępu do swoich danych (chodzi o bezpieczeństwo danych) i wcześniejsze przygotowanie się do utworzenia magazynu danych lub jeziora danych.

Jeśli chcesz uzyskać pełną kontrolę nad surowymi danymi bez ich modyfikowania, zalecamy korzystanie z jednego magazynu z automatycznym importem danych. Na potrzeby marketingu Google BigQuery pozostaje jedną z najlepszych opcji.

Jakie trudności z jakością danych możesz napotkać na tym etapie:

1.1 Pobieranie niekompletnych i niepoprawnych danych z API usługi reklamowej

Co to jest?

Platformy i usługi reklamowe gromadzą ogromne ilości cennych danych o zachowaniach użytkowników, a problem pojawia się, gdy próbujesz uzyskać wszystkie te informacje w całości z tych źródeł danych bez szkody dla ich kompletności.

*Interfejs programowania aplikacji (API) to część serwera, która przesyła dane (otrzymuje żądania i wysyła odpowiedzi), wchodząc w interakcję z użytkownikiem za każdym razem, gdy użytkownik odwiedza stronę w witrynie. Większość nowoczesnych witryn internetowych korzysta z co najmniej kilku interfejsów API innych firm.

Co z tym jest nie tak?

Usługa reklamowa zbiera dane o działaniach użytkownika; jednak dane mogą ulec zmianie retrospektywnie po ich przeniesieniu, a interfejs API usługi może zostać zaktualizowany lub być niedostępny przez pewien czas. W rezultacie część danych po prostu nie zostanie dostarczona, a ogólna jakość danych zostanie uszkodzona. Analityk może o tym nie wiedzieć i może wykorzystać nieistotne dane do przygotowania danych biznesowych. Jednak uzyskanie przydatnych informacji lub podjęcie właściwej decyzji na podstawie niekompletnych i/lub niedokładnych danych nie jest możliwe. Mówiąc najprościej, możesz zainwestować dużo czasu i wysiłku, a mimo to znaleźć się z powrotem na dole drabiny bez przydatnych danych ani dowodu, że wydajność jest udana i opłacalna dla firmy.

Jakie są powody?

Dane mogą być niekompletne lub nieprawidłowe z powodu utraty danych, rozbieżności lub duplikatów. Typowe przyczyny tych problemów to:

- Tworzone jest nowe konto na platformie reklamowej, ale analitycy nie są informowani, a dane z niego nie są zbierane.

- Interfejs API nie obsługuje parametrów dynamicznych w tagach UTM i nie zbiera ich ani nie przesyła. Jeśli używasz nieobsługiwanych parametrów w tagach UTM, zobaczysz nazwy parametrów zamiast ich wartości – na przykład {{geo}} zamiast rzeczywistej nazwy kampanii.

- Retrospektywne aktualizacje danych. Usługi reklamowe często aktualizują dane retrospektywnie (o kosztach, kliknięciach i wyświetleniach na kontach reklamowych). Jednak nie wszyscy analitycy są tego świadomi i biorą to pod uwagę.

Jak rozwiązać ten problem?

Ponieważ nie można bezpośrednio kontrolować kodu podczas pracy z interfejsami API, możesz rozwiązać te problemy poprzez:

- rozdzielenie obszarów odpowiedzialności podczas zbierania danych w celu uzyskania lepszej kontroli nad zbieraniem danych.

- za pomocą zautomatyzowanych narzędzi do importu danych, które obsługują zmiany API, parametry dynamiczne itp. W przypadku braku danych narzędzia te mogą pokazać istniejące luki w danych i pobrać dane retrospektywnie.

1.2 Uzyskiwanie niekompletnych i niepoprawnych danych ze strony internetowej

Co to jest?

Analizując dane z serwisów reklamowych wiemy, ile wydajemy na reklamę. Natomiast z danych o zachowaniach użytkowników serwisu uzyskujemy informacje o tym, ile zarabiamy. Ponieważ pytania biznesowe zwykle brzmią jak „która reklama się opłaca, a która nie?” niezbędna jest znajomość stosunku dochodów do wydatków.

Co z tym jest nie tak?

Dane o zachowaniu użytkowników serwisu różnią się od danych kosztowych gromadzonych przez serwisy reklamowe, ponieważ dane o zachowaniu użytkownika serwisu:

- jest pobierana bezpośrednio przez właścicieli witryn

- jest znacznie większy niż dane kosztowe z usług reklamowych

Ponadto, jeśli nie zauważymy, że nie ma gromadzenia danych o zachowaniach użytkowników i nie wyeliminujemy problemu, dane te zostaną bezpowrotnie utracone.

Podobnie jak w przypadku problemów z gromadzeniem danych z interfejsów API usług reklamowych, niekompletne lub nieprawidłowe informacje prowadzą do błędnych rozwiązań. Z kolei błędne decyzje zarządcze prowadzą do utraty dochodów.

Jakie są powody?

Podczas zbierania danych serwisu mogą wystąpić błędy, ponieważ:

- Nie wszystkie strony witryny mają kontener Menedżera tagów Google (GTM). GTM zbiera wyniki kampanii reklamowych oraz dane o zachowaniach użytkowników. Dlatego jeśli na stronie nie ma kontenera GTM, żadne dane nie są zbierane.

- Projekt Google Cloud nie jest opłacany na czas, dlatego zbieranie danych zostaje wstrzymane.

- Poprawność danych wprowadzanych do formularzy zgłoszeniowych przez użytkowników serwisu (imię i nazwisko, adres, e-mail itp.) nie jest sprawdzana.

Jak rozwiązać ten problem?

Podobnie jak w przypadku zbierania danych z API, rozwiązania do zbierania danych z witryn internetowych obejmują:

- rozdzielenie obszarów odpowiedzialności podczas zbierania danych w celu uzyskania lepszej kontroli nad zbieraniem danych

- korzystanie z narzędzi do automatycznego importu danych; w przypadku braku danych narzędzia te mogą ostrzec Cię o istniejących błędach danych

2. Uzyskiwanie zagregowanych, próbkowanych danych

Co to jest?

Zagregowane i próbkowane dane to uogólnione dane, które pojawiają się w przypadkach, gdy nie wszystkie dane są przetwarzane i wykorzystywane do analizy i raportowania. Dzieje się tak, gdy usługi takie jak Google Analytics analizują tylko część danych, aby zmniejszyć obciążenie serwerów i zrównoważyć szybkość i dokładność przetwarzania danych. Ponieważ pobieranie próbek prowadzi do uogólnienia, prowadzi to do braku zaufania do uzyskanych wyników.

Co z tym jest nie tak?

Próbkowane raporty zniekształcają dane o skuteczności, a to może kosztować fortunę, jeśli chodzi o wskaźniki związane z pieniędzmi, takie jak cele, konwersje i przychody. Z tego powodu ryzykujesz, że nie zauważysz dochodowej kampanii reklamowej i możesz ją wyłączyć z powodu zniekształconych danych w raporcie lub odwrotnie – możesz wydać wszystkie swoje pieniądze na nieefektywne kampanie.

Innymi słowy, za każdym razem, gdy stosowane jest próbkowanie, istnieje ryzyko uzyskania niedokładnych wyników. A jeśli próbujesz podjąć decyzję na podstawie tylko części danych, grasz w zgadywanie z budżetem firmy.

Jakie są powody?

Próbując jak najszybciej tworzyć raporty i oszczędzać zasoby, systemy zamiast przetwarzania ogromnych tablic danych stosują próbkowanie, agregację i filtrowanie.

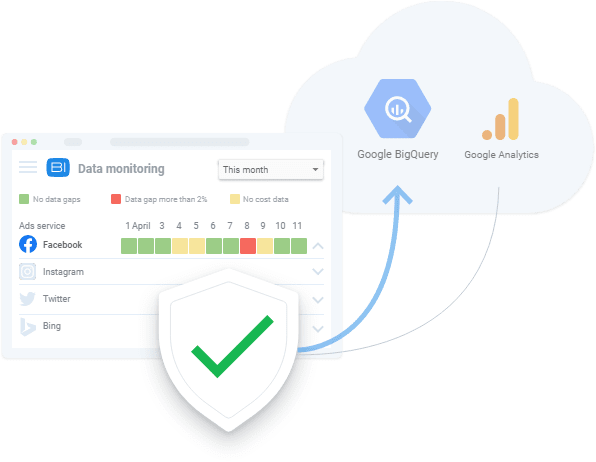

Jak rozwiązać ten problem?

Jedyne, co możesz zrobić, aby uniknąć próbkowania danych, to zbieranie nieprzetworzonych danych i ciągłe sprawdzanie kompletności danych we wszystkich raportach. Ten proces monitorowania najlepiej odbywa się automatycznie, aby uniknąć czynników ludzkich. Na przykład możesz zastosować automatyczne testowanie prawidłowego zbierania metryk na swojej stronie internetowej, tak jak zrobił to OZON przy pomocy OWOX BI.

Krok 3. Normalizuj surowe dane

Po zebraniu wszystkich niezbędnych danych czas na ich normalizację. Na tym etapie analitycy przekształcają dostępne informacje w formę wymaganą przez biznes. Na przykład musimy uzyskać numery telefonów w jednym formacie.

Normalizacja danych to ręczna i rutynowa „małpia robota”, która zwykle powstrzymuje analityków przed bardziej ekscytującymi zadaniami, takimi jak wydobywanie przydatnych informacji na temat danych. Nie wspominając o tym, że trudności z normalizacją zwykle zajmują do 50% całkowitego czasu pracy analityka.

Na tym etapie można napotkać trudności z jakością danych:

1. Zależności wstawiania, aktualizowania i usuwania

Co to jest?

Są to uciążliwe skutki uboczne, które pojawiają się podczas normalizacji nieustrukturyzowanych danych.

Co z tym jest nie tak?

Powszechnym skutkiem tych zależności danych jest to, że systemy raportowania odrzucają takie nieprawidłowe dane podczas ich analizy. W rezultacie otrzymujemy niedokładne raporty, które nie są oparte na pełnych danych. Załóżmy na przykład, że mamy obiekt sesji i obiekt reklamy. W sesjach mamy dane z dni od 10 do 20, a w reklamach dane z dni od 10 do 15 (z jakiegoś powodu nie ma danych o kosztach od dni 16 do 20). W związku z tym albo tracimy dane z reklam w dniach od 16 do 20, albo dane z sesji będą dostępne tylko w dniach od 10 do 15.

Jakie są powody?

Niepożądane efekty uboczne pojawiają się, gdy interfejs API usługi reklamowej zostanie zmieniony, niedostępny lub zwróci nieprawidłowe dane.

Jak rozwiązać ten problem?

W ten sam sposób sprawdzasz błędy zbierania danych, zawsze powinieneś weryfikować dane, z którymi pracujesz. Co więcej, jeśli użytkownik nie zna szczegółów łączenia danych, istnieje prawdopodobieństwo, że podczas normalizacji danych wystąpią błędy. W praktyce najlepszą decyzją na tym etapie jest opracowanie systemu monitorowania jakości danych, który alarmuje osobę odpowiedzialną za jakość danych w przypadku wystąpienia anomalii w danych. W tym celu możesz skorzystać z takich usług jak OWOX BI z wbudowaną funkcjonalnością monitorowania danych.

Nasi klienci

rosnąć 22% szybciej

Rozwijaj się szybciej, mierząc, co najlepiej sprawdza się w Twoim marketingu

Przeanalizuj swoją skuteczność marketingową, znajdź obszary wzrostu, zwiększ ROI

Pobierz demo2. Różne formaty danych, struktury i poziomy szczegółowości

Co to jest?

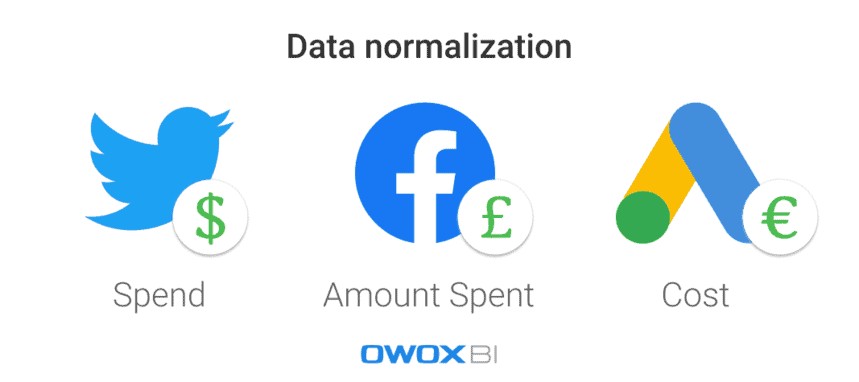

Każda platforma lub usługa reklamowa wykorzystuje różne formaty danych, waluty i struktury. W rezultacie, po zebraniu danych ze wszystkich źródeł, musisz znormalizować je do jednego formatu/struktury.

Co z tym jest nie tak?

Trudno jest zbudować trójkątną fortecę, gdy masz tylko okrągłe i owalne elementy. Jeśli masz wiele zestawów danych w różnych formatach, po prostu nie możesz utworzyć raportu przed ujednoliceniem danych.

Jakie są powody?

W usługach reklamowych istnieją różne schematy danych. Na przykład tę samą kolumnę na różnych platformach można nazwać Nazwa produktu i Kategoria produktu. Innym przykładem jest użycie różnych walut w danych o kosztach: na przykład dolarów w reklamach na Twitterze i funtach na Facebooku.

Jak rozwiązać ten problem?

Przed analizą danych należy je przekonwertować do jednego formatu; w przeciwnym razie z twojej analizy nie wyjdzie nic dobrego. Na przykład należy połączyć dane sesji użytkownika z danymi o kosztach reklamy, aby zmierzyć wpływ każdego konkretnego źródła ruchu lub kanału marketingowego i zobaczyć, które kampanie reklamowe przynoszą większe przychody. Oczywiście można to zrobić ręcznie, wykorzystując skrypty i SQL, ale lepszym wyborem jest zastosowanie zautomatyzowanych rozwiązań.

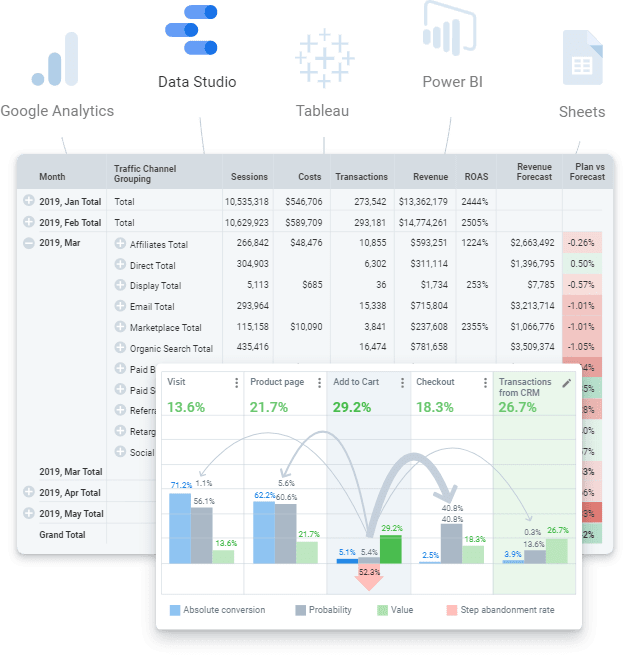

Krok 4. Przygotuj dane biznesowe

Dane gotowe do pracy to oczyszczony ostateczny zestaw danych w strukturze odpowiadającej modelowi biznesowemu. Innymi słowy, jeśli wykonałeś wszystkie etapy pracy z danymi i wszystko ukończyłeś, powinieneś otrzymać ostateczny zestaw danych. To gotowe dane, które można przesłać do dowolnej usługi wizualizacji danych (Power BI, Tableau, Google Data Studio itp.).

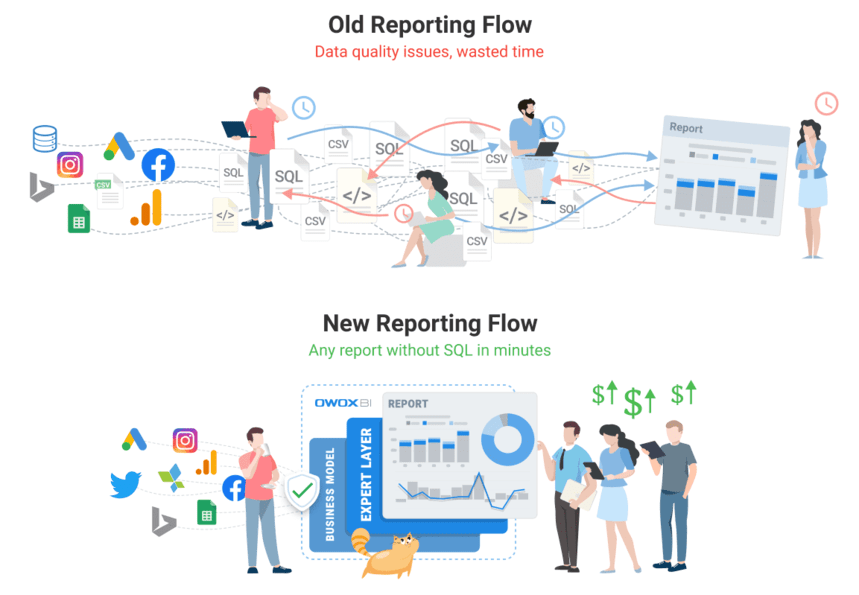

Nie należy jednak mylić go z surowymi danymi, na podstawie których można próbować zbudować raport. Jest to błędne podejście, które pociąga za sobą wiele powtarzających się problemów: znajdowanie błędów i przyczyn rozbieżności zajmie dużo czasu, a logika biznesowa będzie musiała być stale powielana we wszystkich zapytaniach SQL. Oczywiście taka ilość surowych, nieustrukturyzowanych danych jest trudna, aby być na bieżąco i kontrolować zmiany w logice przekształceń. Na przykład możesz napotkać takie problemy, jak aktualizacja historii danych o kosztach po dostosowaniu jej przez serwis reklamowy. Innym przykładem może być odkupienie zakończonych transakcji. W takim przypadku zrozumienie, czy transakcja została zrealizowana, zajmuje trochę czasu, ale musimy przypisać ten status do momentu zamówienia.

Niestety powszechną praktyką jest pomijanie tego kroku i natychmiastowe tworzenie raportu. Z naszego doświadczenia wynika jednak, że wykorzystanie ostatecznego zbioru danych i przygotowanie danych gotowych dla biznesu do współczesnego świata analityki jest koniecznością. Na dłuższą metę tańsza i łatwiejsza jest praca z przygotowanymi danymi, zamiast biegać po surowych danych, robiąc te same rzeczy w kółko.

Jakie trudności z jakością danych mogą pojawić się na tym etapie:

1. Brak definicji danych prowadzi do rozbieżności

Co to jest?

Trudno jest kontrolować zmiany w logice transformacji ze względu na niespójne lub nieobecne definicje typów danych wymaganych podczas przetwarzania danych.

Co z tym jest nie tak?

Gdy dane nie są jasno zdefiniowane, użytkownicy nie są na tej samej stronie na temat wykorzystania danych: nie są pewni, do której tabeli lub kolumny mają zostać wysłane zapytania, jakiego filtra użyć ani kogo poprosić o informacje o obiektach danych. Poza tym nawigacja i zrozumienie wszystkich obiektów danych z nieprzetworzonych danych, w tym ich atrybutów, ich miejsca w modelu danych i wzajemnego powiązania, zajmuje zbyt dużo czasu.

Jakie są powody?

Firma nie zdefiniowała jasno swoich podstawowych danych i modelu danych. Dlatego logika łączenia danych jest niezrozumiała.

Jak rozwiązać ten problem?

Przede wszystkim nie stosuj logiki biznesowej do każdego raportu lub zestawu danych, ale korzystaj z modelowania danych na poziomie firmy. W firmie powinien istnieć przejrzysty model danych biznesowych i kontrola cyklu życia danych. Oznacza to, że wszystkie użyte definicje muszą być jasne. Na przykład użytkownicy końcowi powinni być świadomi tego, co reprezentują dane dotyczące konwersji i odwiedzających witrynę.

Oprócz tego, ponieważ przygotowanie i utrzymywanie aktualnych danych symulowanych jest wyzwaniem, odpowiedzią jest zastosowanie zautomatyzowanych rozwiązań (np. narzędzia do budowania danych (dbt)), które mogą zbierać, czyścić, normalizować i monitorować jakość danych więc jest gotowy do pracy.

Ponownie rozważ swój związek z danymi z OWOX BI

Zespół OWOX BI wie więcej niż ktokolwiek, jak poważny jest problem z danymi, ponieważ spotyka go każdy z naszych klientów. Stworzyliśmy produkt, który pozwala analitykom zautomatyzować rutynę, dostarczać wartość biznesową z danych i zapewniać jakość danych.

OWOX BI to zunifikowana platforma, która umożliwia zbieranie, przygotowywanie i analizowanie wszystkich danych marketingowych. Automatyzuje dostarczanie danych z zamkniętych źródeł do miejsca docelowego analiz, zapewniając, że dane są zawsze dokładne i aktualne.

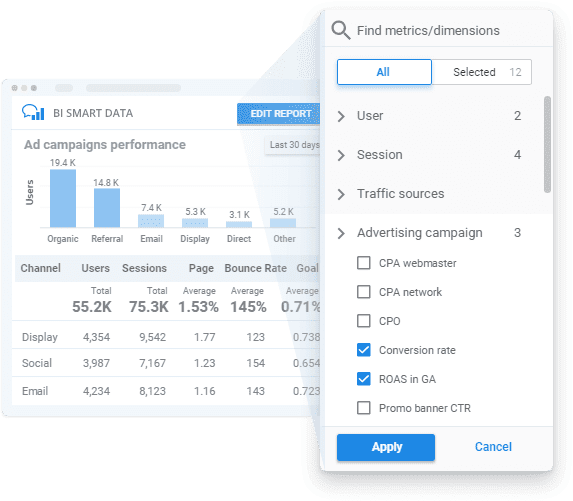

Stosując OWOX BI, możesz uzyskać gotowe dane biznesowe zgodnie z Twoim modelem biznesowym z przejrzystym monitorowaniem jakości danych i łatwym w użyciu narzędziem do tworzenia raportów, które pozwala uzyskać wgląd w dane bez SQL lub kodu.

Przyjrzyjmy się, jak OWOX BI może Ci pomóc we wszystkich krokach, o których wspomnieliśmy powyżej.

- Zaplanuj swoje pomiary . Stwórz plan pomiarów dla swojej firmy lub opracuj system metryk specjalnie dla potrzeb Twojej firmy z pomocą naszych specjalistów.

- Zbierz podstawowe dane . OWOX BI zbiera surowe dane z Google Analytics, usług reklamowych, stron internetowych, sklepów offline, systemów śledzenia połączeń i systemów CRM w Twoich danych. Platforma działa płynnie z dużymi kontami reklamowymi i przesyła wszystkie dane niezależnie od liczby kampanii. Oprócz automatycznego importowania danych kosztowych, OWOX BI rozpoznaje parametry dynamiczne w tagach UTM, przelicza koszty na jedną walutę i monitoruje trafność danych.

Nie musisz już szukać różnych złączy, a w razie potrzeby nasz zespół może nawet skonfigurować dla Ciebie niestandardowe integracje.

- Normalizuj surowe dane . Korzystając z OWOX BI, nie musisz ręcznie czyścić, strukturyzować i przetwarzać danych. Otrzymasz gotowe zestawy danych w przejrzystej i najwygodniejszej strukturze. Co więcej, w każdej chwili możesz otrzymać wizualny raport na temat trafności danych z usług reklamowych przesłanych do Google Analytics.

- Przygotuj dane biznesowe . Dzięki OWOX BI masz zaufane dane biznesowe na wyciągnięcie ręki. Nie ma już potrzeby tworzenia nowego zestawu danych dla każdego nowego raportu, ponieważ otrzymujesz gotowe gotowe zestawy danych przygotowane zgodnie z modelem danych biznesowych. Dzięki aktualnym i ujednoliconym danym, gotowym do dalszej segmentacji danych, możesz uzyskać wgląd w szybkość działania Twojej firmy i zwiększyć wartość swoich danych.

- Wizualizuj dane . Platforma OWOX BI pozwala analizować i wizualizować dane w dowolnym miejscu. Gdy Twoje dane marketingowe będą gotowe, możesz kilkoma kliknięciami wysłać je do wybranego narzędzia BI lub wizualizacji.

Zarezerwuj bezpłatne demo, aby zobaczyć, jak OWOX BI gwarantuje jakość danych i jak już dziś możesz skorzystać z w pełni zautomatyzowanego zarządzania danymi!

Krok 5. Wizualizuj dane

Wizualna prezentacja kluczowych wskaźników jest ostatnim krokiem do działania danych, dlatego prezentacja danych powinna być zarówno informacyjna, jak i przyjazna dla użytkownika. Zautomatyzowane i odpowiednio skonfigurowane wizualizacje mogą znacznie skrócić czas na znalezienie problemu; oznacza to, że możesz wykonać więcej iteracji przy mniejszym nakładzie pracy w tym samym okresie, aby poprawić jakość danych.

Należy również pamiętać, że usługi wizualizacji danych, takie jak popularne Studio danych Google, nie mogą scalać ani przekształcać danych. Jeśli potrzebujesz raportów opartych na wielu źródłach danych, zalecamy wcześniejsze zebranie wszystkich potrzebnych danych w jednym miejscu przechowywania danych, aby uniknąć jakichkolwiek trudności.

Trudności z jakością danych, które możesz napotkać na tym etapie:

1. Faktyczne błędy danych

Co to jest?

Gdy coś pójdzie nie tak na poprzednich poziomach gromadzenia i normalizacji danych, błędy danych mogą trafić do raportów wyświetlanych przez usługi wizualizacji danych.

Co z tym jest nie tak?

Raporty tworzone z faktycznymi błędami w danych to strata czasu i pieniędzy. Nie zapewniają zysku ani cennych informacji na temat stref ryzyka i wzrostu dla biznesu. Przepraszam Mario, ale księżniczka jest w innym zamku!

Jakie są powody?

Mówiąc najprościej, wizualizowane dane nie są istotne. Aby jednak znaleźć źródło tych błędów, należy cofnąć się do ponownej weryfikacji danych.

Jak rozwiązać ten problem?

Jedynym sposobem rozwiązania tego problemu jest dokładne przygotowanie danych i monitorowanie ich jakości przed tworzeniem raportów.

2. Uszkodzone zapytania SQL lub zbyt wiele edycji raportów (i/lub zapytań SQL)

Co to jest?

Wymagania dotyczące danych ulegają ciągłym zmianom, zmieniają się również zapytania SQL. W rezultacie im bardziej skomplikowany staje się system raportowania, tym łatwiej go załamać.

Co z tym jest nie tak?

W zmianach nie ma nic złego, chyba że jest ich tak wiele, że nie sposób przypomnieć sobie, jakie zmiany zostały wprowadzone, gdzie i kiedy. W końcu wszystkie starannie zbudowane systemy raportowania mogą zniknąć, ponieważ zapytania SQL nie działają i nie ma poprawnych danych do wizualizacji.

Jakie są powody?

Zapamiętywanie każdej drobnostki jest nie lada wyzwaniem, więc typowym błędem jest zapomnienie o wprowadzeniu zmian we wszystkich zestawach danych tam, gdzie są one potrzebne.

Jak rozwiązać ten problem?

Idealnie byłoby, gdyby użytkownicy byli w stanie generować raporty marketingowe bez używania wielu zapytań SQL i bez konieczności wprowadzania wielu zmian i/lub edycji.

3. Niezrozumienie i niewłaściwe wykorzystanie zebranych danych

Co to jest?

Jednym z najczęstszych problemów jest niezrozumienie danych (a tym samym ich niewłaściwe wykorzystanie). Dzieje się tak, gdy konkretną metrykę lub parametr można interpretować na więcej niż jeden sposób. Załóżmy na przykład, że raport zawiera dane konwersji, a ten raport jest używany przez różnych użytkowników. Jeden z użytkowników uważa, że konwersja oznacza wizytę na stronie, a inny uważa, że oznacza to złożenie zamówienia. Jednak jest też osoba trzecia, która uważa, że te dane konwersji dotyczą dostarczonych i zakupionych zamówień. Jak widać, istnieje wiele potencjalnych interpretacji, więc musisz jasno określić, jakie informacje są prezentowane w raporcie.

Co z tym jest nie tak?

Jeśli nie masz jasnego zrozumienia, jakie dane są używane w raportach i pulpitach nawigacyjnych, nie ma gwarancji, że Twoje decyzje będą oparte na faktach w terenie.

Jakie są powody?

Niejasne wyjaśnienie metryk i parametrów wykorzystywanych w raportach lub nieodpowiedni rodzaj wizualizacji danych może prowadzić do złych decyzji.

Jak rozwiązać ten problem?

Weryfikacja danych nie kończy się, gdy upewnisz się, że wprowadzone dane są poprawne i istotne. Te dane nadal mogą być niewłaściwie wykorzystywane. Aby uniknąć tego problemu, użytkownicy końcowi muszą mieć dostęp do kompletnych, aktualnych, gotowych do pracy danych z jasnymi i precyzyjnymi wyjaśnieniami, jakie informacje są prezentowane w raportach.

Nasi klienci

rosnąć 22% szybciej

Rozwijaj się szybciej, mierząc, co najlepiej sprawdza się w Twoim marketingu

Przeanalizuj swoją skuteczność marketingową, znajdź obszary wzrostu, zwiększ ROI

Pobierz demoKluczowe dania na wynos

Analiza jakości zaczyna się od wysokiej jakości danych. Twoje wysiłki w zakresie danych powinny być wartościowe i godne zaufania. Dlatego należy proaktywnie identyfikować i zwalczać błędy i rozbieżności w danych, aby uzyskać całościowe raportowanie wydajności i poprawić jakość danych. Ogólnie rzecz biorąc, poprawa jakości danych jest procesem iteracyjnym, w którym można wyróżnić trzy kroki:

- Badanie stanu swoich danych

- Zlokalizowanie problemu, który pogarsza jakość danych

- Rozwiązywanie problemu

Najbardziej czasochłonne są dwa pierwsze kroki. Trudno jest zidentyfikować problem i zrozumieć, w jakich sytuacjach pojawia się błąd. Gdy staje się jasne, na czym polega problem i gdzie się on znajduje, okazuje się, że stosunkowo łatwo go naprawić.

Na koniec możesz utworzyć trzy dokumenty, aby poprawić swoje dane:

- Schemat przenoszenia danych

- Matryca odpowiedzialności (kto za co odpowiada)

- Model danych biznesowych