一般的なデータ品質の問題とそれらを克服する方法

公開: 2022-04-12私たちはデータ駆動型テクノロジーの時代にいますが、上級管理職の50%以上が、分析から得られる価値に一般的に不満を持っています。 これの主な理由の1つは、データ品質の低下です。 さらに、タスクの最初に質の悪いデータがあると、それ以降のアクションは役に立たなくなります。 さらに、行われる決定は誤った情報に基づいて行われるため、企業にとって、これは確かに悪いニュースです。

そのため、データを扱う長年の経験と専門知識を共有することにしました。 過去1年間、私たちは仲間のアナリストと多くのことを話し、世界クラスの専門家と多くのインタビューを行いました。 ここで、データの操作で最も頻繁に発生する問題と、それらを克服する方法についてのガイダンスを提供したいと思います。

この記事では、データワークフローの段階、発生する可能性のあるエラー、およびその理由について説明します。 そして最も重要なことは、データ品質の問題を解決するためのアプローチを共有することです。

目次

- データ品質の問題はどこから発生しますか?

- ステップ1.測定を計画する

- ステップ2.一次データを収集する

- ステップ3.生データを正規化する

- ステップ4.ビジネス対応データを準備する

- OWOXBIを使用してデータとの関係を再検討する

- ステップ5.データを視覚化する

- 重要なポイント

始める前のいくつかの定義:

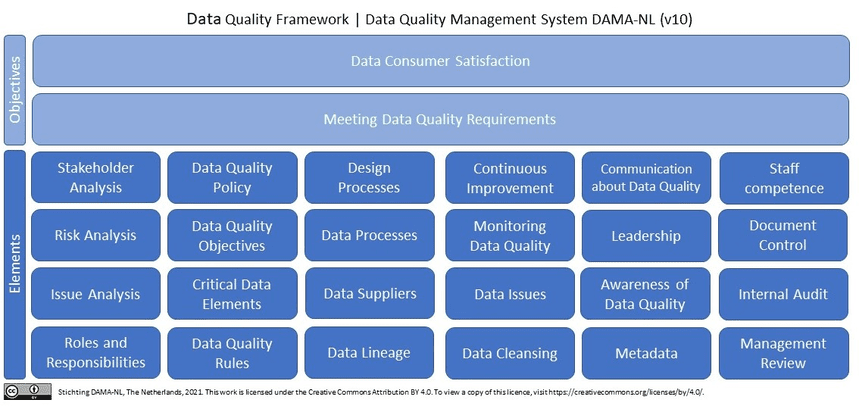

品質データとは何ですか? 一言で言えば(そしてマーケティングデータの観点から)、品質データは関連性があり、エラーや矛盾のない最新のデータです。 ウィキペディアでデータ品質を調べると、10(!)を超える定義が表示されます。 さらに、ウィキペディアは、参照のフレームとしてISO 9001を使用した、データ品質の次元の定義に関するDAMANLによる最新の研究を引用しています。

マーケター、アナリスト、意思決定者にとって品質データが必須なのはなぜですか? 品質と信頼できるデータがなければ、マーケティング分析に依存して意思決定を行うことは不可能です。

データ品質の問題はどこから発生しますか?

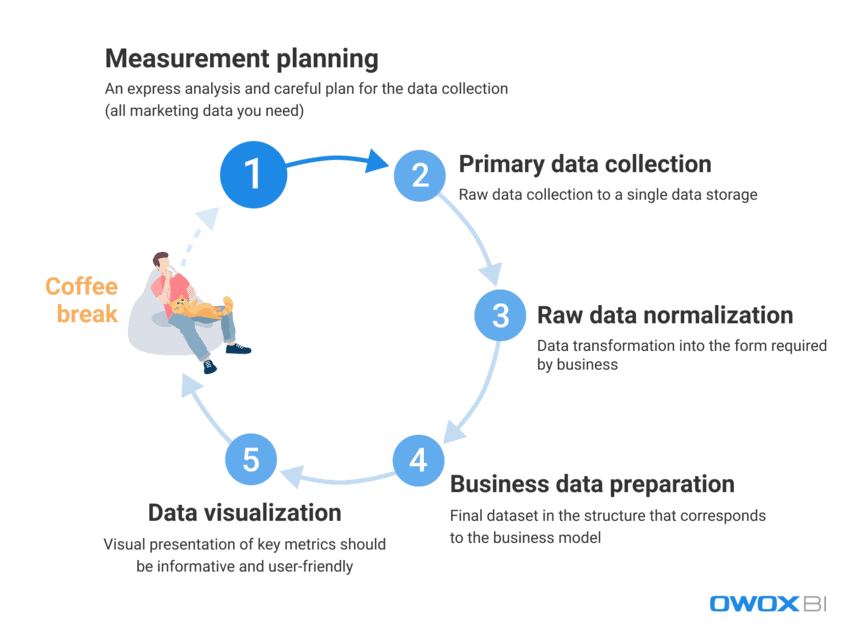

マーケターやアナリストが毎日使用する膨大な量のデータを処理する場合、エラーや不一致を完全に排除することが課題になります。 エンドユーザーに高品質のデータをすぐに提供することは非常に困難です。 ただし、データエラーは積極的に戦い、積極的に見つけることができます。 まず、データを操作するプロセスを見て、データ品質の問題が発生する可能性のあるステップを区別しましょう。

- 測定計画

- 一次データ収集

- 生データの正規化

- ビジネスデータの準備

- データの視覚化

私たちの経験では、実際のデータエラーは通常最初の2つのステップで発生しますが、データの誤用のケースは最後のステップでより頻繁に発生します。

これらのステップで発生する可能性のあるデータ品質の問題とその解決方法について詳しく見ていきましょう。

ステップ1.測定を計画する

この段階ではデータにエラーはありませんが、完全に省略することはできません。 悪魔は詳細に宿っており、分析のためのデータ収集は詳細な計画から始まります。 常にエクスプレス分析から始めて、必要なすべてのマーケティングデータの収集を慎重に計画することをお勧めします。

計画ステップをスキップすると、構造化されていないアプローチになり、新しいタスクやプロジェクトに十分なデータが得られません。一方、目標は、使用するすべてのデータソースから断片化されたデータを収集することです。 すべてのデータがない場合は、最初から意思決定と行動に欠陥があります。 新しいプロジェクトを開始する前に収集する必要のあるデータを見てみましょう。

- ウェブサイトやアプリケーションからのユーザー行動データ

- 広告プラットフォームからのコストデータ

- 通話追跡、チャットボット、および電子メールデータ

- CRM/ERPシステムなどからの実際の売上データ。

ステップ2.一次データを収集する

測定計画を作成したら、主要なデータ収集ステップに進みましょう。 このステップでは、克服する必要のある他のすべての課題の中でも、データへのアクセスを制御し(データのセキュリティがすべてです)、データストレージまたはデータレイクの作成に備えて事前に準備することを検討する必要があります。

生データを変更せずに完全に制御したい場合は、自動データインポートを備えた単一のストレージを使用することをお勧めします。 マーケティングのニーズについては、GoogleBigQueryが依然として最良の選択肢の1つです。

このステップで遭遇する可能性のあるデータ品質の問題:

1.1広告サービスのAPIから不完全で不正確なデータを取得する

これは何ですか?

広告プラットフォームとサービスは、膨大な量の貴重なユーザー行動データを収集します。問題は、完全性を損なうことなく、これらのデータソースからこのすべての情報を完全に取得しようとすると発生します。

*アプリケーションプログラミングインターフェイス(API)は、データを送信(要求を受信し、応答を送信)するサーバーの一部であり、ユーザーがWebサイトのページにアクセスするたびにユーザーと対話します。 最新のWebサイトのほとんどは、少なくともいくつかのサードパーティAPIを使用しています。

それのどこが悪いんだい?

広告サービスは、ユーザーの行動に関するデータを収集します。 ただし、データは転送後に遡及的に変更される可能性があり、サービスAPIが更新されるか、しばらくの間利用できなくなる可能性があります。 その結果、データの一部が配信されず、データの全体的な品質が低下します。 アナリストはこれについて知らない可能性があり、ビジネスデータを準備するために無関係なデータを使用する可能性があります。 ただし、不完全なデータや不正確なデータに基づいて、有用な洞察を得たり、正しい決定を下したりすることはできません。 簡単に言えば、多くの時間と労力を費やしても、有用なデータも、パフォーマンスがビジネスにとって成功して利益を上げているという証拠もない状態で、はしごの一番下に戻ることができます。

理由は何ですか?

データの損失、不一致、または重複が原因で、データが不完全または不正確になる可能性があります。 これらの問題の一般的な理由は次のとおりです。

- 広告プラットフォームで新しいアカウントが作成されますが、アナリストには通知されず、そこからのデータは収集されません。

- APIはUTMタグの動的パラメーターをサポートしておらず、それらを収集または転送しません。 UTMタグでサポートされていないパラメータを使用すると、値の代わりにパラメータ名が表示されます。たとえば、実際のキャンペーン名の代わりに{{geo}}が表示されます。

- 遡及的データ更新。 広告サービスは、多くの場合、データを遡及的に更新します(広告アカウントの費用、クリック数、インプレッション数)。 ただし、すべてのアナリストがこれを認識して考慮しているわけではありません。

この問題を解決する方法は?

APIを使用する場合、コードを直接制御することは不可能であるため、次の方法でこれらの問題に対処できます。

- データ収集中に責任範囲を分散して、データ収集をより適切に制御できるようにします。

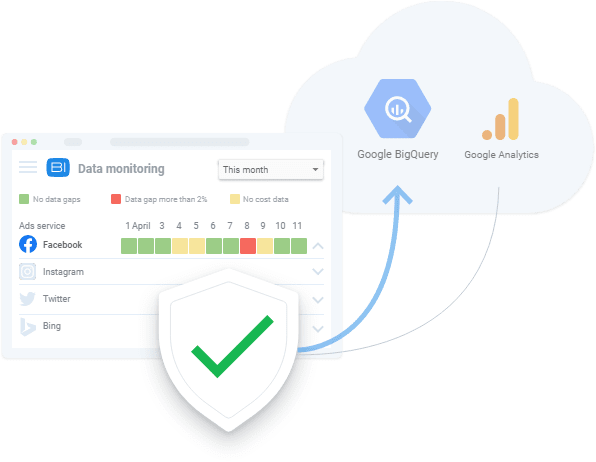

- APIの変更、動的パラメータなどをサポートする自動データインポートツールを使用します。データが利用できない場合、これらのツールは既存のデータギャップを表示し、データを遡及的にダウンロードできます。

1.2ウェブサイトからの不完全で不正確なデータの取得

これは何ですか?

広告サービスからのデータを分析することにより、私たちは広告にいくら費やしているかを知ることができます。 ウェブサイトのユーザー行動データから、私たちはどれだけ稼いでいるかについての情報を取得します。 ビジネス上の質問は通常、「どの広告が効果を発揮し、どれが効果を発揮しないか」のように聞こえます。 収入/費用の比率を知ることは不可欠です。

それのどこが悪いんだい?

ウェブサイトのユーザー行動に関するデータは、ウェブサイトのユーザー行動に関するデータが次の理由で、広告サービスによって収集されたコストデータとは異なります。

- ウェブサイトの所有者によって直接収集されます

- 広告サービスからのコストデータよりもボリュームが大幅に大きい

さらに、ユーザーの行動データの収集がないことに気づかず、問題を排除しない場合、このデータは永久に失われます。

広告サービスAPIからのデータ収集の問題と同様に、不完全または不正確な情報は誤った解決策につながります。 誤った経営判断は、今度は収入の損失につながります。

理由は何ですか?

次の理由により、Webサイトデータの収集時にエラーが発生する可能性があります。

- すべてのウェブサイトページにGoogleTagManager(GTM)コンテナがあるわけではありません。 GTMは、広告キャンペーンの結果とユーザーの行動データを収集します。 したがって、ページにGTMコンテナーがない場合、データは収集されません。

- Google Cloudプロジェクトは期限内に支払われないため、データ収集は保留されます。

- ウェブサイトのユーザーが申請書に入力したデータ(名前、住所、電子メールなど)の正確性は検証されません。

この問題を解決する方法は?

APIからデータを収集する場合と同様に、Webサイトのデータ収集のソリューションには次のものがあります。

- データ収集中の責任範囲を分散して、データ収集をより適切に制御できるようにする

- 自動データインポートツールを使用する。 データが利用できない場合、これらのツールは既存のデータエラーを警告できます

2.集約され、サンプリングされたデータを取得する

これは何ですか?

集計およびサンプリングされたデータは、すべてのデータが処理されて分析およびレポートに使用されない場合に表示される一般化されたデータです。 これは、Google Analyticsなどのサービスがデータの一部のみを分析してサーバーの負荷を軽減し、データ処理の速度と精度のバランスをとる場合に発生します。 サンプリングは一般化をもたらすため、得られた結果に対する信頼の欠如につながります。

それのどこが悪いんだい?

サンプリングされたレポートはパフォーマンスデータを歪め、目標、コンバージョン、収益などのお金に関連する指標に関しては、莫大な費用がかかる可能性があります。 このため、収益性の高い広告キャンペーンに気付かないリスクがあり、レポートのデータが歪んでいるためにオフになる可能性があります。逆の場合もあります。非効率的なキャンペーンにすべてのお金を費やす可能性があります。

つまり、サンプリングを適用するたびに、不正確な結果が得られるリスクがあります。 そして、データの一部だけに基づいて決定を下そうとすると、会社の予算で推測ゲームをプレイします。

理由は何ですか?

できるだけ早くレポートを作成してリソースを節約するために、システムは大量のデータアレイを処理する代わりに、サンプリング、集計、およびフィルタリングを適用します。

この問題を解決する方法は?

データのサンプリングを回避するためにできる唯一のことは、生データを収集し、すべてのレポート全体でデータの完全性を常にチェックすることです。 このプロセス監視は、人的要因を回避する方法として自動的に実行されることが好ましい。 たとえば、OZONがOWOX BIを使用して行ったように、Webサイトで正しいメトリック収集の自動テストを適用できます。

ステップ3.生データを正規化する

必要なデータをすべて収集したら、それを正規化します。 このステップで、アナリストは利用可能な情報をビジネスに必要な形式に変換します。 たとえば、電話番号を1つの形式にする必要があります。

データの正規化は手動で日常的な「サルの仕事」であり、通常、アナリストは有用なデータの洞察を抽出するなど、よりエキサイティングなタスクを実行できません。 言うまでもなく、正規化の難しさは通常、アナリストの作業時間全体の最大50%を占めます。

この段階で遭遇する可能性のあるデータ品質の問題:

1.挿入、更新、および削除の依存関係

これは何ですか?

これらは、非構造化データの正規化中に発生する厄介な副作用です。

それのどこが悪いんだい?

これらのデータ依存関係の一般的な結果は、レポートシステムが分析中にそのような誤ったデータを破棄することです。 その結果、完全なデータに基づいていない不正確なレポートが作成されます。 たとえば、セッションオブジェクトと広告オブジェクトがあるとします。 セッションでは、10日から20日までのデータがあり、広告では、10日から15日までのデータがあります(何らかの理由で、16日から20日までのコストデータはありません)。 したがって、広告からのデータは16日から20日の間失われるか、セッションからのデータは10日から15日までしか利用できなくなります。

理由は何ですか?

広告サービスAPIが変更された場合、利用できない場合、または誤ったデータを返す場合、望ましくない副作用が発生します。

この問題を解決する方法は?

同様に、データ収集エラーをチェックする場合は、使用するデータを常に確認する必要があります。 また、データのマージの詳細がユーザーにわからない場合は、データの正規化中にミスが発生する可能性があります。 実際には、このステップでの最善の決定は、データ異常が発生した場合にデータ品質の責任者に警告するデータ品質監視システムを開発することです。 このために、データ監視機能が組み込まれたOWOXBIなどのサービスを使用できます。

我々の顧客

育つ 22%高速

マーケティングで最も効果的なものを測定することで、より速く成長します

マーケティング効率を分析し、成長分野を見つけ、ROIを向上させます

デモを入手2.さまざまなデータ形式、構造、および詳細レベル

これは何ですか?

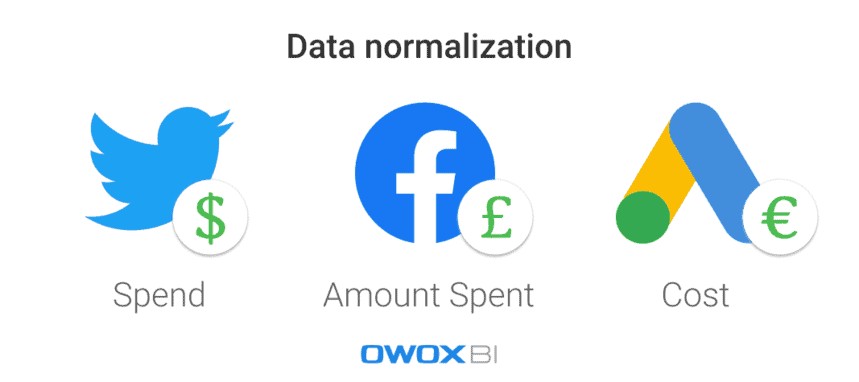

各広告プラットフォームまたはサービスは、異なるデータ形式、通貨、および構造を使用します。 その結果、すべてのソースからデータを収集した後、それを単一のフォーマット/構造に正規化する必要があります。

それのどこが悪いんだい?

あなたが持っているすべてが丸くて楕円形の部分であるとき、三角形の要塞を建てることは難しい仕事です。 さまざまな形式のデータセットが多数ある場合、データを統合する前にレポートを作成することはできません。

理由は何ですか?

広告サービスにはさまざまなデータスキームがあります。 たとえば、異なるプラットフォームの同じ列に、製品名と製品カテゴリという名前を付けることができます。 もう1つの例は、コストデータでさまざまな通貨を使用することです。たとえば、Twitter広告の場合はドル、Facebookの場合はポンドです。

この問題を解決する方法は?

データを分析する前に、単一の形式に変換する必要があります。 そうでなければ、あなたの分析から良いものは何も出てきません。 たとえば、ユーザーセッションデータを広告費用データとマージして、特定の各トラフィックソースまたはマーケティングチャネルの影響を測定し、どの広告キャンペーンがより多くの収益をもたらすかを確認する必要があります。 もちろん、これはスクリプトとSQLを利用して手動で行うことができますが、自動化されたソリューションを適用することをお勧めします。

ステップ4.ビジネス対応データを準備する

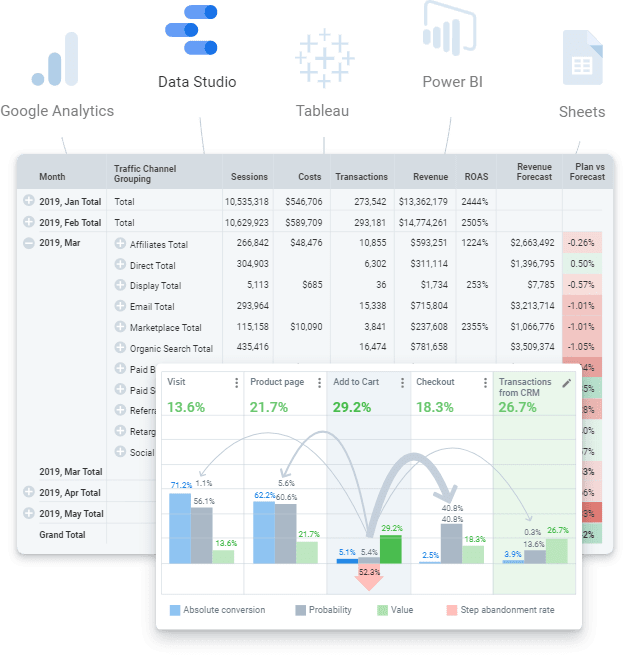

ビジネス対応データは、ビジネスモデルに対応する構造内のクリーンな最終データセットです。 つまり、データの操作のすべての手順を実行し、すべてを完了した場合は、最終的なデータセットを取得する必要があります。 任意のデータ視覚化サービス(Power BI、Tableau、Google Data Studioなど)に送信できる既製のデータ。

ただし、レポートの作成を試みることができる生データと混同しないでください。 これは誤ったアプローチであり、多くの繰り返し発生する問題が発生します。エラーと不一致の原因の検出には長い時間がかかり、すべてのSQLクエリでビジネスロジックを常に複製する必要があります。 もちろん、このような大量の生の非構造化データは、最新の状態に保ち、変換のロジックの変更を制御するのが困難です。 たとえば、広告サービスが調整した後にコストデータ履歴を更新するなどの問題が発生する場合があります。 別の例として、完了したトランザクションの買い戻しがあります。 この場合、トランザクションが引き換えられたかどうかを理解するのに時間がかかりますが、このステータスは注文の瞬間に起因する必要があります。

残念ながら、この手順をスキップして、すぐにレポートの作成に取り掛かるのが一般的な方法です。 しかし、私たちの経験は、最終的なデータセットを使用し、現代の分析の世界に向けてビジネスに対応したデータを準備することが必須であることを示しています。 長期的には、同じことを何度も繰り返す生データを実行するよりも、準備されたデータを操作する方が安価で簡単です。

このステップで発生する可能性のあるデータ品質の問題は次のとおりです。

1.データ定義の欠如は不一致につながります

これは何ですか?

データ処理全体で必要なデータの種類の定義に一貫性がないか存在しないため、変換ロジックの変更を制御することは困難です。

それのどこが悪いんだい?

データが明確に定義されていない場合、ユーザーはデータの使用について同じページにいません。クエリするテーブルまたは列、使用するフィルター、またはデータオブジェクトに関する情報を誰に尋ねるかがわかりません。 さらに、属性、データモデル内での位置、相互の関連性など、生データからすべてのデータオブジェクトをナビゲートして理解するには時間がかかりすぎます。

理由は何ですか?

企業は、コアデータとデータモデルを明確に定義していません。 したがって、データをマージするためのロジックは理解できません。

この問題を解決する方法は?

まず、各レポートやデータセットにビジネスロジックを適用するのではなく、企業レベルでデータモデリングを使用します。 社内には、透過的なビジネスデータモデルとデータライフサイクルの制御が必要です。 これは、使用されるすべての定義が明確でなければならないことを意味します。 たとえば、エンドユーザーは、コンバージョンとWebサイト訪問者のメトリックが何を表すかを知っておく必要があります。

それに加えて、最新のシミュレーションデータを準備および維持することは困難であるため、その答えは、データの品質を収集、クリーンアップ、正規化、および監視できる自動化ソリューション(データ構築ツール(dbt)など)を適用することにあります。だから、それはビジネスの準備ができています。

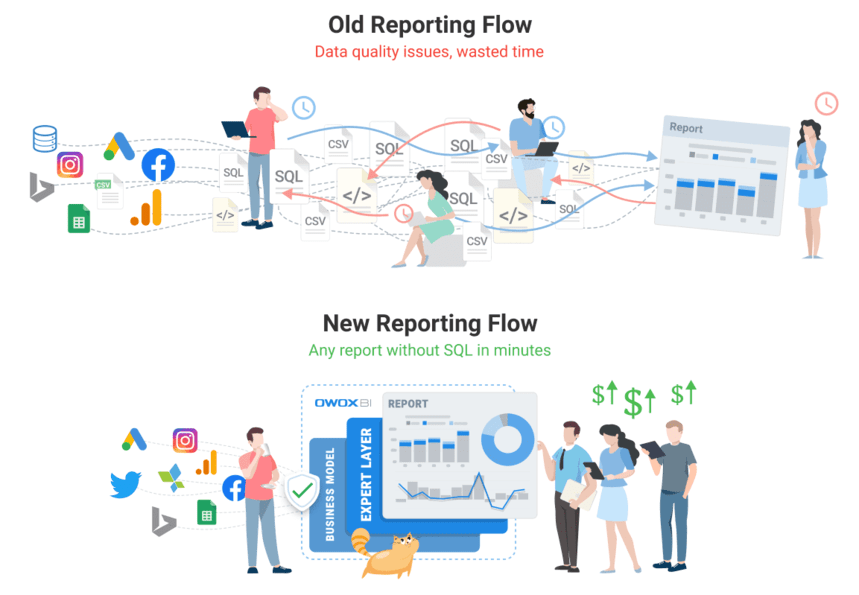

OWOXBIを使用してデータとの関係を再検討する

OWOX BIチームは、各クライアントがデータの問題に直面しているため、データの問題がどれほど深刻であるかを誰よりもよく知っています。 アナリストがルーチンを自動化し、データからビジネス価値を提供し、データ品質を確保できる製品を作成しました。

OWOX BIは、すべてのマーケティングデータを収集、準備、分析できるようにする統合プラットフォームです。 サイロ化されたソースから分析先へのデータ配信を自動化し、データが常に正確で最新であることを保証します。

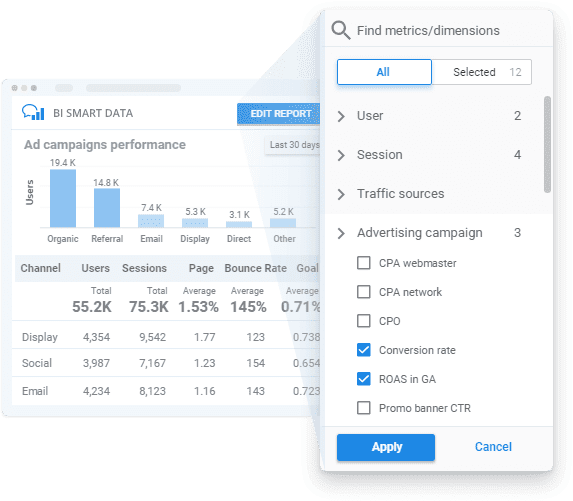

OWOX BIを適用することにより、透過的なデータ品質監視と、SQLやコードなしで洞察を解き放つための使いやすいレポートビルダーを使用して、ビジネスモデルに応じたビジネス対応データを取得できます。

上記のすべてのステップでOWOXBIがどのように役立つかを見てみましょう。

- 測定を計画します。 スペシャリストの助けを借りて、ビジネスの測定計画を作成するか、特にビジネスニーズに合わせたメトリックのシステムを開発します。

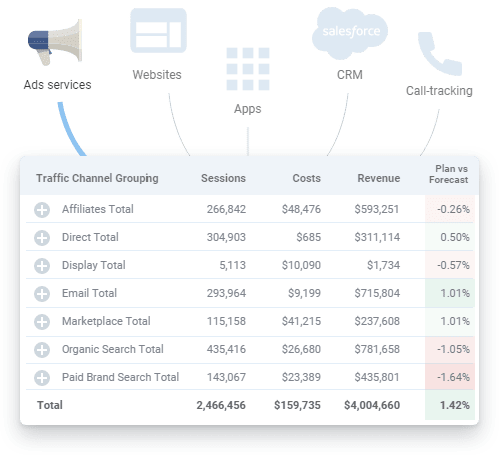

- 一次データを収集します。 OWOX BIは、Google Analytics、広告サービス、Webサイト、オフラインストア、通話追跡システム、およびデータストレージ内のCRMシステムから生データを収集します。 プラットフォームは大規模な広告アカウントでスムーズに機能し、キャンペーンの数に関係なくすべてのデータをアップロードします。 OWOX BIは、コストデータを自動的にインポートするだけでなく、UTMタグの動的パラメータを認識し、コストを1つの通貨に変換し、データの関連性を監視します。

さまざまなコネクタを探す必要がなくなり、必要に応じて、当社のチームがカスタム統合を設定することもできます。

- 生データを正規化します。 OWOX BIを使用する場合、データを手動でクリーンアップ、構造化、および処理する必要はありません。 最も明確で最も便利な構造の準備ができたデータセットを受け取ります。 さらに、いつでもGoogleAnalyticsにアップロードされた広告サービスからのデータの関連性に関する視覚的なレポートを取得できます。

- ビジネスデータを準備します。 OWOX BIを使用すると、すぐに使える信頼できるビジネスデータを手に入れることができます。 ビジネスデータモデルに従って事前に作成された最終データセットが準備されるため、新しいレポートごとに新しいデータセットを作成する必要がなくなります。 最新の統合データを使用してさらにデータをセグメンテーションできるため、ビジネスの速度に関する洞察を得ることができ、データの価値を高めることができます。

- データを視覚化します。 OWOX BIプラットフォームを使用すると、必要な場所でデータを分析および視覚化できます。 マーケティングデータの準備ができたら、数回クリックするだけで、選択したBIまたは視覚化ツールに送信できます。

無料のデモを予約して、OWOX BIがデータ品質を保証する方法と、完全に自動化されたデータ管理から今日どのように利益を得ることができるかを確認してください。

ステップ5.データを視覚化する

主要な指標を視覚的に提示することは、データを機能させるための最後のステップであるため、データの提示は有益でユーザーフレンドリーである必要があります。 自動化され適切に構成された視覚化により、問題を見つけるまでの時間を大幅に短縮できます。 つまり、データ品質を向上させるために、同じ期間に少ない労力でより多くの反復を実行できます。

また、人気のあるGoogleDataStudioのようなデータ視覚化サービスはデータをマージまたは変換できないことを覚えておくことが重要です。 多くのデータソースに基づくレポートが必要な場合は、問題を回避するために、必要なすべてのデータを事前に1つのデータストレージに収集することをお勧めします。

このステップで遭遇する可能性のあるデータ品質の問題:

1.実際のデータエラー

これは何?

以前のレベルのデータ収集と正規化で問題が発生すると、データ視覚化サービスによって表示されるレポートにデータエラーが発生する可能性があります。

それのどこが悪いんだい?

事実に基づくデータエラーで作成されたレポートは、時間とお金の無駄です。 それらは、ビジネスのリスクと成長ゾーンに対する利益や貴重な洞察を提供しません。 申し訳ありませんが、マリオですが、王女は別の城にいます!

理由は何ですか?

簡単に言えば、視覚化されたデータは関係ありません。 ただし、これらのエラーの原因を見つけるには、データの検証に戻る必要があります。

この問題を解決する方法は?

この問題を解決する唯一の方法は、レポートを作成する前に、データを徹底的に準備し、その品質を監視することです。

2.壊れたSQLクエリ、またはレポート(および/またはSQLクエリ)の編集が多すぎる

これは何ですか?

データ要件は絶えず変化しており、SQLクエリも変化しています。 その結果、報告システムが複雑になるほど、故障しやすくなります。

それのどこが悪いんだい?

どのような変更がいつ、どこで、いつ行われたかを思い出せないほど多くの変更がない限り、変更に問題はありません。 最終的には、SQLクエリが機能せず、視覚化する正しいデータがないため、慎重に構築されたすべてのレポートシステムが消滅する可能性があります。

理由は何ですか?

すべての小さなことを覚えておくのは非常に難しいので、一般的な間違いは、必要なすべてのデータセットに編集を適用するのを忘れることです。

この問題を解決する方法は?

理想的には、ユーザーは多くのSQLクエリを使用せずに、また多くの変更や編集を適用する必要なしに、マーケティングレポートを生成できる必要があります。

3.収集されたデータの誤解と誤用

これは何ですか?

最も一般的な問題の1つは、データの誤解です(したがって、データの誤用です)。 これは、特定のメトリックまたはパラメーターを複数の方法で解釈できる場合に発生します。 たとえば、レポートにコンバージョン指標があり、このレポートがさまざまなユーザーによって使用されているとします。 ユーザーの1人は、コンバージョンとはWebサイトへのアクセスを意味し、別のユーザーは注文を意味すると考えています。 ただし、このコンバージョン指標は配信された注文と購入された注文に関するものであると考える第三者もいます。 ご覧のとおり、解釈の可能性はたくさんあるので、レポートにどのような情報が表示されているかを明確にする必要があります。

それのどこが悪いんだい?

レポートやダッシュボードでどのデータが使用されているかが明確に理解されていない場合、現場の事実に基づいて決定が下される保証はありません。

理由は何ですか?

レポートで使用されるメトリックとパラメータの不明確な説明、または不適切なタイプのデータの視覚化は、不適切な決定につながる可能性があります。

この問題を解決する方法は?

入力データが正しく適切であることを確認しても、データの検証は終了しません。 このデータは依然として悪用される可能性があります。 この問題を回避するには、エンドユーザーは、レポートに表示される情報の明確で正確な説明を含む、完全で最新のビジネス対応データにアクセスできる必要があります。

我々の顧客

育つ 22%高速

マーケティングで最も効果的なものを測定することで、より速く成長します

マーケティング効率を分析し、成長分野を見つけ、ROIを向上させます

デモを入手重要なポイント

品質分析は、品質データから始まります。 データの取り組みは価値があり、信頼できるものでなければなりません。 そのため、データのエラーや不一致を事前に特定して対処し、全体的なパフォーマンスレポートを取得して、データの品質を向上させる必要があります。 一般に、データ品質の向上は、次の3つのステップを区別できる反復プロセスです。

- データのステータスを調べる

- データ品質を低下させる問題の特定

- 問題の修正

最も時間がかかるのは最初の2つのステップです。 問題が存在することを識別し、どの状況でエラーが発生するかを理解することは困難です。 問題が何であり、どこにあるのかが明らかになった後、それを修正するのは比較的簡単であることがわかります。

最後に、データを改善するために3つのドキュメントを作成できます。

- データ移動スキーム

- 責任マトリックス(誰が何に対して責任があるか)

- ビジネスデータモデル