Что такое ETL: полное руководство 101

Опубликовано: 2022-05-25Чем больше данных из различных источников собирает компания, тем больше у нее возможностей в аналитике, науке о данных и машинном обучении. Но вместе с возможностями растут и заботы, связанные с обработкой данных. Ведь перед тем, как начать строить отчеты и искать инсайты, все эти сырые и разрозненные данные необходимо обработать: очистить, проверить, привести к единому формату и объединить. Для этих задач используются процессы и инструменты извлечения , преобразования и загрузки (или ETL). В этой статье мы подробно разбираем, что такое ETL и зачем инструменты ETL нужны аналитикам и маркетологам.

Оглавление

- Что такое ETL и почему это важно?

- Краткая история возникновения ETL

- Как работает процесс ETL

- Шаг 1. Извлеките данные

- Шаг 2. Преобразование данных

- Шаг 3. Загрузите данные

- Преимущества ЭТЛ

- Проблемы ETL

- ETL против ELT — в чем разница?

- 5 советов для успешного внедрения ETL

- Как выбрать инструмент ETL

- ETL/ELT и OWOX BI

- Основные выводы

Что такое ETL и почему это важно?

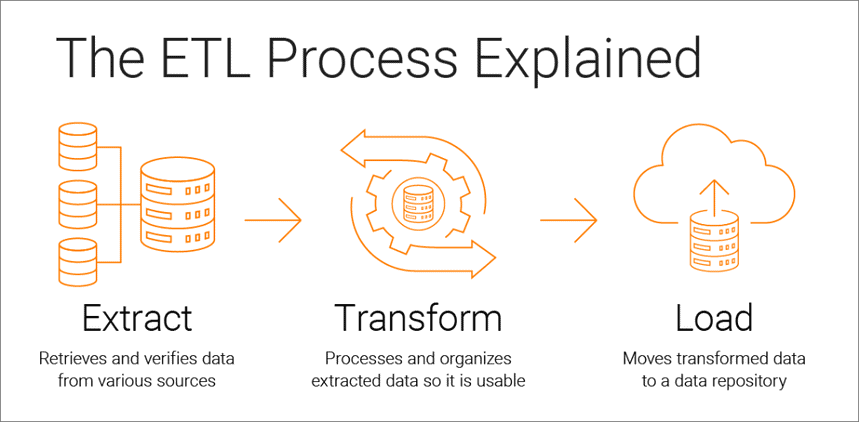

Извлечение, преобразование, загрузка — это процесс интеграции данных, который лежит в основе аналитики на основе данных и состоит из трех этапов:

- Данные взяты из первоисточника

- Данные конвертируются в формат, пригодный для анализа

- Данные загружаются в хранилище, озеро данных или систему бизнес-аналитики.

Инструменты ETL позволяют компаниям собирать данные различных типов из нескольких источников и объединять эти данные для работы с ними в централизованном хранилище, таком как Google BigQuery, Snowflake или Azure.

Процессы извлечения, преобразования и загрузки обеспечивают основу для успешного анализа данных и создают единый источник надежных данных, обеспечивая согласованность и актуальность всех данных вашей компании.

Чтобы быть максимально полезной для лиц, принимающих решения, система бизнес-аналитики должна меняться по мере изменения бизнеса. ETL — это регулярный процесс, и ваша система аналитики должна быть гибкой, автоматизированной и хорошо документированной.

Краткая история возникновения ETL

ETL стал популярным в 1970-х годах, когда компании начали работать с несколькими репозиториями или базами данных. В результате возникла необходимость эффективно интегрировать все эти данные.

В конце 1980-х годов появились технологии хранения данных, которые предлагали интегрированный доступ к данным из нескольких разнородных систем. Но проблема заключалась в том, что многим базам данных требовались ETL-инструменты конкретного поставщика. Поэтому разные отделы часто выбирали разные инструменты ETL для использования с разными решениями для хранения данных. Это привело к необходимости постоянно писать и настраивать скрипты под разные источники данных. Увеличение объема и сложности данных привело к автоматизированному процессу ETL, который позволяет избежать ручного кодирования.

Как работает процесс ETL

Процесс ETL состоит из трех этапов: извлечение, преобразование и загрузка. Давайте внимательно рассмотрим каждый из них.

Шаг 1. Извлеките данные

На этом этапе необработанные (структурированные и частично структурированные) данные из разных источников извлекаются и помещаются в промежуточную область (временную базу данных или сервер) для последующей обработки.

Источниками таких данных могут быть:

- Веб-сайты

- Мобильные устройства и приложения

- CRM/ERP-системы

- API-интерфейсы

- Маркетинговые услуги

- Инструменты аналитики

- Базы данных

- Облачные, гибридные и локальные среды

- Плоские файлы

- Таблицы

- SQL- или NoSQL-серверы

- Эл. адрес

- Инструменты передачи данных Интернета вещей (IoT), такие как торговые автоматы, банкоматы и товарные датчики.

Данные, собранные из разных источников, обычно разнородны и представлены в разных форматах: XML, JSON, CSV и других. Поэтому перед его извлечением необходимо создать логическую карту данных, описывающую взаимосвязь между источниками данных и целевыми данными.

На этом шаге необходимо проверить:

- Извлеченные записи соответствуют исходным данным

- Спам/нежелательные данные попадут в загрузку

- Данные соответствуют требованиям к целевому хранилищу

- Есть дубликаты и фрагментированные данные

- Все ключи на месте

Данные могут быть извлечены тремя способами:

- Частичное извлечение — источник уведомляет вас о последних изменениях данных.

- Частичное извлечение без уведомления — не все источники данных предоставляют уведомление об обновлении; однако они могут указать на записи, которые изменились, и предоставить выдержку из таких записей.

- Полное извлечение. Некоторые системы вообще не могут определить, какие данные были изменены; в этом случае возможна только полная экстракция. Для этого вам понадобится копия последней загрузки в том же формате, чтобы вы могли найти и внести изменения.

Этот шаг может быть выполнен либо вручную аналитиками, либо автоматически. Однако извлечение данных вручную занимает много времени и может привести к ошибкам. Поэтому мы рекомендуем использовать такие инструменты, как OWOX BI, которые автоматизируют процесс ETL и предоставляют вам качественные данные.

Шаг 2. Преобразование данных

На этом этапе необработанные данные, собранные в промежуточной области (временное хранилище), преобразуются в единый формат, отвечающий потребностям бизнеса и требованиям целевого хранилища данных. Такой подход — использование промежуточного хранилища вместо прямой загрузки данных в конечный пункт назначения — позволяет быстро откатить данные, если вдруг что-то пойдет не так.

Преобразование данных может включать следующие операции:

- Очистка — устранение несоответствий и неточностей в данных.

- Стандартизация — преобразование всех типов данных в один формат: даты, валюты и т. д.

- Дедупликация — Исключите или отбросьте избыточные данные.

- Проверка — удаление неиспользуемых данных и отметка аномалий.

- Повторная сортировка строк или столбцов данных

- Сопоставление — объединить данные из двух значений в одно или, наоборот, разделить данные из одного значения на два.

- Дополнение — извлечение данных из других источников.

- Форматирование данных в таблицы согласно схеме целевого хранилища данных

- Аудит качества данных и проверка соответствия

- Прочие задачи — применить любые дополнительные/необязательные правила для улучшения качества данных; например, если имя и фамилия в таблице находятся в разных столбцах, их можно объединить.

Трансформация, пожалуй, самая важная часть процесса ETL. Это помогает повысить качество данных и обеспечивает доставку обработанных данных в хранилище с полной совместимостью и готовностью к использованию в отчетах и других бизнес-задачах.

По нашему опыту, некоторые компании до сих пор не подготавливают готовые для бизнеса данные и не строят отчеты на необработанных данных. Основная проблема такого подхода — бесконечная отладка и переписывание SQL-запросов. Поэтому мы настоятельно рекомендуем не игнорировать этот этап.

OWOX BI автоматически собирает необработанные данные из разных источников и преобразует их в удобный для отчетов формат. Вы получаете готовые наборы данных, которые автоматически трансформируются в нужную структуру с учетом важных для маркетологов нюансов. Вам не придется тратить время на разработку и поддержку сложных преобразований, вникать в структуру данных и часами искать причины расхождений.

Шаг 3. Загрузите данные

На этом этапе обработанные данные из промежуточной области загружаются в целевую базу данных, хранилище или озеро данных либо локально, либо в облаке.

Это обеспечивает удобный доступ к бизнес-данным для различных групп внутри компании.

Есть несколько вариантов загрузки:

- Начальная загрузка — заполнение всех таблиц в хранилище данных в первый раз.

- Инкрементная загрузка — периодически записывайте новые данные по мере необходимости. В этом случае система сравнивает поступающие данные с уже имеющимися и создает дополнительные записи только в случае обнаружения новых данных. Такой подход удешевляет обработку данных за счет уменьшения их объема.

- Полное обновление — удаление содержимого таблицы и перезагрузка таблицы с последними данными.

Вы можете выполнить каждый из этих шагов с помощью инструментов ETL или вручную, используя собственный код и SQL-запросы.

Преимущества ЭТЛ

1. ETL экономит ваше время и помогает избежать ручной обработки данных.

Самым большим преимуществом процесса ETL является то, что он помогает автоматически собирать, преобразовывать и консолидировать данные. Вы можете сэкономить время и силы и избавиться от необходимости вручную импортировать огромное количество строк.

2. ETL упрощает работу со сложными данными.

Со временем вашему бизнесу приходится иметь дело с большим объемом сложных и разнообразных данных: часовые пояса, имена клиентов, идентификаторы устройств, местоположения и т. д. Добавьте еще несколько атрибутов, и вам придется форматировать данные круглосуточно. Кроме того, входящие данные могут быть в разных форматах и разных типов. ETL делает вашу жизнь намного проще.

3. ETL снижает риски, связанные с человеческим фактором.

Как бы аккуратно вы ни обращались со своими данными, вы не застрахованы от ошибок. Например, данные могут быть случайно продублированы в целевой системе или ручной ввод может содержать ошибку. Исключая влияние человека, инструмент ETL помогает избежать таких проблем.

4. ETL помогает улучшить процесс принятия решений.

Автоматизируя рабочие процессы с критически важными данными и снижая вероятность ошибок, ETL гарантирует, что данные, которые вы получаете для анализа, имеют высокое качество и им можно доверять. А качественные данные имеют основополагающее значение для принятия более эффективных корпоративных решений.

5. ETL увеличивает рентабельность инвестиций.

Поскольку процесс ETL экономит ваше время, усилия и ресурсы, процесс ETL в конечном итоге помогает вам повысить рентабельность инвестиций. Кроме того, улучшая бизнес-аналитику, вы увеличиваете свою прибыль. Это связано с тем, что компании полагаются на процесс ETL для получения консолидированных данных и принятия более эффективных бизнес-решений.

Проблемы ETL

При выборе инструмента ETL стоит полагаться на требования вашего бизнеса, объем собираемых данных и то, как вы их используете. С какими проблемами вы можете столкнуться при настройке процесса ETL?

1. Обработка данных из различных источников.

Одна компания может работать с сотнями источников с разными форматами данных. Это могут быть структурированные и частично структурированные данные, потоковые данные в реальном времени, плоские файлы, файлы CSV, корзины S3, источники потоковой передачи и многое другое. Некоторые из этих данных лучше конвертировать в пакетах, тогда как для других лучше работает потоковое преобразование данных. Обработка каждого типа данных наиболее эффективным и практичным способом может оказаться сложной задачей.

2. Качество данных имеет первостепенное значение.

Чтобы аналитика работала эффективно, необходимо обеспечить точную и полную трансформацию данных. Ручная обработка, регулярное обнаружение ошибок и перезапись SQL-запросов могут привести к ошибкам, дублированию или потере данных. Инструменты ETL избавляют аналитиков от рутины и помогают уменьшить количество ошибок. Аудит качества данных выявляет несоответствия и дубликаты, а функции мониторинга предупреждают, если вы имеете дело с несовместимыми типами данных и другими проблемами.

3. Ваша система аналитики должна быть масштабируемой.

Объем данных, которые собирают компании, с годами будет только расти. На данный момент вы можете довольствоваться локальной базой данных и пакетной загрузкой, но всегда ли этого будет достаточно для вашего бизнеса? Здорово иметь возможность масштабировать процессы и емкость ETL до бесконечности! Когда дело доходит до принятия решений на основе данных, мыслите масштабно и быстро: воспользуйтесь преимуществами облачного хранилища (например, Google BigQuery), которое позволяет быстро и дешево обрабатывать большие объемы данных.

ETL против ELT — в чем разница?

ELT (Extract, Load, Transform) — это современный взгляд на знакомый процесс ETL, в котором данные преобразуются после их загрузки в хранилище.

Традиционные инструменты ETL извлекают и преобразовывают данные из разных источников перед их загрузкой в хранилище. С появлением облачных хранилищ больше нет необходимости очищать данные на промежуточном этапе между исходным и целевым хранилищами данных.

ELT особенно актуален для расширенной аналитики. Например, вы можете загружать необработанные данные в озеро данных, а затем объединять их с данными из других источников или использовать для обучения моделей прогнозирования. Хранение необработанных данных позволяет аналитикам расширить свои возможности. Этот подход быстр, потому что он использует мощь современных механизмов обработки данных и уменьшает ненужное перемещение данных.

Что выбрать? ЭТЛ или ЭЛТ? Если вы работаете локально, а ваши данные предсказуемы и поступают только из нескольких источников, то традиционного ETL будет достаточно. Однако это становится все менее и менее актуальным, поскольку все больше компаний переходят на облачные или гибридные архитектуры данных.

5 советов для успешного внедрения ETL

Если вы хотите реализовать успешный процесс ETL, выполните следующие действия:

Шаг 1. Четко определите источники данных, которые вы хотите собирать и хранить. Этими источниками могут быть реляционные базы данных SQL, нереляционные базы данных NoSQL, платформы программного обеспечения как услуги (SaaS) или другие приложения. После подключения источников данных определите конкретные поля данных, которые вы хотите извлечь. Затем примите или введите эти данные из различных источников в необработанном виде.

Шаг 2. Унифицируйте эти данные с помощью набора бизнес-правил (таких как агрегация, вложение, сортировка, функции слияния и т. д.).

Шаг 3. После преобразования данные необходимо загрузить в хранилище. На этом шаге необходимо определиться с периодичностью загрузки данных. Укажите, хотите ли вы записать новые данные или обновить существующие данные.

Шаг 4. Важно проверить количество записей до и после передачи данных в хранилище. Это необходимо сделать, чтобы исключить неверные и избыточные данные.

Шаг 5. Последний шаг — автоматизировать процесс ETL с помощью специальных инструментов. Это поможет вам сэкономить время, повысить точность и уменьшить усилия, связанные с перезапуском процесса ETL вручную. С помощью инструментов автоматизации ETL вы можете проектировать рабочий процесс и управлять им через простой интерфейс. Кроме того, эти инструменты имеют такие возможности, как профилирование и очистка данных.

Как выбрать инструмент ETL

Для начала разберемся, какие существуют ETL-инструменты. В настоящее время доступны четыре типа. Одни предназначены для работы в локальной среде, другие — в облаке, третьи — в обеих средах. Что выбрать, зависит от того, где находятся ваши данные и какие потребности есть у вашего бизнеса:

- Инструменты ETL для пакетной обработки данных в локальном хранилище.

- Инструменты Cloud ETL, которые могут извлекать и загружать данные из источников непосредственно в облачное хранилище. Затем они могут преобразовывать данные, используя мощь и масштаб облака. Пример: OWOXBI.

- Инструменты ETL с открытым исходным кодом, такие как Apache Airflow, Apache Kafka и Apache NiFi, являются бюджетной альтернативой платным услугам. Некоторые из них не поддерживают сложные преобразования и могут иметь проблемы со службой поддержки клиентов.

- Инструменты ETL в реальном времени. Данные обрабатываются в режиме реального времени с использованием распределенной модели и возможностей потоковой передачи данных.

На что обратить внимание при выборе инструмента ETL:

- Простота использования и обслуживания

- Скорость работы

- Уровень безопасности

- Необходимое количество и разнообразие разъемов

- Возможность бесперебойной работы с другими компонентами вашей платформы данных, включая хранилище данных и озера данных.

ETL/ELT и OWOX BI

С OWOX BI вы можете собирать маркетинговые данные для отчетов любой сложности в безопасном облачном хранилище Google BigQuery без помощи аналитиков и разработчиков.

Что вы получаете с OWOX BI:

- Автоматически собирать данные из различных источников

- Автоматически импортировать необработанные данные в Google BigQuery

- Очистка, дедупликация, мониторинг качества и обновление данных

- Подготовка и моделирование бизнес-данных

- Создавайте отчеты без помощи аналитиков или знания SQL

OWOX BI высвобождает ваше драгоценное время, поэтому вы можете уделять больше внимания оптимизации рекламных кампаний и зон роста.

Вам больше не нужно ждать отчетов от аналитика. Получите готовые дашборды или индивидуальный отчет, основанный на смоделированных данных и подходящий для вашего бизнеса.

Благодаря уникальному подходу OWOX BI вы можете изменять источники данных и структуры данных, не перезаписывая SQL-запросы и не изменяя порядок отчетов. Это особенно актуально с выходом новой версии Google Analytics 4.

Основные выводы

Объемы данных, собираемых компаниями, с каждым днем становятся все больше и будут продолжать расти. Пока достаточно работы с локальными базами данных и пакетной загрузкой, однако очень скоро это перестанет удовлетворять потребности бизнеса. Таким образом, возможность масштабировать процессы ETL очень удобна и особенно актуальна для расширенной аналитики.

Основные преимущества инструментов ETL:

- экономия вашего времени.

- избегая ручной обработки данных.

- упрощает работу со сложными данными.

- снижение рисков, связанных с человеческим фактором.

- помогает улучшить принятие решений.

- увеличение рентабельности инвестиций.

Когда дело доходит до выбора инструмента ETL, подумайте о конкретных потребностях вашего бизнеса. Если вы работаете локально, а ваши данные предсказуемы и поступают только из нескольких источников, то традиционного ETL будет достаточно. Но не забывайте, что все больше компаний переходят на облачные или гибридные архитектуры, и вы должны это учитывать.