Qu'est-ce que l'ETL : le guide ultime 101

Publié: 2022-05-25Plus une entreprise collecte de données provenant de diverses sources, plus ses capacités en matière d'analyse, de science des données et d'apprentissage automatique sont grandes. Mais parallèlement aux opportunités, les inquiétudes liées au traitement des données grandissent. Après tout, avant de commencer à construire des rapports et à rechercher des informations, toutes ces données brutes et disparates doivent être traitées : nettoyées, vérifiées, converties dans un format unique et fusionnées. Les processus et outils d' extraction , de transformation et de chargement (ou ETL) sont utilisés pour ces tâches. Dans cet article, nous analysons en détail ce qu'est l'ETL et pourquoi les analystes et les spécialistes du marketing ont besoin d'outils ETL.

Table des matières

- Qu'est-ce que l'ETL et pourquoi est-ce important ?

- Un bref historique de la naissance de l'ETL

- Comment fonctionne le processus ETL

- Étape 1. Extraire les données

- Étape 2. Transformer les données

- Étape 3. Charger les données

- Avantages de l'ETL

- Les défis de l'ETL

- ETL vs ELT - Quelle est la différence ?

- 5 conseils pour une implémentation ETL réussie

- Comment sélectionner un outil ETL

- ETL/ELT et OWOX BI

- Points clés à retenir

Qu'est-ce que l'ETL et pourquoi est-ce important ?

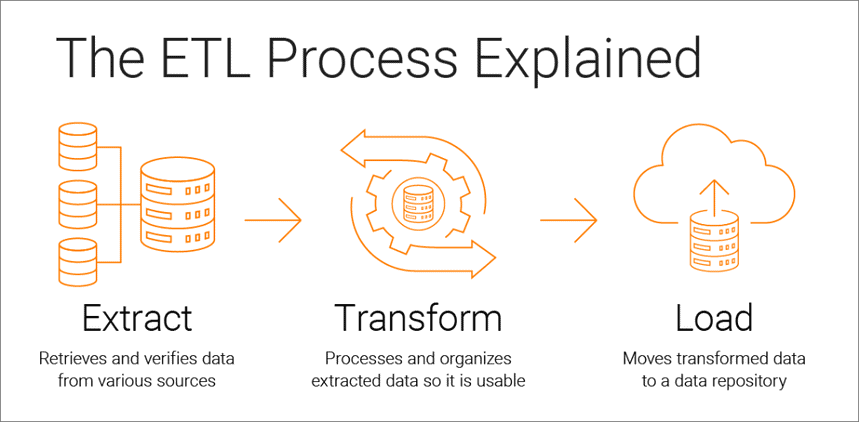

Extract, Transform, Load est un processus d'intégration de données qui sous-tend l'analyse basée sur les données et se compose de trois étapes :

- Les données sont extraites de la source d'origine

- Les données sont converties dans un format adapté à l'analyse

- Les données sont chargées dans le stockage, un lac de données ou un système d'intelligence d'affaires

Les outils ETL permettent aux entreprises de collecter des données de différents types à partir de plusieurs sources et de fusionner ces données pour les utiliser dans un emplacement de stockage centralisé, tel que Google BigQuery, Snowflake ou Azure.

Les processus d'extraction, de transformation et de chargement constituent la base d'une analyse de données réussie et créent une source unique de données fiables, garantissant la cohérence et la pertinence de toutes les données de votre entreprise.

Pour être aussi utile que possible aux décideurs, le système d'analyse d'une entreprise doit changer à mesure que l'entreprise évolue. L'ETL est un processus régulier et votre système d'analyse doit être flexible, automatisé et bien documenté.

Un bref historique de la naissance de l'ETL

ETL est devenu populaire dans les années 1970 lorsque les entreprises ont commencé à travailler avec plusieurs référentiels ou bases de données. Par conséquent, il est devenu nécessaire d'intégrer efficacement toutes ces données.

À la fin des années 1980, sont apparues des technologies de stockage de données offrant un accès intégré aux données de plusieurs systèmes hétérogènes. Mais le problème était que de nombreuses bases de données nécessitaient des outils ETL spécifiques au fournisseur. Par conséquent, différents départements ont souvent choisi différents outils ETL à utiliser avec différentes solutions de stockage de données. Cela a conduit à la nécessité d'écrire et d'ajuster constamment des scripts pour différentes sources de données. L'augmentation du volume et de la complexité des données a conduit à un processus ETL automatisé qui évite le codage manuel.

Comment fonctionne le processus ETL

Le processus ETL se compose de trois étapes : extraire, transformer et charger. Examinons de près chacun d'eux.

Étape 1. Extraire les données

A cette étape, des données brutes (structurées et partiellement structurées) provenant de différentes sources sont extraites et placées dans une zone intermédiaire (une base de données temporaire ou un serveur) pour un traitement ultérieur.

Les sources de ces données peuvent être :

- Sites Internet

- Appareils et applications mobiles

- Systèmes CRM/ERP

- interfaces API

- Services de commercialisation

- Outils d'analyse

- Bases de données

- Environnements cloud, hybrides et sur site

- Fichiers plats

- Feuilles de calcul

- Serveurs SQL ou NoSQL

- Outils de transfert de données Internet des objets (IoT) tels que les distributeurs automatiques, les distributeurs automatiques de billets et les capteurs de produits de base

Les données collectées à partir de différentes sources sont généralement hétérogènes et présentées dans différents formats : XML, JSON, CSV et autres. Par conséquent, avant de l'extraire, vous devez créer une carte de données logique décrivant la relation entre les sources de données et les données cibles.

A cette étape, il faut vérifier si :

- Les enregistrements extraits correspondent aux données source

- Le spam/les données indésirables entreront dans le téléchargement

- Les données répondent aux exigences de stockage de destination

- Il y a des doublons et des données fragmentées

- Toutes les clés sont en place

Les données peuvent être extraites de trois manières :

- Extraction partielle — La source vous informe des dernières modifications de données.

- Extraction partielle sans notification — Toutes les sources de données ne fournissent pas de notification de mise à jour ; cependant, ils peuvent pointer vers des enregistrements qui ont changé et fournir un extrait de ces enregistrements.

- Extraction complète — Certains systèmes ne peuvent pas du tout déterminer quelles données ont été modifiées ; dans ce cas, seule une extraction complète est possible. Pour ce faire, vous aurez besoin d'une copie du dernier téléchargement dans le même format afin de pouvoir rechercher et apporter des modifications.

Cette étape peut être effectuée manuellement par les analystes ou automatiquement. Cependant, l'extraction manuelle des données prend du temps et peut entraîner des erreurs. Par conséquent, nous vous recommandons d'utiliser des outils comme OWOX BI qui automatisent le processus ETL et vous fournissent des données de haute qualité.

Étape 2. Transformer les données

A cette étape, les données brutes collectées dans une zone intermédiaire (stockage temporaire) sont converties dans un format uniforme qui répond aux besoins de l'entreprise et aux exigences du stockage de données cible. Cette approche, qui consiste à utiliser un emplacement de stockage intermédiaire au lieu de télécharger directement les données vers la destination finale, vous permet de restaurer rapidement les données en cas de problème soudain.

La transformation des données peut inclure les opérations suivantes :

- Nettoyage — Éliminer les incohérences et les inexactitudes des données.

- Normalisation — Convertissez tous les types de données au même format : dates, devises, etc.

- Déduplication — Excluez ou supprimez les données redondantes.

- Validation — Supprimez les données inutilisées et signalez les anomalies.

- Retrier les lignes ou les colonnes de données

- Mappage : fusionnez les données de deux valeurs en une seule ou, inversement, divisez les données d'une valeur en deux.

- Compléter — Extraire des données d'autres sources.

- Mise en forme des données dans des tableaux selon le schéma du stockage de données cible

- Audit de la qualité des données et vérification de la conformité

- Autres tâches — Appliquez toutes les règles supplémentaires/facultatives pour améliorer la qualité des données ; par exemple, si les noms et prénoms du tableau se trouvent dans des colonnes différentes, vous pouvez les fusionner.

La transformation est peut-être la partie la plus importante du processus ETL. Il vous aide à améliorer la qualité des données et garantit que les données traitées sont livrées à un stockage entièrement compatible et prêt à être utilisé dans les rapports et autres tâches commerciales.

D'après notre expérience, certaines entreprises ne préparent toujours pas de données prêtes à l'emploi et ne créent pas de rapports à partir de données brutes. Le principal problème de cette approche est le débogage et la réécriture sans fin des requêtes SQL. Par conséquent, nous vous recommandons fortement de ne pas ignorer cette étape.

OWOX BI collecte automatiquement les données brutes de différentes sources et les convertit dans un format convivial pour les rapports. Vous recevez des ensembles de données prêts à l'emploi qui sont automatiquement transformés dans la structure souhaitée, en tenant compte des nuances importantes pour les spécialistes du marketing. Vous n'aurez pas à passer du temps à développer et à prendre en charge des transformations complexes, à vous plonger dans la structure des données et à passer des heures à rechercher les causes des écarts.

Étape 3. Charger les données

À ce stade, les données traitées de la zone de staging sont téléchargées vers la base de données, le stockage ou le lac de données cible, localement ou dans le cloud.

Cela offre un accès pratique aux données prêtes à l'emploi aux différentes équipes de l'entreprise.

Il existe plusieurs options de téléchargement :

- Chargement initial — Remplissez toutes les tables du stockage de données pour la première fois.

- Charge incrémentielle — Écrivez de nouvelles données périodiquement selon les besoins. Dans ce cas, le système compare les données entrantes avec ce qui est déjà disponible et crée des enregistrements supplémentaires uniquement s'il détecte de nouvelles données. Cette approche réduit le coût de traitement des données en réduisant leur volume.

- Mise à jour complète — Supprimez le contenu du tableau et rechargez le tableau avec les dernières données.

Vous pouvez effectuer chacune de ces étapes à l'aide d'outils ETL ou manuellement à l'aide d'un code personnalisé et de requêtes SQL.

Avantages de l'ETL

1. ETL vous fait gagner du temps et vous aide à éviter le traitement manuel des données.

Le principal avantage du processus ETL est qu'il vous aide à collecter, convertir et consolider automatiquement les données. Vous pouvez économiser du temps et des efforts et éliminer le besoin d'importer manuellement un grand nombre de lignes.

2. ETL facilite le travail avec des données complexes.

Au fil du temps, votre entreprise doit gérer une grande quantité de données complexes et diverses : fuseaux horaires, noms de clients, identifiants d'appareils, emplacements, etc. Ajoutez quelques attributs supplémentaires et vous devrez formater les données 24 heures sur 24. De plus, les données entrantes peuvent être dans différents formats et de différents types. ETL vous facilite la vie.

3. ETL réduit les risques liés au facteur humain.

Peu importe à quel point vous êtes prudent avec vos données, vous n'êtes pas à l'abri des erreurs. Par exemple, des données peuvent être accidentellement dupliquées dans le système cible ou une entrée manuelle peut contenir une erreur. En éliminant l'influence humaine, un outil ETL vous aide à éviter de tels problèmes.

4. L'ETL aide à améliorer la prise de décision.

En automatisant les workflows de données critiques et en réduisant les risques d'erreurs, ETL garantit que les données que vous recevez pour analyse sont de haute qualité et fiables. Et des données de qualité sont fondamentales pour prendre de meilleures décisions d'entreprise.

5. ETL augmente le retour sur investissement.

Parce qu'il vous fait gagner du temps, des efforts et des ressources, le processus ETL vous aide finalement à améliorer votre retour sur investissement. De plus, en améliorant l'analyse commerciale, vous augmentez vos profits. En effet, les entreprises s'appuient sur le processus ETL pour obtenir des données consolidées et prendre de meilleures décisions commerciales.

Les défis de l'ETL

Lorsque vous choisissez un outil ETL, il vaut la peine de vous fier aux besoins de votre entreprise, à la quantité de données collectées et à la manière dont vous l'utilisez. Quelles difficultés pouvez-vous rencontrer lors de la mise en place du processus ETL ?

1. Traitement des données provenant de diverses sources.

Une entreprise peut travailler avec des centaines de sources avec différents formats de données. Ceux-ci peuvent inclure des données structurées et partiellement structurées, des données de streaming en temps réel, des fichiers plats, des fichiers CSV, des paniers S3, des sources de streaming, etc. Certaines de ces données sont mieux converties en paquets, tandis que pour d'autres, la conversion de données en continu fonctionne mieux. Traiter chaque type de données de la manière la plus efficace et la plus pratique peut être un énorme défi.

2. La qualité des données est primordiale.

Pour que l'analyse fonctionne efficacement, vous devez garantir une transformation précise et complète des données. Le traitement manuel, la détection régulière des erreurs et la réécriture des requêtes SQL peuvent entraîner des erreurs, des doublons ou des pertes de données. Les outils ETL évitent aux analystes la routine et aident à réduire les erreurs. Un audit de la qualité des données identifie les incohérences et les doublons, et les fonctions de surveillance vous avertissent si vous avez affaire à des types de données incompatibles et à d'autres problèmes.

3. Votre système d'analyse doit être évolutif.

La quantité de données que les entreprises collectent ne fera qu'augmenter au fil des ans. Pour l'instant, vous pouvez vous contenter d'une base de données locale et du téléchargement par lots, mais cela suffira-t-il toujours à votre entreprise ? C'est formidable d'avoir la possibilité de faire évoluer les processus ETL et la capacité à l'infini ! En matière de prise de décision basée sur les données, pensez grand et rapidement : profitez du stockage dans le cloud (comme Google BigQuery) qui vous permet de traiter de grandes quantités de données rapidement et à moindre coût.

ETL vs ELT - Quelle est la différence ?

ELT (Extract, Load, Transform) est essentiellement un regard moderne sur le processus ETL familier dans lequel les données sont converties après avoir été chargées dans le stockage.

Les outils ETL traditionnels extraient et convertissent les données de différentes sources avant de les charger dans le stockage. Avec l'avènement du stockage dans le cloud, il n'est plus nécessaire de nettoyer les données à l'étape intermédiaire entre les emplacements de stockage de données source et cible.

ELT est particulièrement pertinent pour l'analyse avancée. Par exemple, vous pouvez télécharger des données brutes dans un lac de données, puis les fusionner avec des données provenant d'autres sources ou les utiliser pour former des modèles de prédiction. Garder les données brutes permet aux analystes d'étendre leurs capacités. Cette approche est rapide car elle exploite la puissance des mécanismes modernes de traitement des données et réduit les mouvements de données inutiles.

Lequel choisir ? ETL ou ELT ? Si vous travaillez localement et que vos données sont prévisibles et ne proviennent que de quelques sources, l'ETL traditionnel suffira. Cependant, cela devient de moins en moins pertinent à mesure que de plus en plus d'entreprises migrent vers des architectures de données cloud ou hybrides.

5 conseils pour une implémentation ETL réussie

Si vous souhaitez mettre en œuvre un processus ETL réussi, suivez ces étapes :

Étape 1. Identifiez clairement les sources des données que vous souhaitez collecter et stocker. Ces sources peuvent être des bases de données relationnelles SQL, des bases de données non relationnelles NoSQL, des plates-formes de logiciels en tant que service (SaaS) ou d'autres applications. Une fois les sources de données connectées, définissez les champs de données spécifiques que vous souhaitez extraire. Ensuite, acceptez ou saisissez ces données provenant de diverses sources sous forme brute.

Étape 2. Unifiez ces données à l'aide d'un ensemble de règles métier (telles que l'agrégation, la pièce jointe, le tri, les fonctions de fusion, etc.).

Étape 3. Après la transformation, les données doivent être chargées dans le stockage. À cette étape, vous devez décider de la fréquence de téléchargement des données. Indiquez si vous souhaitez enregistrer de nouvelles données ou mettre à jour des données existantes.

Étape 4. Il est important de vérifier le nombre d'enregistrements avant et après le transfert des données vers le référentiel. Cela devrait être fait pour exclure les données non valides et redondantes.

Étape 5. La dernière étape consiste à automatiser le processus ETL à l'aide d'outils spéciaux. Cela vous aidera à gagner du temps, à améliorer la précision et à réduire l'effort nécessaire pour redémarrer manuellement le processus ETL. Avec les outils d'automatisation ETL, vous pouvez concevoir et contrôler un flux de travail via une interface simple. De plus, ces outils ont des fonctionnalités telles que le profilage et le nettoyage des données.

Comment sélectionner un outil ETL

Pour commencer, voyons quels outils ETL existent. Il existe actuellement quatre types disponibles. Certains sont conçus pour fonctionner dans un environnement local, certains fonctionnent dans le cloud et certains fonctionnent dans les deux environnements. Le choix dépend de l'emplacement de vos données et des besoins de votre entreprise :

- Outils ETL pour le traitement par lots des données dans le stockage local.

- Outils Cloud ETL capables d'extraire et de charger des données depuis des sources directement vers le stockage dans le cloud. Ils peuvent ensuite transformer les données en utilisant la puissance et l'échelle du cloud. Exemple : OWOX BI.

- Les outils open source ETL tels qu'Apache Airflow, Apache Kafka et Apache NiFi sont une alternative économique aux services payants. Certains ne prennent pas en charge les transformations complexes et peuvent avoir des problèmes de support client.

- Outils ETL en temps réel. Les données sont traitées en temps réel à l'aide d'un modèle distribué et de capacités de diffusion de données.

Que rechercher lors de la sélection d'un outil ETL :

- Facilité d'utilisation et d'entretien

- Rapidité de travail

- Niveau de sécurité

- Nombre et variété de connecteurs nécessaires

- Capacité à travailler de manière transparente avec d'autres composants de votre plate-forme de données, y compris le stockage de données et les lacs de données

ETL/ELT et OWOX BI

Avec OWOX BI, vous pouvez collecter des données marketing pour des rapports de toute complexité dans le stockage cloud sécurisé de Google BigQuery sans l'aide d'analystes et de développeurs.

Ce que vous obtenez avec OWOX BI :

- Collectez automatiquement des données à partir de diverses sources

- Importez automatiquement des données brutes dans Google BigQuery

- Nettoyer, dédupliquer, surveiller la qualité et mettre à jour les données

- Préparer et modéliser des données prêtes pour l'entreprise

- Créez des rapports sans l'aide d'analystes ou de connaissances SQL

OWOX BI libère votre temps précieux, vous pouvez donc accorder plus d'attention à l'optimisation des campagnes publicitaires et des zones de croissance.

Vous n'avez plus à attendre les rapports d'un analyste. Obtenez des tableaux de bord prêts à l'emploi ou un rapport individuel basé sur des données simulées et adapté à votre entreprise.

Grâce à l'approche unique d'OWOX BI, vous pouvez modifier les sources de données et les structures de données sans écraser les requêtes SQL ni réorganiser les rapports. Ceci est particulièrement pertinent avec la sortie du nouveau Google Analytics 4.

Points clés à retenir

Les volumes de données collectées par les entreprises augmentent chaque jour et continueront de croître. Il suffit pour l'instant de travailler avec des bases de données locales et le téléchargement par lots, mais très bientôt, cela ne satisfera plus les besoins de l'entreprise. Ainsi, la possibilité de faire évoluer les processus ETL est pratique et particulièrement pertinente pour l'analyse avancée.

Les principaux avantages des outils ETL sont :

- économiser votre temps.

- évitant le traitement manuel des données.

- facilitant le travail avec des données complexes.

- réduire les risques liés au facteur humain.

- aider à améliorer la prise de décision.

- augmenter le retour sur investissement.

Lorsqu'il s'agit de choisir un outil ETL, pensez aux besoins particuliers de votre entreprise. Si vous travaillez localement et que vos données sont prévisibles et ne proviennent que de quelques sources, l'ETL traditionnel suffira. Mais n'oubliez pas que de plus en plus d'entreprises migrent vers des architectures cloud ou hybrides et il faut en tenir compte.