Qué es ETL: la guía definitiva 101

Publicado: 2022-05-25Cuantos más datos de varias fuentes recopile una empresa, mayores serán sus capacidades en análisis, ciencia de datos y aprendizaje automático. Pero junto con las oportunidades, crecen las preocupaciones asociadas con el procesamiento de datos. Después de todo, antes de comenzar a crear informes y buscar información, todos estos datos sin procesar y dispares deben procesarse: limpiarse, verificarse, convertirse a un solo formato y fusionarse. Para estas tareas se utilizan procesos y herramientas de extracción , transformación y carga (o ETL). En este artículo, analizamos en detalle qué es ETL y por qué los analistas y especialistas en marketing necesitan herramientas ETL.

Tabla de contenido

- ¿Qué es ETL y por qué es importante?

- Una breve historia de cómo surgió ETL

- Cómo funciona el proceso ETL

- Paso 1. Extraer datos

- Paso 2. Transformar datos

- Paso 3. Cargar datos

- Ventajas de ETL

- Desafíos de ETL

- ETL y ELT: ¿cuál es la diferencia?

- 5 consejos para una implementación ETL exitosa

- Cómo seleccionar una herramienta ETL

- ETL/ELT y OWOX BI

- Conclusiones clave

¿Qué es ETL y por qué es importante?

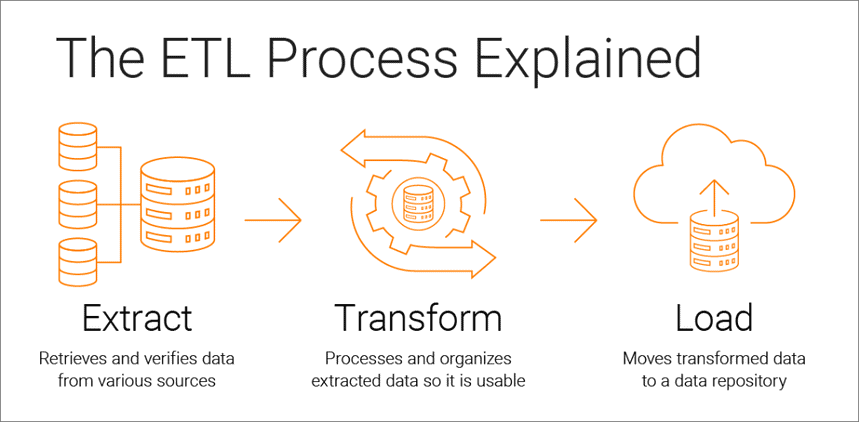

Extraer, transformar, cargar es un proceso de integración de datos que subyace en el análisis basado en datos y consta de tres etapas:

- Los datos se extraen de la fuente original.

- Los datos se convierten a un formato adecuado para el análisis

- Los datos se cargan en el almacenamiento, un lago de datos o un sistema de inteligencia empresarial

Las herramientas ETL permiten a las empresas recopilar datos de varios tipos de múltiples fuentes y fusionar esos datos para trabajar con ellos en una ubicación de almacenamiento centralizada, como Google BigQuery, Snowflake o Azure.

Los procesos de extracción, transformación y carga brindan la base para un análisis de datos exitoso y crean una fuente única de datos confiables, lo que garantiza la coherencia y relevancia de todos los datos de su empresa.

Para ser lo más útil posible para los responsables de la toma de decisiones, el sistema de análisis de una empresa debe cambiar a medida que cambia la empresa. ETL es un proceso regular y su sistema de análisis debe ser flexible, automatizado y bien documentado.

Una breve historia de cómo surgió ETL

ETL se hizo popular en la década de 1970 cuando las empresas comenzaron a trabajar con múltiples repositorios o bases de datos. Como resultado, se hizo necesario integrar efectivamente todos estos datos.

A fines de la década de 1980, aparecieron tecnologías de almacenamiento de datos que ofrecían acceso integrado a datos de varios sistemas heterogéneos. Pero el problema era que muchas bases de datos requerían herramientas ETL específicas del proveedor. Por lo tanto, diferentes departamentos a menudo eligen diferentes herramientas ETL para usar con diferentes soluciones de almacenamiento de datos. Esto llevó a la necesidad de escribir y ajustar constantemente scripts para diferentes fuentes de datos. El aumento en el volumen y la complejidad de los datos condujo a un proceso ETL automatizado que evita la codificación manual.

Cómo funciona el proceso ETL

El proceso ETL consta de tres pasos: extraer, transformar y cargar. Echemos un vistazo de cerca a cada uno de ellos.

Paso 1. Extraer datos

En este paso, los datos sin procesar (estructurados y parcialmente estructurados) de diferentes fuentes se extraen y se colocan en un área intermedia (una base de datos o servidor temporal) para su procesamiento posterior.

Las fuentes de tales datos pueden ser:

- sitios web

- Dispositivos móviles y aplicaciones

- Sistemas CRM/ERP

- interfaces API

- Servicios de marketing

- Herramientas de análisis

- bases de datos

- Entornos en la nube, híbridos y locales

- Archivos planos

- hojas de calculo

- Servidores SQL o NoSQL

- Correo electrónico

- Herramientas de transferencia de datos de Internet de las cosas (IoT), como máquinas expendedoras, cajeros automáticos y sensores de productos básicos

Los datos recopilados de diferentes fuentes suelen ser heterogéneos y se presentan en diferentes formatos: XML, JSON, CSV y otros. Por lo tanto, antes de extraerlo, debe crear un mapa de datos lógicos que describa la relación entre las fuentes de datos y los datos de destino.

En este paso, es necesario comprobar si:

- Los registros extraídos coinciden con los datos de origen

- Spam/datos no deseados entrarán en la descarga

- Los datos cumplen con los requisitos de almacenamiento de destino

- Hay datos duplicados y fragmentados.

- Todas las llaves están en su lugar

Los datos se pueden extraer de tres maneras:

- Extracción parcial: la fuente le notifica los últimos cambios de datos.

- Extracción parcial sin notificación: no todas las fuentes de datos proporcionan una notificación de actualización; sin embargo, pueden señalar registros que han cambiado y proporcionar un extracto de dichos registros.

- Extracción completa: algunos sistemas no pueden determinar qué datos se han modificado en absoluto; en este caso, solo es posible la extracción completa. Para hacer eso, necesitará una copia de la última carga en el mismo formato para que pueda encontrar y hacer cambios.

Este paso puede ser realizado manualmente por los analistas o automáticamente. Sin embargo, la extracción manual de datos requiere mucho tiempo y puede generar errores. Por lo tanto, recomendamos usar herramientas como OWOX BI que automatizan el proceso ETL y le brindan datos de alta calidad.

Paso 2. Transformar datos

En este paso, los datos sin procesar recopilados en un área intermedia (almacenamiento temporal) se convierten en un formato uniforme que cumple con las necesidades del negocio y los requisitos del almacenamiento de datos de destino. Este enfoque, que utiliza una ubicación de almacenamiento intermedia en lugar de cargar datos directamente en el destino final, le permite revertir rápidamente los datos si algo sale mal repentinamente.

La transformación de datos puede incluir las siguientes operaciones:

- Limpieza: elimine las inconsistencias e imprecisiones de los datos.

- Estandarización: convierta todos los tipos de datos al mismo formato: fechas, monedas, etc.

- Deduplicación: excluya o descarte datos redundantes.

- Validación: elimine datos no utilizados y marque anomalías.

- Reordenación de filas o columnas de datos

- Mapeo: combine datos de dos valores en uno o, por el contrario, divida datos de un valor en dos.

- Complementación: extraiga datos de otras fuentes.

- Formateo de datos en tablas de acuerdo con el esquema del almacenamiento de datos de destino

- Auditoría de la calidad de los datos y revisión del cumplimiento

- Otras tareas: aplicar reglas adicionales/opcionales para mejorar la calidad de los datos; por ejemplo, si el nombre y el apellido de la tabla están en columnas diferentes, puede fusionarlos.

La transformación es quizás la parte más importante del proceso ETL. Lo ayuda a mejorar la calidad de los datos y garantiza que los datos procesados se entreguen en un almacenamiento totalmente compatible y listo para usar en informes y otras tareas comerciales.

Según nuestra experiencia, algunas empresas aún no preparan datos listos para el negocio ni crean informes sobre datos sin procesar. El principal problema con este enfoque es la interminable depuración y reescritura de consultas SQL. Por lo tanto, recomendamos encarecidamente no ignorar esta etapa.

OWOX BI recopila automáticamente datos sin procesar de diferentes fuentes y los convierte en un formato compatible con informes. Recibe conjuntos de datos listos para usar que se transforman automáticamente en la estructura deseada, teniendo en cuenta los matices importantes para los especialistas en marketing. No tendrá que dedicar tiempo a desarrollar y respaldar transformaciones complejas, profundizar en la estructura de datos y pasar horas buscando las causas de las discrepancias.

Paso 3. Cargar datos

En este punto, los datos procesados del área de preparación se cargan en la base de datos, el almacenamiento o el lago de datos de destino, ya sea localmente o en la nube.

Esto proporciona un acceso conveniente a datos listos para el negocio a diferentes equipos dentro de la empresa.

Hay varias opciones de carga:

- Carga inicial: llene todas las tablas en el almacenamiento de datos por primera vez.

- Carga incremental: escriba nuevos datos periódicamente según sea necesario. En este caso, el sistema compara los datos entrantes con lo que ya está disponible y crea registros adicionales solo si detecta nuevos datos. Este enfoque reduce el costo de procesamiento de datos al reducir su volumen.

- Actualización completa: elimine el contenido de la tabla y vuelva a cargar la tabla con los datos más recientes.

Puede realizar cada uno de estos pasos usando herramientas ETL o manualmente usando código personalizado y consultas SQL.

Ventajas de ETL

1. ETL le ahorra tiempo y lo ayuda a evitar el procesamiento manual de datos.

El mayor beneficio del proceso ETL es que lo ayuda a recopilar, convertir y consolidar datos automáticamente. Puede ahorrar tiempo y esfuerzo y eliminar la necesidad de importar manualmente una gran cantidad de líneas.

2. ETL facilita el trabajo con datos complejos.

Con el tiempo, su empresa tiene que lidiar con una gran cantidad de datos complejos y diversos: zonas horarias, nombres de clientes, ID de dispositivos, ubicaciones, etc. Agregue algunos atributos más y tendrá que formatear los datos las 24 horas del día. Además, los datos entrantes pueden estar en diferentes formatos y de diferentes tipos. ETL te hace la vida mucho más fácil.

3. ETL reduce los riesgos asociados al factor humano.

No importa cuán cuidadoso sea con sus datos, no es inmune a los errores. Por ejemplo, los datos pueden duplicarse accidentalmente en el sistema de destino o una entrada manual puede contener un error. Al eliminar la influencia humana, una herramienta ETL lo ayuda a evitar tales problemas.

4. ETL ayuda a mejorar la toma de decisiones.

Al automatizar los flujos de trabajo de datos críticos y reducir la posibilidad de errores, ETL garantiza que los datos que recibe para el análisis sean de alta calidad y confiables. Y los datos de calidad son fundamentales para tomar mejores decisiones corporativas.

5. ETL aumenta el ROI.

Debido a que le ahorra tiempo, esfuerzo y recursos, el proceso ETL finalmente lo ayuda a mejorar su ROI. Además, al mejorar el análisis comercial, aumenta sus ganancias. Esto se debe a que las empresas confían en el proceso ETL para obtener datos consolidados y tomar mejores decisiones comerciales.

Desafíos de ETL

Al elegir una herramienta ETL, vale la pena confiar en los requisitos de su negocio, la cantidad de datos recopilados y cómo los usa. ¿Qué desafíos puede encontrar al configurar el proceso ETL?

1. Procesamiento de datos de una variedad de fuentes.

Una empresa puede trabajar con cientos de fuentes con diferentes formatos de datos. Estos pueden incluir datos estructurados y parcialmente estructurados, datos de transmisión en tiempo real, archivos planos, archivos CSV, canastas S3, fuentes de transmisión y más. Algunos de estos datos se convierten mejor en paquetes, mientras que para otros, la conversión de datos de transmisión funciona mejor. Procesar cada tipo de datos de la manera más eficiente y práctica puede ser un gran desafío.

2. La calidad de los datos es primordial.

Para que el análisis funcione de manera eficiente, debe garantizar una transformación de datos precisa y completa. El procesamiento manual, la detección regular de errores y la reescritura de consultas SQL pueden generar errores, duplicaciones o pérdida de datos. Las herramientas ETL salvan a los analistas de la rutina y ayudan a reducir los errores. Una auditoría de calidad de datos identifica inconsistencias y duplicados, y las funciones de monitoreo advierten si se trata de tipos de datos incompatibles y otros problemas.

3. Su sistema de análisis debe ser escalable.

La cantidad de datos que recopilan las empresas solo crecerá con los años. Por ahora, puede estar satisfecho con una base de datos local y la descarga por lotes, pero ¿será siempre suficiente para su negocio? ¡Es genial tener la posibilidad de escalar los procesos y la capacidad de ETL hasta el infinito! Cuando se trata de tomar decisiones basadas en datos, piense en grande y rápido: aproveche el almacenamiento en la nube (como Google BigQuery) que le permite procesar grandes cantidades de datos de forma rápida y económica.

ETL y ELT: ¿cuál es la diferencia?

ELT (Extraer, Cargar, Transformar) es esencialmente una mirada moderna al proceso ETL familiar en el que los datos se convierten después de que se cargan en el almacenamiento.

Las herramientas ETL tradicionales extraen y convierten datos de diferentes fuentes antes de cargarlos en el almacenamiento. Con la llegada del almacenamiento en la nube, no es necesario limpiar los datos en la etapa intermedia entre las ubicaciones de almacenamiento de datos de origen y de destino.

ELT es particularmente relevante para el análisis avanzado. Por ejemplo, puede cargar datos sin procesar en un lago de datos y luego fusionarlos con datos de otras fuentes o usarlos para entrenar modelos de predicción. Mantener los datos sin procesar permite a los analistas ampliar sus capacidades. Este enfoque es rápido porque aprovecha el poder de los mecanismos modernos de procesamiento de datos y reduce el movimiento de datos innecesario.

¿Cuál deberías elegir? ¿ETL o ELT? Si trabaja localmente y sus datos son predecibles y provienen de unas pocas fuentes, entonces el ETL tradicional será suficiente. Sin embargo, se está volviendo cada vez menos relevante a medida que más empresas se trasladan a la nube o arquitecturas de datos híbridas.

5 consejos para una implementación ETL exitosa

Si desea implementar un proceso ETL exitoso, siga estos pasos:

Paso 1. Identifique claramente las fuentes de los datos que desea recopilar y almacenar. Estas fuentes pueden ser bases de datos relacionales SQL, bases de datos no relacionales NoSQL, plataformas de software como servicio (SaaS) u otras aplicaciones. Una vez que las fuentes de datos estén conectadas, defina los campos de datos específicos que desea extraer. Luego acepte o ingrese estos datos de varias fuentes en forma cruda.

Paso 2. Unifique estos datos mediante un conjunto de reglas comerciales (como agregación, adjunto, clasificación, funciones de combinación, etc.).

Paso 3. Después de la transformación, los datos deben cargarse en el almacenamiento. En este paso, debe decidir la frecuencia de carga de datos. Especifique si desea registrar nuevos datos o actualizar los existentes.

Paso 4. Es importante verificar la cantidad de registros antes y después de transferir los datos al repositorio. Esto debe hacerse para excluir datos no válidos y redundantes.

Paso 5. El último paso es automatizar el proceso ETL utilizando herramientas especiales. Esto lo ayudará a ahorrar tiempo, mejorar la precisión y reducir el esfuerzo que implica reiniciar el proceso ETL manualmente. Con las herramientas de automatización de ETL, puede diseñar y controlar un flujo de trabajo a través de una interfaz simple. Además, estas herramientas tienen capacidades como la creación de perfiles y la limpieza de datos.

Cómo seleccionar una herramienta ETL

Para empezar, averigüemos qué herramientas ETL existen. Actualmente hay cuatro tipos disponibles. Algunos están diseñados para funcionar en un entorno local, otros funcionan en la nube y otros funcionan en ambos entornos. Cuál elegir depende de dónde se encuentren sus datos y qué necesidades tenga su empresa:

- Herramientas ETL para procesamiento por lotes de datos en almacenamiento local.

- Herramientas ETL en la nube que pueden extraer y cargar datos de fuentes directamente al almacenamiento en la nube. Luego pueden transformar los datos usando el poder y la escala de la nube. Ejemplo: OWOX BI.

- Las herramientas de código abierto de ETL como Apache Airflow, Apache Kafka y Apache NiFi son una alternativa económica a los servicios pagos. Algunos no admiten transformaciones complejas y pueden tener problemas de atención al cliente.

- Herramientas ETL en tiempo real. Los datos se procesan en tiempo real utilizando un modelo distribuido y capacidades de transmisión de datos.

Qué buscar al seleccionar una herramienta ETL:

- Facilidad de uso y mantenimiento

- Velocidad de trabajo

- Nivel de seguridad

- Número y variedad de conectores necesarios

- Capacidad para trabajar sin problemas con otros componentes de su plataforma de datos, incluido el almacenamiento de datos y los lagos de datos

ETL/ELT y OWOX BI

Con OWOX BI, puede recopilar datos de marketing para informes de cualquier complejidad en el almacenamiento seguro en la nube de Google BigQuery sin la ayuda de analistas y desarrolladores.

Lo que obtienes con OWOX BI:

- Recopile automáticamente datos de varias fuentes

- Importe automáticamente datos sin procesar en Google BigQuery

- Limpiar, deduplicar, monitorear la calidad y actualizar los datos

- Prepare y modele datos listos para el negocio

- Cree informes sin la ayuda de analistas o conocimientos de SQL

OWOX BI libera su valioso tiempo, para que pueda prestar más atención a la optimización de las campañas publicitarias y las zonas de crecimiento.

Ya no tiene que esperar los informes de un analista. Obtenga paneles listos para usar o un informe individual que se base en datos simulados y sea adecuado para su negocio.

Con el enfoque único de OWOX BI, puede modificar fuentes de datos y estructuras de datos sin sobrescribir consultas SQL ni reordenar informes. Esto es especialmente relevante con el lanzamiento del nuevo Google Analytics 4.

Conclusiones clave

Los volúmenes de datos recopilados por las empresas son cada día más grandes y seguirán creciendo. Es suficiente para trabajar con bases de datos locales y descargas por lotes por ahora, sin embargo, muy pronto no satisfará las necesidades comerciales. Por lo tanto, la posibilidad de escalar los procesos ETL resulta útil y es particularmente relevante para el análisis avanzado.

Las principales ventajas de las herramientas ETL son:

- ahorrando tu tiempo.

- evitando el procesamiento manual de datos.

- facilitando el trabajo con datos complejos.

- reducir los riesgos asociados al factor humano.

- ayudar a mejorar la toma de decisiones.

- aumentando el retorno de la inversión.

Cuando se trata de elegir una herramienta ETL, piense en las necesidades particulares de su empresa. Si trabaja localmente y sus datos son predecibles y provienen de unas pocas fuentes, entonces el ETL tradicional será suficiente. Pero no olvides que cada vez más empresas se están pasando a la nube o arquitecturas híbridas y hay que tener esto en cuenta.