Apa itu ETL: panduan pamungkas 101

Diterbitkan: 2022-05-25Semakin banyak data dari berbagai sumber yang dikumpulkan perusahaan, semakin besar kemampuan mereka dalam analitik, ilmu data, dan pembelajaran mesin. Namun seiring dengan peluang, kekhawatiran tumbuh terkait dengan pemrosesan data. Lagi pula, sebelum mulai membuat laporan dan mencari wawasan, semua data mentah dan berbeda ini harus diproses: dibersihkan, diperiksa, dikonversi ke format tunggal, dan digabungkan. Proses dan alat Extract , Transform , dan Load (atau ETL) digunakan untuk tugas-tugas ini. Dalam artikel ini, kami menganalisis secara rinci apa itu ETL dan mengapa alat ETL dibutuhkan oleh para analis dan pemasar.

Daftar Isi

- Apa itu ETL dan mengapa itu penting?

- Sejarah singkat tentang bagaimana ETL muncul

- Bagaimana proses ETL bekerja

- Langkah 1. Ekstrak data

- Langkah 2. Ubah data

- Langkah 3. Muat data

- Keuntungan dari ETL

- Tantangan ETL

- ETL vs ELT — Apa bedanya?

- 5 tips untuk implementasi ETL yang sukses

- Cara memilih alat ETL

- ETL/ELT dan OWOX BI

- takeaways kunci

Apa itu ETL dan mengapa itu penting?

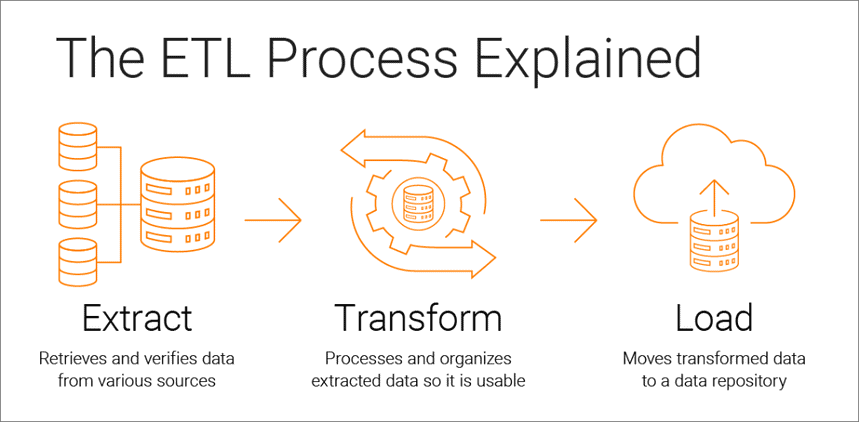

Ekstrak, Transformasi, Muat adalah proses integrasi data yang mendasari analisis berbasis data dan terdiri dari tiga tahap:

- Data diambil dari sumber aslinya

- Data dikonversi ke format yang sesuai untuk analisis

- Data dimuat ke dalam penyimpanan, danau data, atau sistem intelijen bisnis

Alat ETL memungkinkan perusahaan untuk mengumpulkan data dari berbagai jenis dari berbagai sumber dan menggabungkan data tersebut untuk bekerja dengannya di lokasi penyimpanan terpusat, seperti Google BigQuery, Snowflake, atau Azure.

Proses Ekstrak, Transformasi, dan Muat memberikan dasar untuk analisis data yang sukses dan membuat satu sumber data yang andal, memastikan konsistensi dan relevansi semua data perusahaan Anda.

Agar berguna bagi para pengambil keputusan, sistem analitik bisnis harus berubah seiring perubahan bisnis. ETL adalah proses reguler, dan sistem analitik Anda harus fleksibel, otomatis, dan terdokumentasi dengan baik.

Sejarah singkat tentang bagaimana ETL muncul

ETL menjadi populer pada 1970-an ketika perusahaan mulai bekerja dengan banyak repositori, atau database. Akibatnya, menjadi perlu untuk mengintegrasikan semua data ini secara efektif.

Pada akhir 1980-an, muncul teknologi penyimpanan data yang menawarkan akses terintegrasi ke data dari beberapa sistem yang heterogen. Tapi masalahnya adalah banyak database membutuhkan alat ETL khusus vendor. Oleh karena itu, departemen yang berbeda sering memilih alat ETL yang berbeda untuk digunakan dengan solusi penyimpanan data yang berbeda. Hal ini menyebabkan kebutuhan untuk terus-menerus menulis dan menyesuaikan skrip untuk sumber data yang berbeda. Peningkatan volume dan kompleksitas data menyebabkan proses ETL otomatis yang menghindari pengkodean manual.

Bagaimana proses ETL bekerja

Proses ETL terdiri dari tiga langkah: mengekstrak, mengubah, dan memuat. Mari kita lihat dari dekat masing-masing.

Langkah 1. Ekstrak data

Pada langkah ini, data mentah (terstruktur dan sebagian terstruktur) dari berbagai sumber diekstraksi dan ditempatkan di area perantara (database atau server sementara) untuk pemrosesan selanjutnya.

Sumber data tersebut mungkin:

- Situs web

- Perangkat dan aplikasi seluler

- Sistem CRM/ERP

- antarmuka API

- layanan pemasaran

- Alat analisis

- Database

- Lingkungan cloud, hybrid, dan lokal

- File datar

- Spreadsheet

- Server SQL atau NoSQL

- Surel

- Alat transfer data Internet of Things (IoT) seperti mesin penjual otomatis, ATM, dan sensor komoditas

Data yang dikumpulkan dari sumber yang berbeda biasanya heterogen dan disajikan dalam format yang berbeda: XML, JSON, CSV, dan lain-lain. Oleh karena itu, sebelum mengekstraknya, Anda harus membuat peta data logis yang menjelaskan hubungan antara sumber data dan data target.

Pada langkah ini, perlu untuk memeriksa apakah:

- Catatan yang diekstraksi cocok dengan data sumber

- Spam/data yang tidak diinginkan akan masuk ke dalam unduhan

- Data memenuhi persyaratan penyimpanan tujuan

- Ada duplikat dan data terfragmentasi

- Semua kunci ada di tempatnya

Data dapat diekstraksi dengan tiga cara:

- Ekstraksi sebagian — Sumber memberi tahu Anda tentang perubahan data terbaru.

- Ekstraksi sebagian tanpa pemberitahuan — Tidak semua sumber data menyediakan pemberitahuan pembaruan; namun, mereka dapat menunjukkan catatan yang telah berubah dan memberikan kutipan dari catatan tersebut.

- Ekstraksi penuh — Beberapa sistem tidak dapat menentukan data mana yang telah diubah sama sekali; dalam hal ini, hanya ekstraksi lengkap yang mungkin. Untuk melakukannya, Anda memerlukan salinan unggahan terbaru dalam format yang sama sehingga Anda dapat menemukan dan membuat perubahan.

Langkah ini dapat dilakukan secara manual oleh analis atau secara otomatis. Namun, mengekstrak data secara manual memakan waktu dan dapat menyebabkan kesalahan. Oleh karena itu, kami menyarankan untuk menggunakan alat seperti OWOX BI yang mengotomatiskan proses ETL dan memberi Anda data berkualitas tinggi.

Langkah 2. Ubah data

Pada langkah ini, data mentah yang dikumpulkan di area perantara (penyimpanan sementara) diubah menjadi format seragam yang memenuhi kebutuhan bisnis dan persyaratan penyimpanan data target. Pendekatan ini — menggunakan lokasi penyimpanan perantara alih-alih langsung mengunggah data ke tujuan akhir — memungkinkan Anda dengan cepat memutar kembali data jika tiba-tiba terjadi kesalahan.

Transformasi data dapat mencakup operasi berikut:

- Pembersihan — Menghilangkan inkonsistensi dan ketidakakuratan data.

- Standardisasi — Mengonversi semua tipe data ke format yang sama: tanggal, mata uang, dll.

- Deduplikasi — Mengecualikan atau membuang data yang berlebihan.

- Validasi — Hapus data yang tidak digunakan dan tandai anomali.

- Mengurutkan ulang baris atau kolom data

- Pemetaan — Menggabungkan data dari dua nilai menjadi satu atau, sebaliknya, membagi data dari satu nilai menjadi dua.

- Pelengkap — Ekstrak data dari sumber lain.

- Memformat data ke dalam tabel sesuai dengan skema penyimpanan data target

- Mengaudit kualitas data dan meninjau kepatuhan

- Tugas lain — Menerapkan aturan tambahan/opsional untuk meningkatkan kualitas data; misalnya, jika nama depan dan belakang dalam tabel berada di kolom yang berbeda, Anda bisa menggabungkannya.

Transformasi mungkin merupakan bagian terpenting dari proses ETL. Ini membantu Anda meningkatkan kualitas data dan memastikan bahwa data yang diproses dikirim ke penyimpanan yang sepenuhnya kompatibel dan siap digunakan dalam pelaporan dan tugas bisnis lainnya.

Berdasarkan pengalaman kami, beberapa perusahaan masih belum menyiapkan data siap-bisnis dan membuat laporan berdasarkan data mentah. Masalah utama dengan pendekatan ini adalah debugging tanpa akhir dan penulisan ulang kueri SQL. Oleh karena itu, kami sangat menyarankan untuk tidak mengabaikan tahap ini.

OWOX BI secara otomatis mengumpulkan data mentah dari berbagai sumber dan mengubahnya menjadi format yang ramah laporan. Anda menerima kumpulan data siap pakai yang secara otomatis diubah menjadi struktur yang diinginkan, dengan mempertimbangkan nuansa penting bagi pemasar. Anda tidak perlu menghabiskan waktu untuk mengembangkan dan mendukung transformasi kompleks, mempelajari struktur data, dan menghabiskan waktu berjam-jam mencari penyebab perbedaan.

Langkah 3. Muat data

Pada titik ini, data yang diproses dari staging area diunggah ke database target, penyimpanan, atau data lake, baik secara lokal maupun di cloud.

Ini memberikan akses mudah ke data siap-bisnis ke berbagai tim di dalam perusahaan.

Ada beberapa opsi pengunggahan:

- Beban awal — Isi semua tabel dalam penyimpanan data untuk pertama kalinya.

- Beban tambahan — Tulis data baru secara berkala sesuai kebutuhan. Dalam hal ini, sistem membandingkan data yang masuk dengan yang sudah tersedia dan membuat catatan tambahan hanya jika mendeteksi data baru. Pendekatan ini mengurangi biaya pemrosesan data dengan mengurangi volumenya.

- Pembaruan penuh — Hapus konten tabel dan muat ulang tabel dengan data terbaru.

Anda dapat melakukan setiap langkah ini menggunakan alat ETL atau secara manual menggunakan kode kustom dan kueri SQL.

Keuntungan dari ETL

1. ETL menghemat waktu Anda dan membantu Anda menghindari pemrosesan data manual.

Manfaat terbesar dari proses ETL adalah membantu Anda mengumpulkan, mengonversi, dan mengkonsolidasikan data secara otomatis. Anda dapat menghemat waktu dan tenaga serta menghilangkan kebutuhan untuk mengimpor sejumlah besar jalur secara manual.

2. ETL memudahkan untuk bekerja dengan data yang kompleks.

Seiring waktu, bisnis Anda harus berurusan dengan sejumlah besar data yang kompleks dan beragam: zona waktu, nama pelanggan, ID perangkat, lokasi, dll. Tambahkan beberapa atribut lagi, dan Anda harus memformat data sepanjang waktu. Selain itu, data yang masuk bisa dalam format dan tipe yang berbeda. ETL membuat hidup Anda lebih mudah.

3. ETL mengurangi risiko yang terkait dengan faktor manusia.

Tidak peduli seberapa berhati-hati Anda dengan data Anda, Anda tidak kebal terhadap kesalahan. Misalnya, data mungkin secara tidak sengaja diduplikasi dalam sistem target, atau input manual mungkin berisi kesalahan. Dengan menghilangkan pengaruh manusia, alat ETL membantu Anda menghindari masalah seperti itu.

4. ETL membantu meningkatkan pengambilan keputusan.

Dengan mengotomatiskan alur kerja data penting dan mengurangi kemungkinan kesalahan, ETL memastikan bahwa data yang Anda terima untuk analisis berkualitas tinggi dan dapat dipercaya. Dan data berkualitas sangat penting untuk membuat keputusan perusahaan yang lebih baik.

5. ETL meningkatkan ROI.

Karena menghemat waktu, tenaga, dan sumber daya, proses ETL pada akhirnya membantu Anda meningkatkan ROI. Selain itu, dengan meningkatkan analisis bisnis, Anda meningkatkan keuntungan Anda. Ini karena perusahaan mengandalkan proses ETL untuk mendapatkan data terkonsolidasi dan membuat keputusan bisnis yang lebih baik.

Tantangan ETL

Saat memilih alat ETL, ada baiknya mengandalkan kebutuhan bisnis Anda, jumlah data yang dikumpulkan, dan cara Anda menggunakannya. Tantangan apa yang dapat Anda hadapi saat menyiapkan proses ETL?

1. Mengolah data dari berbagai sumber.

Satu perusahaan dapat bekerja dengan ratusan sumber dengan format data yang berbeda. Ini dapat mencakup data terstruktur dan sebagian terstruktur, data streaming waktu nyata, file datar, file CSV, keranjang S3, sumber streaming, dan banyak lagi. Beberapa dari data ini paling baik dikonversi dalam bentuk paket, sementara untuk yang lain, konversi data streaming bekerja lebih baik. Memproses setiap jenis data dengan cara yang paling efisien dan praktis dapat menjadi tantangan besar.

2. Kualitas data adalah yang terpenting.

Agar analitik bekerja secara efisien, Anda perlu memastikan transformasi data yang akurat dan lengkap. Pemrosesan manual, deteksi kesalahan reguler, dan penulisan ulang kueri SQL dapat mengakibatkan kesalahan, duplikasi, atau kehilangan data. Alat ETL menyelamatkan analis dari rutinitas dan membantu mengurangi kesalahan. Audit kualitas data mengidentifikasi inkonsistensi dan duplikat, dan fungsi pemantauan memperingatkan jika Anda berurusan dengan tipe data yang tidak kompatibel dan masalah lainnya.

3. Sistem analitik Anda harus terukur.

Jumlah data yang dikumpulkan perusahaan hanya akan bertambah selama bertahun-tahun. Untuk saat ini, Anda dapat puas dengan database lokal dan unduhan batch, tetapi apakah itu akan selalu cukup untuk bisnis Anda? Sangat menyenangkan memiliki kemungkinan untuk menskalakan proses dan kapasitas ETL hingga tak terbatas! Dalam hal pengambilan keputusan berdasarkan data, pikirkan baik-baik dan cepat: manfaatkan penyimpanan cloud (seperti Google BigQuery) yang memungkinkan Anda memproses data dalam jumlah besar dengan cepat dan murah.

ETL vs ELT — Apa bedanya?

ELT (Extract, Load, Transform) pada dasarnya adalah tampilan modern pada proses ETL yang sudah dikenal di mana data dikonversi setelah dimuat ke penyimpanan.

Alat ETL tradisional mengekstrak dan mengonversi data dari berbagai sumber sebelum memuatnya ke dalam penyimpanan. Dengan munculnya penyimpanan cloud, tidak perlu lagi membersihkan data pada tahap peralihan antara lokasi penyimpanan data sumber dan target.

ELT sangat relevan dengan analitik tingkat lanjut. Misalnya, Anda dapat mengunggah data mentah ke dalam data lake lalu menggabungkannya dengan data dari sumber lain atau menggunakannya untuk melatih model prediksi. Menjaga data tetap mentah memungkinkan analis untuk memperluas kemampuan mereka. Pendekatan ini cepat karena memanfaatkan kekuatan mekanisme pemrosesan data modern dan mengurangi perpindahan data yang tidak perlu.

Mana yang harus Anda pilih? ETL atau ELT? Jika Anda bekerja secara lokal dan data Anda dapat diprediksi dan hanya berasal dari beberapa sumber, maka ETL tradisional sudah cukup. Namun, ini menjadi semakin tidak relevan karena semakin banyak perusahaan beralih ke arsitektur data cloud atau hybrid.

5 tips untuk implementasi ETL yang sukses

Jika Anda ingin menerapkan proses ETL yang sukses, ikuti langkah-langkah berikut:

Langkah 1. Identifikasi dengan jelas sumber data yang ingin Anda kumpulkan dan simpan. Sumber-sumber ini dapat berupa database relasional SQL, database non-relasional NoSQL, platform perangkat lunak sebagai layanan (SaaS), atau aplikasi lain. Setelah sumber data terhubung, tentukan bidang data spesifik yang ingin Anda ekstrak. Kemudian terima atau masukkan data ini dari berbagai sumber dalam bentuk mentah.

Langkah 2. Satukan data ini menggunakan seperangkat aturan bisnis (seperti agregasi, lampiran, pengurutan, fungsi gabungan, dan sebagainya).

Langkah 3. Setelah transformasi, data harus dimuat ke penyimpanan. Pada langkah ini, Anda perlu memutuskan frekuensi pengunggahan data. Tentukan apakah Anda ingin merekam data baru atau memperbarui data yang sudah ada.

Langkah 4. Penting untuk memeriksa jumlah record sebelum dan sesudah mentransfer data ke repositori. Ini harus dilakukan untuk mengecualikan data yang tidak valid dan berlebihan.

Langkah 5. Langkah terakhir adalah mengotomatisasi proses ETL menggunakan alat khusus. Ini akan membantu Anda menghemat waktu, meningkatkan akurasi, dan mengurangi upaya yang diperlukan untuk memulai ulang proses ETL secara manual. Dengan alat otomatisasi ETL, Anda dapat merancang dan mengontrol alur kerja melalui antarmuka yang sederhana. Selain itu, alat ini memiliki kemampuan seperti pembuatan profil dan pembersihan data.

Cara memilih alat ETL

Untuk memulainya, mari kita cari tahu alat ETL apa yang ada. Saat ini ada empat tipe yang tersedia. Beberapa dirancang untuk bekerja di lingkungan lokal, beberapa bekerja di cloud, dan beberapa bekerja di kedua lingkungan. Yang mana yang harus dipilih bergantung pada lokasi data Anda dan kebutuhan bisnis Anda:

- Alat ETL untuk pemrosesan batch data di penyimpanan lokal.

- Alat Cloud ETL yang dapat mengekstrak dan memuat data dari sumber langsung ke penyimpanan cloud. Mereka kemudian dapat mengubah data menggunakan kekuatan dan skala cloud. Contoh: OWOX BI.

- Alat open source ETL seperti Apache Airflow, Apache Kafka, dan Apache NiFi adalah alternatif anggaran untuk layanan berbayar. Beberapa tidak mendukung transformasi kompleks dan mungkin memiliki masalah dukungan pelanggan.

- Alat ETL waktu nyata. Data diproses secara real time menggunakan model terdistribusi dan kemampuan streaming data.

Apa yang harus dicari saat memilih alat ETL:

- Kemudahan penggunaan dan perawatan

- Kecepatan kerja

- Tingkat keamanan

- Jumlah dan variasi konektor yang dibutuhkan

- Kemampuan untuk bekerja tanpa hambatan dengan komponen lain dari platform data Anda, termasuk penyimpanan data dan data lake

ETL/ELT dan OWOX BI

Dengan OWOX BI, Anda dapat mengumpulkan data pemasaran untuk laporan dengan kompleksitas apa pun di penyimpanan cloud Google BigQuery yang aman tanpa bantuan analis dan developer.

Apa yang Anda dapatkan dengan OWOX BI:

- Secara otomatis mengumpulkan data dari berbagai sumber

- Impor data mentah secara otomatis ke Google BigQuery

- Bersihkan, hapus duplikat, pantau kualitas, dan perbarui data

- Menyiapkan dan memodelkan data siap-bisnis

- Buat laporan tanpa bantuan analis atau pengetahuan SQL

OWOX BI membebaskan waktu berharga Anda, sehingga Anda dapat lebih memperhatikan pengoptimalan kampanye iklan dan zona pertumbuhan.

Anda tidak perlu lagi menunggu laporan dari seorang analis. Dapatkan dasbor siap pakai atau laporan individual yang didasarkan pada data simulasi dan cocok untuk bisnis Anda.

Dengan pendekatan unik OWOX BI, Anda dapat memodifikasi sumber data dan struktur data tanpa menimpa kueri SQL atau menyusun ulang laporan. Ini sangat relevan dengan rilis Google Analytics 4 yang baru.

takeaways kunci

Volume data yang dikumpulkan oleh perusahaan semakin besar setiap hari dan akan terus bertambah. Sudah cukup untuk bekerja dengan database lokal dan unduhan batch untuk saat ini, namun, segera itu tidak akan memenuhi kebutuhan bisnis. Jadi, kemungkinan untuk menskalakan proses ETL sangat berguna dan sangat relevan dengan analitik tingkat lanjut.

Keuntungan utama dari alat ETL adalah:

- menghemat waktu Anda.

- menghindari pemrosesan data manual.

- membuatnya mudah untuk bekerja dengan data yang kompleks.

- mengurangi risiko yang terkait dengan faktor manusia.

- membantu meningkatkan pengambilan keputusan.

- meningkatkan ROI.

Saat memilih alat ETL, pikirkan tentang kebutuhan khusus bisnis Anda. Jika Anda bekerja secara lokal dan data Anda dapat diprediksi dan hanya berasal dari beberapa sumber, maka ETL tradisional sudah cukup. Namun jangan lupa bahwa semakin banyak perusahaan yang beralih ke arsitektur cloud atau hybrid dan Anda harus mempertimbangkan hal ini.