Qu'est-ce que la régression linéaire ? Comment il est utilisé dans l'apprentissage automatique

Publié: 2021-07-16La régression linéaire ne fait-elle pas partie des statistiques ?

Sans aucun doute, oui.

En fait, la plupart apprentissage automatique Les algorithmes (ML) sont empruntés à divers domaines, principalement les statistiques. Tout ce qui peut aider les modèles à mieux prédire finira par faire partie du ML. Il est donc prudent de dire que la régression linéaire est à la fois un algorithme statistique et un algorithme d'apprentissage automatique.

La régression linéaire est un algorithme populaire et simple utilisé en science des données et en apprentissage automatique. C'est un enseignement supervisé algorithme et la forme de régression la plus simple utilisée pour étudier la relation mathématique entre les variables.

Qu'est-ce que la régression linéaire ?

La régression linéaire est une méthode statistique qui tente de montrer une relation entre des variables. Il examine différents points de données et trace une ligne de tendance. Un exemple simple de régression linéaire consiste à constater que le coût de réparation d'une pièce de machinerie augmente avec le temps.

Plus précisément, la régression linéaire est utilisée pour déterminer le caractère et la force de l'association entre une variable dépendante et une série d'autres variables indépendantes. Il aide à créer des modèles pour faire des prédictions, telles que la prévision du cours de l'action d'une entreprise.

Avant d'essayer d'adapter un modèle linéaire à l'ensemble de données observé, il convient d'évaluer s'il existe ou non une relation entre les variables. Bien sûr, cela ne signifie pas qu'une variable cause l'autre, mais il devrait y avoir une corrélation visible entre elles.

Par exemple, des notes universitaires plus élevées ne signifient pas nécessairement un package salarial plus élevé. Mais il peut y avoir une association entre les deux variables.

Le saviez-vous? Le terme "linéaire" signifie ressemblant à une ligne ou se rapportant à des lignes.

La création d'un nuage de points est idéale pour déterminer la force de la relation entre les variables explicatives (indépendantes) et dépendantes . Si le nuage de points ne montre aucune tendance à la hausse ou à la baisse, l'application d'un modèle de régression linéaire aux valeurs observées peut ne pas être bénéfique.

Les coefficients de corrélation sont utilisés pour calculer la force d'une relation entre deux variables. Il est généralement désigné par r et a une valeur comprise entre -1 et 1. Une valeur de coefficient de corrélation positive indique une relation positive entre les variables. De même, une valeur négative indique une relation négative entre les variables.

Conseil : Effectuez une analyse de régression uniquement si le coefficient de corrélation est positif ou négatif de 0,50 ou au-delà.

Si vous examiniez la relation entre le temps d'étude et les notes, vous verriez probablement une relation positive. D'un autre côté, si vous regardez la relation entre le temps passé sur les réseaux sociaux et les notes, vous verrez très probablement une relation négative.

Ici, les "notes" sont la variable dépendante, et le temps passé à étudier ou sur les réseaux sociaux est la variable indépendante. En effet, les notes dépendent du temps passé à étudier.

Si vous pouvez établir (au moins) une corrélation modérée entre les variables à la fois par un nuage de points et un coefficient de corrélation, alors lesdites variables ont une certaine forme de relation linéaire.

En bref, la régression linéaire tente de modéliser la relation entre deux variables en appliquant une équation linéaire aux données observées. Une droite de régression linéaire peut être représentée à l'aide de l'équation d'une droite :

y = mx + b

Dans cette simple équation de régression linéaire :

- y est la variable dépendante estimée (ou la sortie)

- m est le coefficient de régression (ou la pente)

- x est la variable indépendante (ou l'entrée)

- b est la constante (ou l'ordonnée à l'origine)

Trouver la relation entre les variables permet de prédire des valeurs ou des résultats. En d'autres termes, la régression linéaire permet de prédire de nouvelles valeurs à partir de données existantes.

Un exemple serait de prédire les rendements des cultures en fonction des précipitations reçues. Dans ce cas, les précipitations sont la variable indépendante et le rendement des cultures (les valeurs prédites) est la variable dépendante.

Les variables indépendantes sont également appelées variables prédictives . De même, les variables dépendantes sont également appelées variables de réponse .

Terminologies clés de la régression linéaire

Comprendre l'analyse de régression linéaire signifierait également se familiariser avec un tas de nouveaux termes. Si vous venez d'entrer dans le monde des statistiques ou de l'apprentissage automatique, il serait utile de bien comprendre ces terminologies.

- Variable : C'est n'importe quel nombre, quantité ou caractéristique qui peut être compté ou mesuré. C'est aussi appelé un élément de données. Le revenu, l'âge, la vitesse et le sexe en sont des exemples.

- Coefficient : C'est un nombre (généralement un nombre entier) multiplié par la variable à côté. Par exemple, dans 7x, le nombre 7 est le coefficient.

- Valeurs aberrantes : ce sont des points de données significativement différents des autres.

- Covariance : direction de la relation linéaire entre deux variables. En d'autres termes, il calcule le degré auquel deux variables sont liées linéairement.

- Multivarié : Cela signifie impliquer deux variables dépendantes ou plus résultant en un seul résultat.

- Résidus : la différence entre les valeurs observées et prédites de la variable dépendante.

- Variabilité : Le manque de cohérence ou la mesure dans laquelle une distribution est comprimée ou étirée.

- Linéarité : propriété d'une relation mathématique étroitement liée à la proportionnalité et pouvant être représentée graphiquement par une ligne droite.

- Fonction linéaire : C'est une fonction dont le graphique est une droite.

- Colinéarité : Corrélation entre les variables indépendantes, de sorte qu'elles présentent une relation linéaire dans un modèle de régression.

- Écart-type (SD) : C'est une mesure de la dispersion d'un ensemble de données par rapport à sa moyenne. En d'autres termes, c'est une mesure de la répartition des nombres.

- Erreur standard (SE) : Le SD approximatif d'un échantillon statistique de population. Il est utilisé pour mesurer la variabilité.

Types de régression linéaire

Il existe deux types de régression linéaire : la régression linéaire simple et la régression linéaire multiple .

La méthode de régression linéaire simple tente de trouver la relation entre une seule variable indépendante et une variable dépendante correspondante. La variable indépendante est l'entrée et la variable dépendante correspondante est la sortie.

Conseil : Vous pouvez implémenter la régression linéaire dans divers langages et environnements de programmation, notamment Python, R, MATLAB et Excel.

La méthode de régression linéaire multiple tente de trouver la relation entre deux ou plusieurs variables indépendantes et la variable dépendante correspondante. Il existe également un cas particulier de régression linéaire multiple appelé régression polynomiale.

En termes simples, un modèle de régression linéaire simple n'a qu'une seule variable indépendante, alors qu'un modèle de régression linéaire multiple aura deux variables indépendantes ou plus. Et oui, il existe d'autres méthodes de régression non linéaire utilisées pour l'analyse de données très compliquée.

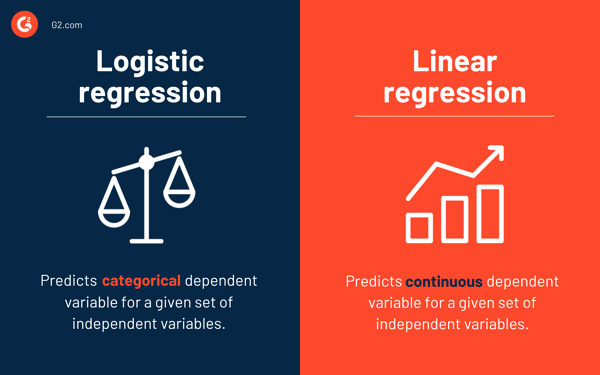

Régression logistique vs régression linéaire

Alors que la régression linéaire prédit la variable dépendante continue pour un ensemble donné de variables indépendantes, la régression logistique prédit la variable dépendante catégorielle.

Les deux sont des méthodes d'apprentissage supervisé. Mais alors que la régression linéaire est utilisée pour résoudre les problèmes de régression, la régression logistique est utilisée pour résoudre les problèmes de classification.

Bien sûr, la régression logistique peut résoudre les problèmes de régression, mais elle est principalement utilisée pour les problèmes de classification. Sa sortie ne peut être que 0 ou 1. Il est utile dans les situations où vous devez déterminer les probabilités entre deux classes ou, en d'autres termes, calculer la probabilité d'un événement. Par exemple, la régression logistique peut être utilisée pour prédire s'il va pleuvoir aujourd'hui.

Hypothèses de régression linéaire

Tout en utilisant la régression linéaire pour modéliser la relation entre les variables, nous faisons quelques hypothèses. Les hypothèses sont des conditions nécessaires qui doivent être remplies avant d'utiliser un modèle pour faire des prédictions.

Il existe généralement quatre hypothèses associées aux modèles de régression linéaire :

- Relation linéaire : il existe une relation linéaire entre la variable indépendante x et la variable dépendante y .

- Indépendance : Les résidus sont indépendants. Il n'y a pas de corrélation entre les résidus consécutifs dans les données de séries chronologiques.

- Homoscédasticité : les résidus ont une variance égale à tous les niveaux.

- Normalité : Les résidus sont normalement distribués.

Méthodes pour résoudre des modèles de régression linéaire

Dans le jargon de l'apprentissage automatique ou des statistiques, apprendre un modèle de régression linéaire signifie deviner les valeurs des coefficients à l'aide des données disponibles. Plusieurs méthodes peuvent être appliquées à un modèle de régression linéaire pour le rendre plus efficace.

Conseil : Utilisez un logiciel d'apprentissage automatique pour éliminer les tâches monotones et faire des prédictions précises.

Examinons les différentes techniques utilisées pour résoudre les modèles de régression linéaire afin de comprendre leurs différences et leurs compromis.

Régression linéaire simple

Comme mentionné précédemment, il existe une seule entrée ou une variable indépendante et une variable dépendante dans la régression linéaire simple . Il est utilisé pour trouver la meilleure relation entre deux variables, étant donné qu'elles sont de nature continue. Par exemple, il peut être utilisé pour prédire la quantité de poids prise en fonction des calories consommées.

Moindres carrés ordinaires

La régression des moindres carrés ordinaires est une autre méthode pour estimer la valeur des coefficients lorsqu'il y a plus d'une variable ou entrée indépendante. C'est l'une des approches les plus courantes pour résoudre la régression linéaire et est également connue sous le nom d' équation normale .

Cette procédure tente de minimiser la somme des carrés des résidus. Il traite les données comme une matrice et utilise des opérations d'algèbre linéaire pour déterminer les valeurs optimales pour chaque coefficient. Bien entendu, cette méthode ne peut être appliquée que si nous avons accès à toutes les données, et il doit également y avoir suffisamment de mémoire pour contenir les données.

Descente graduelle

La descente de gradient est l'une des méthodes les plus simples et les plus couramment utilisées pour résoudre les problèmes de régression linéaire. Il est utile lorsqu'il existe une ou plusieurs entrées et implique d'optimiser la valeur des coefficients en minimisant l'erreur du modèle de manière itérative.

La descente de gradient commence avec des valeurs aléatoires pour chaque coefficient. Pour chaque paire de valeurs d'entrée et de sortie, la somme des carrés des erreurs est calculée. Il utilise un facteur d'échelle comme taux d'apprentissage, et chaque coefficient est mis à jour dans le sens pour minimiser l'erreur.

Le processus est répété jusqu'à ce qu'aucune autre amélioration ne soit possible ou qu'une somme minimale de carrés soit atteinte. La descente en dégradé est utile lorsqu'il existe un grand ensemble de données impliquant un grand nombre de lignes et de colonnes qui ne tiennent pas dans la mémoire.

Régularisation

La régularisation est une méthode qui tente de minimiser la somme des carrés des erreurs d'un modèle et, en même temps, de réduire la complexité du modèle. Il réduit la somme des erreurs quadratiques en utilisant la méthode des moindres carrés ordinaires.

La régression au lasso et la régression en crête sont les deux exemples célèbres de régularisation en régression linéaire. Ces méthodes sont utiles lorsqu'il y a colinéarité dans les variables indépendantes.

La méthode d'Adam

L'estimation adaptative du moment , ou ADAM , est un algorithme d'optimisation utilisé dans l'apprentissage en profondeur. C'est un algorithme itératif qui fonctionne bien sur les données bruitées. Il est simple à mettre en œuvre, efficace en termes de calcul et nécessite un minimum de mémoire.

ADAM combine deux algorithmes de descente de gradient - la propagation quadratique moyenne (RMSprop) et la descente de gradient adaptative . Au lieu d'utiliser l'intégralité de l'ensemble de données pour calculer le gradient, ADAM utilise des sous-ensembles sélectionnés au hasard pour effectuer une approximation stochastique.

ADAM convient aux problèmes impliquant un grand nombre de paramètres ou de données. De plus, dans cette méthode d'optimisation, les hyperparamètres nécessitent généralement un réglage minimal et ont une interprétation intuitive.

Décomposition en valeurs singulières

La décomposition en valeurs singulières , ou SVD , est une technique de réduction de dimensionnalité couramment utilisée dans la régression linéaire. C'est une étape de prétraitement qui réduit le nombre de dimensions pour l'algorithme d'apprentissage.

La SVD consiste à décomposer une matrice en produit de trois autres matrices. Il convient aux données de grande dimension et est efficace et stable pour les petits ensembles de données. En raison de sa stabilité, c'est l'une des approches les plus préférées pour résoudre des équations linéaires pour la régression linéaire. Cependant, il est sensible aux valeurs aberrantes et peut devenir instable avec un énorme ensemble de données.

Préparation des données pour la régression linéaire

Les données du monde réel, dans la plupart des cas, sont incomplètes.

Comme tout autre modèle d'apprentissage automatique, la préparation et le prétraitement des données sont un processus crucial dans la régression linéaire. Il y aura des valeurs manquantes, des erreurs, des valeurs aberrantes, des incohérences et un manque de valeurs d'attribut.

Voici quelques façons de tenir compte des données incomplètes et de créer un modèle de prédiction plus fiable.

- La régression linéaire considère que les variables de prédicteur et de réponse ne sont pas bruyantes. Pour cette raison, la suppression du bruit avec plusieurs opérations d'effacement des données est cruciale. Si possible, vous devez supprimer les valeurs aberrantes dans la variable de sortie.

- Si les variables d'entrée et de sortie ont une distribution gaussienne , la régression linéaire fera de meilleures prédictions.

- Si vous remettez à l'échelle les variables d'entrée à l' aide de la normalisation ou de la standardisation, la régression linéaire fera généralement de meilleures prédictions.

- S'il existe de nombreux attributs, vous devez transformer les données pour avoir une relation linéaire .

- Si les variables d'entrée sont fortement corrélées, la régression linéaire surajustera les données. Dans ce cas, supprimez la colinéarité .

Avantages et inconvénients de la régression linéaire

La régression linéaire est l'un des algorithmes les plus simples à comprendre et les plus simples à mettre en œuvre. C'est un excellent outil pour analyser les relations entre les variables.

Voici quelques avantages notables de la régression linéaire :

- C'est un algorithme incontournable en raison de sa simplicité.

- Bien qu'il soit susceptible de sur-ajustement, il peut être évité à l'aide de techniques de réduction de la dimensionnalité.

- Il a une bonne interprétabilité.

- Il fonctionne bien sur des ensembles de données séparables linéairement.

- Sa complexité spatiale est faible ; c'est donc un algorithme à latence élevée.

Cependant, la régression linéaire n'est généralement pas recommandée pour la majorité des applications pratiques. C'est parce qu'il simplifie à l'extrême les problèmes du monde réel en supposant une relation linéaire entre les variables.

Voici quelques inconvénients de la régression linéaire :

- Les valeurs aberrantes peuvent avoir des effets négatifs sur la régression

- Puisqu'il devrait y avoir une relation linéaire entre les variables pour ajuster un modèle linéaire, il suppose qu'il existe une relation linéaire entre les variables

- Il perçoit que les données sont normalement distribuées

- Il examine également la relation entre la moyenne des variables indépendantes et dépendantes

- La régression linéaire n'est pas une description complète des relations entre les variables

- La présence d'une forte corrélation entre les variables peut affecter de manière significative les performances d'un modèle linéaire

D'abord observer, puis prédire

Dans la régression linéaire, il est crucial d'évaluer si les variables ont une relation linéaire. Bien que certaines personnes essaient de prédire sans regarder la tendance, il est préférable de s'assurer qu'il existe une corrélation modérément forte entre les variables.

Comme mentionné précédemment, l'examen du nuage de points et du coefficient de corrélation sont d'excellentes méthodes. Et oui, même si la corrélation est élevée, il est toujours préférable de regarder le nuage de points. En bref, si les données sont visuellement linéaires, alors l'analyse de régression linéaire est faisable.

Alors que la régression linéaire vous permet de prédire la valeur d'une variable dépendante, il existe un algorithme qui classe les nouveaux points de données ou prédit leurs valeurs en regardant leurs voisins. C'est ce qu'on appelle l'algorithme des k plus proches voisins, et c'est un apprenant paresseux.