¿Qué es la regresión lineal? Cómo se usa en el aprendizaje automático

Publicado: 2021-07-16¿No es la regresión lineal parte de las estadísticas?

Sin duda, sí.

De hecho, la mayoría aprendizaje automático Los algoritmos (ML) se toman prestados de varios campos, principalmente de las estadísticas. Cualquier cosa que pueda ayudar a los modelos a predecir mejor eventualmente se convertirá en parte de ML. Por lo tanto, es seguro decir que la regresión lineal es tanto un algoritmo estadístico como de aprendizaje automático.

La regresión lineal es un algoritmo popular y sin complicaciones que se utiliza en la ciencia de datos y el aprendizaje automático. Es un aprendizaje supervisado algoritmo y la forma más simple de regresión utilizada para estudiar la relación matemática entre variables.

¿Qué es la regresión lineal?

La regresión lineal es un método estadístico que trata de mostrar una relación entre variables. Examina diferentes puntos de datos y traza una línea de tendencia. Un ejemplo simple de regresión lineal es encontrar que el costo de reparar una pieza de maquinaria aumenta con el tiempo.

Más precisamente, la regresión lineal se usa para determinar el carácter y la fuerza de la asociación entre una variable dependiente y una serie de otras variables independientes. Ayuda a crear modelos para hacer predicciones, como predecir el precio de las acciones de una empresa.

Antes de intentar ajustar un modelo lineal al conjunto de datos observado, se debe evaluar si existe o no una relación entre las variables. Por supuesto, esto no significa que una variable cause la otra, pero debería haber alguna correlación visible entre ellas.

Por ejemplo, las calificaciones universitarias más altas no significan necesariamente un paquete salarial más alto. Pero puede haber una asociación entre las dos variables.

¿Sabías? El término “lineal” significa parecido a una línea o perteneciente a líneas.

La creación de un diagrama de dispersión es ideal para determinar la fuerza de la relación entre las variables explicativas (independientes) y dependientes . Si el gráfico de dispersión no muestra tendencias crecientes o decrecientes, es posible que no resulte beneficioso aplicar un modelo de regresión lineal a los valores observados.

Los coeficientes de correlación se utilizan para calcular qué tan fuerte es una relación entre dos variables. Por lo general, se denota por r y tiene un valor entre -1 y 1. Un valor de coeficiente de correlación positivo indica una relación positiva entre las variables. Asimismo, un valor negativo indica una relación negativa entre las variables.

Sugerencia: Realice un análisis de regresión solo si el coeficiente de correlación es positivo o negativo de 0,50 o superior.

Si observara la relación entre el tiempo de estudio y las calificaciones, probablemente vería una relación positiva. Por otro lado, si observa la relación entre el tiempo en las redes sociales y las calificaciones, lo más probable es que vea una relación negativa.

Aquí, las "notas" son la variable dependiente, y el tiempo dedicado a estudiar o en las redes sociales es la variable independiente. Esto se debe a que las calificaciones dependen de cuánto tiempo pasas estudiando.

Si puede establecer (al menos) una correlación moderada entre las variables a través de un diagrama de dispersión y un coeficiente de correlación, entonces dichas variables tienen algún tipo de relación lineal.

En resumen, la regresión lineal intenta modelar la relación entre dos variables aplicando una ecuación lineal a los datos observados. Una línea de regresión lineal se puede representar usando la ecuación de una línea recta:

y = mx + b

En esta ecuación de regresión lineal simple:

- y es la variable dependiente estimada (o la salida)

- m es el coeficiente de regresión (o la pendiente)

- x es la variable independiente (o la entrada)

- b es la constante (o el intercepto en y)

Encontrar la relación entre variables hace posible predecir valores o resultados. En otras palabras, la regresión lineal permite predecir nuevos valores en función de los datos existentes.

Un ejemplo sería predecir el rendimiento de los cultivos en función de la lluvia recibida. En este caso, la lluvia es la variable independiente y el rendimiento del cultivo (los valores pronosticados) es la variable dependiente.

Las variables independientes también se conocen como variables predictoras . Asimismo, las variables dependientes también se conocen como variables de respuesta .

Terminologías clave en regresión lineal

Comprender el análisis de regresión lineal también significaría familiarizarse con un montón de términos nuevos. Si acaba de ingresar al mundo de las estadísticas o el aprendizaje automático, sería útil tener una comprensión justa de estas terminologías.

- Variable: Es cualquier número, cantidad o característica que se puede contar o medir. También se denomina elemento de datos. Los ingresos, la edad, la velocidad y el género son ejemplos.

- Coeficiente: Es un número (normalmente un número entero) multiplicado por la variable que tiene al lado. Por ejemplo, en 7x, el número 7 es el coeficiente.

- Valores atípicos: estos son puntos de datos significativamente diferentes del resto.

- Covarianza: La dirección de la relación lineal entre dos variables. En otras palabras, calcula el grado en que dos variables están linealmente relacionadas.

- Multivariado: Significa involucrar dos o más variables dependientes que dan como resultado un solo resultado.

- Residuales: La diferencia entre los valores observados y pronosticados de la variable dependiente.

- Variabilidad: La falta de consistencia o la medida en que una distribución se comprime o estira.

- Linealidad: La propiedad de una relación matemática que está estrechamente relacionada con la proporcionalidad y puede representarse gráficamente como una línea recta.

- Función lineal: Es una función cuya gráfica es una línea recta.

- Colinealidad: Correlación entre las variables independientes, de manera que exhiben una relación lineal en un modelo de regresión.

- Desviación estándar (DE): es una medida de la dispersión de un conjunto de datos en relación con su media. En otras palabras, es una medida de cuán dispersos están los números.

- Error estándar (SE): la desviación estándar aproximada de una población de muestra estadística. Se utiliza para medir la variabilidad.

Tipos de regresión lineal

Hay dos tipos de regresión lineal: regresión lineal simple y regresión lineal múltiple .

El método de regresión lineal simple trata de encontrar la relación entre una sola variable independiente y una variable dependiente correspondiente. La variable independiente es la entrada y la variable dependiente correspondiente es la salida.

Sugerencia: puede implementar la regresión lineal en varios lenguajes y entornos de programación, incluidos Python, R, MATLAB y Excel.

El método de regresión lineal múltiple trata de encontrar la relación entre dos o más variables independientes y la variable dependiente correspondiente. También hay un caso especial de regresión lineal múltiple llamado regresión polinomial.

En pocas palabras, un modelo de regresión lineal simple tiene solo una variable independiente, mientras que un modelo de regresión lineal múltiple tendrá dos o más variables independientes. Y sí, existen otros métodos de regresión no lineal que se utilizan para análisis de datos muy complicados.

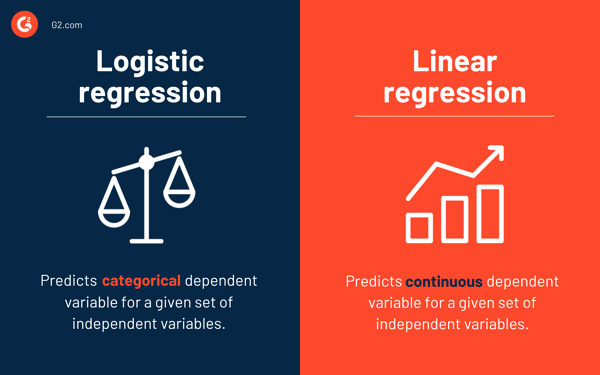

Regresión logística frente a regresión lineal

Mientras que la regresión lineal predice la variable dependiente continua para un conjunto dado de variables independientes, la regresión logística predice la variable dependiente categórica.

Ambos son métodos de aprendizaje supervisado. Pero mientras que la regresión lineal se usa para resolver problemas de regresión, la regresión logística se usa para resolver problemas de clasificación.

Por supuesto, la regresión logística puede resolver problemas de regresión, pero se usa principalmente para problemas de clasificación. Su salida solo puede ser 0 o 1. Es valioso en situaciones en las que necesita determinar las probabilidades entre dos clases o, en otras palabras, calcular la probabilidad de un evento. Por ejemplo, la regresión logística se puede usar para predecir si lloverá hoy.

Supuestos de regresión lineal

Al usar la regresión lineal para modelar la relación entre variables, hacemos algunas suposiciones. Las suposiciones son condiciones necesarias que deben cumplirse antes de usar un modelo para hacer predicciones.

En general, hay cuatro supuestos asociados con los modelos de regresión lineal:

- Relación lineal: existe una relación lineal entre la variable independiente x y la variable dependiente y .

- Independencia: Los residuos son independientes. No hay correlación entre residuos consecutivos en datos de series de tiempo.

- Homocedasticidad: Los residuos tienen igual varianza en todos los niveles.

- Normalidad: Los residuos se distribuyen normalmente.

Métodos para resolver modelos de regresión lineal

En la jerga de aprendizaje automático o estadística, aprender un modelo de regresión lineal significa adivinar los valores de los coeficientes utilizando los datos disponibles. Se pueden aplicar varios métodos a un modelo de regresión lineal para hacerlo más eficiente.

Consejo: use software de aprendizaje automático para eliminar tareas monótonas y hacer predicciones precisas.

Veamos las diferentes técnicas utilizadas para resolver modelos de regresión lineal para comprender sus diferencias y compensaciones.

Regresión lineal simple

Como se mencionó anteriormente, hay una sola entrada o una variable independiente y una variable dependiente en la regresión lineal simple . Se utiliza para encontrar la mejor relación entre dos variables, dado que son de naturaleza continua. Por ejemplo, se puede utilizar para predecir la cantidad de peso ganado en función de las calorías consumidas.

Mínimos cuadrados ordinarios

La regresión de mínimos cuadrados ordinarios es otro método para estimar el valor de los coeficientes cuando hay más de una variable o entrada independiente. Es uno de los enfoques más comunes para resolver la regresión lineal y también se conoce como ecuación normal .

Este procedimiento trata de minimizar la suma de los cuadrados de los residuos. Trata los datos como una matriz y utiliza operaciones de álgebra lineal para determinar los valores óptimos para cada coeficiente. Por supuesto, este método solo se puede aplicar si tenemos acceso a todos los datos, y también debe haber suficiente memoria para que quepan los datos.

Descenso de gradiente

El descenso de gradiente es uno de los métodos más fáciles y comúnmente utilizados para resolver problemas de regresión lineal. Es útil cuando hay una o más entradas e implica optimizar el valor de los coeficientes minimizando el error del modelo de forma iterativa.

El descenso de gradiente comienza con valores aleatorios para cada coeficiente. Para cada par de valores de entrada y salida, se calcula la suma de los errores al cuadrado. Utiliza un factor de escala como tasa de aprendizaje y cada coeficiente se actualiza en la dirección para minimizar el error.

El proceso se repite hasta que no sea posible realizar más mejoras o se logre una suma mínima de cuadrados. El descenso de gradiente es útil cuando hay un gran conjunto de datos que involucra una gran cantidad de filas y columnas que no caben en la memoria.

regularización

La regularización es un método que intenta minimizar la suma de los errores cuadráticos de un modelo y, al mismo tiempo, reducir la complejidad del modelo. Reduce la suma de errores al cuadrado utilizando el método de mínimos cuadrados ordinarios.

La regresión de lazo y la regresión de cresta son los dos ejemplos famosos de regularización en regresión lineal. Estos métodos son valiosos cuando hay colinealidad en las variables independientes.

método de Adán

La estimación del momento adaptativo , o ADAM , es un algoritmo de optimización utilizado en aprendizaje profundo. Es un algoritmo iterativo que funciona bien con datos ruidosos. Es sencillo de implementar, computacionalmente eficiente y tiene requisitos mínimos de memoria.

ADAM combina dos algoritmos de descenso de gradiente: propagación cuadrática media (RMSprop) y descenso de gradiente adaptativo . En lugar de usar todo el conjunto de datos para calcular el gradiente, ADAM usa subconjuntos seleccionados al azar para hacer una aproximación estocástica.

ADAM es adecuado para problemas que involucran una gran cantidad de parámetros o datos. Además, en este método de optimización, los hiperparámetros generalmente requieren un ajuste mínimo y tienen una interpretación intuitiva.

Valor singular de descomposición

La descomposición de valores singulares , o SVD , es una técnica de reducción de dimensionalidad de uso común en la regresión lineal. Es un paso de preprocesamiento que reduce el número de dimensiones para el algoritmo de aprendizaje.

SVD implica descomponer una matriz como producto de otras tres matrices. Es adecuado para datos de alta dimensión y eficiente y estable para pequeños conjuntos de datos. Debido a su estabilidad, es uno de los enfoques preferidos para resolver ecuaciones lineales para regresión lineal. Sin embargo, es susceptible a valores atípicos y puede volverse inestable con un gran conjunto de datos.

Preparación de datos para regresión lineal

Los datos del mundo real, en la mayoría de los casos, están incompletos.

Como cualquier otro modelo de aprendizaje automático, la preparación y el preprocesamiento de datos es un proceso crucial en la regresión lineal. Habrá valores faltantes, errores, valores atípicos, inconsistencias y falta de valores de atributos.

Aquí hay algunas formas de dar cuenta de los datos incompletos y crear un modelo de predicción más confiable.

- La regresión lineal piensa que las variables predictoras y de respuesta no son ruidosas. Debido a esto, es crucial eliminar el ruido con varias operaciones de borrado de datos. Si es posible, debe eliminar los valores atípicos en la variable de salida.

- Si las variables de entrada y salida tienen una distribución gaussiana , la regresión lineal hará mejores predicciones.

- Si cambia la escala de las variables de entrada mediante la normalización o la estandarización, la regresión lineal generalmente hará mejores predicciones.

- Si hay muchos atributos, necesita transformar los datos para tener una relación lineal .

- Si las variables de entrada están altamente correlacionadas, la regresión lineal sobreajustará los datos. En tales casos, elimine la colinealidad .

Ventajas y desventajas de la regresión lineal

La regresión lineal es uno de los algoritmos más sencillos de comprender y más simples de implementar. Es una gran herramienta para analizar relaciones entre variables.

Aquí hay algunas ventajas notables de la regresión lineal:

- Es un algoritmo de referencia debido a su simplicidad.

- Aunque es susceptible de sobreajuste, se puede evitar con la ayuda de técnicas de reducción de dimensionalidad.

- Tiene buena interpretabilidad.

- Funciona bien en conjuntos de datos linealmente separables.

- Su complejidad espacial es baja; por lo tanto, es un algoritmo de alta latencia.

Sin embargo, la regresión lineal generalmente no se recomienda para la mayoría de las aplicaciones prácticas. Es porque simplifica demasiado los problemas del mundo real al asumir una relación lineal entre las variables.

Aquí hay algunas desventajas de la regresión lineal:

- Los valores atípicos pueden tener efectos negativos en la regresión

- Dado que debe haber una relación lineal entre las variables para ajustar un modelo lineal, se supone que hay una relación lineal entre las variables

- Percibe que los datos se distribuyen normalmente.

- También analiza la relación entre la media de las variables independientes y dependientes.

- La regresión lineal no es una descripción completa de las relaciones entre variables

- La presencia de una alta correlación entre variables puede afectar significativamente el desempeño de un modelo lineal

Primero observa, luego predice

En la regresión lineal, es crucial evaluar si las variables tienen una relación lineal. Aunque algunas personas intentan predecir sin mirar la tendencia, es mejor asegurarse de que haya una correlación moderadamente fuerte entre las variables.

Como se mencionó anteriormente, observar el diagrama de dispersión y el coeficiente de correlación son métodos excelentes. Y sí, incluso si la correlación es alta, es mejor mirar el diagrama de dispersión. En resumen, si los datos son visualmente lineales, entonces el análisis de regresión lineal es factible.

Si bien la regresión lineal le permite predecir el valor de una variable dependiente, hay un algoritmo que clasifica nuevos puntos de datos o predice sus valores observando a sus vecinos. Se llama el algoritmo de k-vecinos más cercanos, y es un aprendiz perezoso.