Co to jest regresja liniowa? Jak to jest wykorzystywane w uczeniu maszynowym

Opublikowany: 2021-07-16Czy regresja liniowa nie jest częścią statystyki?

Niewątpliwie tak.

W rzeczywistości większość nauczanie maszynowe Algorytmy (ML) są zapożyczone z różnych dziedzin, głównie statystyki. Wszystko, co może pomóc modelom w lepszym przewidywaniu, ostatecznie stanie się częścią ML. Można więc śmiało powiedzieć, że regresja liniowa jest zarówno algorytmem statystycznym, jak i algorytmem uczenia maszynowego.

Regresja liniowa to popularny i nieskomplikowany algorytm wykorzystywany w nauce o danych i uczeniu maszynowym. To jest Nadzorowana nauka algorytm i najprostsza forma regresji służąca do badania matematycznej zależności między zmiennymi.

Czym jest regresja liniowa?

Regresja liniowa to metoda statystyczna, która próbuje pokazać związek między zmiennymi. Analizuje różne punkty danych i wykreśla linię trendu. Prostym przykładem regresji liniowej jest stwierdzenie, że koszt naprawy elementu maszyny rośnie z czasem.

Dokładniej, regresja liniowa służy do określenia charakteru i siły związku między zmienną zależną a szeregiem innych zmiennych niezależnych. Pomaga tworzyć modele do prognozowania, na przykład przewidywania ceny akcji firmy.

Przed próbą dopasowania modelu liniowego do obserwowanego zbioru danych należy ocenić, czy istnieje związek między zmiennymi. Oczywiście nie oznacza to, że jedna zmienna powoduje drugą, ale powinna istnieć między nimi widoczna korelacja.

Na przykład wyższe stopnie z college'u niekoniecznie oznaczają wyższy pakiet wynagrodzeń. Ale może istnieć związek między tymi dwiema zmiennymi.

Czy wiedziałeś? Termin „liniowy” oznacza przypominający linię lub odnoszący się do linii.

Tworzenie wykresu punktowego jest idealne do określenia siły związku między zmiennymi objaśniającymi (niezależnymi) i zależnymi . Jeśli wykres punktowy nie pokazuje żadnych trendów rosnących ani malejących, zastosowanie modelu regresji liniowej do obserwowanych wartości może nie być korzystne.

Współczynniki korelacji służą do obliczania, jak silny jest związek między dwiema zmiennymi. Jest zwykle oznaczany przez r i ma wartość od -1 do 1. Dodatnia wartość współczynnika korelacji wskazuje na dodatni związek między zmiennymi. Podobnie wartość ujemna wskazuje na ujemną relację między zmiennymi.

Wskazówka: Przeprowadź analizę regresji tylko wtedy, gdy współczynnik korelacji jest dodatni lub ujemny 0,50 lub wyższy.

Gdybyś spojrzał na związek między czasem nauki a ocenami, prawdopodobnie zauważyłbyś pozytywną zależność. Z drugiej strony, jeśli spojrzysz na związek między czasem spędzonym w mediach społecznościowych a ocenami, najprawdopodobniej zobaczysz związek negatywny.

Tutaj „oceny” są zmienną zależną, a czas spędzony na nauce lub w mediach społecznościowych jest zmienną niezależną. Dzieje się tak, ponieważ oceny zależą od tego, ile czasu poświęcasz na naukę.

Jeśli można ustalić (przynajmniej) umiarkowaną korelację między zmiennymi zarówno za pomocą wykresu punktowego, jak i współczynnika korelacji, to wspomniane zmienne mają pewną formę zależności liniowej.

Krótko mówiąc, regresja liniowa próbuje modelować związek między dwiema zmiennymi, stosując równanie liniowe do obserwowanych danych. Linię regresji liniowej można przedstawić za pomocą równania linii prostej:

y = mx + b

W tym prostym równaniu regresji liniowej:

- y jest szacowaną zmienną zależną (lub wyjściem)

- m jest współczynnikiem regresji (lub nachyleniem)

- x jest zmienną niezależną (lub wejściową)

- b jest stałą (lub punktem przecięcia z osią y)

Znalezienie związku między zmiennymi umożliwia przewidywanie wartości lub wyników. Innymi słowy, regresja liniowa umożliwia przewidywanie nowych wartości na podstawie istniejących danych.

Przykładem może być prognozowanie plonów na podstawie otrzymanych opadów. W tym przypadku opady są zmienną niezależną, a plon (wartości przewidywane) jest zmienną zależną.

Zmienne niezależne są również nazywane zmiennymi predykcyjnymi . Podobnie zmienne zależne są również nazywane zmiennymi odpowiedzi .

Kluczowe terminy w regresji liniowej

Zrozumienie analizy regresji liniowej oznaczałoby również zapoznanie się z kilkoma nowymi terminami. Jeśli właśnie wkroczyłeś w świat statystyki lub uczenia maszynowego, dobre zrozumienie tych terminologii byłoby pomocne.

- Zmienna: jest to dowolna liczba, ilość lub cecha, którą można policzyć lub zmierzyć. Jest również nazywany elementem danych. Przykładami są dochód, wiek, szybkość i płeć.

- Współczynnik: Jest to liczba (zwykle liczba całkowita) pomnożona przez znajdującą się obok zmienną. Na przykład w 7x liczba 7 to współczynnik.

- Odstające: są to punkty danych znacznie różniące się od pozostałych.

- Kowariancja: Kierunek zależności liniowej między dwiema zmiennymi. Innymi słowy, oblicza stopień, w jakim dwie zmienne są liniowo powiązane.

- Wielowymiarowy: oznacza angażowanie co najmniej dwóch zmiennych zależnych, co skutkuje jednym wynikiem.

- Reszty: Różnica między obserwowanymi a przewidywanymi wartościami zmiennej zależnej.

- Zmienność: brak spójności lub stopnia, w jakim rozkład jest ściśnięty lub rozciągnięty.

- Liniowość: właściwość zależności matematycznej, która jest ściśle związana z proporcjonalnością i może być przedstawiona graficznie jako linia prosta.

- Funkcja liniowa: Jest to funkcja, której wykres jest linią prostą.

- Kolinearność: Korelacja między zmiennymi niezależnymi, taka, że wykazują one zależność liniową w modelu regresji.

- Odchylenie standardowe (SD): Jest to miara rozproszenia zbioru danych w stosunku do jego średniej. Innymi słowy, jest to miara rozłożenia liczb.

- Błąd standardowy (SE): przybliżone SD statystycznej populacji próby. Służy do pomiaru zmienności.

Rodzaje regresji liniowej

Istnieją dwa rodzaje regresji liniowej: prosta regresja liniowa i wielokrotna regresja liniowa .

Metoda prostej regresji liniowej próbuje znaleźć związek między pojedynczą zmienną niezależną a odpowiadającą jej zmienną zależną. Zmienna niezależna jest wejściem, a odpowiadająca mu zmienna zależna jest wyjściem.

Wskazówka: Regresję liniową można zaimplementować w różnych językach programowania i środowiskach, w tym Python, R, MATLAB i Excel.

Metoda wielokrotnej regresji liniowej próbuje znaleźć związek między dwiema lub większą liczbą zmiennych niezależnych a odpowiadającą im zmienną zależną. Istnieje również specjalny przypadek wielokrotnej regresji liniowej zwany regresja wielomianowa.

Mówiąc najprościej, prosty model regresji liniowej ma tylko jedną zmienną niezależną, podczas gdy model wielokrotnej regresji liniowej będzie miał dwie lub więcej zmiennych niezależnych. I tak, istnieją inne nieliniowe metody regresji używane do bardzo skomplikowanej analizy danych.

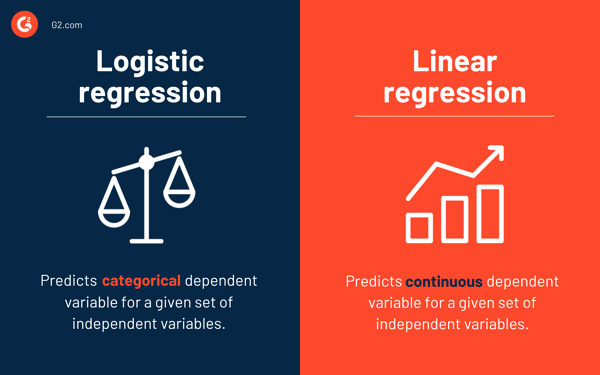

Regresja logistyczna a regresja liniowa

Podczas gdy regresja liniowa przewiduje ciągłą zmienną zależną dla danego zestawu zmiennych niezależnych, regresja logistyczna przewiduje kategoryczną zmienną zależną.

Obie są nadzorowanymi metodami uczenia się. Ale podczas gdy regresja liniowa jest używana do rozwiązywania problemów regresji, regresja logistyczna jest używana do rozwiązywania problemów klasyfikacji.

Oczywiście regresja logistyczna może rozwiązywać problemy regresji, ale jest używana głównie do problemów z klasyfikacją. Jego wynik może wynosić tylko 0 lub 1. Jest to przydatne w sytuacjach, gdy trzeba określić prawdopodobieństwa między dwiema klasami lub innymi słowy obliczyć prawdopodobieństwo zdarzenia. Na przykład regresji logistycznej można użyć do przewidzenia, czy dzisiaj będzie padać.

Założenia regresji liniowej

Używając regresji liniowej do modelowania relacji między zmiennymi, przyjmujemy kilka założeń. Założenia to niezbędne warunki, które należy spełnić, zanim użyjemy modelu do prognozowania.

Generalnie istnieją cztery założenia związane z modelami regresji liniowej:

- Zależność liniowa: istnieje liniowa zależność między zmienną niezależną x a zmienną zależną y .

- Niezależność: reszty są niezależne. Nie ma korelacji między kolejnymi wartościami resztowymi w danych szeregów czasowych.

- Homoskedastyczność: reszty mają równą wariancję na wszystkich poziomach.

- Normalność: reszty mają rozkład normalny.

Metody rozwiązywania modeli regresji liniowej

W uczeniu maszynowym lub żargonie statystycznym uczenie się modelu regresji liniowej oznacza zgadywanie wartości współczynników na podstawie dostępnych danych. Do modelu regresji liniowej można zastosować kilka metod, aby uczynić go bardziej wydajnym.

Wskazówka: użyj oprogramowania do uczenia maszynowego, aby wyeliminować monotonne zadania i dokonać dokładnych prognoz.

Przyjrzyjmy się różnym technikom używanym do rozwiązywania modeli regresji liniowej, aby zrozumieć ich różnice i kompromisy.

Prosta regresja liniowa

Jak wspomniano wcześniej, w prostej regresji liniowej istnieje jedna zmienna wejściowa lub jedna zmienna niezależna i jedna zmienna zależna. Służy do znalezienia najlepszej relacji między dwiema zmiennymi, biorąc pod uwagę, że mają one charakter ciągły. Na przykład może służyć do przewidywania przyrostu masy ciała na podstawie zużytych kalorii.

Zwykłe najmniejsze kwadraty

Regresja zwykłych najmniejszych kwadratów to kolejna metoda szacowania wartości współczynników, gdy istnieje więcej niż jedna zmienna niezależna lub dane wejściowe. Jest to jedno z najczęstszych podejść do rozwiązywania regresji liniowej i jest również znane jako równanie normalne .

Ta procedura próbuje zminimalizować sumę kwadratów reszt. Traktuje dane jako macierz i wykorzystuje operacje algebry liniowej w celu określenia optymalnych wartości dla każdego współczynnika. Oczywiście tę metodę można zastosować tylko wtedy, gdy mamy dostęp do wszystkich danych, a także powinno być wystarczająco dużo pamięci, aby zmieścić dane.

Zejście gradientowe

Zejście gradientowe jest jedną z najłatwiejszych i powszechnie stosowanych metod rozwiązywania problemów regresji liniowej. Jest to przydatne, gdy istnieje jeden lub więcej danych wejściowych i obejmuje optymalizację wartości współczynników poprzez iteracyjne minimalizowanie błędu modelu.

Spadek gradientu zaczyna się od losowych wartości dla każdego współczynnika. Dla każdej pary wartości wejściowych i wyjściowych obliczana jest suma kwadratów błędów. Wykorzystuje współczynnik skali jako szybkość uczenia się, a każdy współczynnik jest aktualizowany w kierunku, aby zminimalizować błąd.

Proces powtarza się do momentu, gdy dalsze ulepszenia nie będą możliwe lub osiągnięta zostanie minimalna suma kwadratów. Opadanie gradientowe jest przydatne, gdy istnieje duży zestaw danych obejmujący dużą liczbę wierszy i kolumn, które nie mieszczą się w pamięci.

Regularyzacja

Regularyzacja to metoda, która stara się zminimalizować sumę kwadratów błędów modelu, a jednocześnie zmniejszyć złożoność modelu. Zmniejsza sumę kwadratów błędów przy użyciu zwykłej metody najmniejszych kwadratów.

Regresja lasso i regresja grzbietowa to dwa znane przykłady regularyzacji w regresji liniowej. Te metody są przydatne, gdy w zmiennych niezależnych występuje kolinearność.

Metoda Adama

Adaptacyjna estymacja momentu lub ADAM jest algorytmem optymalizacyjnym używanym w głęboka nauka. Jest to algorytm iteracyjny, który dobrze radzi sobie z zaszumionymi danymi. Jest prosty w implementacji, wydajny obliczeniowo i ma minimalne wymagania dotyczące pamięci.

ADAM łączy w sobie dwa algorytmy gradientowego spadku — propagacji średniej kwadratowej (RMSprop) i adaptacyjnego spadku gradientowego . Zamiast używać całego zestawu danych do obliczania gradientu, program ADAM używa losowo wybranych podzbiorów do wykonania przybliżenia stochastycznego.

Program ADAM nadaje się do rozwiązywania problemów związanych z dużą liczbą parametrów lub danych. Ponadto w tej metodzie optymalizacji hiperparametry na ogół wymagają minimalnego dostrojenia i mają intuicyjną interpretację.

Rozkład według wartości osobliwych

Rozkład według wartości osobliwych lub SVD jest powszechnie stosowaną techniką redukcji wymiarowości w regresji liniowej. Jest to etap przetwarzania wstępnego, który zmniejsza liczbę wymiarów algorytmu uczenia.

SVD polega na rozbiciu macierzy jako iloczynu trzech innych macierzy. Jest odpowiedni dla danych wielowymiarowych oraz wydajny i stabilny w przypadku małych zestawów danych. Ze względu na swoją stabilność jest to jedno z najbardziej preferowanych podejść do rozwiązywania równań liniowych dla regresji liniowej. Jest jednak podatny na wartości odstające i może stać się niestabilny w przypadku ogromnego zestawu danych.

Przygotowanie danych do regresji liniowej

W większości przypadków dane ze świata rzeczywistego są niekompletne.

Jak każdy inny model uczenia maszynowego, przygotowanie i wstępne przetwarzanie danych jest kluczowym procesem w regresji liniowej. Będą brakujące wartości, błędy, wartości odstające, niespójności i brak wartości atrybutów.

Oto kilka sposobów rozliczania niekompletnych danych i tworzenia bardziej niezawodnego modelu predykcyjnego.

- Regresja liniowa zakłada, że zmienne predyktora i odpowiedzi nie są zaszumione. Z tego powodu kluczowe znaczenie ma usuwanie szumu za pomocą kilku operacji usuwania danych. Jeśli to możliwe, należy usunąć wartości odstające ze zmiennej wyjściowej.

- Jeśli zmienne wejściowe i wyjściowe mają rozkład Gaussa , regresja liniowa zapewni lepsze przewidywania.

- Jeśli przeskalujesz zmienne wejściowe za pomocą normalizacji lub standaryzacji, regresja liniowa generalnie zapewni lepsze prognozy.

- Jeśli istnieje wiele atrybutów, musisz przekształcić dane tak, aby miały relację liniową .

- Jeśli zmienne wejściowe są silnie skorelowane, regresja liniowa przepełni dane. W takich przypadkach usuń kolinearność .

Zalety i wady regresji liniowej

Regresja liniowa to jeden z najbardziej nieskomplikowanych algorytmów do zrozumienia i najprostszy w implementacji. To świetne narzędzie do analizy relacji między zmiennymi.

Oto kilka znaczących zalet regresji liniowej:

- Jest to algorytm, do którego należy przejść ze względu na swoją prostotę.

- Chociaż jest podatny na nadmierne dopasowanie, można go uniknąć za pomocą technik redukcji wymiarów.

- Ma dobrą interpretację.

- Działa dobrze na liniowo rozdzielonych zestawach danych.

- Jego złożoność przestrzenna jest niewielka; dlatego jest to algorytm o dużym opóźnieniu.

Jednak regresja liniowa nie jest generalnie zalecana w większości praktycznych zastosowań. Dzieje się tak dlatego, że nadmiernie upraszcza rzeczywiste problemy, zakładając liniową zależność między zmiennymi.

Oto kilka wad regresji liniowej:

- Wartości odstające mogą mieć negatywny wpływ na regresję

- Ponieważ powinna istnieć liniowa zależność między zmiennymi, aby dopasować model liniowy, zakłada się, że istnieje liniowa zależność między zmiennymi

- Dostrzega, że dane są rozłożone normalnie

- Przygląda się również relacji między średnią zmiennych niezależnych i zależnych

- Regresja liniowa nie jest pełnym opisem relacji między zmiennymi

- Obecność wysokiej korelacji między zmiennymi może znacząco wpłynąć na wydajność modelu liniowego

Najpierw obserwuj, potem przewiduj

W regresji liniowej ważne jest, aby ocenić, czy zmienne mają zależność liniową. Chociaż niektórzy ludzie próbują przewidywać bez patrzenia na trend, najlepiej jest zapewnić umiarkowanie silną korelację między zmiennymi.

Jak wspomniano wcześniej, spojrzenie na wykres rozrzutu i współczynnik korelacji to doskonałe metody. I tak, nawet jeśli korelacja jest wysoka, nadal lepiej spojrzeć na wykres punktowy. Krótko mówiąc, jeśli dane są wizualnie liniowe, możliwa jest analiza regresji liniowej.

Podczas gdy regresja liniowa pozwala przewidzieć wartość zmiennej zależnej, istnieje algorytm, który klasyfikuje nowe punkty danych lub przewiduje ich wartości, patrząc na ich sąsiadów. Nazywa się to algorytmem k-najbliższych sąsiadów i jest leniwym uczniem.