Was ist lineare Regression? Wie es beim maschinellen Lernen verwendet wird

Veröffentlicht: 2021-07-16Ist die lineare Regression nicht Teil der Statistik?

Zweifellos, ja.

Tatsächlich die meisten maschinelles Lernen (ML)-Algorithmen werden aus verschiedenen Bereichen entlehnt, hauptsächlich der Statistik. Alles, was Modellen helfen kann, bessere Vorhersagen zu treffen, wird schließlich Teil von ML werden. Man kann also mit Sicherheit sagen, dass die lineare Regression sowohl ein statistischer als auch ein maschineller Lernalgorithmus ist.

Die lineare Regression ist ein beliebter und unkomplizierter Algorithmus, der in der Datenwissenschaft und im maschinellen Lernen verwendet wird. Es ist ein überwachtes Lernen Algorithmus und die einfachste Form der Regression zur Untersuchung der mathematischen Beziehung zwischen Variablen.

Was ist lineare Regression?

Die lineare Regression ist eine statistische Methode, die versucht, eine Beziehung zwischen Variablen aufzuzeigen. Es betrachtet verschiedene Datenpunkte und zeichnet eine Trendlinie. Ein einfaches Beispiel für lineare Regression ist die Feststellung, dass die Kosten für die Reparatur einer Maschine mit der Zeit steigen.

Genauer gesagt wird die lineare Regression verwendet, um den Charakter und die Stärke der Assoziation zwischen einer abhängigen Variablen und einer Reihe anderer unabhängiger Variablen zu bestimmen. Es hilft bei der Erstellung von Modellen, um Vorhersagen zu treffen, wie z. B. die Vorhersage des Aktienkurses eines Unternehmens.

Bevor man versucht, ein lineares Modell an den beobachteten Datensatz anzupassen, sollte man beurteilen, ob es eine Beziehung zwischen den Variablen gibt oder nicht. Das bedeutet natürlich nicht, dass eine Variable die andere verursacht, aber es sollte eine sichtbare Korrelation zwischen ihnen geben.

Zum Beispiel bedeuten höhere College-Noten nicht unbedingt ein höheres Gehaltspaket. Aber es kann eine Assoziation zwischen den beiden Variablen geben.

Hast Du gewusst? Der Begriff „linear“ bedeutet, einer Linie ähneln oder sich auf Linien beziehen.

Das Erstellen eines Streudiagramms ist ideal, um die Stärke der Beziehung zwischen erklärenden (unabhängigen) und abhängigen Variablen zu bestimmen. Wenn das Streudiagramm keine steigenden oder fallenden Trends zeigt, ist die Anwendung eines linearen Regressionsmodells auf die beobachteten Werte möglicherweise nicht vorteilhaft.

Korrelationskoeffizienten werden verwendet, um zu berechnen, wie stark eine Beziehung zwischen zwei Variablen ist. Er wird normalerweise mit r bezeichnet und hat einen Wert zwischen -1 und 1. Ein positiver Wert des Korrelationskoeffizienten weist auf eine positive Beziehung zwischen den Variablen hin. Ebenso zeigt ein negativer Wert eine negative Beziehung zwischen den Variablen an.

Tipp: Führen Sie eine Regressionsanalyse nur durch, wenn der Korrelationskoeffizient entweder positiv oder negativ 0,50 oder höher ist.

Wenn Sie sich die Beziehung zwischen Studienzeit und Noten ansehen würden, würden Sie wahrscheinlich eine positive Beziehung sehen. Betrachtet man dagegen den Zusammenhang zwischen der Zeit in den sozialen Medien und den Noten, wird man höchstwahrscheinlich einen negativen Zusammenhang feststellen.

Dabei ist „Noten“ die abhängige Variable und die Zeit, die im Studium oder in sozialen Medien verbracht wird, die unabhängige Variable. Denn die Noten hängen davon ab, wie viel Zeit man mit dem Lernen verbringt.

Wenn Sie (mindestens) eine moderate Korrelation zwischen den Variablen sowohl durch ein Streudiagramm als auch durch einen Korrelationskoeffizienten herstellen können, dann haben die genannten Variablen eine Form einer linearen Beziehung.

Kurz gesagt versucht die lineare Regression, die Beziehung zwischen zwei Variablen zu modellieren, indem eine lineare Gleichung auf die beobachteten Daten angewendet wird. Eine lineare Regressionsgerade lässt sich durch die Geradengleichung darstellen:

y = mx + b

In dieser einfachen linearen Regressionsgleichung:

- y ist die geschätzte abhängige Variable (oder die Ausgabe)

- m ist der Regressionskoeffizient (oder die Steigung)

- x ist die unabhängige Variable (oder die Eingabe)

- b ist die Konstante (oder der y-Achsenabschnitt)

Das Auffinden der Beziehung zwischen Variablen ermöglicht es, Werte oder Ergebnisse vorherzusagen. Mit anderen Worten, die lineare Regression ermöglicht es, neue Werte auf der Grundlage vorhandener Daten vorherzusagen.

Ein Beispiel wäre die Vorhersage von Ernteerträgen basierend auf den erhaltenen Niederschlägen. In diesem Fall ist der Niederschlag die unabhängige Variable und der Ernteertrag (die vorhergesagten Werte) die abhängige Variable.

Unabhängige Variablen werden auch als Prädiktorvariablen bezeichnet . Ebenso werden abhängige Variablen auch als Antwortvariablen bezeichnet .

Schlüsselterminologien in der linearen Regression

Das Verständnis der linearen Regressionsanalyse würde auch bedeuten, sich mit einer Reihe neuer Begriffe vertraut zu machen. Wenn Sie gerade erst in die Welt der Statistik oder des maschinellen Lernens eingetreten sind, wäre ein angemessenes Verständnis dieser Terminologien hilfreich.

- Variable: Es ist jede Zahl, Größe oder Eigenschaft, die gezählt oder gemessen werden kann. Es wird auch als Datenelement bezeichnet. Einkommen, Alter, Geschwindigkeit und Geschlecht sind Beispiele.

- Koeffizient: Es ist eine Zahl (normalerweise eine ganze Zahl), die mit der daneben stehenden Variablen multipliziert wird. Bei 7x zum Beispiel ist die Zahl 7 der Koeffizient.

- Ausreißer: Dies sind Datenpunkte, die sich deutlich von den anderen unterscheiden.

- Kovarianz: Die Richtung der linearen Beziehung zwischen zwei Variablen. Mit anderen Worten, es berechnet den Grad, in dem zwei Variablen linear zusammenhängen.

- Multivariat: Es bedeutet die Einbeziehung von zwei oder mehr abhängigen Variablen, die zu einem einzigen Ergebnis führen.

- Residuen: Die Differenz zwischen den beobachteten und vorhergesagten Werten der abhängigen Variablen.

- Variabilität: Der Mangel an Konsistenz oder das Ausmaß, in dem eine Verteilung gestaucht oder gestreckt wird.

- Linearität: Die Eigenschaft eines mathematischen Zusammenhangs, die eng mit der Proportionalität verwandt ist und grafisch als Gerade dargestellt werden kann.

- Lineare Funktion: Es ist eine Funktion, deren Graph eine gerade Linie ist.

- Kollinearität: Korrelation zwischen den unabhängigen Variablen, sodass sie in einem Regressionsmodell einen linearen Zusammenhang aufweisen.

- Standardabweichung (SD): Dies ist ein Maß für die Streuung eines Datensatzes relativ zu seinem Mittelwert. Mit anderen Worten, es ist ein Maß dafür, wie verteilt Zahlen sind.

- Standardfehler (SE): Die ungefähre SD einer statistischen Stichprobenpopulation. Es wird verwendet, um die Variabilität zu messen.

Arten der linearen Regression

Es gibt zwei Arten der linearen Regression: die einfache lineare Regression und die multiple lineare Regression .

Die einfache lineare Regressionsmethode versucht, die Beziehung zwischen einer einzelnen unabhängigen Variablen und einer entsprechenden abhängigen Variablen zu finden. Die unabhängige Variable ist die Eingabe, und die entsprechende abhängige Variable ist die Ausgabe.

Tipp: Sie können die lineare Regression in verschiedenen Programmiersprachen und Umgebungen implementieren, einschließlich Python, R, MATLAB und Excel.

Die Methode der multiplen linearen Regression versucht, die Beziehung zwischen zwei oder mehr unabhängigen Variablen und der entsprechenden abhängigen Variablen zu finden. Es gibt auch einen Sonderfall der sogenannten multiplen linearen Regression Polynomiale Regression.

Einfach ausgedrückt, ein einfaches lineares Regressionsmodell hat nur eine einzige unabhängige Variable, während ein multiples lineares Regressionsmodell zwei oder mehr unabhängige Variablen hat. Und ja, es gibt andere nichtlineare Regressionsmethoden, die für hochkomplizierte Datenanalysen verwendet werden.

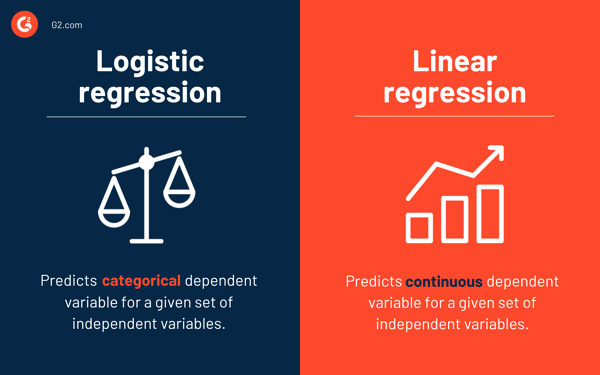

Logistische Regression vs. lineare Regression

Während die lineare Regression die kontinuierliche abhängige Variable für einen gegebenen Satz unabhängiger Variablen vorhersagt, sagt die logistische Regression die kategoriale abhängige Variable voraus.

Beides sind überwachte Lernmethoden. Aber während die lineare Regression verwendet wird, um Regressionsprobleme zu lösen, wird die logistische Regression verwendet, um Klassifizierungsprobleme zu lösen.

Natürlich kann die logistische Regression Regressionsprobleme lösen, aber sie wird hauptsächlich für Klassifizierungsprobleme verwendet. Seine Ausgabe kann nur 0 oder 1 sein. Es ist nützlich in Situationen, in denen Sie die Wahrscheinlichkeiten zwischen zwei Klassen bestimmen oder mit anderen Worten die Wahrscheinlichkeit eines Ereignisses berechnen müssen. Die logistische Regression kann beispielsweise verwendet werden, um vorherzusagen, ob es heute regnen wird.

Annahmen der linearen Regression

Während wir die lineare Regression verwenden, um die Beziehung zwischen Variablen zu modellieren, treffen wir einige Annahmen. Annahmen sind notwendige Bedingungen, die erfüllt sein sollten, bevor wir ein Modell verwenden, um Vorhersagen zu treffen.

Mit linearen Regressionsmodellen sind im Allgemeinen vier Annahmen verbunden:

- Lineare Beziehung: Es besteht eine lineare Beziehung zwischen der unabhängigen Variablen x und der abhängigen Variablen y .

- Unabhängigkeit: Die Residuen sind unabhängig. Es gibt keine Korrelation zwischen aufeinanderfolgenden Residuen in Zeitreihendaten.

- Homoskedastizität: Die Residuen haben auf allen Ebenen die gleiche Varianz.

- Normalität: Die Residuen sind normalverteilt.

Methoden zur Lösung linearer Regressionsmodelle

Im maschinellen Lernen oder Statistikjargon bedeutet das Erlernen eines linearen Regressionsmodells, die Werte der Koeffizienten anhand der verfügbaren Daten zu erraten. Mehrere Methoden können auf ein lineares Regressionsmodell angewendet werden, um es effizienter zu machen.

Tipp: Verwenden Sie Software für maschinelles Lernen, um monotone Aufgaben zu eliminieren und genaue Vorhersagen zu treffen.

Schauen wir uns die verschiedenen Techniken an, die zum Lösen linearer Regressionsmodelle verwendet werden, um ihre Unterschiede und Kompromisse zu verstehen.

Einfache lineare Regression

Wie bereits erwähnt, gibt es bei der einfachen linearen Regression eine einzelne Eingabe oder eine unabhängige Variable und eine abhängige Variable. Es wird verwendet, um die beste Beziehung zwischen zwei Variablen zu finden, da sie von kontinuierlicher Natur sind. So lässt sich beispielsweise anhand der aufgenommenen Kalorien die Gewichtszunahme vorhersagen.

Gewöhnliche kleinste Quadrate

Die gewöhnliche Regression der kleinsten Quadrate ist eine weitere Methode, um den Wert von Koeffizienten zu schätzen, wenn es mehr als eine unabhängige Variable oder Eingabe gibt. Dies ist einer der gebräuchlichsten Ansätze zum Lösen der linearen Regression und wird auch als Normalgleichung bezeichnet.

Dieses Verfahren versucht, die Summe der quadrierten Residuen zu minimieren. Es behandelt Daten als Matrix und verwendet Operationen der linearen Algebra, um die optimalen Werte für jeden Koeffizienten zu bestimmen. Natürlich kann diese Methode nur angewendet werden, wenn wir Zugriff auf alle Daten haben, und es sollte auch genügend Speicher für die Daten vorhanden sein.

Gradientenabstieg

Der Gradientenabstieg ist eine der einfachsten und am häufigsten verwendeten Methoden zur Lösung linearer Regressionsprobleme. Es ist nützlich, wenn eine oder mehrere Eingaben vorhanden sind und die Optimierung des Werts von Koeffizienten durch iterative Minimierung des Modellfehlers beinhaltet.

Der Gradientenabstieg beginnt mit zufälligen Werten für jeden Koeffizienten. Für jedes Paar von Eingabe- und Ausgabewerten wird die Summe der quadrierten Fehler berechnet. Es verwendet einen Skalierungsfaktor als Lernrate, und jeder Koeffizient wird in der Richtung aktualisiert, um Fehler zu minimieren.

Der Vorgang wird wiederholt, bis keine weiteren Verbesserungen mehr möglich sind oder eine Mindestquadratsumme erreicht ist. Der Gradientenabstieg ist hilfreich, wenn ein großer Datensatz mit einer großen Anzahl von Zeilen und Spalten vorhanden ist, die nicht in den Speicher passen.

Regulierung

Regularisierung ist eine Methode, die versucht, die Summe der quadrierten Fehler eines Modells zu minimieren und gleichzeitig die Komplexität des Modells zu reduzieren. Es reduziert die Summe der quadrierten Fehler unter Verwendung der gewöhnlichen Methode der kleinsten Quadrate.

Lasso-Regression und Ridge-Regression sind die beiden berühmten Beispiele für Regularisierung in der linearen Regression. Diese Methoden sind wertvoll, wenn es Kollinearität in den unabhängigen Variablen gibt.

Adams Methode

Die adaptive Momentschätzung oder ADAM ist ein Optimierungsalgorithmus, der in verwendet wird tiefes Lernen. Es ist ein iterativer Algorithmus, der bei verrauschten Daten gut funktioniert. Es ist einfach zu implementieren, recheneffizient und hat minimale Speicheranforderungen.

ADAM kombiniert zwei Gradientenabstiegsalgorithmen – Root Mean Square Propagation (RMSprop) und adaptive Gradientenabstieg . Anstatt den gesamten Datensatz zur Berechnung des Gradienten zu verwenden, verwendet ADAM zufällig ausgewählte Teilmengen, um eine stochastische Annäherung vorzunehmen.

ADAM eignet sich für Probleme mit einer großen Anzahl von Parametern oder Daten. Außerdem erfordern bei diesem Optimierungsverfahren die Hyperparameter im Allgemeinen eine minimale Abstimmung und haben eine intuitive Interpretation.

Einzelwertzerlegung

Die Singulärwertzerlegung oder SVD ist eine häufig verwendete Technik zur Dimensionsreduktion in der linearen Regression. Es ist ein Vorverarbeitungsschritt, der die Anzahl der Dimensionen für den Lernalgorithmus reduziert.

Bei der SVD wird eine Matrix als Produkt von drei anderen Matrizen zerlegt. Es eignet sich für hochdimensionale Daten und ist effizient und stabil für kleine Datensätze. Aufgrund seiner Stabilität ist es einer der am meisten bevorzugten Ansätze zum Lösen linearer Gleichungen für die lineare Regression. Es ist jedoch anfällig für Ausreißer und kann bei einem großen Datensatz instabil werden.

Vorbereiten von Daten für die lineare Regression

Daten aus der realen Welt sind in den meisten Fällen unvollständig.

Wie bei jedem anderen maschinellen Lernmodell ist die Datenvorbereitung und -vorverarbeitung ein entscheidender Prozess bei der linearen Regression. Es gibt fehlende Werte, Fehler, Ausreißer, Inkonsistenzen und fehlende Attributwerte.

Hier sind einige Möglichkeiten, um unvollständige Daten zu berücksichtigen und ein zuverlässigeres Vorhersagemodell zu erstellen.

- Die lineare Regression geht davon aus, dass die Prädiktor- und Antwortvariablen nicht verrauscht sind. Aus diesem Grund ist das Entfernen von Rauschen mit mehreren Datenlöschvorgängen von entscheidender Bedeutung. Wenn möglich, sollten Sie die Ausreißer in der Ausgabevariable entfernen.

- Wenn die Eingabe- und Ausgabevariablen eine Gaußsche Verteilung aufweisen , liefert die lineare Regression bessere Vorhersagen.

- Wenn Sie Eingabevariablen mithilfe von Normalisierung oder Standardisierung neu skalieren, liefert die lineare Regression im Allgemeinen bessere Vorhersagen.

- Wenn viele Attribute vorhanden sind, müssen Sie die Daten so umwandeln, dass sie eine lineare Beziehung haben.

- Wenn die Eingabevariablen stark korreliert sind, passt die lineare Regression die Daten zu stark an. Entfernen Sie in solchen Fällen die Kollinearität .

Vor- und Nachteile der linearen Regression

Die lineare Regression ist einer der am einfachsten zu verstehenden und am einfachsten zu implementierenden Algorithmen. Es ist ein großartiges Werkzeug, um Beziehungen zwischen Variablen zu analysieren.

Hier sind einige bemerkenswerte Vorteile der linearen Regression:

- Es ist wegen seiner Einfachheit ein Go-to-Algorithmus.

- Obwohl es anfällig für Überanpassung ist, kann es mit Hilfe von Techniken zur Reduzierung der Dimensionalität vermieden werden.

- Es hat eine gute Interpretierbarkeit.

- Es funktioniert gut bei linear trennbaren Datensätzen.

- Seine Platzkomplexität ist gering; Daher ist es ein Algorithmus mit hoher Latenz.

Für die meisten praktischen Anwendungen wird die lineare Regression jedoch im Allgemeinen nicht empfohlen. Dies liegt daran, dass reale Probleme zu stark vereinfacht werden, indem eine lineare Beziehung zwischen Variablen angenommen wird.

Hier sind einige Nachteile der linearen Regression:

- Ausreißer können sich negativ auf die Regression auswirken

- Da für ein lineares Modell eine lineare Beziehung zwischen den Variablen bestehen sollte, wird davon ausgegangen, dass zwischen den Variablen eine lineare Beziehung besteht

- Es nimmt wahr, dass die Daten normalverteilt sind

- Es betrachtet auch die Beziehung zwischen dem Mittelwert der unabhängigen und abhängigen Variablen

- Die lineare Regression ist keine vollständige Beschreibung der Beziehungen zwischen Variablen

- Das Vorhandensein einer hohen Korrelation zwischen Variablen kann die Leistung eines linearen Modells erheblich beeinträchtigen

Erst beobachten, dann prognostizieren

Bei der linearen Regression ist es entscheidend zu bewerten, ob die Variablen eine lineare Beziehung haben. Obwohl einige Leute versuchen, Vorhersagen zu treffen, ohne sich den Trend anzusehen, ist es am besten, sicherzustellen, dass zwischen den Variablen eine mäßig starke Korrelation besteht.

Wie bereits erwähnt, sind das Betrachten des Streudiagramms und des Korrelationskoeffizienten hervorragende Methoden. Und ja, auch wenn die Korrelation hoch ist, ist es immer noch besser, sich das Streudiagramm anzusehen. Kurz gesagt, wenn die Daten visuell linear sind, ist eine lineare Regressionsanalyse durchführbar.

Während Sie mit der linearen Regression den Wert einer abhängigen Variablen vorhersagen können, gibt es einen Algorithmus, der neue Datenpunkte klassifiziert oder ihre Werte vorhersagt, indem er ihre Nachbarn betrachtet. Es heißt k-Nächste-Nachbarn-Algorithmus und ist ein fauler Lerner.