Che cos'è la regressione lineare? Come viene utilizzato nell'apprendimento automatico

Pubblicato: 2021-07-16La regressione lineare non fa parte delle statistiche?

Indubbiamente sì.

In effetti, la maggior parte apprendimento automatico Gli algoritmi (ML) sono presi in prestito da vari campi, principalmente la statistica. Tutto ciò che può aiutare i modelli a prevedere meglio finirà per diventare parte del ML. Quindi, è sicuro dire che la regressione lineare è sia un algoritmo statistico che di apprendimento automatico.

La regressione lineare è un algoritmo popolare e semplice utilizzato nella scienza dei dati e nell'apprendimento automatico. È un apprendimento supervisionato algoritmo e la forma più semplice di regressione utilizzata per studiare la relazione matematica tra variabili.

Cos'è la regressione lineare?

La regressione lineare è un metodo statistico che cerca di mostrare una relazione tra variabili. Esamina diversi punti dati e traccia una linea di tendenza. Un semplice esempio di regressione lineare è scoprire che il costo della riparazione di un macchinario aumenta con il tempo.

Più precisamente, la regressione lineare viene utilizzata per determinare il carattere e la forza dell'associazione tra una variabile dipendente e una serie di altre variabili indipendenti. Aiuta a creare modelli per fare previsioni, come prevedere il prezzo delle azioni di una società.

Prima di tentare di adattare un modello lineare al set di dati osservato, si dovrebbe valutare se esiste o meno una relazione tra le variabili. Naturalmente, questo non significa che una variabile causi l'altra, ma dovrebbe esserci una correlazione visibile tra di loro.

Ad esempio, voti universitari più alti non significano necessariamente un pacchetto salariale più alto. Ma ci può essere un'associazione tra le due variabili.

Lo sapevate? Il termine "lineare" significa somigliare a una linea o relativo a linee.

La creazione di un grafico a dispersione è l'ideale per determinare la forza della relazione tra variabili esplicative (indipendenti) e dipendenti . Se il grafico a dispersione non mostra tendenze in aumento o in diminuzione, l'applicazione di un modello di regressione lineare ai valori osservati potrebbe non essere vantaggioso.

I coefficienti di correlazione vengono utilizzati per calcolare la forza di una relazione tra due variabili. Di solito è indicato con r e ha un valore compreso tra -1 e 1. Un valore del coefficiente di correlazione positivo indica una relazione positiva tra le variabili. Allo stesso modo, un valore negativo indica una relazione negativa tra le variabili.

Suggerimento: eseguire l'analisi di regressione solo se il coefficiente di correlazione è positivo o negativo di 0,50 o superiore.

Se stavi guardando la relazione tra tempo di studio e voti, probabilmente vedresti una relazione positiva. D'altra parte, se guardi la relazione tra tempo sui social media e voti, molto probabilmente vedrai una relazione negativa.

Qui, "voti" è la variabile dipendente e il tempo trascorso a studiare o sui social media è la variabile indipendente. Questo perché i voti dipendono da quanto tempo dedichi allo studio.

Se puoi stabilire (almeno) una moderata correlazione tra le variabili sia attraverso un diagramma di dispersione che un coefficiente di correlazione, allora dette variabili hanno una qualche forma di relazione lineare.

In breve, la regressione lineare cerca di modellare la relazione tra due variabili applicando un'equazione lineare ai dati osservati. Una retta di regressione lineare può essere rappresentata usando l'equazione di una retta:

y = mx + b

In questa semplice equazione di regressione lineare:

- y è la variabile dipendente stimata (o l'output)

- m è il coefficiente di regressione (o la pendenza)

- x è la variabile indipendente (o l'input)

- b è la costante (o l'intercetta y)

Trovare la relazione tra le variabili consente di prevedere valori o risultati. In altre parole, la regressione lineare consente di prevedere nuovi valori sulla base dei dati esistenti.

Un esempio potrebbe essere la previsione dei raccolti in base alle precipitazioni ricevute. In questo caso, la piovosità è la variabile indipendente e la resa del raccolto (i valori previsti) è la variabile dipendente.

Le variabili indipendenti sono anche dette variabili predittive . Allo stesso modo, le variabili dipendenti sono anche note come variabili di risposta .

Terminologie chiave nella regressione lineare

Comprendere l'analisi di regressione lineare significherebbe anche acquisire familiarità con una serie di nuovi termini. Se sei appena entrato nel mondo della statistica o dell'apprendimento automatico, avere una buona comprensione di queste terminologie sarebbe utile.

- Variabile: è qualsiasi numero, quantità o caratteristica che può essere contata o misurata. Viene anche chiamato elemento dati. Reddito, età, velocità e sesso sono esempi.

- Coefficiente: è un numero (di solito un intero) moltiplicato per la variabile accanto ad esso. Ad esempio, in 7x, il numero 7 è il coefficiente.

- Valori anomali: questi sono punti dati significativamente diversi dagli altri.

- Covarianza: La direzione della relazione lineare tra due variabili. In altre parole, calcola il grado in cui due variabili sono linearmente correlate.

- Multivariato: significa coinvolgere due o più variabili dipendenti risultanti in un unico risultato.

- Residui: la differenza tra i valori osservati e previsti della variabile dipendente.

- Variabilità: la mancanza di coerenza o la misura in cui una distribuzione viene compressa o allungata.

- Linearità: la proprietà di una relazione matematica che è strettamente correlata alla proporzionalità e può essere rappresentata graficamente come una linea retta.

- Funzione lineare: è una funzione il cui grafico è una linea retta.

- Collinearità: correlazione tra le variabili indipendenti, tale da mostrare una relazione lineare in un modello di regressione.

- Deviazione standard (SD): è una misura della dispersione di un set di dati rispetto alla sua media. In altre parole, è una misura di come sono distribuiti i numeri.

- Errore standard (SE): la DS approssimativa di una popolazione campione statistica. È usato per misurare la variabilità.

Tipi di regressione lineare

Esistono due tipi di regressione lineare: regressione lineare semplice e regressione lineare multipla .

Il metodo della regressione lineare semplice cerca di trovare la relazione tra una singola variabile indipendente e una corrispondente variabile dipendente. La variabile indipendente è l'input e la corrispondente variabile dipendente è l'output.

Suggerimento: puoi implementare la regressione lineare in vari linguaggi di programmazione e ambienti, inclusi Python, R, MATLAB ed Excel.

Il metodo della regressione lineare multipla cerca di trovare la relazione tra due o più variabili indipendenti e la corrispondente variabile dipendente. C'è anche un caso speciale di regressione lineare multipla chiamato regressione polinomiale.

In poche parole, un modello di regressione lineare semplice ha solo una singola variabile indipendente, mentre un modello di regressione lineare multipla avrà due o più variabili indipendenti. E sì, ci sono altri metodi di regressione non lineare utilizzati per l'analisi dei dati molto complicata.

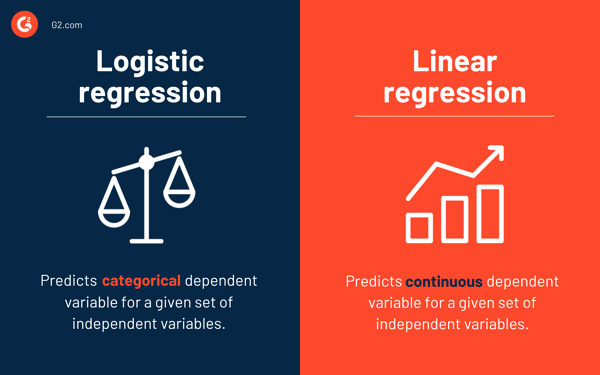

Regressione logistica vs. regressione lineare

Mentre la regressione lineare prevede la variabile dipendente continua per un dato insieme di variabili indipendenti, la regressione logistica prevede la variabile dipendente categoriale.

Entrambi sono metodi di apprendimento supervisionato. Ma mentre la regressione lineare viene utilizzata per risolvere i problemi di regressione, la regressione logistica viene utilizzata per risolvere i problemi di classificazione.

Naturalmente, la regressione logistica può risolvere problemi di regressione, ma viene utilizzata principalmente per problemi di classificazione. Il suo output può essere solo 0 o 1. È utile in situazioni in cui è necessario determinare le probabilità tra due classi o, in altre parole, calcolare la probabilità di un evento. Ad esempio, la regressione logistica può essere utilizzata per prevedere se pioverà oggi.

Ipotesi di regressione lineare

Mentre utilizziamo la regressione lineare per modellare la relazione tra le variabili, facciamo alcune ipotesi. I presupposti sono condizioni necessarie che dovrebbero essere soddisfatte prima di utilizzare un modello per fare previsioni.

Ci sono generalmente quattro ipotesi associate ai modelli di regressione lineare:

- Relazione lineare: esiste una relazione lineare tra la variabile indipendente x e la variabile dipendente y .

- Indipendenza: I residui sono indipendenti. Non c'è correlazione tra residui consecutivi nei dati di serie temporali.

- Omoscedasticità: i residui hanno varianza uguale a tutti i livelli.

- Normalità: I residui sono normalmente distribuiti.

Metodi per risolvere modelli di regressione lineare

Nell'apprendimento automatico o nel gergo statistico, apprendere un modello di regressione lineare significa indovinare i valori dei coefficienti utilizzando i dati disponibili. Diversi metodi possono essere applicati a un modello di regressione lineare per renderlo più efficiente.

Suggerimento: utilizza il software di apprendimento automatico per eliminare le attività monotone e fare previsioni accurate.

Diamo un'occhiata alle diverse tecniche utilizzate per risolvere i modelli di regressione lineare per comprenderne differenze e compromessi.

Regressione lineare semplice

Come accennato in precedenza, nella regressione lineare semplice sono presenti un singolo input o una variabile indipendente e una variabile dipendente. Viene utilizzato per trovare la migliore relazione tra due variabili, dato che sono di natura continua. Ad esempio, può essere utilizzato per prevedere la quantità di peso guadagnato in base alle calorie consumate.

Minimi quadrati ordinari

La regressione dei minimi quadrati ordinari è un altro metodo per stimare il valore dei coefficienti quando è presente più di una variabile o input indipendente. È uno degli approcci più comuni per risolvere la regressione lineare ed è anche noto come equazione normale .

Questa procedura cerca di ridurre al minimo la somma dei residui al quadrato. Tratta i dati come una matrice e utilizza operazioni di algebra lineare per determinare i valori ottimali per ciascun coefficiente. Naturalmente, questo metodo può essere applicato solo se abbiamo accesso a tutti i dati e dovrebbe esserci anche memoria sufficiente per adattarsi ai dati.

Discesa a gradiente

La discesa del gradiente è uno dei metodi più semplici e comunemente usati per risolvere i problemi di regressione lineare. È utile quando sono presenti uno o più input e comporta l'ottimizzazione del valore dei coefficienti riducendo al minimo l'errore del modello in modo iterativo.

La discesa del gradiente inizia con valori casuali per ogni coefficiente. Per ogni coppia di valori di input e output, viene calcolata la somma degli errori al quadrato. Utilizza un fattore di scala come tasso di apprendimento e ogni coefficiente viene aggiornato nella direzione per ridurre al minimo l'errore.

Il processo viene ripetuto fino a quando non sono possibili ulteriori miglioramenti o viene raggiunta una somma minima di quadrati. La discesa del gradiente è utile quando è presente un set di dati di grandi dimensioni che coinvolge un numero elevato di righe e colonne che non si adattano alla memoria.

Regolarizzazione

La regolarizzazione è un metodo che tenta di ridurre al minimo la somma degli errori al quadrato di un modello e, allo stesso tempo, di ridurre la complessità del modello. Riduce la somma degli errori al quadrato utilizzando il metodo dei minimi quadrati ordinari.

La regressione con lazo e la regressione della cresta sono i due famosi esempi di regolarizzazione nella regressione lineare. Questi metodi sono utili quando c'è collinearità nelle variabili indipendenti.

Il metodo di Adamo

La stima del momento adattivo , o ADAM , è un algoritmo di ottimizzazione utilizzato in apprendimento approfondito. È un algoritmo iterativo che funziona bene su dati rumorosi. È semplice da implementare, efficiente dal punto di vista computazionale e ha requisiti di memoria minimi.

ADAM combina due algoritmi di discesa del gradiente: la propagazione del quadrato medio della radice (RMSprop) e la discesa del gradiente adattivo . Invece di utilizzare l'intero set di dati per calcolare il gradiente, ADAM utilizza sottoinsiemi selezionati casualmente per fare un'approssimazione stocastica.

ADAM è adatto per problemi che coinvolgono un gran numero di parametri o dati. Inoltre, in questo metodo di ottimizzazione, gli iperparametri richiedono generalmente un'ottimizzazione minima e hanno un'interpretazione intuitiva.

Scomposizione di un valore singolo

La scomposizione del valore singolare , o SVD , è una tecnica di riduzione della dimensionalità comunemente usata nella regressione lineare. È una fase di preelaborazione che riduce il numero di dimensioni per l'algoritmo di apprendimento.

SVD comporta la scomposizione di una matrice come prodotto di altre tre matrici. È adatto per dati ad alta dimensione ed efficiente e stabile per piccoli set di dati. Grazie alla sua stabilità, è uno degli approcci preferiti per la risoluzione di equazioni lineari per la regressione lineare. Tuttavia, è suscettibile di valori anomali e potrebbe diventare instabile con un enorme set di dati.

Preparazione dei dati per la regressione lineare

I dati del mondo reale, nella maggior parte dei casi, sono incompleti.

Come qualsiasi altro modello di machine learning, la preparazione e la preelaborazione dei dati è un processo cruciale nella regressione lineare. Ci saranno valori mancanti, errori, valori anomali, incoerenze e mancanza di valori di attributo.

Ecco alcuni modi per tenere conto dei dati incompleti e creare un modello di previsione più affidabile.

- La regressione lineare ritiene che le variabili predittive e di risposta non siano rumorose. Per questo motivo, è fondamentale rimuovere il rumore con diverse operazioni di cancellazione dei dati. Se possibile, dovresti rimuovere i valori anomali nella variabile di output.

- Se le variabili di input e di output hanno distribuzione gaussiana , la regressione lineare farà previsioni migliori.

- Se si ridimensionano le variabili di input utilizzando la normalizzazione o la standardizzazione, la regressione lineare generalmente farà previsioni migliori.

- Se sono presenti molti attributi, è necessario trasformare i dati per avere una relazione lineare .

- Se le variabili di input sono altamente correlate, la regressione lineare supererà i dati. In questi casi, rimuovere la collinearità .

Vantaggi e svantaggi della regressione lineare

La regressione lineare è uno degli algoritmi più semplici da comprendere e più semplici da implementare. È un ottimo strumento per analizzare le relazioni tra le variabili.

Ecco alcuni notevoli vantaggi della regressione lineare:

- È un algoritmo di riferimento per la sua semplicità.

- Sebbene sia suscettibile di overfitting, può essere evitato con l'aiuto di tecniche di riduzione della dimensionalità.

- Ha una buona interpretabilità.

- Funziona bene su set di dati separabili linearmente.

- La sua complessità spaziale è bassa; pertanto, è un algoritmo ad alta latenza.

Tuttavia, la regressione lineare non è generalmente consigliata per la maggior parte delle applicazioni pratiche. È perché semplifica eccessivamente i problemi del mondo reale assumendo una relazione lineare tra le variabili.

Ecco alcuni svantaggi della regressione lineare:

- I valori anomali possono avere effetti negativi sulla regressione

- Dal momento che dovrebbe esserci una relazione lineare tra le variabili per adattarsi a un modello lineare, presuppone che ci sia una relazione lineare tra le variabili

- Percepisce che i dati sono normalmente distribuiti

- Esamina anche la relazione tra la media delle variabili indipendenti e dipendenti

- La regressione lineare non è una descrizione completa delle relazioni tra variabili

- La presenza di un'elevata correlazione tra le variabili può influenzare significativamente le prestazioni di un modello lineare

Prima osserva, poi prevedi

Nella regressione lineare, è fondamentale valutare se le variabili hanno una relazione lineare. Sebbene alcune persone cerchino di prevedere senza guardare la tendenza, è meglio assicurarsi che ci sia una correlazione moderatamente forte tra le variabili.

Come accennato in precedenza, guardare il grafico a dispersione e il coefficiente di correlazione sono metodi eccellenti. E sì, anche se la correlazione è alta, è comunque meglio guardare il grafico a dispersione. In breve, se i dati sono visivamente lineari, l'analisi di regressione lineare è fattibile.

Mentre la regressione lineare ti consente di prevedere il valore di una variabile dipendente, esiste un algoritmo che classifica i nuovi punti dati o ne prevede i valori osservando i loro vicini. Si chiama algoritmo k-neiest neighbors, ed è uno studente pigro.